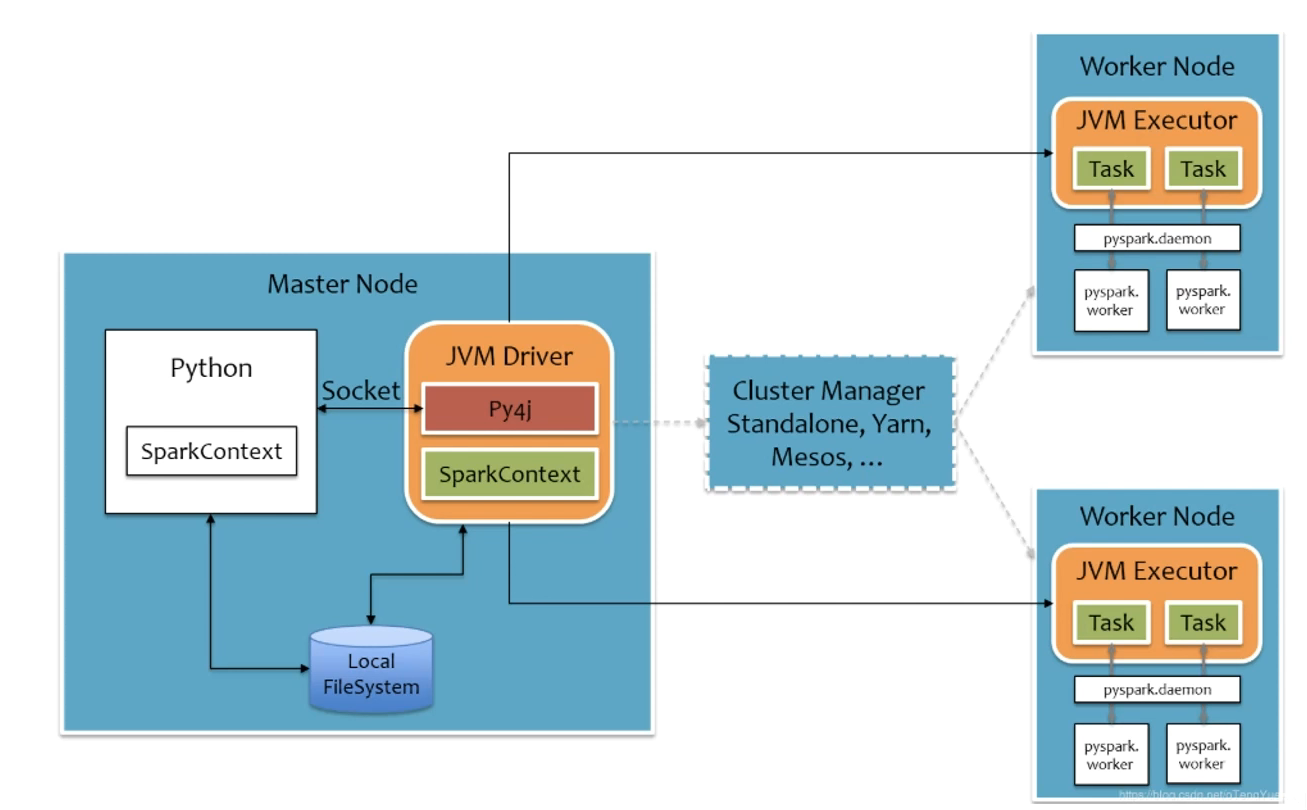

Python On Spark的执行流程

分布式代码执行的重要特征?

代码在集群上运行,是被分布式运行的。

在Spark中,非任务处理部分由Driver执行(非RDD代码)

任务处理部分是由Executor执行(RDD代码)

Executor的数量可以很多,所以任务的计算是分布式在运行的。

Pyspark的架构体系?

Python On Spark Driver端由JVM执行,Executor端由JVM做命令转发,底层由Python解释器进行工作。

RDD?

RDD叫做弹性分布式数据集,是Spark中最基本的数据抽象,代表一个不可变、可分区、里面的元素可并行计算的集合。

五大特征:

1..RDD是有分区的

2.计算方法都会作用到每一个分区之上

3.RDD之间室友相互依赖关系的

4.KV型RDD可以有分区器

5.RDD分区数据的读取会尽量靠近数据所在地