Multi-scale guided attention for medical image segmentation

[论文阅读]Multi-scale guided attention for medical image segmentation

1.Introduction

传统的分割的CNN:FCN和encoder-decoder结构的CNN的问题

- 这些多尺度方法导致信息流的冗余使用,例如,在网络内的不同级别上多次提取类似的低级特征。

- 用于像素方式识别的学习到的特征表示的辨别力可能不足以用于一些具有挑战性的任务,例如医学图像分割。

特征融合策略:金字塔池化,空洞卷积金字塔

- 尽管这些策略可能有助于在不同尺度上捕获对象,但所有图像区域的上下文依赖都是同构的、非自适应的,忽略了不同类别的局部表示和上下文依赖之间的差异。

- 这些多上下文表示是手工设计的,缺乏对多上下文表示建模的灵活性。这使得在这些方法中无法充分利用整个图像中的长距离对象关系,这在许多医学图像分割问题中具有至关重要的意义。

attention机制

- 注意力允许网络在没有额外监督的情况下专注于最相关的特性,避免使用多个相似的特性图,并突出显示对给定任务有用的突出特性。

- 它们在医学图像中的应用仍然很少,仅限于简单的注意力模型。

2.methods

2.1Multi-scale attention maps

网络基于resnet101的修改,res2-res5层输出的不同尺度特征图定义为F0,F1,F2,F3,将他们上采样到统一的尺度得到,将

在通道上堆叠经过卷积得到

(多尺度特征图).

![]()

得到的多尺度特征图再分别和

进行concatenate操作,经过卷积后送入到Guided Attention模块中,得到注意力特征图(attention feature maps):A0,A1,A2,A3.

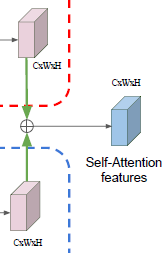

2.2 Spatial and Channel self-attention modules

a).Position attention module(PAM):捕获长距离依赖,解决局部感受野的问题

3个分支,前两个分支和

计算位置与位置之间的相关性矩阵:

再由位置之间的相关性矩阵指导第三条分支

计算得到空间注意力图,与输入进行加权和:

b).Channel attention module(CAM):捕获通道间存在的依赖关系,增强特定的语义特征表示

3个分支,前两个分支和

计算通道与通道之间的相关性矩阵:

再由通道之间的相关性矩阵指导第三条分支

计算得到通道注意力图,与输入进行加权和:

最后将空间注意力图与通道注意力图进行元素加操作得到空间-通道注意力特征图

2.3 Guiding attention

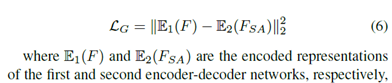

Guided loss:通过强制使两个编码器和解码器的语义表示接近,将类别信息嵌入到第二个注意模块中

编码-解码器重建Loss:

2.4 Deep supervision

在每个尺度对应的位置的特征图与ground truth计算损失进行深度监督,每个位置的深度监督损失为注意力模块前的特征图F'和经过注意力模块后特征图A

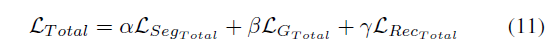

总loss:

3实验结果

3.1 消融实验

3.2 与state-of-art方法比较