生物医学大数据:

收集数据后对数据的分析,如同看相,而对数据信息的挖掘可以看作是算命。这两个过程是基于算法和软件这类工具之上的。

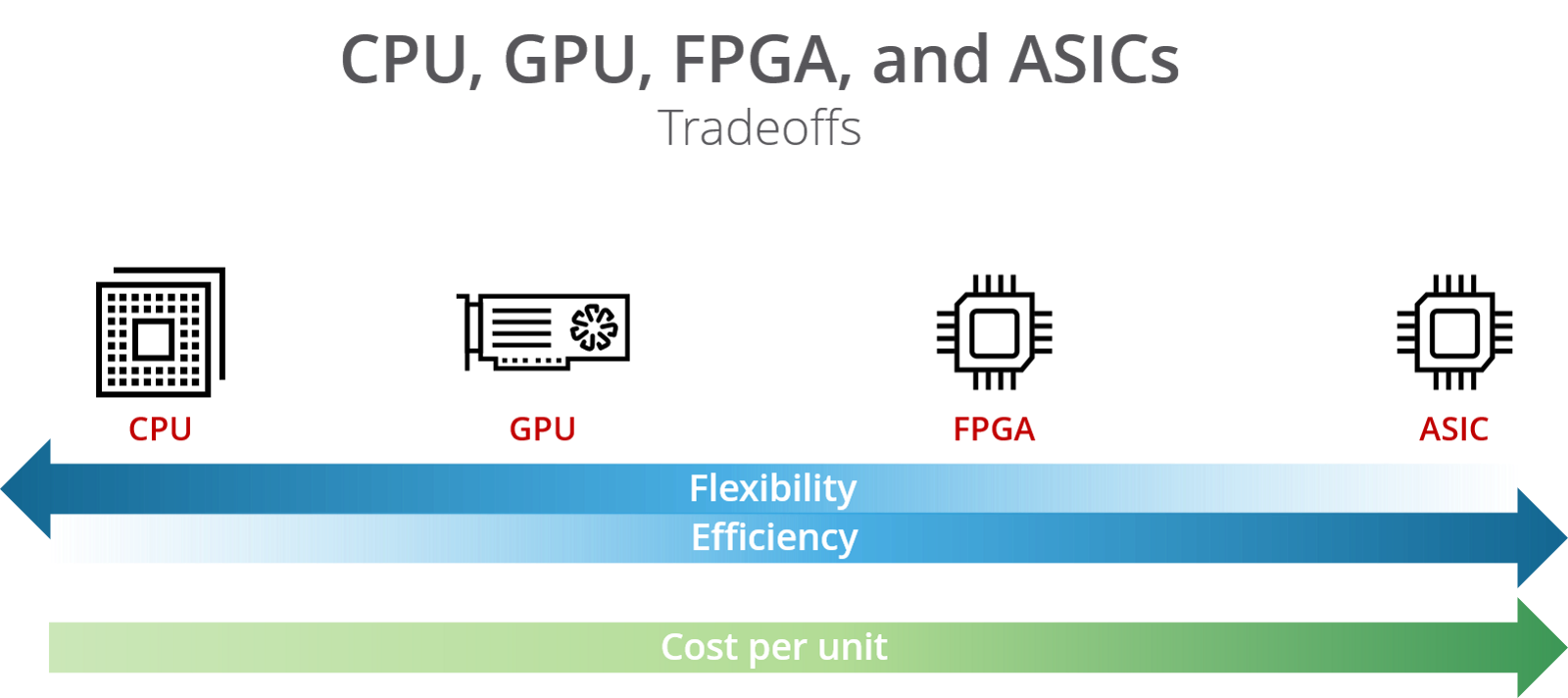

在存储方面:在硬件上,为了Parallel computing的目的,刚开始选择的处理器是multiple core,之后选择many integrated core architecture(MIC:英特尔® 集成众核架构(英特尔® MIC 架构)产品为开发人员提供了一个关键优势:它们基于标准的现有编程工具和方法运行),之后选择GPU(大内存),之后是FPGA(电场可编程逻辑闸阵列,它是在PAL、GAL、CPLD等可编程逻辑器件的基础上进一步发展的产物。它是作为专用集成电路领域中的一种半定制电路而出现的,既解决了全定制电路的不足,又克服了原有可编程逻辑器件门电路数有限的缺点。但是就生物信息学领域只能跑GATK),如今又有了超级计算机。

No free lunch:由CPU到超算,灵活性下降但是专有性上升,同时存在的问题是费用变高。现如今的生物信息学分析,正在使用更为专有性的硬件,也更加费钱。

因此,面临Massive data和由于data transfer造成的cost,可以有以下基于软件的应对方法:

1.尽可能传输压缩包

2.decouple:将原始数据分析拆解,选择有需要的类型,会减少数据量

3.使用dataset保存分析结果:因为生物数据的特点是a.快速增长b.异构c.一次读多次写,所以以数据特征作为研究对象更为重要,将这些数据特征存入数据库更可以方便查找。

4.去冗余:将原始数据中重复部分去掉。

对于Data的处理过程中,需要注意:

1.要对数据进行Analysis,mining(即是prediction),visual。其中,Data mining这个过程是:首先先能够建立scientific model,这个model是一种grey box,它有别于white box或者black box。white box是研究现象的本质,black box是由现象1指向现象2,它们其中是没有过程的,即不知道为什么;而grey box是通过statistical定量得到的,是利用统计学将不确定是否发生的概率数据化,将预测变成可以度量的数字。因为统计学是将现象1和现象2用数学公式联系在一起,其中数公式反应的是两者的关联强度,并对这个关联强度定量,所以人们利用这个定量值make decision,这个decision可以是判定这些原始数据与某patterns关联很大(或反应了某pattern),据此有一个结论,就是“是or不是某pattern”,根据这个结论,科学家可以找到new knowledge。

2.明白Meta-data(元数据,又称诠释数据、中介数据、中继数据、后设数据等,为描述其他数据信息的数据。)与raw-data之间的关系,因为生物信息学数据有一次读多次写(或者多次分析)的特点,所以应该分离读写。

3.同时面临越来越多的数据必须要扩大内存。