从 Paxos 到 ZooKeeper

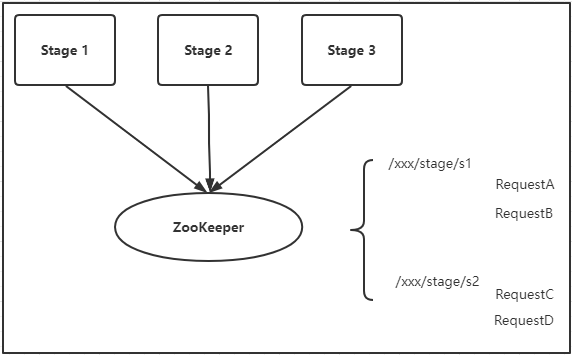

分布式一致性

分布式文件系统、缓存系统和数据库等大型分布式存储系统中,分布式一致性都是一个重要的问题。

什么是分布式一致性?分布式一致性分为哪些类型?分布式系统达到一致性后将会是一个什么样的状态?

如果失去了分布式一致性,分布式系统是否还可以依赖?

如果一味地追求一致性,对系统的整体架构和性能会有多大的影响?

每次写需求的时候总会思考,在某些特殊恶劣的条件下,这些代码的运行结果会是什么?

尽管在实习期间,已经遇到了很多次 因为代码漏洞导致线上环境数据不一致而导致被迫改数据库的问题,对此已见怪不怪;

但还是希望,经由我手写出来的代码能别这么脆弱!

敲代码为了混口饭吃固然没错,但也要为自己通过键盘录入的每一个字符负责的。

一、概述

用户在使用计算机产品时,对于数据一致性的需求是不一样的:

- 有些系统,要求快速地响应用户,同时还要保证系统的数据对于任意客户端都是真实可靠的,就像火车站的售票系统;

- 有些系统,需要未用户保证绝对可靠的数据安全,虽然在一致性上存在延时,但最终务必保证严格的一致,就像银行的转账系统;

- 还有些系统,虽然向用户展示了一些 “错误”的过时数据,但是在整个系统使用的过程中,一定会在某一个流程上对系统数据进行准确无误的检查,从而避免用户发送不必要的损失,就像网购系统。

分布式一致性需要考虑更新的并发性问题,如果逻辑控制流在时间上是重叠的,那么它们就是并发的。同一时间点上进行的多个程序操作,可能会修改内存中某个变量的值。

分布式一致性还需要考虑数据的复制问题,如数据库之间复制的延时问题。分布式系统对于数据的复制需求来自于两个原因:

- 增加系统的可用性,防止单点故障

- 提高系统的整体性能,通过负载均衡,让分布在不同地方的数据副本都能为用户提供服务

因此在分布式环境中引入了数据复制机制后,不同数据节点间因为延时等原因就有可能出现不一致的情况。

但是,我们无法找到一种能够满足分布式系统所有系统属性的分布式一致性解决方案,每一个具体的分布式系统都需要在一致性和系统性能之间进行考虑和权衡。于是,一致性级别由此诞生:

- 强一致性:要求系统写入什么,读出的就是什么,符合用户直觉,但是对系统的性能影响较大。

- 弱一致性:系统写入后,不要求立即能读到最新的值,也不要求多久之后一定能读到最新的值,但会尽可能保证一定时间后能读到最新的值

- 会话一致性:保证对于写入的值,同一个客户端会话中可以读到一致的值,其他的会话不保证

- 用户一致性:保证对于写入的值,同一个用户可以读到一致的值,其他的用户不保证

- 最终一致性:是弱一致性的特例,系统保证最终能达到一致,它是非常重要的一种一致性模型。

二、分布式架构

2.1 从集中式到分布式

自 20世纪 60年代大型主机被发明出来以后,集中式的计算机系统架构成为了主流。由于大型主机卓越的性能和良好的稳定性,其在单机处理能力方面的优势非常明显,使得 IT系统快速进入了集中式处理阶段,其对应的计算机系统称为集中式系统。

但从 20世纪 80年代之后,计算机系统向网络化和微型化的发展日益明显,传统的集中式处理模式越来越不能适应人们的需求:

- 大型主机操作复杂,运营人才培养成本高

- 昂贵

- 单点故障

- 普通 PC机性能不断提升,网络技术快速普及

集中式的特点:

- 由一台或多台主计算机组成中心节点,数据集中存储在中心节点上,所有业务单元集中部署在中心节点上;其他终端或客户端机器仅负责数据的录入和输出,而数据的存储和控制完全交由主机来完成。

- 部署结构简单,基于底层性能卓越的大型主机,无需考虑对服务进行多个节点的部署,因此不需要考虑多个节点间的分布式协作问题。

分布式的特点:

分布式系统是一个硬件或软件组件分布在不同的网络计算机上,彼此之间仅仅通过消息传递进行通信和协调的系统,它一般具体以下几个特征:

- 分布性:多台计算机在空间上随意分布,且分布情况随时变动

- 对等性:分布式系统中的计算机没有主从之分,组成分布式系统的所有计算机节点都是对等的。通过数据副本和服务副本对数据和服务提供冗余,可以解决数据丢失、服务失效等问题。每个节点都有能力接收外部请求,处理数据。

- 并发性:同一个分布式系统中的多个节点,可能会并发地操作一些共享的资源,因此需要准确、高效地协调并发操作。

- 缺乏全局时钟:分布式系统中的进程间通过交换消息进行相互通信,但是很难定义两个事件的先后顺序,因为缺乏一个全局的时钟序列控制。

- 故障总会发生:组成分布式系统的所有计算机,都有可能发生任何形式的故障。

分布式环境的各种问题:

- 通信异常:节点之间通过网络进行交互,但是网络本身是不可靠的;且因为基于网络,其延时会远大于单机操作,网络延迟会可能会导致消息的丢失和延迟。

- 网络分区:因为网络时延的影响,导致部分节点间交互断裂,集群中仅剩下小部分节点能正常通信,即“脑裂”。当脑裂问题产生后,产生的局部小集群可能会继续工作,就会产生事务、数据方面的问题。

- 三态:分布式系统因为网络的影响,每一次请求与响应,存在”三态“的概念:成功、失败和超时。超时即表示消息丢失,它可能发生在请求阶段,也可能发生在响应阶段。

- 节点故障:组成分布式系统的服务器节点出现宕机或假死现象,每个节点都可能发生。

2.2 从 ACID到 CAP/BASE

分布式系统在 事务处理和 数据一致性上容易遇到麻烦。

ACID

事务(Transaction)指的是由一系列的数据操作所组成的一个逻辑单元(Unit)。当多个应用程序并发访问数据库时,事务可以提供隔离;当数据库操作失败后,事务可以提供从失败中恢复回正常的方法,事务具有四个特征,分别是原子性(Atomicity)、一致性(Consistency)、隔离性(Isolation)、持久性(Durability),简称为事务的 ACID特性。

- 原子性:事务必须是一个原子的操作序列单元,要么全部成功执行,要么全部失败不执行;任何一项操作的失败都会导致整个事务的失败,同一事务内之前到操作都会回滚。

- 一致性:事务的执行不得破坏数据库数据的完整性和一致性,一个事务在执行前后,都必须处于一致的状态。事务的执行必须是从一个一致状态转变到另一个一致状态。

- 隔离性:并发的事务间相互隔离,事务间不能相互干扰。标准的 SQL规范中定义了 4个事务隔离级别:

- 读未提交(Read Uncommited):事务 A可以读取到事务 B未提交的修改数据,即允许脏数据的读取,其隔离级别最低。

- 读已提交(Read Committed):事务 A在运行期间可以读取到事务 B刚完成提交的数据,解决了脏读问题,但在事务 A的运行过程中某个值可能是不确定的,因此会有不可重复读的问题。

- 可重复读(Repeatable Read):事务 A 在运行期间多次读取一个值,其值和事务开始时的值是一样的,能避免读取其他事务的提交而发生修改的值,解决了不可重复读问题,但是无法避免读到因其他事务的提交而新创建的值,因此会有幻读的问题。

- 串行化(Serializable):最严格的隔离级别,所有事务串行执行。

| 隔离级别 | 脏读 | 不可重复读 | 幻读 |

|---|---|---|---|

| 读未提交 | 存在 | 存在 | 存在 |

| 读已提交 | 不存在 | 存在 | 存在 |

| 可重复读 | 不存在 | 不存在 | 存在 |

| 串行化 | 不存在 | 不存在 | 不存在 |

- 持久性:一个事务一旦提交,它对数据库中的数据的操作就应该是永久性的。即使之后发生系统故障,已提交的事务结果也必须能复现。

分布式事务

事务在分布式领域内也得到了广泛的应用,在单机数据库中,我们能很容易地实现满足 ACID特性的事务处理系统,但在分布式环境下,数据分散在不同的机器上,事务的参与者、支持事务的服务器、资源服务器和事务管理器都可能位于不同的节点上,因此事务的功能就很难实现。

CAP

2000年 7月,来自加州大学伯克利分校的 Eric Brewer教师再 ACM PODC会议上,提出了 CAP猜想;两年后,来自 MIT的 Seth Gilbert和 Nancy Lynch从理论上证明了 CAP猜想的可行性。

CAP理论告诉我们,一个分布式系统不可能同时满足一致性、可用性和分区容错性这三个基本需求,最多只能同时满足其中的两项。

- 一致性(Consistency):在分布式环境中,数据在多个副本间能否保持一致性的特性。在分布式系统中,如果能做到针对一个数据项的更新,所有其他用户都能读取立刻读取到最新的值,就称之为强一致性

- 可用性(Availability):分布式系统提供的服务必须一直处于可用的状态,对于用户的每一个请求都必须在有限的时间内返回结果,如果超过了时间,就会认为是不可用的。它强调具体的某个服务。

- 分区容错性(Partition Tolerance):分布式系统在遇到任何网络分区故障的时候,仍然需要能保证对外提供满足一致性和可用性的服务。此外,分布式系统中每一个节点的加入和退出都可以看作是一个特殊的网络分区变化。它强调整体的部署。

| 放弃 CAP 定理 | 说 明 |

|---|---|

| 放弃 C | 放弃一致性,指的并不是完全放弃。 而是放弃强一致性,但是会追求 最终一致性;也就是说,系统不保证数据实时一致,但是最终一定会达到一个一致的状态。 |

| 放弃 A | 一旦遇到系统网络分区或者其他故障时,那么期间的受灾节点可以允许不提供正常的服务 |

| 放弃 P | 放弃 P就意味着放弃分布式系统的扩展性 因为放弃 P只有一个方式,就是将所有的数据都存到一个节点上,一荣俱荣,一损俱损,等于单机 |

因此可以明确:分布式系统不能同时满足 CAP三个特性;对于分布式系统而言,P是一个必须满足的特性。

首先我们应有个基本的理解, 系统部署在多个结点, 各个结点是需要进行通信, 数据共享的. 假如我们有3个结点.

如果满足C(一致性), 也就是说当Server1收到一条最新的数据, 需要把这条数据广播到Server2和Server3, 在广播期间, 为了保证一致性, Server是不对外保证服务的. 所以在有限时间内, 不能保证所有结点的可用性, 也就是CAP中的A.

如果满足A(可用性), 很显然, Server1收到一条新的数据更新, 在数据更新到Server2和Server3期间, 如果有新的请求到Server2和Server3, 那么Server1和Server2或者Server1和Server3之间的数据是不一致的, 也就是满足不了CAP中的C.

BASE

BASE是 Basiclly Available、Soft state和 Eventually consistent三个短语的简写,是由来自 eBay的架构师 Dan Pritchett在其文章 BASE: An Acid Alternative中第一次明确提出的。它是对 CAP中一致性和可用性权衡的结果,是基于 CAP定理逐步演化而来的,其核心思想是即使无法做到强一致性(Strong consistency),但每个应用都可以根据自身的业务特点,采用适当的方式实现最终一致性。

- 基本可用:指当分布式系统在出现不可预知的故障时,允许损失部分可用性。

- 允许响应时间上的损失

- 允许功能上的损失

- 弱状态:允许系统中的数据存在中间状态,并认为该中间状态不会影响系统的整体可用性,即允许系统在不同节点的数据副本之间进行数据同步的过程存在延时。

- 最终一致性:强调系统中所有的数据副本,在经过一段时间的同步后,最终能达到一个一致的状态。最终一致性,可以看作是一种特殊的弱一致性,允许在没有发生故障的前提下,数据达到一致状态的时间延迟。实际工程实践中,最终一致性有以下五类变种:

- 因果一致性(Causal consistency):如果进程 A在更新完某个数据项后通知进程 B,那么进程 B之后对该数据项的访问一定呢给你获取到进程 A更新后的值,而与进程 A无因果关系的进程 C对该数据项的访问则不保证。

- 读己之所写(Read your writes):进程 A更新一个数据项之后,自己一定能访问到更新过的新值,而不会获取到旧值。

- 会话一致性(Session consistency):将对系统数据的访问过程框定在一个会话中,系统保证在同一个有效会话中实现【读己之所写】的一致性。

- 单调读一致性(Monotonic read consistency):一个进程在读取到新值之后,再次反复读取,一定不会再读到旧值

- 单调写一致性(Monotonic write consistency):一个进程的写从中,被顺序地执行

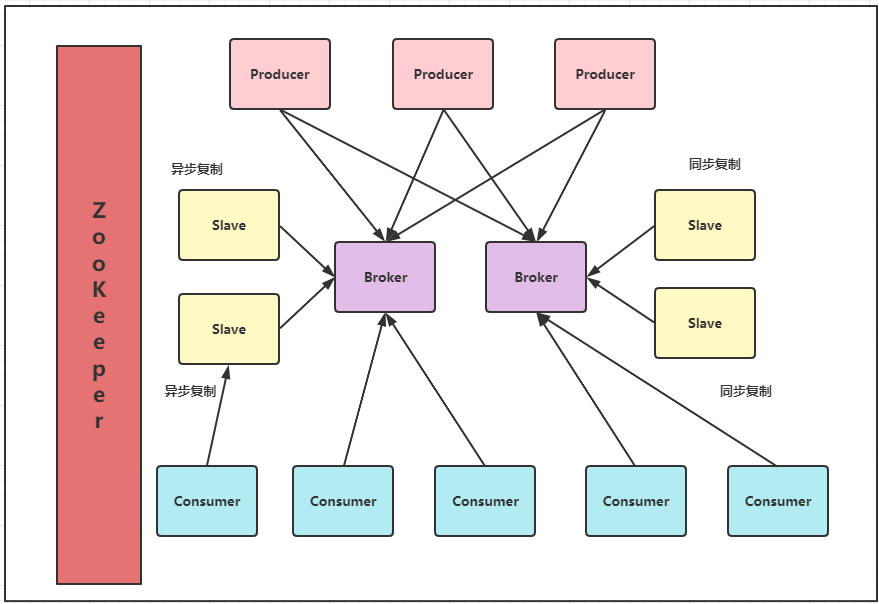

在现代关系型数据库中,许多都会采用最终一致性模型,它们会采用同步和异步的方式来实现主备数据复制技术。

- 在同步方式中,数据的复制过程通常是更新事务的一部分,因此在事务完成后,主备数据库的数据就会达到一致;

- 在异步方式中,备库的更新往往会存在延时,这取决于事务日志在主备数据库之间传输的时间长短;

2.3 小结

BASE理论面向大型高可用可扩展的分布式系统,和传统的 ACID特性相反,它完全不同于 ACID的强一致性模型,而是提出通过牺牲强一致性来获得可用性,并允许数据在一段时间内是不一致的,但最终达到一致状态。同时,在实际的分布式场景中,不同业务单元和组件对数据一致性的要求是不同的,因此在具体的分布式系统架构设计过程中,ACID特性与 BASE理论又往往会结合在一起使用。

♥ 三、一致性协议

2.1 2PC 与 3PC

在分布式系统中,每一个机器节点仅能获知自己在事务操作中的结果是成功或失败,但无法获知其他分布式节点的操作结果。

因此当一个事务需要跨越多个分布式节点的时候,为了保持事务处理的 ACID特性,就需要引入一个”协调者“(Coordinator)的组件来统一调度所有分布式节点的执行逻辑,这些被调度的分布式节点被称为“参与者”(Participant)。Coordinator负责调度 Participant的行为,并最终决定这些 Participant是否要把事务真正进行提交。

2PC

2PC,是 Two-Phase Commit的缩写,即二阶段提交,是一种一致性协议,能保证分布式系统数据的一致性。目前,绝大多数的关系型数据库都是采用 2PC来完成分布式事务处理的,利用该协议能够非常方便地完成所有分布式事务参与者的协调,统一决定事务的提交或回滚。

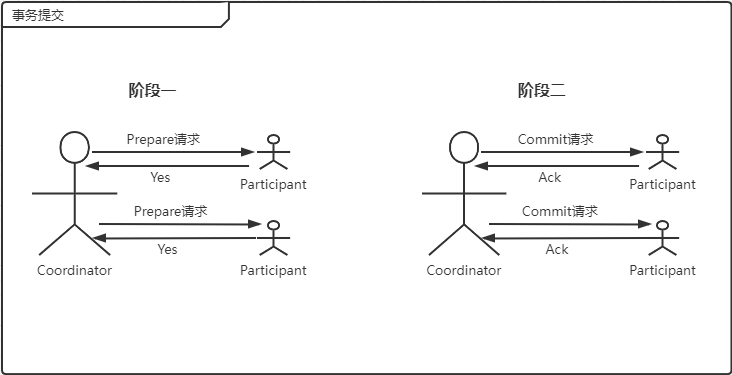

顾名思义,二阶段提交协议就是将事务的提交过程分成两个阶段来进行处理,执行流程如下:

- 阶段一:提交事务请求

- 事务询问:Coordinator向所有的 Participants发生事务内容,询问是否可以开始事务操作,并等待各 Participant的响应

- 执行事务:各 Participant执行事务操作,并将 Undo和 Redo信息记录到事务日志中

- 反馈事务:如果 Participant成功执行了事务操作,那么就反馈给 Coordinator Yes响应;否则反馈 No响应

- 阶段二:执行事务提交

- 执行事务提交:如果 Coordinator接收到的都是 Yes响应,那么就会执行事务提交

- 发送提交请求:Coordinator向所有的 Participants发送 Commit请求

- 事务提交:各个 Participant接收到 Commit请求后,会正式执行事务提交操作,并在完成提交后释放在整个事务执行期间占用的事务资源

- 反馈事务提交结果:各个 Participant在完成事务之后,向 Coordinator发送 Ack信息

- 完成事务:Coordinator接收到所有的 Ack消息后,认定完成了事务

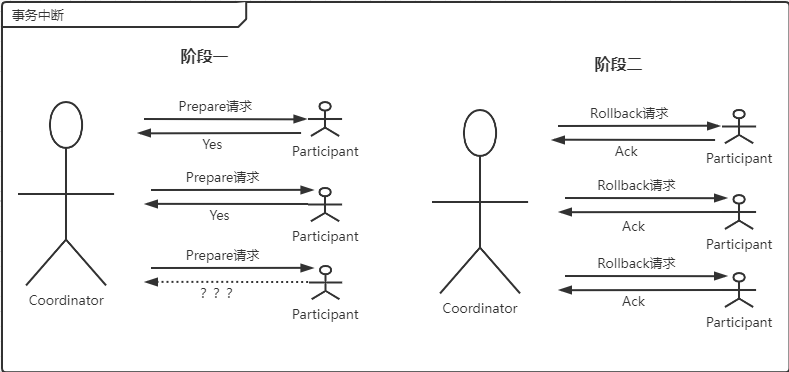

- 中断事务:Coordinator一旦接收到了一个 No响应,或者在等待超时后,就会中断事务

- 发送回滚请求:Coordinator向所有的 Participants发送 Rollback请求

- 事务回滚:各个 Participant利用其记录的 Undo信息来执行事务的回滚操作,并在完成回滚后释放在整个事务执行期间占用的事务资源

- 反馈事务回滚结果:各个 Participant在回滚事务之后,向 Coordinator发送 Ack信息

- 中断事务:Coordinator接收到所有的 Ack消息后,认定回滚了事务

- 执行事务提交:如果 Coordinator接收到的都是 Yes响应,那么就会执行事务提交

二阶段提交将一个事务的处理过程分为了【投票】和【执行】两个阶段,其核心是对每个事务都采用先尝试后提交的处理方式,因此可以看作是一个强一致性的算法。

2PC的优点:原理简单,实现方便

2PC的缺点:同步阻塞、单点问题、脑裂、太过保守

- 同步阻塞:在 2PC的提交过程中,所有参与事务的逻辑都处于阻塞状态,也就是说各个 Participant在等待的其他 Participant响应的过程中,都无法进行其他任何的操作。

- 单点问题:一旦 Coordinator出现问题,整个 2PC都无法允许,更为严重的是,当 Coordinator在第二阶段出现问题,那么其他的所有 Participants都会一直处于锁定事务资源的状态,无法继续完成事务操作

- 脑裂:在 2PC的第二阶段进行事务提交的时候,当 Coordinator向所有的 Participants发送 Commit请求时,若发生了局部网络异常或者 Coordinator在尚未发生完全部 Commit请求前,自身先发生了崩溃,那么将导致只有部分 Participants会进行事务的提交,而其他没有收到 Commit请求的参与者则无法进行事务提交,于是整个分布式系统便会出现数据不一致现象。

- 太过保守:如果在 2PC的第一阶段询问时,便有某 Participant出现故障,导致 Coordinator无法收到明确的 Yes/No响应,那么其实 Coordinator只能依靠自身的超时机制来判断是否需要中断事务

3PC

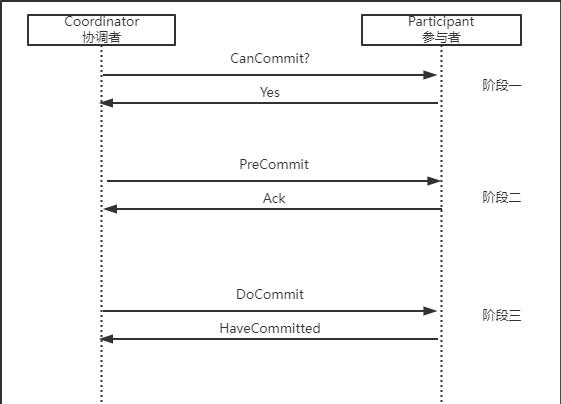

3PC,是 Three-Phase Commit的缩写,即三阶段提交,是 2PC的改进版,将其 2PC的 一阶段又进行了划分,形成了由 CanCommit、PreCommit和 DoCommit三个阶段组成的事务处理协议。

-

阶段一:CanCommit

- 事务询问:Coordinator向所有的 Participants发送一个包含事务内容的 canCommit请求,询问是否可以执行事务提交的操作,并且开始等待各 Participant的响应

- 反馈事务:各 Participant在接收到来自 Coordinator的 canCommit请求后,正常情况下,如果其自身认为可以顺利执行事务,那么会反馈 Yes,并进入预备状态;否则返回 No

-

阶段二:PreCommit

-

执行事务预提交:如果 Coordinator从所有的 Participants获得的反馈都是 Yes,那么就会执行事务的预提交

- 发送预提交请求:Coordinator向所有的 Participants发送 preCommit请求,并进入到 【预提交】阶段

- 事务预提交:各个 Participant接收到 preCommit请求后,会执行事务,并将 Undo和 Redo信息记录到日志中

- 反馈事务:各 Participant向 Coordinator反馈事务执行的响应,如果成功则返回 Ack

-

中断事务:如果 Coordinator收到了一个 No响应,或者等待超时,那么就会中断事务

- 发送中断请求:Coordinator向所有的 Participants发送 abort请求

- 中断事务:各个 Participant在收到 abort请求,或者等待超时,都会中断事务

-

-

阶段三:DoCommit

- 执行提交:如果 Coordinator收到了所有 Participants的 Ack反馈

- 发送提交请求:如果 Coordinator处于正常工作状态,并且接收到了来自所有 Participants的 Ack响应,那么它将从【预提交】状态切换到【提交】状态,并向所有的 Participants发送 doCommit请求

- 事务提交:各个 Participant接收到 doCommit请求后,会正式执行事务提交操作,并在完成后释放资源

- 反馈事务:各个 Participant在完成事务后,向 Coordinator发送 Ack消息

- 完成事务:Coordinator接收到所有 Participants的 Ack消息,完成事务

- 中断事务:如果 Coordinator收到 No响应,或者等待超时,那么就会中断事务

- 发送中断请求:Coordinator向所有的 Participants发送 abort请求

- 事务回滚:各个 Participant接收到 abort请求后,会利用其在阶段二中记录的 Undo日志来回滚事务,并在完成后释放资源

- 反馈事务:各个 Participant在完成事务回滚之后,向 Coordinator发送 Ack消息

- 中断事务:Coordinator接收到所有 Participants的 Ack消息,中断事务

- 执行提交:如果 Coordinator收到了所有 Participants的 Ack反馈

需要注意的是:一旦进入阶段三,可能会存在以下两种故障:

- Coordinator出现问题

- Coordinator和 Participant之间的网络出现问题

无论出现哪种情况,最终都会导致 Participant无法及时接收到来自 Coordinator的 doCommit或是 abort请求,针对这样的异常情况,Participant会在等待超时后,继续进行事务提交。

3PC的优点:降低了 Participant的阻塞范围,且能够在产生单点故障后继续达成一致

3PC的缺点:当 Participant在接收到 preCommit请求后,如果出现网络分区,Coordinator和 Participant无法通信,那么 Participant依旧会进行事务的提交,这必然出现数据的不一致。

2.2 Paxos算法简介

Paxos算法是 Leslie Lamport于 1990年提出的一种基于消息传递且有高度容错特性的一致性算法,是目前公认的解决分布式一致性问题最有效的算法之一。

在常见的分布式系统中,总会发生诸如机器宕机或网络异常等情况。Paxos算法解决的就是如何在一个可能发生上述异常的分布式系统中,快速且正确地在集群内部对某一个数据的值达成一致,并且保证不论发生以上任何异常,都不会破坏整个系统的一致性。

拜占庭将军问题

拜占庭帝国有许多支军队,不同军队的将军之间必须制定一个统一的行动计划,从而做出进攻或是撤退的决定,同时,各个将军在地理上都是被分隔开来的,只能依靠军队的通讯员来进行通讯。然而,在所有的通讯员中可能会存在叛徒,这些叛徒可以任意篡改消息,从而达到欺骗将军的目的。

从理论上来说,在分布式计算领域,视图在异步系统和不可靠通道上来达到一致性状态是不可能的,因此在对一致性的研究过程中,都往往假设信道是可靠的。

而事实上,大多数系统都是部署在同一个局域网中的,因此消息被篡改的情况非常罕见;并且,由于硬件和网络原因而造成的消息不完整的问题,也可以通过校验算法避免。

因此,在实际的工程实践中,可以假设不存在拜占庭问题,也即假设所有消息都是完整的,没有被篡改的。

Lamport在 1990年提出了一个理论上的一致性解决方案,通过类比阐述了”拜占庭将军问题“

在古希腊有一个叫做 Paxos的小岛,岛上采用议会的形式来通过法令,议会中的议员通过信使进行消息的传递。并且,议员和信使都是兼职的,他们随时可能离开议会厅(宕机),并且信使可能会重复传递消息(消息重复),也可能一去不复返(消息丢失)。因此,议会协议要保证在这种情况下法令仍然能够正确地产生,并且不会产生冲突

Leslie Lamport介绍

Lamport是 2013年图灵奖得主,先后多次荣获 ACM和 IEEE以及其他各类计算机重大奖项。Lamport对时间时钟、面包店算法、拜占庭将军问题以及 Paxos算法的创造性研究,极大地推动了计算机科学尤其是分布式计算的发展。

Lamport早在 1990年就已经将其对 Paxos算法的研究论文 The Part-Time Parliament提交给了 ACM TOCS Jnl.的评委,但是由于 Lamport创造性地使用故事的方式来进行算法的讨论,导致当时评委都无法理解其中的意思,时任主编要求 Lamport使用严谨的数据证明方式来描述该算法,但 Lamport拒绝修改,并主动撤销了这篇论文的提交。

1996年,来自微软的 Butler Lampson在 WDAG96大会上提出重新审视这篇分布式论文的建议,在次年的 WDAG97大会上,MIT的 Nancy Lynch也公布了其根据 Lamport的原文重新修改后的 Revisiting the Paxos Algorithm,使用数学的形式化术语定义并证明了 Paxos算法。于是在 1998年的 ACM TOCS上,这篇延迟了 9年的论文终于被接受了,也标志着 Paxos算法正式被计算机科学接受并开始影响更多的工程师解决分布式一致性问题。

后来在 2001年,Lamport本人做出让步,放弃了故事的描述方式,而是使用通俗易懂的语言重新讲述了原文,并发表了 Paxos Made Simple 论文。由于 Lamport个人自负固执的性格,使得 Paxos理论的诞生一波三折。

2.3 Paxos算法详解

Paxos算法的核心是一个一致性算法,也就是论文 The Part-Time Parliament中提到的 ”synod“算法。

问题描述

假设有一组可以提出提案的进程集合,那么对于一个一致性算法来说,需要保证以下几点:

- 在这些被提出的提案中,只有一个提案会被选定(只会认定 a=1)

- 如果没有提案被提出,那么就不会有提案被选定

- 当一个提案被选定之后,进程应该可以获取被选定的提案信息(都能看到 a=1)

对于一致性来说,安全性(Safety)需求如下:

- 只有被提出的提案才能被选定(Chosen)

- 只能有一个值被选定

- 如果某个进程认为某个提案被选定了,那么这个提案必须是真的被选定的那一个(不能只是一个人觉得,必须是所有人觉得,否则就不一致了)

从整体上来说,Paxos算法的目标就是要保证最终有一个提案会被选定(分布式节点间能针对某一个值形成共识),当提案(value)被选定之后,进程最终也能够获取到被选定的提案。

在该一致性算法中,有三个参与角色:Proposer、Acceptor和 Learner。在具体的实现中,一个进程可能充当不止一种角色。假设不同参与者之间可以通过收发消息 来进行通信,那么:

- 每个参与者以任意的速度执行,可能会因为出错而停止,也可能会重启。同时,即使一个提案被选定后(一个值被确认后),所有的参与者也都可能失败而重启,因此除非那些失败或重启的参与者可以记录某些信息(需要持久化),否则将无法确定最终的值。

- 消息在传输过程中可能会出现不可预知的延迟,也可能会重复或丢失,但是消息不会被损坏,即消息内容不会被篡改(拜占庭式的问题)。

我们暂且认为提案 == 求同的值 == value,而求同,便是指三个角色都认为某个变量可以是某个值,进而达成一致。

- 只要 Proposer发出的提案被 Acceptor接收,它就认为该 Value被 Chosen了

- 只要 Acceptor接收了某个提案,它就认为该 Value被 Chosen了

- 只要 Learner被通知了与该变量相关的消息,它就认为该 Value被 Chosen了

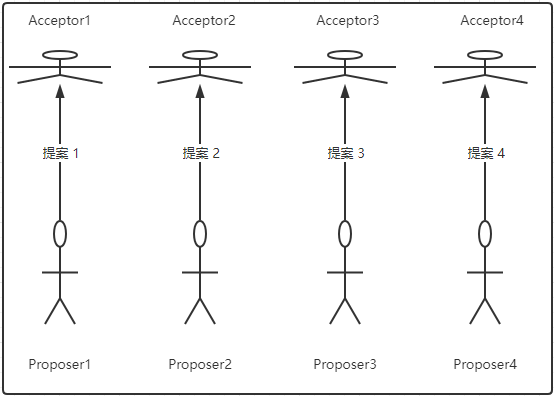

提案的选定

要选定一个唯一提案的最简单方式:只允许一个 Acceptor存在。这样的话,Proposer只能发送提案给该 Acceptor,Acceptor会选择它接收到的第一个提案作为选定的提案。这种方式很简单,但是会出现单点故障,一旦 Acceptor宕机,整个系统就无法工作了。因此,需要使用多个 Acceptor来避免 Acceptor的单点问题。

在存在多个 Acceptor的情况下,提案的选取过程为:Proposer向一个 Acceptor集合发送提案,集合中每个的 Acceptor都可能会批准(Accept)该提案,也有可能拒绝(Reject)这个提案,当有【足够多】的 Acceptor批准这个提案的时候,我们就认为该提案被选定了。此外,我们再规定每一个 Acceptor最多只能批准一个提案,那么就能保证只有一个提案被选定了。

推导过程

在没有失败和消息丢失的情况下,如果我们希望即使在只有一个提案被提出的情况下(只有一个人想说话,那么这句话就必须被听到),仍然可以选出一个提案,那么就需要:

P1:一个 Acceptor必须批准它收到的第一个提案(注意:前面规定了[每一个 Acceptor最多只能批准一个提案])

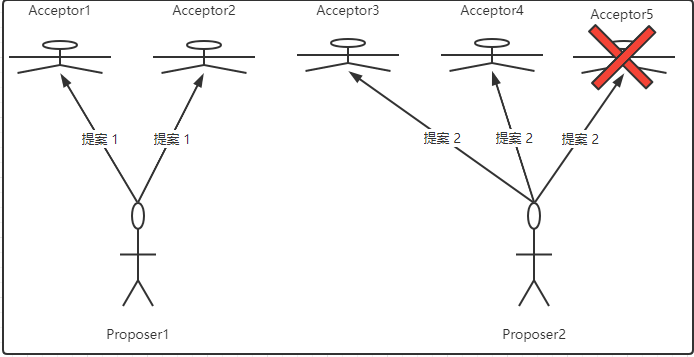

但是这样的需求存在一个问题:如果有多个提案被不同的 Proposer同时提出,这可能会导致虽然每一个 Acceptor都批准了它收到的第一个提案,但是没有一个提案是由多数人批准的,如下图。

另外,即使只有两个提案被提出,如果每个提案都被差不多一半的 Acceptor批准了,此时即使只有一个 Acceptor出错,都有可能导致无法确定选定哪一个提案,如下图。假设共有 5个 Acceptor,其中两个同意了 “提案 1”,另外三个同意了 “提案 2”,此时如果批准 “提案2”的一个 Acceptor出错了,那么此时两个提案的批准者都变成了 2个,那么就无法选定最终的提案了。

因此,在【P1】的基础上,再加上一个提案被选定需要由半数以上的 Acceptor批准的需求暗示着一个 Acceptor必须能够批准不止一个提案(打破了前面规定的[每一个 Acceptor最多只能批准一个提案]的假设)。

因为一个 Acceptor可能批准多个提案,那么就需要使用一个全局编号来唯一标识每一个被 Acceptor批准的提案,当一个具有某 Value值的提案被半数以上的 Acceptor批准后,我们就认为该 Value被选定了,即该提案被选定了。注意,此时 提案 != Value ,而是使用【编号,Value】的二元组形式定义一个提案。

我们虽然允许多个提案被选定,但是同时必须要保证所有被选定的提案都具有相同的 Value值,由此可以得到如下定义:

P2:如果编号为 M0、Value值为 V0的提案(即【M0, V0】)被选定了(所有节点都认定了 V0这个值),那么所有比 M0编号更高,且被选定的提案,其 Value值必须也是 V0

因为提案的编号是全序的,条件【P2】就保证了只有一个 Value值被选定。同时,一个提案要被选定,其首先就必须被至少一个 Acceptor批准,因此我们通过满足如下条件来满足【P2】:

P2a:如果编号为 M0、Value值为 V0的提案(即【M0, V0】)被选定了,那么所有比 M0编号更高的,且被 Acceptor批准的提案,其 Value值必须也是 V0

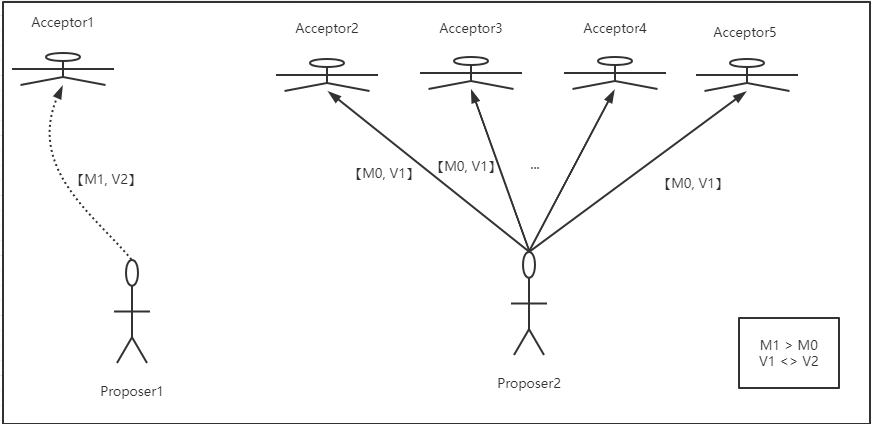

至此,我们仍然需要【P1】来保证提案会被选定,但是因为通信是异步的,一个提案可能会在某个 Acceptor还未收到任何提案的时候就被选定了,如下图。在 Acceptor1没有收到任何提案的情况下,其他 4个 Acceptor已经批准了来自 Proposer2的提案【M0, V1】,而 Proposer1产生了一个具有其他 Value值的、编号更高的提案【M1, V2】并发送给了 Acceptor1。根据【P1】,就需要 Acceptor1批准该提案,但是这与【P2a】矛盾,因此需要对【P2a】进行强化:

P2b:如果一个提案【M0, V0】被选定后,那么之后任何 Proposer产生的编号更高的提案,其 Value值都是 V0

数学归纳法证明

我们需要证明如下结论:

假设编号在 M0到 Mn-1之间的提案,其 Value值都是 V0,那么编号为 Mn的提案的 Value值也为 V0

因为编号为 M0的提案已经被选定了,这就意味着肯定存在一个由半数以上的 Acceptor组成的集合 C,C中的每一个 Acceptor都批准了该提案。因此,这就意味着:

C中的每一个 Acceptor都批准了一个编号在 M0到 Mn-1范围内的提案(至少 M0肯定是被批准了的),并且每个编号在 M0到 Mn-1范围内的被 Acceptor批准的提案,其 Value值都为 V0

又因为任何包含半数以上 Acceptor的集合 S 都至少包含 集合C 中的一个 Acceptor成员,因此我们可以认为如果保持了下面 【P2c】的不变性,那么编号为 Mn的提案的 Value也为 V0。

P2c:对于任意的 Mn和 Vn,如果提案【Mn, Vn】被提出,那么肯定存在一个由半数以上的 Acceptor组成的集合 S,满足以下两个条件中的任何一个

1. S中不存在任何批准过编号小于 Mn的提案的 Acceptor(Mn要够大)

2. 选取 S中所有 Acceptor批准的编号小于 Mn的提案,其中编号最大的那个提案,其 Value就是 Vn(Vn必须被提出过)

实际上,【P2c】规定了每个 Proposer如何产生一个提案:对于产生的每个提案【Mn, Vn】,需要满足如下条件:

存在一个由超过半数的 Acceptor组成的集合 S:

- 要么 S中没有 Acceptor批准过的编号小于 Mn的任何提案

- 要么 S中的所有 Acceptor批准的所有编号小于 Mn的提案中,编号最大的那个提案的 Value值就是 Vn

当每个 Proposer都按照这个规则来产生提案时,就可以保证满足【P2b】了。

接下来我们证明【P2c】

首先假设提案【M0, V0】被选定了,设比该提案编号大的提案为【Mn, Vn】,我们需要证明的就是在 P2c的前提下,对于所有的【Mn, Vn】,存在 Vn = V0

- 当 Mn=M0+1时,因为【M0, V0】已被选定,那么一定存在由超过半数 Acceptor组成的集合 S,S中所有 Acceptor批准的所有编号小于 Mn的提案中,编号最大的提案的 Value值为 Vn,又因为 Mn=M0+1,比 Mn小,但又最大的只有 M0,所以 Vn = V0

- 当 Mn比 M0大很多时,因为,V0被选定,所以编号在 M0+1 到 Mn-1区间内的所有提案的 Value值为 V0,那么同样的肯定存在集合 S批准了小于 Mn的提案,那么 Mn的提案的 Value值只能是 S中编号小于 Mn,但为最大编号的那个提案的 Value,即 V0。

Proposer生成提案

对于 Proposer来说,获取那些已经被通过的提案远比预测未来可能会通过的提案来的简单,因此,当 Proposer在产生一个编号为 Mn的提案时,必须要知道当前某一个将要或已经被半数以上 Acceptor批准的编号小于 Mn但为最大编号的提案。并且,Proposer会要求所有的 Acceptor都不要再批准任何编号小于 Mn的提案,由此引出了提案生成算法:

- Proposer选择一个新的提案编号 Mn,然后向某个 Acceptor集合的成员发送【Prepare请求】,要求该集合中的 Acceptor做出如下回应

- 向 Proposer承诺,保证不再批准任何编号小于 Mn的提案

- 如果 Acceptor已经批准过任何提案,那么就向 Proposer反馈当前 Acceptor已经批准过、编号小于 Mn但为最大编号的那个提案的 Value值(省点事儿,直接用别人已经提出的 Value)

- 如果 Proposer收到了来自半数以上的 Acceptor的响应结果,那么它就可以产生【Mn, Vn】的提案,这里的 Vn是所有响应中编号最大的提案的 Value值;但是,如果半数以上的 Acceptor之前都没有批准过任何提案,那么这个 Vn值就可以由该 Proposer自行选择(也就是说,第一个吃螃蟹的人必须自己整一个 Vn的值)

在确定了提案之后,Proposer就会将该提案以【Accept请求】的方式,再次发送给某一个 Acceptor集合,并期望获得批准。注意:此时接收 Accept请求的 Acceptor集合不一定是之前响应 Prepare请求的 Acceptor集合,但是二者一定至少包含一个公共 Acceptor(两个大于一半的集合间肯定存在非空交集)。

Acceptor批准提案

一个 Acceptor可能会收到来自 Proposer的两种请求,分别是 【Prepare请求】和 【Accept请求】

- Prepare请求:Acceptor可以在任何时候响应一个 Prepare请求

- Accept请求:在不违背 Accept现有承诺的前提下,可以任意响应 Accept请求

因此,对 Acceptor逻辑处理的约束条件,大体可以定义如下:

P1a:一个 Acceptor只要尚未响应过任何编号大于 Mn的 Prepare请求,那么它就可以接受这个编号为 Mn的提案(因为之前就已经限制过了提案的 Value,所以这里直接接受就行)

Paxos算法允许 Acceptor忽略任何请求而不用担心破坏其算法的安全性

算法优化

之前通过全局唯一编号,获得了一个满足安全性需求的提案选择算法,对此可以进行优化:Acceptor应尽可能地忽略 Prepare请求

假设一个 Acceptor收到了一个编号为 Mn的 Prepare请求,但此时该 Acceptor已经对编号大于 Mn的 Prepare请求做出了响应,因此它肯定不会再批准任何新的编号为 Mn的提案,那么很明显,Acceptor就没有必要对这个 Prepare请求做出响应,于是 Acceptor可以选择忽略这样的 Prepare请求。同时,Acceptor也可以忽略掉那些它已经批准过的提案的 Prepare请求。

通过这个优化,每个 Acceptor只需要记住它已经批准的提案的最大编号已经它已经做出 Prepare请求响应的提案的最大编号,以便在出现故障或者节点重启情况下,也能保证【P2c】的不变性。而对于 Proposer来说,只要它可以保证不会产生具有相同编号(编号全局唯一)的提案,那么就可以随意丢弃任意的提案以及它所有的运行时状态信息。

算法陈述

结合 Proposer和 Acceptor对提案的处理逻辑,可以得到如下类似于 2PC的执行过程:

-

阶段一

-

Proposer选择一个提案编号 Mn,然后向 Acceptor的某个超过半数的子集成员发送编号为 Mn的 Prepare请求

-

如果一个 Acceptor收到一个编号为 Mn的 Prepare请求,且编号 Mn大于该 Acceptor已经响应的所有 Prepare请求的编号,那么该 Acceptor会将已批准过的最大编号的提案作为响应反馈给 Proposer,同时承诺不会再批准任何编号小于 Mn的提案。

比如说,假定一个 Acceptor已经响应过的所有 Prepare请求对应的提案编号分别为 1、2、3 … 和 7,那么该 Acceptor在接收到一个编号为 8的 Prepare请求后,就会将编号为 7的提案作为响应反馈给 Proposer。

-

-

阶段二

- 如果 Proposer收到来自半数以上的 Acceptor对于其发出的编号为 Mn的 Prepare请求的响应,那么它就会发送一个针对【Mn, Vn】提案的 Accept请求给 Acceptor。注意:Vn的值就是收到的响应中编号最大的提案的值,如果响应中不包含任何提案,那么它由 Proposer自己指定。

- 如果 Acceptor收到针对【Mn, Vn】提案的 Accept请求,只要该 Acceptor尚未对编号大于 Mn的 Prepare请求做出响应,它就可以通过这个提案。

在实际运行中,每个 Proposer都可能会产生多个提案,但只要每个 Proposer都遵循如上所述的算法运行,就一定能保证算法执行的正确性。每个 Proposer都可以在任意时刻丢弃一个提案,哪怕针对该提案的请求和响应在提案被丢弃后会到达,但根据 Paxos算法的一系列规约,依然可以保证其在提案选定上的正确性。

事实上,如果某个 Proposer已经在试图生成编号更大的提案了,那么丢弃一些旧的提案未尝不是一个好的选择。因此,如果一个 Acceptor因为已经收到过更大编号的 Prepare请求而忽略某个编号更小的 Prepare请求或者 Accept请求,那么它也应当通知其对应的 Proposer,以便该 Proposer也能够将该提案进行丢弃。

提案的获取

- 方案一

- Learner获取一个已经被选定的提案的前提是,该提案已经被半数以上的 Acceptor批准。因此,最简单的做法就是一旦 Acceptor批准了一个提案,就将该提案发送给所有的 Learner。

- 但是,这需要让每个 Acceptor与所有的 Learner逐个通信,很低效。

- 方案二

- 让所有的 Acceptor将它们对提案的批准情况,统一发送给一个特定的 Learner(主 Learner)。当主 Learner被通知一个提案已被选定后,它会负责通知其他的 Learner。

- 这个方案虽然减少了通信次数,主 Learner存在单点故障问题

- 方案三

- 将主 Learner的范围扩大,即 Acceptor可以将批准的提案发送给一个特定的 Learner集合

- 这个 Learner集合中的 Learner个数越多,可靠性越好,但同时复杂度越高。

通过选取主 Proposer保证算法的活性

假设存在这样一种极端情况,有两个 Proposer依次提出一系列编号递增的议案,但是最终都无法被选定:

P1提出了一个编号为 M1的提案,并完成了上述 阶段一的流程。但于此同时,P2也提出了编号为 M2(M2 > M1)的提案,同样也完成了 阶段一的流程,于是 Acceptor已经承诺不再批准编号小于 M2的提案了。

因此,当 P1进入 阶段二的时候,其发出的 Accept请求被 Acceptor忽略,于是 P1又进入 阶段一并发出了编号为 M3(M3 > M2)的提案,而这又导致 P2在 阶段二的 Accept请求被忽略,以此类推,形成了死循环。

为了保证 Paxos算法流程的可持续性,以避免陷入上述提到的“死循环”,必须有一个主 Proposer,并规定只有主 Proposer才能提出提案。这样一来,只要主 Proposer和过半的 Acceptor能够正常进行网络通信,那么但凡主 Proposer提出一个编号更高的提案,该提案终将被批准。

当然,如果 Proposer发现当前算法流程中已经有一个编号更大的提案被提出或正在接收批准,那么它会丢弃当前这个编号较小的提案,并最终能够选出一个编号足够大的提案。因此,如果系统中有足够多的组件能正常工作,那么通过一个主 Proposer,整套 Paxos算法流程就能够保持活性。

2.4 Multi Paxos

之前介绍的是原始的 Paxos(Basic Paxos),只能对一个值形成决议,且决议的形成需要进行两个阶段。

而实际应用中几乎都需要连续确定多个值,因此 Multi Paxos算法被提出,它基于 Basic Paxos做出了两点改进:

- 针对一个待确定的值,运行一次 Paxos算法实例(Paxos Instance),每个实例通过 InstanceID标识

- 在所有的 Proposers中,选举一个 Leader,由 Leader唯一地提交提案给 Acceptors进行表决,可以避免 Proposer间的竞争,进而跳过 Prepare阶段,使原本的二阶段削减为一阶段即可

Multi Paxos首先需要进行 Leader的选举,其本身就是一次 Paxos决议,选出了 Leader后只能由 Leader来发布提案。

为了区分连续提交多个 Instance实例(这多个 Instance之间其实是独立的),为了区分,就需要使用 InstanceID。

Multi Paxos允许存在多个 Leader节点发布提案,但是这就会导致 Multi Paxos退化为 Basic Paxos。

如果 Multi Paxos算法中,多个 Instance均对同一个值进行修改,那么 Leander在学习的时候就会依照 InstanceID的大小依次学习,避免出现 Leander学习时候的不一致。

Chubby和 ZK都使用的是 Multi Paxos。

2.5 小结

三种一致性协议都是非常优秀的分布式一致性协议,都从不同方面不同程度地解决了分布式数据一致性的问题。

2PC解决了分布式事务的原子性问题,但存在同步阻塞、无限等待和脑裂等问题。

3PC在 2PC的基础上添加了 PreCommit过程,避免了无限等待问题。

Paxos引入了“过半”的理念,支持节点角色间的轮换,避免了单点问题,既解决了无限等待问题,又解决了脑裂问题。

三、Paxos的工程实践

3.1 Chubby

Google Chubby是一个大名鼎鼎的分布式锁服务,GFS和 Big Table等都依赖它解决分布式协作、元数据存储和 Master选举等一系列与分布式锁相关的问题。其底层实现就是以 Paxos算法为基础的,Google曾公开 Chubby的论文 The Chubby lock service for loosely-coupled distributed systems

概述

Chubby是一个面向松耦合分布式系统的锁服务,通常用于为一个由大量小型计算机构成的松耦合分布式系统提供高可用的分布式锁服务。Chubby允许它的客户端进程同步彼此的操作,并对当前所处环境的基本状态信息达成一致。

针对此,Chubby提供了粗粒度的分布式锁服务,开发人员仅需调用 Chubby的锁服务接口即可实现分布式系统中多个进程之间粗粒度的同步控制,从而保证数据的一致性。

Chubby的客户端接口设计得类似 UNIX文件系统结构,应用程序可以通过 Chubby客户端实现对 Chubby服务器上的整个文件进行读写操作,添加锁控制,订阅文件变动事件等。

应用场景

最为典型的是集群中服务器的 Master选举,如在 GFS中使用 Chubby锁服务实现对 GFS Master服务器的选举。在 Big Table中 Chubby用来定位 Master服务器,存储系统运行时的元数据。

设计目标

Chubby被设计成一个完整的、需要访问中心化节点的分布式锁服务,因为锁服务具有以下 4个传统算法库不具有的优点:

- 对上层应用程序的侵入性更小

- 便于提供数据的发布与订阅

- 开发人员对基于锁的接口更为熟悉

- 更便捷地构建更可靠的服务

因此,Chubby被设计成一个需要访问中心化节点的分布式锁服务,同时,在 Chubby的设计过程中,提出了以下几个设计目标:

- 提供一个完整的、独立的分布式锁服务,而非仅仅是一个一致性协议的客户端库

- 提供粗粒度的锁服务,更适用于长期持有锁的场景(细粒度的锁往往被设计为锁服务一旦失效,就释放锁,因为细粒度的锁持有时间短,所以放弃锁的代价小)

- 在提供锁服务的同时提供对小文件的读写功能

- 高可用、高可靠

- 提供事件通知机制

技术架构

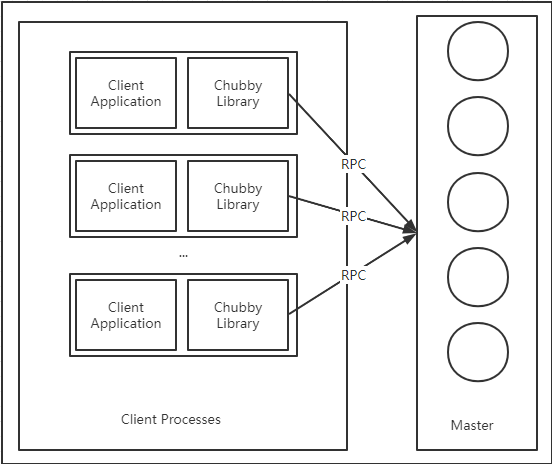

Chubby的整个系统结构主要由服务的和客户端两部分组成,客户端通过 RPC调用与服务器端进行通信

一个典型的 Chubby集群,或称为 Chubby Cell,通常由 5台服务器组成。这些副本服务器采用 Paxos协议,通过投票的方式来选举 Master。每个 Master都会有一个租期,期间 Chubby保证不会再产生其他 Master服务器。并且每个 Master运行期间可以通过续租来延长租期。因此只有在 Master宕机或集群刚启动的时候才会进行 Master的选举。

集群中的每个服务器都持有副本,但是只有 Master才能进行写操作,其他服务器都是使用 Paxos协议从 Master服务器上同步数据。

客户端定位服务器

Chubby客户端通过向记录有 Chubby服务器机器列表的 DNS来请求获取所有的 Chubby服务器列表,然后逐个发起请求询问是否为 Master。在询问过程中,如果不是 Master,那么该服务器会将当前 Master所在的服务器的标识反馈给客户端。

一旦客户端定位到到 Master服务器,只要 Master正常,就会将所有的请求都打到 Master上。

- 针对写请求,Master会通过一致性协议将其广播给所有其他节点,并且在过半的服务器都接受了该写请求后,再对客户端做出响应

- 针对读请求,Master单独处理

如果 Master崩溃了,那么其他服务器会在 Master的租期到期后,重新开启新一轮的选举,预计一半耗时几秒。如果非 Master服务器崩溃,则不会影响集群工作。新加入集群的服务器首先进行数据同步,之后才会加入到正常的 Paxos运作流程中与其他服务器副本一起协同工作。

目录与文件

Chubby的数据结构可以看作是一个由文件和目录组成的树,每个节点都可以表示为一个使用斜杠分割的字符串,如 /ls/foo/wombat/pouch

其中,ls是所有 Chubby节点所共有的前缀,代表着锁服务,是 Lock Service的缩写;foo则指定了 Chubby集群的名字,从 DNS可以查询到由一个或多个服务器组成该 Chubby集群;剩余的 /wombat/pouch则是一个真正包含业务含义的节点名字,由 Chubby服务器内部解析并定位到数据节点。

Chubby的命名空间,包括文件和目录,称为节点(nodes)。在同一个 Chubby集群中,每一个 node都是全局唯一的。

Chubby上的每个数据节点都分为 持久节点和 临时节点两大类,其中持久节点需要显式地调用接口 API来进行删除,而临时节点则会在其对应的客户端会话失效后自动删除。因此,临时节点通常可以用来进行客户端会话有效性的判断。

此外 Chubby上的数据节点中都包含少量的元数据信息,包括 4个单调递增的 64位编号:

- 实例编号:标识 Chubby创建该数据节点的顺序,按事件排序,唯一

- 文件内容编号:标识文件内容的变化情况,会在文件写入时增加

- 锁编号:标识节点锁状态变更情况,会在节点锁从自由(free)状态转换为被持有(hold)时增加

- ACL编号:标识节点的 ACL信息变更情况,会在节点的 ACL配置信息被写入时增加

同时 Chubby还会标识一个 64位的文件内容校验码,标识此文件是否变更。

锁与序列器

在分布式系统中,因为网络通信的不确定性,锁机制变得十分复杂,消息的延迟或乱序都可能导致锁的失效。

一个典型的分布式锁错乱案例(消息接收顺序紊乱导致)

客户端 C1获取到互斥锁 L,并且在锁 L的保护下发出了请求 R1,但请求 R1迟迟没有到达服务端(网络延迟或反复重发等原因),此时应用程序认为请求失败。

于是便会位另一个客户端 C2分配锁 L,然后再重新发起之前的请求 R2,此时原来的请求 R1也到达了服务端,R1因为曾经持有过锁,因此可能不受此时 L的控制,会覆盖 R2的操作,导致数据不一致。

在 Chubby中,任意一个数据节点都可以充当一个读写锁来使用:

- 一种是单个客户端以排他锁(写锁)模式持有这个锁

- 另一种是任意数目的客户端以共享锁(读锁)模式持有这个锁

并且 Chubby舍弃了严格的强制锁,客户端可以在没有获取到任何锁的情况下访问 Chubby的文件,也就是说,持有锁 F既不是访问文件 F的必要条件,也不能阻止其他客户端访问文件 F。

在 Chubby中,主要采用【锁延迟】和【锁序列器】两种策略来解决由于 消息延迟 和 重排序引起的分布式锁问题。

- 锁延迟(lock-delay):如果锁是正常被释放的,那么其他客户端可以立即获取该锁;但是如果锁是异常被释放的,那么 Chubby服务器会额外保留该锁一段时间

- 锁序列器:该策略需要 Chubby的上层应用配合;锁的持有者请求锁时需要传递锁名称、锁模式和锁序号,当客户端在使用锁时,会将锁序列器发送给服务端,服务端接收后会先检查序列器是否有效,以及是否处于恰当的锁模式等,如果没有通过检查,则拒绝该请求。

事件通知机制

为了避免大量客户端的轮询,Chubby提供了事件通知机制。客户端可以向服务端注册事件通知,当触发这些事件后,服务端就会向客户端发送对应的事件通知。具体的消息通知都是通过异步的方式发送给客户端的,常见的 Chubby事件如下:

- 文件内容变更

- 节点删除:一般在临时节点中比较常见

- 子节点新增、删除

- Master服务器转移

缓存

为了提高性能,降低因频繁的读请求给服务端带来的压力,Chubby除了提供事件通知机制外,还在客户端中实现了缓存,会对客户端文件内容和元数据信息进行缓存。

缓存机制能提高系统性能,但也提高了复杂性,Chubby中通过租期机制来保证缓存的一致性。

Chubby缓存的生命周期和 Master的租期机制紧紧相关,Master会维护每一个客户端的数据缓存情况,并通过向客户端发送过期信息的方式来保证客户端数据的一致性。在这种机制下,Chubby要么从缓存访问到一致的数据,要么访问出错,一般不会访问不到不一致的数据。而一旦租期到期,客户端就需要向服务端续租来维持缓存。

当文件数据或元数据信息被修改时,Chubby会先阻塞该修改操作,然后由 Master向所有可能缓存了该数据的客户端发送缓存过期的信号,等到 Master接收到所有相关客户端针对该过期信息的应答(客户端明确要求更新缓存 或 客户端允许缓存租期过期)后,才会继续之前的修改操作。

Chubby的缓存数据保证了强一致性!

会话和会话激活

Chubby客户端和服务端之间通过 TCP进行通信,称之为会话(Session)。

会话是有生命周期的,存在超时时间,Chubby通过心跳检测来保持会话的活性,使会话周期得以延续,称之为 KeepAlive(会话激活)

如果在 KeepAlive过程中 Session能延续,那么客户端创建的句柄、锁和缓存数据等都依然有效。

KeepAlive请求

当 Master在接收到客户端的 KeepAlive请求时,会先阻塞该请求,并等到该客户端的当前 Session即将过期时,才为其续租该会话租期,之后再响应这个 KeepAlive请求,并同时将最新的 Session过期时间反馈给客户端,

Master对于会话续期时间一般设置为 12秒,具体会根据实际的运行情况进行自动的调整。

如果 Master处于高负载下,那么会适当延迟 Session的续期时间,以减少客户端 KeepAlive请求的发送频率。

客户端在接收到来自 Master的响应后,会立即发起一个新的 KeepAlive请求,再由 Master阻塞 。。。。。。

由此可见,每一个 Chubby客户端总会有一个 KeepAlive请求阻塞在 Master服务器上;除了为客户端进行会话续租外,Master还将通过 keepAlive响应来传递 Chubby事件通知和缓存过期通知给客户端。如果 Master发现服务端已经触发了针对该客户端的事件通知或缓存过期通知,那么就会提前将 KeepAlive响应反馈给客户端。

会话超时

因为 KeepAlive响应在网络中传输的耗时,可能会导致客户端和服务器端的不一致问题,因此 Chubby客户端也会维持一个和 Master端类似的会话租期。

如果 Chubby客户端检测到本地会话超时,但是并没有接收到 Master的 KeepAlive响应,那么它将无法确定 Master是否已终止当前会话,进入 “危险状态”。此时,Chubby客户端会清空本地缓存,并标记其为不可用。之后客户端进入一个称为 “宽期限” 的时间周期,默认为 45秒。如果到期前,成功地进行了 KeepAlive,那么客户端会再次开启本地缓存;否则,客户端认为当前会话过期,中止会话。

当客户端进入危险状态时,Chubby的客户端会通过一个 “jeopardy”事件来通知上层应用程序,如果恢复正常,客户端同样会以一个 “safe”事件来通知应用程序可以继续正常运行了;但如果没能恢复,那么客户端会以一个 “expired”事件来通知应用程序当前的 Chubby会话已经超时。

上层应用通过不同的事件类型,可以做出不同的处理,针对短时间内 Chubby服务不可用的情况,客户端可以选择等待而非重启。

Master故障恢复

Master服务器上运行着 “会话租期计时器”,用来管理所有会话的生命周期。如果 Master出现了故障,那么计时器就会停止,直到选出新的 Master后才恢复计时。也就是说,从旧的 Master崩溃到新的 Master选举产生的时间将不计入会话超时的计算中,在等价于延长了客户端的会话租期。

如果新的 Master很快选出来了,那么客户端就可以在本地会话过期前与其创建连接;但如果 Master的选举花费时间很长,就会导致客户端只能清空本地的缓存,并进入 “宽期限”等待。

所以,由于 “宽期限”的存在,会话能够很好地在服务端 Master转换的时候得到维持。

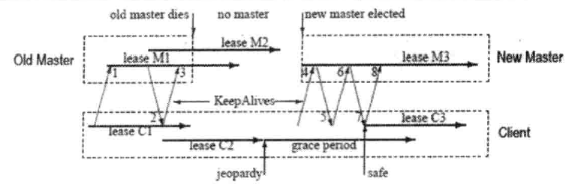

如同,一开始在旧的 Master服务器上维持了会话租期【lease M1】,在客户端上维持了对应的【lease C1】,同时客户端发送 “KeepAlive请求 1”,一直被 Master阻塞着。在一段时间之后,Master向客户端反馈了 “KeepAlive响应 2”,同时开启了新的会话租期【lease M2】,客户端在接收到响应之后又立即发送了 “KeepAlive请求 3”,并同时也开启了新的会话租期【lease C2】。随后 Master发生故障,无法反馈客户端的 “KeepAlive请求 3”。

在这个过程中,客户端检测到会话租期【lease C2】已经过期,它会清空本地缓存并进入“宽限期”,在“宽限期”开始时,客户端会向上层应用发送一个 “jeopardy”事件。此时,客户端无法确定 Master上的会话周期是否也已经过期,因此不会销毁它的本地会话,而是将所有应用程序对它的 API调用也阻塞住,以避免不一致问题的产生。

一段时间之后,服务端选举产生了新的 Master,并为该客户端初始化了新的会话租期【lease M3】,当客户端向新的 Master发送 “KeepAlive请求 4”的时候,新的 Master检测到客户端的 Master周期号(Master epoch numer)已过期,因此会在 “KeepAlive响应 5”中拒绝这个客户端请求,并将最新的 Master周期号发送给客户端。之后客户端会携带新的 Master周期号,再次发送 “KeepAlive请求 6”给 Master。最终,整个客户端和服务端的会话就会再次恢复正常。

所以,可以这么说,只要客户端的 “宽限期”足够长,那么客户端应用程序就可以在没有察觉的清空下,实现 Chubby的故障恢复,但如果 客户端的 “宽限期”很短,那么客户端就会丢弃当前会话,并将这个异常情况通知给上层应用程序。

一旦客户端与新的 Master建立连接之后,客户端和 Master之间就可以通过相互配合实现故障的平滑恢复。一个新的 Master服务器选举产生之后,会进行如下几个主要处理:

- 新的 Master选举产生之后,首先需要【确定 Master周期】。Master周期是用来唯一标识一个 Chubby集群的 Master统治轮次,以便区分不同的 Master。一旦新的 Master周期确定下来之后,Master就会拒绝所有携带旧的周期的客户端请求,同时告知其最新的 Master周期。即使新选举的就是原来的那个 Master,也会如此。

- 立即响应客户端的 Master寻址操作,但是不会立即开始处理客户端会话相关的请求操作。

- Master根据本地数据库中存储的会话和锁信息,来构建服务器的内存状态。

- 此时 Master已经能够处理客户端的 KeepAlive请求了,但依然无法处理其他会话相关的操作。

- Master会发送一个 “Master 故障切换”事件给每一个会话,客户端收到之后会立刻清空自己的本地缓存并通知上层应用

- Master会一直等待客户端的应答,直到每一个会话都应答了这个切换事件

- 在 Master接收到了所有的应答之后,就能够开始处理所有的请求操作了

- 如果客户端使用了一个在故障切换之前的句柄,Master会为其重新创建一个句柄的内存对象。如果该句柄在之前的 Master周期中已经被关闭了,那么就不会重创了。

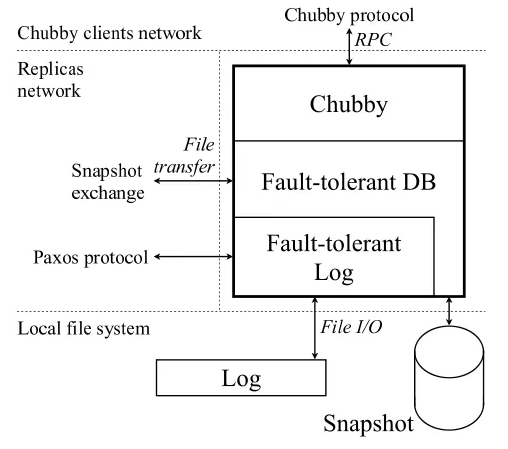

Paxos协议实现

Chubby服务端的基本架构可分为三层:

- 最底层的是【容错日志系统(Fault-Tolerant Log)】,通过 Paxos算法能够保证集群中所有机器上的日志完全一致,同时具备较好的容错性

- 日志层之上是【Key-Value类型的容错数据库(Fault-Tolerant DB)】,通过下层的日志来保证一致性和容错性

- 存储层之上就是 Chubby对外提供的【分布式锁服务】和【小文件存储服务】

Paxos算法的作用就在于保证集群内各个副本节点的日志能够保持一致。

Chubby事务日志中的每一个 Value对应 Paxos算法的一个 Instance,由于 Chubby需要对外提供不间断的服务,因此事务日志会无限增长,于是在整个 Chubby运行过程中,会存在多个 Paxos Instance(同时进行多个 value值的确定)。同时,Chubby会为每一个 Paxos Instance都按序号分配一个全局唯一的 InstanceID,并顺序写入到事务日志中。

在Multi Paxos Instance的模式下,为了提升算法执行的性能,就必须选举出一个副本节点作为 Paxos算法的主节点(称为 Leader或 Coordinator),以避免因为每一个 Paxos Instance都提出提案而陷入多个 Paxos Round并存的情况(一个 Proposer提出一个提案,交由一群 Acceptors裁决就可以看作一个 Round)。同时,Paxos会保证在 Leader重启或出现故障而进行切换的时候,允许出现 **短暂的多个 Leader共存 **但不影响副本之间的一致性。

在 Paxos中,每个 Paxos Instance都会进行一轮或多轮的 “Prepare -> Promise -> Propose -> Accept”这样完整的二阶段请求过程来完成对一个提案值的选定(一个 Instance可以看作是一个 Basic Paxos),而多个 Instance之间是完全独立的,每个 Instance可以自己决定每一个 Round的序号(【编号,Value】),仅仅只需要保证在 Instance内部不会出现序号重复即可(保证 Instance内编号的唯一即可)。为了在保证正确性的前提下,尽可能地提高算法运行性能,可以让多个 Instance共用一套序号分配机制将 “Prepare -> Promise”合并为一个阶段(多个 Instance执行同一次 “Prepare -> Promise”,但之后的 “Propose -> Accept”还是独立的),具体做法如下:

- 当某个副本节点通过选举成为 Leader后,就会使用新分配的编号 N来广播一个 Prepare消息,该 Prepare消息会被所有未达成一致的 Instance和目前还未开始的 Instance共用(N作为编号,而不是 InstanceID)

- 当 Acceptor接收到 Prepare消息后,必须对多个 Instance同时做出回应,它会将这些反馈信息封装在一个数据包中来实现。假设最多允许 K个 Instance同时进行提案指的选定(K个 Basic Paxos并发执行),那么:

- 当前至多存在 K个未达成一致的 Instance,将这些未决的 Instance各自最后接受的提案值(若该提案尚未接受,就用 null替代)封装进一个数据包,作为 Promise消息返回。

- 同时,判断 N是否大于当前 Acceptor的 highestPromisedNum(当前已经接受的最大提案编号),如果大于该值,那么就记录为 highestPromisedNum,之后这些 Instance都不会再接受小于 N的提案

- 然后 Leader就可以对所有未决 Instance和所有未来 Instance分别执行 “Propose -> Accept”阶段的处理。如果当前 Leader能够一直稳定运行的话,那么在接下来的算法中,不再需要 “Prepare -> Promise”的处理了;但是,一旦 Leader发现了 Acceptor返回了一个 Reject消息,说明集群中已经出现了另一个 Leader,并且试图使用更大的提案编号,那么当前 Leader就需要重新分配新的、更大的提案编号,并再次进行 “Prepare -> Promise”阶段的逻辑处理。

通过该算法,在 Leader稳定的情况下,多个 Instance使用同一个编号(不是 InstanceID)来一次执行每一个 Instance的 “Promise -> Accept”处理。一个 Instance完成后就可以将对应的 Value值写入本地事务日志并广播 COMMIT消息给其他的副本节点,其他副本节点在接收到 COMMIT消息后也会写入本地事务日志。如果某个副本没有收到 COMMIT,它可以主动向集群中的其他副本节点进行查询。至此,就实现了满足一致性的日志副本,并在此基础上实现了一直的状态机副本,即容错数据库层。

副本宕机后恢复

集群中副本宕机后重启,需要恢复原状,最简单的方法是 redo一遍事务日志,但是事务日志可能积累得很多,恢复时间会很长。因此需要定期对状态机做一个快照并存入磁盘,之后就可以将这之前的日志删除。

通常副本宕机后会出现磁盘 未损坏 或 已损坏两种情况。针对前者,只需要快照 + 日志即可恢复。针对后者,无法直接从本地数据恢复。

副本节点在宕机重启后,一般不会立即参与 Paxos Instance的流程,而是需要等待 K个 Paxos Instance流程成功完成之后才能开始参与,这样可以保证新分配的提案编号不会和自己以前发过的重复。

并且得益于 Paxos算法的容错机制,只要任意时刻保证多数派的机器能够正常运行,那么在宕机瞬间未能写入磁盘的数据(没有 flush到磁盘)也可以通过其他正常的副本上复制恢复,因此不需要实时地进行事务日志的 flush操作,可以大幅度提高事务的写入效率。

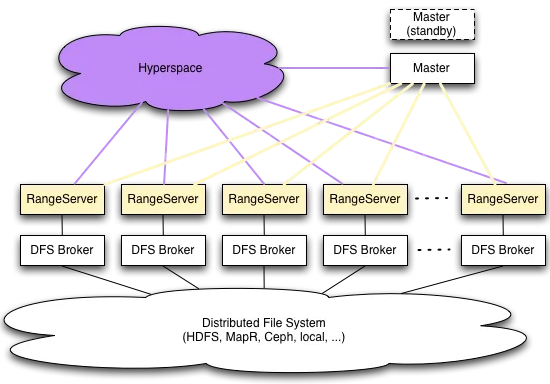

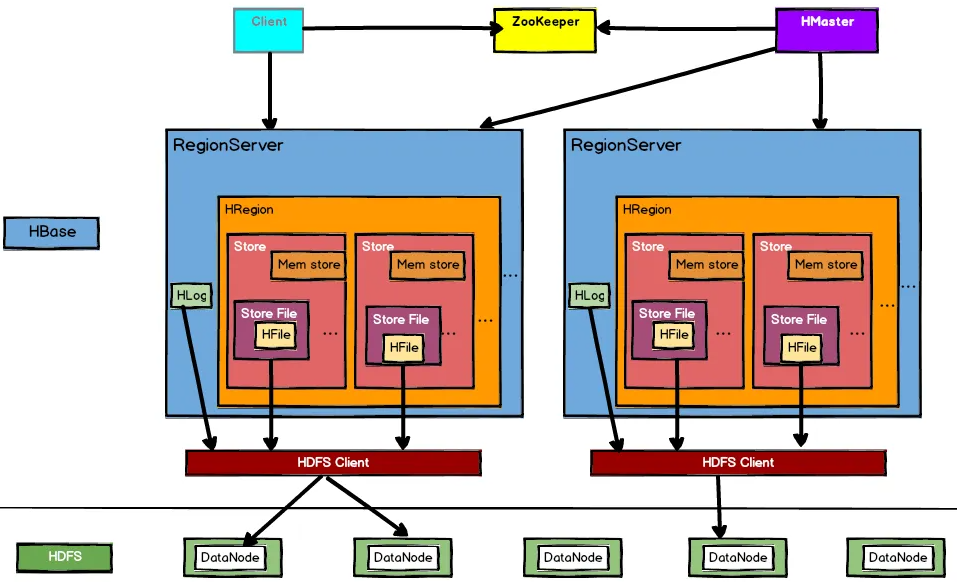

3.2 Hypertable

Hypertable基于 Google的 BigTable论文为基础,采用与 HBase相似的分布式模型,是一个针对分布式海量数据的高并发数据库。

概述

Hypertable的优势在于:

- 支持对大量并发请求的处理

- 支持对海量数据的管理

- 扩展性良好,在保证可用性的前提下,能够通过随意添加集群中的机器来实现水平扩容

- 可用性极高,具有非常好的容错性,任何节点的失效,不会造成系统的瘫痪或数据的完整性

Hypertable的核心组件包括 Hyperspace、RangeServer、Master和 DFS Broker四部分。

Hyperspace提供对分布式锁服务的支持和元数据的管理,是保证 Hypertable数据一致性的核心。类似 Chubby。

RangeServer是实际对外提供服务的组件单元,负责数据的读取和写入。

Master是元数据管理中心,管理包括创建表、删除表或是其他表空间变更在内的所有元数据操作,同时检测 RangeServer的工作状态,在 RangeServer宕机后能自动对 Range重新分配。

DFS Broker是底层分布式文件系统的抽象层,衔接上层 Hypertable和底层文件存储。所有对文件系统的读写操作都是通过 DFS Broker完成的。

算法实现

Hyperspace通常以集群的形式部署,由 5~11台服务器组成,其中会选举出一个 Active Server,其余的都是 Standby Server,二者之间会进行数据和状态的实时同步。

在 Hypertable启动初始化的期间,Master模块会随机连接 Hyperspace集群中的任意一台服务器,如果这台 Hyperspace服务器恰好处于 Active状态,那么便完成了初始化;否则,如果处于 Standby状态,那么该服务器会将当前处于 Active状态的服务器地址发送给 Master,Master会重新连接。之后 Master的所有操作都发送给这个 Active Hyperspace服务器。也就是说,只有 Active Hyperspace才能真正对外提供服务。

而在 Hyperspace集群中,BDB(Berkley Database)也很重要。BDB服务也是采用集群部署的,也存在 Master角色,是 Hyperspace底层实现分布式数据一致性的核心。在 Hypertable对外提供服务的时候,任何对于元数据的操作,Master模块都会将其对应的事务请求发送给 Hyperspace服务器。在 BDB服务器接收到该事务请求后,会采用 Paxos的逻辑进行投票,得到半数以上的投票后就会反馈 Hyperspace,再由 Hyperspace反馈给 Master。

当某台处于 Active状态的 Hyperspace服务器出现故障时,集群中剩余的服务器会自动进行 Active选举。其核心逻辑是:根据所有服务器上事务日志的更新时间来确定哪个服务器的数据最新,越新的越可能被选为 Active Hyperspace。完成 Active选举后,剩下的 Standby Hyperspace会和新选出来的服务器进行数据同步,即所有 Hyperspace服务器对应的 BDB数据库的数据都需要和 Master BDB保持一致。

3.3 小结

Paxos算法晦涩难懂,学习成本高;但是其具有超强的容错能力和对分布式数据一致性的可靠保障。

四、ZooKeeper与 Paxos

4.1 初识 ZooKeeper

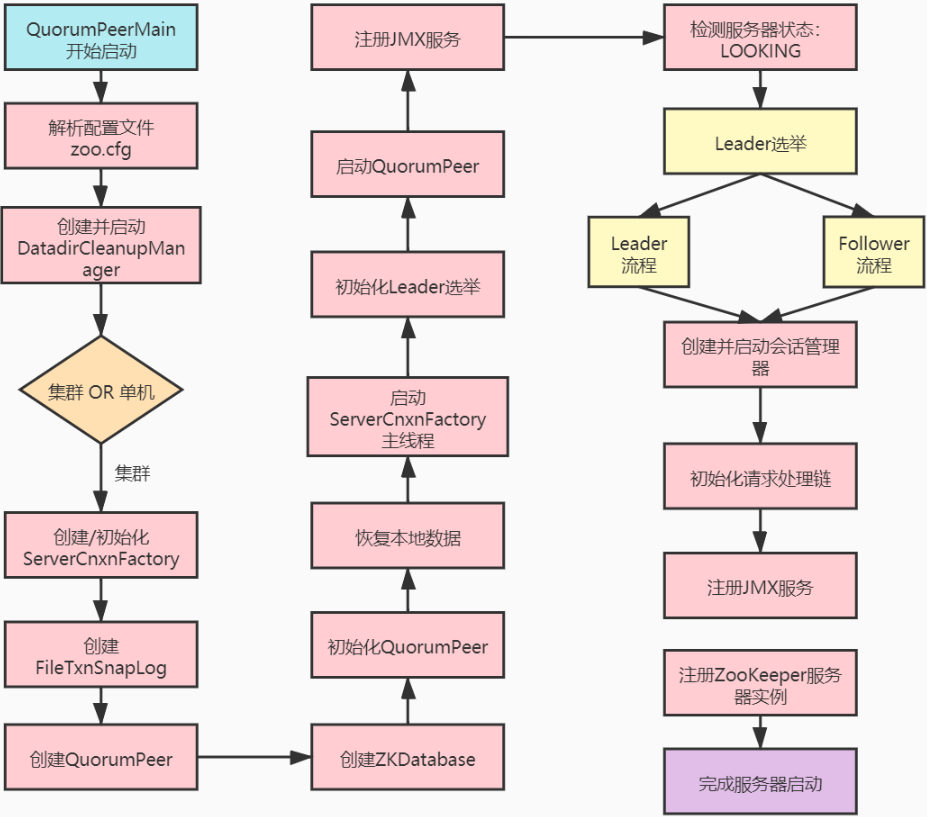

ZooKeeper为分布式应用提供了高效且可靠的分布式协调服务,提供了诸如统一命名服务、配置管理和分布式锁等基础服务。在解决分布式数据一致性方面,ZooKeeper并没有直接采用 Paxos算法,而是采用了 ZAB算法(ZooKeeper Atomic Broadcast)。

ZooKeeper介绍

ZK是一个开源的分布式协调服务,由雅虎创建,是 Chubby的开源实现。其设计目标为将那些复杂且容易出错的分布式一致性服务封装起来,构成一个高效可靠的原语集,并以一系列简单的接口提供给用户使用。

分布式应用程序可以基于 ZK实现诸如数据发布/订阅、负载均衡、命名服务、分布式协调/通知、集群管理、Master选举、分布式锁和分布式队列等功能。ZK可以保证如下分布式一致性特性:

- 顺序一致性:同一个客户端发起的多个事务请求,会严格按照发起顺序被 ZK执行

- 原子性:所有事务请求的处理结果在整个 ZK集群中的应用情况是一样的,不会出现部分机器应用了,部分没应用的情况

- 单一视图:无论客户端连接的是哪一个 ZK服务器,其看到的服务端数据模型都是一致的

- 可靠性:一旦某个事务被成功地应用了,那么它带来的服务端状态变更一定会被保留下来,直到下一个事务的作用

- 实时性:ZK保证在一定的时间段内,客户端最终一定能够从服务端上读到最新的数据状态

ZooKeeper设计目标

ZK追求高性能、高可用,且具有严格的顺序访问控制能力。

高性能使得 ZK能够应用于那些对系统吞吐有明确要求的大型分布式系统,高可用使得分布式的单点问题得到了很好的解决,严格的顺序访问控制使得客户端能基于 ZK实现一些复杂的同步原语。

ZK的四个设计目标:

- 简单的数据模型:通过一个共享的、树形结构的名称空间进行协调;由一系列 ZNode数据节点组成,类似文件系统;全量数据都存在内存中,提高服务器的吞吐、减少延迟

- 可以构建集群:通常由 3~5台机器组成;每台机器都会在内存中维护当前服务器状态,且互相保持通信

- 顺序访问:对于每一个更新请求,ZK都会分配一个全局唯一的递增编号,反映了所有事务操作的先后顺序

- 高性能:全量数据都存在内存,直接服务于客户端的所有非事务请求,适用于读操作为主的场景

ZooKeeper从何而来

ZK最早源于雅虎研究院的一个研究小组,雅虎内部很多大型系统基本都需要依赖一个类似的系统来进行分布式协调,但这些系统往往存在单点问题。所以雅虎开发人员试图开发一个通用的无单点问题的分布式协调框架。

在立项之初,考虑到之前内部很多项目都是使用动物的名字命名的,因此雅虎的工程师希望给这个项目也取一个动物名字。时任研究院的首席科学家 Raghu Ramakrishnan开玩笑地说:“再这样下去,我们这儿就变成动物园了!”此话一处,大家都统一以动物园管理者来命名。于是 ZooKeeper的名字由此诞生。

ZooKeeper的基本概念

集群角色(Role)

一般的集群模式是 Master/Slave模式的,在这种模式中,我们把能够处理所有写操作的机器称为 Master机器,把所有通过异步复制方式获取最新数据,并提供读服务的机器称为 Slave机器。

而 ZooKeeper采用了 Leader、Follower和 Observer三种角色。ZK集群中的所有机器通过一个 “Leader选举” 的过程来选定一台被称为【Leader】的机器,它为客户端提供读和写服务。其他角色包括 Follower和 Observer都仅能提供读服务。其中 Observer机器不参与 “Leader选举”过程,也不参与 “过半写成功”的策略,因此 Observer机器可以在不影响写性能的情况下提升集群的读性能。

会话(Session)

在 ZK中,一个客户端连接是指客户端和服务器之间的一个 TCP长连接。ZK对外的服务端口默认为 2181。客户端启动的时候,首先会与服务端建立一个 TCP连接,自此客户端会话的生命周期也开始了。

通过这个连接,客户端能够凭借心跳检测与服务器保持有效的会话,也能够向服务器发送请求并接受响应,同时还能够通过该连接接收来自服务器的 Watch事件通知。

Session的 sessionTimeout值(类似于 Chubby中的“宽期限”)用来设置一个客户端会话的超时时间。当由于服务器压力太大、网络故障或客户端主动断开等各种原因导致会话断开时,只需要在 sessionTimeout时间内能够重新连接上集群中的任意一台服务器,会话就依旧有效。

数据节点(ZNode)

在 ZK中,“节点”一般分为两类,第一类指构成集群的机器(机器节点),第二轮指数据模型中的数据单元(数据节点,ZNode)。

ZK将所有数据存储在内存中,模型是一颗树(ZNode Tree),由斜杠( / )分割路径,/foo/path1就是一个 ZNode。每个 ZNode上都会保持自己的数据内容,同时保持一系列的属性信息。

在 ZK中,ZNode可以分为【持久节点】和【临时节点】两类。持久节点指一旦创建后,除非显式地进行 ZNode的移除操作,否则这个 ZNode将一直保存着;而临时节点在创建后,一旦客户端会话失效,那么这个客户端创建的所有临时节点都会被移除。

此外,ZK允许用户为每个节点添加一个特殊的属性:SEQUENTIAL。一旦节点被该属性标记,那么在创建的时候,ZK会自动在其节点名后面追加一个整形数字(由父节点维护的自增序列)

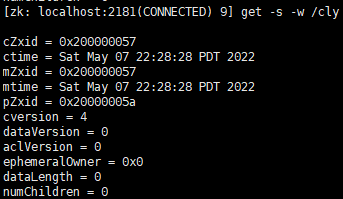

版本(Version)

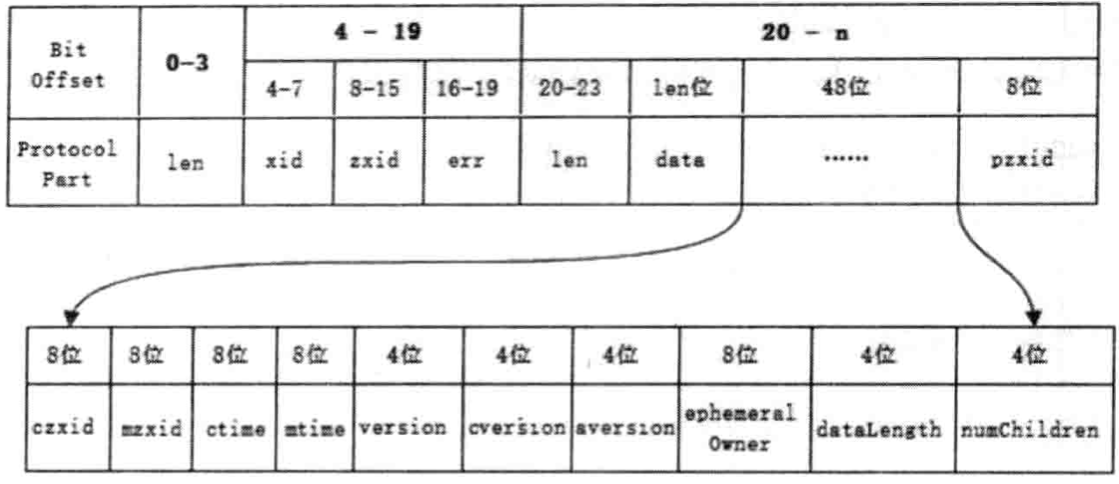

ZK的每个 ZNode上都会存储数据,对应于每个 ZNode,ZK都会维护一个称为 Stat的数据结构。

Stat中记录了这个 ZNode的三个数据版本,分别是 version(当前 ZNode的版本)、cversion(当前 ZNode子节点的版本)、aversion(当前 ZNode的 ACL版本)

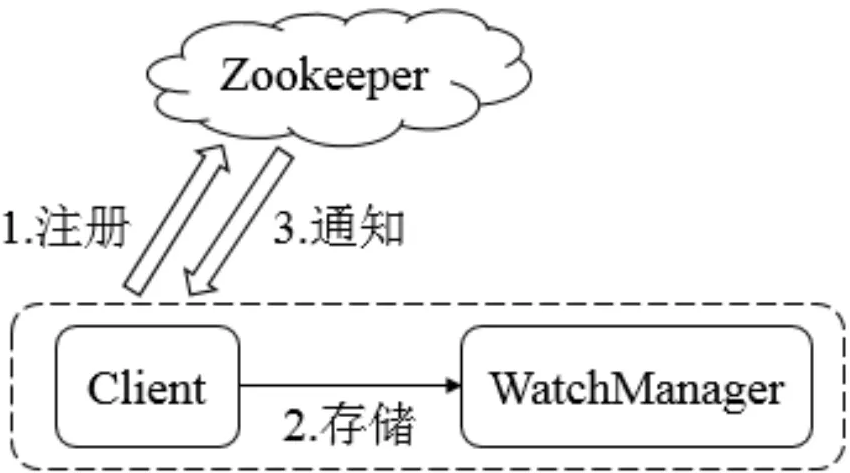

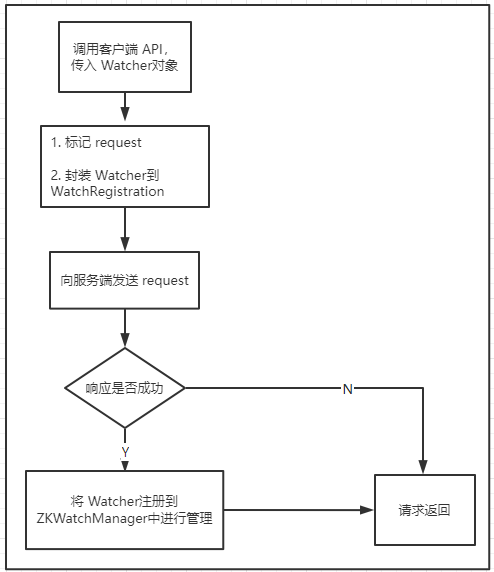

事件监听器(Watcher)

ZK允许用户在指定节点上注册一些 Watcher,并在特定事件触发的时候,ZK会将事件通知到感兴趣的客户端处。

访问控制列表(ACL, Access Control Lists)

ZK采用 ACL策略进行权限控制,类似 UNIX文件系统的权限控制。

- CREATE:创建子节点的权限

- READ:获取节点数据和子节点列表的权限

- WRITE:更新节点数据的权限

- DELETE:删除子节点的权限

- ADMIN:设置节点 ACL的权限

为什么选择 ZooKeeper

随着分布式架构的出现,越来越多的分布式应用会面临数据一致性的问题。在解决分布式数据一致性上,除了 ZooKeeper外,目前还没有一个成熟稳定且被大规模应用的解决方案。

且 ZK是开源的、免费的、已得到广泛的应用的。

4.2 ZooKeeper的 ZAB协议

ZAB协议

ZooKeeper并没有完全采用 Paxos算法,而是使用了一种称为 ZAB(ZooKeeper Atomic Broadcast)的协议作为其数据一致性的核心算法。

ZAB是为分布式协调服务 ZooKeeper专门设计的一种支持崩溃恢复的原子广播协议,它并不像 Paxos那样是通用的分布式一致性算法,而是特别为 ZooKeeper设计的。

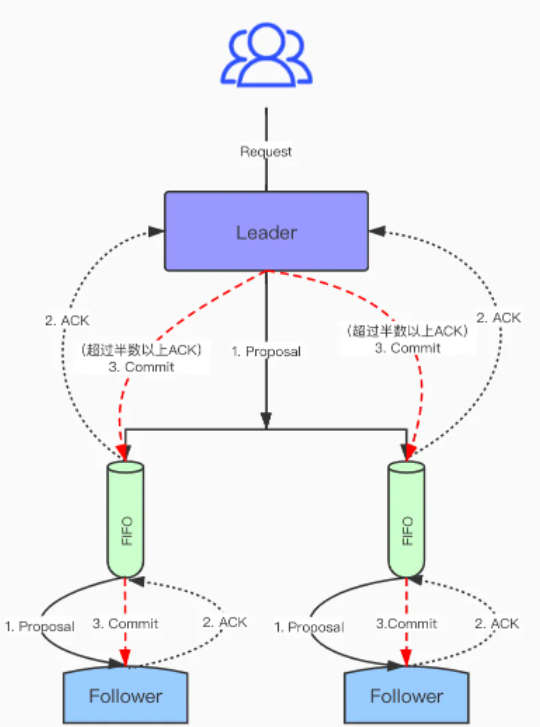

ZAB协议的核心是定义了对于那些会改变 ZooKeeper服务器数据状态的事务请求的处理方式:

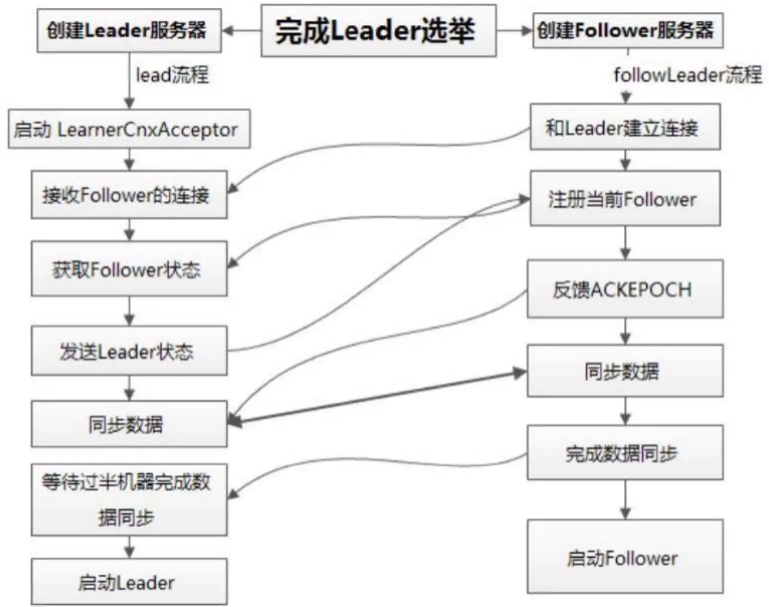

所有事务请求必须由一个全局唯一的服务器来协调处理,这样的服务器被称为【Leader】,而余下的其他服务器则称为【Follower】。Leader负责将一个客户端事务请求转换成一个事务 Proposal(提议),并将该 Proposal分发给集群中所有的 Follower服务器。如果 Leader得到了半数以上 Follower的正确反馈,那么 Leader就会再次向所有的 Follower服务器分发 Commit消息,要求其将前一个 Proposal提交

协议介绍

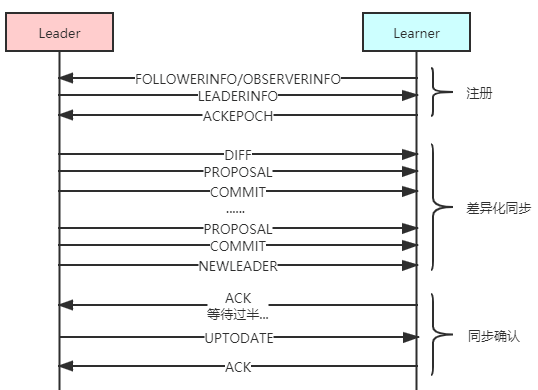

ZAB协议分为两种基本的模式:崩溃恢复 和 消息广播。

当整个服务框架在启动过程中,或是当 Leader服务器出现网络中断、崩溃退出与重启等异常情况时,ZAB协议就会进入【恢复模式】并选举产生新的 Leader服务器,同时集群中已经由过半的机器与该 Leader服务器完成了状态同步(数据同步)之后,ZAB协议就会退出恢复模式。

当集群中已经有过半的 Follower服务器完成了和 Leader服务器的状态同步,那么整个服务框架就可以计入【消息广播模式】了。当 Leader服务器接收到客户端的事务请求后,会生成对应的事务提案并发起一轮广播协议;而如果集群中的其他机器接收到了客户端的事务请求,那么这些非 Leader服务器会首先将这个事务请求转发给 Leader服务器。

如果一台统一遵守 ZAB协议的服务器启动后加入到集群中,且此时集群内已经存在了一个 Leader服务器在负责消息广播,那么新加入的服务器就会自觉进入【数据恢复模式】,它会找到 Leader,与其进行数据同步,然后一起参与到消息广播流程中去。

当 Leader服务器出现崩溃退出或机器重启,亦或是集群中已经不存在过半的服务器与该 Leader服务器保持正常通信时,那么在下一轮原子广播前,所有进程会先进入【恢复模式】来使彼此再达到一个一致的状态。

消息广播

ZAB的消息广播是原子的,类似一个二阶段提交的过程。

针对客户端的事务请求,Leader服务器会为其生成对应的事务 Proposal,并将其发送给集群中其余所有的机器,然后再分别收集各自的选票,最后进行事务提交。

ZAB的二阶段和 Paxos的二阶段略有不同。在 ZAB协议的二阶段提交过程中,移除了中断逻辑,所有的 Follower服务器要么正常反馈 Leader提出的事务 Proposal,要么抛弃 Leader服务器,这样的好处是当 Leader收到半数以上的 Ack后就可以直接提交事务 Proposal了,无需再等待其他的 Follower。但是这样无法处理 Leader服务器崩溃退出而带来的数据不一致问题。因此,ZAB协议中添加了【恢复模式】。此外,整个【消息广播协议】是基于具有 FIFO特性的 TCP协议来进行网络通信的,因此可以保证消息广播中的顺序性。

在整个消息广播中,Leader服务器会为每个事务请求生成对应的 Proposal来进行广播,且会分配一个全局单调递增的唯一 ID(ZXID)。由于 ZAB协议需要保证消息的顺序性,因此每个事务 Proposal都会严格按照 ZXID的先后顺序来进行排序处理。

具体的,Leader会为每个 Follower都分配一个单独的队列,然后将需要广播的事务 Proposal依次放入这些队列中,且根据 FIFO策略进行发送。每一个 Follower在接收到这个事务 Proposal后,都会首先将其以事务日志的形式写入磁盘,成功后返回 Ack给 Leader。当 Leader收到半数以上 Ack后,会提交事务,之后发出 Commit消息;而 Follower在收到 Commit消息后,也会提交事务。

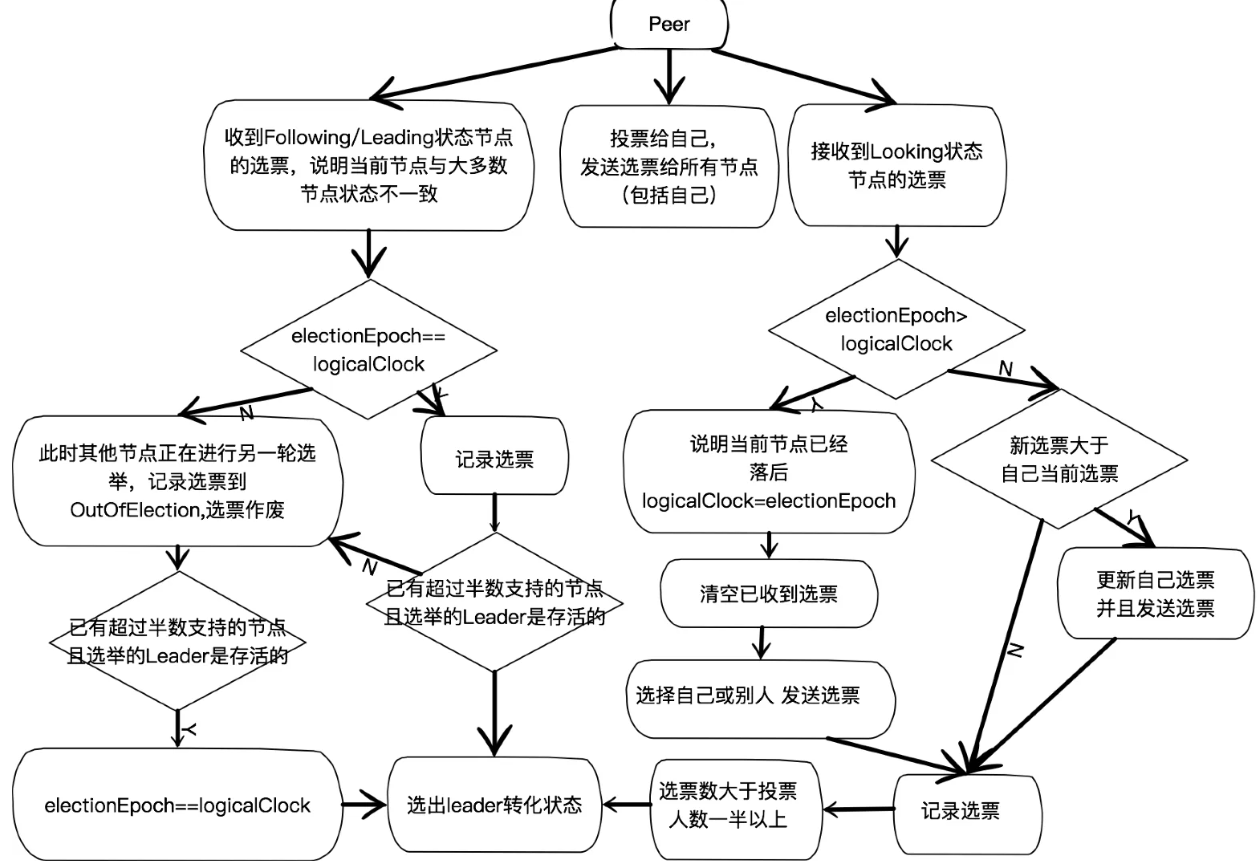

崩溃恢复

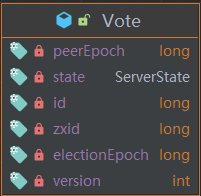

当 Leader出现崩溃或因网络等原因失去了与过半 Follower的联系后,就会进入崩溃恢复模式,期间,需要选出一个新的 Leader服务器。该 Leader选举算法不仅需要让 Leader自己知道自己被选举了,同时还需要让集群中的所有其他机器也能够快速地感知到选举产生的新的 Leader服务器。

为了达到一致性,ZAB的 Leader选举算法要求为:确保提交所有已经被 Leader提交的事务 Proposal,同时丢弃已经被跳过的事务 Proposal。针对此,如果让 Leader选举算法能够保证新选举出来的 Leader服务器拥有集群中最大的 ZXID,那么就可以保证这个新的 Leader一定具有所有已提交的提案。并且,通过此可以省去 Leader服务器检查 Proposal的提交和丢弃工作的这一步操作了。

数据同步

完成 Leader选举后,在正式开始工作前,Leader会首先确认事务日志中的所有 Proposal是否都已经被集群中过半的机器提交了,即是否完成了数据同步。

正常情况下,Leader服务器会为每一个 Follower都准备一个队列,并将那些没有被各个 Follower同步的事务以 Proposal消息的形式逐个发送给 Follower服务器,并在每一个 Proposal消息后面紧接着再发送一个 Commit消息,以表示该事务已经被提交。等到 Follower服务器将所有其尚未同步的事务 Proposal都从 Leader服务器上同步过来并成功应用到本地数据库中后,Leader服务器就会将该 Follower服务器加入到真正的可用 Follower列表中。

而针对那些需要被丢弃的事务 Proposal,在 ZAB中,ZXID是一个 64位的数字,其中低 32位可以看作一个新事务的计数器(每次加一),而高 32位则代表了 Leader周期的 epoch编号,每当选举产生一个新的 Leader服务器,就会从这个 Leader服务器上取出其本地日志中最大事务 Proposal的 ZXID,并解析出 epoch值,然后对其加一后作为新的 epoch,并将低 32位全部置为 0,得到新的 ZXID。ZAB通过 epoch编号来区分 Leader周期变化,这能够有效地避免不同的 Leader服务器错误地使用相同的 ZXID编号。基于此,当一个包含了上一个 Leader周期中尚未提交过的事务 Proposal的服务器启动时,因为此时集群中一定包含了更高的 epoch的事务 Proposal,所以这个新机器的 Proposal一定不是最高的,肯定无法成为 Leader。那么,当该机器加入到集群中之后,Leader会根据自己服务器上最后被提交的 Proposal来和该服务器的 Proposal进行,要求该服务器进行一个回退操作。

4.3 深入 ZAB协议

系统模型

通常在一组进程 Π = {P1, P2, ..., Pn}组成的分布式系统中,其每个进程都有各自的存储设备,各进程之间通过相互通信来实现消息的传递。其中每一个进程都有可能出现一次或多次的崩溃,同样的在崩溃恢复后也会再次加入到进程组 Π中。如果一个进程正常工作,我们称该进程处于 UP状态;否则称其处于 DOWN状态。当集群中存在过半的处于 UP状态的进程组成了一个进程子集之后,就可以进行正常的消息广播了。我们称这样的一个进程子集为 Q(Quorum),并假设这样的 Q存在,且满足:

我们使用 Pi和 Pj来分布表示进程组 Π中的两个不同进程,使用 Cij来表示进程 Pi和 Pj之间的网络通信通道,其满足如下两个基本特性:

- 完整性(Integrity):进程 Pj如果收到来自进程 Pi的消息 m,那么进程 Pi一定确实发送了消息 m

- 前置性(Prefix):如果进程 Pj收到了消息 m,那么一定存在消息 m’:如果消息 m’是消息 m的前置消息,那么 Pj一定先接收 m’,再接收 m

问题描述

Zk是一个高可用的分布式协调服务,它存在大量的客户端进程,且都依赖 ZK完成一系列诸如可靠配置存储和运行时状态记录等分布式协调工作。鉴于这些大型应用对 ZK的依赖,ZK必须具备高吞吐和低延迟的特性,并且能很好地在高并发情况下完成分布式数据的一致性处理,同时能够优雅地处理运行时故障,并具备快速恢复的能力。

ZAB协议是整个 ZK的核心所在,其规定了任何时候都需要保证只有一个 Leader负责消息广播,如果 Leader崩溃了,就需要快速选出新的 Leader。Leader的选举和消息广播是紧密相关的。因为集群中每个进程都有可能成为 Leader,那么随着时间的推移,会出现多个主进程构成一个序列:P1, P2, ..., Pe-1, Pe,其中 Pe∈Π,e表示主进程序列号(epochID)。对于这个序列中的任意两个主进程来说,如果 e小于 e’,那么我们就称 Pe是 Pe’之前的主进程,并且因为一个进程可能会崩溃多次,也可能多次被选为 Leader,所以存在可能:Pe和 Pe’本质上是同一个进程,只是二者处于不同的周期中而已。

主进程周期

为了保证主进程每次广播出来的事务消息具有一致性,ZAB协议必须保证只有在充分完成了崩溃恢复之后,新的主进程才可以开始生成新的事务消息广播。在运行过程中,ZAB协议能够非常明确地告知上层系统(主进程和其他副本进程)是否可以开始事务消息的广播,同时 ZAB还需要为当前主进程设置一个实例值,用于唯一标识当前主进程的周期(epochID)

事务

主进程每次发布状态变更的广播都会调用 transaction(v, z)函数,其中包含两个字段:事务内容 v 和 事务标识 z,且 z = <e, c>,e 表示 主进程周期,c 表示 主进程周期内的事务计数 c。我们使用 epoch(z)来表示一个事务标识中的主进程周期 epoch,使用 counter(z)来表示事务标识中的事务计数。

针对每一个新的事务,主进程都会首先将事务计数 c 递增。如果一个事务标识 z 优先于另一个事务 z’,那么就有两种情况:

- 主进程周期优先,即 epoch(z) < epoch(z’)

- 事务计数优先,即 epoch(z) = epoch(z’) 且 counter(z) < counter(z’)

- 无论哪种都可以标识为 z < z’

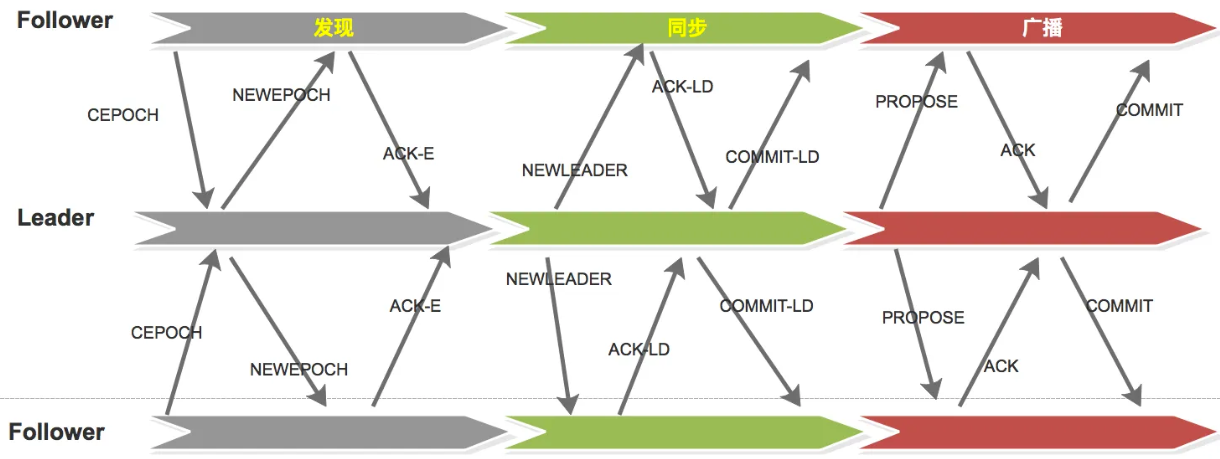

算法描述

整个 ZAB协议主要包括 消息广播 和 崩溃恢复 两个过程,进一步可以划分为三个阶段,分别是 发现(Discovery)、同步(Synchronization)和 广播(Broadcast)阶段。组成 ZAB协议的每一个分布式进程会循环执行这三个阶段,我们称一个循环为一个主进程周期。

我们先定义一些专有标识和术语

| 术语名称 | 说 明 |

|---|---|

| F·P | Follower f 处理过的最后一个事务 Proposal |

| F·zxid | Follower f 处理过的历史事务 Proposal中最后一个事务 Proposal的事务标识 ZXID |

| hf | Follower f 处理过的事务序列 |

| Ie | 初始化历史记录,在某一个主进程周期 epoche中,当准 Leader完成 发现阶段后,此时它的 hf 就会被标记为 Ie |

| CEPOCH | Follower向准 Leader发送自己处理过的最后一个事务 Proposal的 epoch值 |

| NEWEPOCH | 准 Leader根据接收的各 Follower的 epoch,来生成新一轮周期的 epoch值 |

| ACK-E | Follower针对 NEWEPOCH给准 Leader的反馈 |

| NEWLEADER | 准 Leader进程确立自己的领导地位,发送给各进程 |

| ACK-LD | Follower针对 NEWLEADER给 Leader的反馈 |

| COMMIT-LD | Leader要求 Follower提交相应的历史事务 Proposal |

| PROPOSE | Leader进程生成一个针对客户端事务请求的 Proposal |

| ACK | Follower针对 PROPOSE给 Leader的反馈 |

| COMMIT | Leader要求所有进程提交事务 PROPOSE |

-

阶段一:发现(Leader选举)

- 步骤 F.1.1 -> Follwoer将自己最后接受的事务 Proposal的 epoch值

CEPOCH(F.p)发送给准 Leader - 步骤 L.1.1 -> 当准 Leader接收到来自过半 Follower的

CEPOCH(F.p)消息后,准 Leader会从中选取出最大的 epoch值,然后对其加一,得到 e’;之后,准 Leader 会生成NEWEPOCH(e’)消息给这些过半的 Follwer。 - 步骤 F.1.2 -> 当 Follower接收到来自准 Leader的

NEWEPOCH(e’)消息后,如果其检测到当前的CEPOCH(F.p)小于 e’,那么就会将NEWEPOCH(e’)赋值给 e’,同时反馈 Ack-E消息。在这个反馈消息中,包含了当前该 Follower的epoch CEPOCH(F.p),以及该 Follower的历史事务 Proposal集合: hf - 步骤 L1.2 -> 当准 Leader接收到来自过半 Follower的确认消息 Ack之后,准 Leader就会从这过半服务器中选取出一个 ZXID最大的 Follower F,使用其作为初始化事务集合 Ie’

- 步骤 F.1.1 -> Follwoer将自己最后接受的事务 Proposal的 epoch值

-

阶段二:同步(数据一致)

- 步骤 L.2.1 -> 准 Leader会将 e’ 和 Ie’以

NEWLEADER(e', Ie')消息的形式发送给所有的 Follower - 步骤 F.2.1-> 当 Follower接收到来自 Leader的

NEWLEADER(e', Ie')消息后,如果 Follower发现CEPOCH(F.p) != e',那么之间进入下一轮循环,因为此时该 Follower还处于上一轮(甚至更上一轮),无法参与本次同步;如果CEPOCH(F.p) == e',那么 Follower机会执行事务应用操作,对于每个事务 Proposal <v, z>∈Ie’,Follower都会接收<e’, <v, z>>。最后,Follower反馈 ACK-LD消息,表明自己已经完成了 Ie’中的所有事务 - 步骤 L.2.2 -> 当准 Leader接收到来自过半 Follower针对

NEWLEADER(e', Ie')的反馈消息后,就会向所有的 Follower发送 Commit消息。 - 步骤 F.2.2 -> 当 Follower接收到来自准 Leader的 Commit消息后,就会依次处理并提交所有在 Ie’中未处理的事务

- 步骤 L.2.1 -> 准 Leader会将 e’ 和 Ie’以

-

阶段三:广播(发布数据)

- 步骤 L.3.1 -> Leader接收到客户端新的事务请求后,生成对应的事务 Proposal,并根据 ZXID的顺序向所有 Follower发送提案 <e’, <v, z>>,其中

epoch(z) == e’ - 步骤 F.3.1 -> Follower根据消息接收的先后次序来处理这些来自 Leader的事务 Proposal,并将它们追加到 hf中去,之后再反馈给 Leader

- 步骤 L.3.2 -> 当 Leader接收到来自过半 Follower针对事务 Proposal<e’, <v, z>>的 Ack消息后,就会发送 Commit<e‘, <v, z>>消息给所有的 Follower,要求它们进行事务的提交

- 步骤 F.3.2 -> 当 Follower接收到来自 Leader的 Commit消息后,就会提交对应的事务。并且此时,该 Follower必定已经提交了该事务前的所有事务。

- 步骤 L.3.1 -> Leader接收到客户端新的事务请求后,生成对应的事务 Proposal,并根据 ZXID的顺序向所有 Follower发送提案 <e’, <v, z>>,其中

正常运行过程中,ZAB协议会一直运行于阶段三来反复地进行消息广播,如果出现 Leader崩溃或其他原因导致 Leader缺少,那么 ZAB会进入阶段一来重新选举 Leader。并且只有完成了阶段二,即完成了数据同步之后,准 Leader才能真正地成为 Leader。进入到阶段三后,Leader会以队列的形式为每一个与自己保持同步的 Follower创建一个操作队列。

运行分析

在 ZAB协议中,每一个进程都有可能处于以下三种状态之一:

- LOOKING:Leader选举阶段

- FOLLOWING:作为 Follower和 Leader保持同步状态

- LEADING:作为 Leader领导状态

当组成 ZAB协议的所有进程启动的时候,其初始化状态都是 LOOKING,此时进程组中不存在 Leader。所有处于 LOOKING状态都会试图选举出一个 Leader。如果,进程发现已经选举出 Leader了,那么就会进入到 FOLLOWING状态,并开始和 Leader保持同步。如果被选举为了 Leader,就会进入 LEADING状态。如果 Leader崩溃了,那么之前处于 FOLLOWING状态的进程又会回到 LOOKING状态,并开始新一轮的选举。因此,在 ZAB协议运行过程中,每个进程都会在三个状态间不断切换。

4.4 小结

ZAB并不是 Paxos算法的典型实现

- 两者都存在一个类似 Leader的角色,负责协调多个 Follower

- Leader进程都会等待过半 Follower做出正确反馈后才会提交提案

- 在 ZAB协议中,每个 Proposal都包含了 epoch值,代表当前的 Leader周期;Paxos中也存在类似的值,称为 Ballot

在 Paxos算法中,一个新选出来的 Leader会先和其他进程通信,收集上一个主进程提出的提案,并将它们提交;之后才会开始提出自己的提案。在此基础上,ZAB额外添加了一个同步阶段。在同步阶段中,新的 Leader会确保存在过半的 Follower已经提交了之前 Leader周期中的所有事务 Proposal,正是这一步的引入,保证了 Leader在新的周期中提出新事务前,所有的进程都已经完成了对之前事务的提交。

总体而言,ZAB协议和 Paxos算法的本质区别在于,二者的设计目标不同。ZAB的目标是构建一个高可用的分布式数据主备系统。而 Paxos是为了构建一个分布式的一致性状态机系统。

五、使用 ZooKeeper

5.1 部署与运行

系统环境

GNU/Linux、Sunday Solaris、Win32以及 Mac OS X均可。

ZK使用 Java语言编写,因此需要 Java环境的支持。

集群与单机

ZK有两种运行模式:集群模式 和 单机模式。

-

集群模式:三台机器模拟 ZK集群

-

准备 Java环境

-

下载 ZK安装包并解压

-

配置文件 conf/zoo.cfg,三台机器上的 zoo.cfg文件都需要一样

tickTime=2000 dataDir=/var/lib/zookeeper clientPort=2181 initLimit=5 syncLimit=2 server.1=192.168.44.10:2888:3888 # 每一行代表一个机器配置 server.id=host:port:port,id表示集群中的机器序号 server.2=192.168.44.20:2888:3888 server.3=192.168.44.30:2888:3888 -

在 dataDir目录下,创建 myid文件,里面只有一个数字,标识本台机器

1 # 本机器对应的 server.id中的 id值 -

使用 bin/zkServer.sh脚本,启动服务器

bash zkServer.sh start -

验证服务器

telnet 127.0.0.1 2181 stat

-

-

单机模式:和集群模式基本一致

-

配置 zoo.cfg,在机器列表上只要配一台就行了,其他都一样。

server.1=192.168.44.10:2888:3888

-

-

伪集群模式:借助于硬件的虚拟化技术,把一台物理机转换为多台虚拟机

-

配置 zoo.cfg,三个机器的ip写成一样的,但是端口写成不同的。

server.1=192.168.44.10:2888:3888 server.2=192.168.44.10:2889:3889 server.3=192.168.44.10:2890:3890

-

运行服务

ZooKeeper的常见启动方式有两种

- Java命令行启动

- 使用 ZK自带的启动脚本启动

| 脚 本 | 说 明 |

|---|---|

| zkCleanup | 清理 ZooKeeper历史数据,包括事务日志文件和快照数据文件 |

| zkCli | ZooKeeper的一个简易客户端 |

| zkEnv | 设置 ZooKeeper的环境变量 |

| zkServer | ZooKeeper服务器的启动、停止和重启脚本 |

停止服务

使用 zkServer脚本的 stop命令来停止服务

bash zkServer.sh stop

常见异常

- 端口被占用:Address already in use -> 2181端口已经被其他进程占用了

- 磁盘没有剩余空间:No space left on device -> 清理磁盘

- 端口没开启(防火墙的问题,开启后最好再刷新一下防火墙)

- 无法找到 myid文件:Invalid config, exiting abnormally -> 在 dataDir下创建 myid文件

5.2 客户端脚本

通过 zkCli脚本可以直接连接 zk服务端

bash zkCli.sh

bash zkCli.sh -server ip:port

创建

使用 create命令,可以创建一个 ZooKeeper节点

create [-s] [-e] path data acl

-s:顺序节点

-e:临时节点

acl:权限控制

默认创建持久节点

读取

使用 ls命令,可以列出 ZooKeeper指定节点下的所有子节点

ls path [watch]

默认在根节点 / 下面有一个叫做 /zookeeper的保留节点

使用 get命令,可以读取 ZooKeeper指定节点的数据内容和属性信息

get path [watch]

更新

使用 set命令,可以更新指定节点的数据内容

set path data [version]

version: 在 zk中,节点的数据是有版本的,这个参数用于指定本次更新操作是基于 ZNode的哪一个数据版本进行的

删除

使用 delete命令,可以删除 ZooKeeper上的指定节点

delete path [version]

无法使用 delete删除一个包含子节点的节点

5.3 Java客户端 API使用

需要事先引入相关依赖

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.6.3</version>

</dependency>

创建会话

客户端通过创建一个 ZooKeeper实例来连接服务器。

ZooKeeper(String connectString, int sessionTimeout, Watcher watcher, long sessionId, byte[] sessionPasswd, boolean canBeReadOnly)

- connectString:指定 ZK服务器列表,eg:192.168.1.1:2181,192.168.1.2:2181 ;也可以直接在列表路径中指定目录,eg:192.168.1.1:2181/foo/bar,/foo/bar称为 Chroot,即客户端隔离命名空间

- sessionTimeout:会话超时时间,毫秒值;超出该值的时间后还没有心跳,session失效

- watcher:作为默认的 Watcher处理器

- canBeReadOnly:标识当前会话是否支持“read-only”模式,如果是的话,在半数以上服务器宕机后,集群还可以读

- sessionId和 sessionPasswd:分别代表会话 ID和会话密钥,二者唯一确定一个会话。客户端使用这两个参数,可以直接使用之前的会话,实现会话复用、会话恢复效果。

ZK客户端和服务端会话的建立是一个异步的过程,该构造方法会在处理完客户端初始化后立即返回,在大多数情况下,此时并没有真正建立好一个可用的会话。当该会话真正创建完毕后,ZK服务端会向该会话对应的客户端发送一个事件通知,客户端只有在获得了这个通知之后,才算真正建立了对话。

/**

* 创建一个最基本的 ZK会话实例

*/

public class ZooKeeper_Constructor_Usage_Simple implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

@Override

public void process(WatchedEvent watchedEvent) {

System.out.println("receive watched event: " + watchedEvent);

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

latch.countDown();

}

}

public static void main(String[] args) throws IOException {

ZooKeeper zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_Constructor_Usage_Simple());

System.out.println(zooKeeper.getState());

try {

latch.await();

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(zooKeeper.getState());

}

}

/*

CONNECTING

receive watched event: WatchedEvent state:SyncConnected type:None path:null

CONNECTED

*/

/**

* 复用 sessionId和 sessionPasswd

*/

public class ZooKeeper_Constructor_Usage_With_SID_PASSWD implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

@Override

public void process(WatchedEvent watchedEvent) {

System.out.println("receive watched event: " + watchedEvent);

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

latch.countDown();

}

}

public static void main(String[] args) throws IOException {

ZooKeeper zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_Constructor_Usage_With_SID_PASSWD());

System.out.println(zooKeeper.getState());

try {

latch.await();

} catch (InterruptedException e) {

e.printStackTrace();

}

// 获取原连接的 sessionId和 sessionPasswd

long sessionId = zooKeeper.getSessionId();

byte[] sessionPasswd = zooKeeper.getSessionPasswd();

// 使用原来的 sessionId和 sessionPasswd进行连接复用

zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_Constructor_Usage_With_SID_PASSWD(), sessionId, sessionPasswd);

System.out.println(zooKeeper.getState());

}

}

创建节点

String create(String path, byte[] data, List<ACL> acl, CreateMode createMode, Stat stat, long ttl); // 同步创建

create(String path, byte[] data, List<ACL> acl, CreateMode createMode, Create2Callback cb, Object ctx, long ttl); // 异步创建

- path:数据节点的路径

- data[]:该节点的值

- acl:节点的 ACL策略

- createMode:节点类型

- PERSISTENT

- PERSISTENT_SEQUENTIAL

- EPHEMERAL

- EPHEMERAL_SEQUENTIAL

- cb:异步回调函数

- ctx:上下文信息,回调时使用

无论是同步创建还是异步创建,ZK都不支持递归创建,即无法在父节点不存在的情况下创建子节点,且节点不能重名。

ZK不负责节点内容的序列化,因此传参时开发者必须实现手动序列化。

/**

* 同步创建节点

*/

public class ZooKeeper_CREATE_API_Sync_Usage implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

@Override

public void process(WatchedEvent watchedEvent) {

System.out.println("receive watched event: " + watchedEvent);

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

latch.countDown();

}

}

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

ZooKeeper zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_CREATE_API_Sync_Usage());

System.out.println(zooKeeper.getState());

latch.await();

String path1 = zooKeeper.create("/zk-test-ephemeral-",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL);

System.out.println("success on creating znode: " + path1);

String path2 = zooKeeper.create("/zk-test-ephemeral-",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL_SEQUENTIAL);

System.out.println("success on creating znode: " + path2);

System.out.println(zooKeeper.getState());

}

}

/**

* 异步创建节点

*/

public class ZooKeeper_CREATE_API_ASync_Usage implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

@Override

public void process(WatchedEvent watchedEvent) {

System.out.println("receive watched event: " + watchedEvent);

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

latch.countDown();

}

}

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

ZooKeeper zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_CREATE_API_ASync_Usage());

System.out.println(zooKeeper.getState());

latch.await();

zooKeeper.create("/zk-test-ephemeral-",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL, (i, s, o, s1) -> {

System.out.println("create path result: [" + i + "," + s + "," + o + "," + s1 + "]");

}, "I am context");

zooKeeper.create("/zk-test-ephemeral-",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL_SEQUENTIAL, (i, s, o, s1) -> {

System.out.println("create path result: [" + i + "," + s + "," + o + "," + s1 + "]");

}, "I am context");

System.out.println(zooKeeper.getState());

}

}

异步创建时,所有的结果都会在回调函数中通过 ResultCode来体现

回调方法 void processResult(int rc, String path, Object ctx, String name)

- rc:ResultCode,服务端响应码,客户端可以通过该值识别出 API的调用结果

- 0:接口调用成功

- -4:连接已断开

- -110:节点已存在

- -112:会话已过期

- path:接口调用时传入的节点路径

- ctx:接口调用时传入的 Object ctx

- name:实际在服务端创建的节点名称(在顺序创建时,会显式后缀的序号)

删除节点

void delete(String path, int version); // 同步删除

void delete(String path, int version, VoidCallback cb, Object ctx); // 异步删除

- path:节点路径

- version:节点的数据版本

- cb:异步回调

- ctx:传递的上下文信息

ZK中只允许删除叶子节点,如果一个节点存在至少一个子节点的话,该节点无法被直接删除。

读取数据

GetChildren

List<String> getChildren(String path, Watcher watcher, Stat stat); // 同步获取子节点

void getChildren(String path, boolean watch, Children2Callback cb, Object ctx); // 异步获取子节点

- path:节点路径

- watcher:注册的 Watcher,当本次子节点获取之后,子节点列表发送变化,那么就会通过该 Watcher向客户端发送通知

- watch:是否需要注册一个 Watcher

- cb:异步回调

- stat:数据节点的状态信息

- ctx:传递的上下文信息

ZK客户端在获取到指定节点的子节点列表时,可以订阅该列表的变化通知。当有子节点的增删时,服务端会发送一个 NodeChildrenChanged(EventType.NodeChildrenChanged)类型的事件通知。但是这个通知,仅仅是一个通知而已,客户端获取到之后需要主动重新获取最新的子节点列表。

有时候,我们不仅需要获取子节点列表,还需要获取当前节点的基本信息,此时我们可以传递一个旧的 stat变量,服务端会替换新的 stat。

/**

* 同步获取子节点列表

*/

public class ZooKeeper_GetChildren_API_Sync_Usage implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

private static ZooKeeper zooKeeper = null;

@Override

public void process(WatchedEvent watchedEvent) {

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

if (Event.EventType.None == watchedEvent.getType() && null == watchedEvent.getPath()) {

latch.countDown();

} else if (Event.EventType.NodeChildrenChanged == watchedEvent.getType()) {

try {

System.out.println("ReGet Children: " + zooKeeper.getChildren(watchedEvent.getPath(), true));

} catch (KeeperException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_GetChildren_API_Sync_Usage());

System.out.println(zooKeeper.getState());

latch.await();

String path = "/cly";

zooKeeper.create(path,

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

zooKeeper.create(path + "/c1",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL);

// 同步获取,并且注册一个 Watcher,该 watcher是一次性的,触发一次之后就会失效

List<String> children = zooKeeper.getChildren(path, true);

System.out.println(children);

// 变更子节点列表,因为 Watcher的存在,服务端会像客户端发送一个通知

zooKeeper.create(path + "/c2",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL);

Thread.sleep(Integer.MAX_VALUE);

}

}

/**

* 异步获取子节点列表

*/

public class ZooKeeper_GetChildren_API_ASync_Usage implements Watcher {

private static CountDownLatch latch = new CountDownLatch(1);

private static ZooKeeper zooKeeper = null;

@Override

public void process(WatchedEvent watchedEvent) {

if (Event.KeeperState.SyncConnected == watchedEvent.getState()) {

if (Event.EventType.None == watchedEvent.getType() && null == watchedEvent.getPath()) {

latch.countDown();

} else if (Event.EventType.NodeChildrenChanged == watchedEvent.getType()) {

try {

System.out.println("ReGet Children: " + zooKeeper.getChildren(watchedEvent.getPath(), true));

} catch (KeeperException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

}

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, new ZooKeeper_GetChildren_API_ASync_Usage());

System.out.println(zooKeeper.getState());

latch.await();

String path = "/zwb";

zooKeeper.create(path,

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

zooKeeper.create(path + "/c1",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL);

zooKeeper.getChildren(path, true, new AsyncCallback.Children2Callback() {

@Override

public void processResult(int i, String s, Object o, List<String> list, Stat stat) {

System.out.println("result: [" + i + "," + s + "," + o + "m" + list + "," + stat + "]");

}

}, "I am context");

zooKeeper.create(path + "/c2",

"".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL);

Thread.sleep(Integer.MAX_VALUE);

}

}

GetData

byte[] getData(String path, boolean watch, Stat stat); // 同步获取

void getData(String path, Watcher watcher, DataCallback cb, Object ctx); // 异步获取

客户端在获取一个节点的数据的时候,也可以注册 Watcher,当该节点的状态发生变更,那么服务端就会向客户端发送一个 NodeDataChanged(EventType.NodeDataChanged)的事件通知。

更新数据

Stat setData(String path, byte[] data, int version); // 同步更新

void setData(String path, byte[] data, int version, StatCallback cb, Object ctx); // 异步更新

version参数用于指定数据的版本,表明本次更新操作是针对指定的版本进行的。其实就是用于 CAS的,保证分布式环境下,数据更新的安全性,并不是说会保存多个版本的数据。version从 0开始计数,-1表示最新版本。

检测节点是否存在

Stat exists(String path, Watcher watcher); // 同步检测

void exists(String path, Watcher watcher, StatCallback cb, Object ctx); // 异步检测

如果传入了监听器,那么在改进的发生变动后,会得到来自服务端的通知。无论节点是否存在,调用 exists()接口都能注册 Watcher,它能对针对该节点(子节点不行)的一切变动进行监听

权限控制

一个 ZK服务器集群可能同时为多个应用提供服务,为了避免存储在 ZK上的数据被其他进程干扰,需要对数据进行权限控制(Access Control)。ZK提供了 ACL的权限控制机制,它通过设置 ZK服务器上 ZNode的 ACL,来控制客户端对该数据节点的访问权限。ZK提供了多种权限控制模式:world、auth、digest、ip和 super。

开发人员如果需要使用 ZK的权限控制功能,需要在会话创建后,手动给该会话添加相关的权限信息。

addAuthInfo(String schema, byte[] auth)

- schema:权限控制模式,world、auth、digest、ip和 super

- auth:具体的权限信息

/**

* 为会话添加权限,并且在该权限下,创建节点

*/

public class AuthSample {

final static String PATH = "/zwb-cly";

public static void main(String[] args) throws IOException, InterruptedException, KeeperException {

// 创建会话

ZooKeeper zooKeeper = new ZooKeeper("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

50000, null);

// 添加权限

zooKeeper.addAuthInfo("digest", "foo:true".getBytes(StandardCharsets.UTF_8));

// 添加受权限控制的节点,其他无权限的会话将无法获取当前节点的数据

zooKeeper.create(PATH, "".getBytes(StandardCharsets.UTF_8), ZooDefs.Ids.CREATOR_ALL_ACL, CreateMode.PERSISTENT);

Thread.sleep(Integer.MAX_VALUE);

}

}

在 ZK中,几乎所有的 API接口操作,都会受到权限的限制。

但是针对【删除】操作,却比较特别。如果 session1添加了权限 A,创建了节点 /a 和 /a/b;那么任何无 A权限的 session都无法删除二者;但是 session2添加了权限 A,删除了 /a/b,那么之后所有 session都可以删除 /a了(针对 /a的权限丢失了)

5.4 ZkClient

ZkClient是对 ZooKeeper原生 API接口的一个封装,是一个更易用的 ZooKeeper客户端。

其 Maven依赖:

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.6.3</version>

</dependency>

<dependency>

<groupId>com.101tec</groupId>

<artifactId>zkclient</artifactId>

<version>0.10</version>

</dependency>

创建会话

ZkClient(IZkConnection zkConnection, int connectionTimeout, ZkSerializer zkSerializer, long operationRetryTimeout);

- zkServers:指定的 ZK服务器列表,eg: 192.168.26.10:2181,192.168.26.20:2181

- sessionTimeout:会话超时时间,默认为 30000ms

- connectionTimeout:连接超时时间,默认为 Integer.MAX_VALUE ms

- zkConnection:IZkConnection接口的实现类

- zkSerializer:自定义序列化器

- operationRetryTimeout:操作超时时间

ZkClient通过包装,将异步的客户端连接建立过程同步化了。IZkConnection接口是对 ZooKeeper原生接口最直接的包装。

在注册完序列化器之后,客户端在进行读写操作的过程中,都会自动地进行序列化和反序列化。

并且 ZkClient引入了 Listener来实现 Watcher的注册。

/**

* 使用 ZkClient来创建一个 ZooKeeper客户端

*/

public class Create_Session_Sample {

public static void main(String[] args) {

ZkClient zkClient = new ZkClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181", 5000);

System.out.println("ZooKeeper session established");

}

}

创建节点

create(final String path, Object data, final List<ACL> acl, final CreateMode mode);

createEphemeral(String path, Object data, List<ACL> acl);

createEphemeralSequential(String path, Object data, List<ACL> acl);

createPersistent(String path, boolean createParents, List<ACL> acl)

createPersistentSequential(String path, Object data, List<ACL> acl);

- path:ZNode的路径

- data:ZNode中存储的值

- mode:节点类型

- acl:节点的 ACL策略

- createParents:指定是否创建父节点

原生接口只允许传入字节数组,而 ZkClient提供的接口,由于支持了自定义序列化器,可以传入复杂对象作为参数。

并且通过 createParents参数,ZkClient能够在内部递归建立父节点。

/**

* 使用 ZkClient创建节点

*/

public class Create_Node_Sample {

public static void main(String[] args) {

ZkClient zkClient = new ZkClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181", 5000);

zkClient.createPersistent("/zkClient/zwb/cly", true);

}

}

删除节点

boolean delete(final String path, final int version);

boolean deleteRecursive(String path);

在 ZkClient中,通过调用 deleteRecursive(String path)方法,可以实现逐层遍历删除节点。

读取数据

getChildren

List<String> getChildren(final String path, final boolean watch);

List<String> subscribeChildChanges(String path, IZkChildListener listener);

集合中存储的值依旧是子节点的相对路径(相对于 path)。

客户端可以通过调用 subscribeChildChanges()接口,注册针对子列表变更的监听,一旦发生变更,服务端就会发出通知,由这个 listener的handleChildChange(String parentPath, List<String> currentChilds)来进行处理。

- parentPath:子节点变更后通知对应的父节点的路径

- currentChilds:当前子节点列表

/**

* 使用 ZkClient获取子节点列表

*/

public class Get_Children_Sample {

public static void main(String[] args) throws InterruptedException {

ZkClient zkClient = new ZkClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181", 5000);

// 注册监听,客户端可以针对一个尚未存在的节点进行监听,且 ZkClient提供的监听器不是一次性的

zkClient.subscribeChildChanges("/zkClient", (parentPath, currentChilds) -> {

System.out.println("handleChildChange ... [" + parentPath + "," + currentChilds + "]");

});

// 进行一系列的修改

zkClient.createPersistent("/zkClient/tmp", true);

Thread.sleep(1000);

zkClient.delete("/zkClient/tmp");

Thread.sleep(1000);

zkClient.deleteRecursive("/zkClient");

Thread.sleep(1000);

}

}

getData

<T extends Object> T readData(String path, boolean returnNullIfPathNotExists);

<T extends Object> T readData(final String path, final Stat stat, final boolean watch);

void subscribeDataChanges(String path, IZkDataListener listener)

- returnNullIfPathNotExists:默认情况下如果节点不存在会报错,如果这个参数设为了 true,就会返回 null

- stat:获取该 ZNode的 stat数据

客户端可以通过 subscribeDataChanges()接口监听节点数据的变更,如果内容变动,则会使用handleDataChange(String dataPath, Object data)方法处理;如果节点删除,则会使用handleDataDeleted(String dataPath)方法处理。

- dataPath:事件通知对应的节点路径

- data:最新的数据内容

/**

* 使用 ZkClient获取节点数据内容

*/

public class Get_Data_Sample {

public static void main(String[] args) throws InterruptedException {

ZkClient zkClient = new ZkClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181", 5000);

zkClient.subscribeDataChanges("/zkClient", new IZkDataListener() {

@Override

public void handleDataChange(String dataPath, Object data) throws Exception {

System.out.println("Node " + dataPath + " changed, new data: " + data);

}

@Override

public void handleDataDeleted(String dataPath) throws Exception {

System.out.println("Node " + dataPath + " deleted");

}

});

String o = zkClient.readData("/zkClient");

System.out.println(o);

Thread.sleep(1000);

zkClient.writeData("/zkClient", "123");

Thread.sleep(1000);

zkClient.delete("/zkClient");

Thread.sleep(1000);

}

}

更新数据

void writeData(final String path, Object datat, final int expectedVersion);

Stat writeDataReturnStat(final String path, Object datat, final int expectedVersion);

- expectedVersion:预期的数据版本,可用于 CAS操作

检测节点是否存在

exists(final String path, final boolean watch);

5.5 Curator

Curator也是对 ZooKeeper原生 API的封装,并且还提供了 ZK的各种场景应用(选举、锁、计数等)

Curator的 Maven依赖:

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.6.3</version>

</dependency>

<dependency>

<groupId>org.apache.curator</groupId>

<artifactId>curator-framework</artifactId>

<version>5.2.0</version>

</dependency>

创建会话

- 使用 CuratorFrameworkFactory的静态方法

newClient创建客户端 - 使用 CuratorFramework中的

start来创建会话

static newClient(String connectString, int sessionTimeoutMs, int connectionTimeoutMs, RetryPolicy retryPolicy, ZKClientConfig zkClientConfig);

void start();

- connectString:ZK服务器列表,格式和之前的一样

- retryPolicy:重试策略

- ExponentialBackoffRetry:指数补偿

- RetryNTimes:重试多少次

- RetryOneTime:重试一次

- RetryUntilElapsed:直到多少秒之后停止

/**

* 使用 Curator来创建一个 ZooKeeper客户端

*/

public class Create_Session_Sample {

public static void main(String[] args) throws InterruptedException {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

}

}

ExponentialBackoffRetry的重试策略如下:

给定一个初始 sleep时间 baseSleepTimeMs,在这个基础上结合重试次数,通过以下公式计算当前需要 sleep的时间:

当前 sleep时间 = baseSleepTimeMs * Math.max(1, random.nextInt(1 << (retryCount + 1)))

也就是说,随着重试的次数增加,sleep的时间会越来越大,如果该 sleep时间大于 maxSleepMs了,那么就使用 maxSleepMs,并且重试次数不能大于 maxRetries。

/**

* 使用 Fluent风格的 API接口来创建会话

*/

public class Create_Session_Sample_Fluent {

public static void main(String[] args) throws InterruptedException {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.builder()

.connectString("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181")

.sessionTimeoutMs(5000)

.retryPolicy(retryPolicy)

.namespace("curator") // 创建隔离命名空间

.build();

// 创建 session会话

client.start();

}

}

创建节点

- 创建一个节点,初始内容为空 ->

client.create().forPath(path) - 创建一个节点,附带初始内容 ->

client.create().forPath(path, "xxx".getBytes()) - 创建一个临时节点 ->

client.create().withMode(CreateMode.EPHEMERAL).forPath(path) - 创建一个节点,递归创建父节点 ->

client.create().creatingParentsIfNeeded().forPath(path)

/**

* 使用 Curator创建节点

*/

public class Create_Node_Sample {

public static void main(String[] args) throws Exception {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

String path = client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.forPath("/curator", "hahaha".getBytes(StandardCharsets.UTF_8));

System.out.println(path);

}

}

删除节点

- 删除一个节点 ->

client.delete().forPath(path) - 递归删除一个节点 ->

client.delete().deletingChildrenIfNeeded().forPath(path) - 指定版本删除节点 ->

client.delete().withVersion(version).forPath(path) - 保证强制删除 ->

client.delete().guaranteed().forPath(path)

/**

* 使用 Curator删除节点

*/

public class Del_Node_Sample {

public static void main(String[] args) throws Exception {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

String path = client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.forPath("/curator");

Stat stat = new Stat();

client.getData()

.storingStatIn(stat)

.forPath("/curator");

client.delete()

.guaranteed()

.deletingChildrenIfNeeded()

.withVersion(stat.getVersion())

.forPath("/curator");

}

}

guaranteed()方法保证客户端会记录本次删除操作,即使出现网络原因导致客户端无法连接服务端,只要会话能够恢复,客户端后台会反复重试删除操作。

读取数据

- 读取一个节点的数据 ->

client.getData().forPath(path) - 读取节点数据的同时,获取该节点的 stat ->

client.getData().storingStatIn(stat).forPath(path)

/**

* 使用 Curator读取数据

*/

public class Get_Data_Sample {

public static void main(String[] args) throws Exception {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

String path = client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.forPath("/curator", "hahaha".getBytes(StandardCharsets.UTF_8));

Stat stat = new Stat();

byte[] data = client.getData()

.storingStatIn(stat)

.forPath("/curator");

System.out.println(new String(data));

}

}

更新数据

- 更新一个节点的数据内容 ->

client.setData().forPath(path) - 指定版本更新 ->

client.setData().withVersion(version).forPath(path)

/**

* 使用 Curator设置数据

*/

public class Set_Data_Sample {

public static void main(String[] args) throws Exception {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

String path = client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.forPath("/curator", "hahaha".getBytes(StandardCharsets.UTF_8));

Stat stat = new Stat();

byte[] data = client.getData()

.storingStatIn(stat)

.forPath("/curator");

System.out.println(new String(data));

stat = client.setData()

.withVersion(stat.getVersion())

.forPath("/curator", "asdasdad".getBytes(StandardCharsets.UTF_8));

data = client.getData()

.storingStatIn(stat)

.forPath("/curator");

System.out.println(new String(data));

}

}

异步接口

Curator引入了 BackgroundCallback接口来处理异步调用后服务端返回的结果

public interface BackgroundCallback {

public void processResult(CuratorFramework client, CuratorEvent event) throws Exception;

}

- client:当前客户端实例

- event:服务端事件,定义了一些列的事件参数

- 事件类型(CuratorEventType)

- CREATE -> create()

- DELETE -> delete()

- EXISTS -> checkExists()

- GET_DATA -> getData()

- SET_DATA -> setData()

- CHILDREN -> getChildren()

- SYNC -> sync(String, Object)

- GET_ACL -> getACL()

- WATCHED -> watched()/usingWatcher(Watcher)

- CLOSING ->会话断开

- 响应码(resultCode)

- OK(0) -> 接口调用成功

- CONNECTIONLOSS(-4) -> 客户端和服务端连接已断开

- NODEEXISTS(-110) -> 指定节点已存在

- SESSIONEXPIRED(-112) -> 会话已过期

- 事件类型(CuratorEventType)

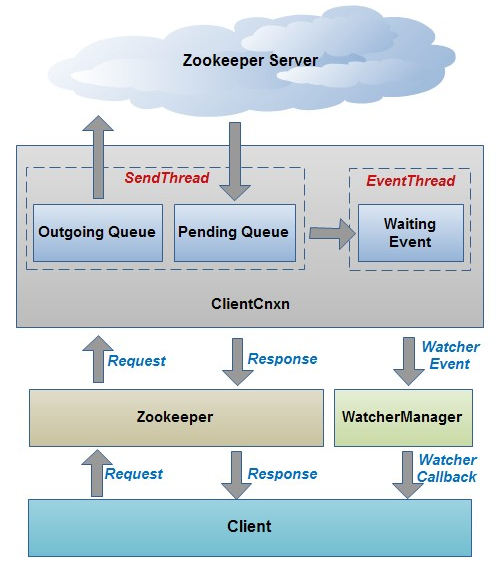

在 ZooKeeper中所有异步通知事件都是由 EventThread这个线程来处理的(串行通知)。因此当面临复杂问题处理时,往往力不从心。所以可以通过 inBackground接口,传入 Executor实例,将那些复杂的事件统一放到一个专门的线程池中。

/**

* 使用 Curator的异步接口

*/

public class Create_Node_Background_Sample {

static CountDownLatch latch = new CountDownLatch(2);

static ExecutorService executor = Executors.newFixedThreadPool(2);

public static void main(String[] args) throws Exception {

// 创建重试策略

ExponentialBackoffRetry retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建客户端

CuratorFramework client = CuratorFrameworkFactory.newClient("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181",

5000, 3000, retryPolicy);

// 创建 session会话

client.start();

client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.inBackground(new BackgroundCallback() {

@Override

public void processResult(CuratorFramework client, CuratorEvent event) throws Exception {

System.out.println("event[code:" + event.getResultCode() + ", type:" + event.getType() + "]");

System.out.println(Thread.currentThread().getName());

latch.countDown();

}

}, executor)

.forPath("/curator", "hahaha".getBytes(StandardCharsets.UTF_8));

client.create()

.creatingParentContainersIfNeeded()

.withMode(CreateMode.EPHEMERAL)

.inBackground(new BackgroundCallback() {

@Override

public void processResult(CuratorFramework client, CuratorEvent event) throws Exception {

System.out.println("event[code:" + event.getResultCode() + ", type:" + event.getType() + "]");

System.out.println(Thread.currentThread().getName());

latch.countDown();

}

})

.forPath("/curator", "hahaha".getBytes(StandardCharsets.UTF_8));

Thread.sleep(10000);

}

}

5.6 Curator典型使用场景

Curator不仅为开发者提供了便利的 API接口,而且提供了一些典型场景的使用参考。

Maven依赖:

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.6.3</version>

</dependency>

<dependency>

<groupId>org.apache.curator</groupId>

<artifactId>curator-recipes</artifactId>

<version>5.2.0</version>

</dependency>

事件监听

Curator引入了 Cache来实现对 ZooKeeper服务端事件的监听。Cache是 Curator中对事件监听的包装,它提供的事件监听,类似一个本地缓存视图和远程 ZooKeeper视图对比的过程。Cache分为两类监听类型:

-

节点监听(NodeCache) -> NodeCacheListener;

NodeCache(CuratorFramework client, String path); NodeCache(CuratorFramework client, String path, boolean dataIsCompressed)- client:客户端实例

- pah:节点路径

- dataIsCompressed:是否进行数据压缩

/** * NodeCache使用 */ public class NodeCache_Sample { static String PATH = "/curator/asd"; static CuratorFramework client = CuratorFrameworkFactory.builder() .connectString("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181") .sessionTimeoutMs(5000) .retryPolicy(new ExponentialBackoffRetry(1000, 3)) .build(); public static void main(String[] args) throws Exception { client.start(); client.create() .creatingParentContainersIfNeeded() .withMode(CreateMode.EPHEMERAL) .forPath(PATH, "123".getBytes(StandardCharsets.UTF_8)); NodeCache cache = new NodeCache(client, PATH, false); cache.start(true); cache.getListenable().addListener(() -> { ChildData child = cache.getCurrentData(); if (child != null) System.out.println(new String(cache.getCurrentData().getData())); }); client.setData().forPath(PATH, "adasd".getBytes(StandardCharsets.UTF_8)); Thread.sleep(1000); client.delete().deletingChildrenIfNeeded().forPath(PATH); Thread.sleep(1000); } } -

子节点监听(PathChildrenCache)

PathChildrenCache(CuratorFramework client, String path, boolean cacheData, boolean dataIsCompressed, final CloseableExecutorService executorService);- executorService:线程池

- cacheData:是否把节点的内容缓存起来,用户在收到变更的同时也收到变更后的值

/** * PathChildrenCache使用 */ public class PathChildrenCache_Sample { static String PATH = "/curator"; static CuratorFramework client = CuratorFrameworkFactory.builder() .connectString("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181") .sessionTimeoutMs(5000) .retryPolicy(new ExponentialBackoffRetry(1000, 3)) .build(); public static void main(String[] args) throws Exception { client.start(); PathChildrenCache cache = new PathChildrenCache(client, PATH, true); cache.start(PathChildrenCache.StartMode.POST_INITIALIZED_EVENT); cache.getListenable().addListener(new PathChildrenCacheListener() { @Override public void childEvent(CuratorFramework client, PathChildrenCacheEvent event) throws Exception { System.out.println(event.getType() + " " + event.getData() + " " + event.getInitialData()); } }); client.create().withMode(CreateMode.PERSISTENT).forPath(PATH); Thread.sleep(1000); client.create().withMode(CreateMode.PERSISTENT).forPath(PATH + "/c1"); client.delete().forPath(PATH + "/c1"); Thread.sleep(1000); client.delete().forPath(PATH); Thread.sleep(1000); } }

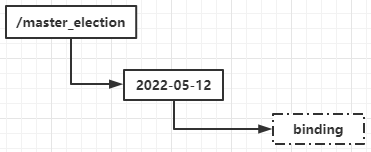

Master选举

借助 ZooKeeper我们可以比较方便地实现 Master选举的功能,大体思路为:

选择一个根节点 /foo,多台机器同时针对该节点发起 create请求,创建 /foo/lock,利用 ZooKeeper的特性,最终只有一台机器能够创建成功,成功的那台机器就是 Master

Curator内有 LeaderSelector类,封装了所有和 Master选举相关的逻辑。

/**

* 使用 Curator实现分布式 Master选举

*/

public class Recipes_MasterSelect {

// 代表了一个 Master选举的根节点,表明本次 Master选举都是在该节点下进行的

static String master_path = "/curator_recipes_master_path";

static CuratorFramework client = CuratorFrameworkFactory.builder()

.connectString("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181")

.sessionTimeoutMs(5000)

.retryPolicy(new ExponentialBackoffRetry(1000,3))

.build();

public static void main(String[] args) throws InterruptedException {

client.start();

// Curator在成功获取 Master权限的时候会回调监听器

LeaderSelector selector = new LeaderSelector(client, master_path, new LeaderSelectorListenerAdapter() {

// Curator会在竞争到 Master后自动调用该方法,一旦执行完 takeLeaderShip方法,Curator会立即释放 Master权限,然后开始下一轮选举

@Override

public void takeLeadership(CuratorFramework client) throws Exception {

System.out.println("成为 Master角色");

Thread.sleep(1000);

System.out.println("完成 Master操作,释放 Master权限");

}

});

selector.autoRequeue();

selector.start();

Thread.sleep(Integer.MAX_VALUE);

}

}

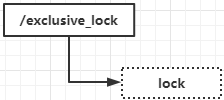

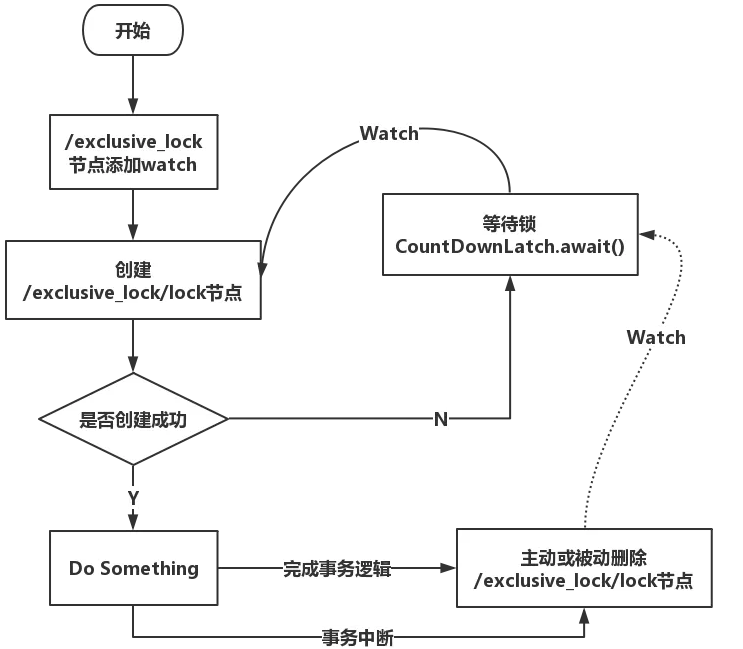

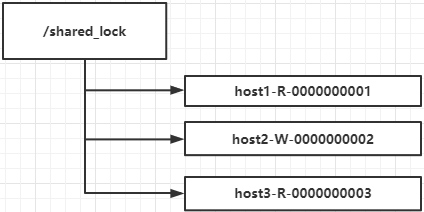

分布式锁

在分布式环境中,为了保证数据的一致性,经常需要在程序的某个运行点进行同步控制。

/**

* 使用 Curator实现分布式锁

*/

public class Recipes_Lock {

static String lock_path = "/curator_recipes_lock_path";

static CuratorFramework client = CuratorFrameworkFactory.builder()

.connectString("192.168.26.10:2181,192.168.26.20:2181,192.168.26.30:2181")

.sessionTimeoutMs(5000)

.retryPolicy(new ExponentialBackoffRetry(1000, 3))

.build();

public static void main(String[] args) throws InterruptedException {

client.start();

InterProcessMutex lock = new InterProcessMutex(client, lock_path);

CountDownLatch latch = new CountDownLatch(1);

for (int i = 0; i < 30; i++) {

new Thread(() -> {

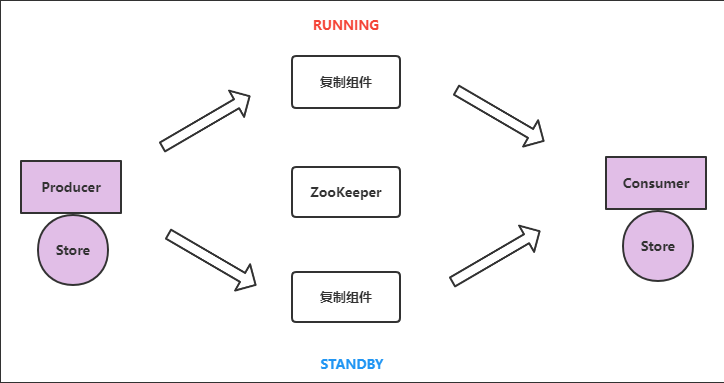

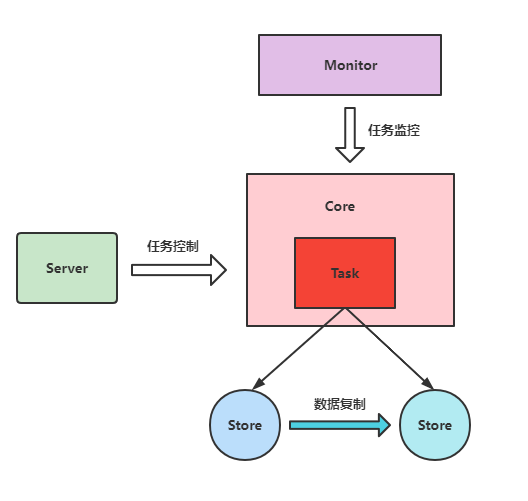

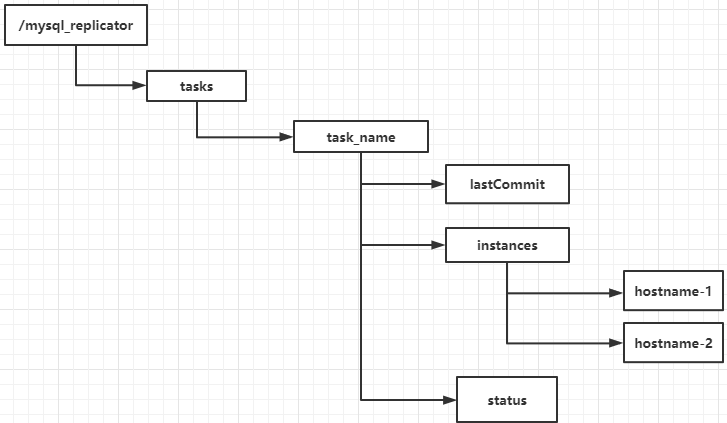

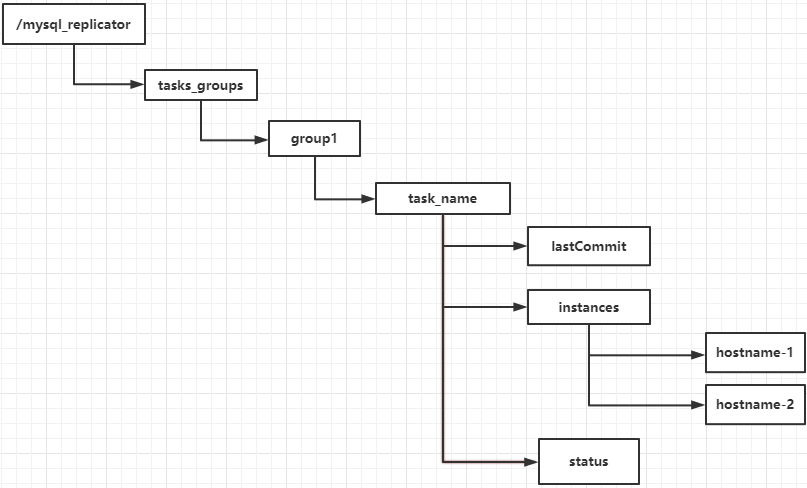

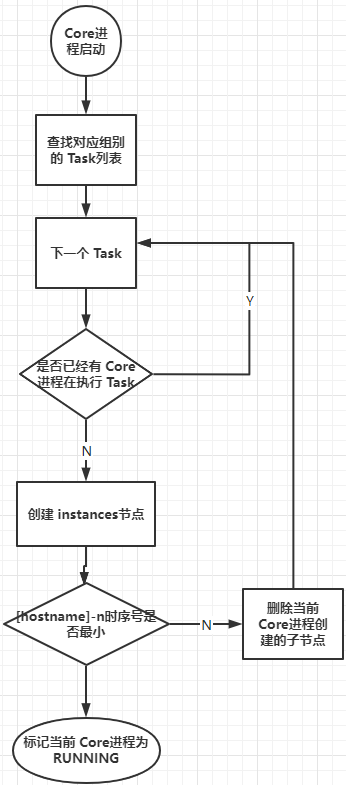

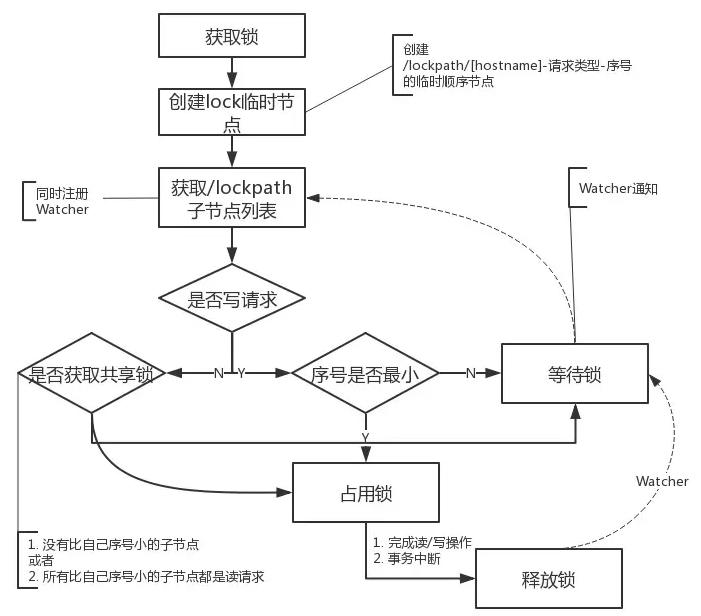

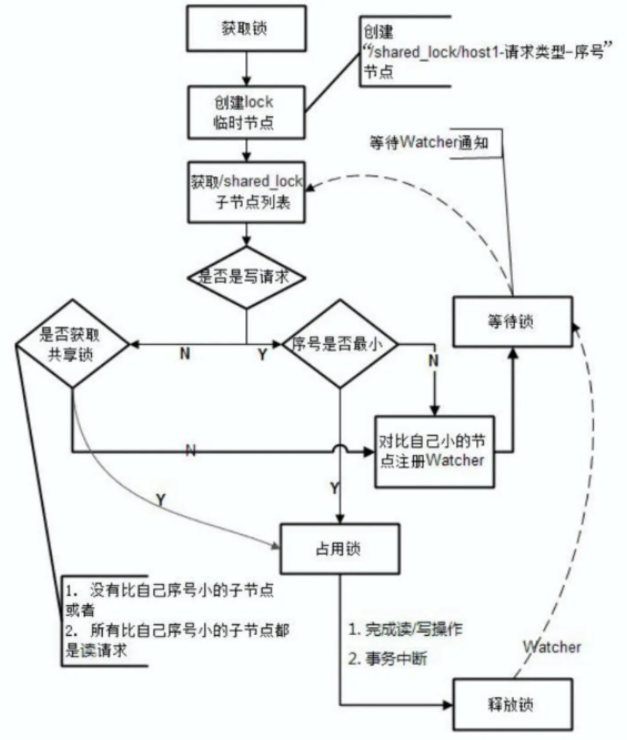

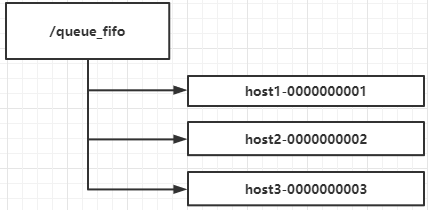

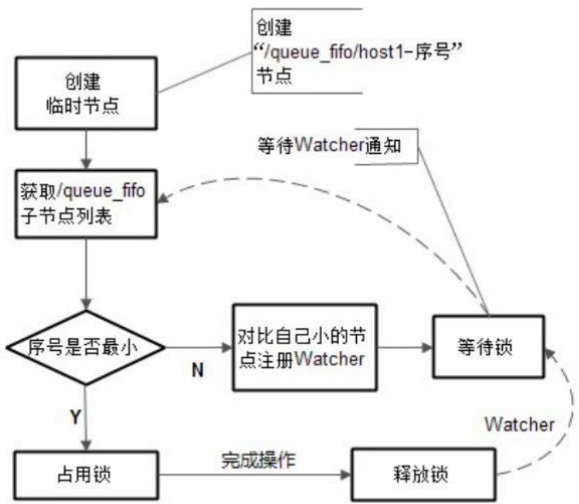

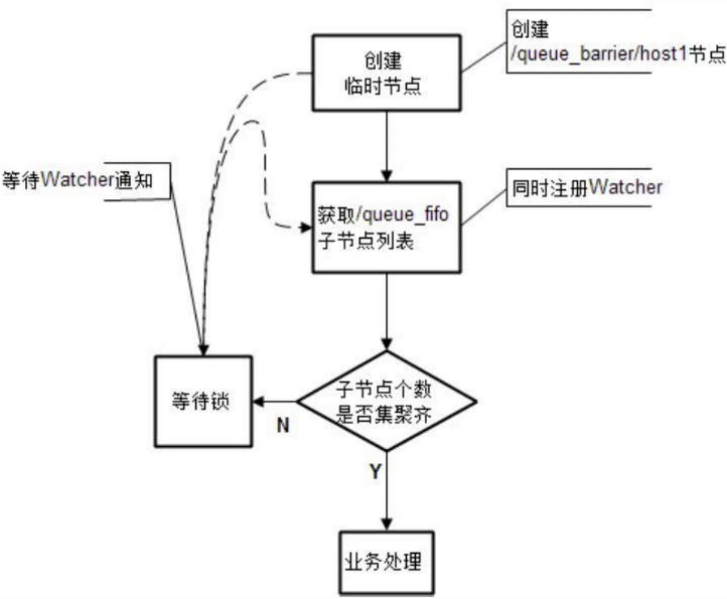

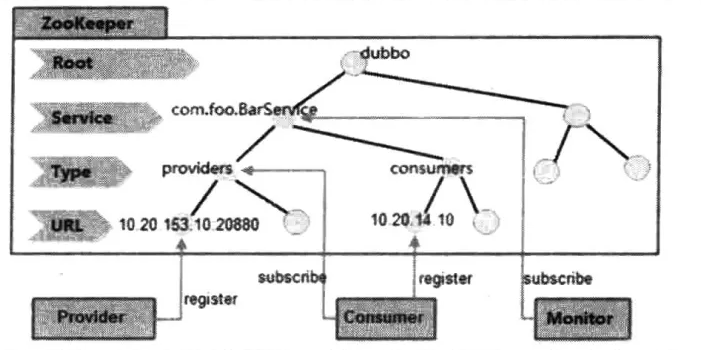

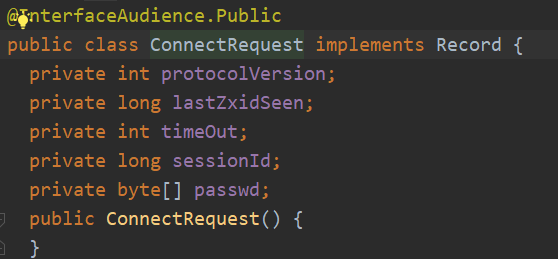

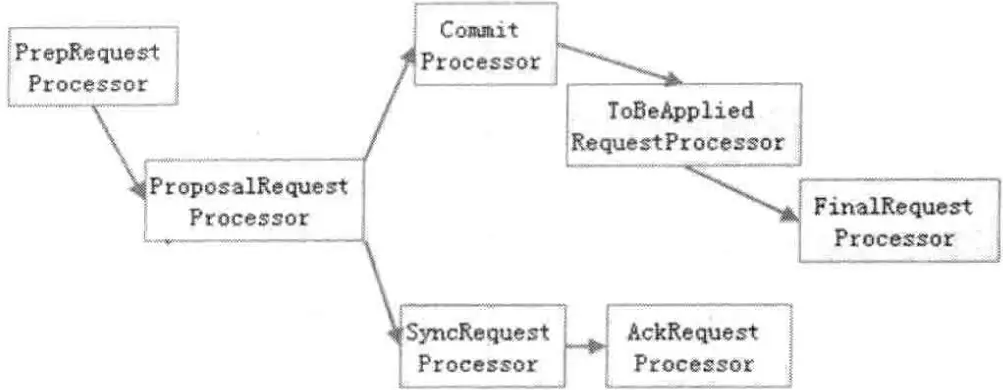

try {