说话人日志/分类/分割/跟踪(Speaker Diarisation)

简称SD,顾名思义,在采集的语音信号流中,分辨出不同说话人的说话时长并标注,即以时间为索引,检测出每段语音所对应的说话人身份,其通常由说话人分割和聚类两步组成。

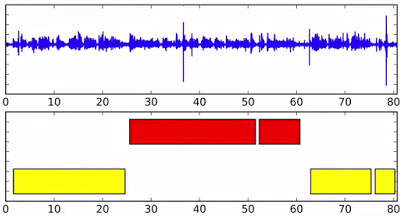

参照2010年8月的文献[1]中的一张图:

又称说话人分割等,在语音信号处理的多种场景下均有应用需求,近年来也被多来越多的研究者所关注。SD的方法分为以下两种:1)无监督方法,比如谱聚类以及k均值等;2)监督方法,深度神经网络,比如RNN等方法。

原理

Diarisation是一个生造的词,可以翻译为“分割和聚类”,在一些场景中,如一段电话对话、一场会议、一段广播语音或者是一个电视节目等等日常生活中的语音场景,对语音信息进行切分,找到每个人说的语音,即对整个语音信息的分割和聚类。

Speaker diarisation is the task to find “who spoke when”, while speech recognition is to find “what was spoken”. 这个在语音识别系统中,是作为一个对对话、会议和电视节目识别前的进行预处理的部分,同时在带有语音信息的视频理解等任务中,也是一个很重要的组成部分。

Speaker diarization consists of segmenting and clustering a speech recording into speaker-homogenous regions, using an unsupervised algorithm. In other words, given an audio track of a meeting, a speaker-diarization system will automatically discriminate between and label the different speakers (“Who spoke when?”). This involves speech/non-speech detection (“When is there speech?”) and overlap detection and resolution (“Who is overlapping with whom?”), as well as speaker identification.

所以事实上,SD不能简单的被翻译为说话人分割或者说话人分类。但是为了方便以及辨识性,大部分会如此称呼。

pipeline

参考http://pyannote.github.io/pyannote-metrics/reference.html,下图为SD的典型pipeline:

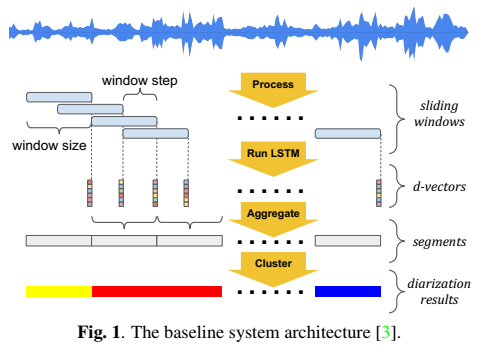

参考[3],首先一段语音信息流,通过VAD模块(Voice Activity Detection, 语音活跃性检测),检测出哪些帧是有语音的,哪些帧是没有语音的(无声音或者只有背景声)。接着通过CPD模块(Change Point Detection,变更点检测)来检测出说话人的变更点。最后对分割后的每一段语音,提取特征,进行聚类(Speaker Clustering),得到每一段的语音属于哪个人说的。当然最后,会使用迭代的方法,对上述过程进行反复优化迭代,即refine过程,来获得更好的diarisation的结果。

- VAD模块(Voice Activity Detection, 语音活跃性检测),任务就是找到,什么时候有语音,也可叫“端点检测”或者”End Point Detection”。传统方法基于信号处理(Model-free),如时域处理或者频域能量分析,这些方法很不鲁棒。比较好的是基于Model-based的方法。

- CPD模块(Change Point Detection,变更点检测),任务就是寻找说话人变更点,找到这些点,对语音信息进行分割。比如可以使用滑动窗,在语音流上滑动,当提取的特征对应的分数发生一定阈值以上的变更,就认为发生了说话人身份变更现象。也可以使用神经网络,对每个点进行一个分类,分出变更点和非变更点。

- 说话人聚类(Speaker Clustering)模块,就是对CPD模块的分割输出,进行聚类,将同一个人说的话聚类到一起。常用的方法如IAC、AHC、k-means以及谱聚类等,或者基于每个人的说话特点,提取特征进行聚类等。

- 最后对上述的流程进行反复迭代,refine结果。常用的方法如iterative Variational Bayes,以及不同迭代次数中,改变滑动窗的长度,甚至也有使用语音识别结果,来迭代修正前面的流程。

challenges

1、一个端到端模型?

2、说话人数目不确定、无上限,如何聚类?

3、CPD模块是否必要,如何改进适用?

基于特定人跟踪的在线说话人日志研究

论文题目:Online Neural Speaker Diarization with Target Speaker Tracking

作者列表:Weiqing Wang and Ming Li

论文原文:https://ieeexplore.ieee.org/document/10768974

预印版本:https://sites.duke.edu/dkusmiip/files/2024/11/main_taslp_weiqing_24.pdf

IEEE T-ASLP | 基于特定人跟踪的在线说话人日志研究 (qq.com)

说话人日志(Speaker Diarization,SD)旨在自动化识别多人对话中不同说话人的身份和说话时间区域,解决“谁在什么时间说”的问题。在常见的SD系统中,基于特定人语音活动(Target-Speaker Voice Activity Detection,TS-VAD)的方法在近些年取得了较好的性能。传统的TS-VAD系统作为一个二阶段方法,需要依赖一个前置的日志系统(例如模块化、端到端方法)获得初始的日志结果用于提取目标说话人嵌入,这种特点限制了TS-VAD系统的在线场景的应用。然而,TS-VAD系统自身天然地可以用滑窗地形式逐块处理输入音频,只要可以在线获得目标说话人的嵌入表征,那么TS-VAD就可以实时运行,这种潜力往往被忽视了。此外,如果TS-VAD本身可以生成目标说话人嵌入表示,就可以直接使用的那个神经网络完成整个说话人日志的输出,而无需复杂的多个模块组合。因此,我们在这篇文章里探索如何利用TS-VAD方法去在线获取目标说话人表征以完成在线说话人日志任务,并扩展到多通道和轻量化版本。

基于聚类的无监督方法

基于RNN的监督方法

UIS-RNN[2]

这是谷歌2019年发表的一篇文章,研究了实时处理的说话人分类,不限制说话人数目,基于d-vector特征,为每一个说话人建立了一个RNN模型,并且持续更新。文中表示实时说话人分割的准确率可以达到92%,并且DER降低至7.6%,超过了其先前基于聚类方法(8.8%)和深度网络嵌入方法(9.9%)。

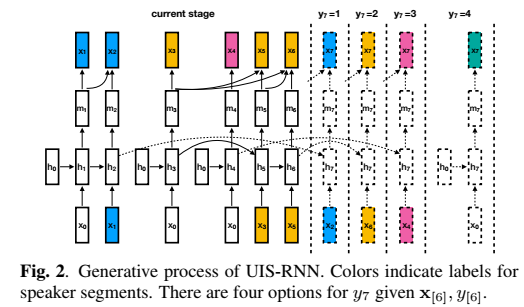

文章主要提出了无界间隔状态(Unbounded Interleaved-State) RNN,一个可以通过监督学习训练的对于时变数据分割和聚类的算法。

首先看一张图,这是文中的SD results show:

不同颜色表示不同的说话人,横轴为时间索引。

这一方法与通常聚类方法的主要区别在于研究人员使用了参数共享的循环神经网络为所有的说话人(embeddings)建模,并通过循环神经网络的不同状态来识别说话人,这就能将不同的语音片段与不同的人对应起来。

具体来看,每一个人的语音都可以看做权值共享的RNN的一个实例,由于生成的实例不受限所以可以适应多个说话人的场景。将RNN在不同输入下的状态对应到不同的说话人即可实现通过监督学习来实现语音片段的归并。通过完整的监督模型,可以得到语音中说话人的数量,并可以通过RNN携带时变的信息,这将会对在线系统的性能带来质的提升。

系统的baseline结构为:

UIS-RNN是一个整句(X,Y)的在线生成处理过程,提出的算法结构为:

解码过程中采用最大后验概率准则解码,采用beam search方法处理。

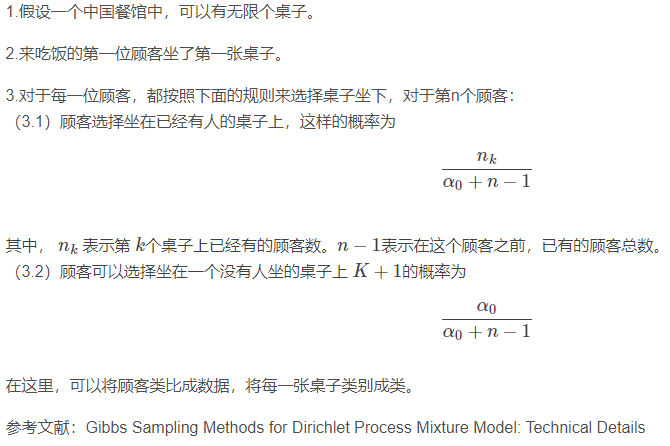

同时,在speaker segment建模中,采用了一个贝叶斯非参数模型:distance dependent Chinese restaurant process (ddCRP)的loss,用来估计number of clusters。

为验证模型,作者们选用数据集CALLHOME(2000 NIST SRE,disk-8),5折交叉验证,模型效果采用DER评价参数衡量。此外,又使用了两个off-domain数据集:Switchboard(2000 NIST SRE,disk-6) 和 ICSI会议语料库。最终DER可以低至7.6%,分割性能超过现有的SOTA算法。

在未来研究人员将会改进这一模型用于离线解码上下文信息的整合;同时还希望直接利用声学特征代替d-vectors作为音频特征,这样就能实现完整的端到端模型了。

中餐馆过程

Chinese restaurant process,中国餐馆过程是一个典型的Dirichlet过程混合模型。参考:中国餐馆过程(Chinese restaurant process)_qy20115549的博客-CSDN博客

集束搜索

Beam Search Algorithm. 可参考:集束搜索(Beam Search) - Skye_Zhao - 博客园 (cnblogs.com)

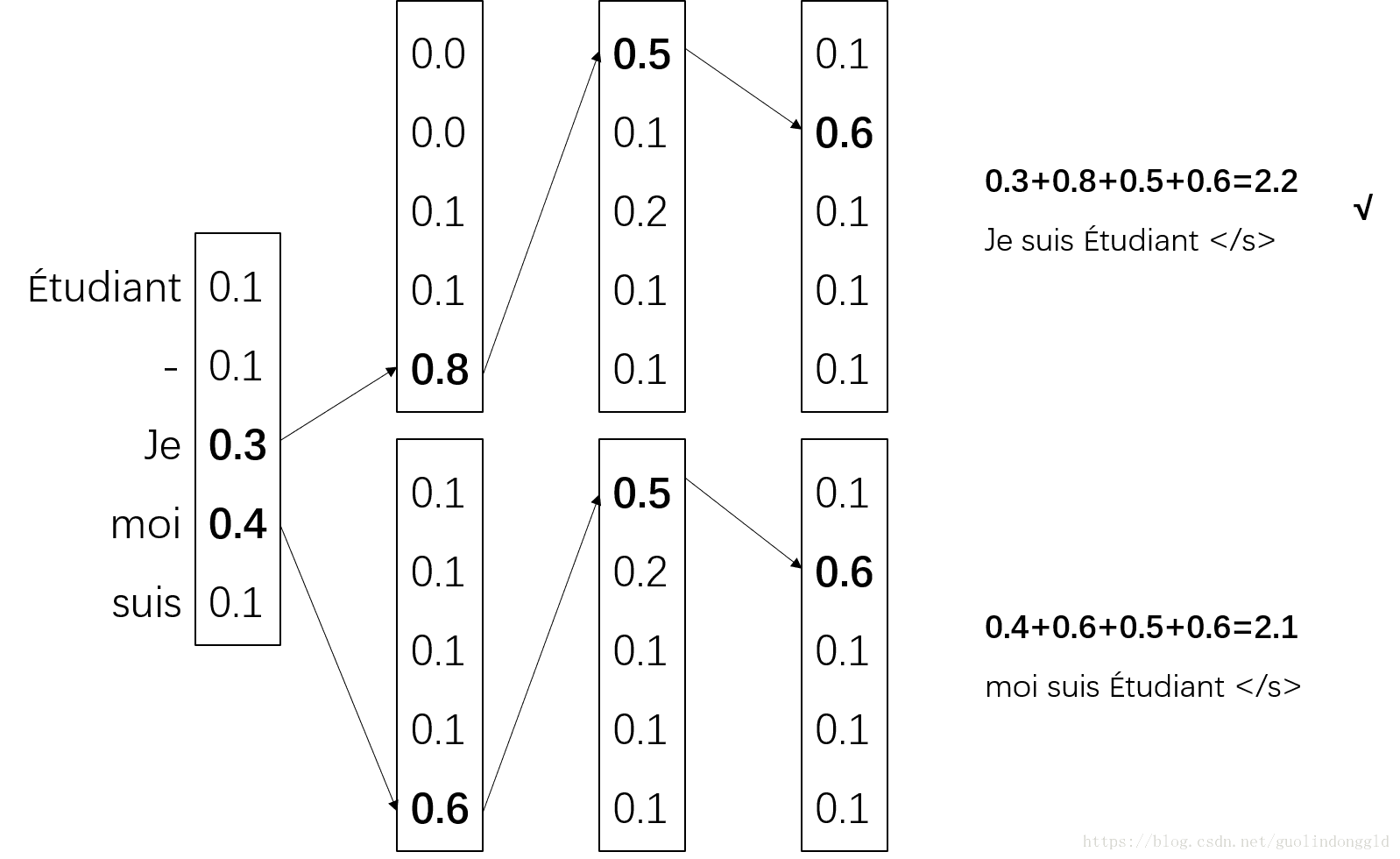

贪心搜索只选择了概率最大的一个,而集束搜索则选择了概率最大的前k个。这个k值也叫做集束宽度(Beam Width)。下图中k=2:

Beam Search(集束搜索)是一种启发式图搜索算法,通常用在图的解空间比较大的情况下,为了减少搜索所占用的空间和时间,在每一步深度扩展的时候,剪掉一些质量比较差的结点,保留下一些质量较高的结点。这样减少了空间消耗,并提高了时间效率。

使用广度优先策略建立搜索树,在树的每一层,按照启发代价对节点进行排序,然后仅留下预先确定的个数(Beam Width-集束宽度)的节点,仅这些节点在下一层次继续扩展,其他节点就被剪掉了。

- 将初始节点插入到list中,

- 将给节点出堆,如果该节点是目标节点,则算法结束;

- 否则扩展该节点,取集束宽度的节点入堆。然后到第二步继续循环。

- 算法结束的条件是找到最优解或者堆为空。

参考

[1] Speaker Diarization: A Review of Recent Research

[2] Fully Supervised Speaker Diarization, 2019 ICASSP accepted.

[3] 剑桥大学张超:《基于深度学习的多说话人分割聚类》 (qq.com)

浙公网安备 33010602011771号

浙公网安备 33010602011771号