一、机器学习基础

算法是核心,数据和计算是基础。

数据类型

- 离散型数据:记录不同类别个体的数目所得到的数据,又称为计数数据,全部是整数,不能再细分,也不能进一步提高精度。

- 连续型数据:变量可以在某个范围内取任意数,即变量的取值可以是连续的,通常是非整数。

- 离散型是区间内不可分,连续型是区间内可分。

机器学习算法分类

监督学习(预测):特征值+目标值

- 分类(离散值):k-邻近算法、贝叶斯分类、决策树和随机森林、逻辑回归、神经网络

- 回归(连续值):线性回归、岭回归

- 标注:隐马尔科夫模型

无监督学习:特征值

- 聚类:k-means

基本流程

- 原始数据(公司本身的数据、合作过来数据、购买的数据)----明确问题做什么

- 建立模型----根据数据类型划分应用种类

- 数据的基本处理----pandas处理数据(缺失值、合并表...)

- 特征工程----特征进行处理

- 找到合适的算法去进行分析(模型=算法+数据)

- 模型的评估,判定效果

- 效果好

- 上线使用(API形式提供)

- 效果不好

- 换算法、换参数、特征工程

二、 sklearn数据集与估计器

1、数据集划分

训练和评估不能用一个数据集。

训练集:构建模型用于训练

测试集:评估模型是否有效

训练集和测试集的比例一般是7:3、8:2、7.5:2.5(最佳比例)

2、sklearn数据集API

数据集:sklearn.datasets

- 加载获取流行数据集

datasets.load_*()

- 获取小规模数据集,数据包含在datasets里

datasets.fetch_*(data_home=None)

- 获取大规模数据集,需要从网络上下载,函数的第一个参数是data_home,表示数据集下载的目录,默认是 ~/scikit_learn_data/

load*和fetch*返回的数据类型:datasets.base.Bunch(一个字典格式)

- data:特征数据数组,是 [n_samples * n_features] 的二维 numpy.ndarray 数组

- target:标签数组,是 n_samples 的一维 numpy.ndarray 数组

- DESCR:数据描述

- feature_names:特征名,新闻数据,手写数字、回归数据集没有

- target_names:标签名,回归数据集没有

例如

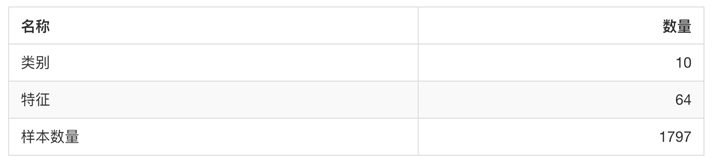

分类数据集

sklearn.datasets.load_iris() 加载并返回鸢尾花数据集

sklearn.datasets.load_digits() 加载并返回数字数据集

from sklearn.datasets import load_iris li = load_iris() print("特征值:") # 二维数组 print(li.data) # 150个样本,4个特征 print("目标值:") print(li.target) # 3种类别,每个类别50个 print("描述:") print(li.DESCR)

数据集划分:sklearn.model_selection.train_test_split

sklearn.model_selection.train_test_split(*arrays, **options)

x 数据集的特征值

y 数据集的标签值

test_size 测试集的大小,一般为float

random_state 随机数种子,不同的种子会造成不同的随机采样结果。相同的种子采样结果相同。

return 训练集特征值,测试集特征值,训练标签,测试标签 (默认随机取)

from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split li = load_iris() # 返回值包含了训练集x_train,y_train和测试集x_test,y_test x_train, x_test, y_train, y_test = train_test_split(li.data, li.target, test_size=0.25) print("训练集特征值和目标值:", x_train, y_train) print("测试集特征值和目标值:", x_test, y_test)

用于分类的大数据集

sklearn.datasets.fetch_20newsgroups(data_home=None,subset=‘train’)

- subset: 'train'或者'test','all',可选,选择要加载的数据集,“训练”,“测试”或“全部”。

datasets.clear_data_home(data_home=None)

- 清除目录下的数据

from sklearn.datasets import fetch_20newsgroups news = fetch_20newsgroups(subset="all") print(news.data) print(news.target)

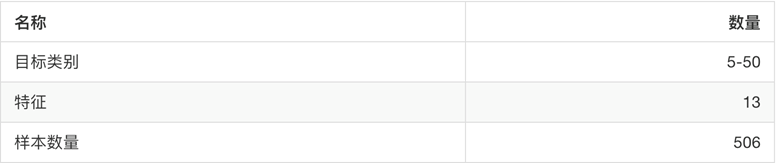

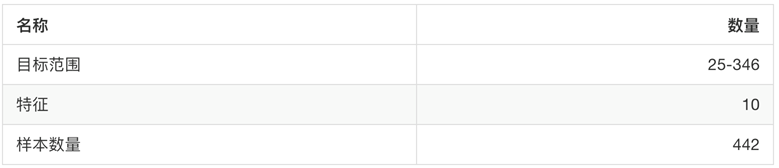

回归数据集

sklearn.datasets.load_boston() 加载并返回波士顿房价数据集

sklearn.datasets.load_diabetes() 加载和返回糖尿病数据集

from sklearn.datasets import load_boston lb = load_boston() print("特征值:") # 二维数组 print(lb.data) # 150个样本,4个特征 print("目标值:") print(lb.target) # 3种类别,每个类别50个 print("描述:") print(lb.DESCR)

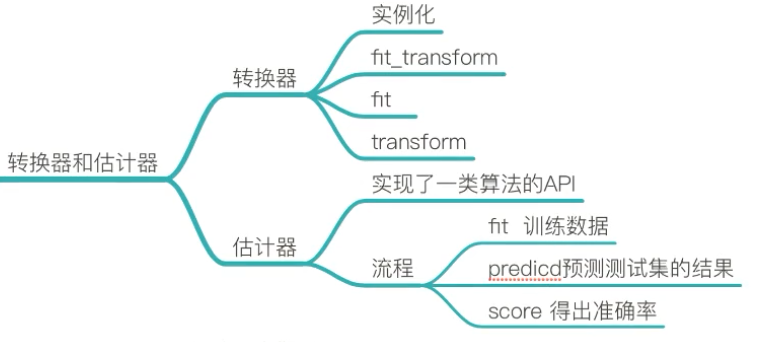

3、转换器与估计器

特征工程的步骤:

- 实例化(实例化的是一个转换器类) 调用fit_transform()(输入数据并转换。对于文档建立分类词频矩阵,不能同时调用)

- fit()输入数据并做一些如平均值标准差的计算

- transform()进行数据的转换

估计器:是一类实现了算法的API

用于分类的估计器:

sklearn.neighbors k-近邻算法

sklearn.naive_bayes 贝叶斯

sklearn.linear_model.LogisticRegression 逻辑回归

用于回归的估计器:

sklearn.linear_model.LinearRegression 线性回归

sklearn.linear_model.Ridge 岭回归

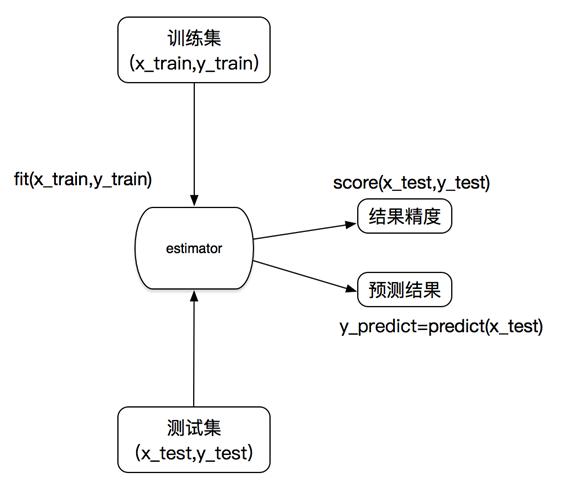

估计器的工作流程:

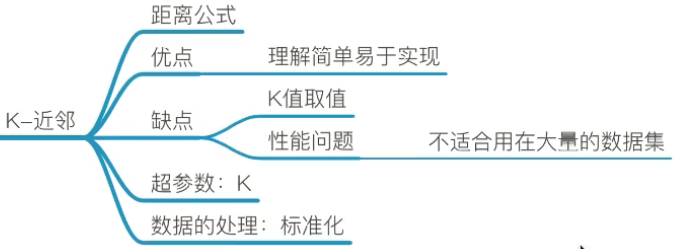

三、k-近邻算法

分类算法:目标值是离散型

k-近邻(KNN)

定义:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

来源:KNN算法最早是由Cover和Hart提出的一种分类算法

两个样本的距离可以通过如下公式计算,又叫欧式距离

比如说,a(a1,a2,a3),b(b1,b2,b3)

![]()

思想:相似的样本,特征之间的值应该都是相近的

为了防止某一个特征的值对最后的结果造成影响,k-近邻算法需要做标准化处理

k-近邻算法API

sklearn.neighbors.KNeighborsClassifier(n_neighbors=5,algorithm='auto')

- n_neighbors:int,可选(默认= 5),k_neighbors查询默认使用的邻居数(找到最近的k个邻居)

- algorithm:{‘auto’,‘ball_tree’,‘kd_tree’,‘brute’},可选用于计算最近邻居的算法:‘ball_tree’将会使用 BallTree,‘kd_tree’将使用 KDTree。‘auto’将尝试根据传递给fit方法的值来决定最合适的算法。 (不同实现方式影响效率)

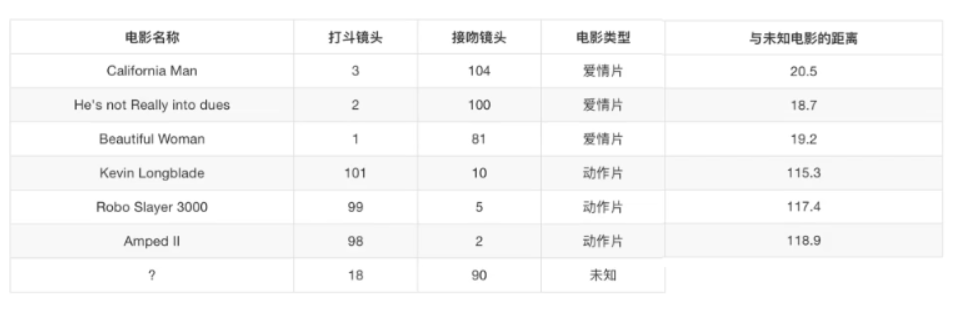

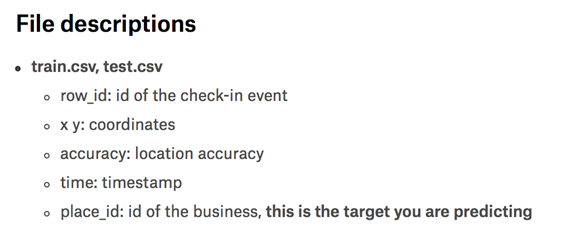

预测入住位置

分类问题

特征值:x,y坐标,定位准确性,时间

目标值:入住位置的id

数据处理

(1)缩小x,y,即缩小范围,节省时间

(2)时间戳进行处理(年、月、日、周、时、分、秒),当做新的特征

(3)入住位置的类别数量太多(几千-几万),导致准确率降低,把少于指定签到人数的位置删除

from sklearn.neighbors import KNeighborsClassifier from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler import pandas as pd def knncls(): """ k-近邻预测用户签到位置 :return:None """ # 读取数据 data = pd.read_csv("./data/FBlocation/train.csv") # print(data.head(10)) # 处理数据 # 1.缩小数据,查询数据筛选 data = data.query("x > 1.0 & x < 1.25 & y > 2.5 & y > 2.75") # 2.处理时间戳,转换成秒 time_value = pd.to_datetime(data['time'], unit='s') # print(time_value) # 3.把日期格式转换成字典格式 time_value = pd.DatetimeIndex(time_value) # 4.构造成一些新的特征 data['day'] = time_value.day # 会报警告,建议用loc data['hour'] = time_value.hour data['weekday'] = time_value.weekday # 5.删除时间戳特征,pandas里列是1 data = data.drop(["time"], axis=1) # 6.对签到人数少于n的目标位置删除,统计-分组-求和 place_count = data.groupby("place_id").count() # 分组 # 上一步使得index变成了place_id,row_id现在变成了place_id对应的次数 # 我们把次数>3的保留,然后重设index,使得index重新排列 tf = place_count[place_count.row_id > 3].reset_index() # 判断data里的place_id是否在tf里,如果在就保留下来 data = data[data['place_id'].isin(tf.place_id)] # 7.取出数据当中的特征值和目标值 y = data["place_id"] x = data.drop(['row_id', 'place_id'], axis=1) # 按列删除 # 8.分割数据,分成训练集和测试集,得到训练集和测试集的特征值、训练集和测试集的目标值 x_train, x_test, y_train, y_test = train_test_split(x, y, test_size=0.25) # 特征工程(标准化) std = StandardScaler() # 对训练集和测试集的特征值进行标准化 x_train = std.fit_transform(x_train) x_test = std.transform(x_test) # 不用再fit计算平均值标准差等 # knn算法 knn = KNeighborsClassifier(n_neighbors=9) knn.fit(x_train, y_train) # 传入数据 y_predict = knn.predict(x_test) # 得出预测结果 print("预测的目标签到位置为:", y_predict) print("预测的准确率为:", knn.score(x_test, y_test)) # 得出预测的准确率 return None if __name__ == '__main__': knncls()

![]()

knn总结:

(1)k值取多大,有什么影响?

k值取很小:容易受异常点影响

k值取很大:容易受k值数量(类别)波动影响

(2)性能问题

样本数大时,逐个计算距离,时间复杂度高

(3)优点

简单,易于理解和实现,无需估计参数,无需训练

(4)缺点

懒惰算法,对测试样本分类时的计算量大,内存开销大

必须指定k值,k值选择不当则分类精度不能保证

(5)加快搜索速度---基于算法的改进KDTree,API里有实现

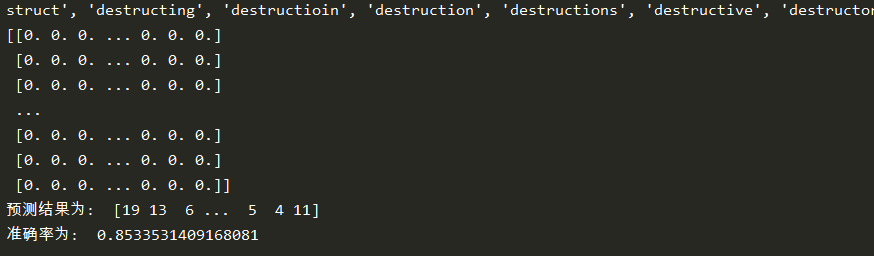

四、朴素贝叶斯算法

1、概率基础

概率:一件事情发生的可能性。

联合概率:包含多个条件,且所有条件同时成立的概率

P(A,B) = P(A)P(B)

条件概率:事件A在另外一个事件B已经发生的条件下的概率

P(A|B) = P(AB)/P(B)

若A1,A2相互独立,P(A1,A2|B) = P(A1|B)P(A2|B)

朴素贝叶斯应用前提:特征独立

贝叶斯公式:

W为给定文档的特征值(频数统计,预测文档提供),C为文档类别

![]()

P(C):每个文档类别的概率(某类别文档数/总文档数量)

P(W|C):给定类别下特征(被预测文档中出现的词)的概率

P(W):预测文档中每个词的概率

首先通过tf-idf确定每篇文章中重要的词,然后统计一些公共的重要词语,得到下面的统计结果:

P(科技 | 影院,支付宝,云计算) = P(影院,支付宝,云计算 | 科技)P(科技) = (8/100)(20/100)(63/100)(30/90) = 0.00456109

P(娱乐 | 影院,支付宝,云计算) = P(影院,支付宝,云计算 | 娱乐)P(娱乐) = (56/121)(15/121)(0/121)(60/90) = 0

预测文档属于科技类。

上例中娱乐概率为0是不合理的,如果词频列表里有很多出现次数都为0,很可能计算结果都为0。

拉普拉斯平滑系数

防止分类时类别概率为0。

P(F1|C) = (Ni+α)/(N+αm)

α为指定的系数一般为1,m为训练文档中统计出的特征词个数。

P(科技 | 影院,支付宝,云计算) = P(影院,支付宝,云计算 | 科技)P(科技) = ((8+1)/(100+4))((20+1)/(100+4))((63+1)/(100+4))(30/90)

P(娱乐 | 影院,支付宝,云计算) = P(影院,支付宝,云计算 | 娱乐)P(娱乐) = ((56+1)/(121+1*4))((15+1)/(121+1*4))((0+1)/(121+1*4))(60/90)

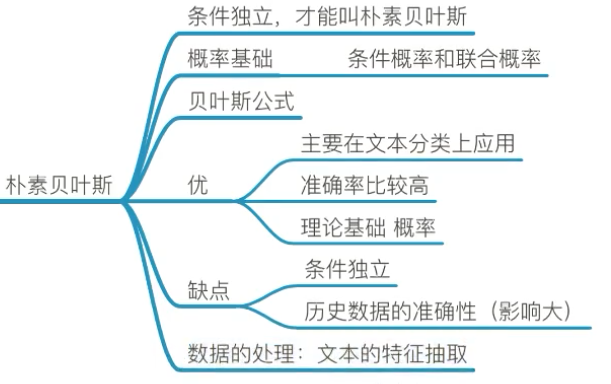

2、朴素贝叶斯

sklearn.naive_bayes.MultinomialNB

sklearn.naive_bayes.MultinomialNB(alpha = 1.0)

朴素贝叶斯分类

alpha:拉普拉斯平滑系数

20类新闻分类:

20个新闻组数据集包含20个主题的18000个新闻

朴素贝叶斯案例流程:

① 加载20类新闻数据,并进行分割

② 生成文章特征词

③ 朴素贝叶斯estimator流程进行预估

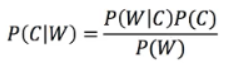

from sklearn.datasets import fetch_20newsgroups from sklearn.model_selection import train_test_split from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.naive_bayes import MultinomialNB def naivebayes(): """ 朴素贝叶斯进行文本分类 :return: None """ news = fetch_20newsgroups(subset='all') # 进行数据分割 x_train, x_test, y_train, y_test = train_test_split(news.data, news.target, test_size=0.25) # 对数据集进行特征抽取 tf = TfidfVectorizer() x_train = tf.fit_transform(x_train) # 以训练集的词列表进行重要性统计 print(tf.get_feature_names()) x_test = tf.transform(x_test) # 以测试集的词列表进行重要性统计 print(x_train.toarray()) # 打印sparse矩阵 # 朴素贝叶斯 mlt = MultinomialNB(alpha=1.0) # 朴素贝叶斯不能通过调参来提高准确率 mlt.fit(x_train, y_train) y_predict = mlt.predict(x_test) print("预测结果为: ", y_predict) print("准确率为: ", mlt.score(x_test, y_test)) return None if __name__ == '__main__': naivebayes()

朴素贝叶斯总结

优点:

- 发源于古典数学理论,有稳定的分类效率。

- 对缺失数据不太敏感,算法也比较简单,常用于文本分类。

- 分类准确度高,速度快。

- 不需要调参。

缺点:

- 由于使用了样本数据独立性的假设,如果样本属性有关联时其效果不好。

- 训练集误差大会导致结果不好。

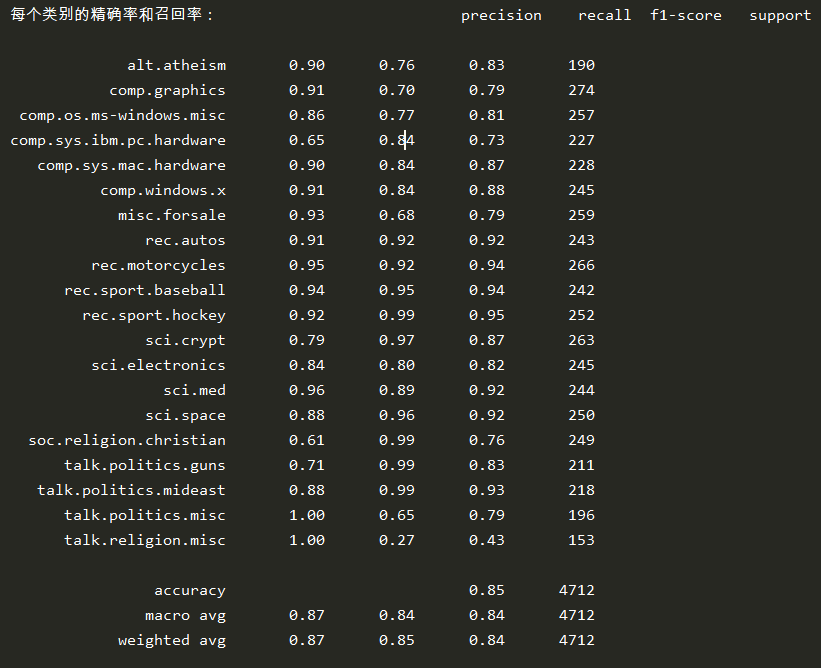

五、分类模型的评估

一般常见使用的是准确率 estimator.score() ,即预测结果正确的百分比。

但是除了准确率,还有其他的评估标准吗?

1、精确率和召回率

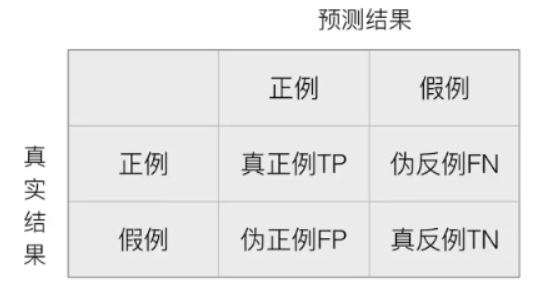

混淆矩阵

在分类任务下,预测结果与正确标记之间存在四种不同的组合,构成混淆矩阵。对于每个类别,都有一个混淆矩阵。

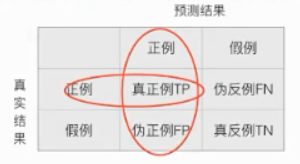

精确率:预测结果为正例样本中真实为正例的比例(查得准)

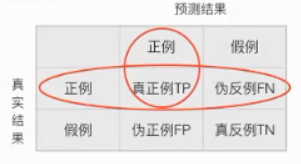

召回率:真实为正例的样本中预测结果为正例的比例(查得全)(对正样本的区分能力)

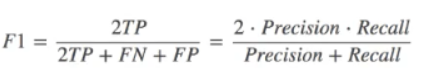

F1-score:反映了模型的稳健性。

分类模型评估API:

sklearn.metrics.classification_report

sklearn.metrics.classification_report(y_true, y_pred, target_names=None)

- (真实目标值,估计器预测目标值,目标类别名称)

- return:每个类别精确率与召回率

在朴素贝叶斯案例上增加如下代码:

print("每个类别的精确率和召回率:", classification_report(y_test, y_predict, target_names=news.target_names))

2、模型的选择与调优

① 交叉验证

为了让被评估的模型更加准确可信。

把训练集n等分,再分成训练集和验证集,每次更换不同的验证集,使用每个验证集可以得出一个准确率,最后将n组模型的结果取平均值作为最终结果。

求四个模型的平均结果。

以上称为4折交叉验证。

② 网格搜索

网格搜索,又称超参数搜索。通常情况下,有很多参数是需要手动指定的(如k近邻算法中的k值),叫做超参数。

但是手动过程繁杂,所以需要对模型预设几种超参数组合。

每组超参数都采用交叉验证来进行评估,最后选出最优参数组合建立模型。

网格搜索API:Cross Validation

sklearn.model_selection.GridSearchCV

sklearn.model_selection.GridSearchCV(estimator, param_grid=None, cv=None)

- 对估计器的指定参数值进行详尽搜索

- (估计器对象,估计器参数,指定几折交叉验证)其中估计器参数为字典类型{"参数名":[一些值]} {"n-neighbors":[1, 3, 5]}

- fit:输入训练数据

- score:准确率

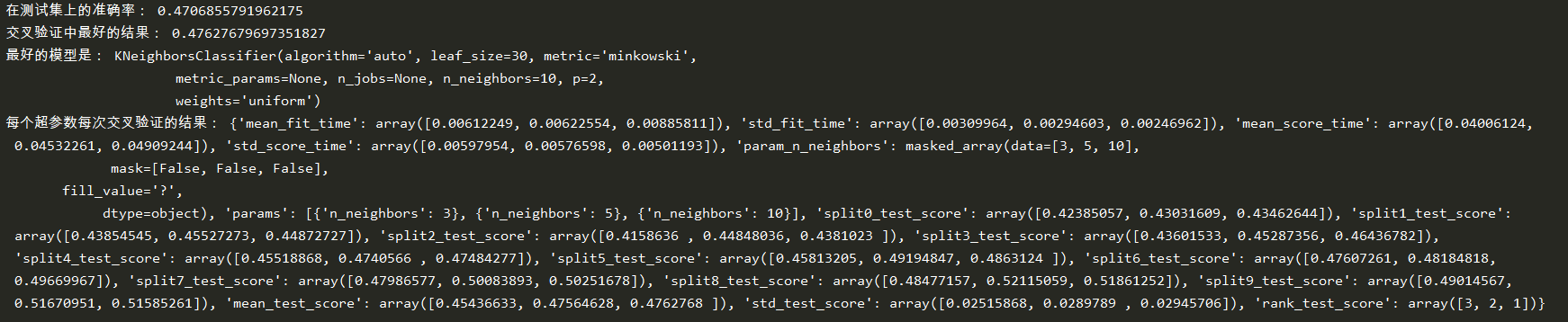

- 结果分析:

- best_score:在交叉验证中验证的最好结果

- best_estimator_:最好的参数模型

- cv_results_:每次交叉验证后的验证集准确率结果和训练集准确率结果

修改knn案例如下:

# 进行算法流程 knn = KNeighborsClassifier(n_neighbors=8) # 构造一些参数的值进行搜索 param = {"n_neighbors": [3, 5, 10]} # 进行网格搜索 gc = GridSearchCV(knn, param_grid=param, cv=10) gc.fit(x_train, y_train) # 预测准确率 print("在测试集上的准确率:", gc.score(x_test, y_test)) print("交叉验证中最好的结果:", gc.best_score_) print("最好的模型是:", gc.best_estimator_) print("每个超参数每次交叉验证的结果:", gc.cv_results_)