支持向量机SVM

此系列笔记来源于

Coursera上吴恩达老师的机器学习课程

支持向量机

优化目标

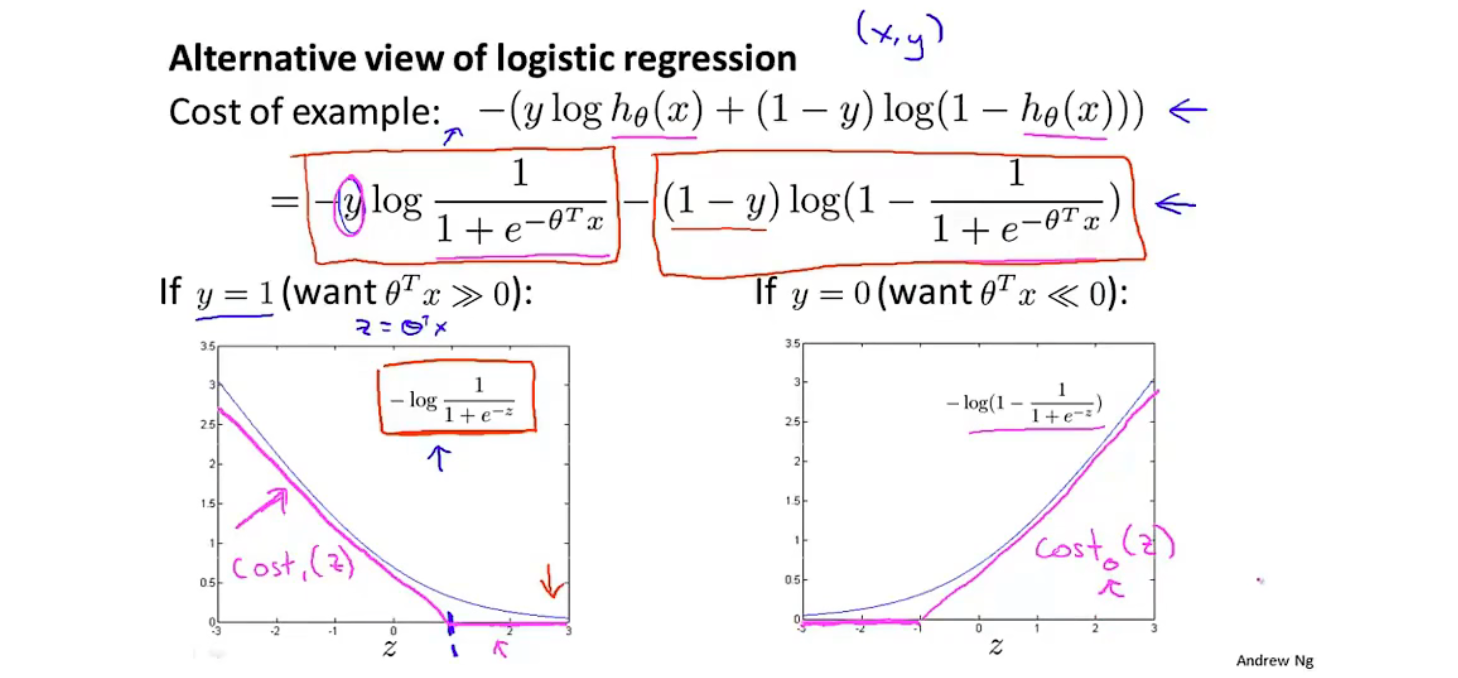

我们将逻辑回归中的曲线,变为紫色的线,由一条斜的直线和一条水平直线组成,并将其对应的函数变为 和

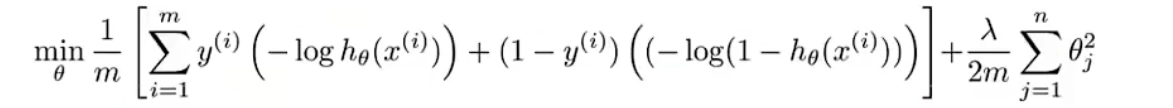

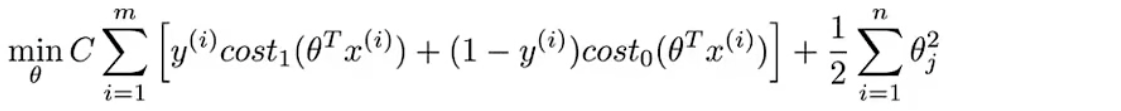

在逻辑回归中,这个是我们要优化的代价函数,我们按上面所述的更改函数,同时去掉 部分,并在前一项之前加常数 C作为更改权重的参数。

即:

C可以理解为

由此我们便能得到SVM中我们所要优化的函数:

这里的假设函数:

大间隔分类器

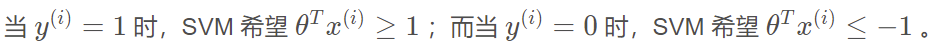

对于SVM的假设函数,我们当然希望其cost函数为0,由图像可知,

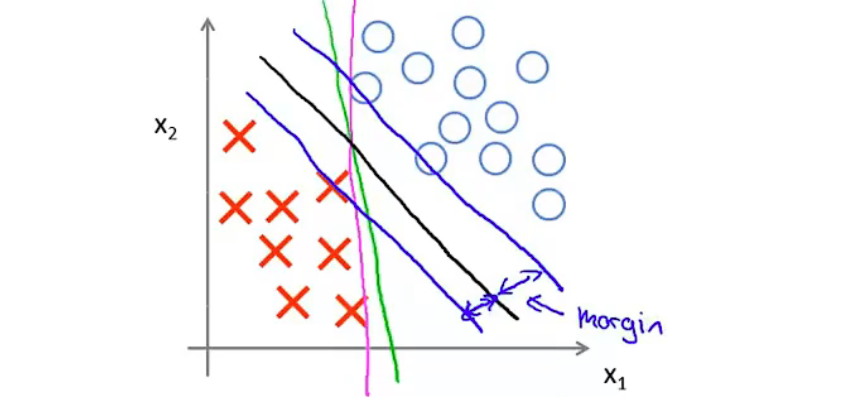

SVM是一种大间隔分类器,即其所绘决策边界与各类之间有着较大的间隔

例:图中黑线,而非绿线和紫线

由于此特性,SVM具有鲁棒性(面对异常时的具有更高的稳定性、容错率)

数学原理:

因为在满足上面的我们希望的条件时,代价函数的前半部分基本等于 0,因此只用讨论第二项

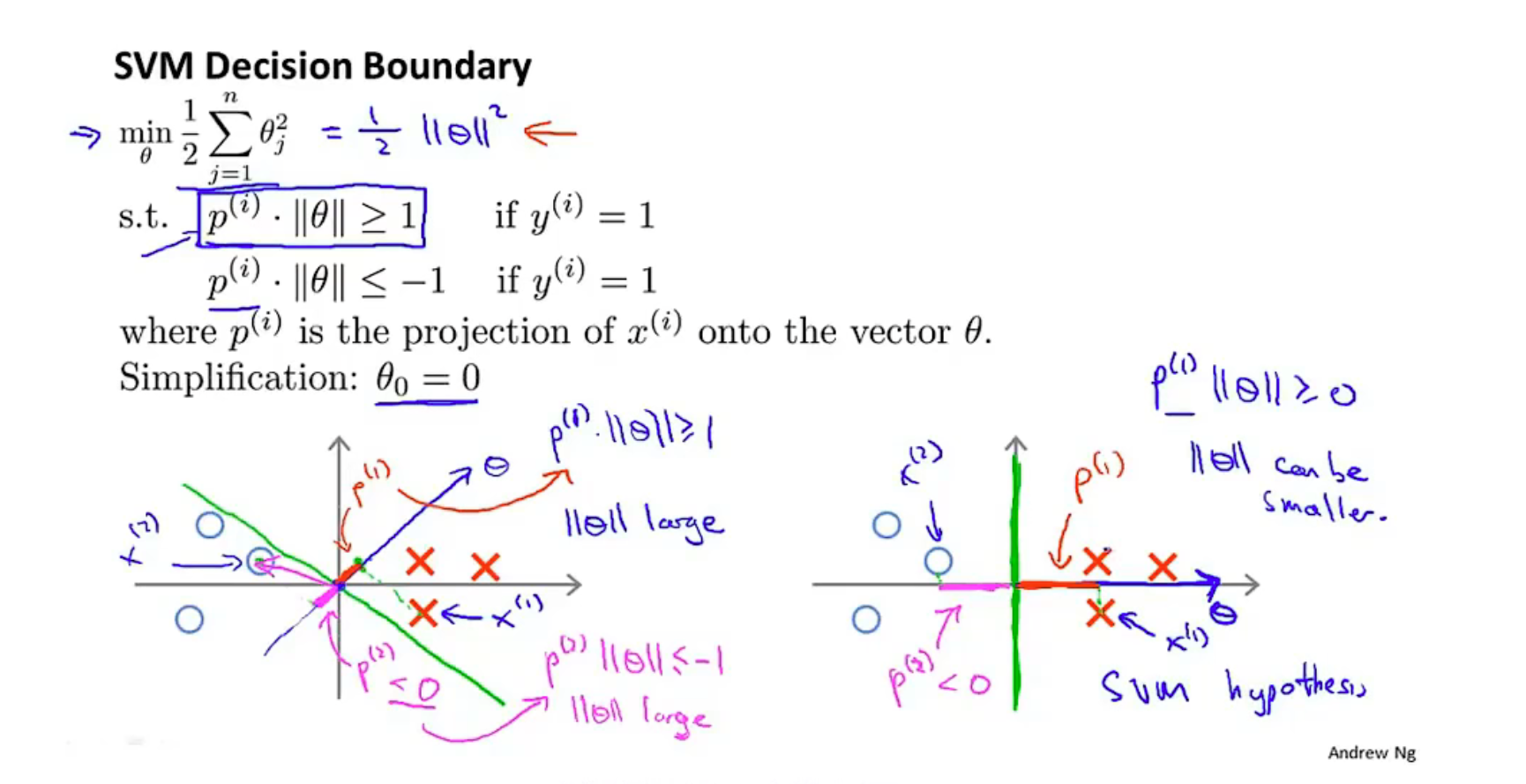

首先我们可以将公式 用线性代数的方法如下表示,是在向量上的投影,同时我们进行简单化,令

首先,向量因为作为系数,且方程等于0,所以他与决策边界垂直(即点积为0)

蓝色的即为向量,绿色的是决策边界。

我们的目的是最小化

那么根据图一,此时很小,因此为了满足条件,就很大,则矛盾

因此,如图二,此时决策边界是大间距的,向量与x轴平行 此时比起图一显然增大了许多,对应的则就可以变得更小了

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本