优化器-SGD、SGD with momentum、Adagrad、RMSProp、Adam

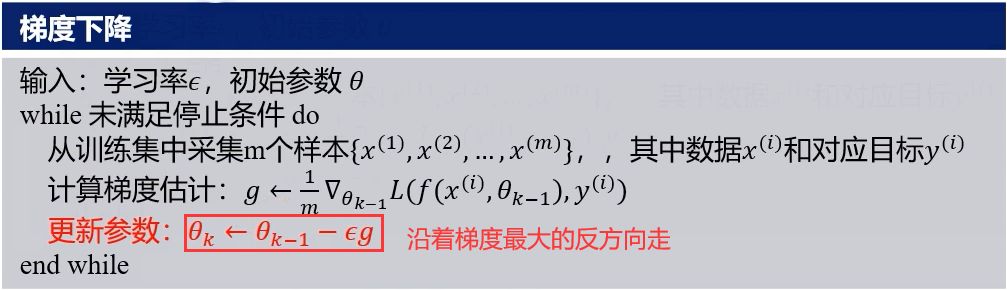

一、SGD(梯度下降)

在多变函数中,梯度是一个方向,梯度的方向指出了函数在给定点上升最快的方向,或者说指引了函数值增大的方向,因此我们只要考虑往梯度的反方向走,就至少能走到极小值,可能能走到全局最小值。

二、SGD with momentum(动量法:梯度累加)

动量累加:震荡方向的梯度相互抵消,梯度小的方向逐渐累加。

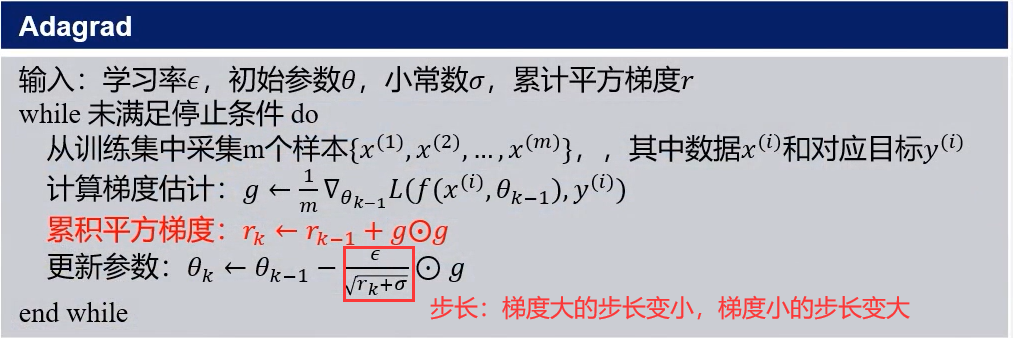

三、Adagrad(自适应:调整学习率)

调整步长:震荡方向的步长很小,梯度小的方向步长变大。

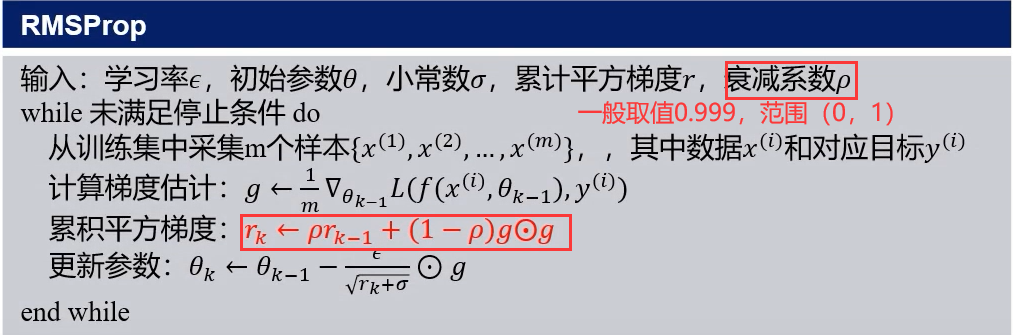

四、RMSProp(历史累计在衰减)

Adagrad梯度小的方向,步长一开始比较大,但逐渐减小(梯度一直在累加,步长一直在减小),此时就失去了调节作用。

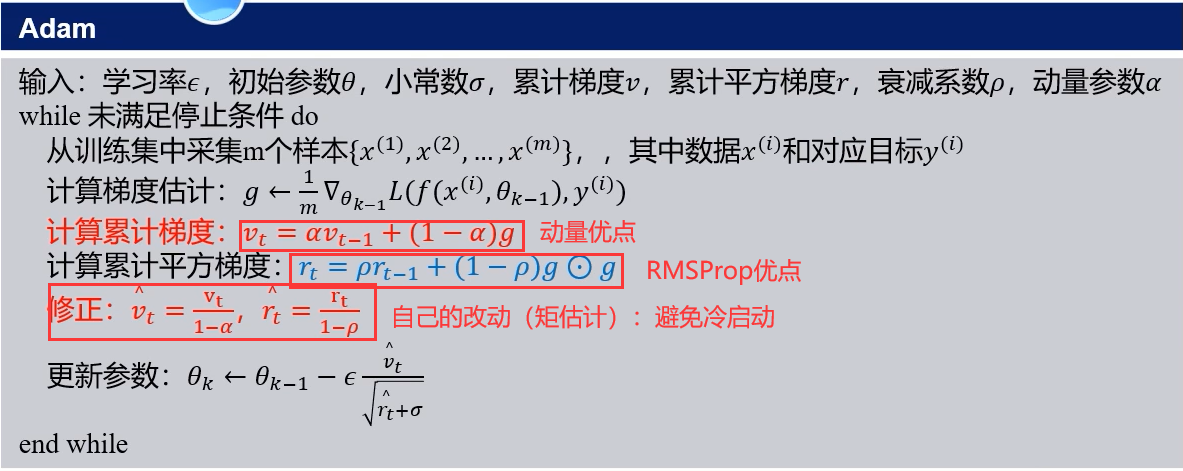

五、Adam(融合了动量和自适应,避免了冷启动)

冷启动:一开始更新是很小的改动,对其进行修正,使其幅度变大。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 25岁的心里话

· 闲置电脑爆改个人服务器(超详细) #公网映射 #Vmware虚拟网络编辑器

· 零经验选手,Compose 一天开发一款小游戏!

· 因为Apifox不支持离线,我果断选择了Apipost!

· 通过 API 将Deepseek响应流式内容输出到前端