scrapy:电影天堂案例

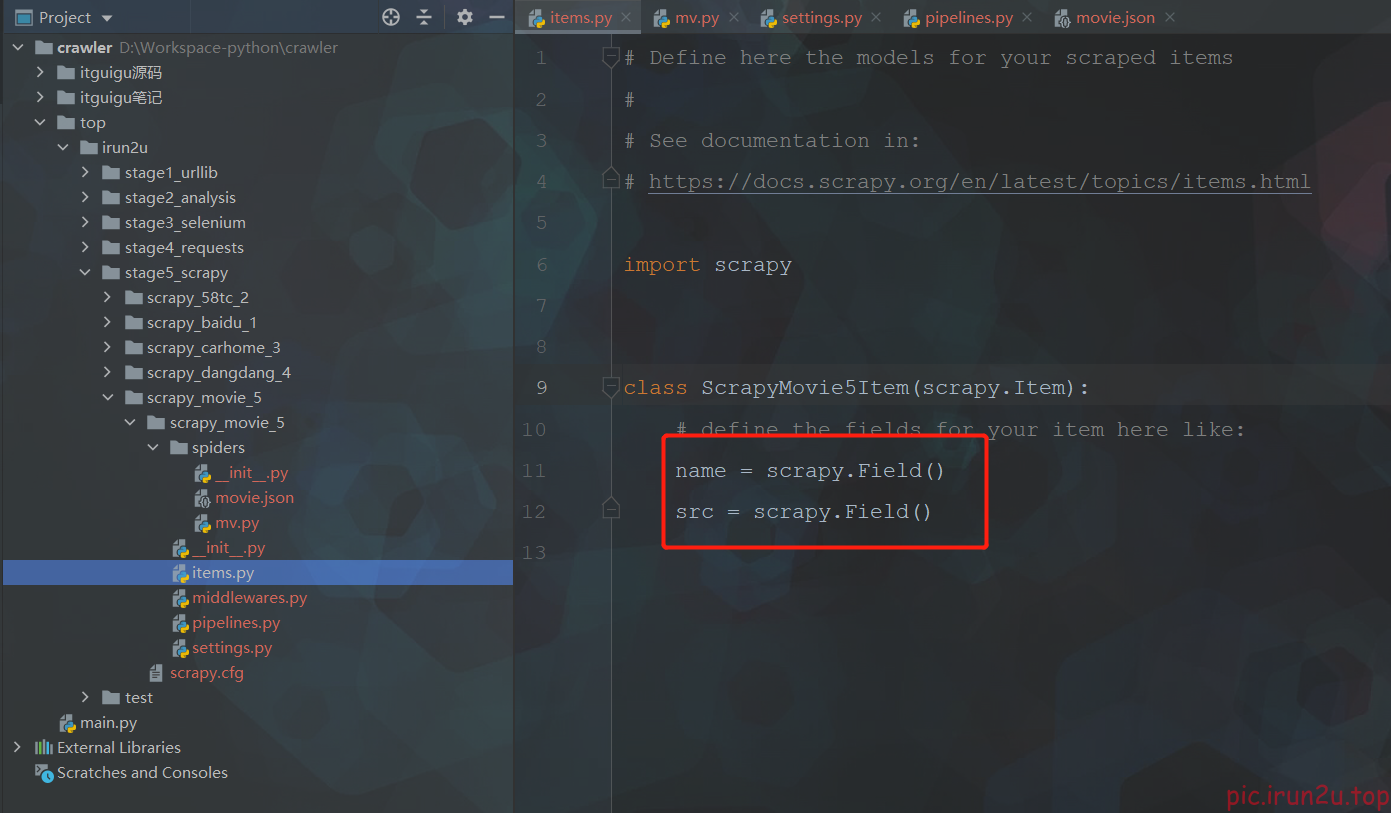

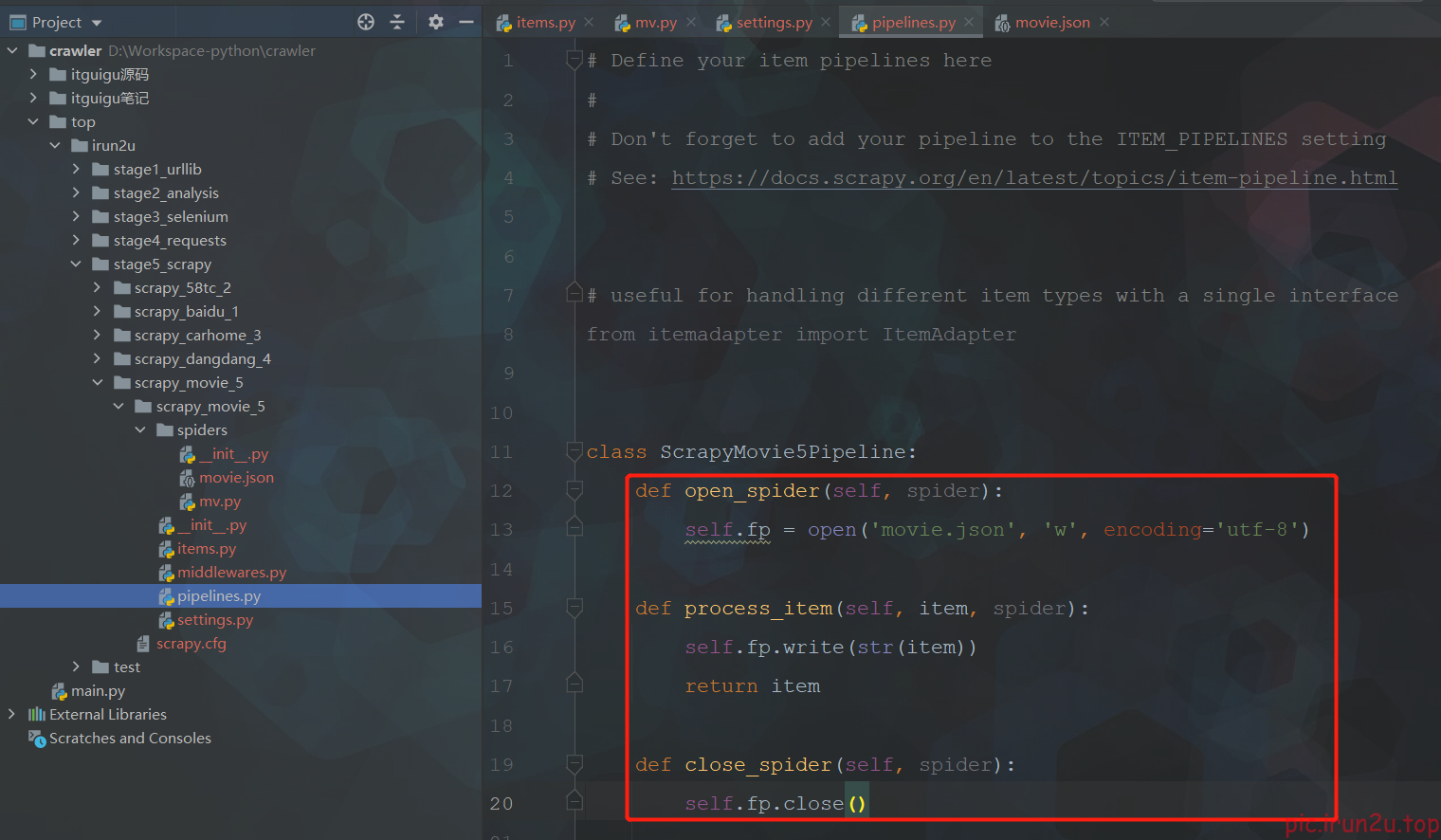

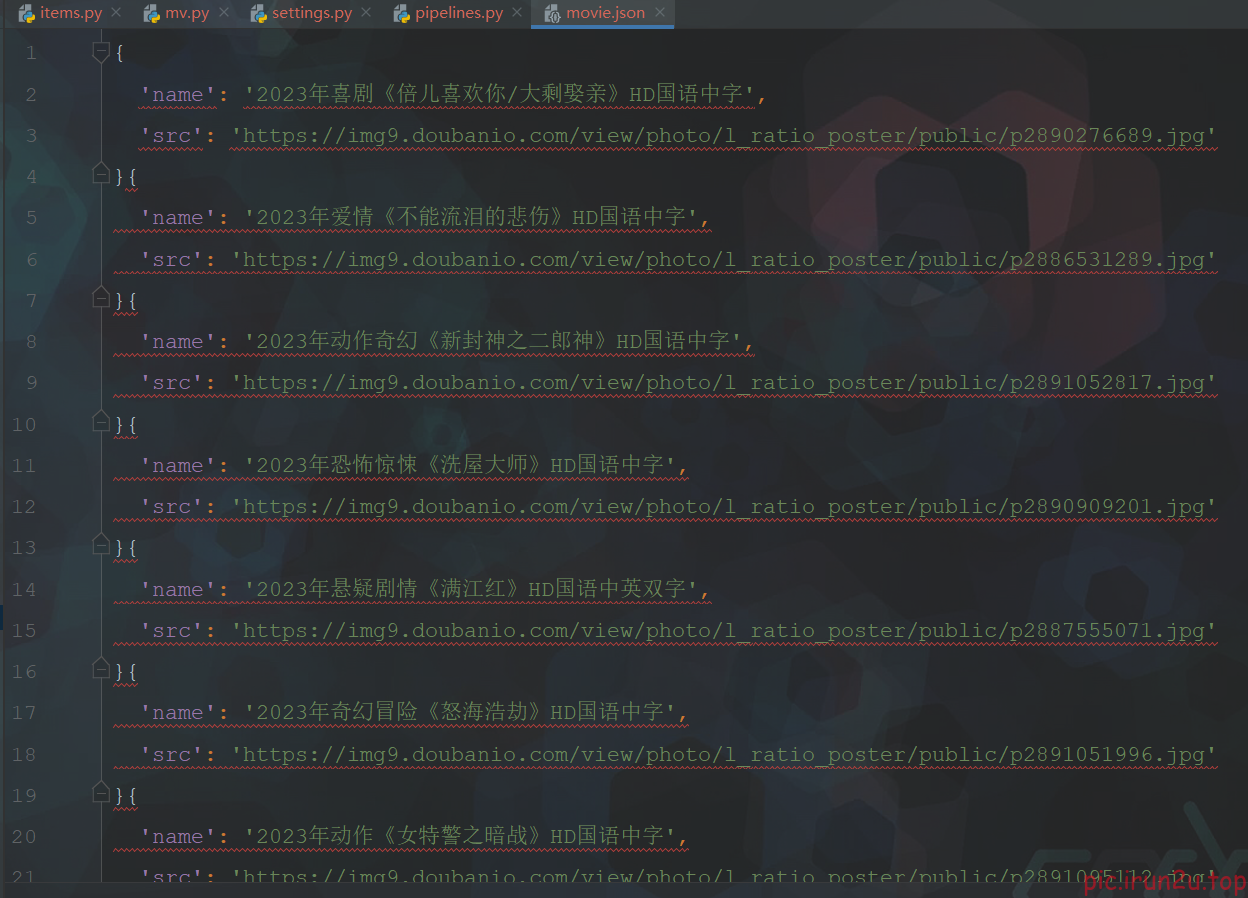

嵌套数据封装成一个item(一个item包含多级页面的数据):每条记录的名称+点进去之后第二页中的图片

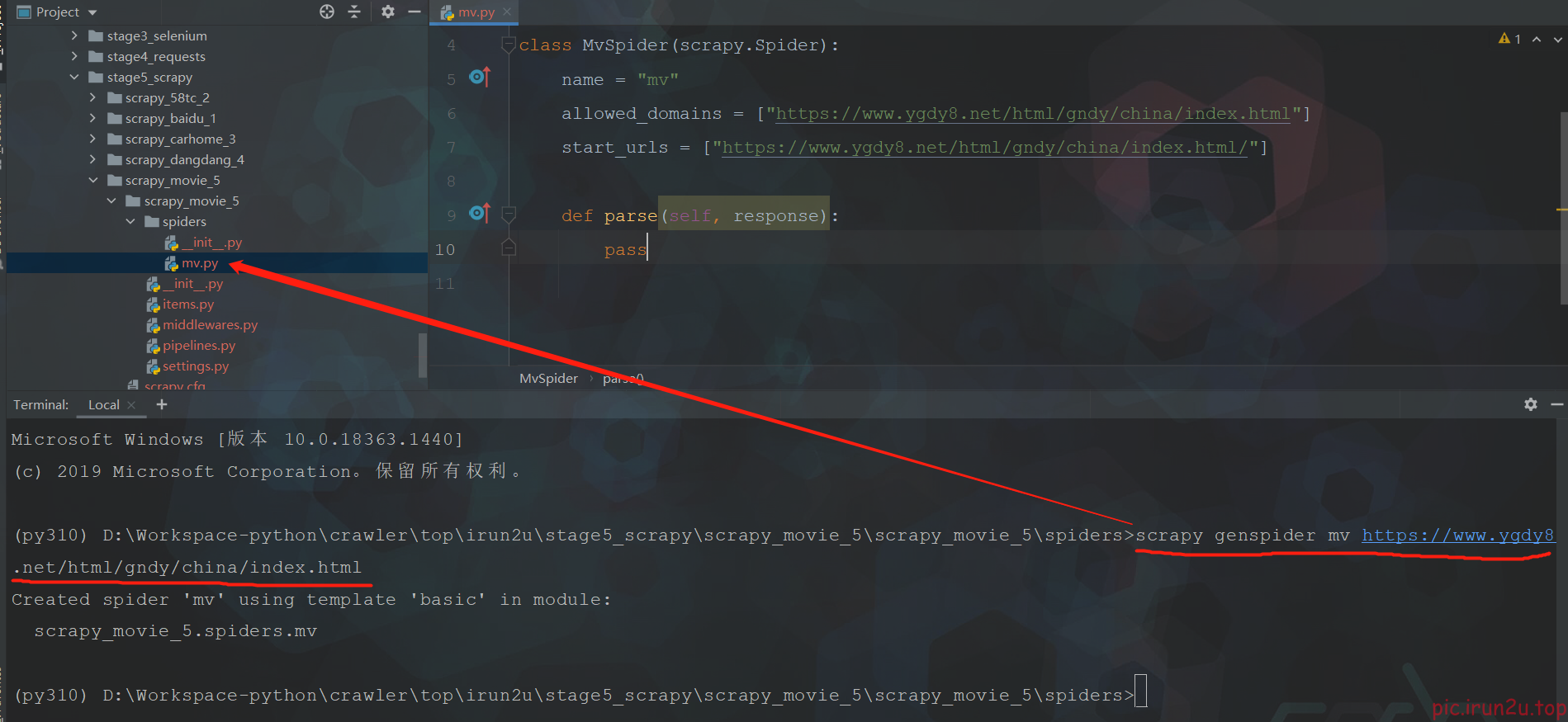

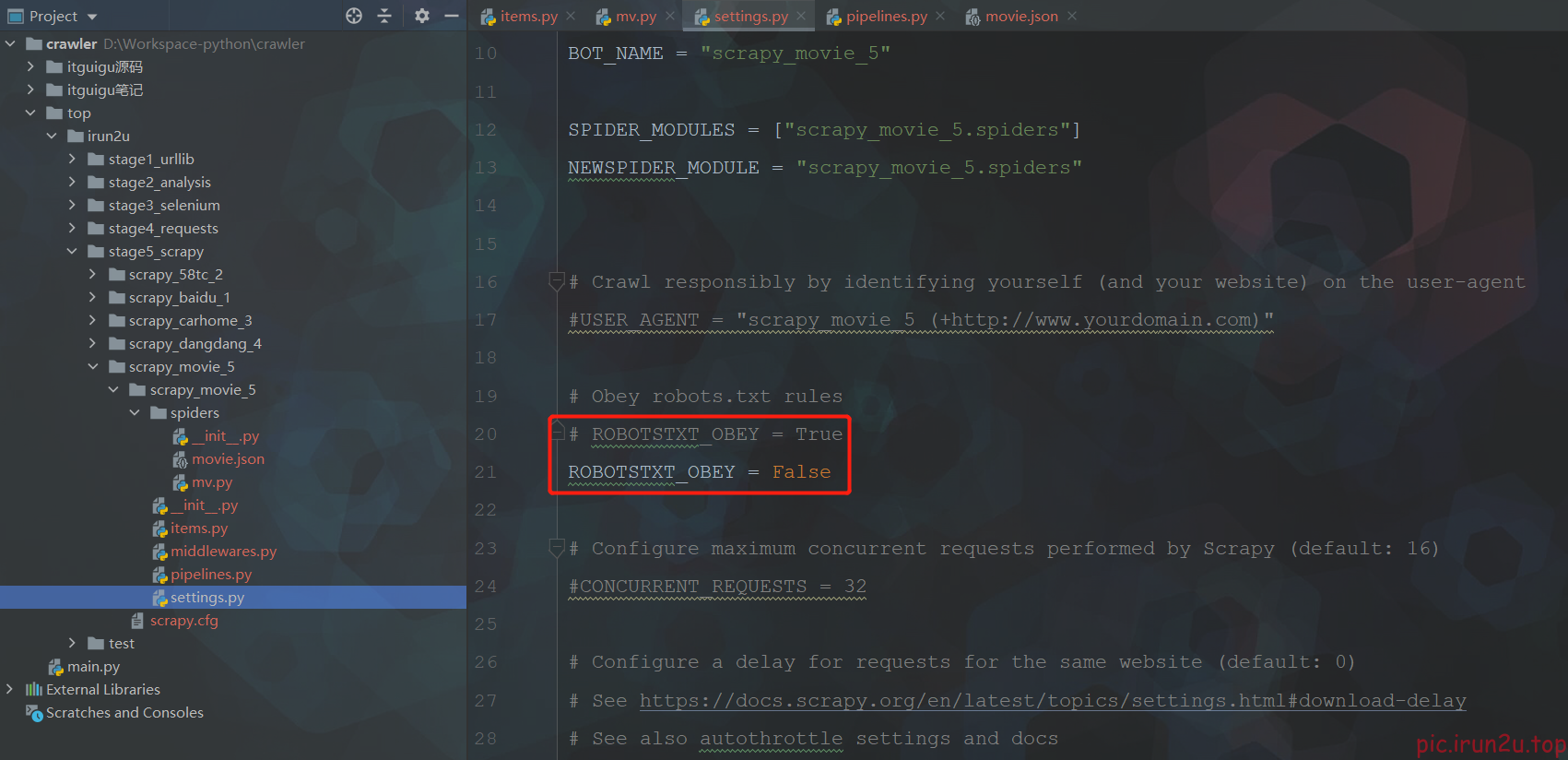

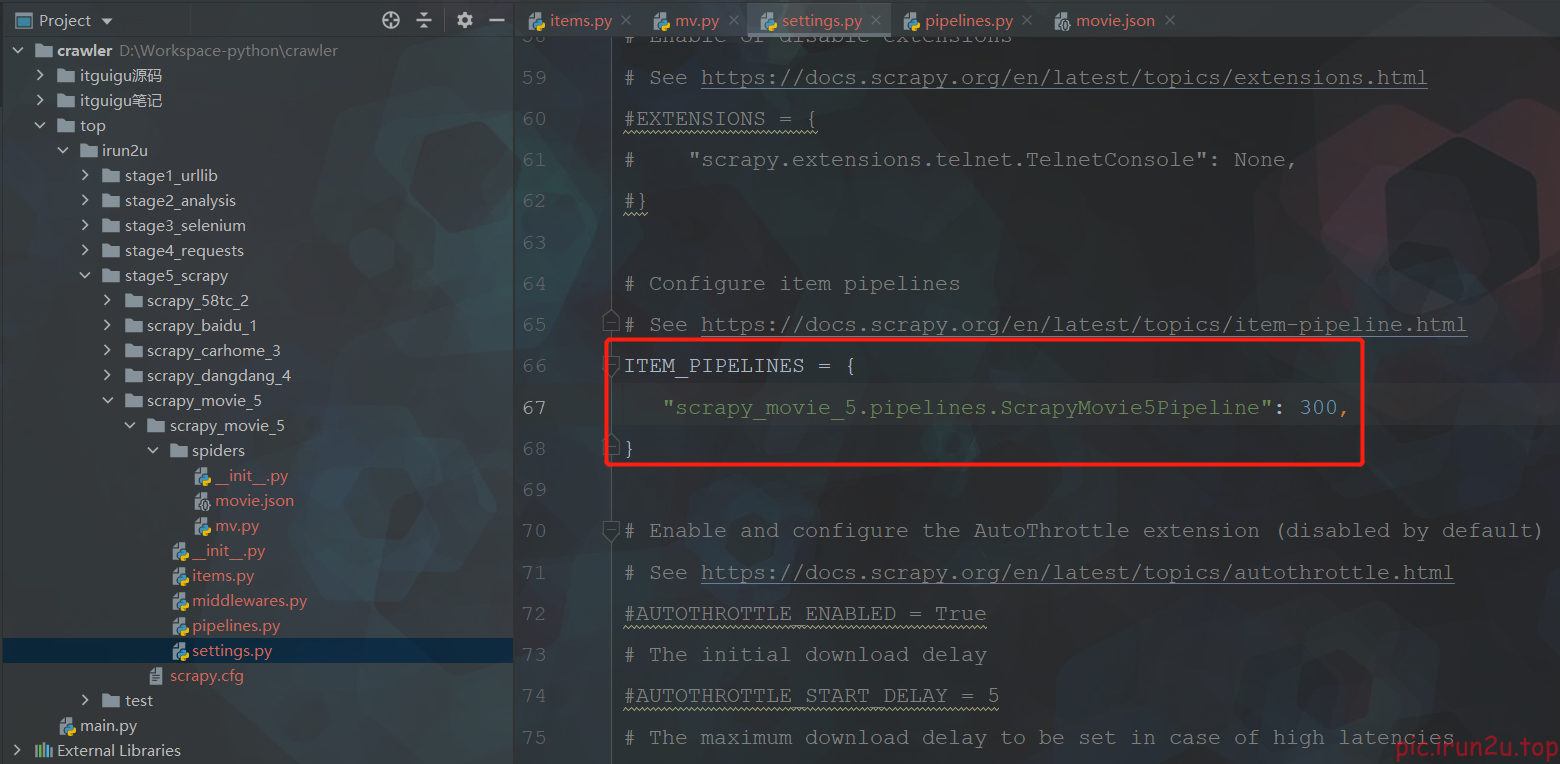

1. 创建爬虫项目

scrapy startproject scrapy_movie_5

2. 创建爬虫文件

scrapy genspider mv https://www.ygdy8.net/html/gndy/china/index.html

3. 实现爬虫

import scrapy

from scrapy_movie_5.items import ScrapyMovie5Item

class MvSpider(scrapy.Spider):

name = "mv"

# allowed_domains = ["https://www.ygdy8.net/html/gndy/china/index.html"]

allowed_domains = ['www.dytt8.net']

start_urls = ['https://www.dytt8.net/html/gndy/china/index.html']

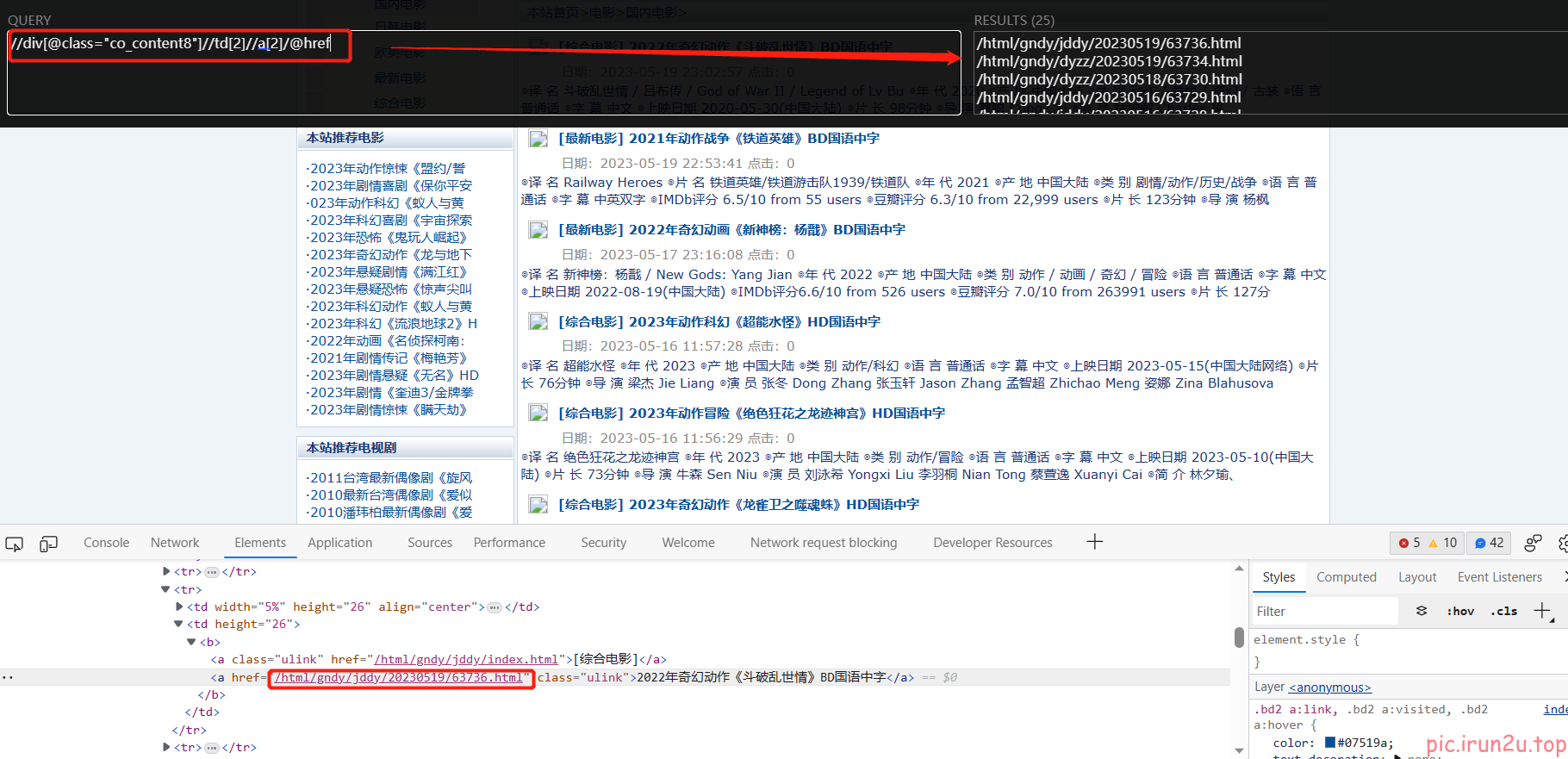

def parse(self, response):

# 第一页的名字和第二页的图片

a_list = response.xpath('//div[@class="co_content8"]//td[2]//a[2]')

for a in a_list:

# 获取第一页的name 和 要点击的链接

name = a.xpath('./text()').extract_first()

href = a.xpath('./@href').extract_first()

# 第二页的地址

url = 'https://www.dytt8.net' + href # 注意要修改allowed_domains,因为需要访问的第二页不再原范围内

# 对第二页的链接发起访问

yield scrapy.Request(url=url, callback=self.parse_second, meta={'name': name})

# 注意当涉及多级页面时,要用meta来存参数

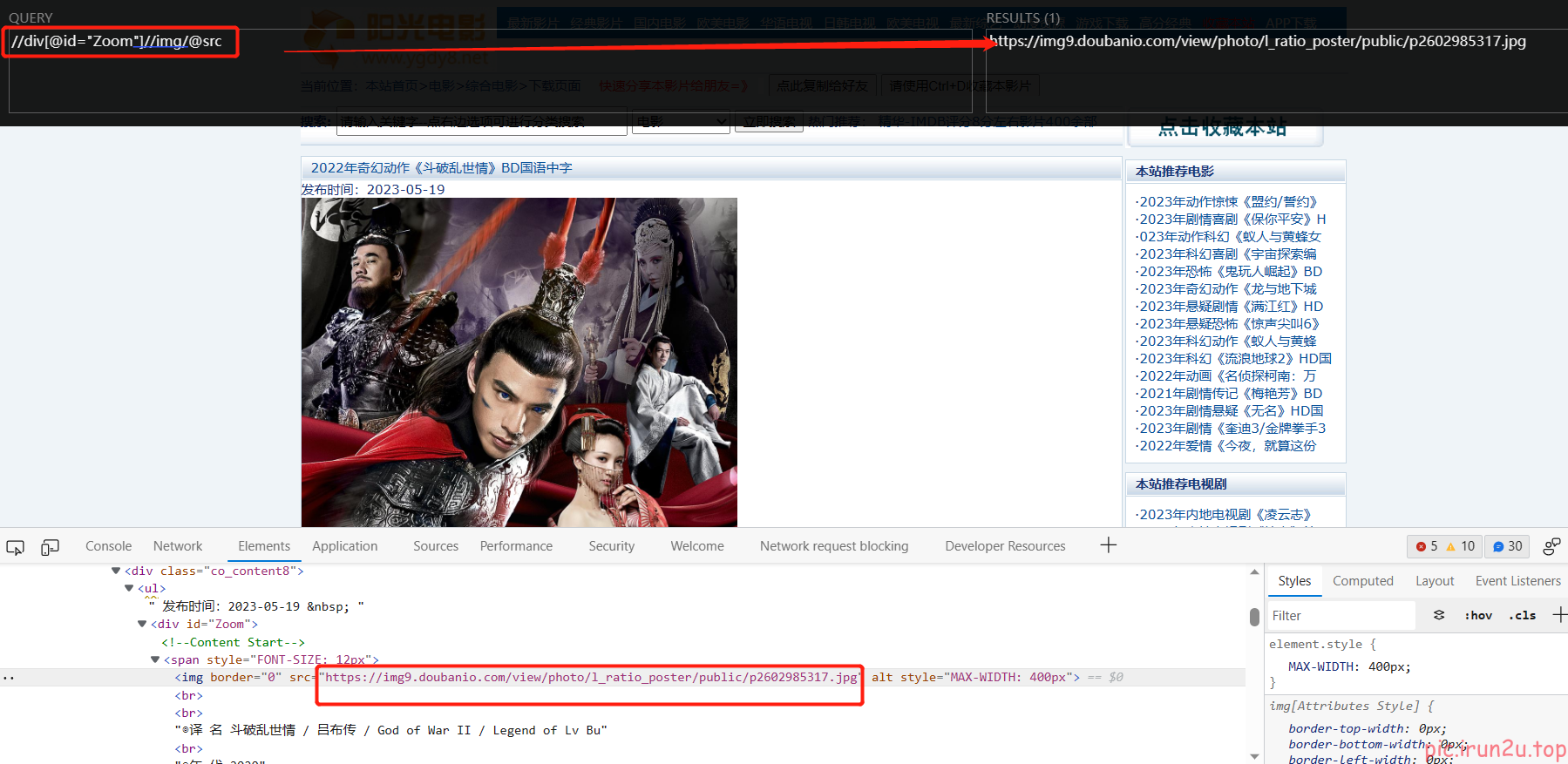

def parse_second(self, response):

# 注意 如果拿不到数据的情况下 一定检查你的xpath语法是否正确

src = response.xpath('//div[@id="Zoom"]//img/@src').extract_first()

# 接受到请求的那个meta参数的值

name = response.meta['name']

movie = ScrapyMovie5Item(src=src, name=name)

yield movie

scrapy crawl mv

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!