HM-SpringCloud微服务系列12.4【MQ集群】

1. 集群分类

RabbitMQ的是基于Erlang语言编写,而Erlang又是一个面向并发的语言,天然支持集群模式。RabbitMQ的集群有两种模式:

-

普通集群:是一种分布式集群,将队列分散到集群的各个节点,从而提高整个集群的并发能力。

- 普通模式集群不进行数据同步,每个MQ都有自己的队列、数据信息(其它元数据信息如交换机等会同步)。例如我们有2个MQ:mq1,和mq2,如果你的消息在mq1,而你连接到了mq2,那么mq2会去mq1拉取消息,然后返回给你。如果mq1宕机,消息就会丢失。

-

镜像集群:是一种主从集群,普通集群的基础上,添加了主从备份功能,提高集群的数据可用性。

- 与普通模式不同,队列会在各个mq的镜像节点之间同步,因此你连接到任何一个镜像节点,均可获取到消息。而且如果一个节点宕机,并不会导致数据丢失。不过,这种方式增加了数据同步的带宽消耗。

镜像集群虽然支持主从,但主从同步并不是强一致的,某些情况下可能有数据丢失的风险。因此在RabbitMQ的3.8版本以后,推出了新的功能:仲裁队列来代替镜像集群,底层采用Raft协议确保主从的数据一致性。

2. 普通集群

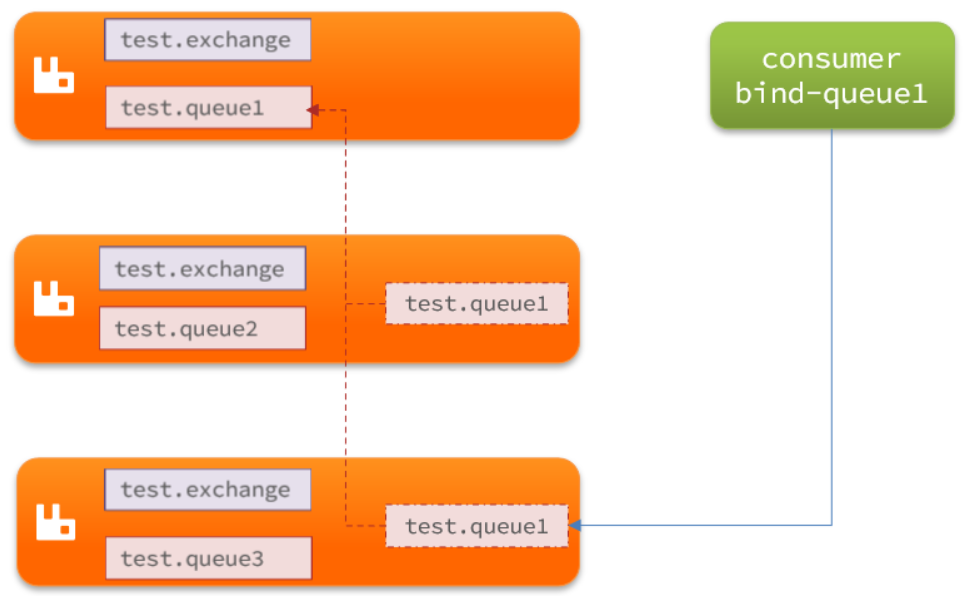

2.1 集群结构和特征

普通集群,或者叫标准集群(classic cluster)。

具备下列特征:

- 会在集群的各个节点间共享部分数据,包括:交换机、队列元信息。不包含队列中的消息。

- 当访问集群某节点时,如果队列不在该节点,会从数据所在节点传递到当前节点并返回

- 队列所在节点宕机,队列中的消息就会丢失

结构如图:

2.2 部署

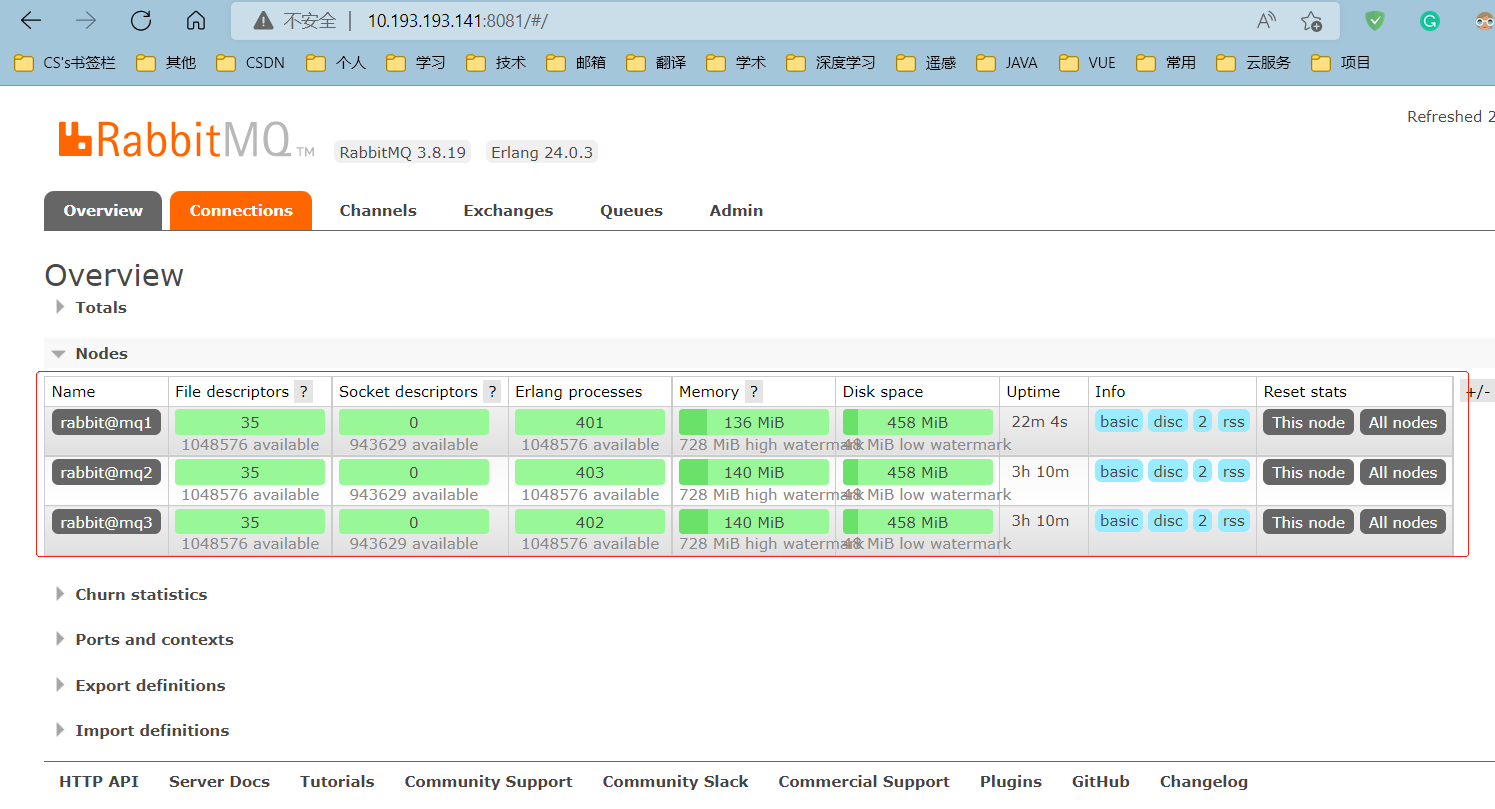

计划部署3节点的mq集群:

| 主机名 | 控制台端口 | amqp通信端口 |

|---|---|---|

| mq1 | 8081 ---> 15672 | 8071 ---> 5672 |

| mq2 | 8082 ---> 15672 | 8072 ---> 5672 |

| mq3 | 8083 ---> 15672 | 8073 ---> 5672 |

集群中的节点标示默认都是:rabbit@[hostname],因此以上三个节点的名称分别为:

- rabbit@mq1

- rabbit@mq2

- rabbit@mq3

2.2.1 获取cookie

RabbitMQ底层依赖于Erlang,而Erlang虚拟机就是一个面向分布式的语言,默认就支持集群模式。

集群模式中的每个RabbitMQ 节点使用 cookie 来确定它们是否被允许相互通信。

要使两个节点能够通信,它们必须具有相同的共享秘密,称为Erlang cookie。

cookie 只是一串最多 255 个字符的字母数字字符。

每个集群节点必须具有相同的 cookie。实例之间也需要它来相互通信。

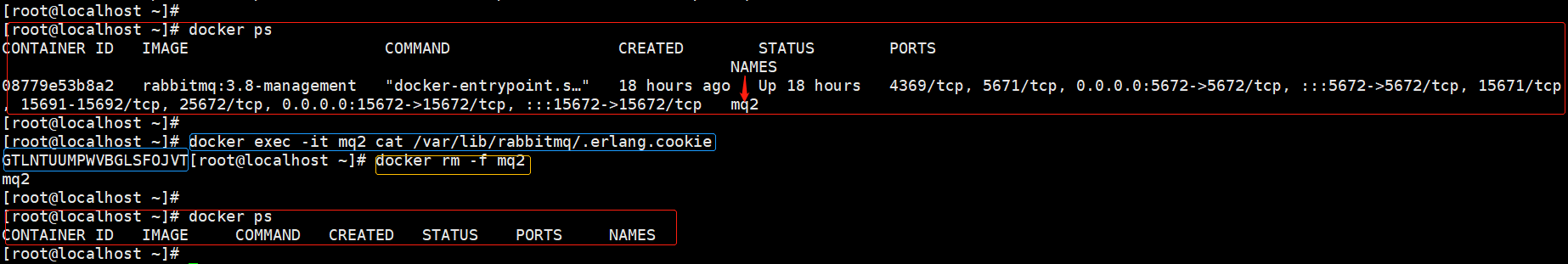

我们先在之前https://www.cnblogs.com/yppah/p/16244811.html启动的mq2容器中获取一个cookie值,作为集群的cookie。

执行下面的命令:

docker exec -it mq2 cat /var/lib/rabbitmq/.erlang.cookie

可以看到cookie值如下:

GTLNTUUMPWVBGLSFOJVT

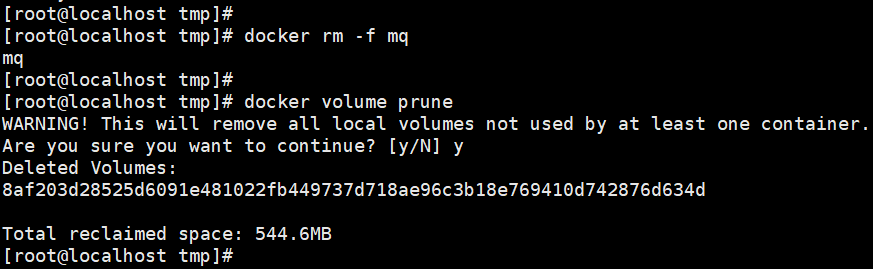

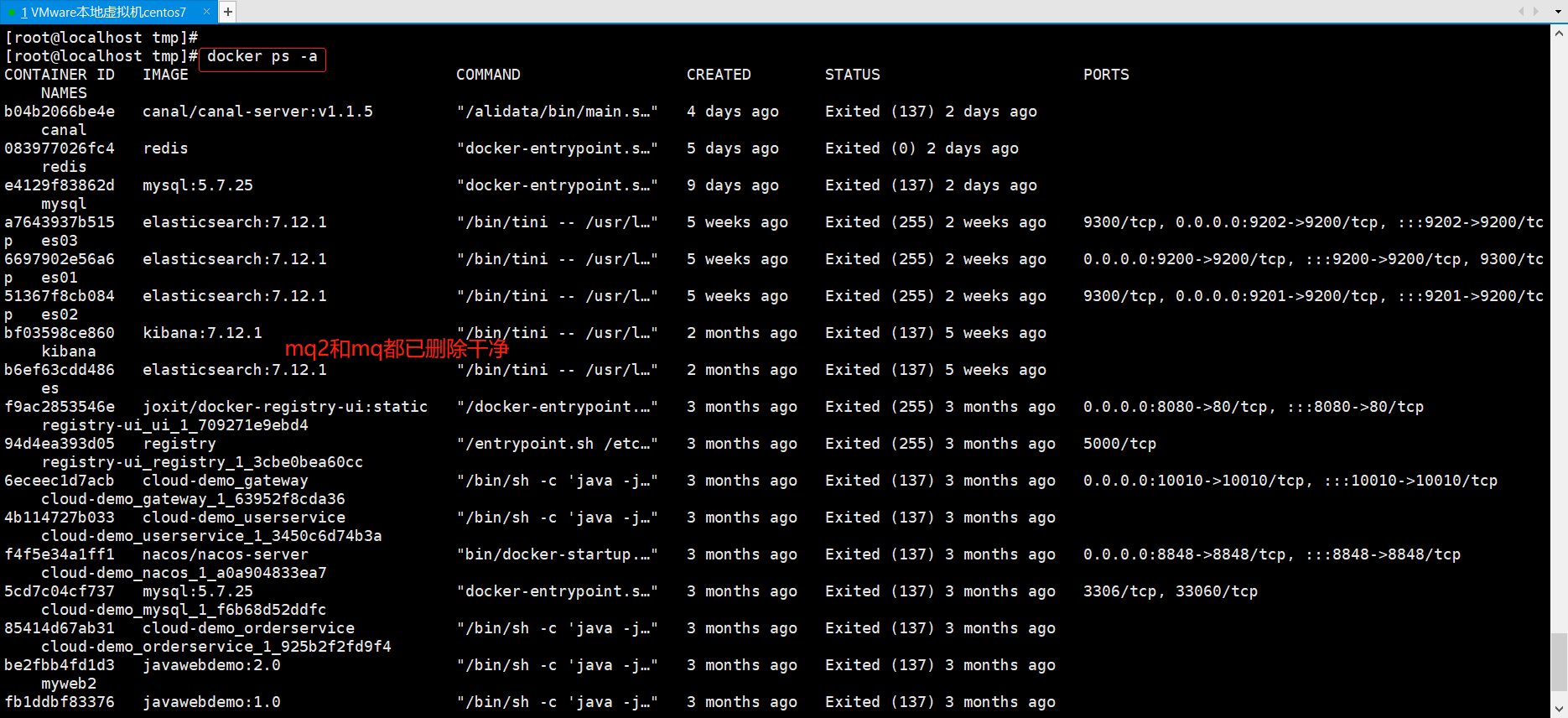

我们需要重新搭建集群,接下来,停止并删除当前的mq2容器,防止干扰:

docker rm -f mq2

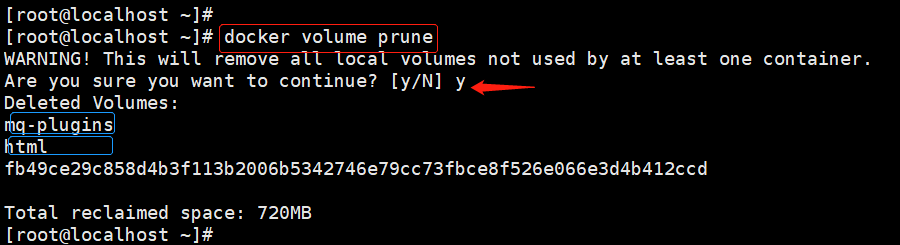

然后,通过以下命令清理一下mq2的数据卷:

docker volume prune

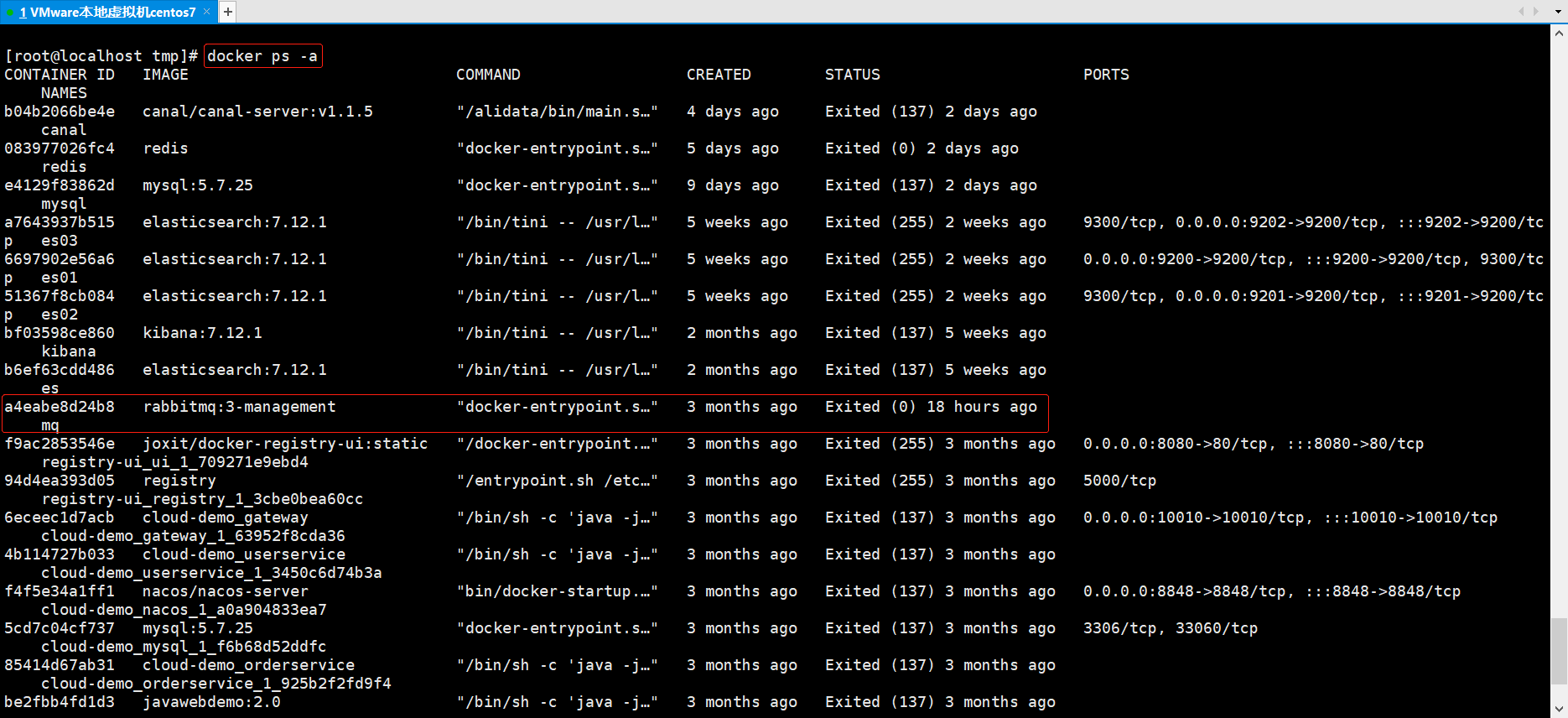

此外,将https://www.cnblogs.com/yppah/p/15832492.html的mq也删除掉

2.2.2 准备集群配置

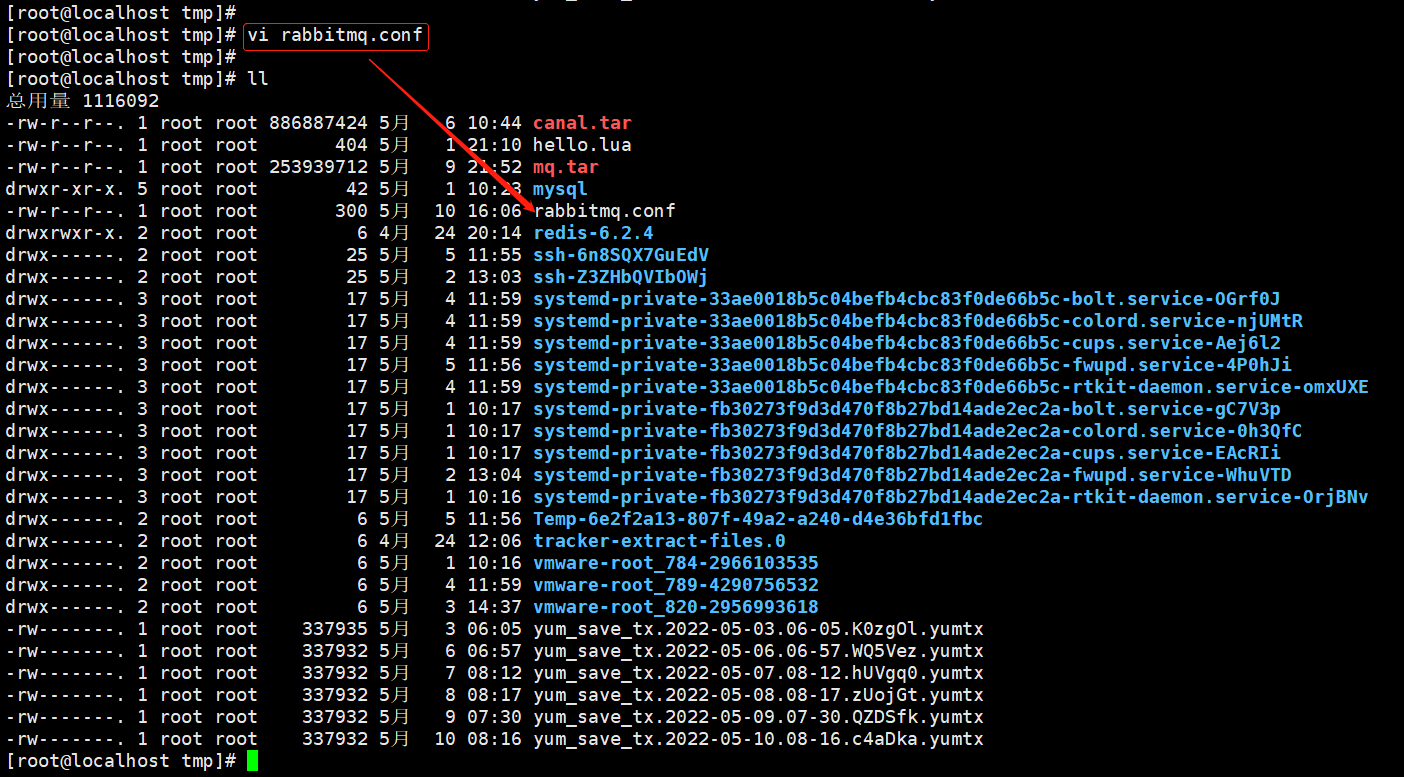

在/tmp目录新建一个配置文件 rabbitmq.conf:

cd /tmp

# 创建文件

touch rabbitmq.conf

文件内容如下:

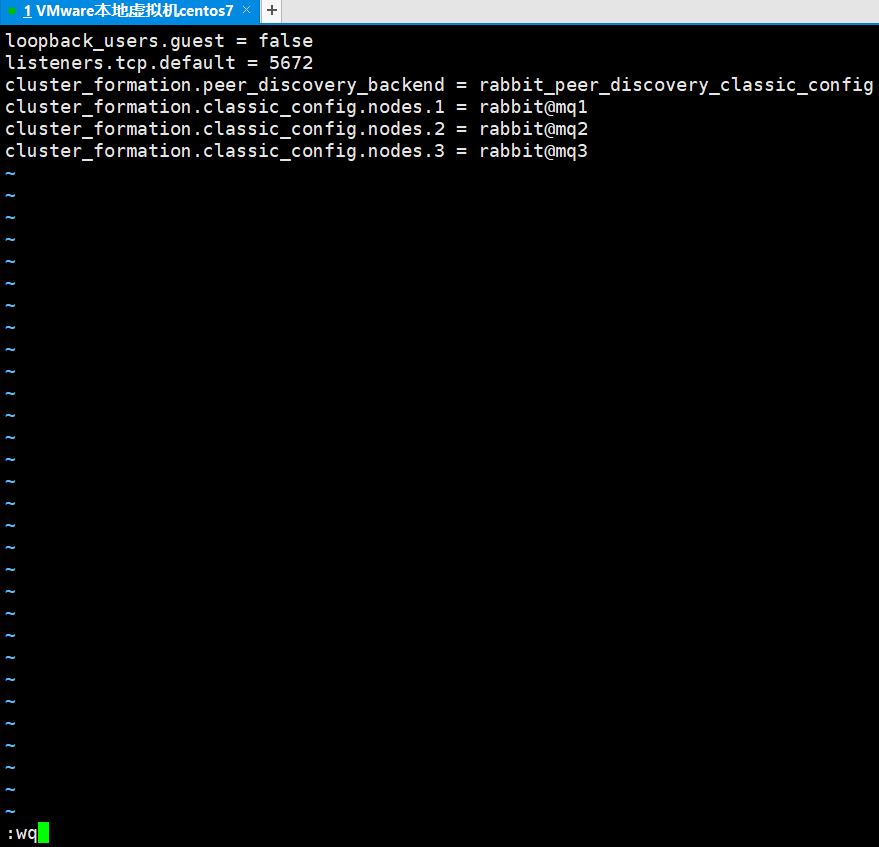

loopback_users.guest = false

listeners.tcp.default = 5672

cluster_formation.peer_discovery_backend = rabbit_peer_discovery_classic_config

cluster_formation.classic_config.nodes.1 = rabbit@mq1

cluster_formation.classic_config.nodes.2 = rabbit@mq2

cluster_formation.classic_config.nodes.3 = rabbit@mq3

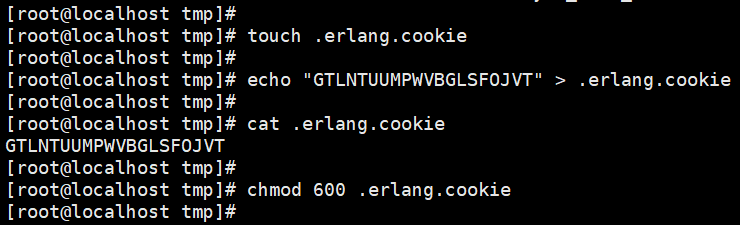

在/tmp目录再创建一个文件,记录cookie:

cd /tmp

# 创建cookie文件

touch .erlang.cookie

# 写入cookie(上一步中获取到的)

echo "GTLNTUUMPWVBGLSFOJVT" > .erlang.cookie

# 修改cookie文件的权限(600:root用户具有读写权限,其他用户无任何权限)

chmod 600 .erlang.cookie

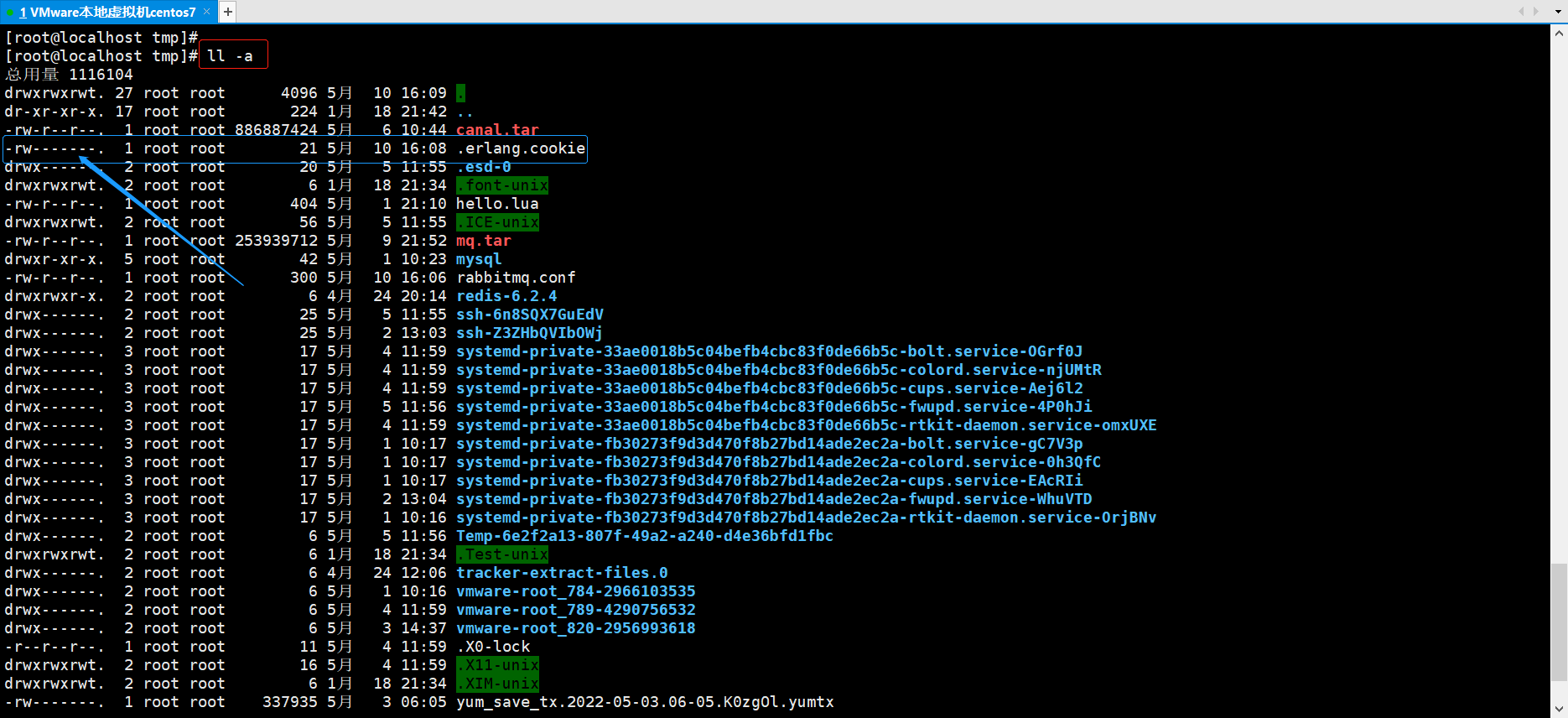

在/tmp下准备三个目录mq1、mq2、mq3:

cd /tmp

# 创建目录

mkdir mq1 mq2 mq3

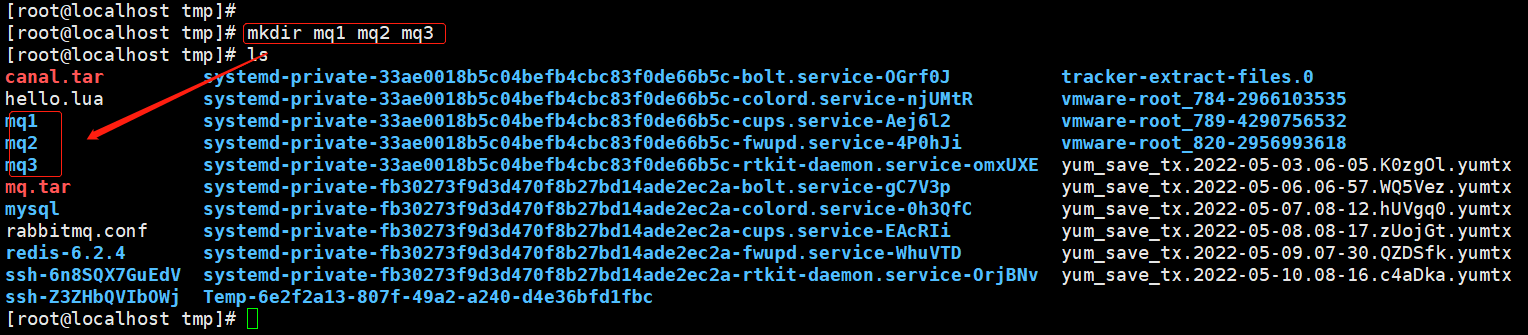

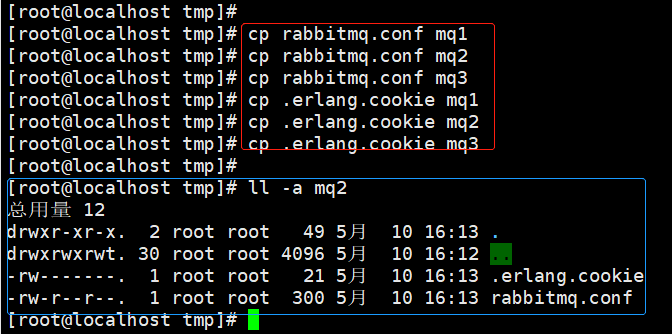

然后拷贝rabbitmq.conf、cookie文件到mq1、mq2、mq3:

# 进入/tmp

cd /tmp

# 拷贝

cp rabbitmq.conf mq1

cp rabbitmq.conf mq2

cp rabbitmq.conf mq3

cp .erlang.cookie mq1

cp .erlang.cookie mq2

cp .erlang.cookie mq3

2.2.3 启动集群

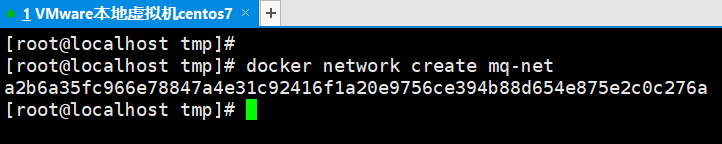

为了使三个docker容器可以互联,首先创建一个网络

docker network create mq-net

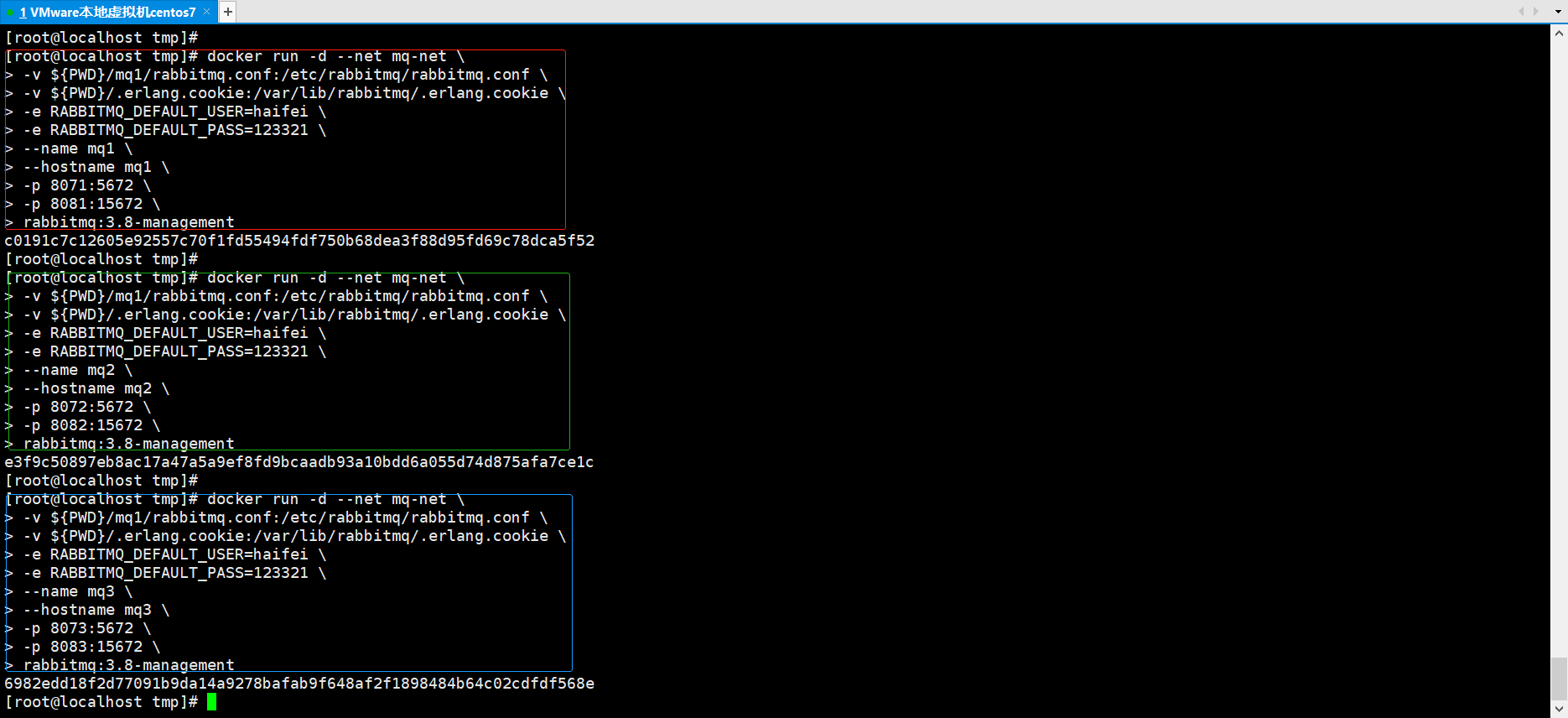

docker volume create,依次运行命令:

docker run -d --net mq-net \

-v ${PWD}/mq1/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=haifei \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq1 \

--hostname mq1 \

-p 8071:5672 \

-p 8081:15672 \

rabbitmq:3.8-management

docker run -d --net mq-net \

-v ${PWD}/mq1/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=haifei \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq2 \

--hostname mq2 \

-p 8072:5672 \

-p 8082:15672 \

rabbitmq:3.8-management

docker run -d --net mq-net \

-v ${PWD}/mq1/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=haifei \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq3 \

--hostname mq3 \

-p 8073:5672 \

-p 8083:15672 \

rabbitmq:3.8-management

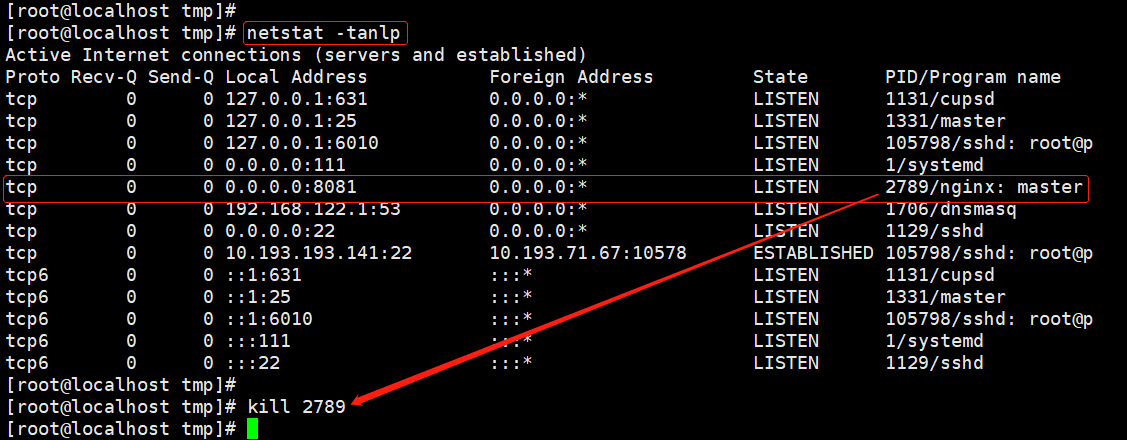

端口专用报错解决方案:https://blog.csdn.net/qq_47768542/article/details/114147974

PS:需要参照2.2.1 获取cookie中方法删掉刚刚图1创建的mq1,再重新创建

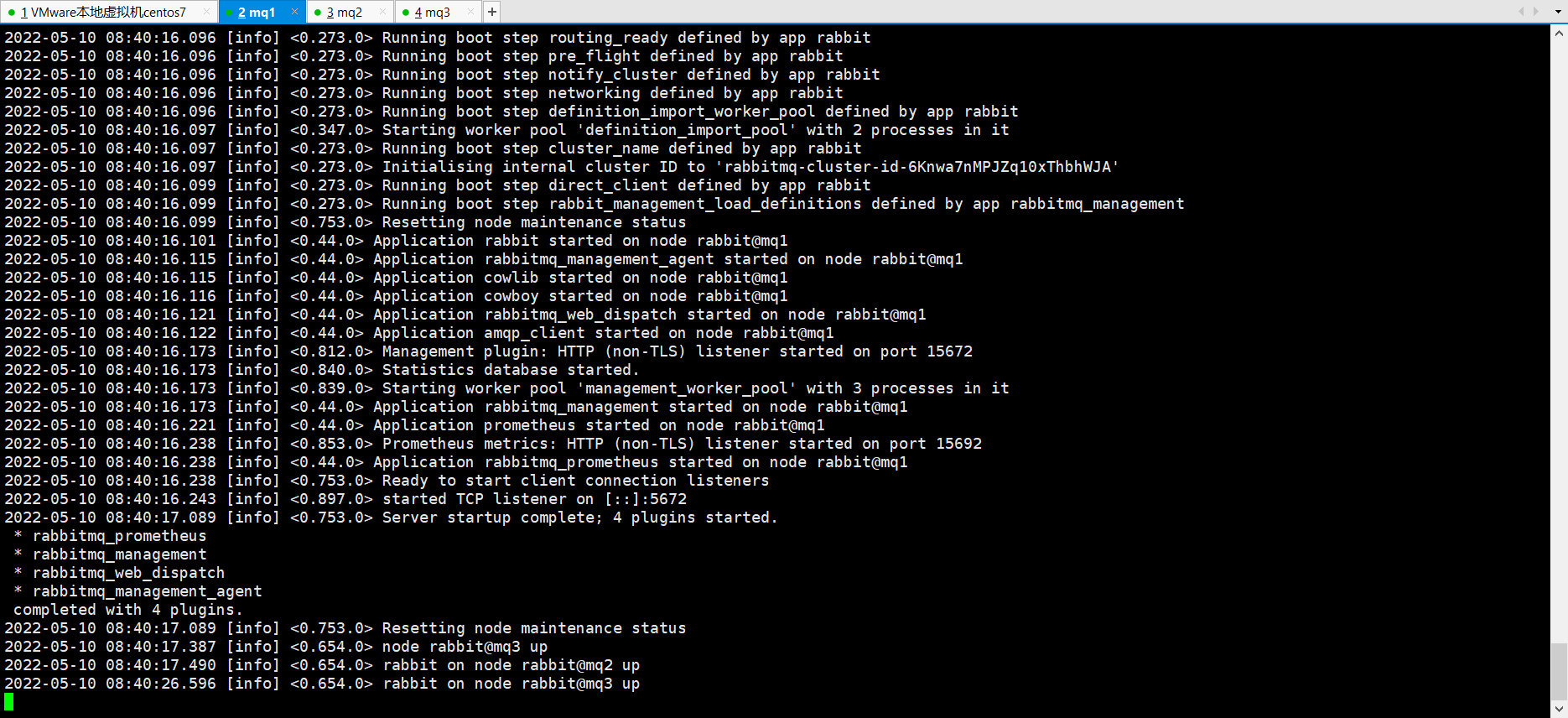

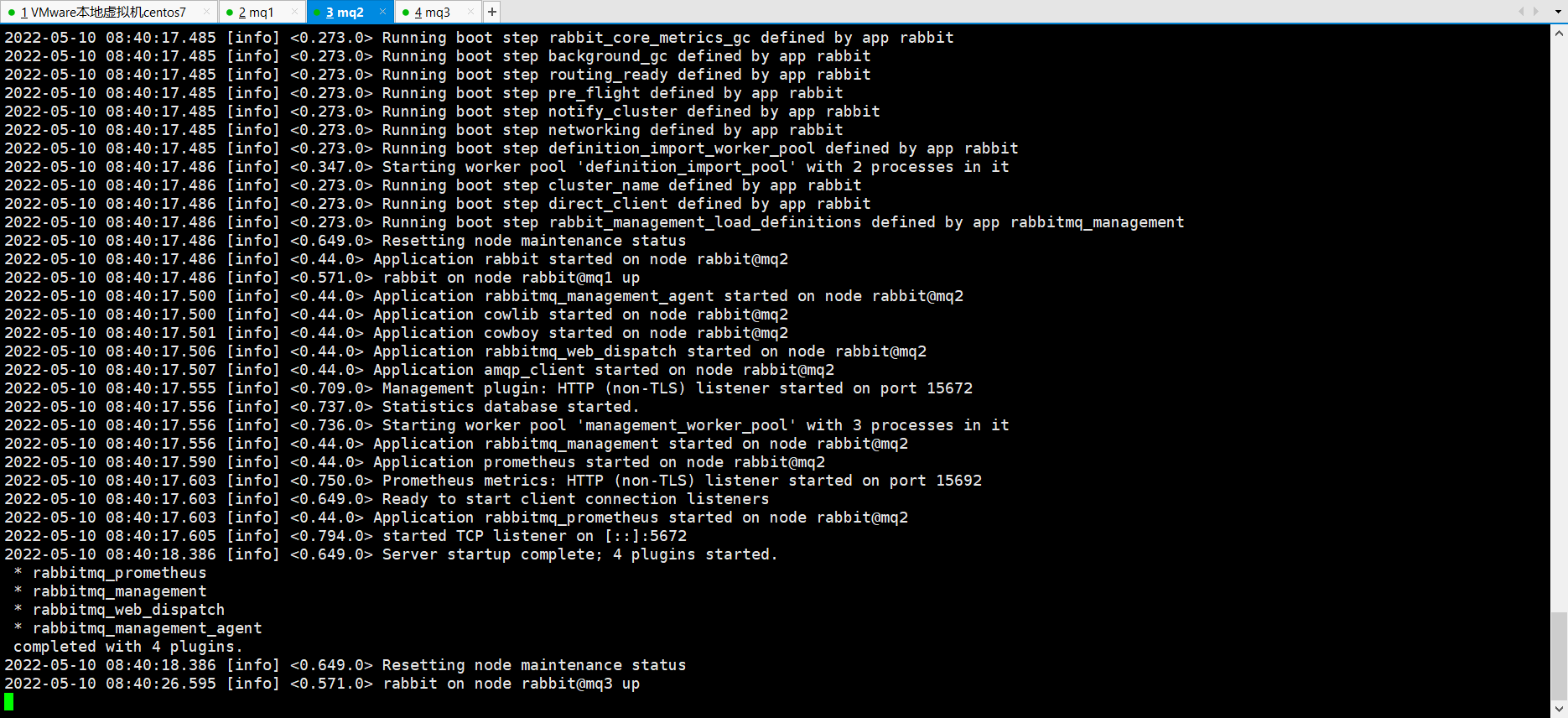

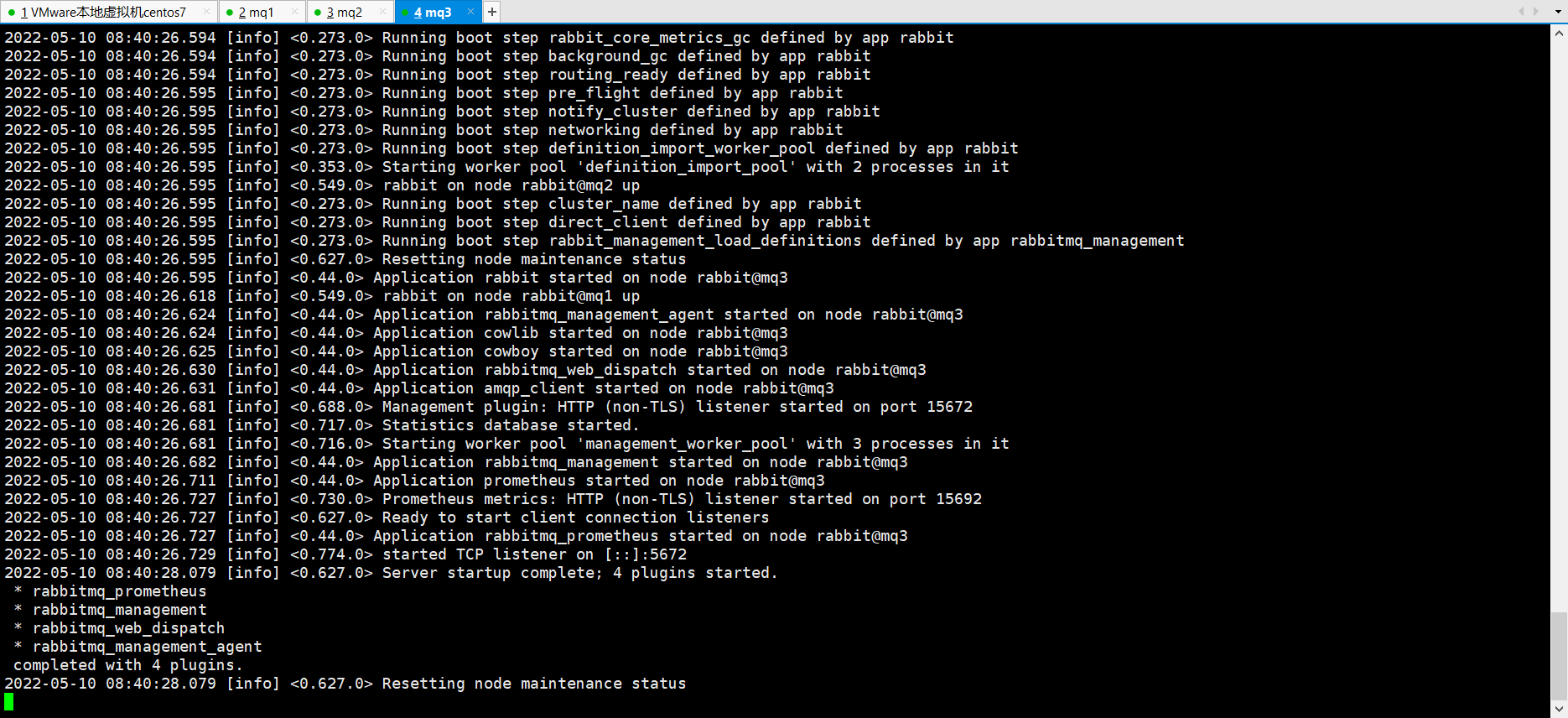

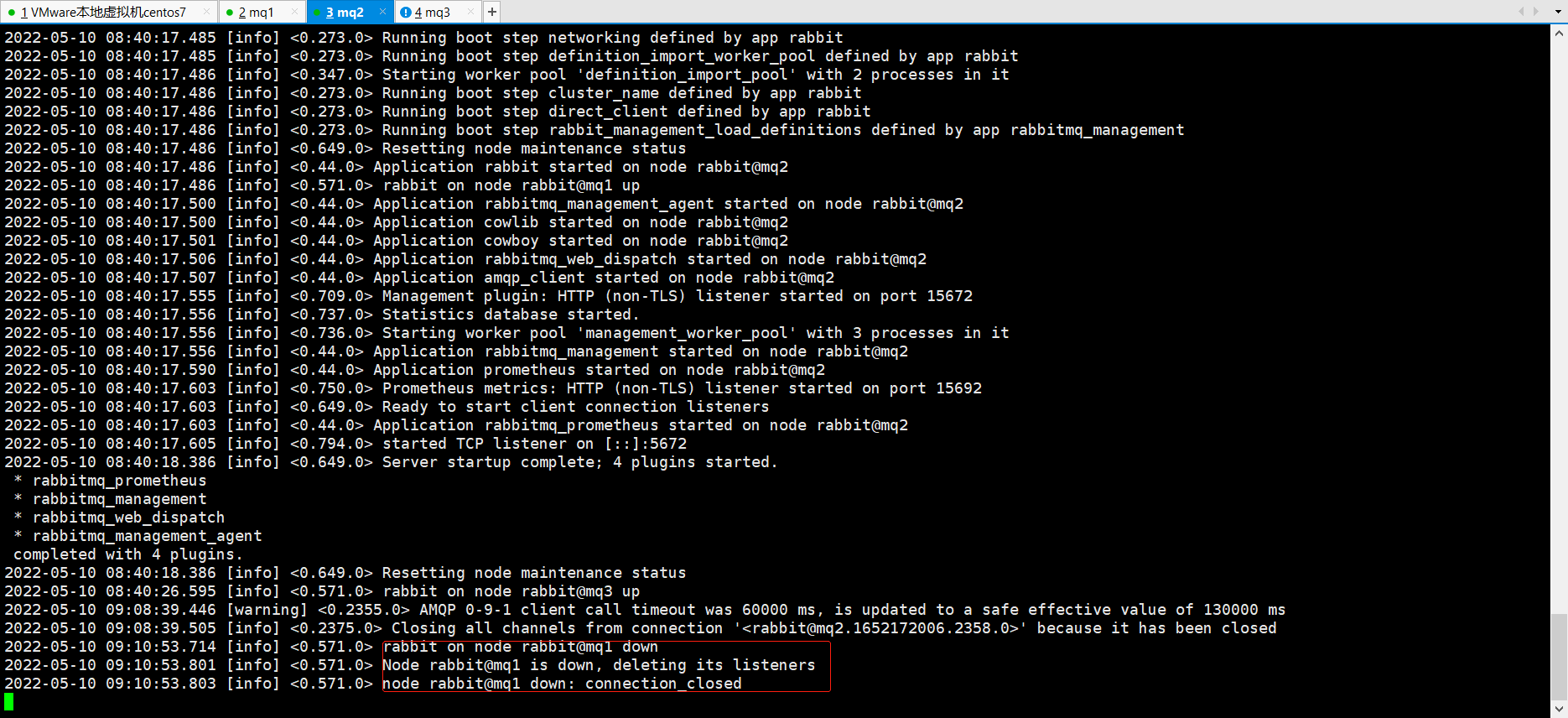

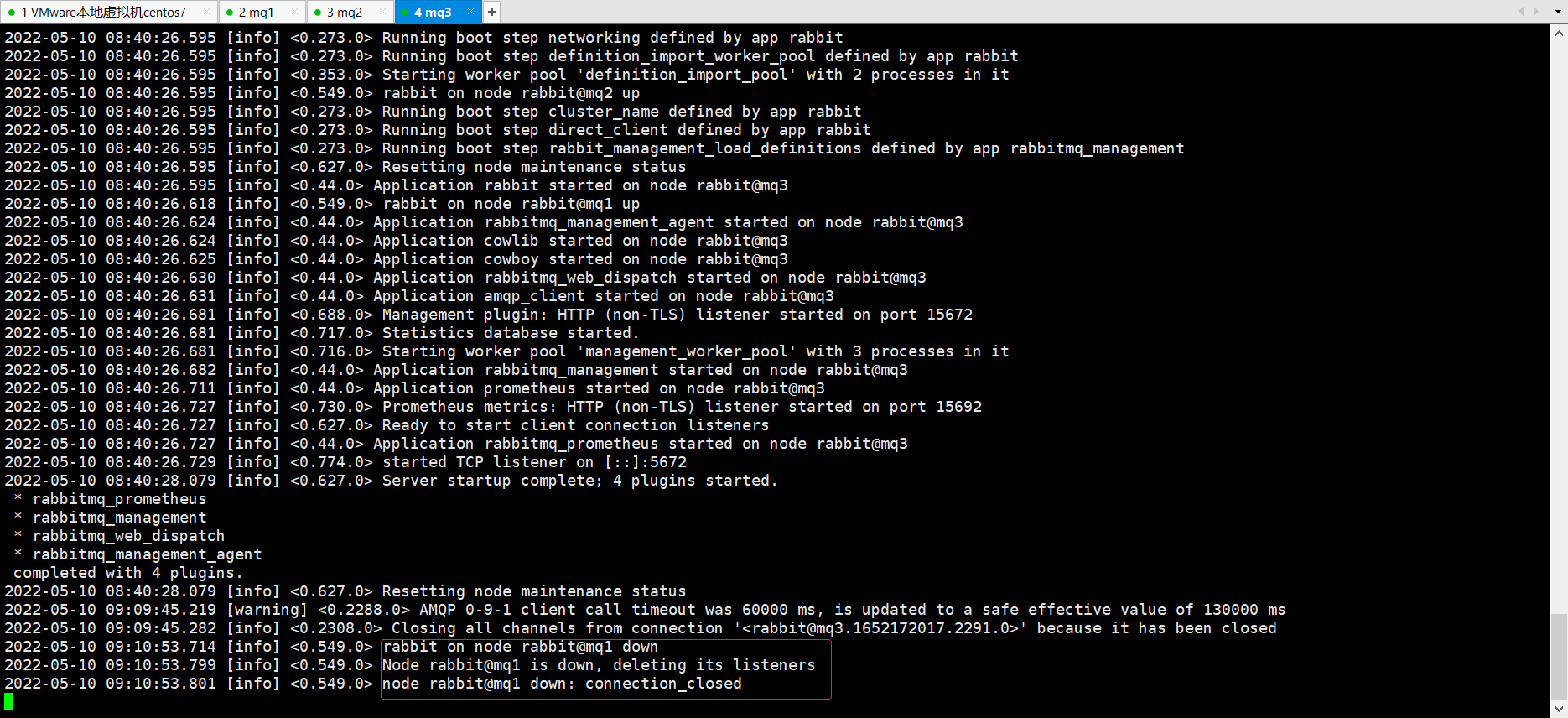

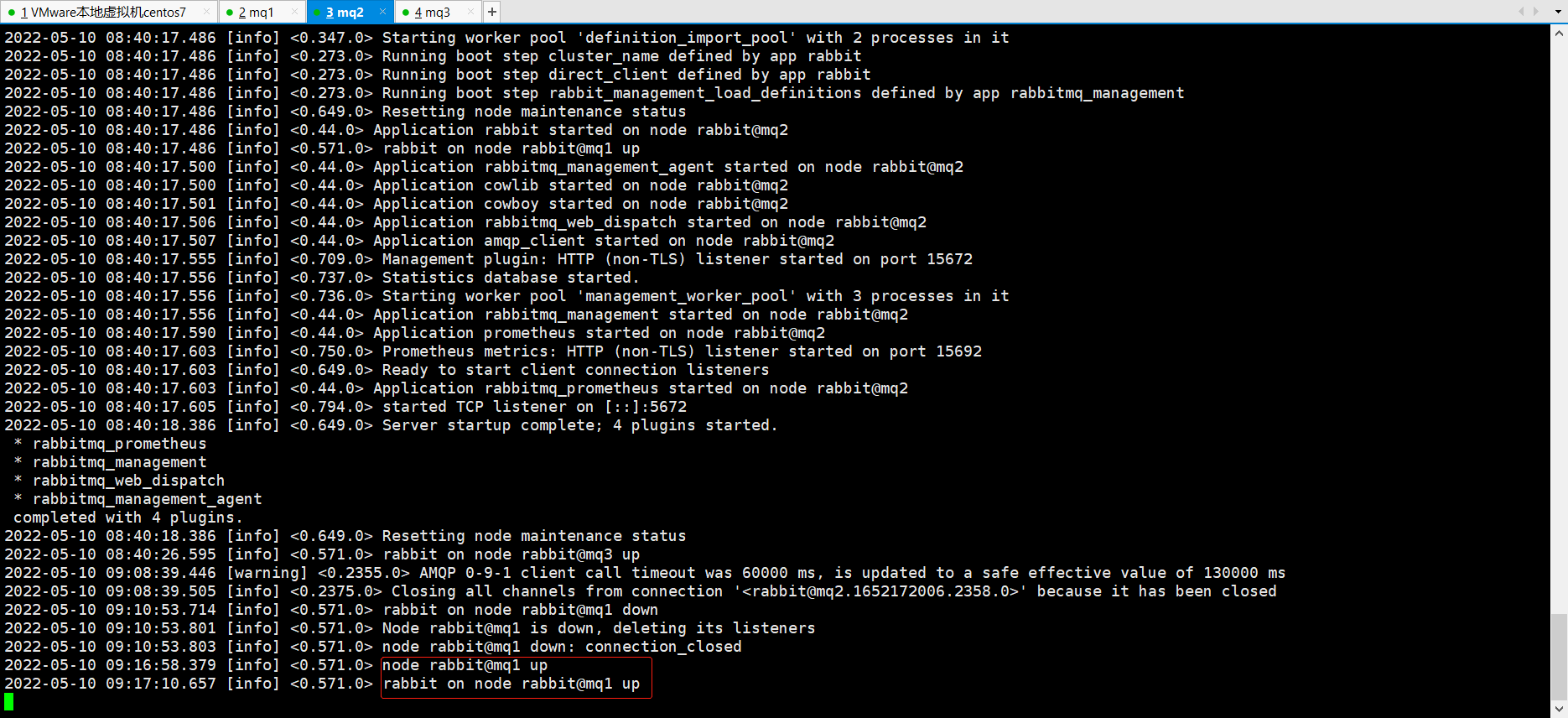

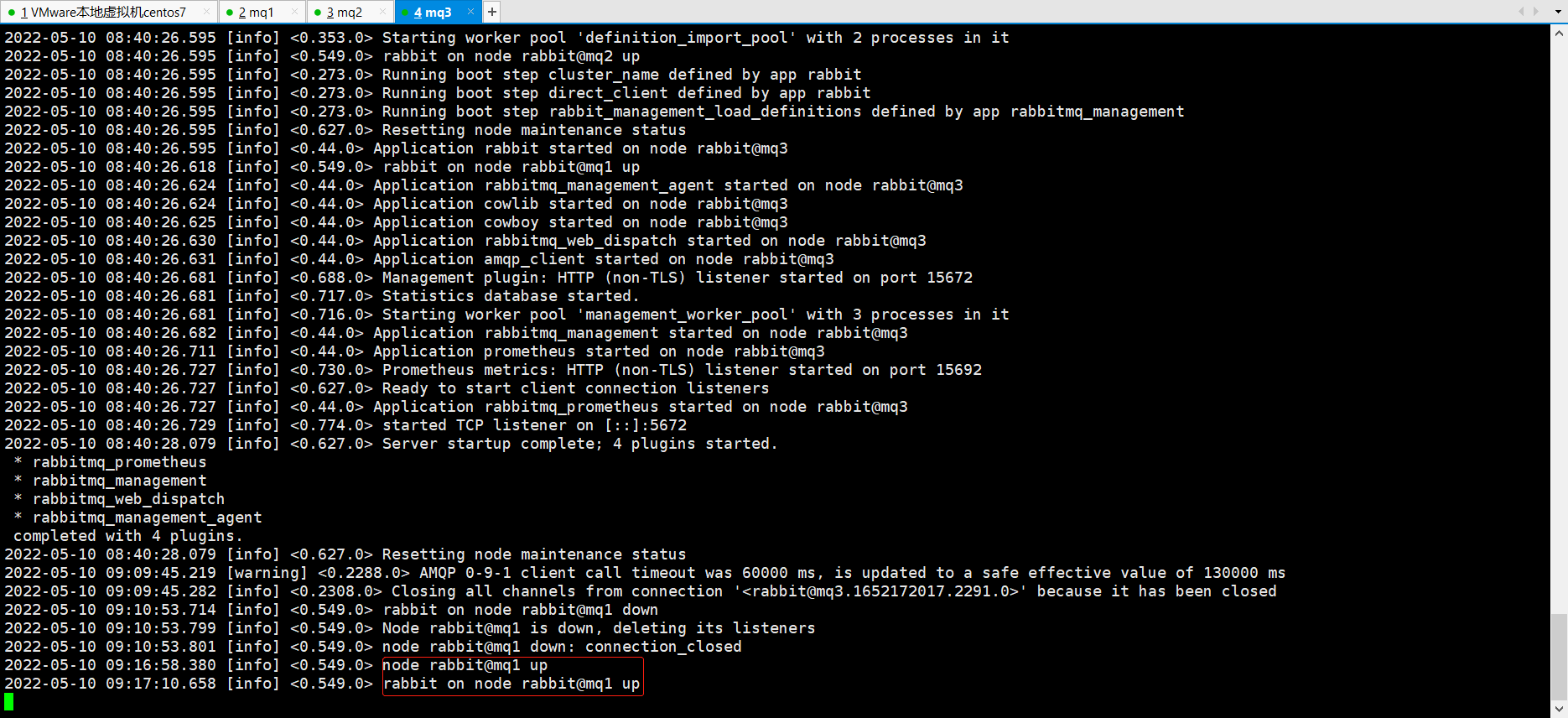

再打开三个窗口,分别通过命令docker logs -f mq1/2/3看一下三个mq的启动情况

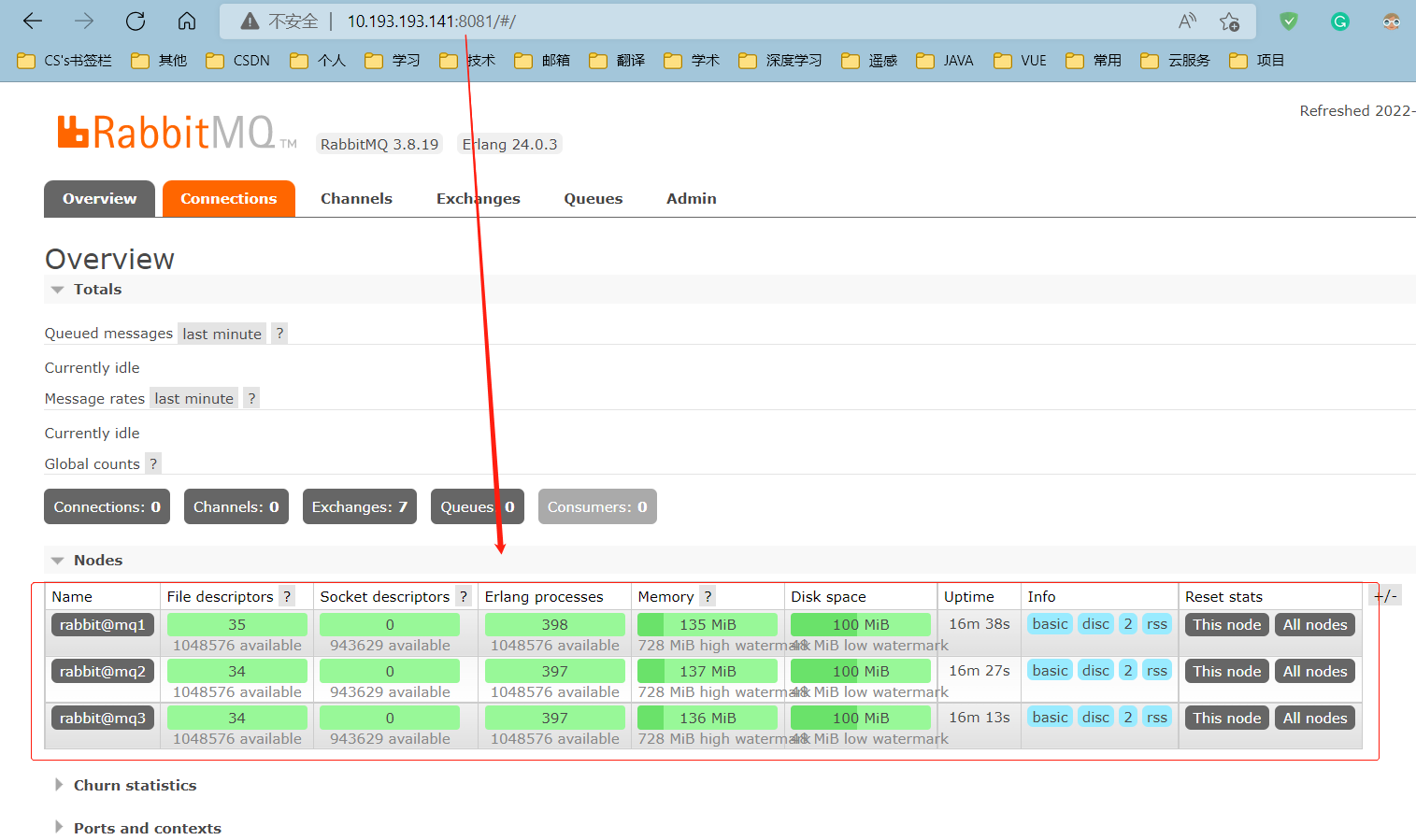

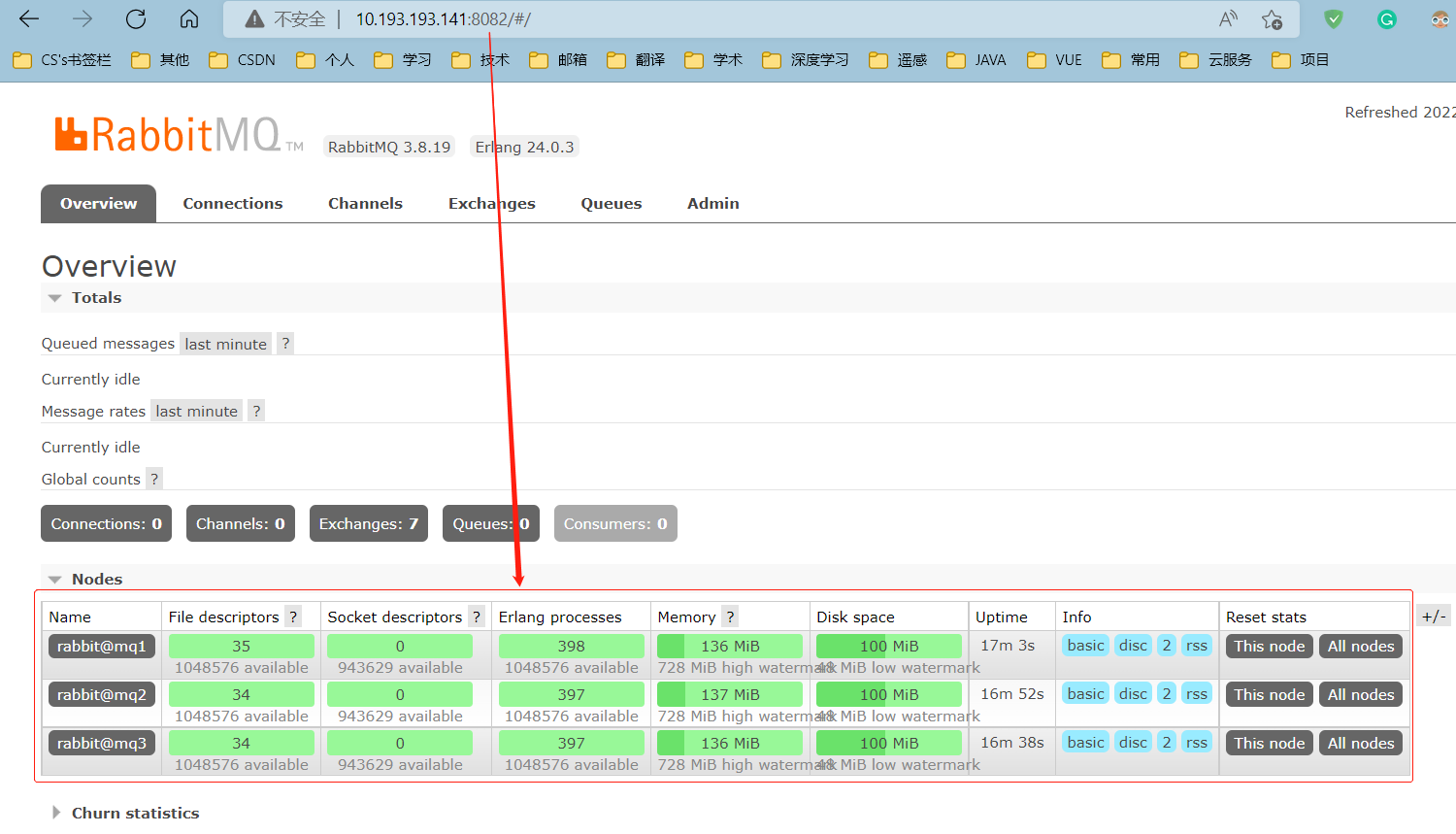

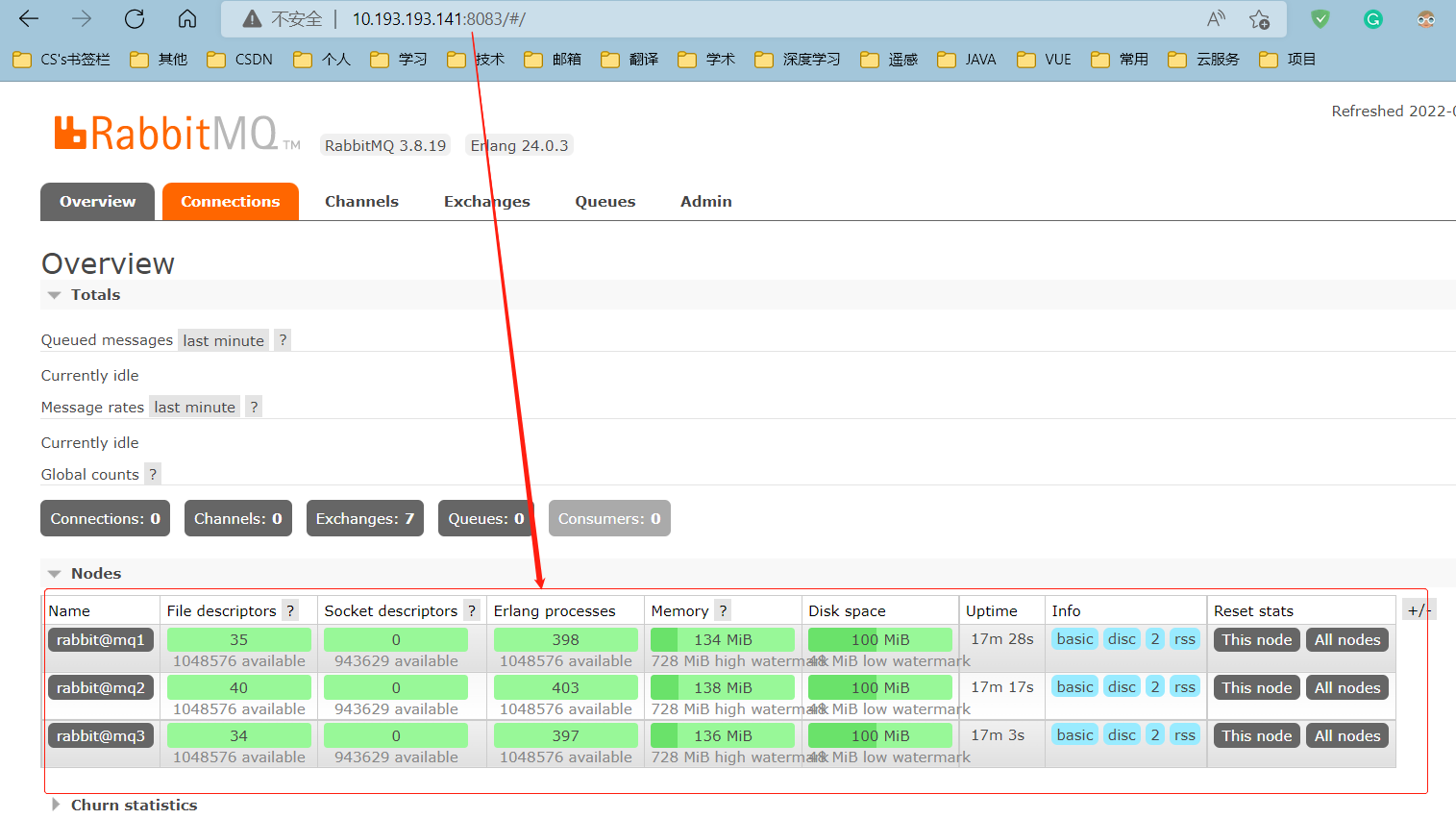

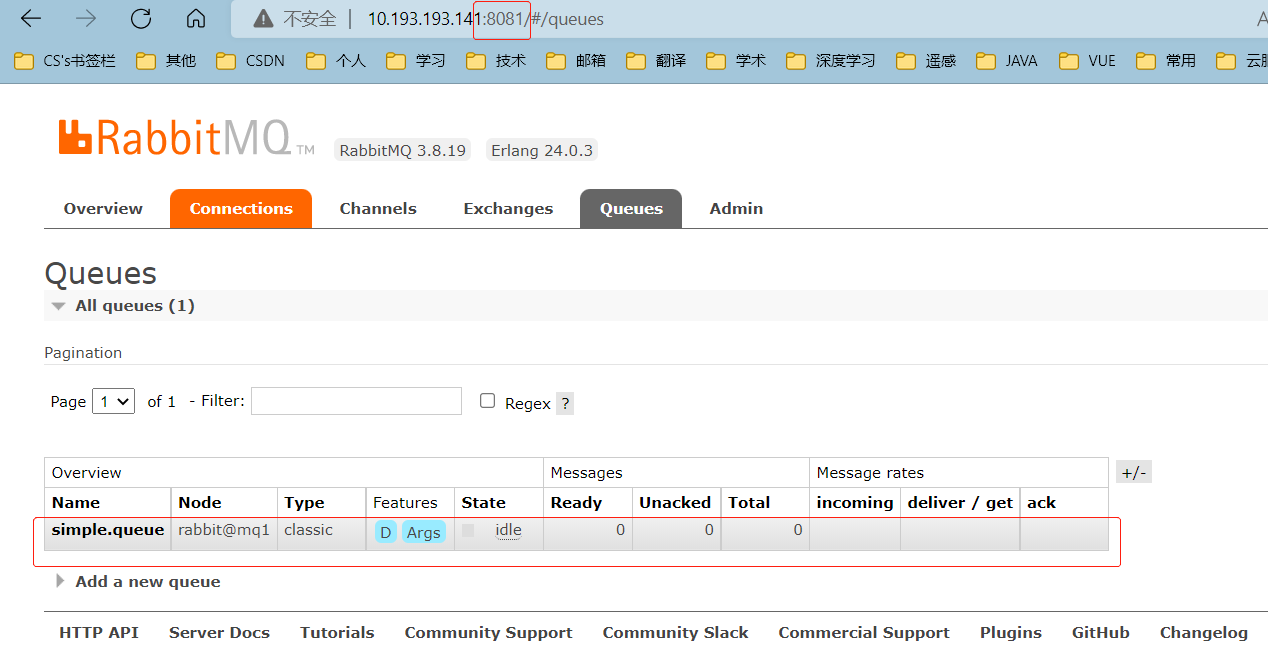

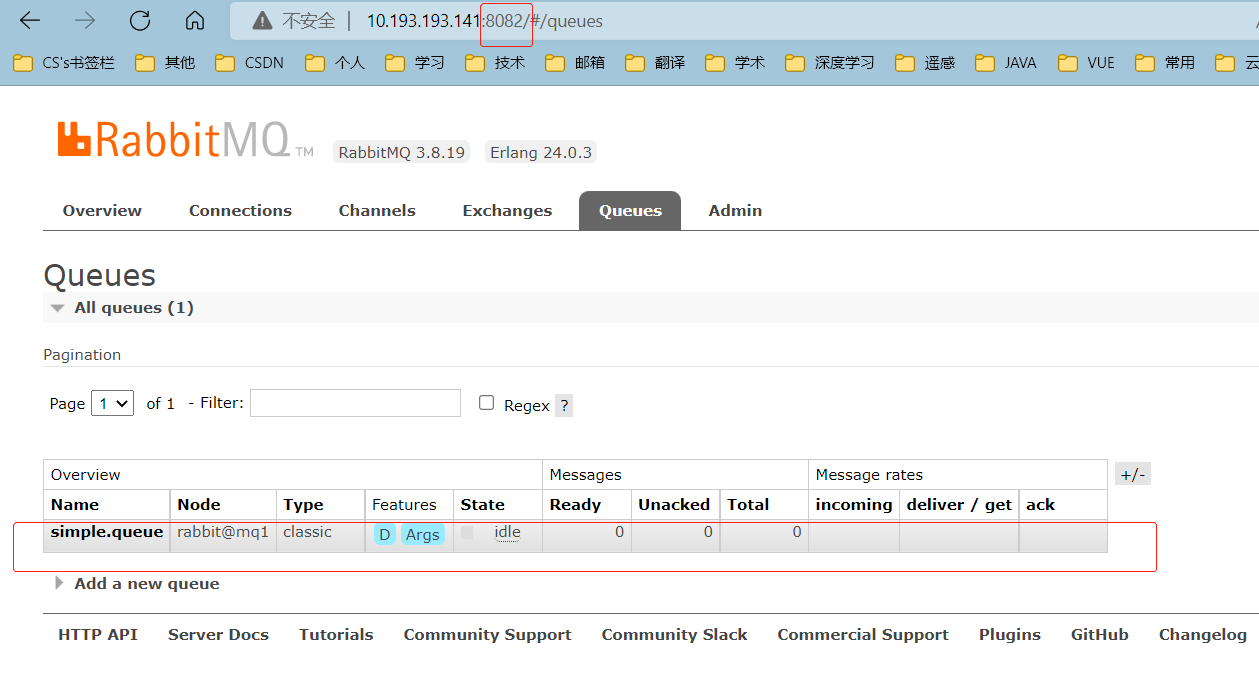

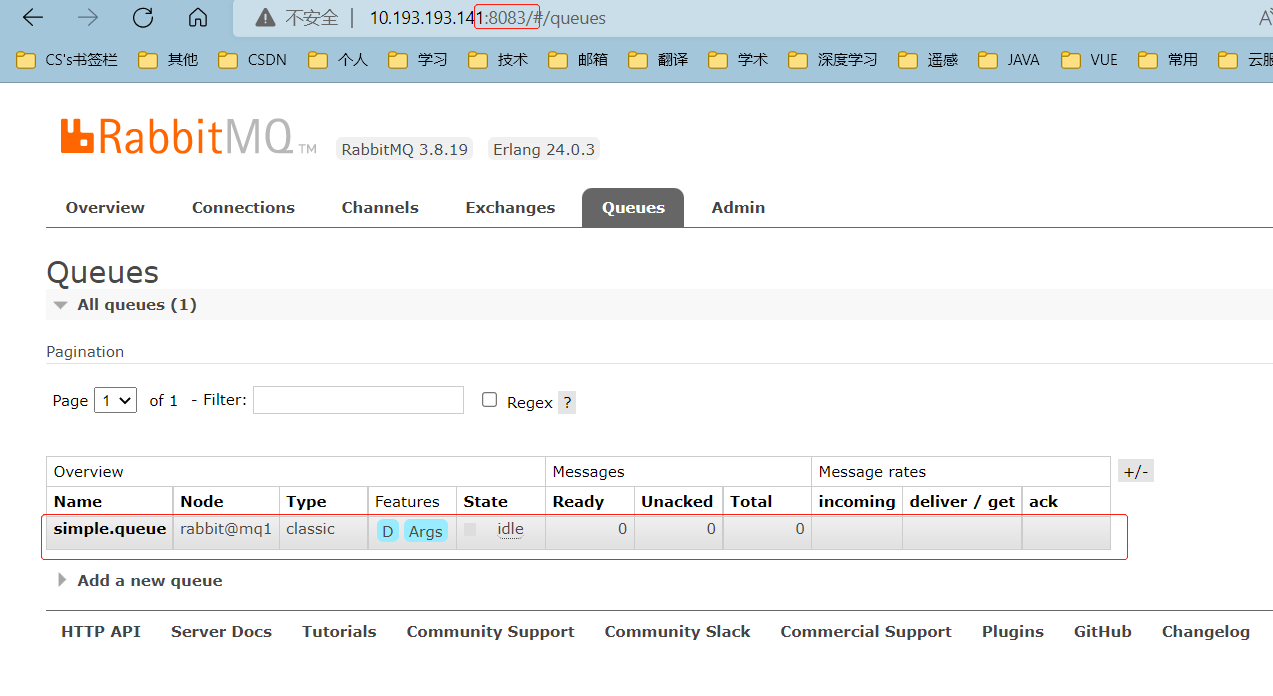

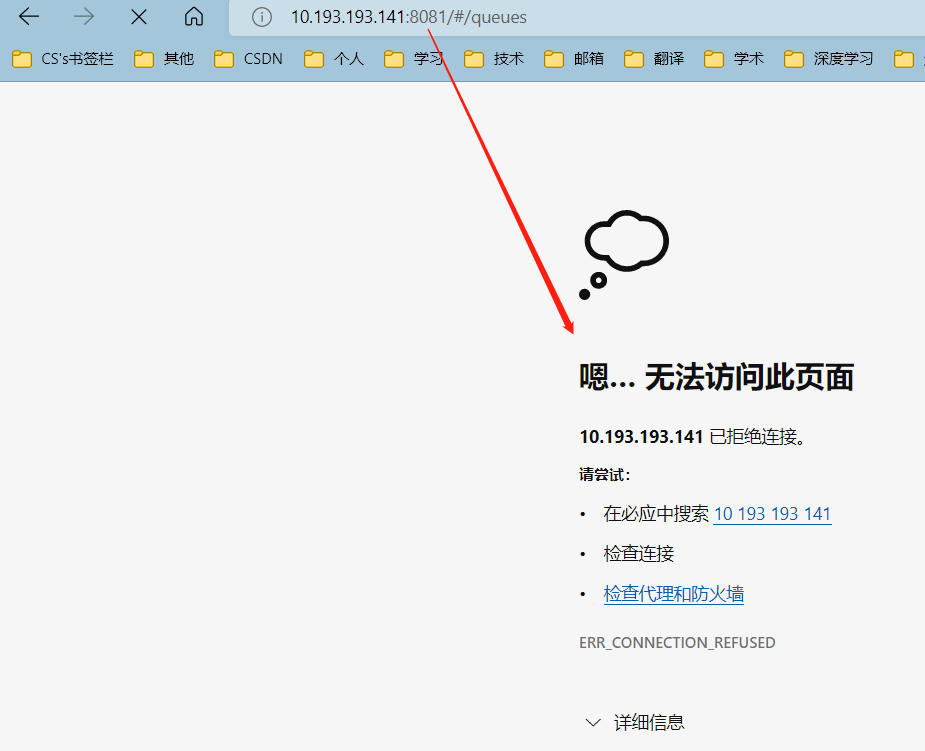

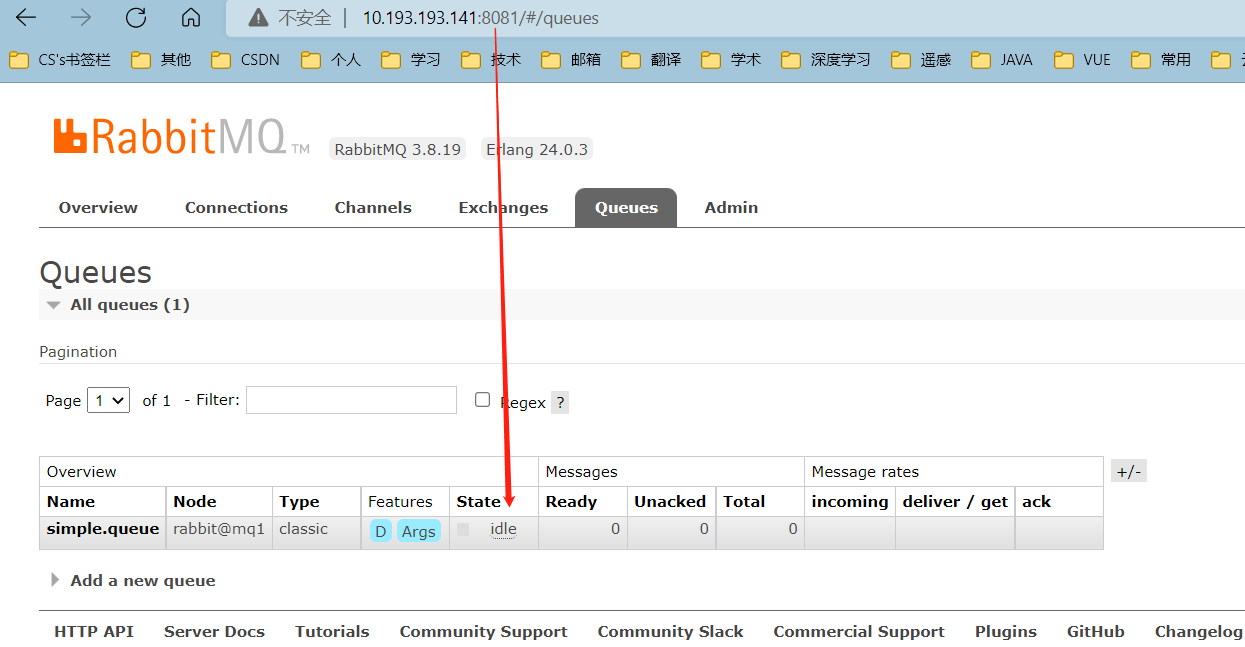

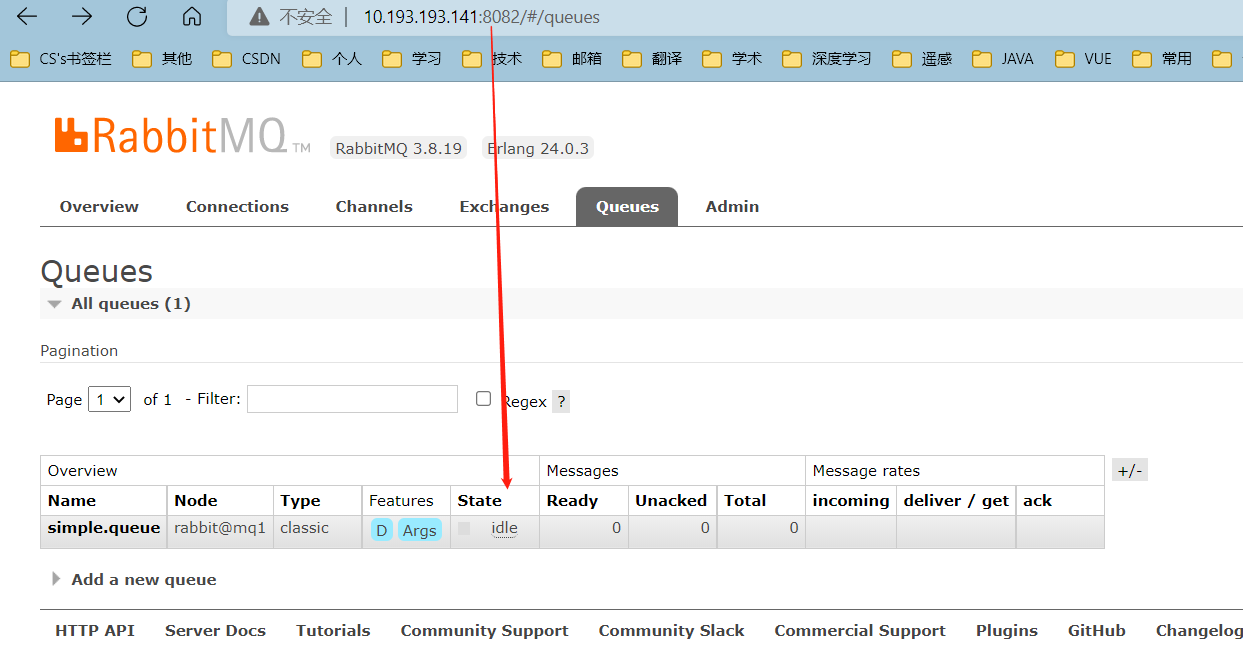

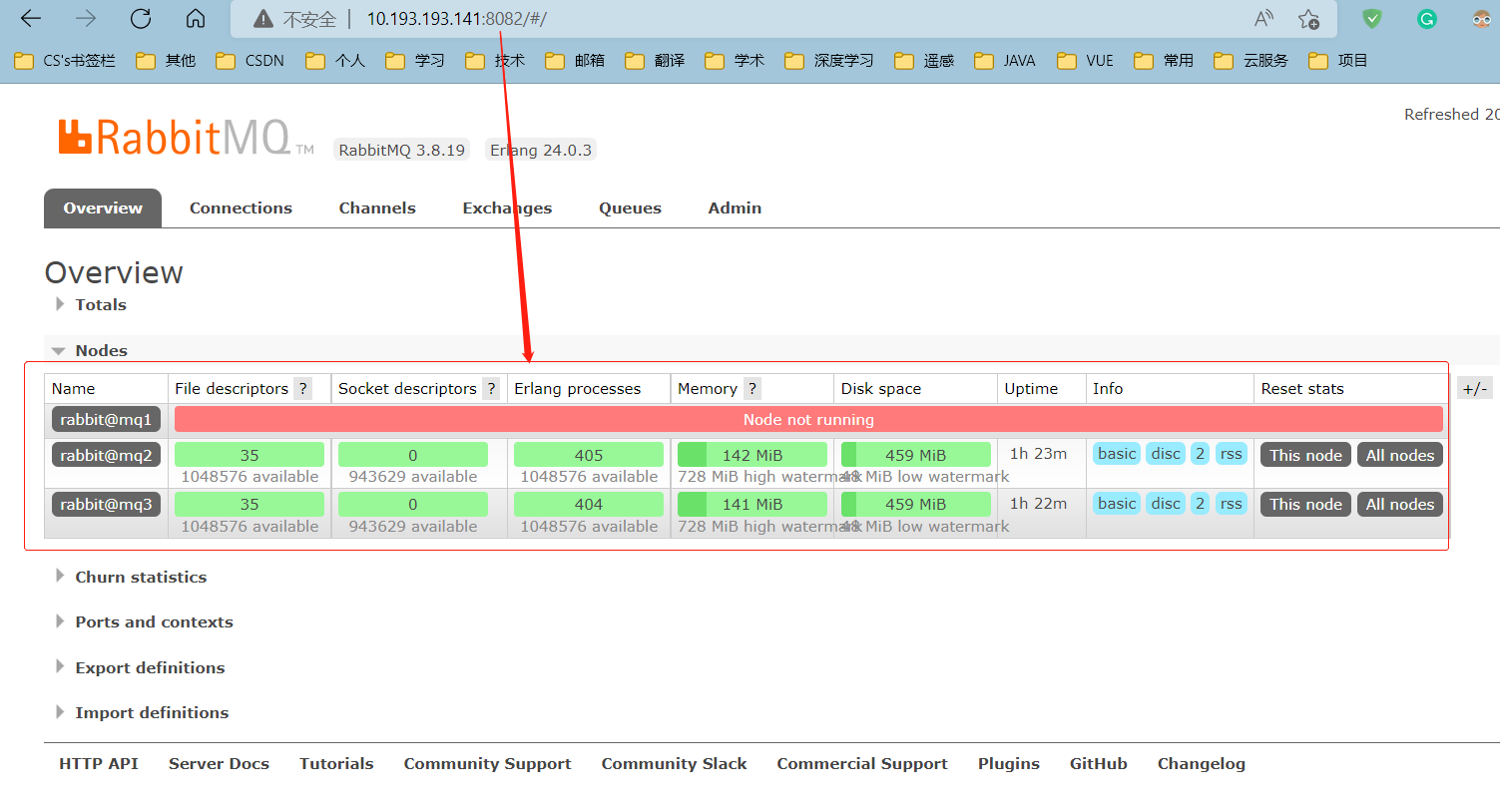

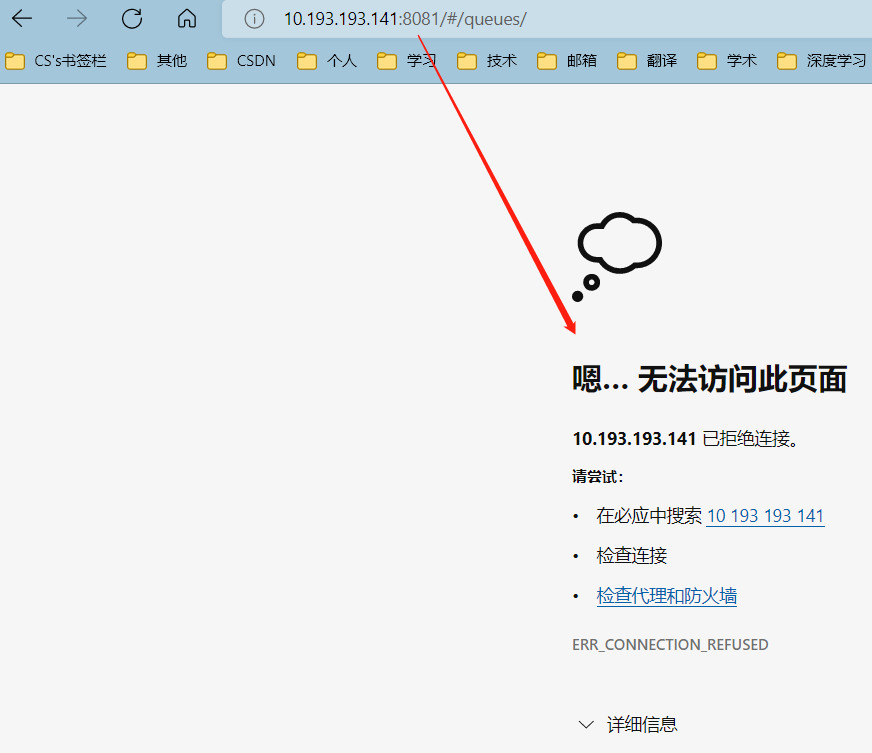

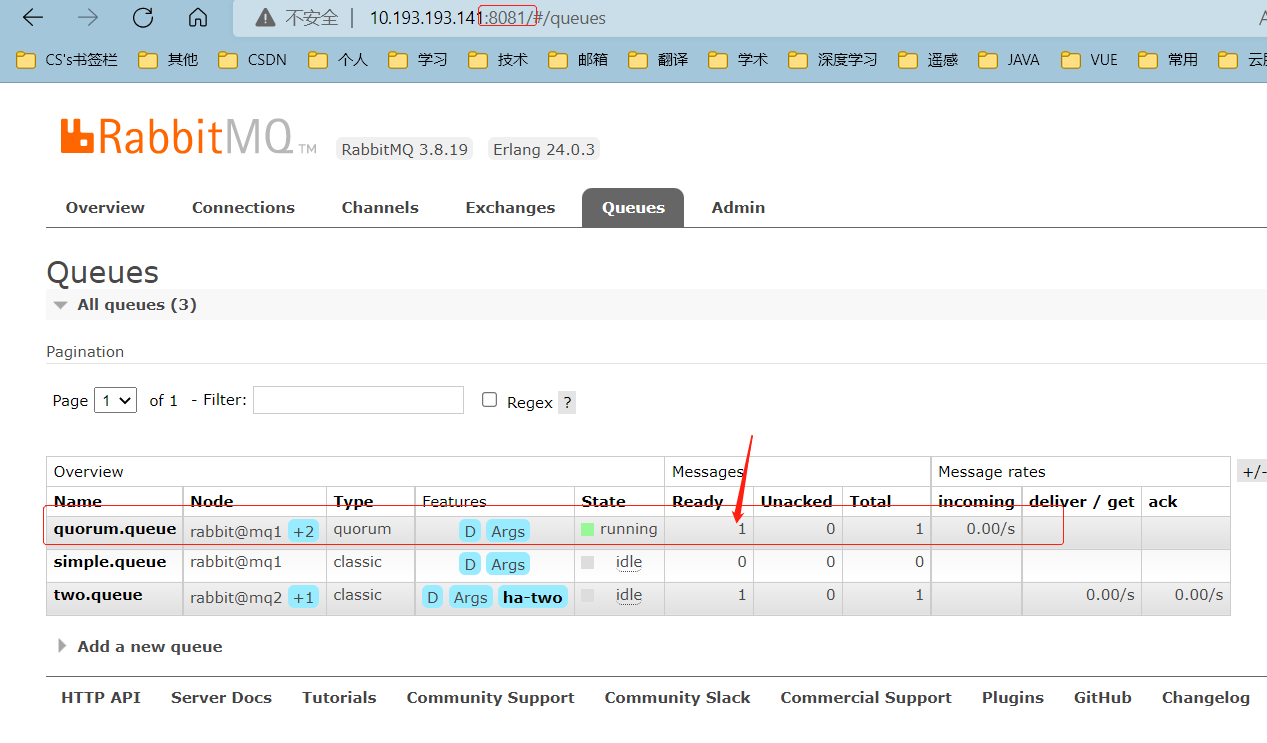

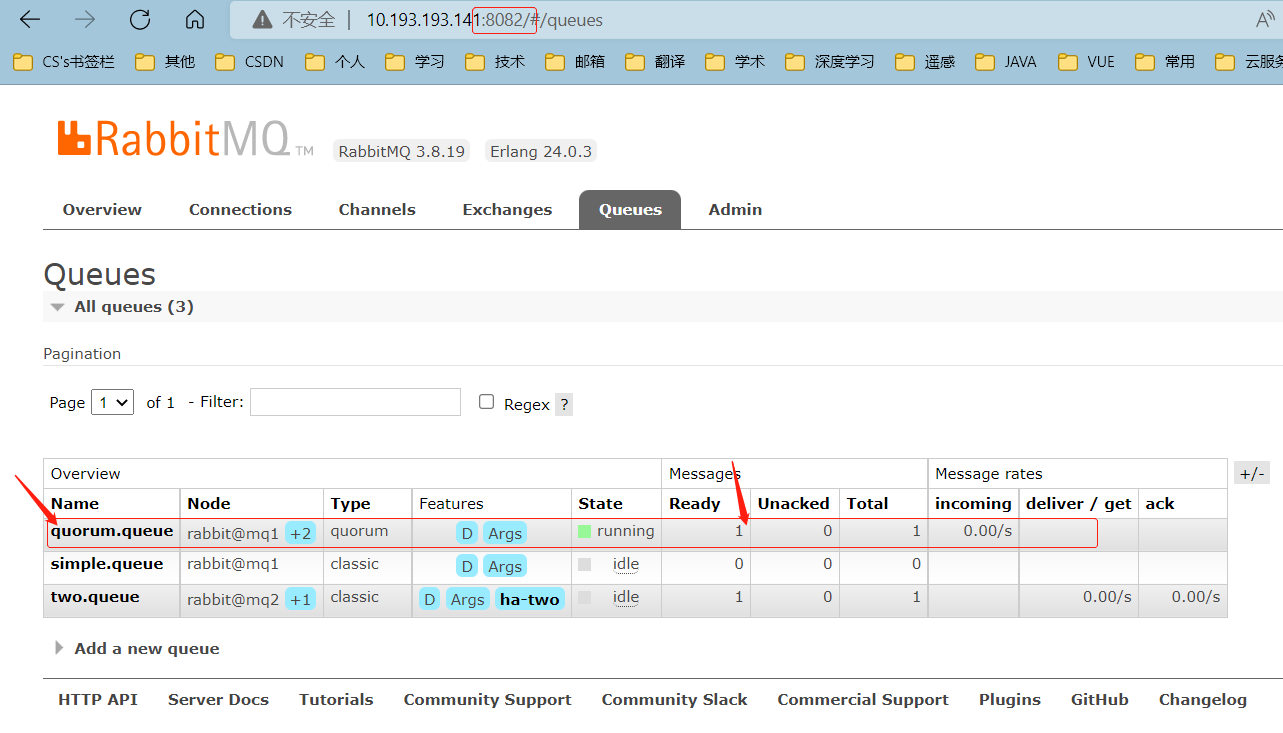

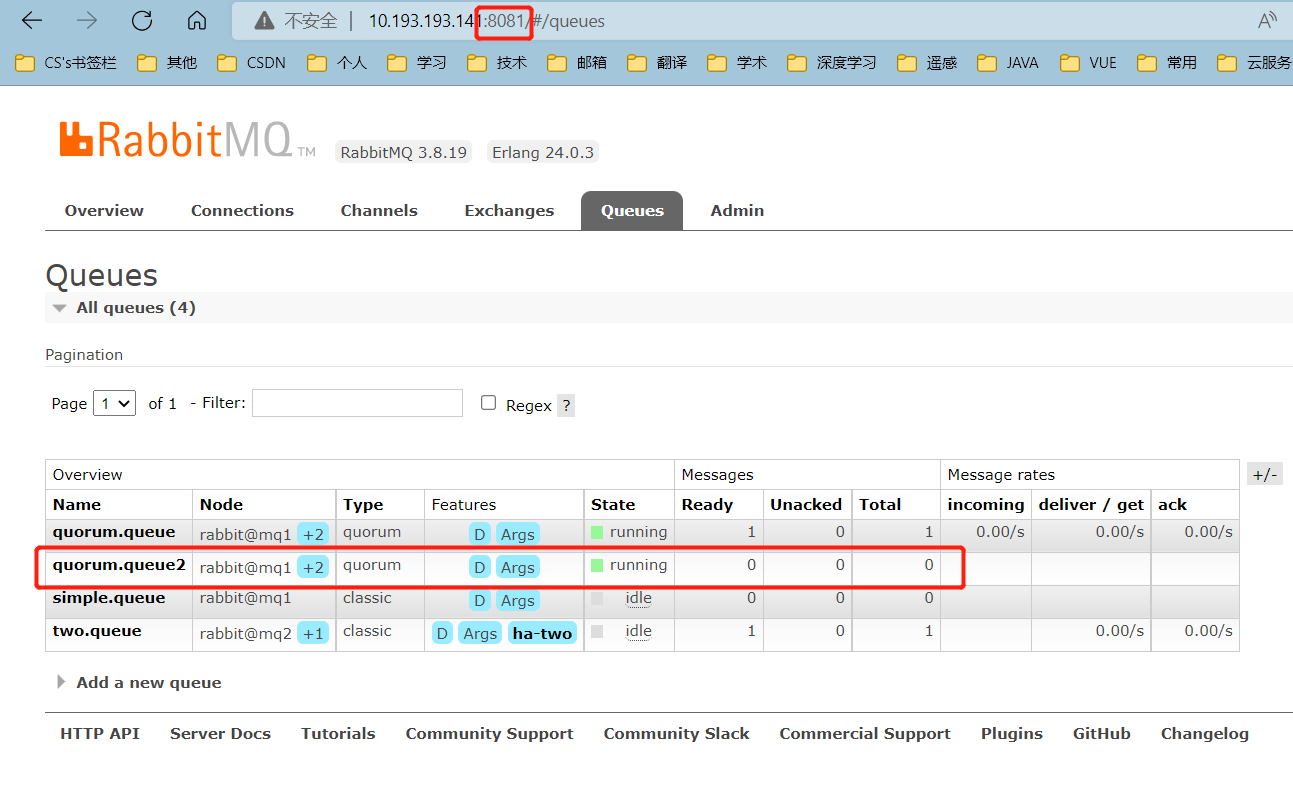

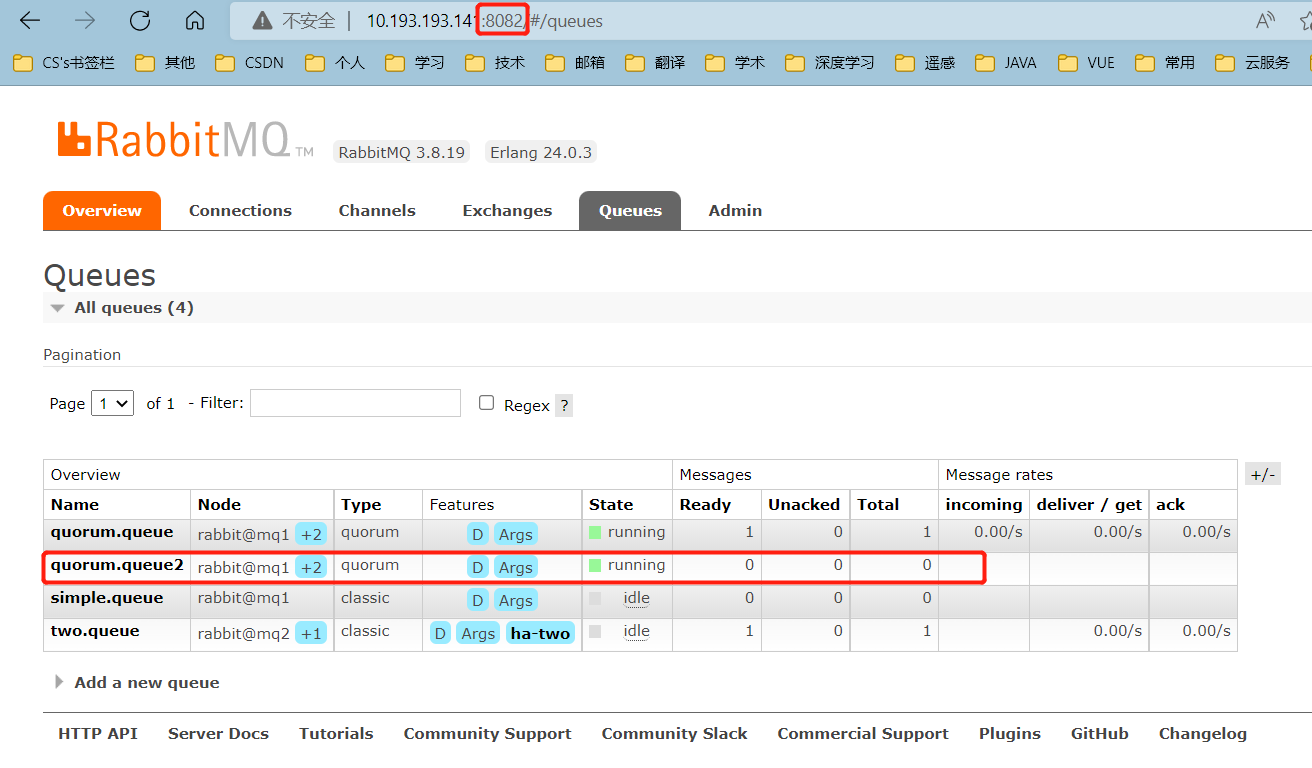

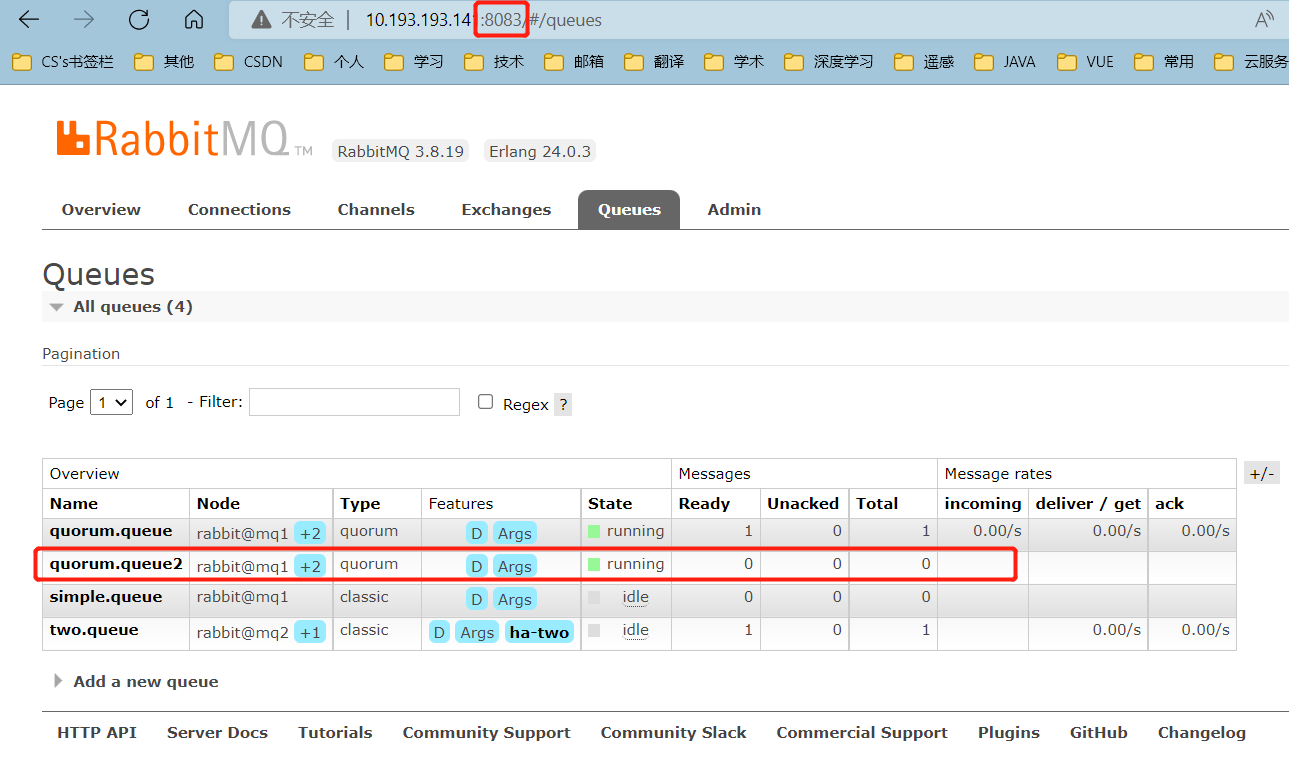

本地浏览器分别访问<10.193.193.141:8081/8082/8083>通过mq管理平台查看集群

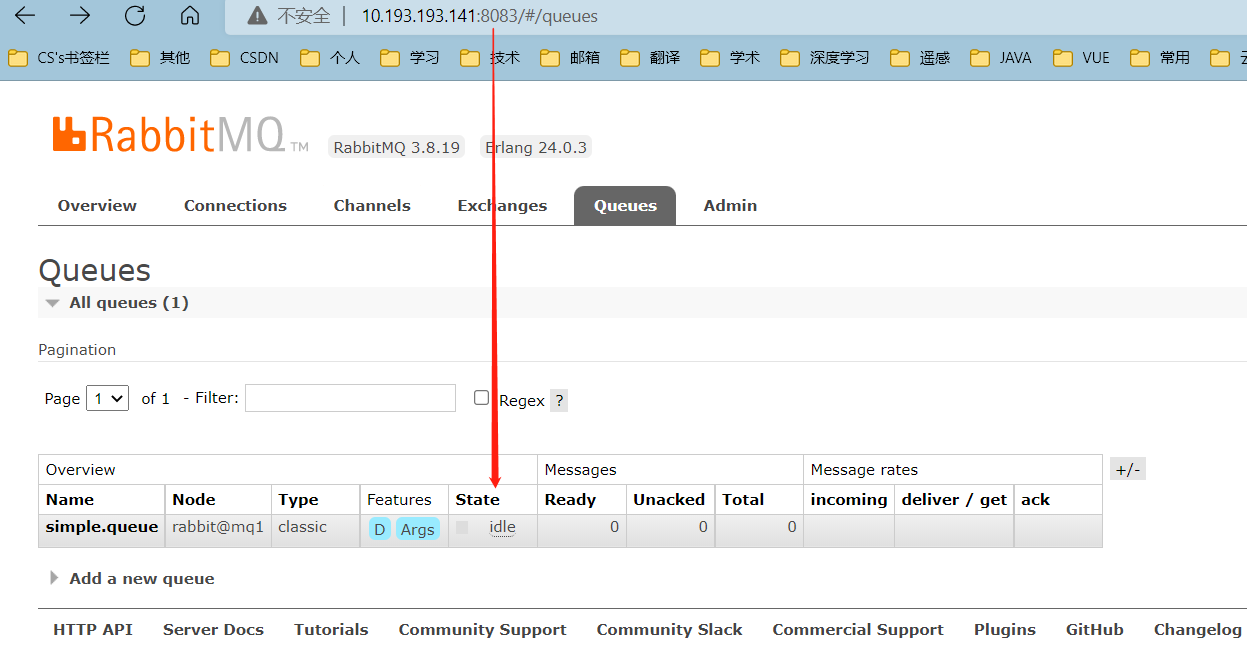

2.3 测试

2.3.1 数据共享测试

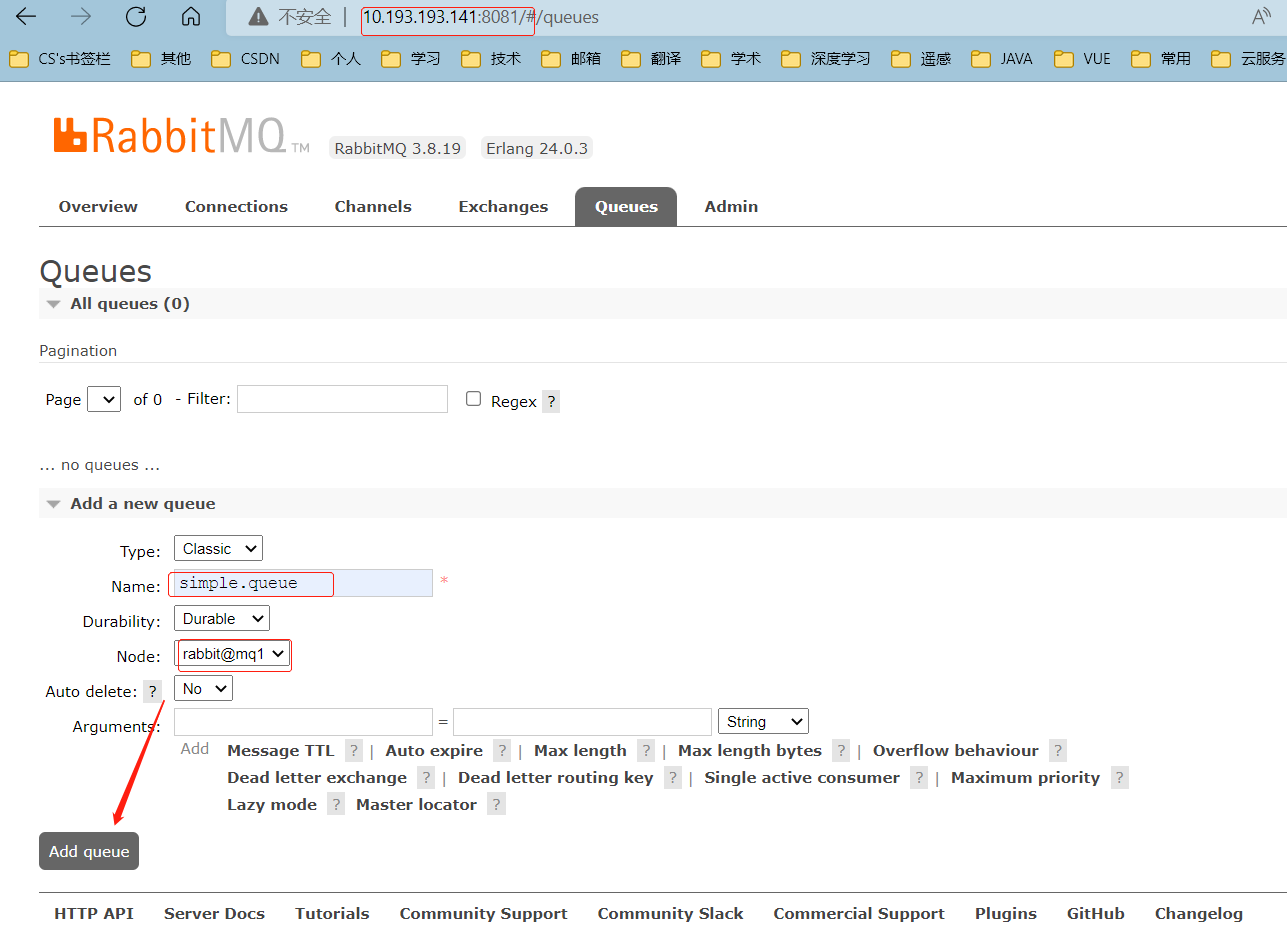

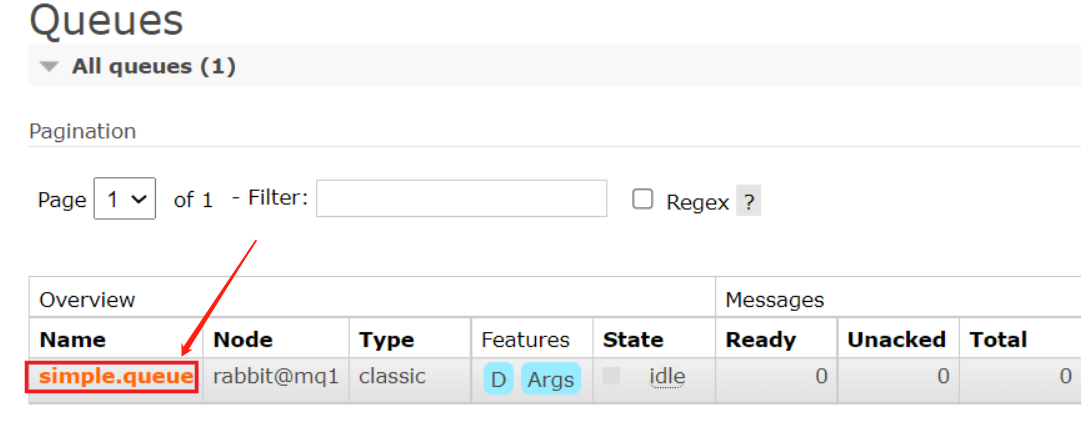

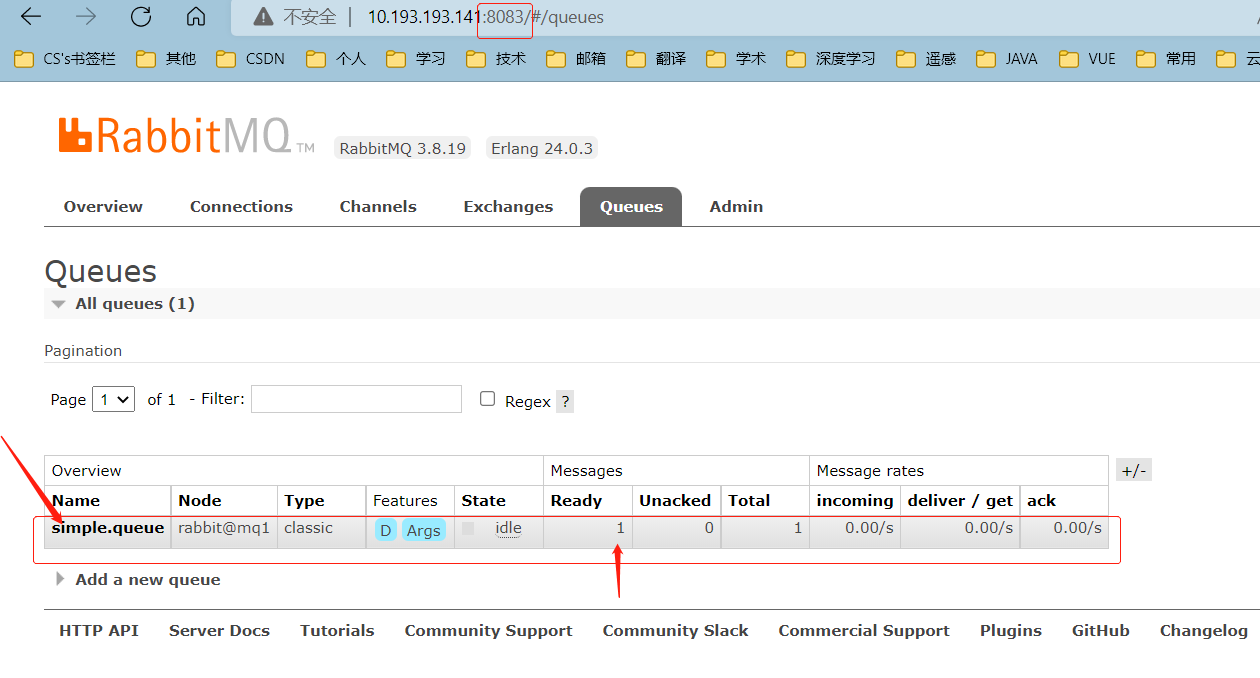

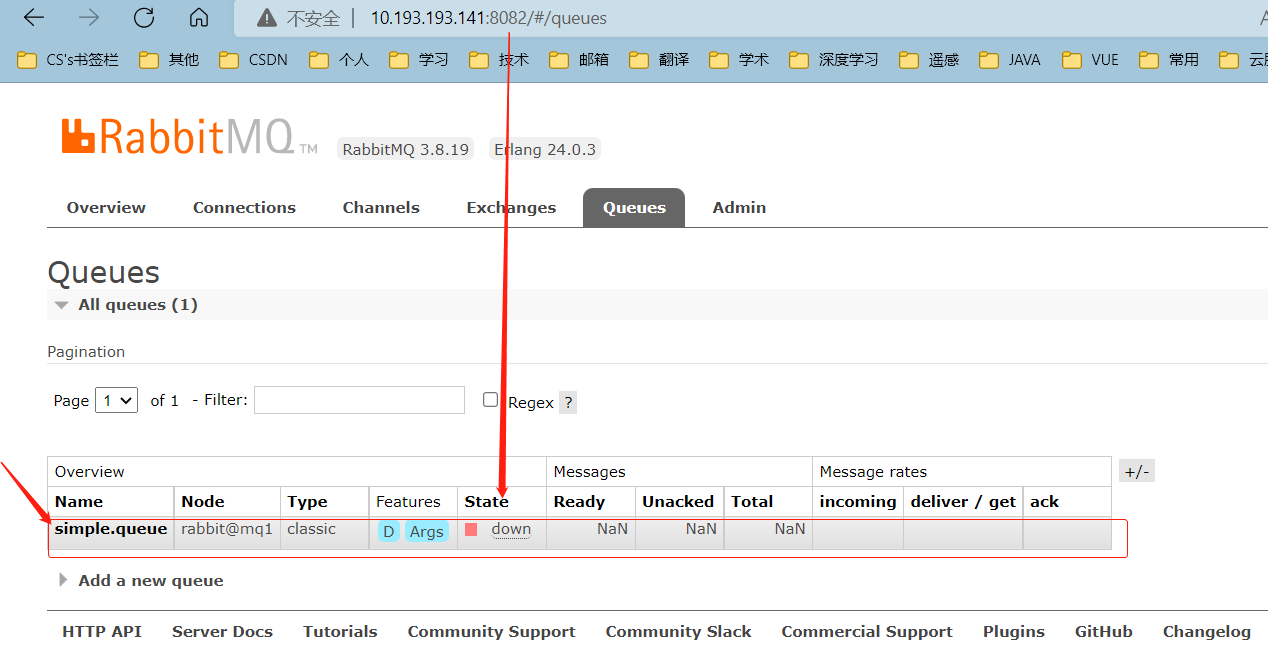

在mq1这个节点上添加一个队列:

如图,在mq2和mq3两个控制台也都能看到:

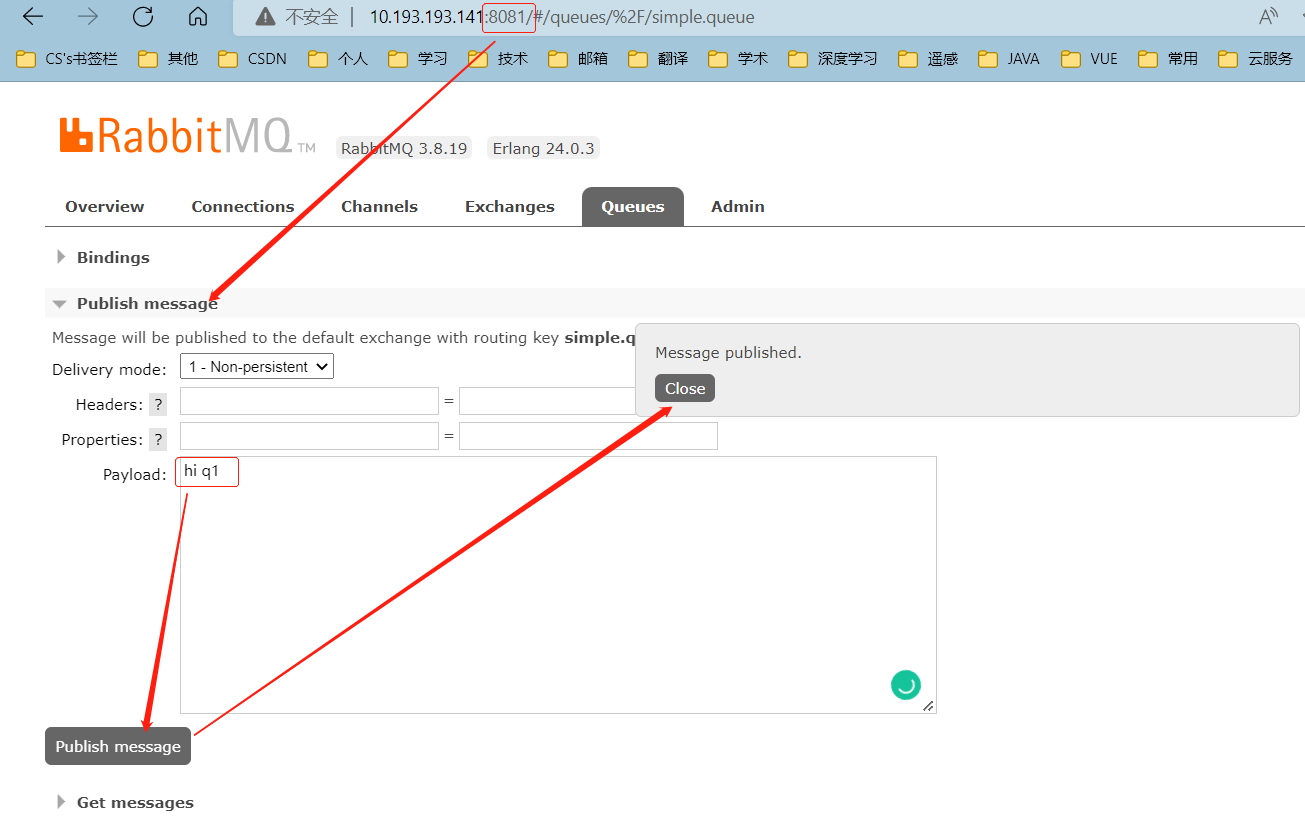

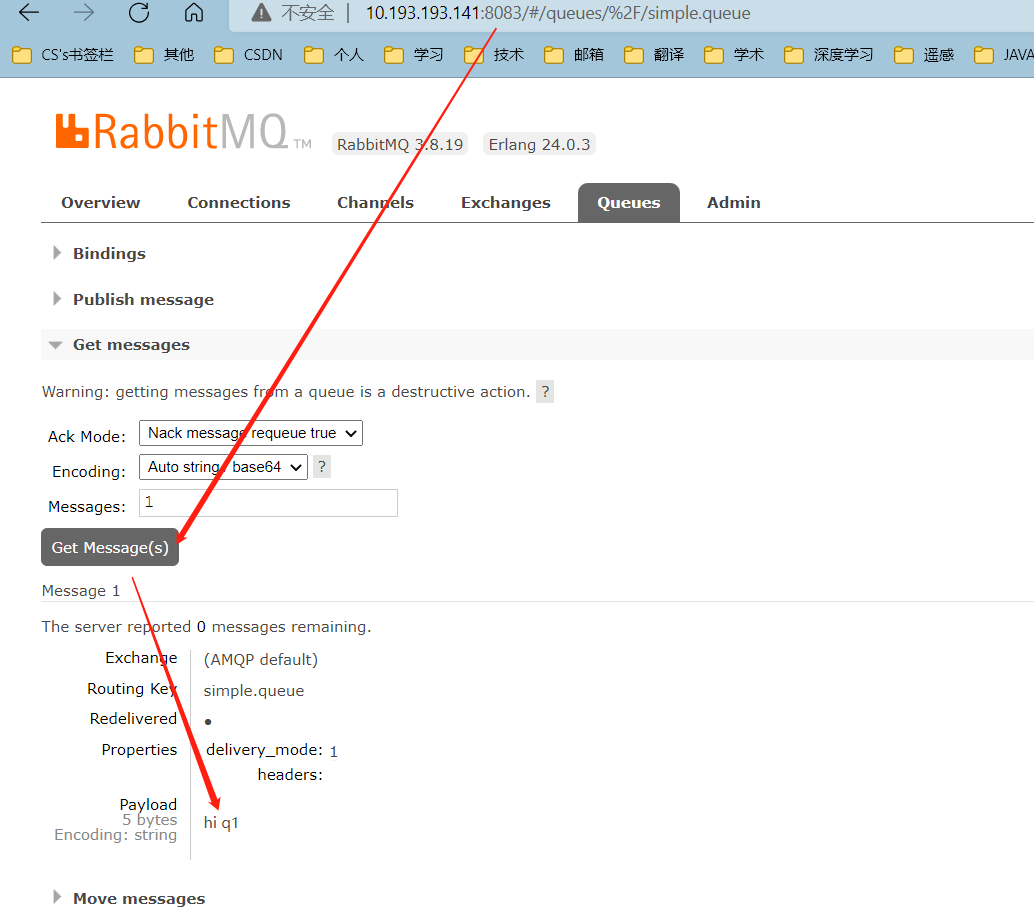

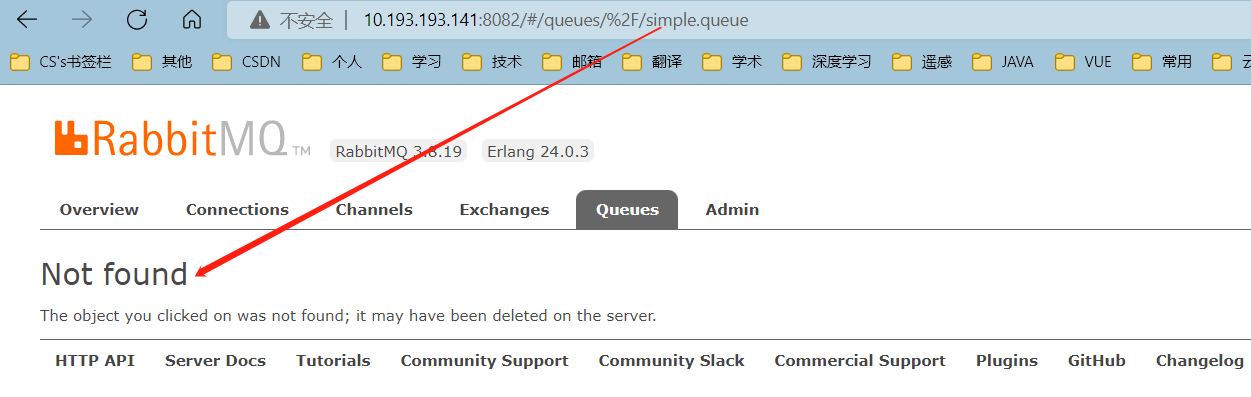

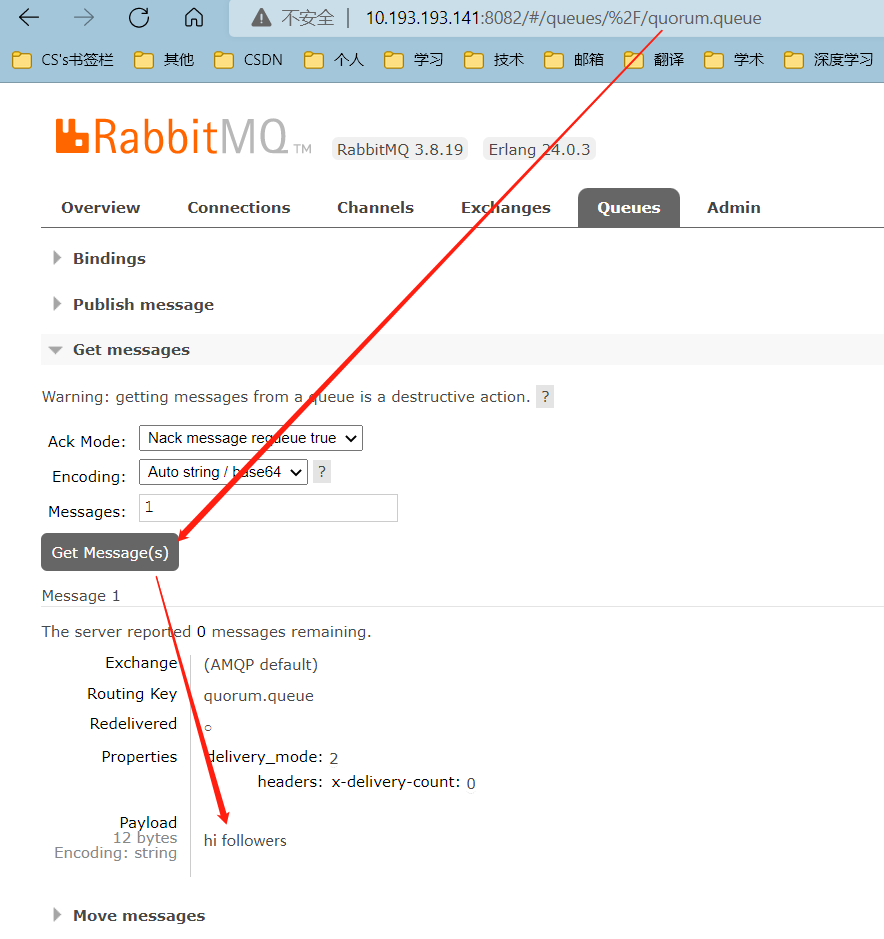

在mq1中点击这个队列,进入管理页面:

然后利用控制台发送一条消息到这个队列:

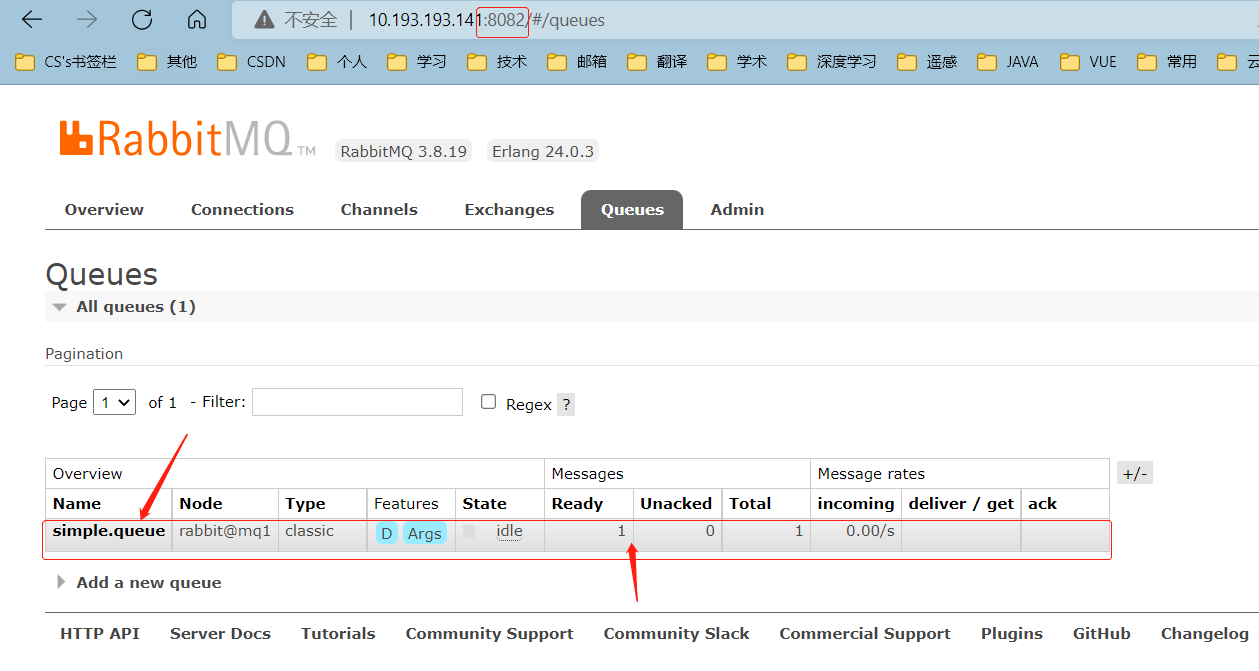

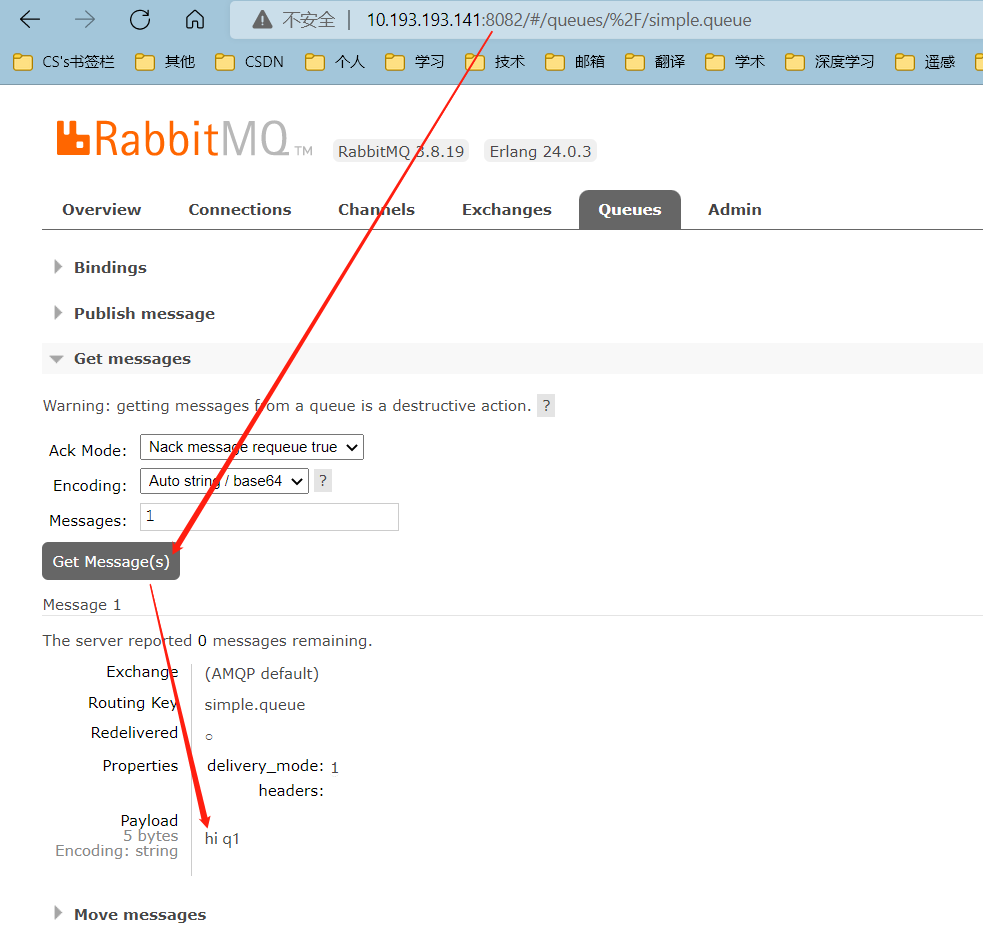

结果在mq2、mq3上都能看到这条消息:

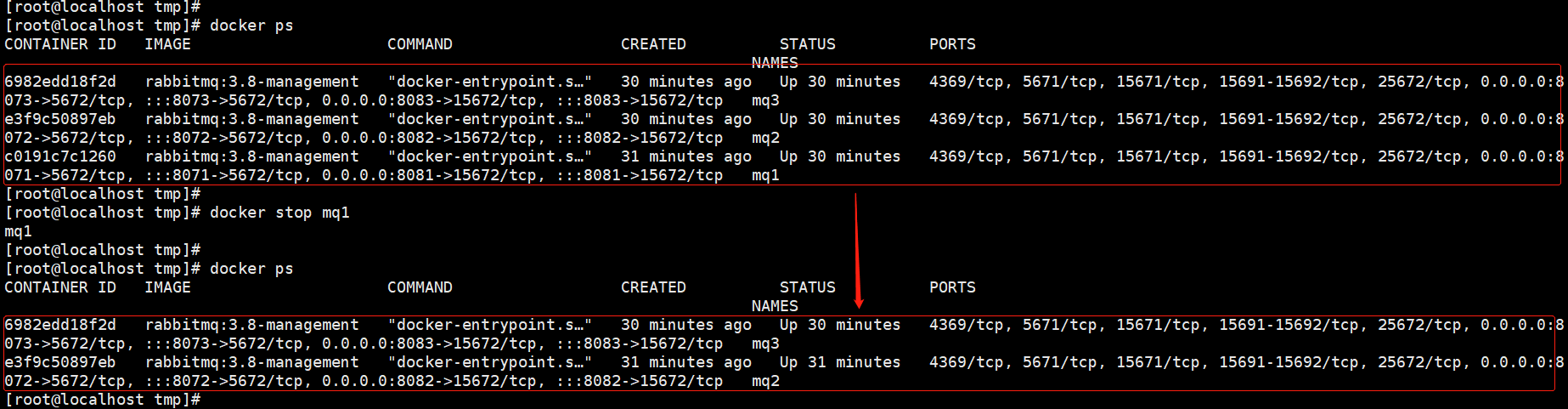

2.3.2 可用性测试

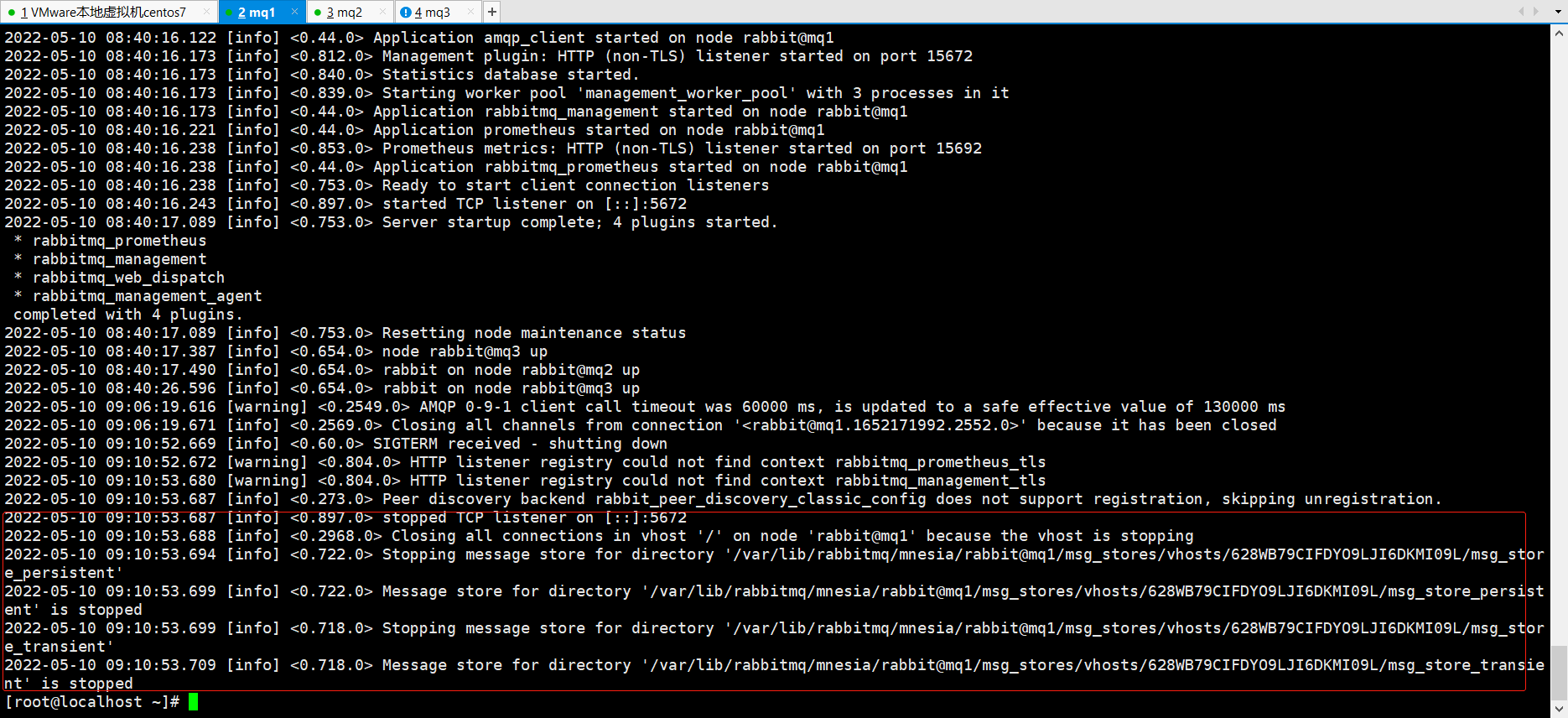

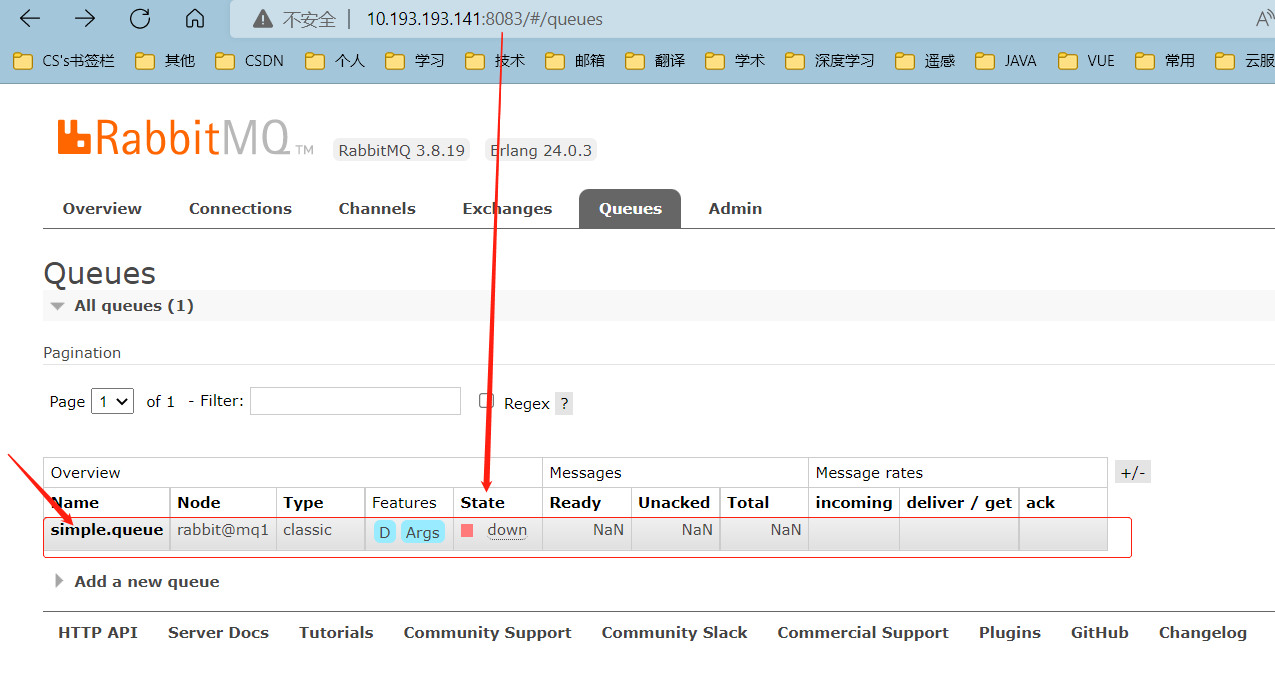

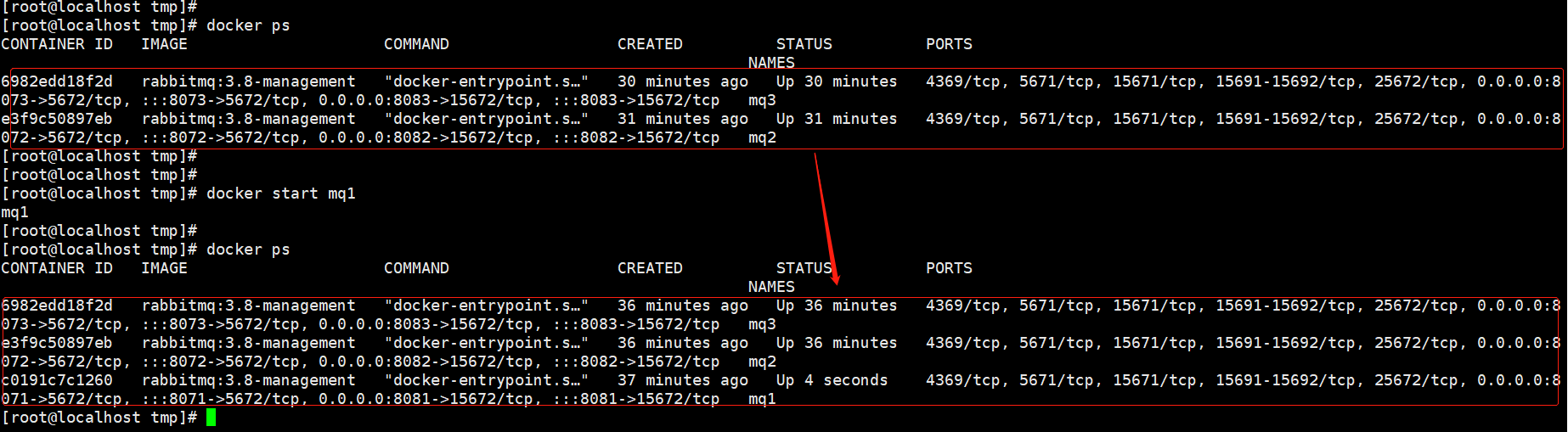

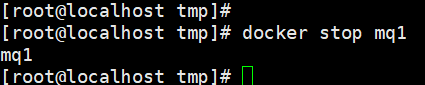

我们让其中一台节点mq1宕机:

docker stop mq1

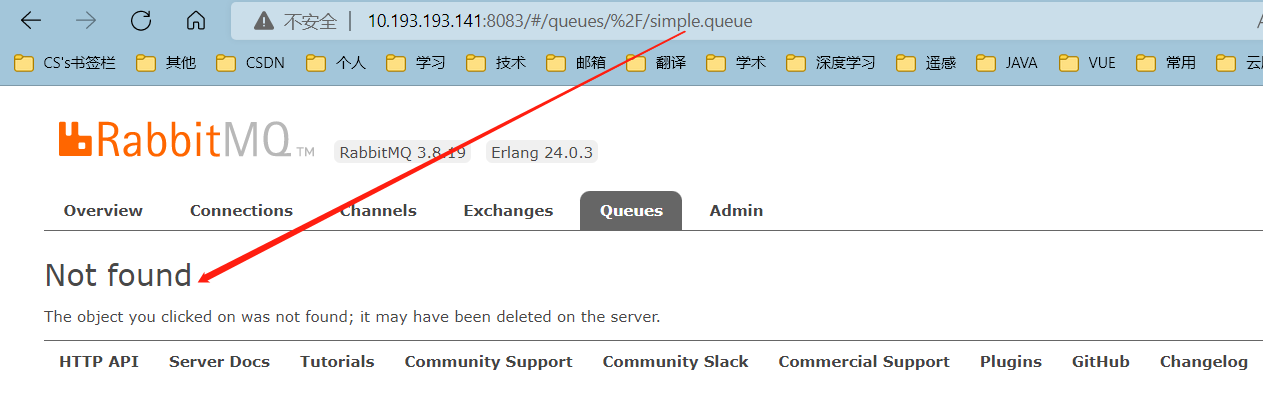

然后登录mq2或mq3的控制台,发现simple.queue也不可用了:

说明数据并没有拷贝到mq2和mq3。

重新启动mq1节点

3. 镜像集群

在刚刚的案例中,一旦创建队列的主机宕机,队列就会不可用。不具备高可用能力。

如果要解决这个问题,必须使用官方提供的镜像集群方案。

官方文档地址:https://www.rabbitmq.com/ha.html

PS:镜像集群实际上就是在传统普通集群基础上做了一些配置实现的

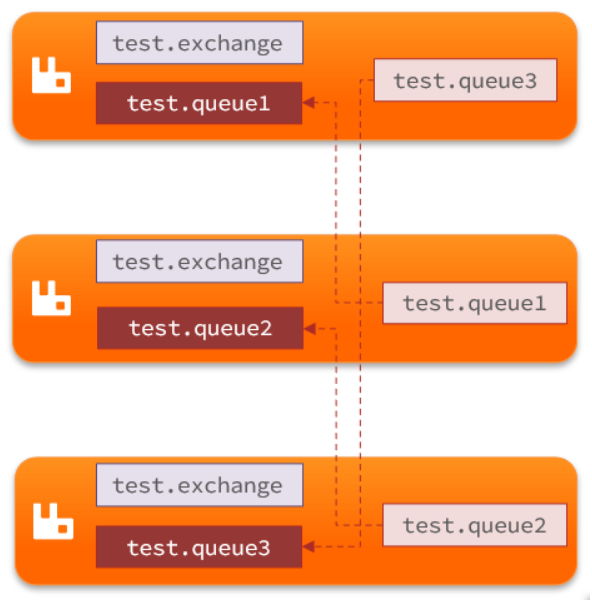

3.1 集群结构和特征

镜像集群:本质是主从模式。

具备下面的特征:

- 交换机、队列、队列中的消息会在各个mq的镜像节点之间同步备份。

- 创建队列的节点被称为该队列的主节点,备份到的其它节点叫做该队列的镜像节点。

- 一个队列的主节点可能是另一个队列的镜像节点

- 所有操作都是主节点完成,然后同步给镜像节点

- 主宕机后,镜像节点会替代成新的主

结构如图:

3.2 镜像模式的特征

默认情况下,队列只保存在创建该队列的节点上。而镜像模式下,创建队列的节点被称为该队列的主节点,队列还会拷贝到集群中的其它节点,也叫做该队列的镜像节点。

但是,不同队列可以在集群中的任意节点上创建,因此不同队列的主节点可以不同。甚至,一个队列的主节点可能是另一个队列的镜像节点。

用户发送给队列的一切请求,例如发送消息、消息回执默认都会在主节点完成,如果是从节点接收到请求,也会路由到主节点去完成。镜像节点仅仅起到备份数据作用。

当主节点接收到消费者的ACK时,所有镜像都会删除节点中的数据。

总结如下:

- 镜像队列结构是一主多从(从就是镜像)

- 所有操作都是主节点完成,然后同步给镜像节点

- 主宕机后,镜像节点会替代成新的主(如果在主从同步完成前,主就已经宕机,可能出现数据丢失)

- 不具备负载均衡功能,因为所有操作都会有主节点完成(但是不同队列,其主节点可以不同,可以利用这个提高吞吐量)

3.3 镜像模式的配置

镜像模式的配置有3种模式:

| ha-mode | ha-params | 效果 |

|---|---|---|

| 准确模式exactly | 队列的副本量count | 集群中队列副本(主服务器和镜像服务器之和)的数量。count如果为1意味着单个副本:即队列主节点。count值为2表示2个副本:1个队列主和1个队列镜像。换句话说:count = 镜像数量 + 1。如果群集中的节点数少于count,则该队列将镜像到所有节点。如果有集群总数大于count+1,并且包含镜像的节点出现故障,则将在另一个节点上创建一个新的镜像。 |

| all | (none) | 队列在群集中的所有节点之间进行镜像。队列将镜像到任何新加入的节点。镜像到所有节点将对所有群集节点施加额外的压力,包括网络I / O,磁盘I / O和磁盘空间使用情况。推荐使用exactly,设置副本数为(N / 2 +1)。 |

| nodes | node names | 指定队列创建到哪些节点,如果指定的节点全部不存在,则会出现异常。如果指定的节点在集群中存在,但是暂时不可用,会创建节点到当前客户端连接到的节点。 |

这里我们以rabbitmqctl命令作为案例来讲解配置语法。

语法示例如下

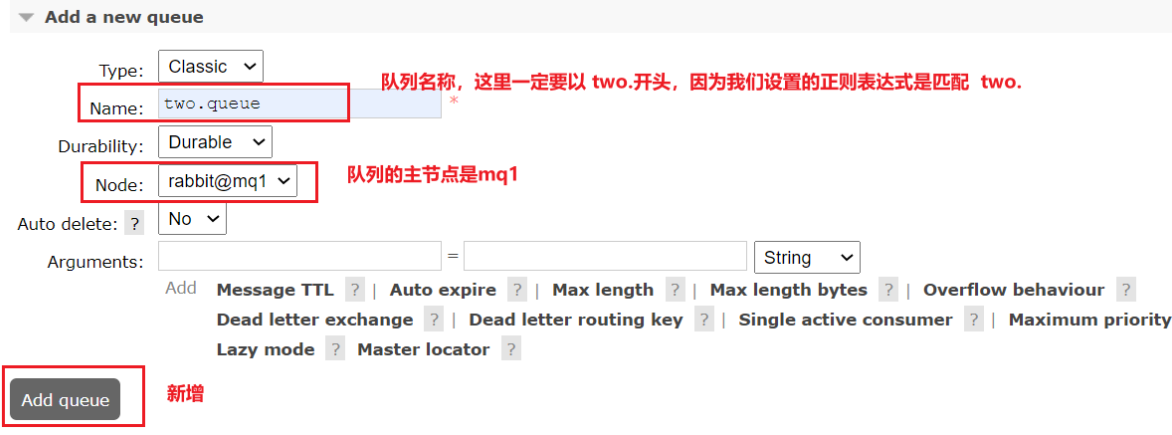

3.3.1 exactly模式

rabbitmqctl set_policy ha-two "^two\." '{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}'

rabbitmqctl set_policy:固定写法ha-two:策略名称,自定义"^two\.":匹配队列的正则表达式,符合命名规则的队列才生效,这里是任何以two.开头的队列名称'{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}': 策略内容"ha-mode":"exactly":策略模式,此处是exactly模式,指定副本数量"ha-params":2:策略参数,这里是2,就是副本数量为2,1主1镜像"ha-sync-mode":"automatic":同步策略,默认是manual,即新加入的镜像节点不会同步旧的消息。如果设置为automatic,则新加入的镜像节点会把主节点中所有消息都同步,会带来额外的网络开销

3.3.2 all模式

rabbitmqctl set_policy ha-all "^all\." '{"ha-mode":"all"}'

ha-all:策略名称,自定义"^all\.":匹配所有以all.开头的队列名'{"ha-mode":"all"}':策略内容"ha-mode":"all":策略模式,此处是all模式,即所有节点都会称为镜像节点

3.3.3 nodes模式

rabbitmqctl set_policy ha-nodes "^nodes\." '{"ha-mode":"nodes","ha-params":["rabbit@nodeA", "rabbit@nodeB"]}'

rabbitmqctl set_policy:固定写法ha-nodes:策略名称,自定义"^nodes\.":匹配队列的正则表达式,符合命名规则的队列才生效,这里是任何以nodes.开头的队列名称'{"ha-mode":"nodes","ha-params":["rabbit@nodeA", "rabbit@nodeB"]}': 策略内容"ha-mode":"nodes":策略模式,此处是nodes模式"ha-params":["rabbit@mq1", "rabbit@mq2"]:策略参数,这里指定副本所在节点名称

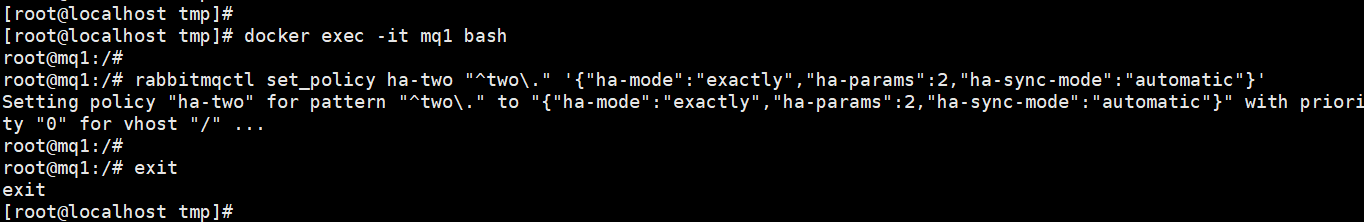

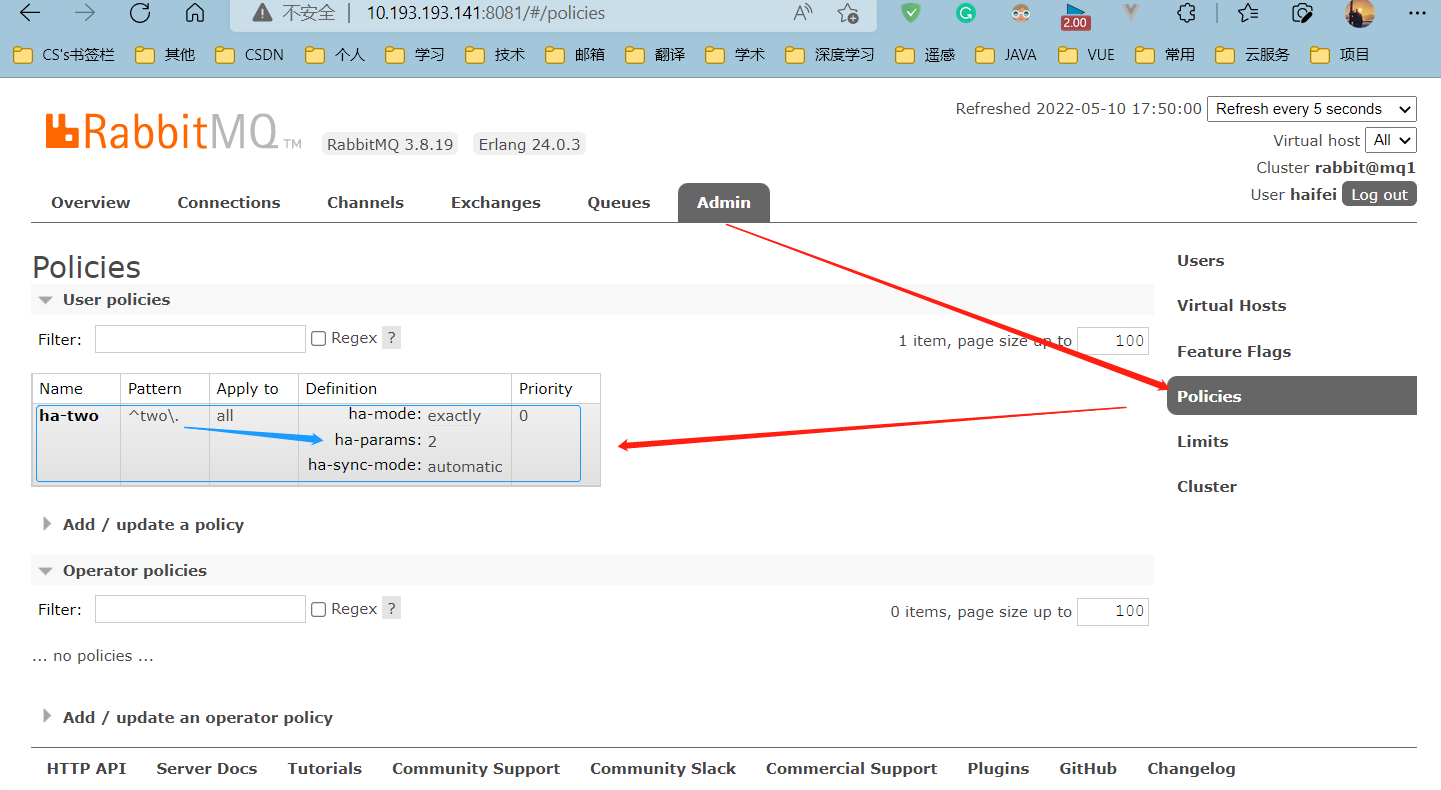

3.4 测试

我们使用exactly模式的镜像,因为集群节点数量为3,因此镜像数量就设置为2.

运行下面的命令进入mq1容器内部:

docker exec -it mq1 bash

然后配置镜像模式:

rabbitmqctl set_policy ha-two "^two\." '{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}'

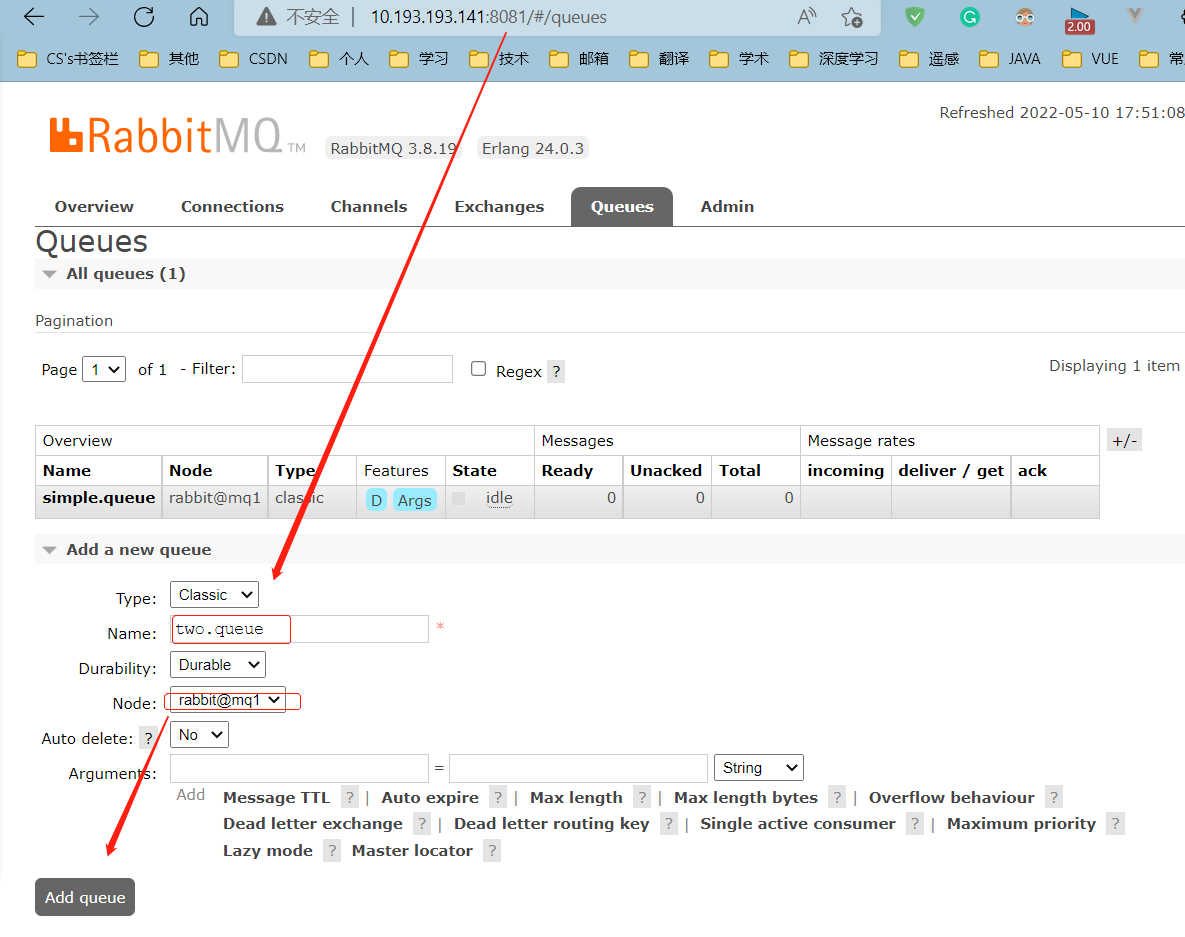

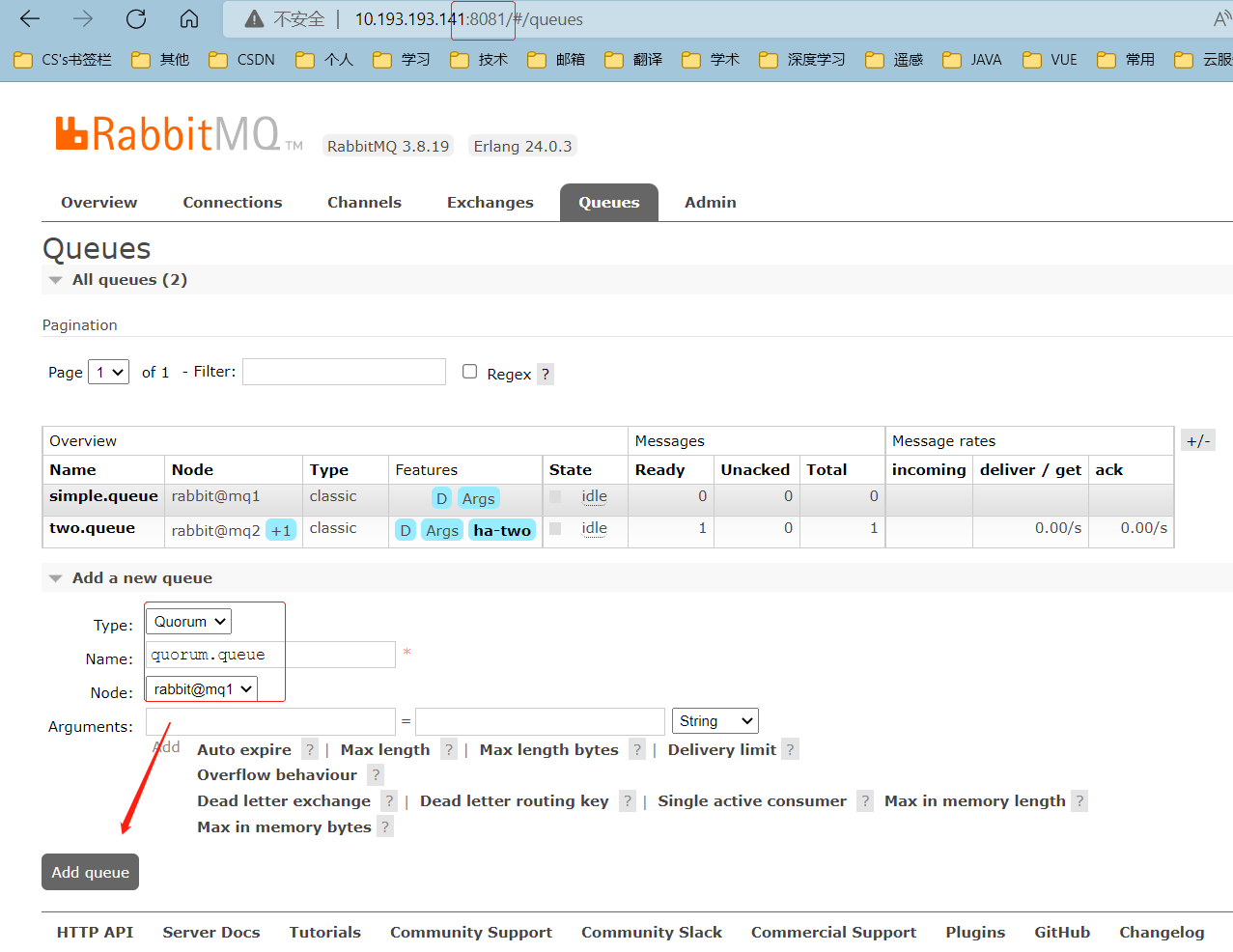

下面,在mq1上创建一个新的队列:

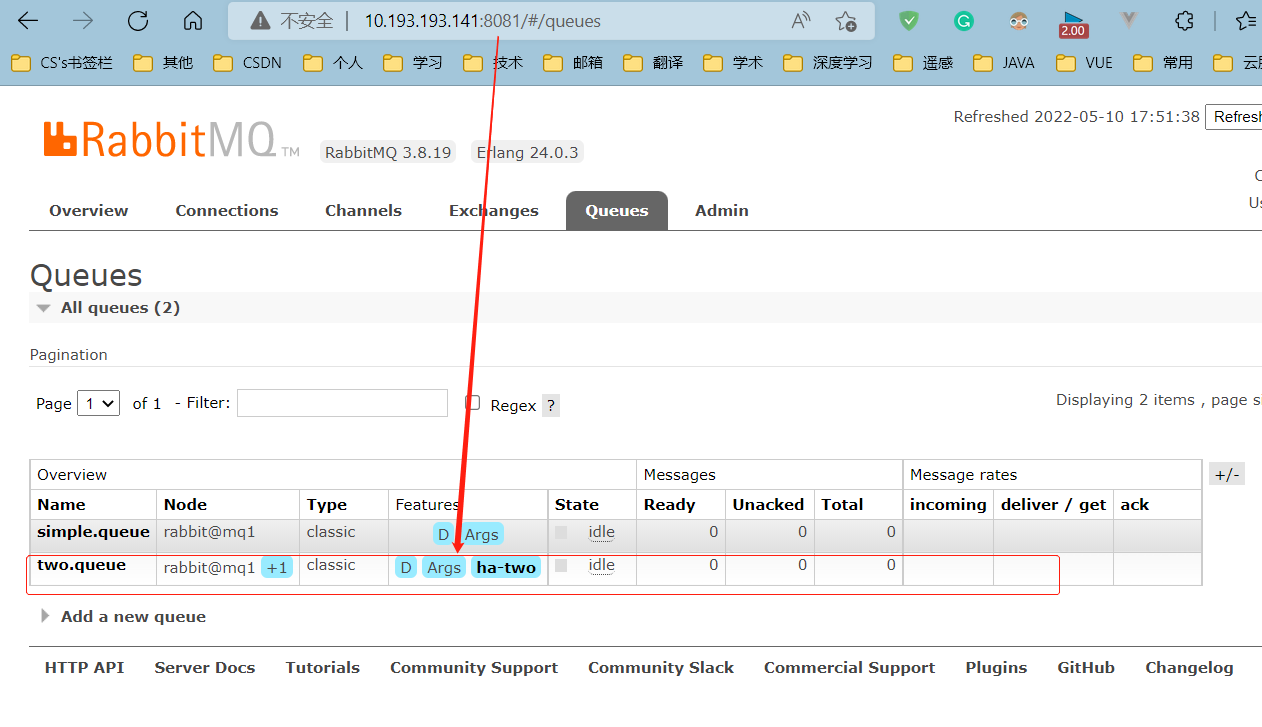

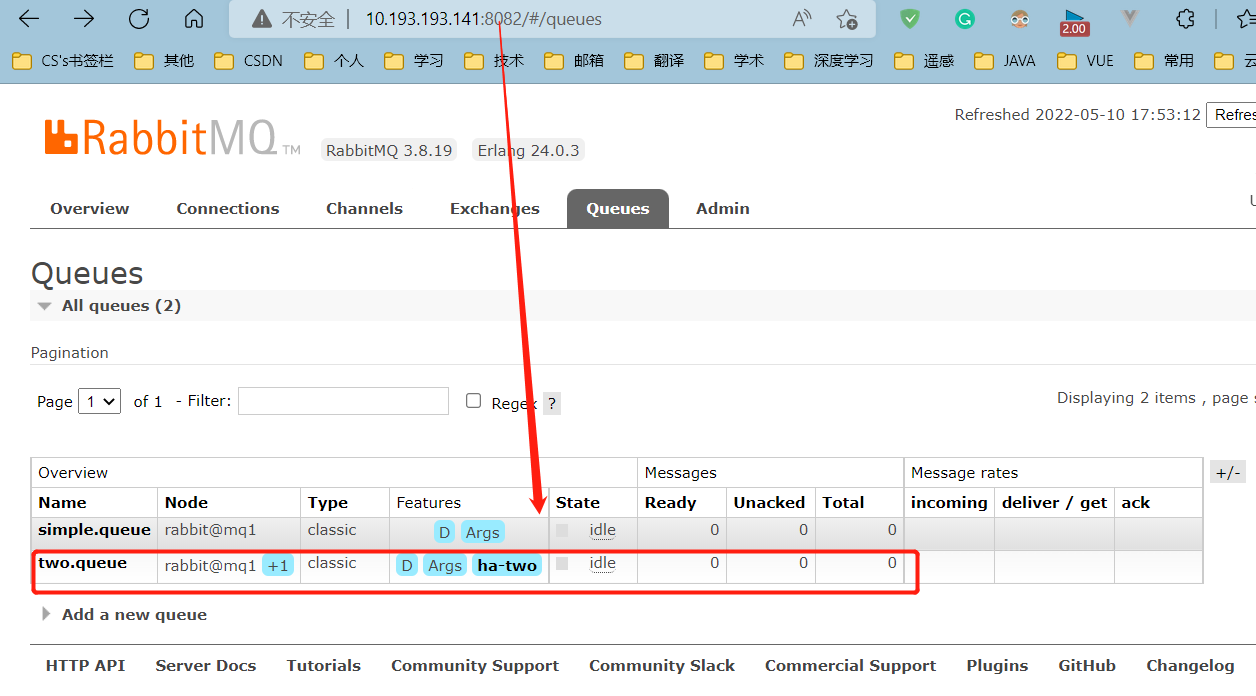

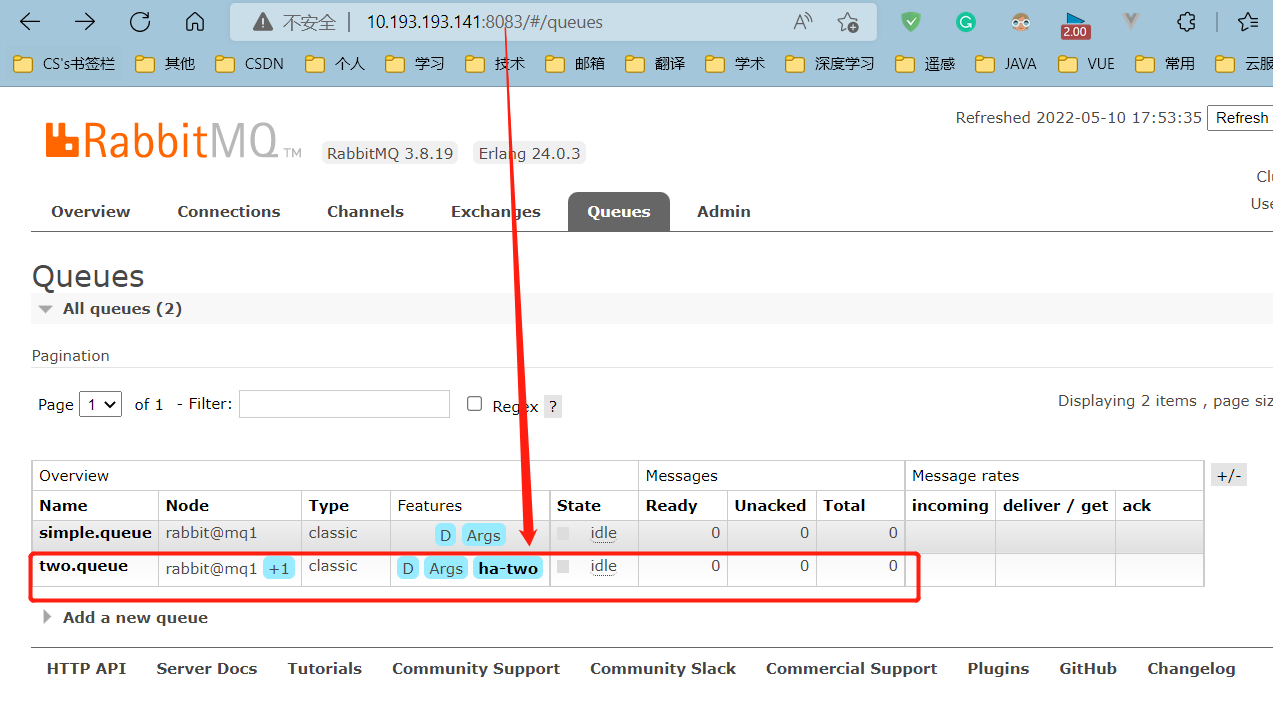

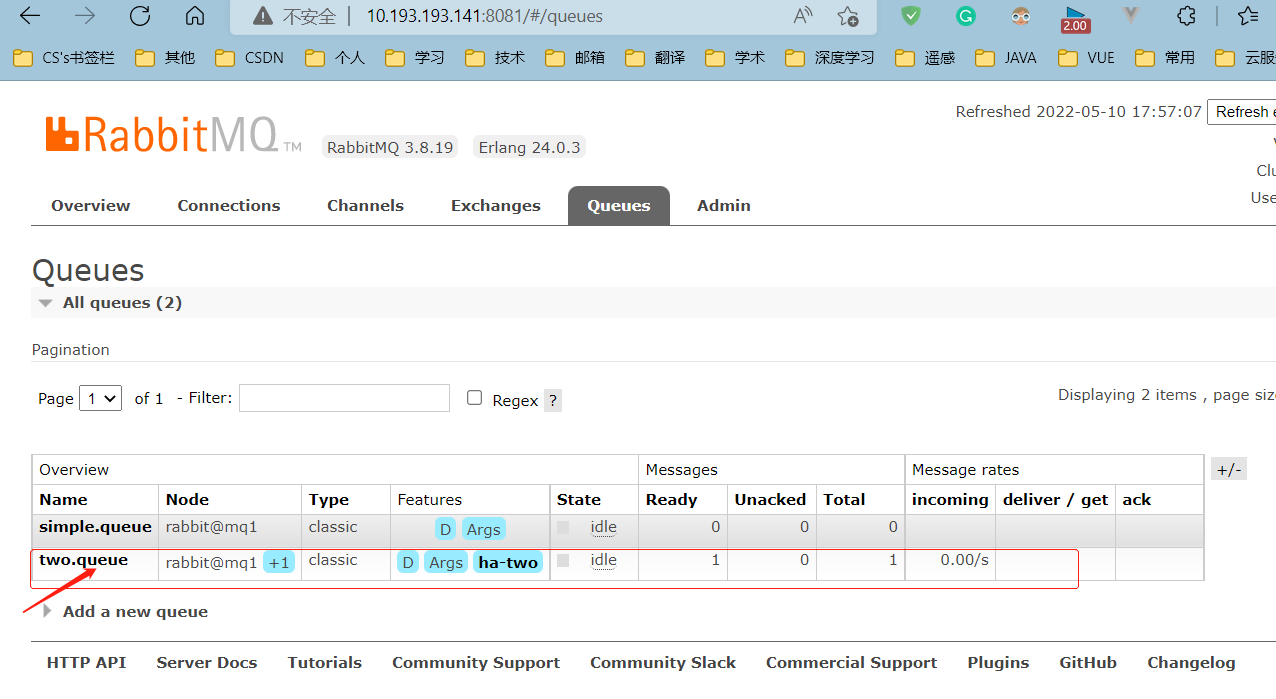

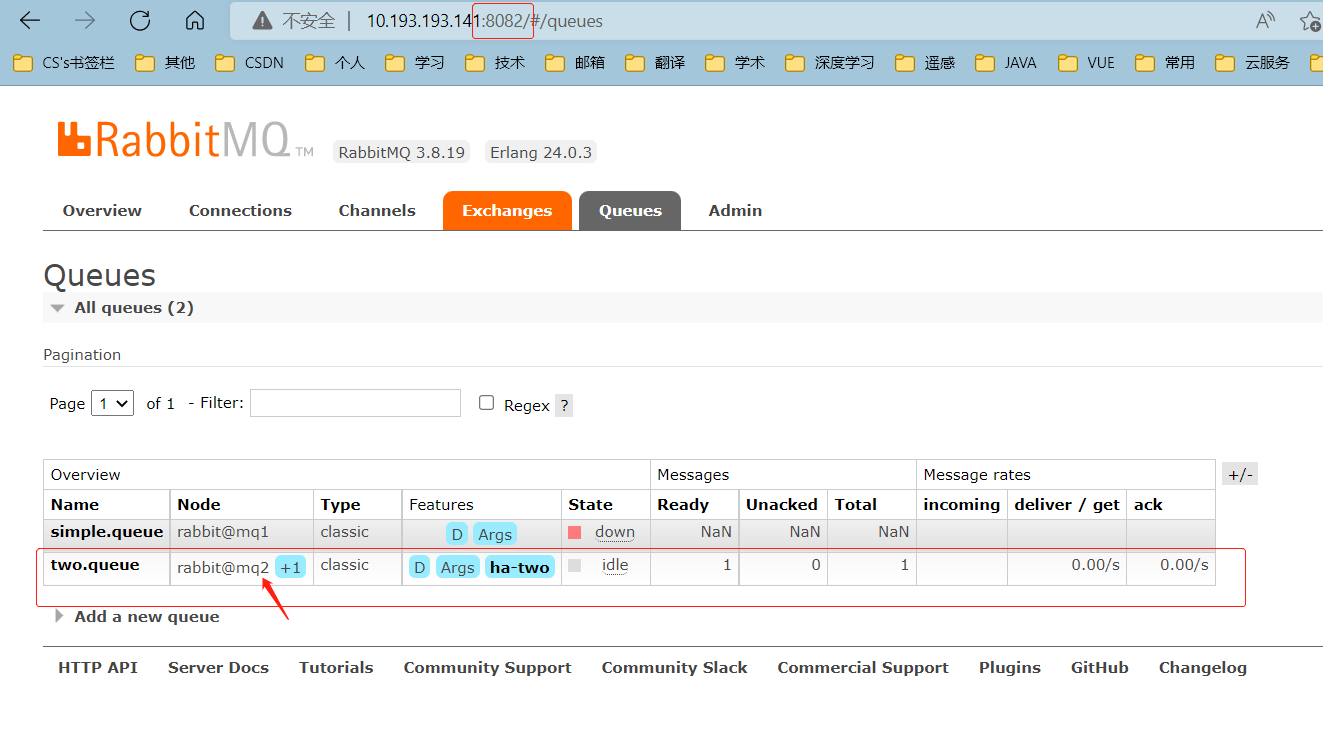

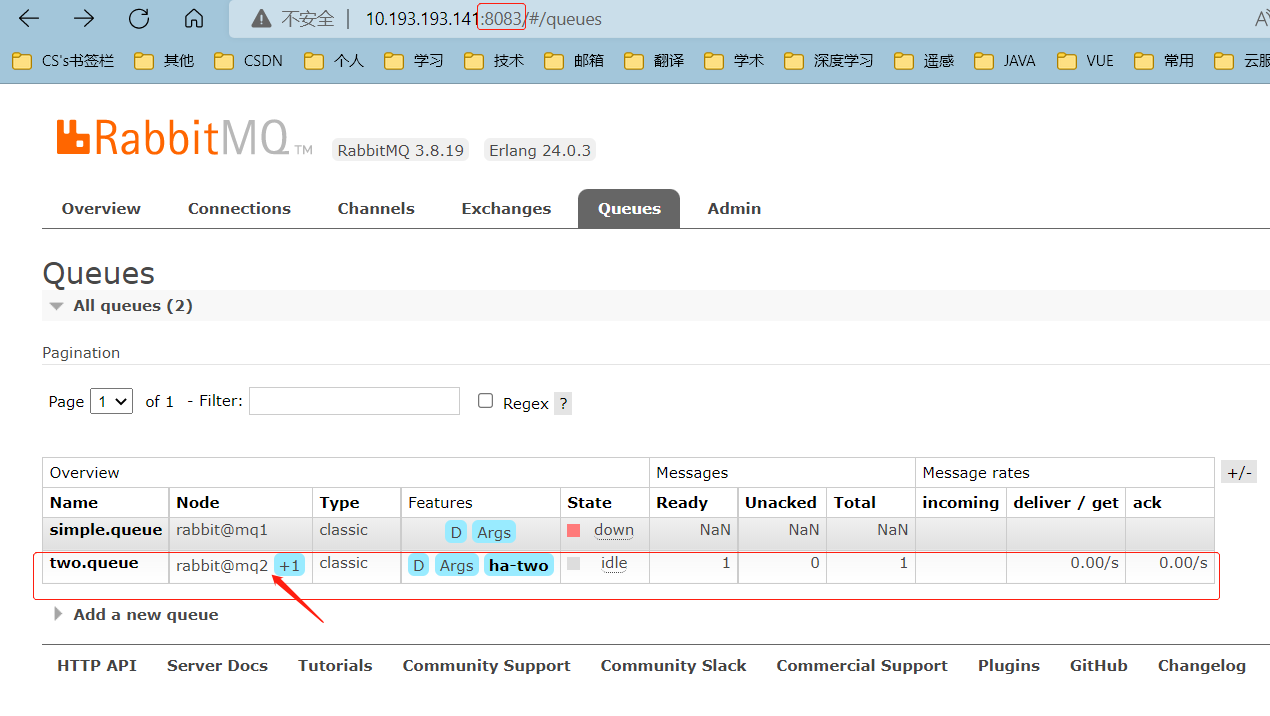

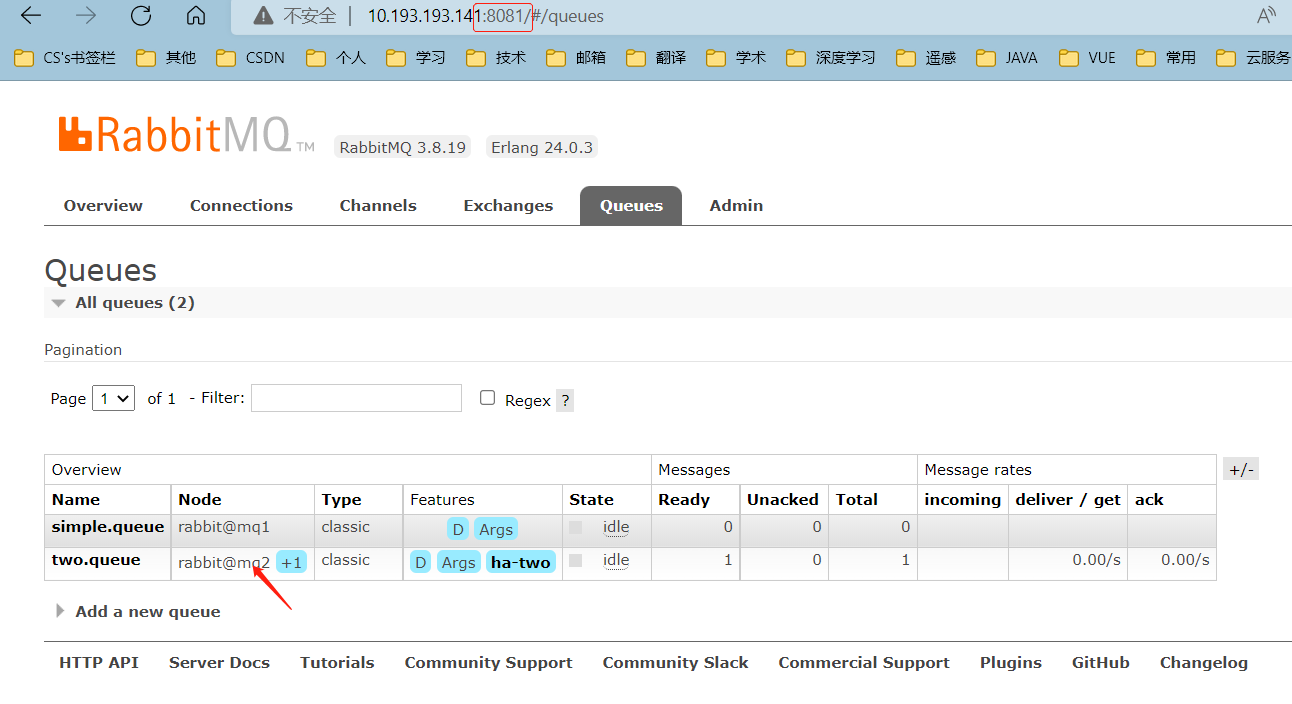

在任意一个mq控制台查看队列:

3.4.1 数据共享测试

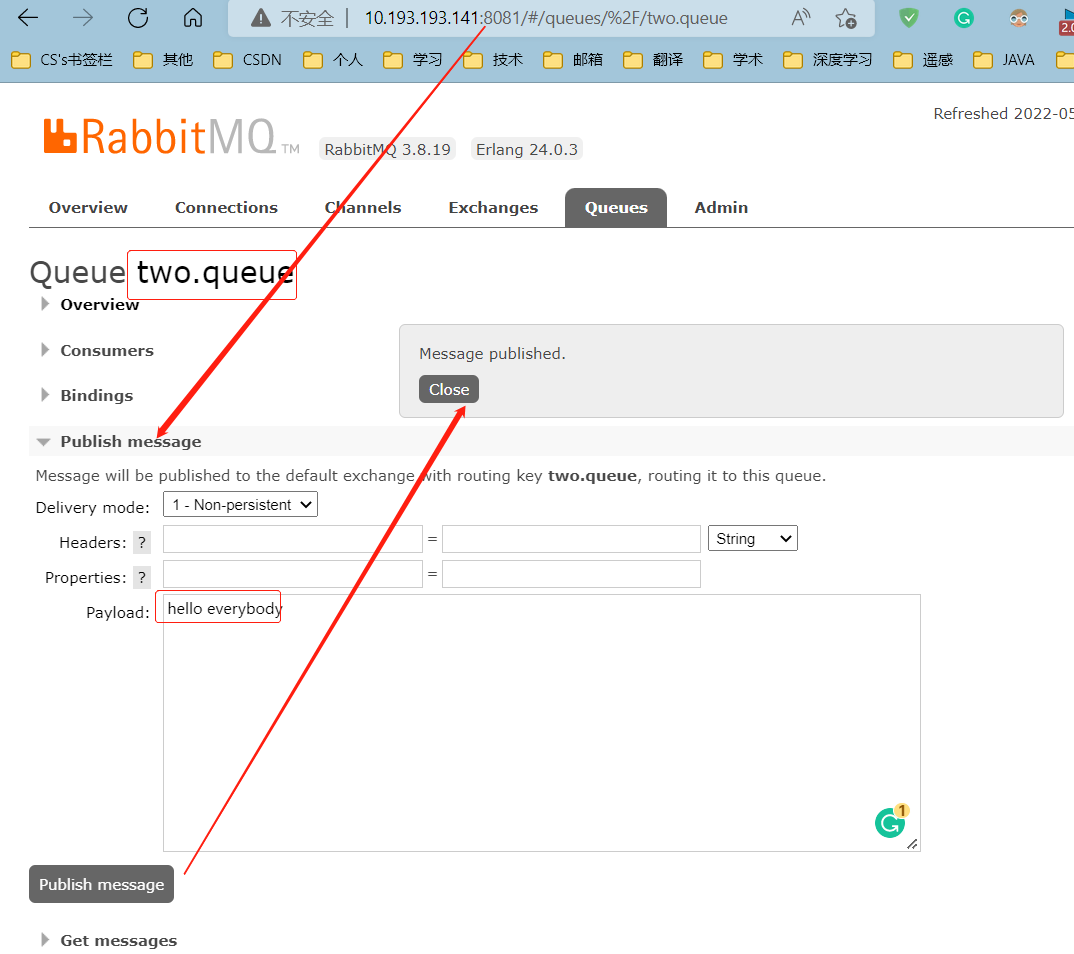

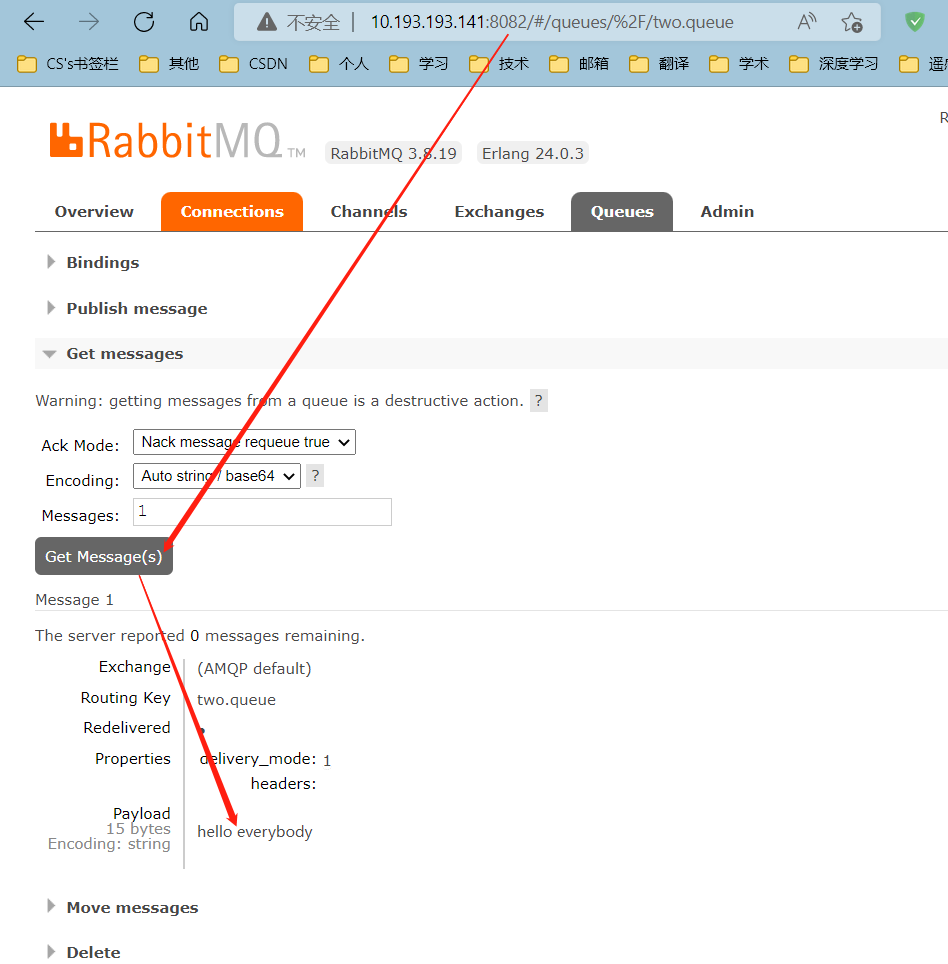

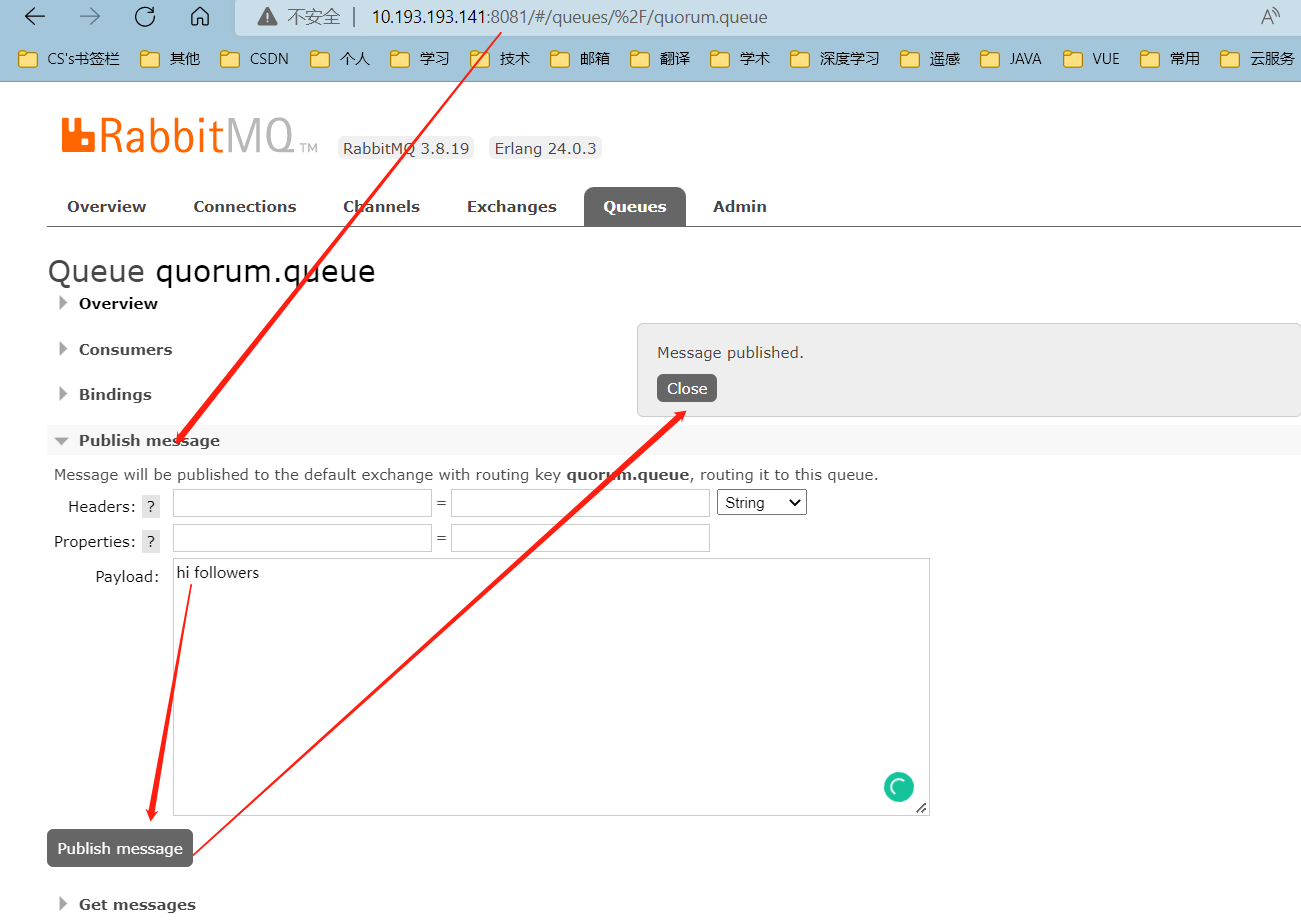

在mq1中给two.queue发送一条消息:

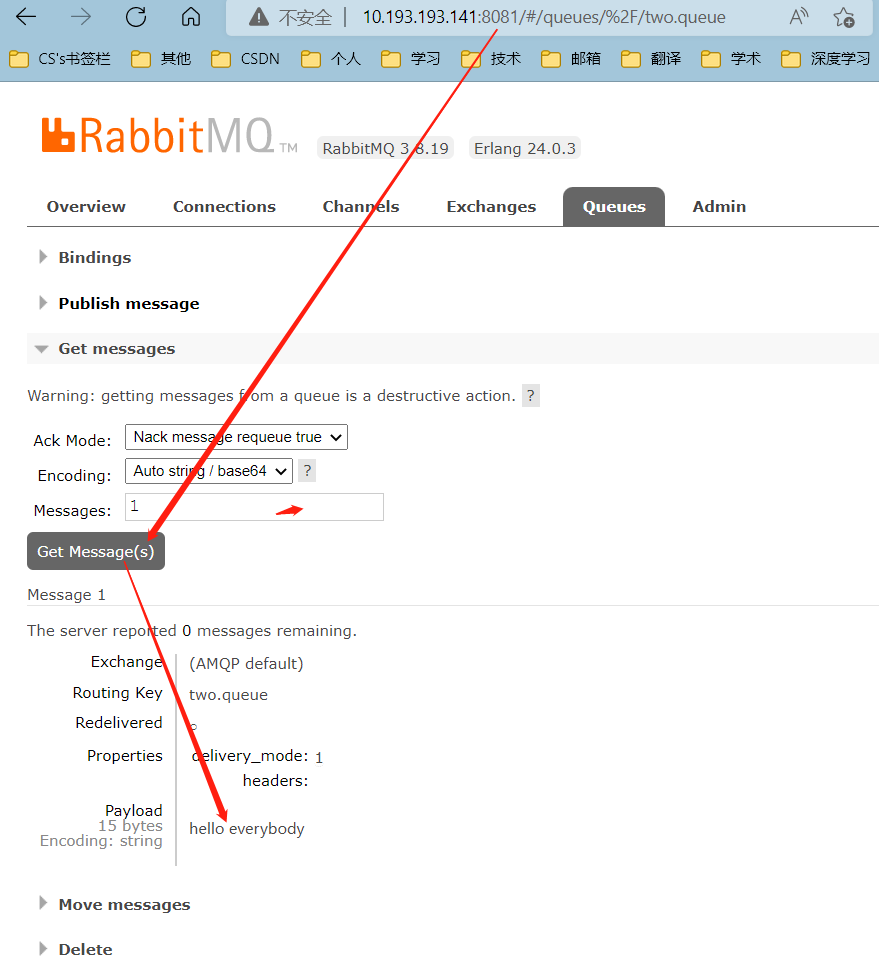

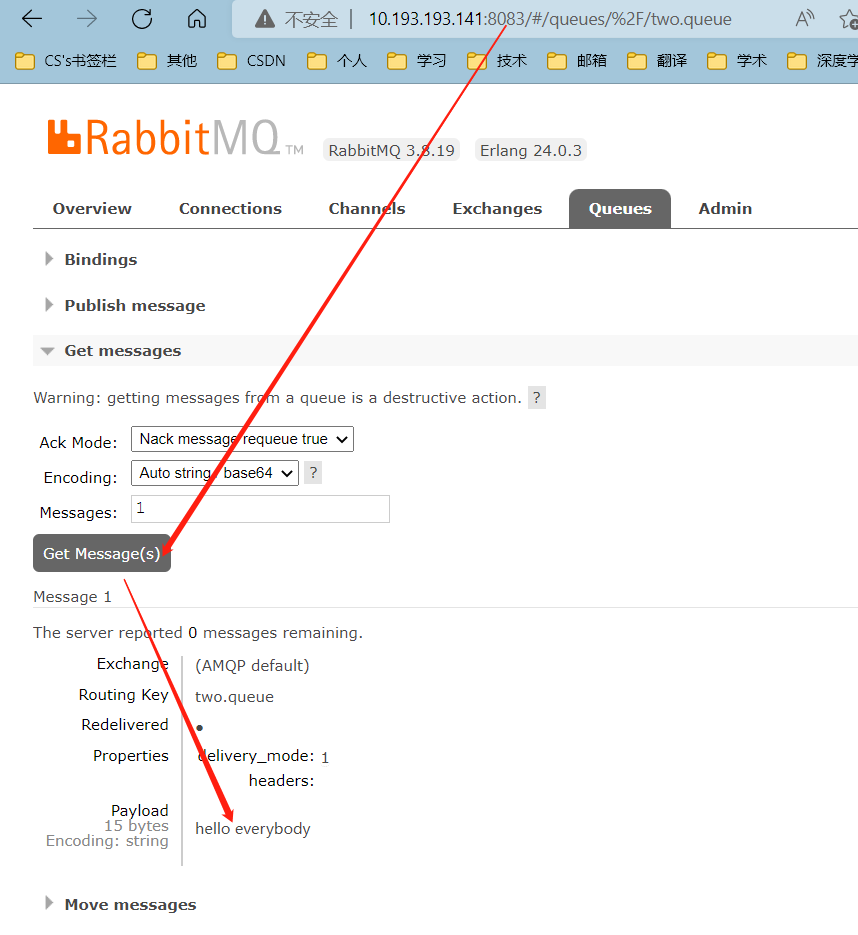

然后在mq1、mq2、mq3的任意控制台查看消息:

3.4.2 高可用测试

现在,我们让two.queue的主节点mq1宕机:

docker stop mq1

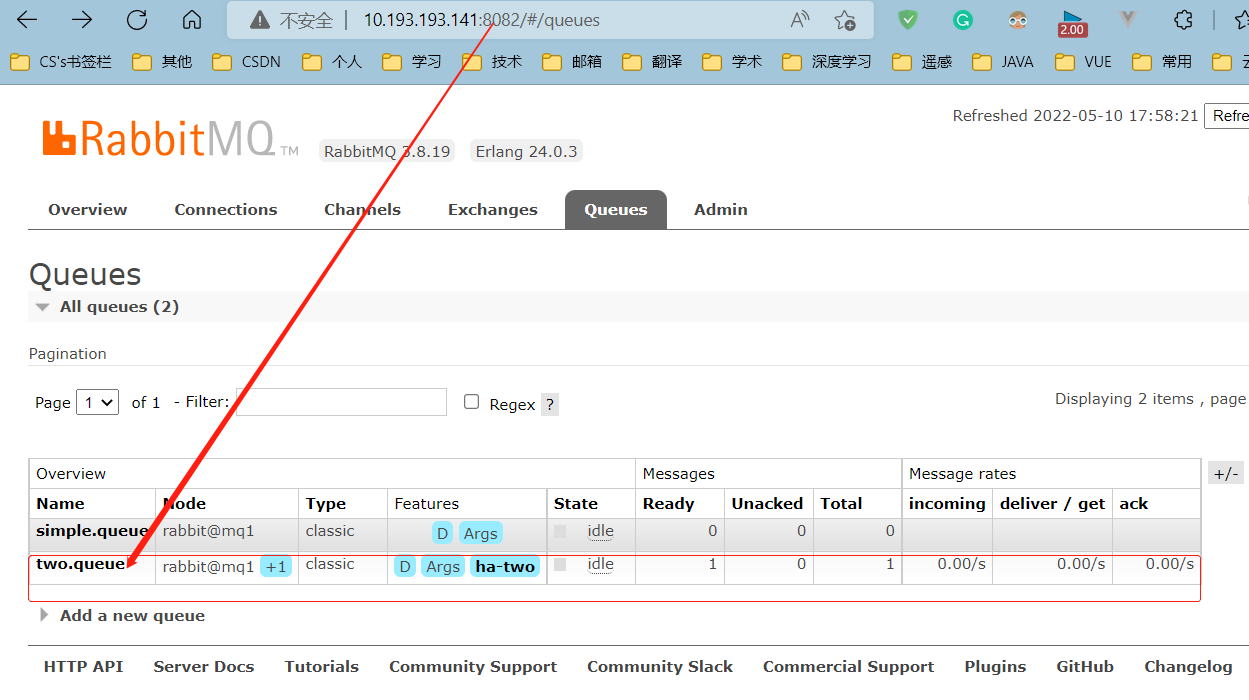

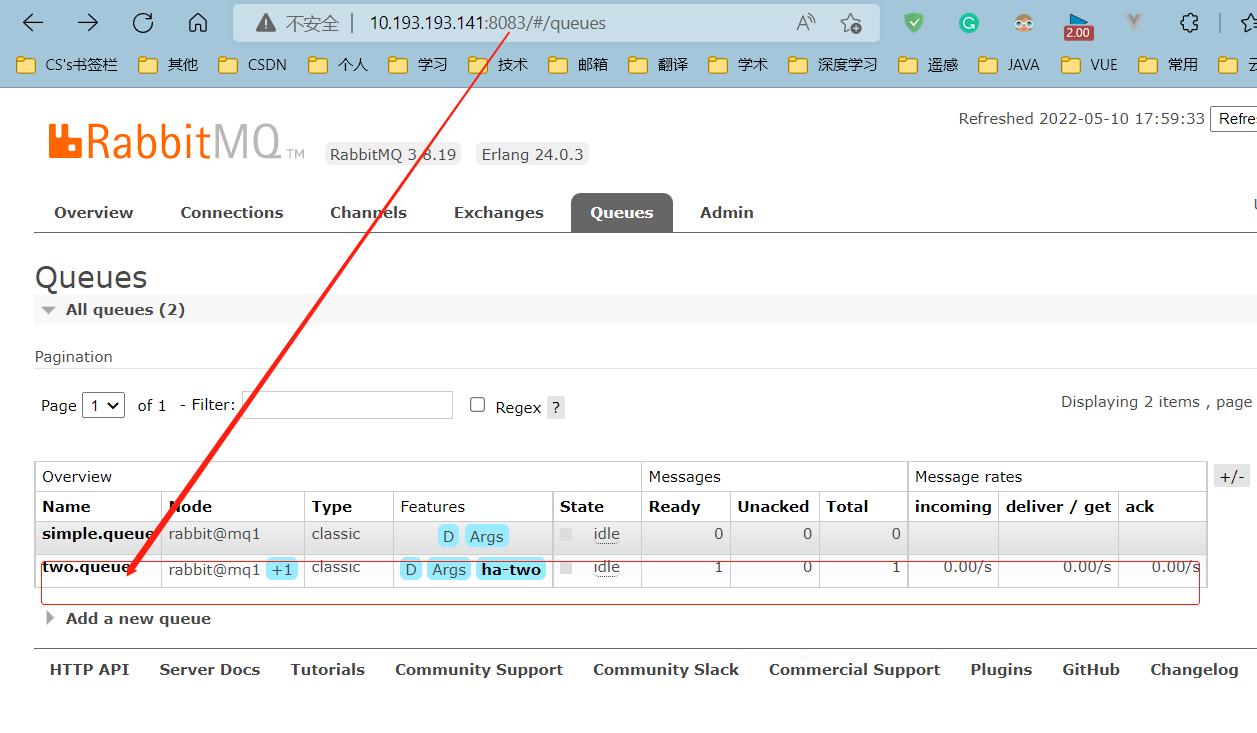

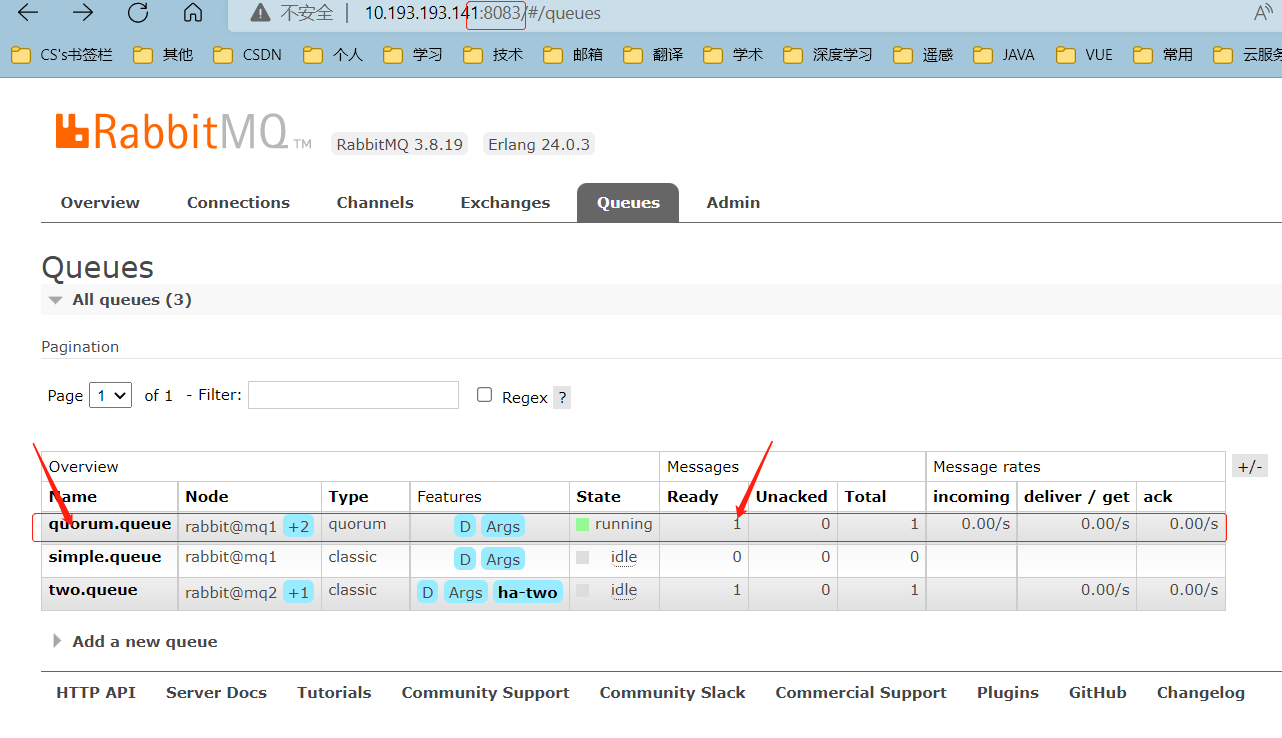

查看集群状态:

查看队列状态:

发现依然是健康的!并且其主节点切换到了rabbit@mq2上

现在,再来重启mq1

可以发现,two.queue的主机仍是mq2,已与mq1无关

4. 仲裁队列

4.1 集群结构和特征

仲裁队列:仲裁队列是3.8版本以后才有的新功能,用来替代镜像队列。

具备下列特征:

- 与镜像队列一样,都是主从模式,支持主从数据同步

- 使用非常简单,没有复杂的配置

- 主从同步基于Raft协议,强一致

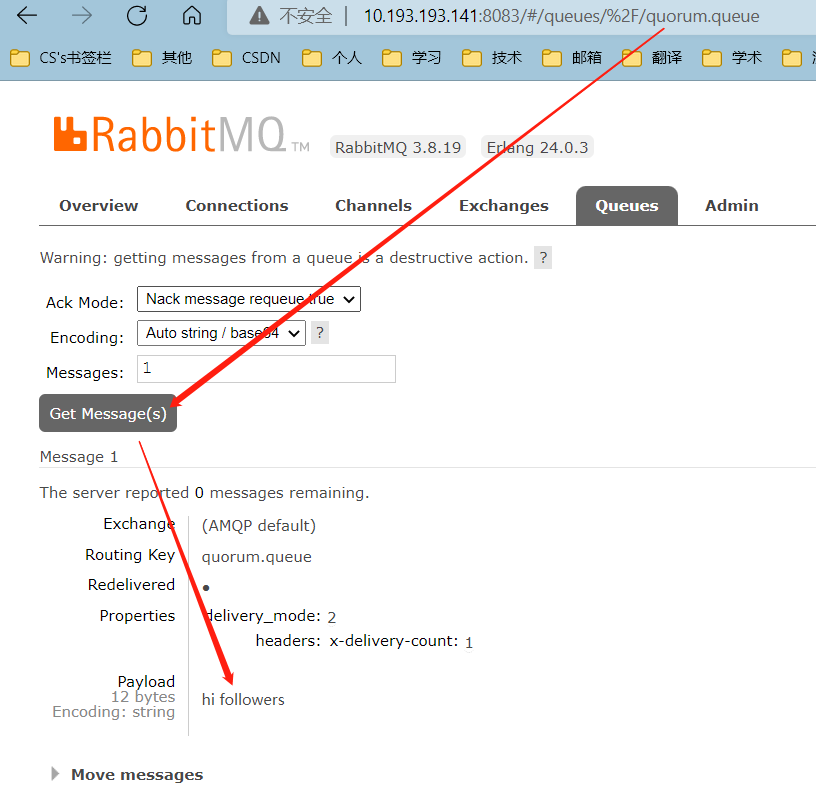

4.2 控制台手动添加仲裁队列

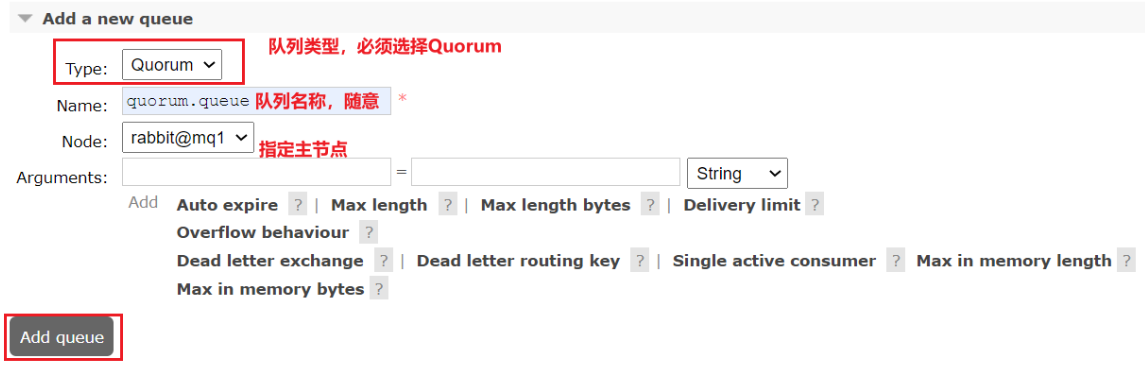

在任意控制台添加一个队列,一定要选择队列类型为Quorum类型。

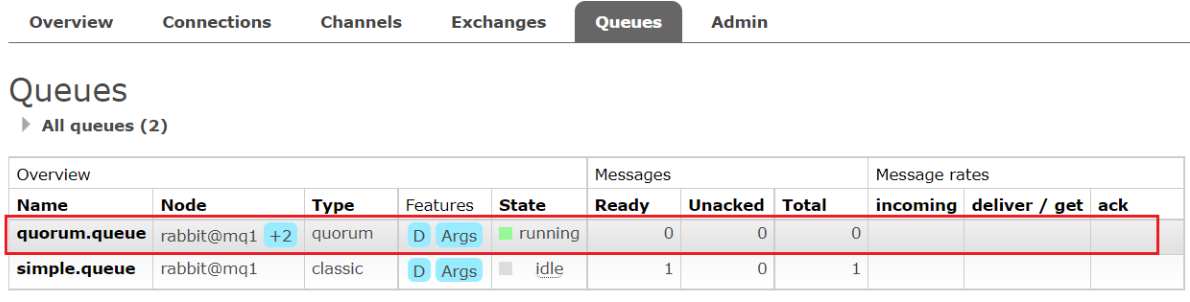

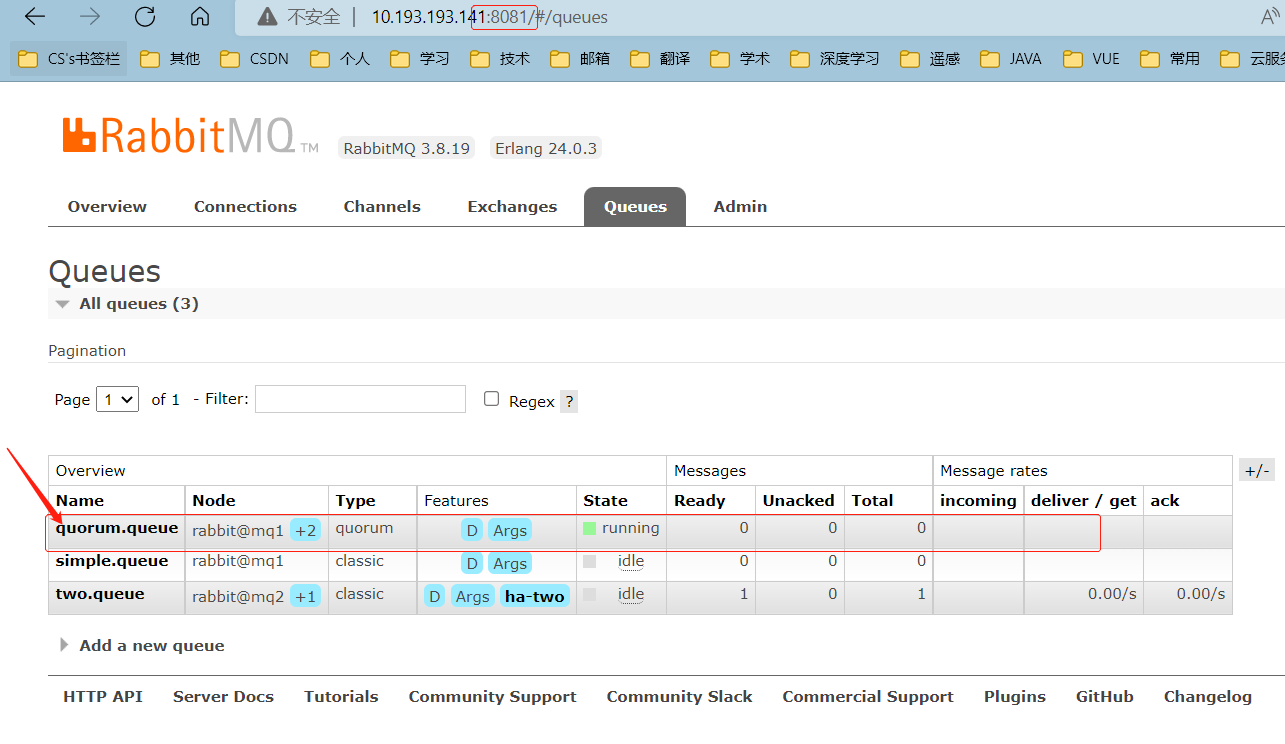

在任意控制台查看队列:

可以看到,仲裁队列的 + 2字样。代表这个队列有2个镜像节点。

因为仲裁队列默认的镜像数为5。如果你的集群有7个节点,那么镜像数肯定是5;而我们集群只有3个节点,因此镜像数量就是3。

4.3 Java处理仲裁队列

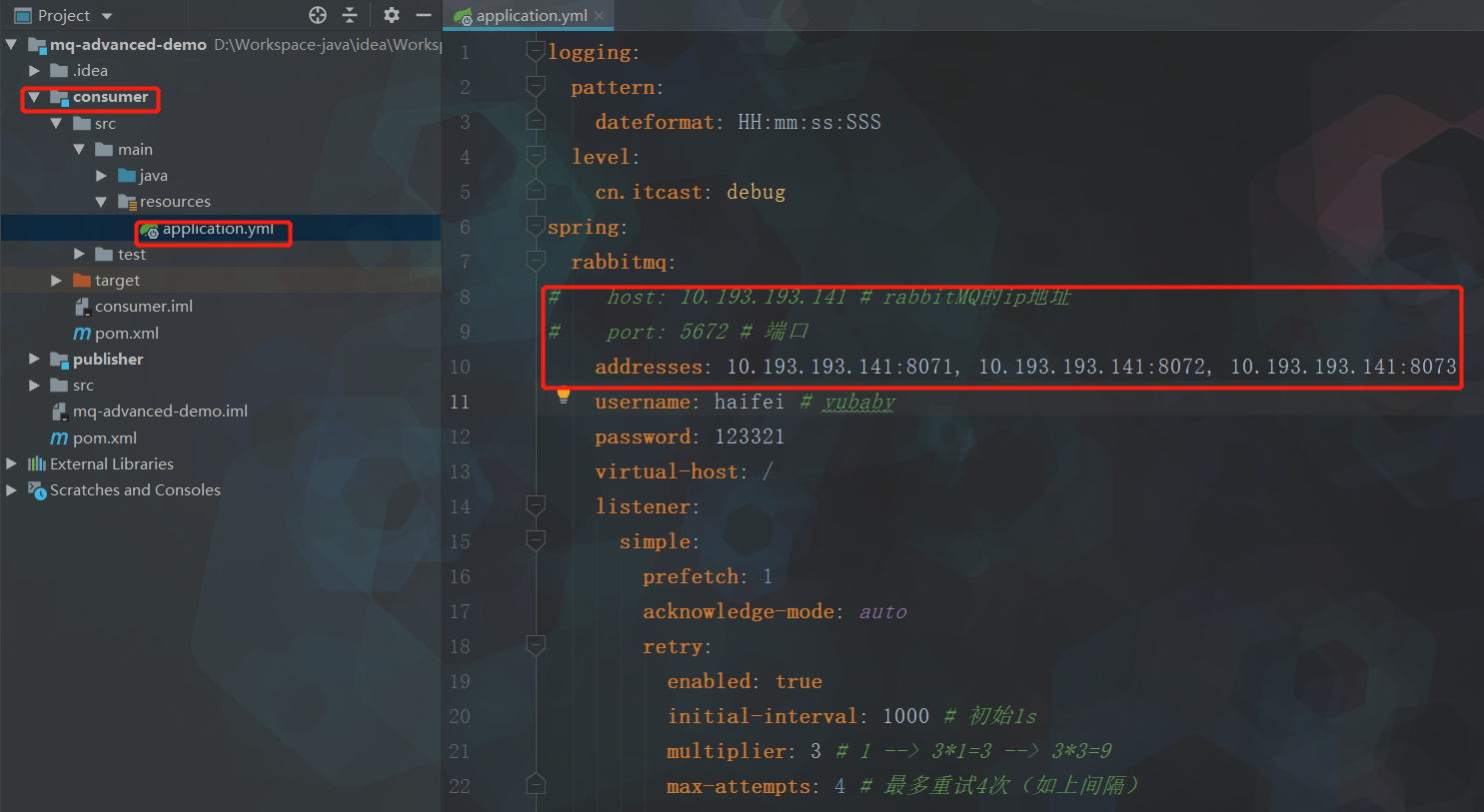

4.3.1 SpringAMQP连接MQ集群

注意,yaml这里用address来代替host、port方式

spring:

rabbitmq:

addresses: 10.193.193.141:8071, 10.193.193.141:8072, 10.193.193.141:8073

username: haifei

password: 123321

virtual-host: /

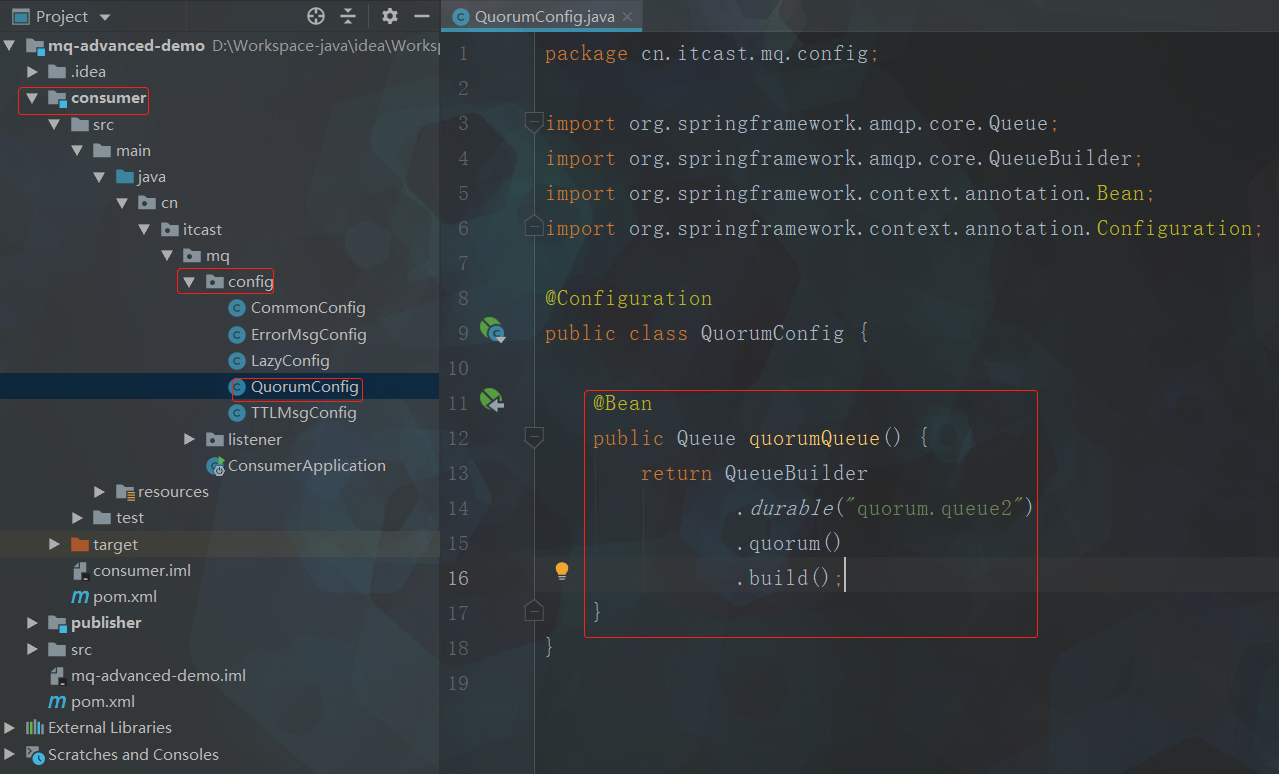

4.3.2 SpringAMQP创建仲裁队列

@Bean

public Queue quorumQueue() {

return QueueBuilder

.durable("quorum.queue") // 持久化

.quorum() // 仲裁队列

.build();

}

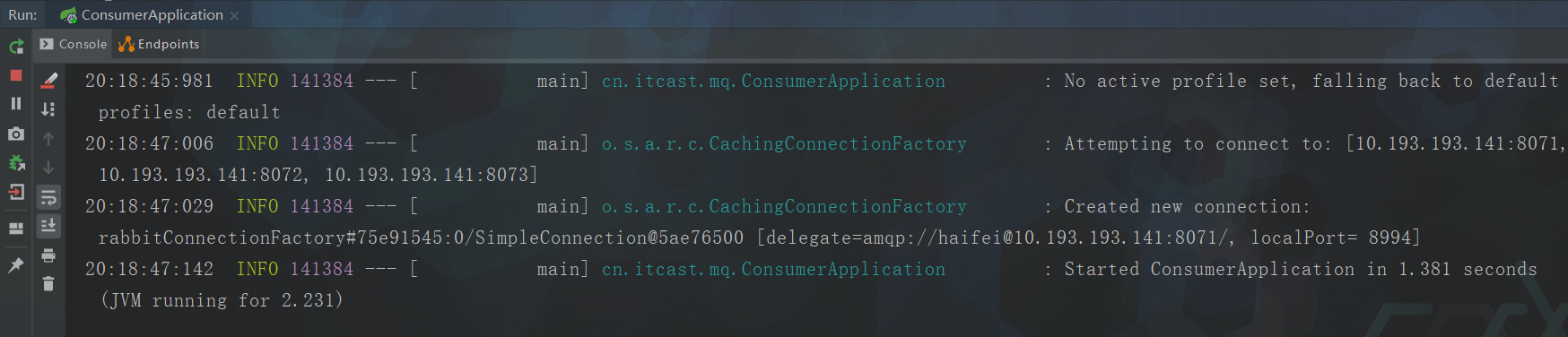

4.3.3 测试

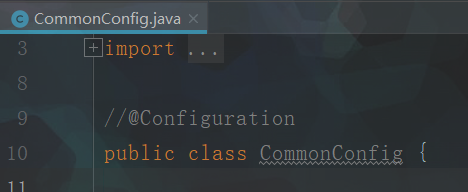

考虑到目前为mq集群模式,consumer服务config包下其余配置类都是针对此前单机课程的配置,

倘若当前直接启动consumer服务,难免会报一堆错,

因此,现将除QuorumConfig类之外的其余配置类中的@Configuration注解都先注释掉

并且,令SpringRabbitListener类中只保留istenSimpleQueue(),其余方法先注释掉

package cn.itcast.mq.listener;

import lombok.extern.slf4j.Slf4j;

import org.springframework.amqp.rabbit.annotation.Exchange;

import org.springframework.amqp.rabbit.annotation.Queue;

import org.springframework.amqp.rabbit.annotation.QueueBinding;

import org.springframework.amqp.rabbit.annotation.RabbitListener;

import org.springframework.stereotype.Component;

@Slf4j

@Component

public class SpringRabbitListener {

@RabbitListener(queues = "simple.queue")

public void listenSimpleQueue(String msg) {

System.out.println("消费者接收到simple.queue的消息:【" + msg + "】");

}

/*@RabbitListener(queues = "simple.queue")

public void listenSimpleQueue(String msg) {

log.debug("消费者接收到simple.queue的消息:【" + msg + "】");

System.out.println(1/0); //模拟异常:手动错误

log.info("消费者处理消息成功!");

}*/

/*@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "dl.queue", durable = "true"),

exchange = @Exchange(name = "dl.direct"),

key = "dl"

))

public void listenDlQueue(String msg) {

log.debug("消费者接收到dl.queue的延迟消息:{}", msg);

}*/

/*@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "delay.queue", durable = "true"),

exchange = @Exchange(name = "delay.direct", delayed = "true"),

key = "delay"

))

public void listenDelayQueue(String msg) {

log.debug("消费者接收到delay.queue的延迟消息:{}", msg);

}*/

}

启动consumer服务

PS:创建队列是如上操作;发送消息跟此前学的一样,再次不再演示

4.4 集群扩容(扩展|未讲)

4.4.1 加入集群

1)启动一个新的MQ容器:

docker run -d --net mq-net \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=itcast \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq4 \

--hostname mq5 \

-p 8074:15672 \

-p 8084:15672 \

rabbitmq:3.8-management

2)进入容器控制台:

docker exec -it mq4 bash

3)停止mq进程

rabbitmqctl stop_app

4)重置RabbitMQ中的数据:

rabbitmqctl reset

5)加入mq1:

rabbitmqctl join_cluster rabbit@mq1

6)再次启动mq进程

rabbitmqctl start_app

4.4.2 增加仲裁队列副本

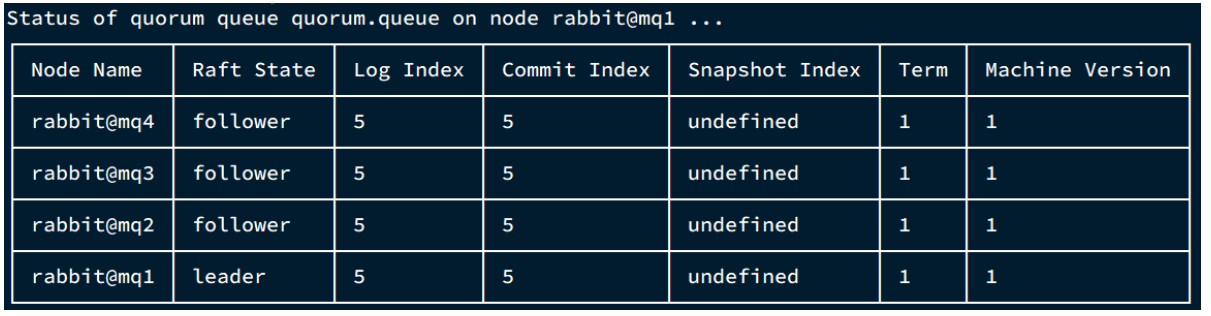

我们先查看下quorum.queue这个队列目前的副本情况,进入mq1容器:

docker exec -it mq1 bash

执行命令:

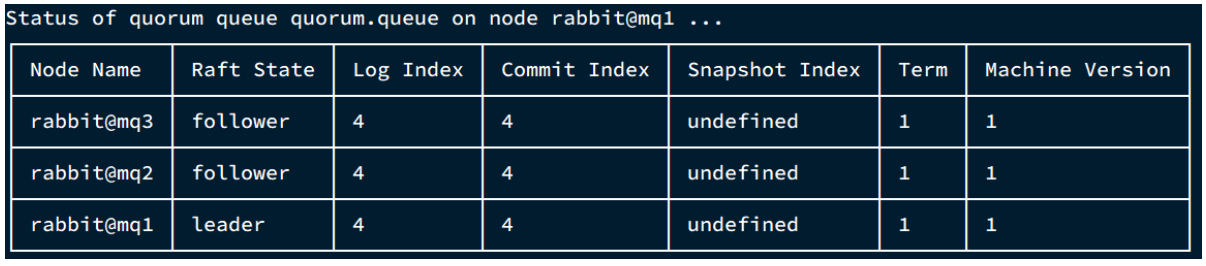

rabbitmq-queues quorum_status "quorum.queue"

结果:

现在,我们让mq4也加入进来:

rabbitmq-queues add_member "quorum.queue" "rabbit@mq4"

结果:

再次查看:

rabbitmq-queues quorum_status "quorum.queue"

查看控制台,发现quorum.queue的镜像数量也从原来的 +2 变成了 +3:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!

2021-05-10 16.4【STL案例1-评委打分】