Hadoop 配置hbase

首先要启动hadoop

start-dfs.sh

start-yarn.sh

查看一下自己的hadoop版本,确保自己下载的hbase与自己的hadoop版本匹配

hadoop version

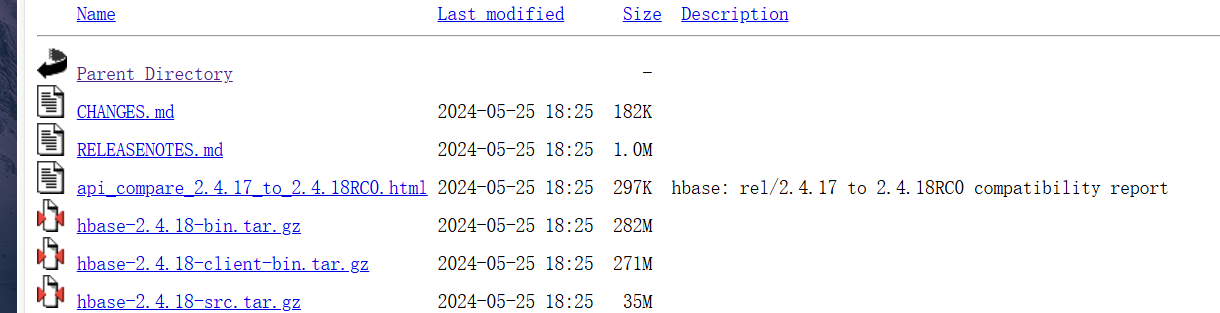

Index of /apache/hbase (tsinghua.edu.cn) 下载hbase

选择倒数第三个下载

下载完成后 进入 /export/server/ 上传压缩包后 完成解压 重命名操作

1 2 3 | tar -xzf hbase-2.4.18-bin.tar.gz mv hbase-2.4.18 hbase |

接下来配置系统变量 将hbase下的bin目录添加到path中

vi /etc/profile 添加 export PATH=$PATH:/export/server/hbase/bin 保存配置 source /etc/profile

1 2 | 检查hbase是否安装成功 成功后会显示版本号/export/server/hbase/bin/hbase version |

配置hbase-env.sh

1 2 3 4 5 6 7 | vi /export/server/hbase/connf/hbase-env.sh添加 export JAVA_HOME=/export/server/JDKexport HBASE_CLASSPATH=/export/server/hbase/confexport HBASE_MANAGES_ZK=true |

配置hbase-site.xml

vi /export/server/hbase/conf/hbase-site.xml

添加下面代码

<property> <name>hbase.rootdir</name> <value>hdfs://localhost:9000/hbase</value> </property><property> <name>hbase.cluster.distributed</name> <value>true</value> </property>

这个

core-site.xml

$HADOOP_HOME/etc/hadoop/

fs.defaultFS

接下来进入 shell

hbase shell

接下来进入 shell

hbase shell

SLF4J: Found binding in [jar:file:/usr/local/hadoop/share/hadoop/common/lib/slf4j-reload4j-1.7.35.jar!/org/slf4j/impl/StaticLoggerBinder.class] SLF4J: Found binding in [jar:file:/usr/local/hbase/lib/client-facing-thirdparty/slf4j-reload4j-1.7.33.jar!/org/slf4j/impl/StaticLoggerBinder.class]

如果出现这个错误

需要将这个jar包 删除一个

后面就可以使用命令了

在我看的教程中,还会出现几个错误,但是我没有遇到,所有就不说明了,后面有我看的教程链接。

我遇到了一个教程中没有的错误。启动成功后,还是报错,显示没有启动成功

需要在 hbase/conf/hbase-env.sh中添加

export HBASE_DISABLE_HADOOP_CLASSPATH_LOOKUP=true

重新启动hdfs、hbase,问题解决

如果启动失败 可能是hadoop处于安全模式

输入 hdfs dfsadmin -safemode forceExit 退出安全模式

重新启动 hadoop hbase 进入shell 可以实现建表语句

教程链接Hadoop之Hbase安装和配置_hadoop之hbase的安装与配置-CSDN博客

bug 链接【Bug解决】Hbase 进入shell输入命令list报错:Server is not running yet-CSDN博客

希望大家都可以配置好hbase

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix