【cs231n】lecture 5 课程笔记

课程5 卷积神经网络

key: CNN 卷积核(滤波器)

卷积神经网络 Convolutional Neural Networks

1.一点历史:从马克一号(1957)开始出现感知计算机,有了激活函数的思想;到1960出现多层,至1986第一次反向传播开始流行,2006年有 再激活 研究在深度学习中;2012年出现重大结果,用在语言识别

2.一点迁移:对大脑的研究也符合规律,也是不同层次的反应与感知;1980出现认知神经机;2012出现AlexNet网络

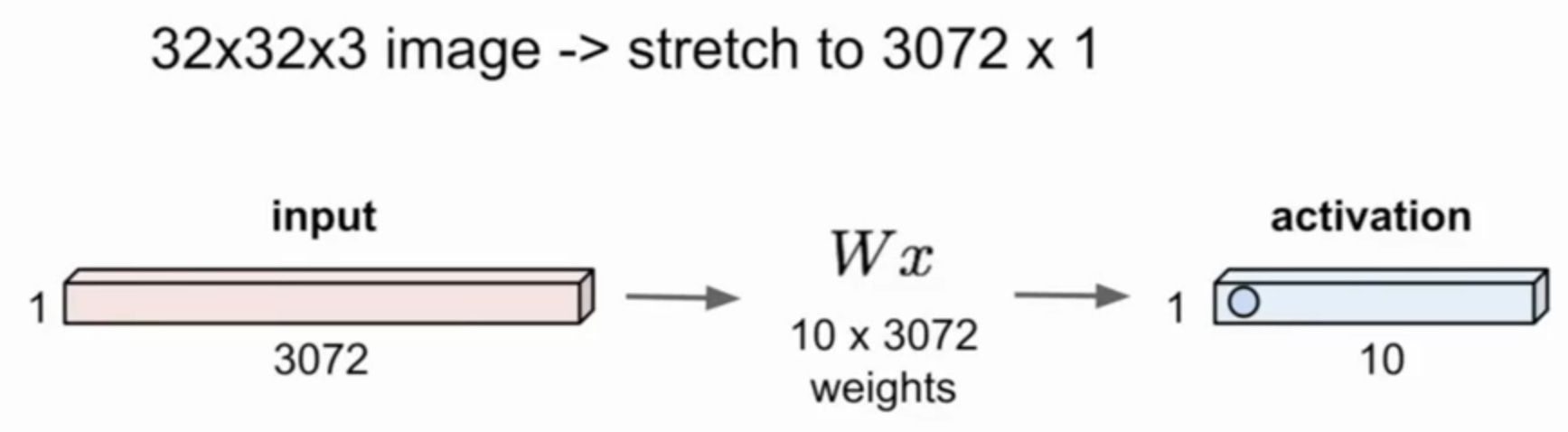

3.全连接层:把输入拉成一维的向量,与权重矩阵作用,得到激活值(一维向量)

- 作用:将卷积层得到的feature map(特征图or特征映射)通过矩阵运算,得到十个数,对应到十个类上(举例),值只会是0 or 1,且只有一个1(与训练集有关);或者,有不同的值,对应于复杂概念的受激程度

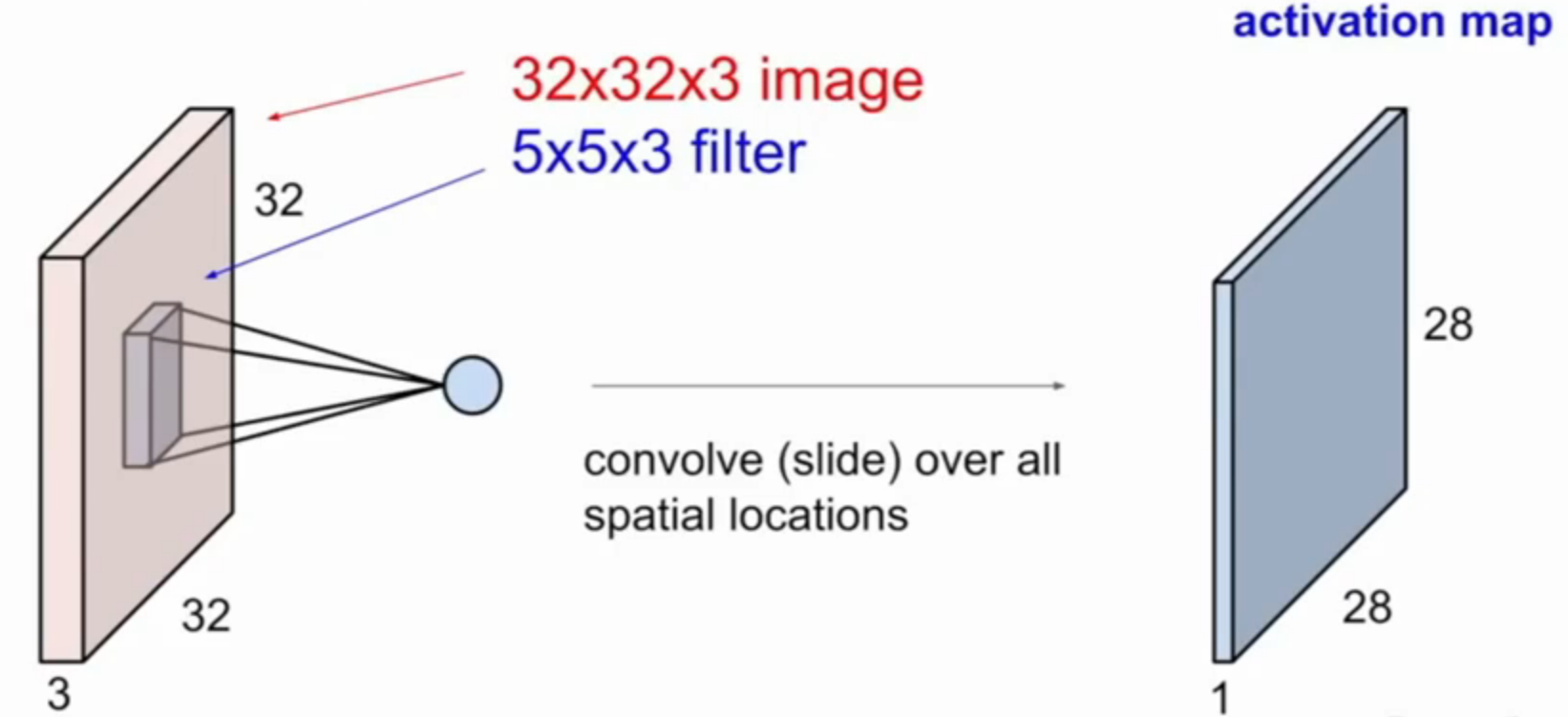

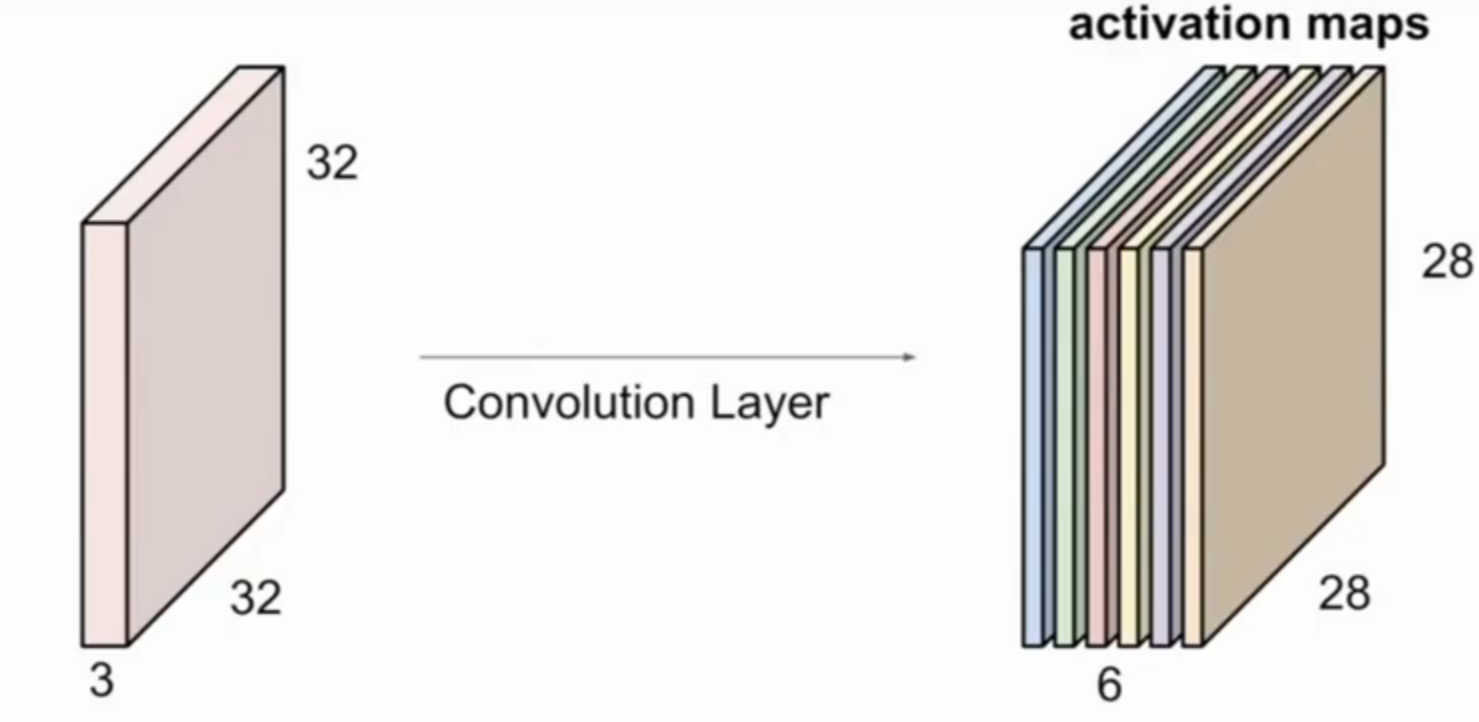

4.卷积层:保留空间结构,权重变成小的卷积核,将卷积核在输入上滑动(做点积),每次得一个值(对应空间位置的数相乘,全部相加),形成激活映射;对于28,步长为1,(32-5)/1 + 1 = 28(见下)

-

如果有更多不同的卷积核,可以得到多个激活映射

![image]()

-

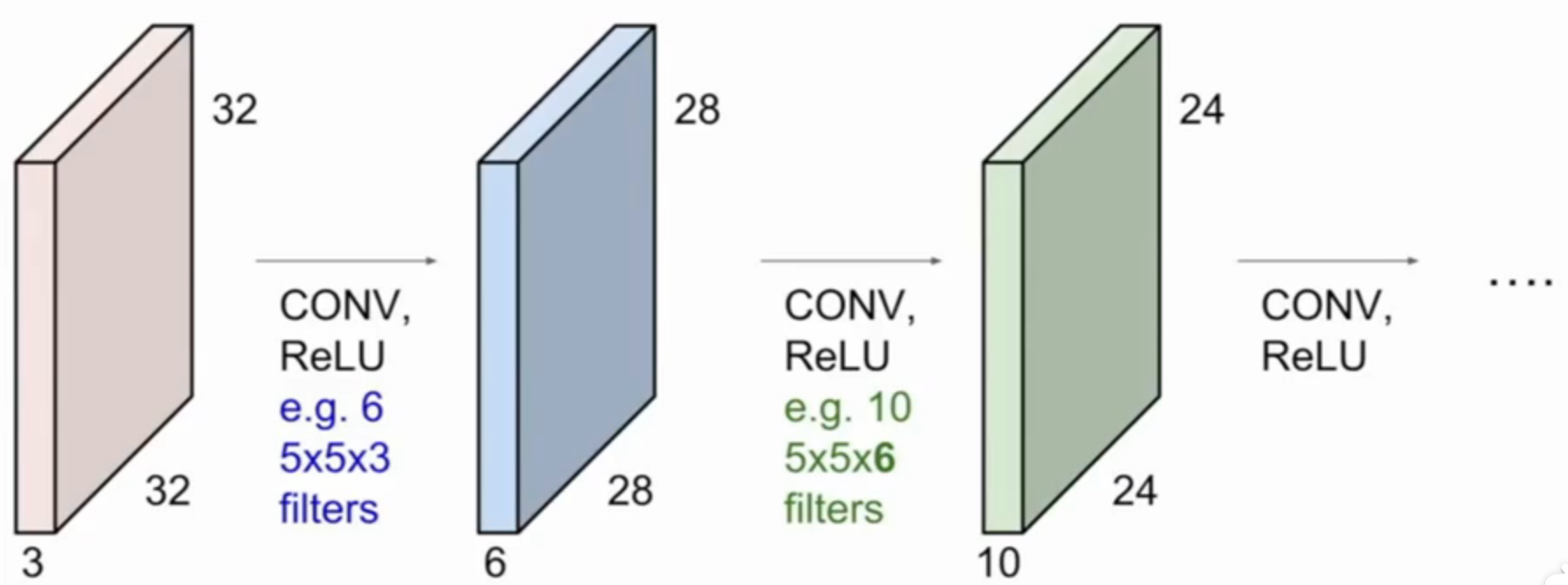

CNN就是一系列的卷积层,每一层由不同的卷积核滑动而来,对应提取到的不同的特征

![image]()

-

为什么叫卷积? 因为和两个信号的卷积是相关的(数学上)

-

原理:为了实现非线性,并没有确切的理论(玄学)

-

神经元视角下:全连接层是每个神经元关注所有输入,卷积层是几个不同的神经元都关注输入的局部区域

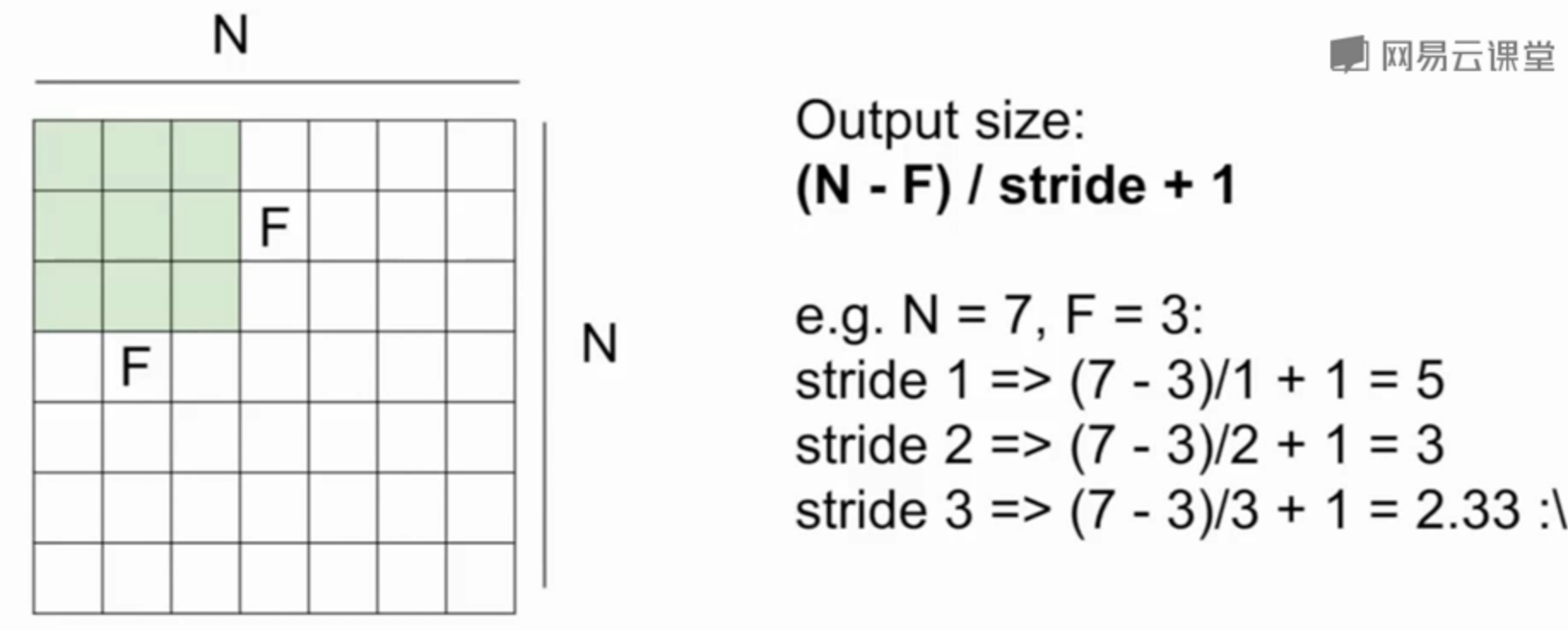

5.步长:不同步长对应不同的结果数

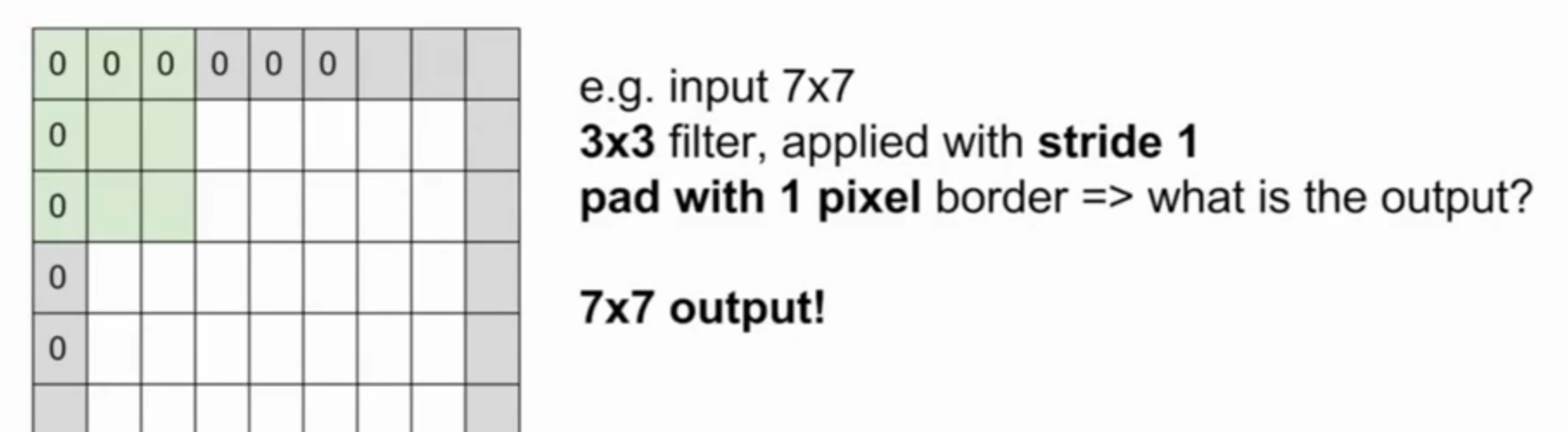

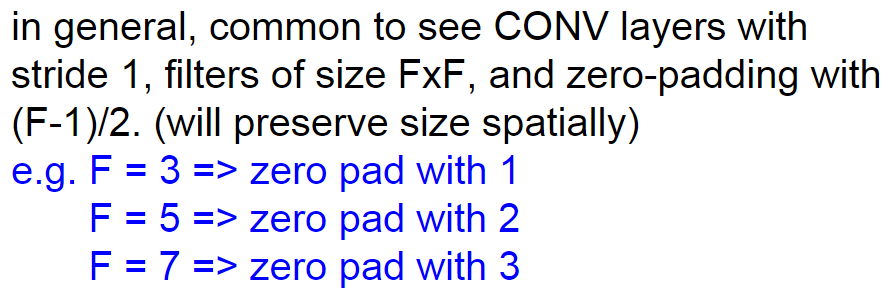

6.零填充:对于无法输出整数(对称)的结果数的情况,在输入外补一圈0

- 作用:为了保证输入图像的大小

![image]()

- 1 * 1 的卷积层:实现通道数下降,再由卷积核数量实现改变通道数量,可以替代全连接层实现分类的映射

小结

这里有一些公式,计算滤波器、输入、输出、步长、填充数相关的,见课件

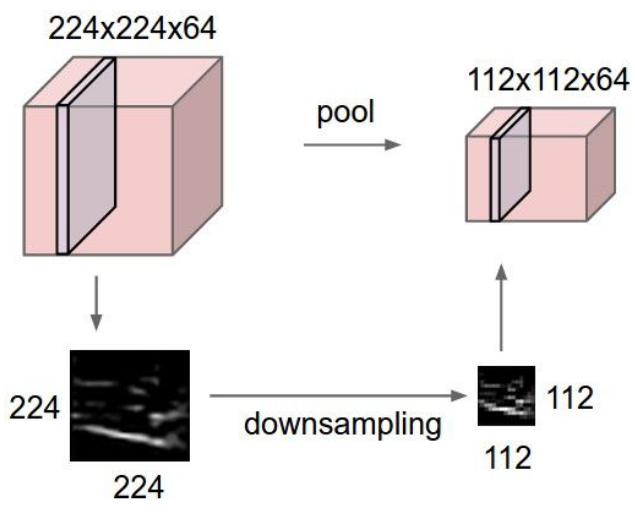

8.池化层:对每一层激活映射独立操作,进行降采样,缩小样本(中间结果)大小,使之更可控

-

最大池化:常用,找到某区域的最大刺激

-

池化也有滤波器,通常会设置步长使之不重叠,一般不填充,做降采样

浙公网安备 33010602011771号

浙公网安备 33010602011771号