机器学习——线性回归模型

# Linear Regression

## 定义

- 回归定义: 通过带标签样本训练构造适当模型并通过该模型算出新样本的预测值

- 线性回归: 基于线性模型的回归学习任务通常称之为线性回归,相应的线性模型称为线性回归模型

- 对于任意给定的样本$X= (x_1, x_2, … , x_𝑚)^𝑇,Y= (y_1, y_2, … , y_𝑚)^𝑇$, 线性回归的初始模型表示为:

$$

𝑓(X) = 𝑤_1𝑥_1 + 𝑤_2𝑥_2 + ··· +𝑤_𝑚𝑥_𝑚

$$

其中$W = (𝑤_1, 𝑤_2, … , 𝑤_𝑚)^𝑇$为参数向量

## 模型求解

给定训练样本$x_1, x_2, … , x_𝑚$,使用最小二乘法,即基于均方误差最小化进行模型求解:

$$

𝒘^∗= \arg min_{w} \sum^n_{i=1}(𝑓(𝒙_𝑖) - 𝑦_𝑖)^2 = \arg min_{w} \sum^n_{i=1}(𝒘^𝑇𝒙_𝑖 - 𝑦_𝑖)^2

$$

则:

$$

𝐽(𝒘) = \sum^n_{i=1}(𝒘^𝑇𝒙_𝑖 - 𝑦_𝑖)^2 = \vert \vert X𝒘 - 𝒚 \vert \vert ^2

$$

令$𝐽(𝒘)$对参数向量$𝒘$各分量的偏导数为0,即:

$$

\frac{\partial J}{\partial w}= X^𝑇(𝐲 - X𝒘 )= 0 \\

\longrightarrow 𝒘 = (X^𝑇X)^{-1}X^𝑇𝐲=X^+Y

$$

这个式子中 $(X^TX)^{-1}X^T$ 又被称为伪逆。对于行满秩或者列满秩的 $X$,可以直接求解,但是对于非满秩的样本集合,需要使用奇异值分解(SVD)的方法,对 $X$ 求奇异值分解,得到

$$

X=U\Sigma V^T \\

X^+=V\Sigma^{-1}U^T

$$

在几何上的解释可以这样说:

- 最小二乘法相当于模型(这里就是直线)和试验值的距离的平方求和。

**分散到每个样本**

- 假设我们的试验样本重构成一个 $p$ 维空间(满秩的情况):$X=Span(x_1,\cdots,x_N)$,而模型可以写成 $f(w)=X \beta$,也就是 $x_1,\cdots,x_N$ 的某种组合,而最小二乘法就是说希望 $Y$ 和这个模型距离越小越好,于是它们的差应该与这个重构的空间垂直:

$$

X^T\cdot(Y-X\beta)=0\longrightarrow\beta=(X^TX)^{-1}X^TY

$$

**分散到每个重构的维度**。这里的0并非是实数,而是0向量。

## 多重共线现象与过拟合

- 多元线性回归模型: 其重要假定之一不同样本之间的属性标记值之间不存在线性关系。即$𝐗^𝑇𝐗$是可逆矩阵

- 多重共线现象: 当矩阵$𝐗$的行向量之间存在一定的线性相关性时,就会使得矩阵$𝐗^𝑇𝐗$不可逆,此时就无法解出w的解析解。

- 在实际应用时,如果样本容量不远远大于样本的特征维度($n<<d$),很可能造成过拟合,对这种情况,我们有下面三个解决方式:

1. 加数据

2. 特征选择(降低特征维度)如 PCA 算法。

3. 正则化

## 线性回归的贝叶斯方法解释

### 噪声为高斯分布的 MLE

对于一维的情况,记 $y=w^Tx+\epsilon,\epsilon\sim\mathcal{N}(0,\sigma^2)$,那么 $y\sim\mathcal{N}(w^Tx,\sigma^2)$。代入极大似然估计中:

$$

\begin{align}

L(w)=\log p(Y|X,w)&=\log\prod\limits_{i=1}^Np(y_i|x_i,w)\nonumber\\

&=\sum\limits_{i=1}^N\log(\frac{1}{\sqrt{2\pi}\sigma}e^{-\frac{(y_i-w^Tx_i)^2}{2\sigma^2}})\\

\mathop{argmax}\limits_wL(w)&=\mathop{argmin}\limits_w\sum\limits_{i=1}^N(y_i-w^Tx_i)^2

\end{align}

$$

这个表达式和最小二乘估计得到的结果一样。

$$

LSE \iff MLE \ (noise \ is \ Gaussian \ Distribution)

$$

### 权重先验也为高斯分布的 MAP

取先验分布 $w\sim\mathcal{N}(0,\sigma_0^2)$。于是:

$$

\begin{align}

\hat{w}=\mathop{argmax}\limits_wp(w|Y)&=\mathop{argmax}\limits_wp(Y|w)p(w)\nonumber\\

&=\mathop{argmax}\limits_w\log p(Y|w)p(w)\nonumber\\

&=\mathop{argmax}\limits_w(\log p(Y|w)+\log p(w))\nonumber\\

&=\mathop{argmin}\limits_w[(y-w^Tx)^2+\frac{\sigma^2}{\sigma_0^2}w^Tw]

\end{align}

$$

这里省略了 $X$,$p(Y)$和 $w$ 没有关系,同时也利用了上面高斯分布的 MLE的结果。

我们将会看到,超参数 $\sigma_0$的存在和下面会介绍的 Ridge 正则项可以对应,同样的如果将先验分布取为 Laplace 分布,那么就会得到和 $L_1$正则类似的结果。

## [正则化](./Regularization.md)

正则化一般是在损失函数(如上面介绍的最小二乘损失)上加入正则化项(表示模型的复杂度对模型的惩罚),下面我们介绍一般情况下的两种正则化框架。

$$

\begin{align}

L_1&:\mathop{argmin}\limits_wL(w)+\lambda||w||_1,\lambda\gt0\\

L_2&:\mathop{argmin}\limits_wL(w)+\lambda||w||^2_2,\lambda \gt 0

\end{align}

$$

下面对最小二乘误差分别分析这两者的区别。

### Lasso : $ L_1 $范数

$L_1$正则化可以引起稀疏解。

从最小化损失的角度看,由于 $L_1$项求导在0附近的左右导数都不是0,因此更容易取到0解。

从另一个方面看, $L_1$正则化相当于:

$$

\mathop{argmin}\limits_wL(w)\\

s.t. ||w||_1\lt C

$$

我们已经看到平方误差损失函数在 $w$ 空间是一个椭球,因此上式求解就是椭球和 $||w||_1=C$的切点,因此更容易相切在坐标轴上。

### Ridge : $L_2$范数

也称岭回归 为了解决多重共线现象带来的问题,对线性回归参数的求解方法进行改进 。同时这种方法又称权值衰减。

**基本思想:** 在线性回归模型损失函数上增加一个针对$𝒘$的范数惩罚函数,通过对目标函数做正则化处理,将参数向量 $𝒘 $中所有参数的取值压缩到一个相对较小的范围,即要求$𝒘$中所有参数的取值不能过大

岭回归的**损失函数**:

$$

𝐽(𝒘) = \vert\vert X𝒘 - 𝒚\vert \vert ^2 + \lambda\vert \vert 𝒘 \vert \vert ^2

$$

其中, $\lambda \ge 0$称为正则化参数。当$\lambda $的取值较大时,惩罚项$\lambda 𝒘^𝑇𝒘$就会对损失函数的最小化产生一定的干扰,优化算法就会对回归模型参数$𝒘$赋予较小的取值以消除这种干扰 。令$𝐽(𝒘)$对参数$𝒘$的偏导数为0,得:

$$

𝒘 = (𝐗^𝑇𝐗 + \lambda 𝐈)^{-1}𝐗^𝑇𝐲

$$

其中$𝐈$为𝑚阶单位矩阵。可以看到,这个正则化参数和前面的 MAP 结果不谋而合。利用2范数进行正则化不仅可以是模型选择 $w$ 较小的参数,同时也避免 $ X^TX$不可逆的问题。即使$𝐗^𝑇𝐗$本身不是可逆矩阵,加上$\lambda 𝐈$也可使得$𝐗^𝑇𝐗 + \lambda𝐈$组成为可逆矩阵,这也解决了多重共线问题

$$

Regularized \ LSE \iff MAP \ (noise \ is \ Gaussian \ Distribution)

$$

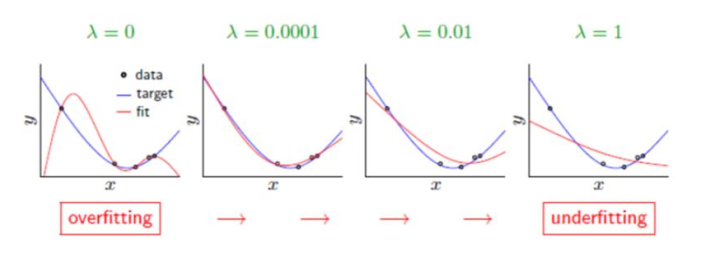

正则化参数的影响

## 小结

线性回归模型是最简单的模型,但是麻雀虽小,五脏俱全,在这里,我们利用最小二乘误差得到了闭式解。同时也发现,在噪声为高斯分布的时候,MLE 的解等价于最小二乘误差,而增加了正则项后,最小二乘误差加上 L2 正则项等价于高斯噪声先验下的 MAP解,加上 L1 正则项后,等价于 Laplace 噪声先验。

传统的机器学习方法或多或少都有线性回归模型的影子:

1. 线性模型往往不能很好地拟合数据,因此有三种方案克服这一劣势:

1. 对特征的维数进行变换,例如多项式回归模型就是在线性特征的基础上加入高次项。

2. 在线性方程后面加入一个非线性变换,即引入一个非线性的激活函数,典型的有线性分类模型如感知机。

3. 对于一致的线性系数,我们进行多次变换,这样同一个特征不仅仅被单个系数影响,例如多层感知机(深度前馈网络)。

2. 线性回归在整个样本空间都是线性的,我们修改这个限制,在不同区域引入不同的线性或非线性,例如线性样条回归和决策树模型。

3. 线性回归中使用了所有的样本,但是对数据预先进行加工学习的效果可能更好(所谓的维数灾难,高维度数据更难学习),例如 PCA 算法和流形学习。

有时会发现学习是一件很快乐的事情 比一直跑步容易多了 不是嘛

浙公网安备 33010602011771号

浙公网安备 33010602011771号