机器学习基础——概率论

1. 概率的基本要素

为了定义集合上的概率,我们需要一些基本元素,

-

样本空间ΩΩ:随机实验的所有结果的集合。在这里,每个结果 w∈Ωw∈Ω 可以被认为是实验结束时现实世界状态的完整描述。

-

事件集(事件空间)FF:元素 A∈FA∈F 的集合(称为事件)是 ΩΩ 的子集(即每个 A⊆ΩA⊆Ω 是一个实验可能结果的集合)。

备注:FF需要满足以下三个条件:

(1) ∅∈F∅∈F

(2) A∈F⟹Ω∖A∈FA∈F⟹Ω∖A∈F

(3) A1,A2,⋯Ai∈F⟹∪iAi∈FA1,A2,⋯Ai∈F⟹∪iAi∈F

-

概率度量PP:函数PP是一个F→RF→R的映射,满足以下性质:

-

对于每个 A∈FA∈F,P(A)≥0P(A)≥0,

-

P(Ω)=1P(Ω)=1

-

如果A1,A2,⋯A1,A2,⋯ 是互不相交的事件 (即 当$ i \neq j时,时,A_{i} \cap A_{j}=\emptyset$ ), 那么:

P(∪iAi)=∑iP(Ai)P(∪iAi)=∑iP(Ai)

-

以上三条性质被称为概率公理。

举例:

考虑投掷六面骰子的事件。样本空间为Ω={1,2,3,4,5,6}Ω={1,2,3,4,5,6}。最简单的事件空间是平凡事件空间F={∅,Ω}F={∅,Ω}.另一个事件空间是ΩΩ的所有子集的集合。对于第一个事件空间,满足上述要求的唯一概率度量由P(∅)=0P(∅)=0,p(Ω)=1p(Ω)=1给出。对于第二个事件空间,一个有效的概率度量是将事件空间中每个事件的概率分配为i/6i/6,这里ii 是这个事件集合中元素的数量;例如P({1,2,3,4})=4/6P({1,2,3,4})=4/6,P({1,2,3})=3/6P({1,2,3})=3/6。

性质:

- 如果A⊆BA⊆B,则:P(A)≤P(B)P(A)≤P(B)

- P(A∩B)≤min(P(A),P(B))P(A∩B)≤min(P(A),P(B))

- (布尔不等式):P(A∪B)≤P(A)+P(B)P(A∪B)≤P(A)+P(B)

- P(Ω|A)=1−P(A)P(Ω|A)=1−P(A)

- (全概率定律):如果A1,⋯,AkA1,⋯,Ak是一些互不相交的事件并且它们的并集是ΩΩ,那么它们的概率之和是1

1.1 事件的关系与运算#

(1) 子事件:A⊂BA⊂B,若AA发生,则BB发生。

(2) 相等事件:A=BA=B,即A⊂BA⊂B,且B⊂AB⊂A 。

(3) 和事件:A⋃BA⋃B(或A+BA+B),AA与BB中至少有一个发生。

(4) 差事件:A−BA−B,AA发生但BB不发生。

(5) 积事件:A⋂BA⋂B(或ABAB),AA与BB同时发生。

(6) 互斥事件(互不相容):A⋂BA⋂B=∅∅。

(7) 互逆事件(对立事件):

A⋂B=∅,A⋃B=Ω,A=ˉB,B=ˉAA⋂B=∅,A⋃B=Ω,A=¯B,B=¯A

1.2 运算律#

(1) 交换律:A⋃B=B⋃A,A⋂B=B⋂AA⋃B=B⋃A,A⋂B=B⋂A

(2) 结合律:(A⋃B)⋃C=A⋃(B⋃C)(A⋃B)⋃C=A⋃(B⋃C)

(3) 分配律:(A⋂B)⋂C=A⋂(B⋂C)(A⋂B)⋂C=A⋂(B⋂C)

1.3 德⋅⋅摩根律#

¯A⋃B=ˉA⋂ˉB¯¯¯¯¯¯¯¯¯¯¯¯¯¯¯A⋃B=¯A⋂¯B

¯A⋂B=ˉA⋃ˉB¯¯¯¯¯¯¯¯¯¯¯¯¯¯¯A⋂B=¯A⋃¯B

1.4 完全事件组#

A1A2⋯AnA1A2⋯An两两互斥,且和事件为必然事件,即Ai⋂Aj=∅,i≠j,Uni=1=ΩAi⋂Aj=∅,i≠j,Uni=1=Ω

1.5 概率的基本公式#

(1)条件概率:

P(A|B)≜P(A∩B)P(B)P(A|B)≜P(A∩B)P(B),表示AA发生的条件下,BB发生的概率。

(2)全概率公式:

P(A)=n∑i=1P(A|Bi)P(Bi),BiBj=∅,i≠j,⋃ni=1Bi=ΩP(A)=n∑i=1P(A|Bi)P(Bi),BiBj=∅,i≠j,⋃ni=1Bi=Ω

(3) Bayes 公式:

注:上述公式中事件BiBi的个数可为可列个。

(4)乘法公式:

P(A1A2)=P(A1)P(A2|A1)=P(A2)P(A1|A2)P(A1A2)=P(A1)P(A2|A1)=P(A2)P(A1|A2)

P(A1A2⋯An)=P(A1)P(A2|A1)P(A3|A1A2)⋯P(An|A1A2⋯An−1)P(A1A2⋯An)=P(A1)P(A2|A1)P(A3|A1A2)⋯P(An|A1A2⋯An−1)

1.6.事件的独立性#

(1)AA与BB相互独立

⇔P(AB)=P(A)P(B)⇔P(AB)=P(A)P(B)

(2)AA,BB,CC两两独立

⇔P(AB)=P(A)P(B)⇔P(AB)=P(A)P(B);P(BC)=P(B)P(C)P(BC)=P(B)P(C) ;P(AC)=P(A)P(C)P(AC)=P(A)P(C);

(3)AA,BB,CC相互独立

⇔P(AB)=P(A)P(B)⇔P(AB)=P(A)P(B); P(BC)=P(B)P(C)P(BC)=P(B)P(C) ;

P(AC)=P(A)P(C)P(AC)=P(A)P(C) ; P(ABC)=P(A)P(B)P(C)P(ABC)=P(A)P(B)P(C)

1.7 独立重复试验#

将某试验独立重复nn次,若每次实验中事件 A 发生的概率为pp,则nn次试验中AA发生kk次的概率为:

P(X=k)=Cknpk(1−p)n−kP(X=k)=Cknpk(1−p)n−k

1.8 重要公式与结论#

(1)P(ˉA)=1−P(A)(1)P(¯A)=1−P(A)

(2)P(A⋃B)=P(A)+P(B)−P(AB)(2)P(A⋃B)=P(A)+P(B)−P(AB)

P(A⋃B⋃C)=P(A)+P(B)+P(C)−P(AB)−P(BC)−P(AC)+P(ABC)P(A⋃B⋃C)=P(A)+P(B)+P(C)−P(AB)−P(BC)−P(AC)+P(ABC)

(3)P(A−B)=P(A)−P(AB)(3)P(A−B)=P(A)−P(AB)

(4)P(AˉB)=P(A)−P(AB),P(A)=P(AB)+P(AˉB),(4)P(A¯B)=P(A)−P(AB),P(A)=P(AB)+P(A¯B),

P(A⋃B)=P(A)+P(ˉAB)=P(AB)+P(AˉB)+P(ˉAB)P(A⋃B)=P(A)+P(¯AB)=P(AB)+P(A¯B)+P(¯AB)

(5)条件概率P(⋅|B)P(⋅|B)满足概率的所有性质,

例如:. P(ˉA1|B)=1−P(A1|B)P(¯A1|B)=1−P(A1|B)

P(A1⋃A2|B)=P(A1|B)+P(A2|B)−P(A1A2|B)P(A1⋃A2|B)=P(A1|B)+P(A2|B)−P(A1A2|B)

P(A1A2|B)=P(A1|B)P(A2|A1B)P(A1A2|B)=P(A1|B)P(A2|A1B)

(6)若A1,A2,⋯,AnA1,A2,⋯,An相互独立,则P(n⋂i=1Ai)=n∏i=1P(Ai),P(n⋂i=1Ai)=n∏i=1P(Ai),

P(n⋃i=1Ai)=n∏i=1(1−P(Ai))P(n⋃i=1Ai)=n∏i=1(1−P(Ai))

(7)互斥、互逆与独立性之间的关系:

AA与BB互逆⇒⇒ AA与BB互斥,但反之不成立,AA与BB互斥(或互逆)且均非零概率事件⇒⇒$A与与B$不独立.

(8)若A1,A2,⋯,Am,B1,B2,⋯,BnA1,A2,⋯,Am,B1,B2,⋯,Bn相互独立,则f(A1,A2,⋯,Am)f(A1,A2,⋯,Am)与g(B1,B2,⋯,Bn)g(B1,B2,⋯,Bn)也相互独立,其中f(⋅),g(⋅)f(⋅),g(⋅)分别表示对相应事件做任意事件运算后所得的事件,另外,概率为 1(或 0)的事件与任何事件相互独立.

2. 随机变量

考虑一个实验,我们翻转10枚硬币,我们想知道正面硬币的数量。这里,样本空间ΩΩ的元素是长度为10的序列。例如,我们可能有w0={H,H,T,H,T,H,H,T,T,T}∈Ωw0={H,H,T,H,T,H,H,T,T,T}∈Ω。然而,在实践中,我们通常不关心获得任何特定正反序列的概率。相反,我们通常关心结果的实值函数,比如我们10次投掷中出现的正面数,或者最长的背面长度。在某些技术条件下,这些函数被称为随机变量。

更正式地说,随机变量XX是一个的Ω⟶RΩ⟶R函数。通常,我们将使用大写字母X(ω)X(ω)或更简单的XX(其中隐含对随机结果ωω的依赖)来表示随机变量。我们将使用小写字母xx来表示随机变量的值。

举例:

在我们上面的实验中,假设X(ω)X(ω)是在投掷序列ωω中出现的正面的数量。假设投掷的硬币只有10枚,那么X(ω)X(ω)只能取有限数量的值,因此它被称为离散随机变量。这里,与随机变量XX相关联的集合取某个特定值kk的概率为:

举例:

假设X(ω)X(ω)是一个随机变量,表示放射性粒子衰变所需的时间。在这种情况下,X(ω)X(ω)具有无限多的可能值,因此它被称为连续随机变量。我们将XX在两个实常数aa和bb之间取值的概率(其中a<ba<b)表示为:

2.1 累积分布函数#

为了指定处理随机变量时使用的概率度量,通常可以方便地指定替代函数(CDF、PDF和PMF),在本节和接下来的两节中,我们将依次描述这些类型的函数。

累积分布函数(CDF)(简称分布函数)是函数FX:R→[0,1]FX:R→[0,1],它将概率度量指定为:

通过使用这个函数,我们可以计算任意事件发生的概率。图1显示了一个样本CDF函数。

性质:

- 0≤FX(x)≤10≤FX(x)≤1

- limx→−∞FX(x)=0limx→−∞FX(x)=0

- limx→∞FX(x)=1limx→∞FX(x)=1

- x≤y⟹FX(x)≤FX(y)x≤y⟹FX(x)≤FX(y)

2.2 概率质量函数#

当随机变量XX取有限种可能值(即,XX是离散随机变量)时,表示与随机变量相关联的概率度量的更简单的方法是直接指定随机变量可以假设的每个值的概率。特别地,概率质量函数(PMF)是函数 pX:Ω→RpX:Ω→R,这样:

在离散随机变量的情况下,我们使用符号Val(X)Val(X)表示随机变量XX可能假设的一组可能值。例如,如果X(ω)X(ω)是一个随机变量,表示十次投掷硬币中的正面数,那么Val(X)={0,1,2,...,10}Val(X)={0,1,2,...,10}。

性质:

- 0≤pX(x)≤10≤pX(x)≤1

- ∑x∈V al (X)pX(x)=1∑x∈V al (X)pX(x)=1

- ∑x∈ApX(x)=P(X∈A)∑x∈ApX(x)=P(X∈A)

2.3 概率密度函数#

对于一些连续随机变量,累积分布函数FX(x)FX(x)处可微。在这些情况下,我们将概率密度函数(PDF)定义为累积分布函数的导数,即:

请注意,连续随机变量的概率密度函数可能并不总是存在的(即,如果它不是处处可微)。

根据微分的性质,对于很小的ΔxΔx,

CDF和PDF(当它们存在时!)都可用于计算不同事件的概率。但是应该强调的是,任意给定点的概率密度函数(PDF)的值不是该事件的概率,即fX(x)≠P(X=x)fX(x)≠P(X=x)。例如,fX(x)fX(x)可以取大于1的值(但是fX(x)fX(x)在RR的任何子集上的积分最多为1)。

性质:

- fX(x)≥0fX(x)≥0

- ∫∞−∞fX(x)=1∫∞−∞fX(x)=1

- ∫x∈AfX(x)dx=P(X∈A)∫x∈AfX(x)dx=P(X∈A)

2.4 期望#

假设XX是一个离散随机变量,其PMF为 pX(x)pX(x),g:R⟶Rg:R⟶R是一个任意函数。在这种情况下,g(X)g(X)可以被视为随机变量,我们将g(X)g(X)的期望值定义为:

如果XX是一个连续的随机变量,其PDF 为fX(x)fX(x),那么g(X)g(X)的期望值被定义为:

直觉上,g(X)g(X)的期望值可以被认为是g(x)g(x)对于不同的xx值可以取的值的“加权平均值”,其中权重由pX(x)pX(x)或fX(x)fX(x)给出。作为上述情况的特例,请注意,随机变量本身的期望值,是通过令g(x)=xg(x)=x得到的,这也被称为随机变量的平均值。

性质:

- 对于任意常数 a∈Ra∈R,E[a]=aE[a]=a

- 对于任意常数 a∈Ra∈R,E[af(X)]=aE[f(X)]E[af(X)]=aE[f(X)]

- (线性期望):E[f(X)+g(X)]=E[f(X)]+E[g(X)]E[f(X)+g(X)]=E[f(X)]+E[g(X)]

- 对于一个离散随机变量XX,E[1{X=k}]=P(X=k)E[1{X=k}]=P(X=k)

2.5 方差#

随机变量XX的方差是随机变量XX的分布围绕其平均值集中程度的度量。形式上,随机变量XX的方差定义为:

使用上一节中的性质,我们可以导出方差的替代表达式:

其中第二个等式来自期望的线性,以及E[X]E[X]相对于外层期望实际上是常数的事实。

性质:

- 对于任意常数 a∈Ra∈R,Val[a]=0Val[a]=0

- 对于任意常数 a∈Ra∈R,Var[af(X)]=a2Var[f(X)]Var[af(X)]=a2Var[f(X)]

举例:

计算均匀随机变量XX的平均值和方差,任意x∈[0,1]x∈[0,1],其PDF为 pX(x)=1pX(x)=1,其他地方为0。

举例:

假设对于一些子集A⊆ΩA⊆Ω,有g(x)=1{x∈A}g(x)=1{x∈A},计算E[g(X)]E[g(X)]?

离散情况:

连续情况:

2.6 一些常见的随机变量#

离散随机变量

-

伯努利分布:硬币掷出正面的概率为pp(其中:0≤p≤10≤p≤1),如果正面发生,则为1,否则为0。

p(x)={p if p=11−p if p=0p(x)={p if p=11−p if p=0 -

二项式分布:掷出正面概率为pp(其中:0≤p≤10≤p≤1)的硬币nn次独立投掷中正面的数量。

p(x)=(nx)px(1−p)n−xp(x)=(nx)px(1−p)n−x -

泊松分布:用于模拟罕见事件频率的非负整数的概率分布(其中:λ>0λ>0)。

p(x)=e−λλxx!p(x)=e−λλxx! -

几何分布:掷出正面概率为pp(其中:p>0p>0)的硬币第一次掷出正面所需要的次数。

G(p):P(X=k)=(1−p)k−1p,0<p<1,k=1,2,⋯.G(p):P(X=k)=(1−p)k−1p,0<p<1,k=1,2,⋯. -

超几何分布:H(N,M,n):P(X=k)=CkMCn−kN−MCnN,k=0,1,⋯,min(n,M)H(N,M,n):P(X=k)=CkMCn−kN−MCnN,k=0,1,⋯,min(n,M)

连续随机变量

-

均匀分布:在aa和bb之间每个点概率密度相等的分布(其中:a<ba<b)。

f(x)={1b−a if a≤x≤b0 otherwise f(x)={1b−a if a≤x≤b0 otherwise -

指数分布:在非负实数上有衰减的概率密度(其中:λ>0λ>0)。

f(x)={λe−λx if x≥00 otherwise f(x)={λe−λx if x≥00 otherwise -

正态分布:又被称为高斯分布。

f(x)=1√2πσe−12σ2(x−μ)2f(x)=1√2πσe−12σ2(x−μ)2

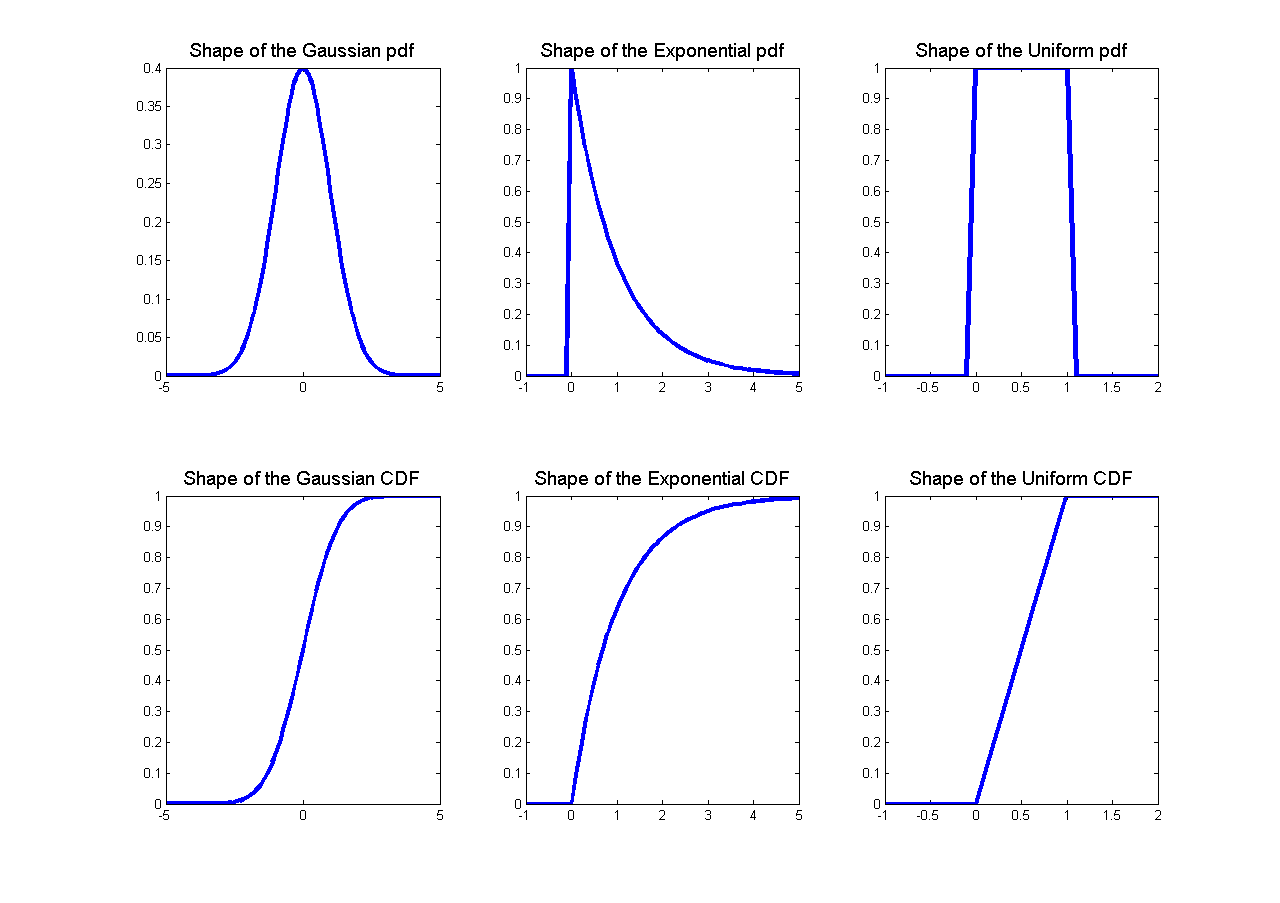

一些随机变量的概率密度函数和累积分布函数的形状如图2所示。

下表总结了这些分布的一些特性:

| 分布 | 概率密度函数(PDF)或者概率质量函数(PMF) | 均值 | 方差 |

|---|---|---|---|

| Bernoulli(p)Bernoulli(p)(伯努利分布) | {p if x=11−p if x=0{p if x=11−p if x=0 | pp | p(1−p)p(1−p) |

| Binomial(n,p)Binomial(n,p)(二项式分布) | (nk)pk(1−p)n−k(nk)pk(1−p)n−k 其中:0≤k≤n0≤k≤n | npnp | npqnpq |

| Geometric(p)Geometric(p)(几何分布) | p(1−p)k−1p(1−p)k−1 其中:k=1,2,⋯k=1,2,⋯ | 1p1p | 1−pp21−pp2 |

| Poisson(λ)Poisson(λ)(泊松分布) | e−λλx/x!e−λλx/x! 其中:k=1,2,⋯k=1,2,⋯ | λλ | λλ |

| Uniform(a,b)Uniform(a,b)(均匀分布) | 1b−a1b−a 存在x∈(a,b)x∈(a,b) | a+b2a+b2 | (b−a)212(b−a)212 |

| Gaussian(μ,σ2)Gaussian(μ,σ2)(高斯分布) | 1√2πσe−12σ2(x−μ)21√2πσe−12σ2(x−μ)2 | μμ | σ2σ2 |

| Exponential(λ)Exponential(λ)(指数分布) | λe−λxλe−λx x≥0,λ>0x≥0,λ>0 | 1λ1λ | 1λ21λ2 |

2.7 重要公式与结论#

(1) X∼N(0,1)⇒φ(0)=1√2π,Φ(0)=12,X∼N(0,1)⇒φ(0)=1√2π,Φ(0)=12, Φ(−a)=P(X≤−a)=1−Φ(a)Φ(−a)=P(X≤−a)=1−Φ(a)

(2) X∼N(μ,σ2)⇒X−μσ∼N(0,1),P(X≤a)=Φ(a−μσ)X∼N(μ,σ2)⇒X−μσ∼N(0,1),P(X≤a)=Φ(a−μσ)

(3) X∼E(λ)⇒P(X>s+t|X>s)=P(X>t)X∼E(λ)⇒P(X>s+t|X>s)=P(X>t)

(4) X∼G(p)⇒P(X=m+k|X>m)=P(X=k)X∼G(p)⇒P(X=m+k|X>m)=P(X=k)

(5) 离散型随机变量的分布函数为阶梯间断函数;连续型随机变量的分布函数为连续函数,但不一定为处处可导函数。

(6) 存在既非离散也非连续型随机变量。

3. 两个随机变量

到目前为止,我们已经考虑了单个随机变量。然而,在许多情况下,在随机实验中,我们可能有不止一个感兴趣的量。例如,在一个我们掷硬币十次的实验中,我们可能既关心X(ω)=X(ω)=出现的正面数量,也关心Y(ω)=Y(ω)=连续最长出现正面的长度。在本节中,我们考虑两个随机变量的设置。

3.1 联合分布和边缘分布#

假设我们有两个随机变量,一个方法是分别考虑它们。如果我们这样做,我们只需要FX(x)FX(x)和FY(y)FY(y)。但是如果我们想知道在随机实验的结果中,XX和YY同时假设的值,我们需要一个更复杂的结构,称为XX和YY的联合累积分布函数,定义如下:

可以证明,通过了解联合累积分布函数,可以计算出任何涉及到XX和YY的事件的概率。

联合CDF: FXY(x,y)FXY(x,y)和每个变量的联合分布函数FX(x)FX(x)和FY(y)FY(y)分别由下式关联:

这里我们称FX(x)FX(x)和FY(y)FY(y)为 FXY(x,y)FXY(x,y)的边缘累积概率分布函数。

性质:

- 0≤FXY(x,y)≤10≤FXY(x,y)≤1

- limx,y→∞FXY(x,y)=1limx,y→∞FXY(x,y)=1

- limx,y→−∞FXY(x,y)=0limx,y→−∞FXY(x,y)=0

- FX(x)=limy→∞FXY(x,y)FX(x)=limy→∞FXY(x,y)

3.2 联合概率和边缘概率质量函数#

如果XX和YY是离散随机变量,那么联合概率质量函数 pXY:R×R→[0,1]pXY:R×R→[0,1]由下式定义:

这里, 对于任意xx,yy,0≤PXY(x,y)≤10≤PXY(x,y)≤1, 并且 ∑x∈Val(X)∑y∈Val(Y)PXY(x,y)=1∑x∈Val(X)∑y∈Val(Y)PXY(x,y)=1

两个变量上的联合PMF分别与每个变量的概率质量函数有什么关系?事实上:

对于pY(y)pY(y)类似。在这种情况下,我们称pX(x)pX(x)为XX的边际概率质量函数。在统计学中,将一个变量相加形成另一个变量的边缘分布的过程通常称为“边缘化”。

3.3 联合概率和边缘概率密度函数#

假设XX和YY是两个连续的随机变量,具有联合分布函数FXYFXY。在FXY(x,y)FXY(x,y)在xx和yy中处处可微的情况下,我们可以定义联合概率密度函数:

如同在一维情况下,fXY(x,y)≠P(X=x,Y=y)fXY(x,y)≠P(X=x,Y=y),而是:

请注意,概率密度函数fXY(x,y)fXY(x,y)的值总是非负的,但它们可能大于1。尽管如此,可以肯定的是 ∫∞−∞∫∞−∞fXY(x,y)=1∫∞−∞∫∞−∞fXY(x,y)=1

与离散情况相似,我们定义:

作为XX的边际概率密度函数(或边际密度),对于fY(y)fY(y)也类似。

3.4 条件概率分布#

条件分布试图回答这样一个问题,当我们知道XX必须取某个值xx时,YY上的概率分布是什么?在离散情况下,给定YY的条件概率质量函数是简单的:

假设分母不等于0。

在连续的情况下,在技术上要复杂一点,因为连续随机变量的概率等于零。忽略这一技术点,我们通过类比离散情况,简单地定义给定X=xX=x的条件概率密度为:

假设分母不等于0。

3.5 贝叶斯定理#

当试图推导一个变量给定另一个变量的条件概率表达式时,经常出现的一个有用公式是贝叶斯定理。

对于离散随机变量XX和YY:

对于连续随机变量XX和YY:

3.6 独立性#

如果对于XX和YY的所有值,FXY(x,y)=FX(x)FY(y)FXY(x,y)=FX(x)FY(y),则两个随机变量XX和YY是独立的。等价地,

- 对于离散随机变量, 对于任意x∈Val(X)x∈Val(X), y∈Val(Y)y∈Val(Y) ,pXY(x,y)=pX(x)pY(y)pXY(x,y)=pX(x)pY(y)。

- 对于离散随机变量, pY|X(y|x)=pY(y)pY|X(y|x)=pY(y)当对于任意y∈Val(Y)y∈Val(Y)且pX(x)≠0pX(x)≠0。

- 对于连续随机变量, fXY(x,y)=fX(x)fY(y)fXY(x,y)=fX(x)fY(y) 对于任意 x,y∈Rx,y∈R。

- 对于连续随机变量, fY|X(y|x)=fY(y)fY|X(y|x)=fY(y) ,当fX(x)≠0fX(x)≠0对于任意y∈Ry∈R。

非正式地说,如果“知道”一个变量的值永远不会对另一个变量的条件概率分布有任何影响,那么两个随机变量XX和YY是独立的,也就是说,你只要知道f(x)f(x)和f(y)f(y)就知道关于这对变量(X,Y)(X,Y)的所有信息。以下引理将这一观察形式化:

引理3.1

如果XX和YY是独立的,那么对于任何A,B⊆RA,B⊆R,我们有:

利用上述引理,我们可以证明如果XX与YY无关,那么XX的任何函数都与YY的任何函数无关。

3.7 期望和协方差#

假设我们有两个离散的随机变量XX,YY并且g:R2⟶Rg:R2⟶R是这两个随机变量的函数。那么gg的期望值以如下方式定义:

对于连续随机变量XX,YY,类似的表达式是:

我们可以用期望的概念来研究两个随机变量之间的关系。特别地,两个随机变量的协方差定义为:

使用类似于方差的推导,我们可以将它重写为:

在这里,说明两种协方差形式相等的关键步骤是第三个等号,在这里我们使用了这样一个事实,即E[X]E[X]和E[Y]E[Y]实际上是常数,可以被提出来。当cov[X,Y]=0cov[X,Y]=0时,我们说XX和YY不相关。

性质:

- (期望线性) E[f(X,Y)+g(X,Y)]=E[f(X,Y)]+E[g(X,Y)]E[f(X,Y)+g(X,Y)]=E[f(X,Y)]+E[g(X,Y)]

- Var[X+Y]=Var[X]+Var[Y]+2Cov[X,Y]Var[X+Y]=Var[X]+Var[Y]+2Cov[X,Y]

- 如果XX和YY相互独立, 那么 Cov[X,Y]=0Cov[X,Y]=0

- 如果XX和YY相互独立, 那么 E[f(X)g(Y)]=E[f(X)]E[g(Y)]E[f(X)g(Y)]=E[f(X)]E[g(Y)].

3.8 常见的二维随机变量#

(1) 二维均匀分布:(x,y)∼U(D)(x,y)∼U(D) ,f(x,y)={1S(D),(x,y)∈D0,其他f(x,y)={1S(D),(x,y)∈D0,其他

(2) 二维正态分布:(X,Y)∼N(μ1,μ2,σ21,σ22,ρ)(X,Y)∼N(μ1,μ2,σ21,σ22,ρ),(X,Y)∼N(μ1,μ2,σ21,σ22,ρ)(X,Y)∼N(μ1,μ2,σ21,σ22,ρ)

f(x,y)=12πσ1σ2√1−ρ2.exp{−12(1−ρ2)[(x−μ1)2σ21−2ρ(x−μ1)(y−μ2)σ1σ2+(y−μ2)2σ22]}f(x,y)=12πσ1σ2√1−ρ2.exp{−12(1−ρ2)[(x−μ1)2σ21−2ρ(x−μ1)(y−μ2)σ1σ2+(y−μ2)2σ22]}

3.9 重要公式与结论#

(1) 边缘密度公式: fX(x)=∫+∞−∞f(x,y)dy,fX(x)=∫+∞−∞f(x,y)dy,

fY(y)=∫+∞−∞f(x,y)dxfY(y)=∫+∞−∞f(x,y)dx

(2) P{(X,Y)∈D}=∬Df(x,y)dxdyP{(X,Y)∈D}=∬Df(x,y)dxdy

(3) 若(X,Y)(X,Y)服从二维正态分布N(μ1,μ2,σ21,σ22,ρ)N(μ1,μ2,σ21,σ22,ρ)

则有:

-

X∼N(μ1,σ21),Y∼N(μ2,σ22).X∼N(μ1,σ21),Y∼N(μ2,σ22).

-

XX与YY相互独立⇔ρ=0⇔ρ=0,即XX与YY不相关。

-

C1X+C2Y∼N(C1μ1+C2μ2,C21σ21+C22σ22+2C1C2σ1σ2ρ)C1X+C2Y∼N(C1μ1+C2μ2,C21σ21+C22σ22+2C1C2σ1σ2ρ)

-

X X关于Y=yY=y的条件分布为: N(μ1+ρσ1σ2(y−μ2),σ21(1−ρ2))N(μ1+ρσ1σ2(y−μ2),σ21(1−ρ2))

-

YY关于X=xX=x的条件分布为: N(μ2+ρσ2σ1(x−μ1),σ22(1−ρ2))N(μ2+ρσ2σ1(x−μ1),σ22(1−ρ2))

(4) 若XX与YY独立,且分别服从N(μ1,σ21),N(μ1,σ22),N(μ1,σ21),N(μ1,σ22),

则:(X,Y)∼N(μ1,μ2,σ21,σ22,0),(X,Y)∼N(μ1,μ2,σ21,σ22,0),

C1X+C2Y˜ N(C1μ1+C2μ2,C21σ21C22σ22).C1X+C2Y~ N(C1μ1+C2μ2,C21σ21C22σ22).

(5) 若XX与YY相互独立,f(x)f(x)和g(x)g(x)为连续函数, 则f(X)f(X)和g(Y)g(Y)也相互独立。

4. 多个随机变量

上一节介绍的概念和想法可以推广到两个以上的随机变量。特别是,假设我们有nn个连续随机变量,X1(ω),X2(ω),⋯Xn(ω)X1(ω),X2(ω),⋯Xn(ω)。在本节中,为了表示简单,我们只关注连续的情况,对离散随机变量的推广工作类似。

4.1 基本性质#

我们可以定义X1,X2,⋯,XnX1,X2,⋯,Xn的联合累积分布函数、联合概率密度函数,以及给定X2,⋯,XnX2,⋯,Xn时X1X1的边缘概率密度函数为:

为了计算事件A⊆RnA⊆Rn的概率,我们有:

链式法则:

从多个随机变量的条件概率的定义中,可以看出:

独立性:对于多个事件,A1,⋯,AkA1,⋯,Ak,我们说A1,⋯,AkA1,⋯,Ak 是相互独立的,当对于任何子集S⊆{1,2,⋯,k}S⊆{1,2,⋯,k},我们有:

同样,我们说随机变量X1,X2,⋯,XnX1,X2,⋯,Xn是独立的,如果:

这里,相互独立性的定义只是两个随机变量独立性到多个随机变量的自然推广。

独立随机变量经常出现在机器学习算法中,其中我们假设属于训练集的训练样本代表来自某个未知概率分布的独立样本。为了明确独立性的重要性,考虑一个“坏的”训练集,我们首先从某个未知分布中抽取一个训练样本(x(1),y(1))(x(1),y(1)),然后将完全相同的训练样本的m−1m−1个副本添加到训练集中。在这种情况下,我们有:

尽管训练集的大小为mm,但这些例子并不独立!虽然这里描述的过程显然不是为机器学习算法建立训练集的明智方法,但是事实证明,在实践中,样本的不独立性确实经常出现,并且它具有减小训练集的“有效大小”的效果。

4.2 随机向量#

假设我们有n个随机变量。当把所有这些随机变量放在一起工作时,我们经常会发现把它们放在一个向量中是很方便的...我们称结果向量为随机向量(更正式地说,随机向量是从ΩΩ到RnRn的映射)。应该清楚的是,随机向量只是处理nn个随机变量的一种替代符号,因此联合概率密度函数和综合密度函数的概念也将适用于随机向量。

期望:

考虑g:Rn→Rg:Rn→R中的任意函数。这个函数的期望值 被定义为

其中,∫Rn∫Rn是从−∞−∞到∞∞的nn个连续积分。如果gg是从RnRn到RmRm的函数,那么gg的期望值是输出向量的元素期望值,即,如果gg是:

那么,

协方差矩阵:对于给定的随机向量X:Ω→RnX:Ω→Rn,其协方差矩阵ΣΣ是n×nn×n平方矩阵,其输入由Σij=Cov[Xi,Xj]Σij=Cov[Xi,Xj]给出。从协方差的定义来看,我们有:

其中矩阵期望以明显的方式定义。

协方差矩阵有许多有用的属性:

- Σ⪰0Σ⪰0;也就是说,ΣΣ是正半定的。

- Σ=ΣTΣ=ΣT;也就是说,ΣΣ是对称的。

4.3 多元高斯分布#

随机向量上概率分布的一个特别重要的例子叫做多元高斯或多元正态分布。随机向量X∈RnX∈Rn被认为具有多元正态(或高斯)分布,当其具有均值μ∈Rnμ∈Rn和协方差矩阵Σ∈Sn++Σ∈Sn++(其中$ \mathbb{S}_{++}^{n}指对称正定指对称正定n \times n$矩阵的空间)

fX1,X2,…,Xn(x1,x2,…,xn;μ,Σ)=1(2π)n/2|Σ|1/2exp(−12(x−μ)TΣ−1(x−μ))

我们把它写成X∼N(μ,Σ)。请注意,在n=1的情况下,它降维成普通正态分布,其中均值参数为μ1,方差为Σ11。

一般来说,高斯随机变量在机器学习和统计中非常有用,主要有两个原因:

首先,在统计算法中对“噪声”建模时,它们非常常见。通常,噪声可以被认为是影响测量过程的大量小的独立随机扰动的累积;根据中心极限定理,独立随机变量的总和将趋向于“看起来像高斯”。

其次,高斯随机变量便于许多分析操作,因为实际中出现的许多涉及高斯分布的积分都有简单的封闭形式解。我们将在本课程稍后遇到这种情况。

5. 随机变量的数字特征

一些具体的推导前文有过详细的阐述,这里不加缀述,此处仅作总结用

5.1 数学期望#

离散型:P{X=xi}=pi,E(X)=∑ixipi;

连续型: X∼f(x),E(X)=∫+∞−∞xf(x)dx

性质:

(1) E(C)=C,E[E(X)]=E(X)

(2) E(C1X+C2Y)=C1E(X)+C2E(Y)

(3) 若X和Y独立,则E(XY)=E(X)E(Y)

(4)[E(XY)]2≤E(X2)E(Y2)

5.2 方差:#

D(X)=E[X−E(X)]2=E(X2)−[E(X)]2

5.3 标准差:#

- 离散型:D(X)=∑i[xi−E(X)]2pi

- 连续型:D(X)=∫+∞−∞[x−E(X)]2f(x)dx

性质:

(1) D(C)=0,D[E(X)]=0,D[D(X)]=0

(2) X与Y相互独立,则D(X±Y)=D(X)+D(Y)

(3) D(C1X+C2)=C21D(X)

(4) 一般有 D(X±Y)=D(X)+D(Y)±2Cov(X,Y)=D(X)+D(Y)±2ρ√D(X)√D(Y)

(5) D(X)<E(X−C)2,C≠E(X)

(6) D(X)=0⇔P{X=C}=1

5.4 随机变量函数的数学期望#

(1) 对于函数Y=g(x)

X为离散型:P{X=xi}=pi,E(Y)=∑ig(xi)pi;

X为连续型:X∼f(x),E(Y)=∫+∞−∞g(x)f(x)dx

(2) Z=g(X,Y);(X,Y)∼P{X=xi,Y=yj}=pij; E(Z)=∑i∑jg(xi,yj)pij (X,Y)∼f(x,y);E(Z)=∫+∞−∞∫+∞−∞g(x,y)f(x,y)dxdy

5.5 协方差#

Cov(X,Y)=E[(X−E(X)(Y−E(Y))]

5.6 相关系数#

ρXY=Cov(X,Y)√D(X)√D(Y),k阶原点矩 E(Xk);

k阶中心矩 E{[X−E(X)]k}

性质:

(1) Cov(X,Y)=Cov(Y,X)

(2) Cov(aX,bY)=abCov(Y,X)

(3) Cov(X1+X2,Y)=Cov(X1,Y)+Cov(X2,Y)

(4) |ρ(X,Y)|≤1

(5) ρ(X,Y)=1⇔P(Y=aX+b)=1 ,其中a>0

ρ(X,Y)=−1⇔P(Y=aX+b)=1

,其中a<0

5.7 重要公式与结论#

(1) D(X)=E(X2)−E2(X)

(2) Cov(X,Y)=E(XY)−E(X)E(Y)

(3) |ρ(X,Y)|≤1,且 ρ(X,Y)=1⇔P(Y=aX+b)=1,其中a>0

ρ(X,Y)=−1⇔P(Y=aX+b)=1,其中a<0

(4) 下面 5 个条件互为充要条件:

ρ(X,Y)=0 ⇔Cov(X,Y)=0 ⇔E(X,Y)=E(X)E(Y) ⇔D(X+Y)=D(X)+D(Y) ⇔D(X−Y)=D(X)+D(Y)

注:X与Y独立为上述 5 个条件中任何一个成立的充分条件,但非必要条件。

6. 数理统计的基本概念

6.1 基本概念#

总体:研究对象的全体,它是一个随机变量,用X表示。

个体:组成总体的每个基本元素。

简单随机样本:来自总体X的n个相互独立且与总体同分布的随机变量X1,X2⋯,Xn,称为容量为n的简单随机样本,简称样本。

统计量:设X1,X2⋯,Xn,是来自总体X的一个样本,g(X1,X2⋯,Xn))是样本的连续函数,且g()中不含任何未知参数,则称g(X1,X2⋯,Xn)为统计量。

样本均值:¯X=1n∑ni=1Xi

样本方差:S2=1n−1∑ni=1(Xi−¯X)2

样本矩:样本k阶原点矩:Ak=1n∑ni=1Xki,k=1,2,⋯

样本k阶中心矩:Bk=1n∑ni=1(Xi−¯X)k,k=1,2,⋯

6.2 常用分布#

χ2分布:χ2=X21+X22+⋯+X2n∼χ2(n),其中X1,X2⋯,Xn,相互独立,且同服从N(0,1)

t分布:T=X√Y/n∼t(n) ,其中X∼N(0,1),Y∼χ2(n),且X,Y 相互独立。

F分布:F=X/n1Y/n2∼F(n1,n2),其中X∼χ2(n1),Y∼χ2(n2),且X,Y相互独立。

分位数:若P(X≤xα)=α,则称xα为X的α分位数

6.3 正态总体的常用样本分布#

(1) 设X1,X2⋯,Xn为来自正态总体N(μ,σ2)的样本,

¯X=1n∑ni=1Xi,S2=1n−1∑ni=1(Xi−¯X)2,则:

-

¯X∼N(μ,σ2n) 或者¯X−μσ√n∼N(0,1)

-

(n−1)S2σ2=1σ2∑ni=1(Xi−¯X)2∼χ2(n−1)

-

1σ2∑ni=1(Xi−μ)2∼χ2(n)

4) ¯X−μS/√n∼t(n−1)

6.4 重要公式与结论#

(1) 对于χ2∼χ2(n),有E(χ2(n))=n,D(χ2(n))=2n;

(2) 对于T∼t(n),有E(T)=0,D(T)=nn−2(n>2);

(3) 对于F˜ F(m,n),有 1F∼F(n,m),Fa/2(m,n)=1F1−a/2(n,m);

(4) 对于任意总体X,有 E(¯X)=E(X),E(S2)=D(X),D(¯X)=D(X)n

参考

概率论与数理统计 浙江大学 第4版

概率论辅导讲义 王式安

CS229 - Probability

A First Course in Probability 第9版

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律