卷积神经网络

卷积神经网络整体架构

卷积层涉及参数

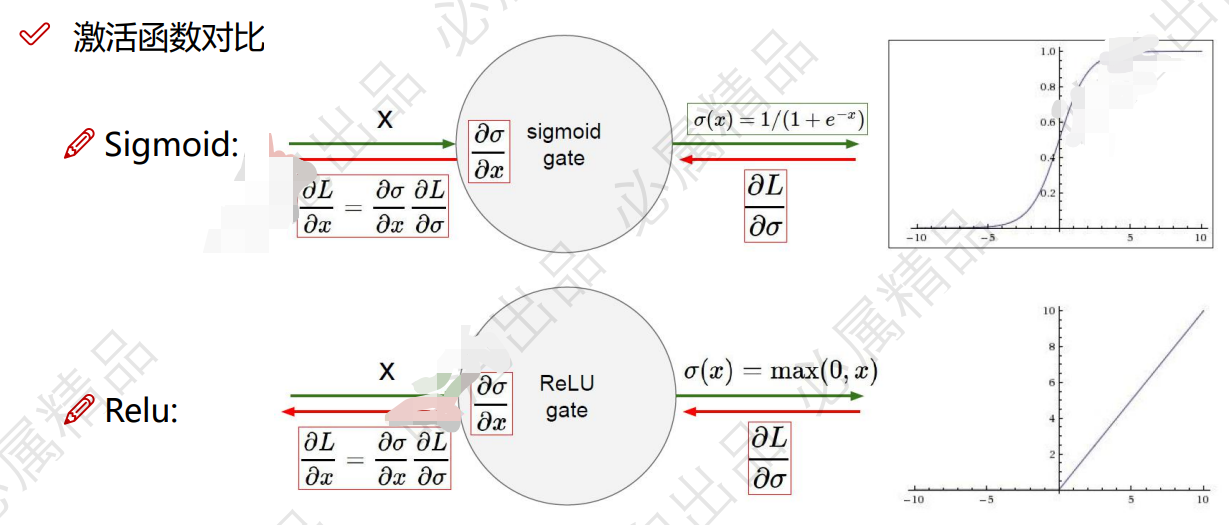

激活函数

每个区域提取的特征要尽可能的多?

卷积大量提取特征,让下游有的选择,特征的多样性,第一层有丰富信息,第二层才有得做

256

512

每个区域提取的特征要尽可能的多

每个区域都有 256 个特征

卷积核的层数和输入是一样的?

刚刚输入的彩色图片是三层,那么初始的卷积核就是三层的

卷积核上的权重是什么样的?

开始时是随机的

后需要更新的

卷积加偏置等于最后的值

卷积核大小 为什么 3×3 ?

计算量更大,

算的次数多,

特征算出来的多,

提取较多的特征

步长的选择?

越小越好,特征也提取的比较好

pading的作用?

加上边界,对边界点不公平,需要加个边界,加一圈 0

h 加 2,w 加 2

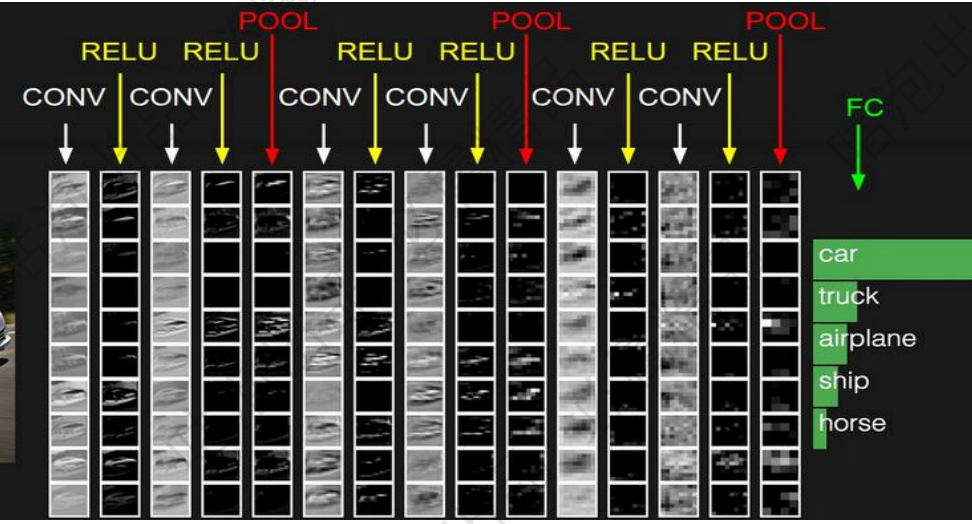

提很多层卷积,每一层卷积在做什么?

不可解释

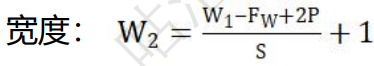

卷积结果计算公式?

共享权重参数?

w权重不变,每一层的权重不变,随着步长一步一步的往下走

共享权重参数,

省参数,省资源,多个卷积核来弥补

如果图像变大了,参数个数不会发生改变

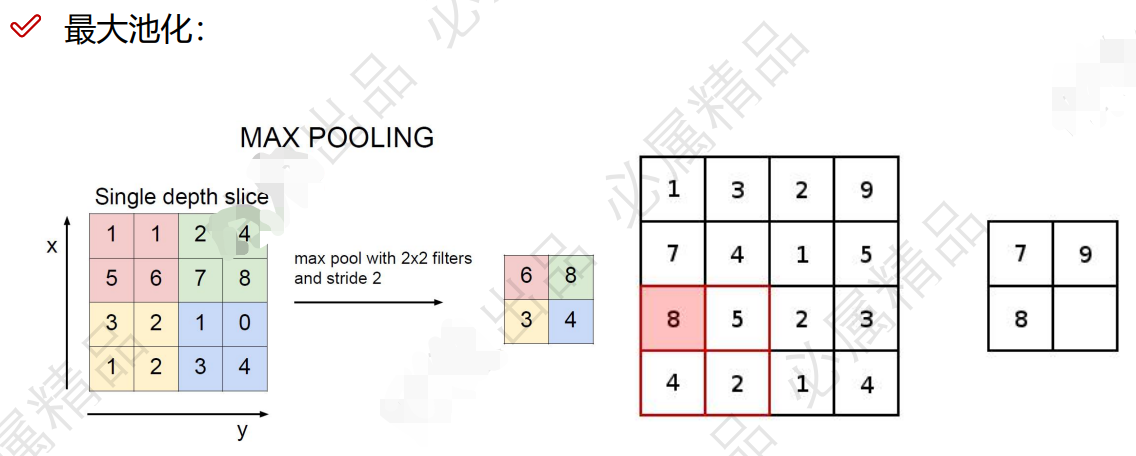

池化层的作用?

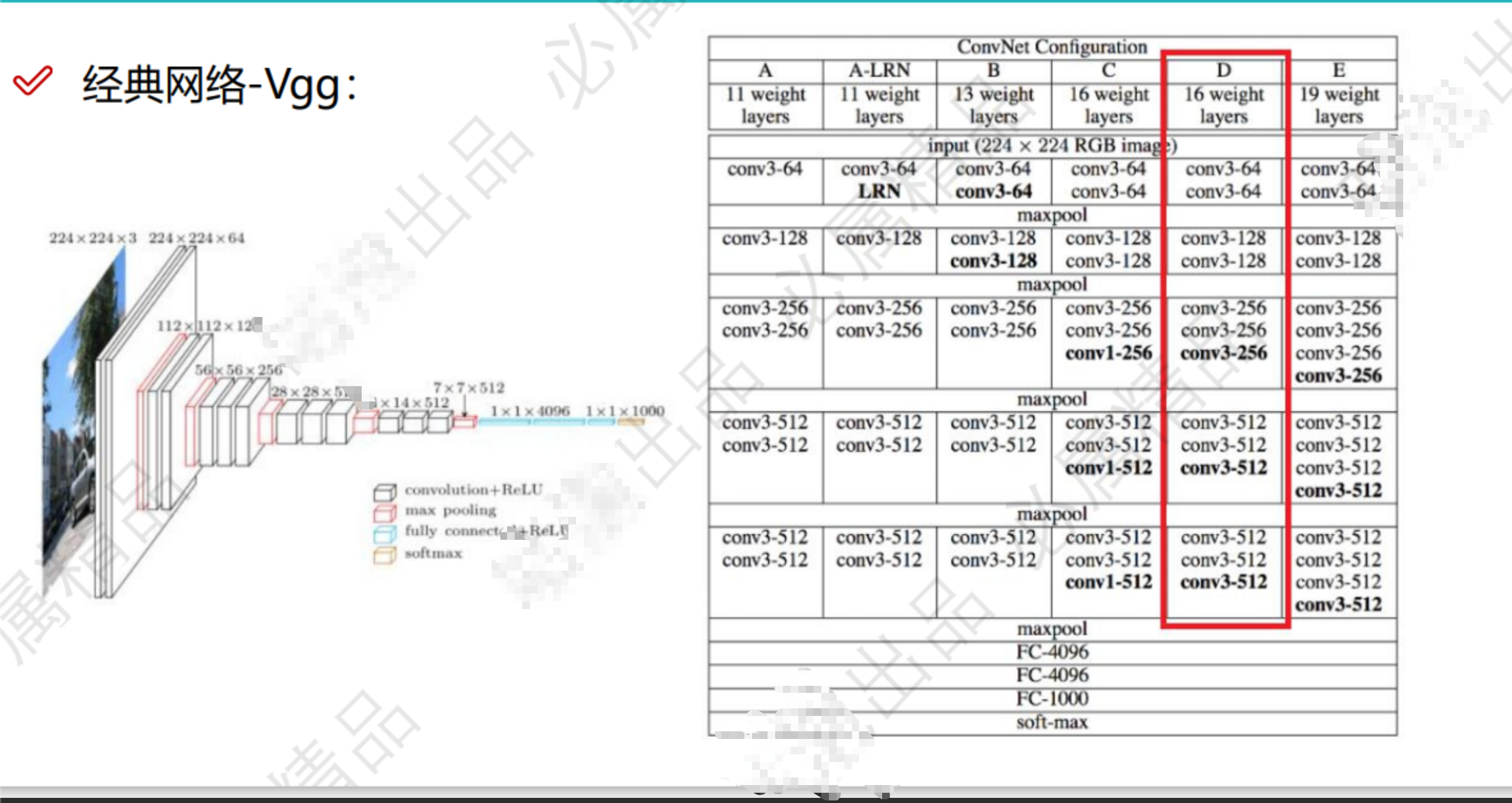

经典算法vgg

经典算法 resnet

目的: 筛选特征的过程

图变小了,个数没变,

maxpooling 取出四个位置中的 最大的值 最大池化,也就是最厉害的特征,无法证明,实践发现,数值越来越大,的效果越来越好,也就是最好的特征

平均池化,已经很少用了,在取全局特征时,会取平均池化

池化不需要训练,已经定好了,去最大的,没有参数计算的过程,参数也不会发生变化

4×4 变成 2×2

vgg 经典

1 3×3 卷积可以一直用

2 pooling突变小后,就是精锐了,卷积核翻倍 再去扩充特征

3 速度慢

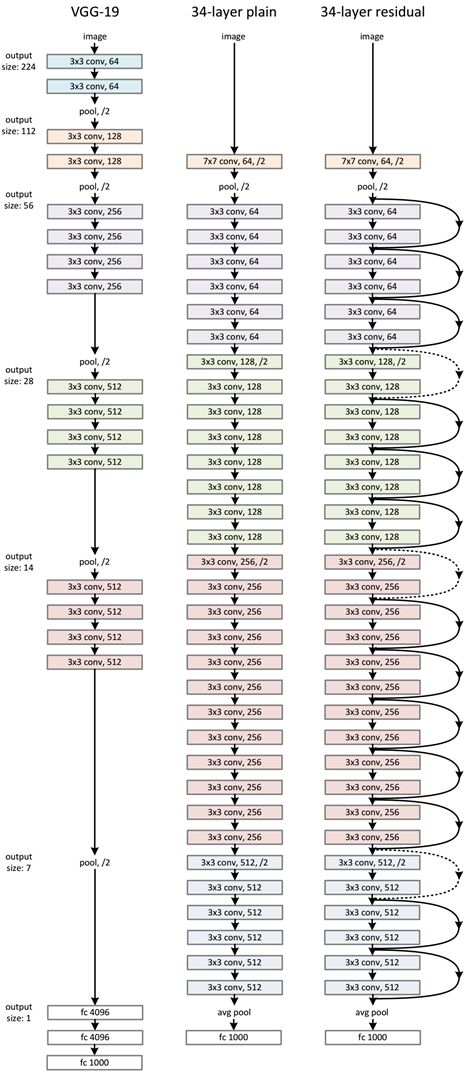

存在的问题:层数越高,错误率越高,无法解决

resnet 经典 改变世界的一件事

一句话:至少不比原来差

为什么会变差,无可解释,为什么越来越变差?

x 2x 3x 对照实验

全改成 resnet 格式

缺点:存储空间太大了,额外存储其中的 x 显存翻倍了,中间过程的显存使用翻倍了

怎么办?

分支越多推理速度越慢,分支合并后续讲,推理时省,训练时省不了(推理这部分还不理解)

参数没有变大

感受野 重要操作

特征图中上的一个点相当于是原始图像的多大区域

感受野的计算

计算一个点代表的原输入的多少像素点

是越大越好吗?

是的,感受野越大越好

一个点相当于是很大一个区域

为什么 3×3?

1 参数少

2 特征多

3 速度快

4 同样的感受野下,3*3要多处理几层,可以增加非线性 增加 bn 标准化

浙公网安备 33010602011771号

浙公网安备 33010602011771号