卷积神经网络基础

卷积神经网络基础

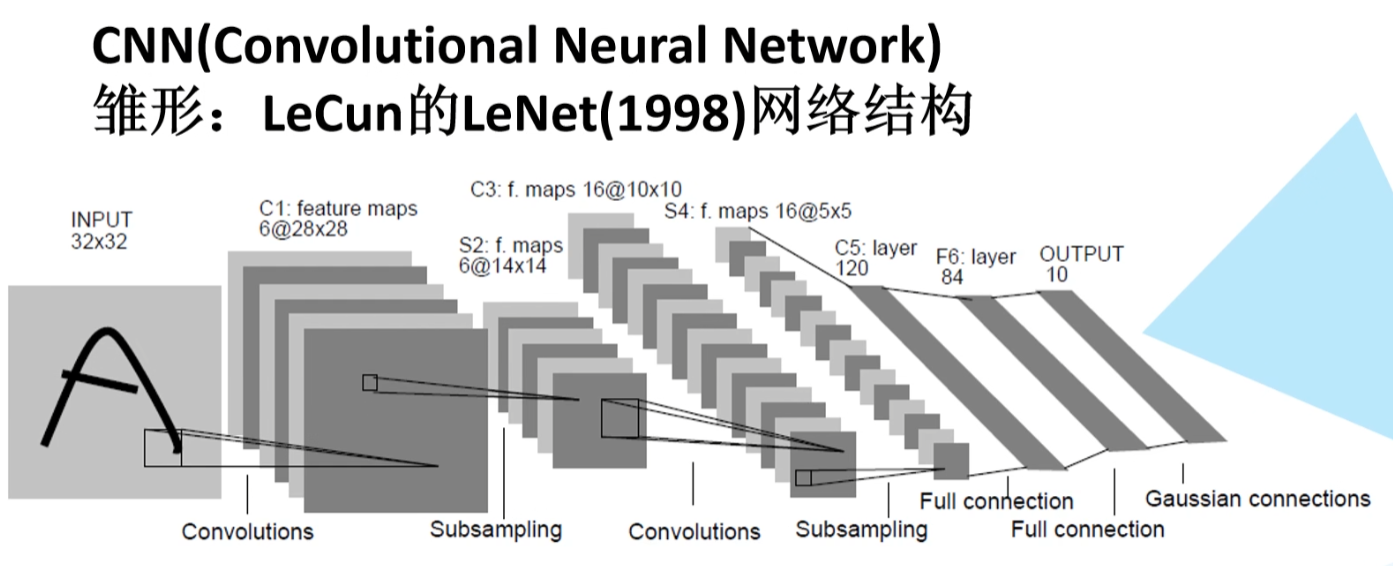

卷积神经网络 LeNet第一次提出

卷积神经网络CNN的发展历史

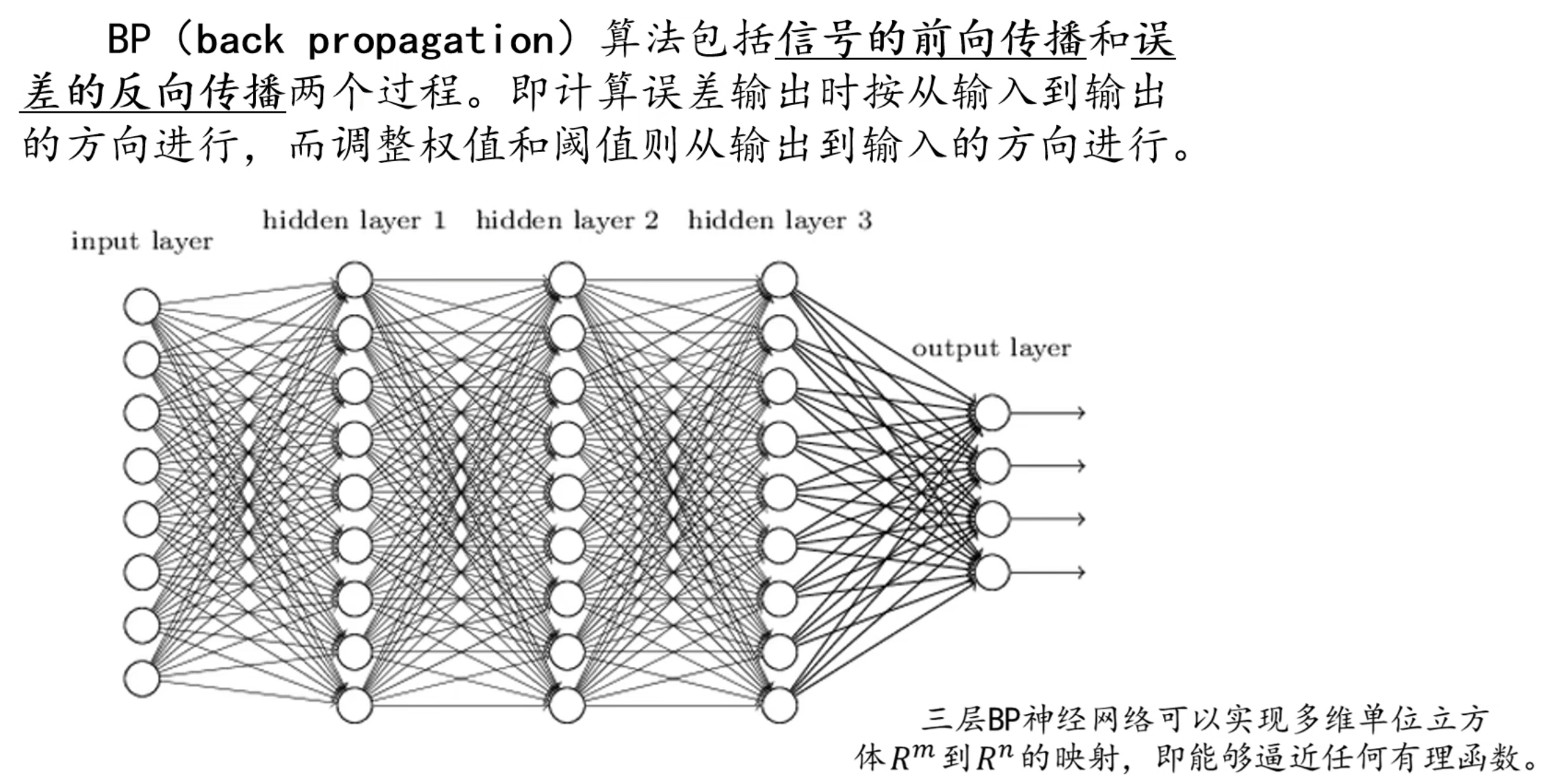

1986 Rumelhart和Hinton等人提出了反向传播(Back Propagation,BP)算法。

1998 LeCun的利用BP算法训练LeNet5网络,标志着CNN的真正面世。(硬件跟不上)

2006 Hinton在他们的Science Paper中首次提出了Deep Learning的概念。

2012 Hinton的学生Alex Krizhevsky在寝室用GPU死磕了一个Deep Learning模型,一举摘下了视觉领域竞赛ILSVRC 2012的桂冠,在百万量级的ImageNet数据集合上,效果大幅度超过传统的方法,从传统的70%多提升到80%多。

全连接层

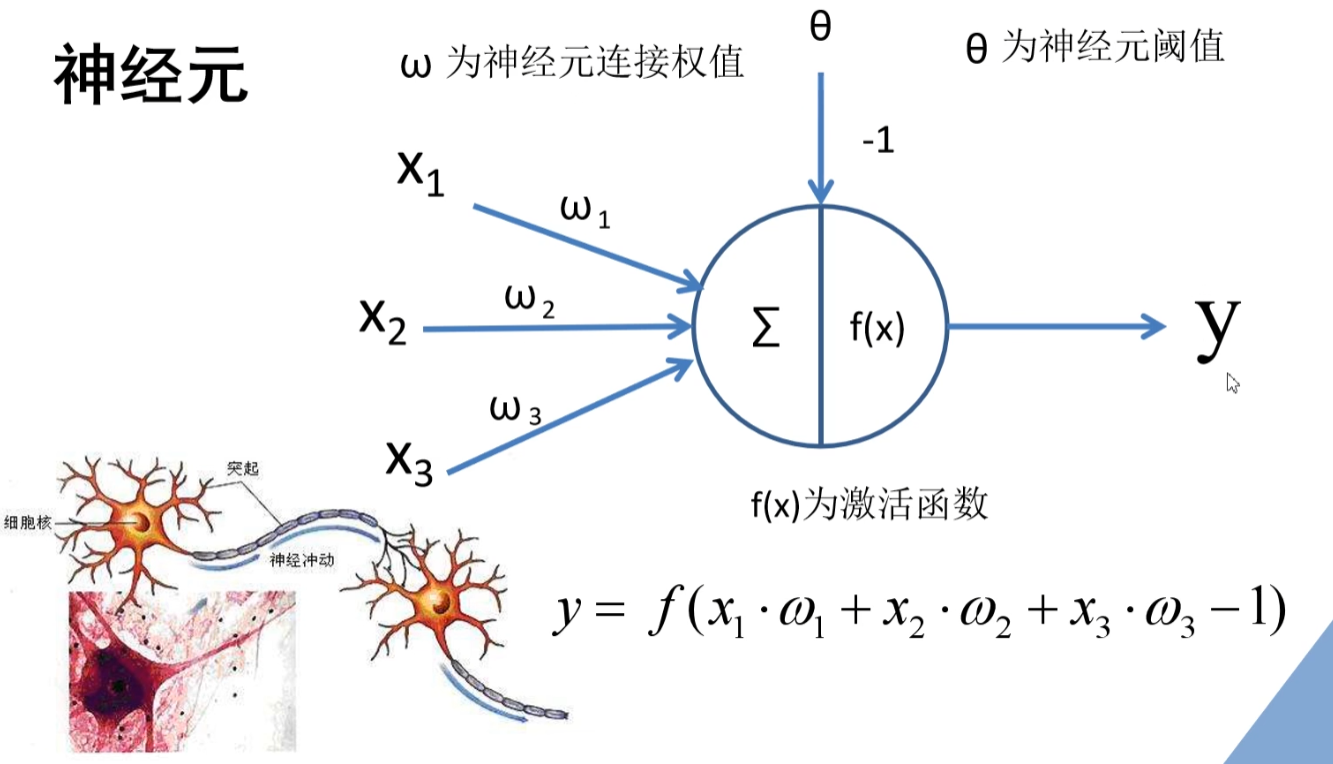

神经元

BP神经网络

如果将神经元按列排列,列于列之间连接,就得到一个BP神经网络

重点 - 信号的向前传播

- 误差的反向传播

one-hot编码

100 = 0

010 = 1

001 = 3

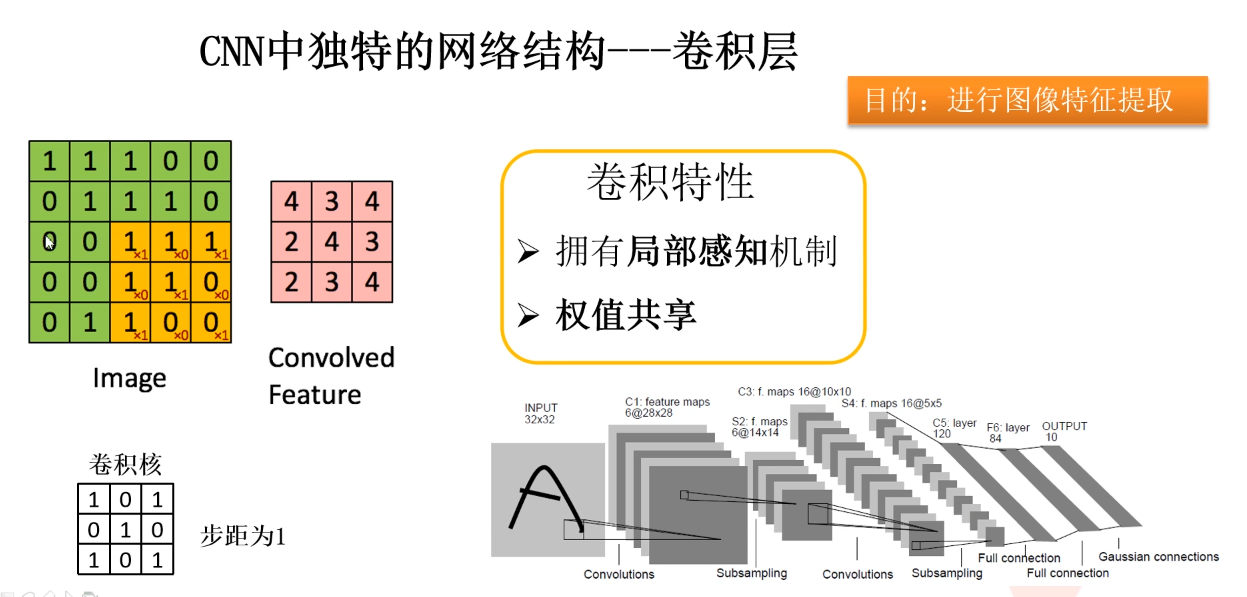

卷积层

局部感知

权值共享

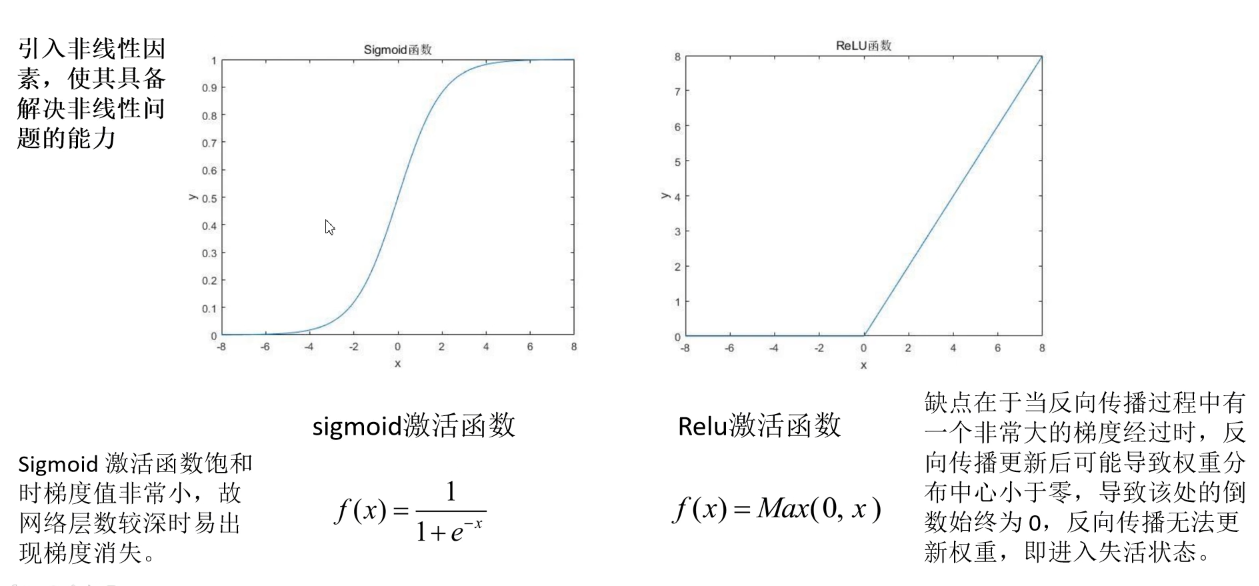

激活函数

作用:引入非线性因素,使其具备解决非线性问题的能力

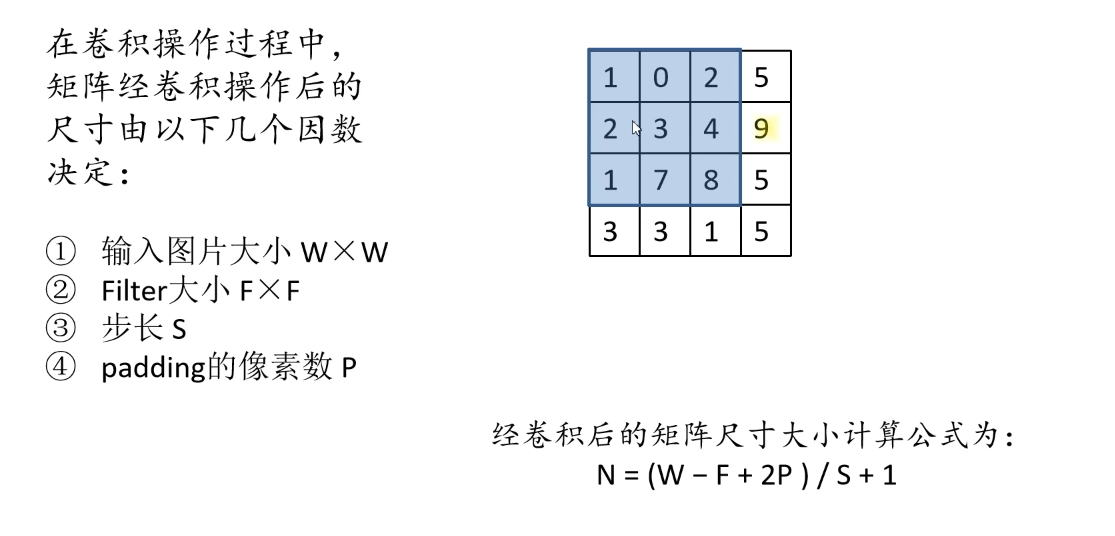

经过卷积后的尺寸如何计算

N = (W - F + 2P) / S + 1

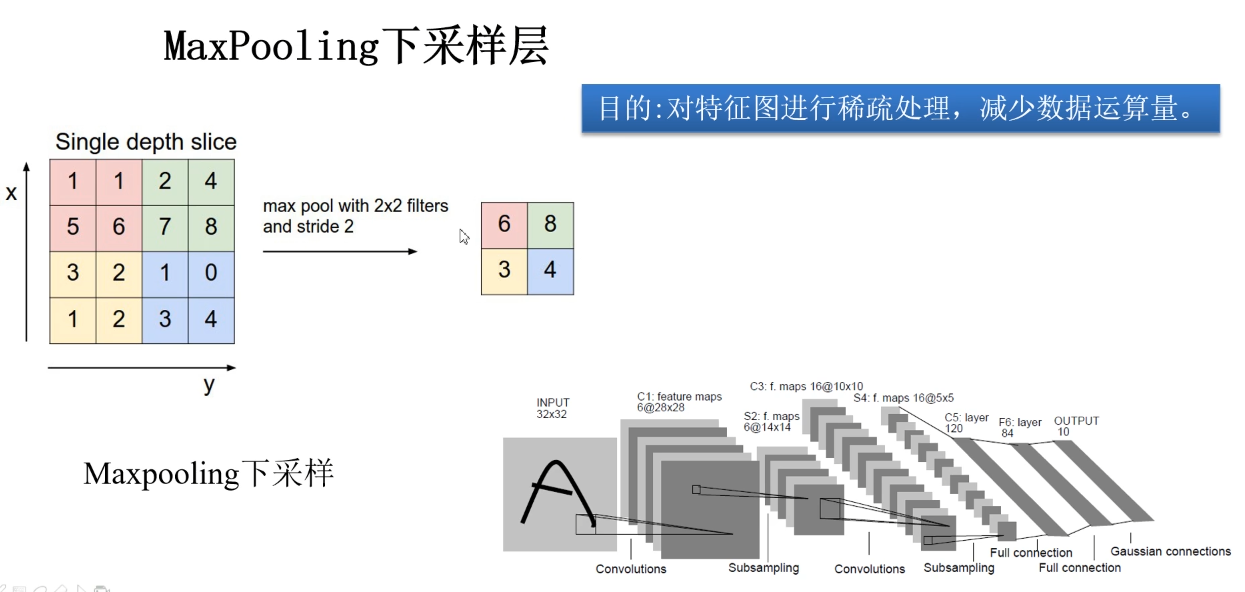

池化层 MaxPooling下采样层

作用:对特征进行稀疏处理,减少运算数据量

没有任何的训练参数

只改变特征矩阵的宽度和高度,不改变深度

一般来说池化核大小和步距一样

Cross Entropy Loss 交叉熵损失

1.多分类问题 softmax 输出概率和为1

2.二分类问题 sigmoid 输出互不相干

优化器 optimazer

目的:使得网络更快的收敛

SGD + 动量部分

adam 优化器(自适应学习率)---学习率慢慢降低

信息集聚地

本文作者:youbaotang

本文链接:https://www.cnblogs.com/youbaotang/p/16554273.html

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步