模式识别期末复习

默认是列向量,所以

第二章、聚类分析

- 协方差矩阵:通常应该是指

那么特别地,对一个变量来说,这里写

这个东西叫方差应该更合适= = - 自相关矩阵,即相关系数的拓展:

- 很自然地有

即 - 马氏距离:

- 相关系数

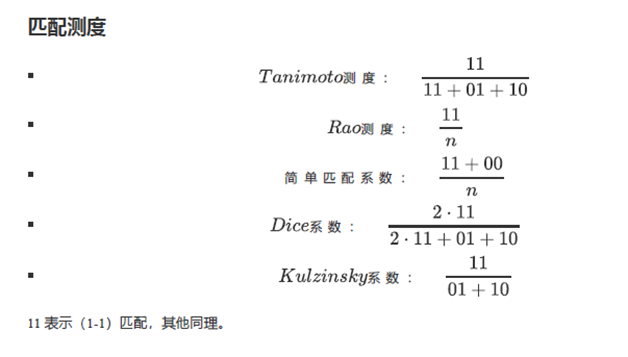

- 匹配测度(这个还没看)

第三章、特征选择与提取

补充:分类器

- MED:最小欧氏距离分类器

- MICD:最小类间距离分类器,常用马氏距离

对特征的要求

- 可分性(信息量大)、可靠性强(不能是模棱两可的)、独立性(不要有重复、相关)、尽量少

- 特征选择vs特征提取

3.2 类别可分性测度——衡量类别间可分性的尺度

- 类内(within)距离 :

- 类内散布矩阵:就是协方差矩阵

- 类间距离:

- 类间(between)散布矩阵(Scatter Matrix):

两种特征提取方法

1、类内散布矩阵(单类模式提取)

特点:压缩维数,类内距离减小,样本更密集

过程:1、协方差矩阵

性质:

变换后分量的方差=特征值,相当于丢掉了大方差,类内距离保持不变(因为变换矩阵归一化)

2、KL变换

特点:1、最小均方差(MSE,Mean Square Error)。2、使用任意概率密度。3、消除特征之间相关性。

过程:1、算自相关矩阵

优点:1、最小均方误差。2、大特征,突出模式类的差异。3、消除相关性

缺点:1、多类问题效果不好。2、需要足够多样本。3、计算困难

3.5流形学习

测地距离、等距映射ISOMAP,

3.6 特征选择

最优搜索:分支定界算法

次优搜索

信息熵

4、判别函数&几何分类

问题:给了很多个模式,如何分类?

判别函数/判决函数:用来对模式进行分类的准则函数

- 几何性质:线性、非线性,一些问题可能不是线性可分的

- 系数、维数、正负

- 对于线性判决函数,

4.3 线性判别函数

二分类:

多类情况:

- 对比: 第二种需要多个判决函数,但对于线性可分的可能性更大。

4.4 广义线性判别函数

换元

4.5 线性判别函数的几何性质

设

很符合我们的认识

结论:判决函数正比于点到超平面的距离。

权空间

规范化增广

规范化:对于二分类来说,不属于的

增广:因为有个常数

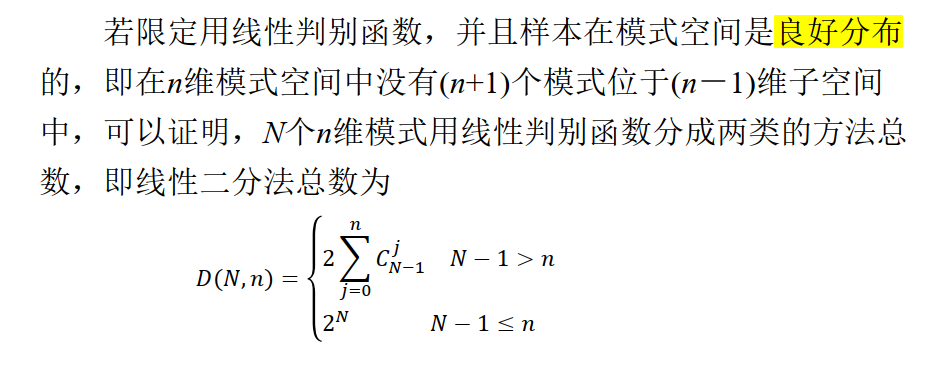

二分法

随便给

4.6 权向量求解

4.6.1感知器

二分类:先规范化增广,对训练样本迭代:如果

结论:只要线性可分,就是收敛的

应用于多分类:

- 使用

- 只增广,不需要规范化

- 每次迭代,对每个模式,计算所有判决函数,如果

- 其他不变

- 收敛

4.6.2 梯度算法

定一个准则函数

1、规范化增广,设置

2、对训练样本,

不一定收敛,

4.6.2.* 对梯度算法的修正——固定增量法

准则函数

求导:

那么很明显,

结论:感知器是固定增量法(梯度法)的特例。

4.6.3 最小平方误差 LMSE

特点:可分模式收敛,不可分的情况也能跑(能够判断出来是不可分的),同时利用

思路:考虑二分类,规范化增广,假设规范化增广后的样本是一个

即使得 $$J(W,X,B)=\frac{1}{2}||XW-b||2=\frac{1}{2}\sum_{i=1}N (W^T X_i-b_i)^2$$最小

思路:对

可分性:模式线性可分,且系数

4.7 非线性判别函数

4.8 Fisher线性判别

考虑二分类问题,将样本投影到一个一维空间上,这样就可以用一个简单的阈值来分类。

假设映射到

考虑强制让分母为

得到

4.9 支持向量机SVM

应用举例:手写数字识别、性别识别

SVM的标准:最大边缘超平面(MMH,maximum margin hyperplane)

分类面

支持向量:距离超平面最近的几个样本

特点:训练时间长,复杂的非线性决策边界精度高。

创新:二次规划、指出了二分类的关键是支持向量。

训练出SVM后,分类器的复杂性也只和支持向量(个数)有关, 独立于数据维数,

补充:SVM求解非线性问题

- 原空间

- 特征空间:如xor问题,做映射,这个通常是低维到高维。

- 核函数:

- 假设特征映射

- 结论:空间

- 性质:核函数对加法、乘法、数乘封闭,也可以直接用特征函数相乘。

- 美好期望:核函数要能够反应样本距离,是否同类

- 核技巧:计算变成向量点乘。

- 假设特征映射

补充:核函数的应用——KPCA

传统PCA:

1、中心化

2、协方差矩阵

3、算协方差矩阵的特征向量,找特征值最大的

KPCA:处理非线性的分布、去噪

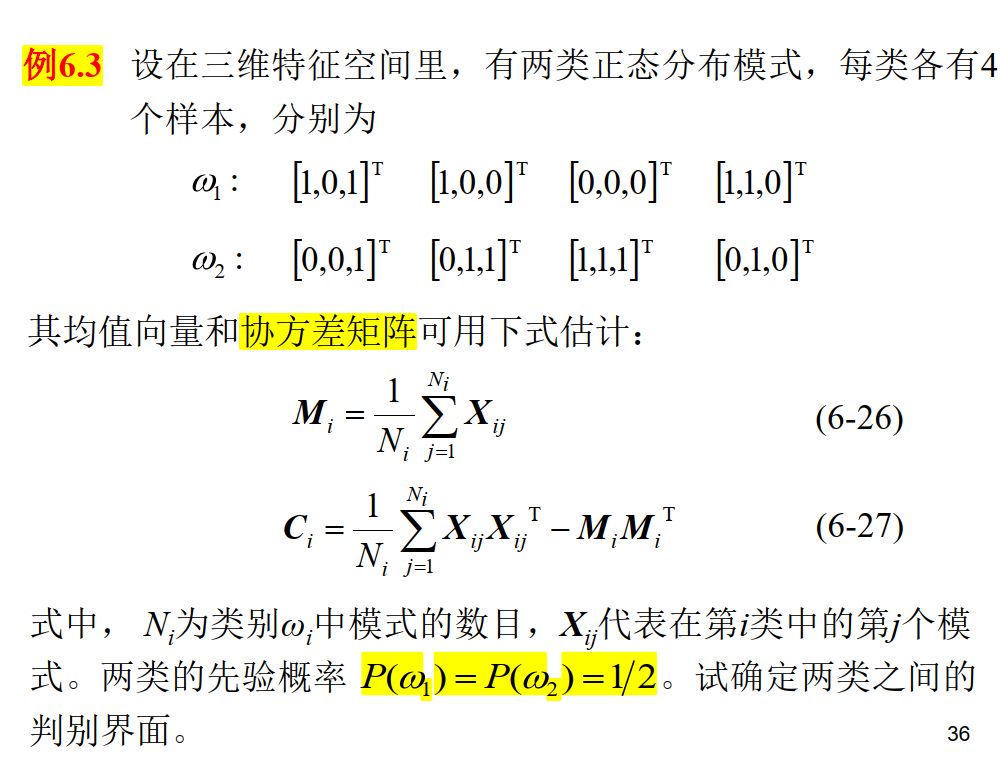

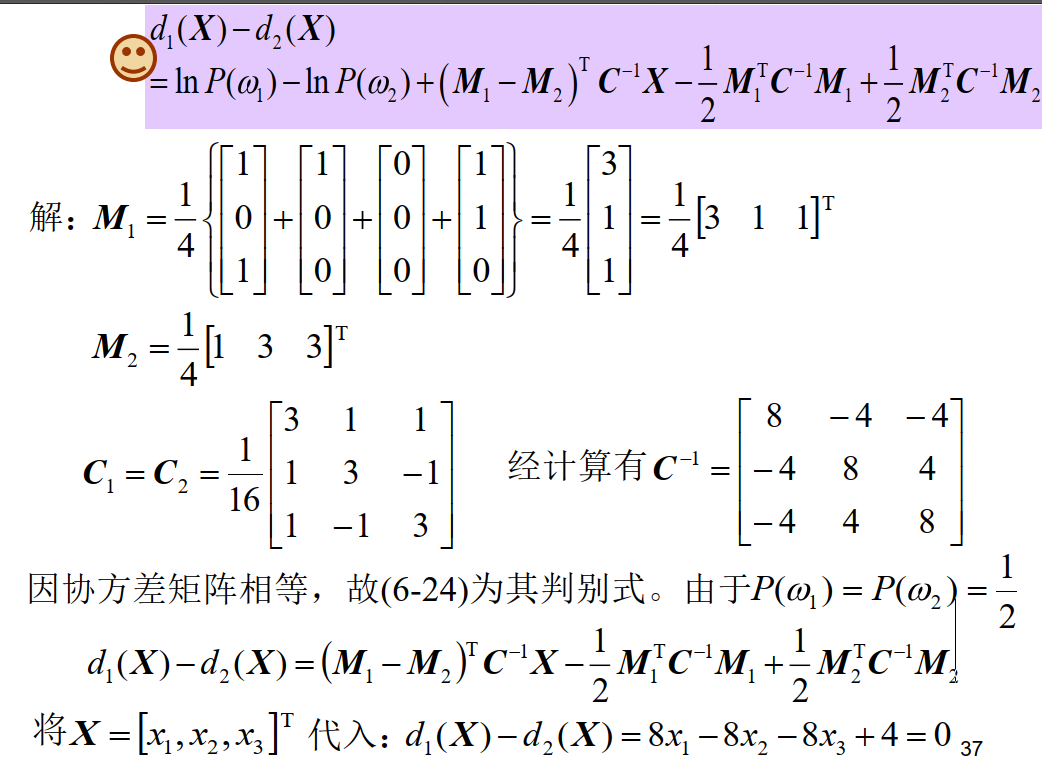

第六章、基于统计决策的概率分类

先验概率:根据以前知识(统计等)得到的样本

后验概率:收到一批样本

条件概率:已知类型,推断某事件的概率

模式识别中,通常是知道样本

6.2 贝叶斯决策

6.2.1.最小错误率贝叶斯决策

看

不管分到哪一类,分母相同,因此只看分子,属于哪一类,以及每个类中有某个元素的概率都可以通过统计得到。

分类规则:选择后验概率最大的

特别地,对于两类问题:比较

化成

这个

6.2.2.最小风险贝叶斯决策

疾病、火灾之类的问题,如果出现了但没检测到,可能是影响很大的。

对每个样本

这里

分类办法就是找

(0-1) 损失最小风险贝叶斯:L是单位阵的情况,退化成为最小错误率贝叶斯决策

6.2.3 正态分布的贝叶斯决策

继续考察最小错误率的贝叶斯,其判别函数是

二分类:判决边界是一个超曲面,特别地如果

错误率

在分类问题中,贝叶斯错误率是一个分类器对某个类别所能达到的最低的分类错误率。

这里

结论:最小错误率贝叶斯决策的错误率,反比于类间的马氏距离。

错误率估计

- 设计好的分类器:

- 先验概率未知——随机抽样

- 先验概率已知,决定抽取几个样本

- 未设计好分类器:

- 需要设计分类器,再估计性能

- 1、样本划分法:分两组,一组设计分类器,另一组用来检测。不同取法算错误率取平均。缺点:需要很大样本

- 2、留一法:样本划分法中

6.4 聂耳-皮尔逊决策

假设

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律