Hive简介

Hive是什么

Hive是构建在Hadoop之上的数据仓库平台。 Hive是一个SQL解析引擎,将SQL转译成MapReduce程序并在Hadoop上运行。 Hive是HDFS的一个文件目录,一个表名对应一个目录名,若该表是分区表,则分区值对应子目录名。

Hive的历史由来

Hive体系结构

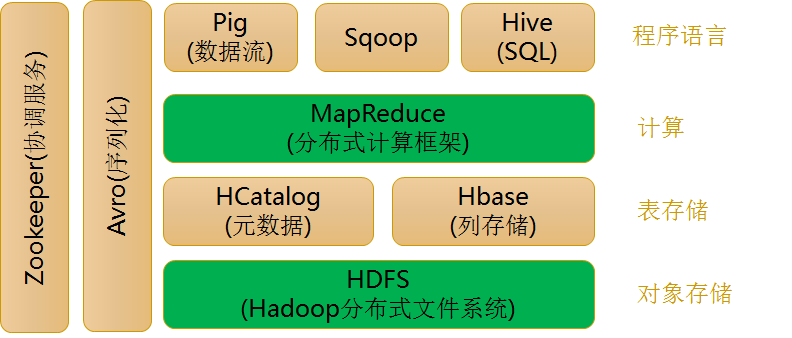

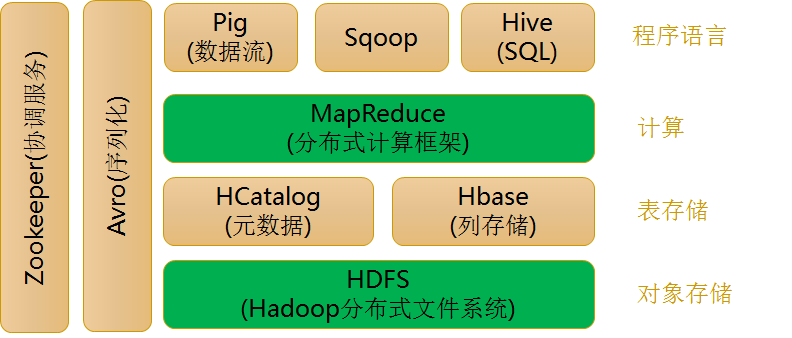

Hive在Hadoop中的位置

Hive设计特征

Hive 做为Hadoop 的数据仓库处理工具,它所有的数据都存储在Hadoop 兼容的文件系统中。

Hive 在加载数据过程中不会对数据进行任何的修改,只是将数据移动到HDFS 中Hive 设定的目录下,因此,Hive 不支持对数据的改写和添加,所有的数据都是在加载的时候确定的。

Hive 的设计特点如下:

支持索引,加快数据查询。 不同的存储类型,例如,纯文本文件、HBase 中的文件。 将元数据保存在关系数据库中,减少了在查询中执行语义检查时间。 可以直接使用存储在Hadoop 文件系统中的数据。 内置大量用户函数UDF 来操作时间、字符串和其他的数据挖掘工具,支持用户扩展UDF 函数来完成内置函数无法实现的操作。 类SQL 的查询方式,将SQL 查询转换为MapReduce 的job 在Hadoop集群上执行。 编码跟Hadoop同样使用UTF-8字符集。

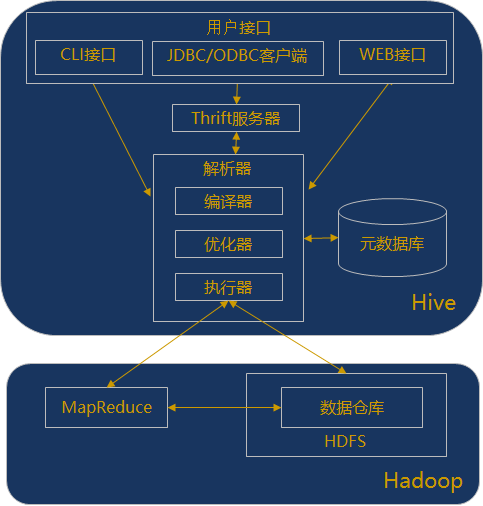

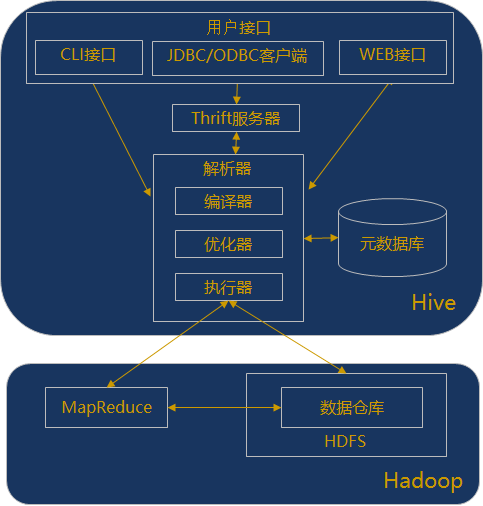

Hive体系结构

用户接口:

CLI:命令行界面,Cli 启动的时候,会同时启动一个 Hive 副本。 JDBC客户端:封装了Thrift,java应用程序,可以通过指定的主机和端口连接到在另一个进程中运行的hive服务器 ODBC客户端:ODBC驱动允许支持ODBC协议的应用程序连接到Hive。 WUI 接口:是通过浏览器访问 Hive Thrift服务器:

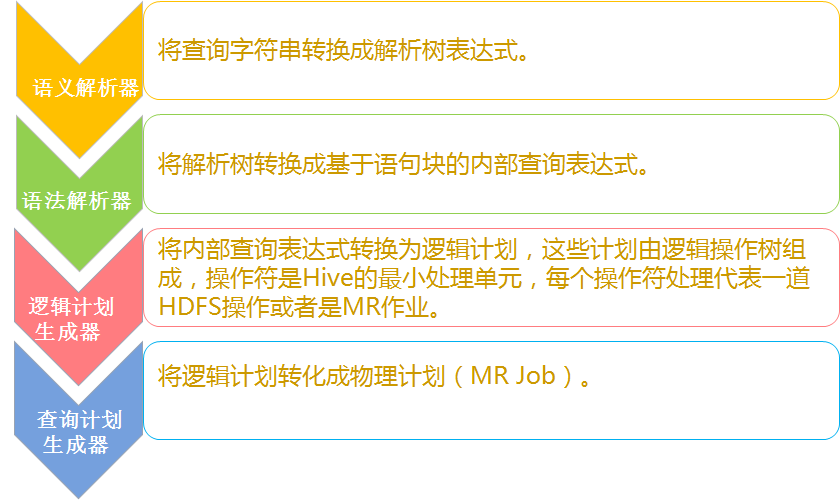

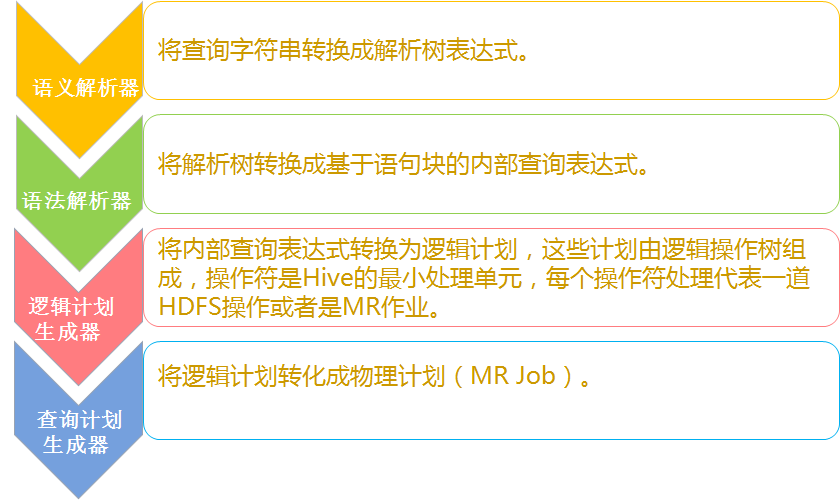

基于socket通讯,支持跨语言。Hive Thrift服务简化了在多编程语言中运行Hive的命令。绑定支持C++,Java,PHP,Python和Ruby语言。 解析器:

编译器:完成 HQL 语句从词法分析、语法分析、编译、优化以及执行计划的生成。 优化器是一个演化组件,当前它的规则是:列修剪,谓词下推。 执行器会顺序执行所有的Job。如果Task链不存在依赖关系,可以采用并发执行的方式执行Job。 元数据库:

Hive的数据由两部分组成:数据文件和元数据。元数据用于存放Hive库的基础信息,它存储在关系数据库中,如 mysql、derby。元数据包括:数据库信息、表的名字,表的列和分区及其属性,表的属性,表的数据所在目录等。 Hadoop:

Hive 的数据文件存储在 HDFS 中,大部分的查询由 MapReduce 完成。(对于包含 * 的查询,比如 select * from tbl 不会生成 MapRedcue 作业)

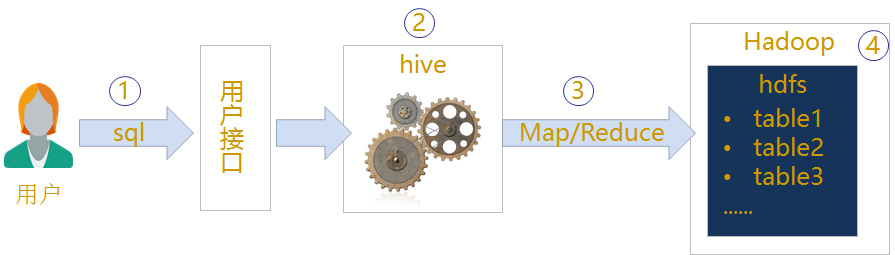

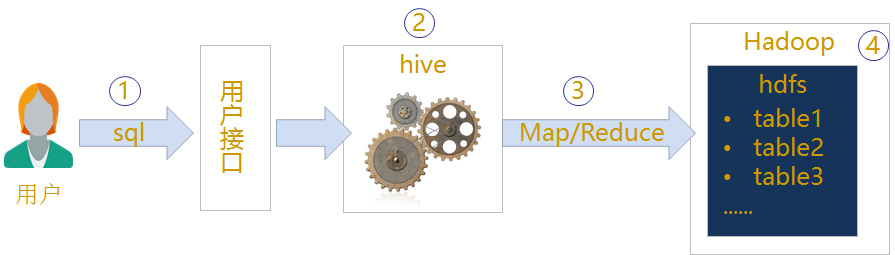

Hive运行机制

① 用户通过用户接口连接Hive,发布Hive SQL

② Hive解析查询并制定查询计划

③ Hive将查询转换成MapReduce作业

④ Hive在Hadoop上执行MapReduce作业

Hive适用场景

Hive的优势

- 解决了传统关系数据库在大数据处理上的瓶颈。适合大数据的批量处理。

- 充分利用集群的CPU计算资源、存储资源,实现并行计算。

- Hive支持标准SQL语法,免去了编写MR程序的过程,减少了开发成本。

- 具有良好的扩展性,拓展功能方便。

Hive的缺点

- Hive的HQL表达能力有限:有些复杂运算用HQL不易表达。

- Hive效率低:Hive自动生成MR作业,通常不够智能;HQL调优困难,粒度较粗;可控性差。

- 针对Hive运行效率低下的问题,促使人们去寻找一种更快,更具交互性的分析框架。 SparkSQL 的出现则有效的提高了Sql在Hadoop 上的分析运行效率。

Hive的应用场景

适用场景

不适用场景

- 复杂的机器学习算法

- 复杂的科学计算

- 联机交互式实时查询

Hive安装

参考:Hive伪分布式下安装