ol7.7安装部署4节点spark3.0.0分布式集群

为学习spark,虚拟机中开4台虚拟机安装spark3.0.0

底层hadoop集群已经安装好,见ol7.7安装部署4节点hadoop 3.2.1分布式集群学习环境

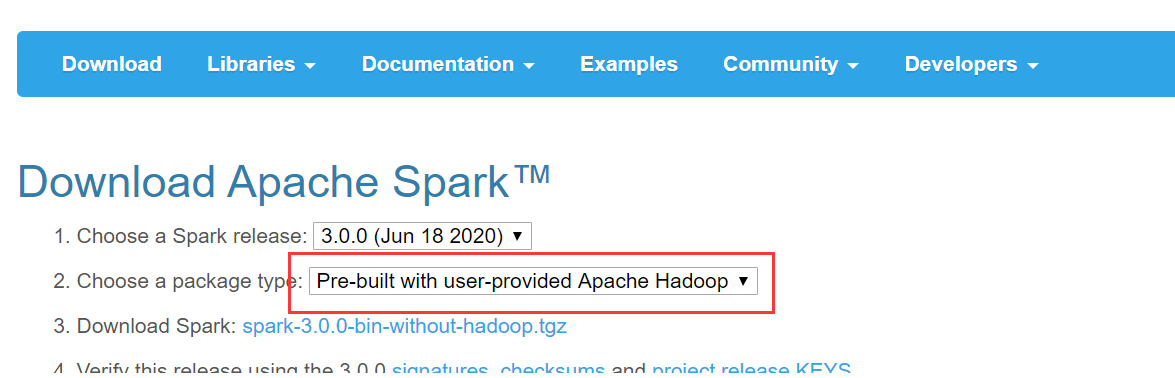

首先,去http://spark.apache.org/downloads.html下载对应安装包

解压

解压

1 2 3 4 | [hadoop@master ~]$ sudo tar -zxf spark-3.0.0-bin-without-hadoop.tgz -C /usr/local[hadoop@master ~]$ cd /usr/local[hadoop@master /usr/local]$ sudo mv ./spark-3.0.0-bin-without-hadoop/ spark[hadoop@master /usr/local]$ sudo chown -R hadoop: ./spark |

四个节点都添加环境变量

1 2 | export SPARK_HOME=/usr/local/sparkexport PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin |

配置spark

spark目录中的conf目录下cp ./conf/spark-env.sh.template ./conf/spark-env.sh后面添加

1 2 3 4 | export SPARK_MASTER_IP=192.168.168.11export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoopexport SPARK_LOCAL_DIRS=/usr/local/hadoopexport SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath) |

然后配置work节点,cp ./conf/slaves.template ./conf/slaves修改为

1 2 3 4 | masterslave1slave2slave3 |

写死JAVA_HOME,sbin/spark-config.sh最后添加

1 | export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_191 |

复制spark目录到其他节点

1 2 3 4 | sudo scp -r /usr/local/spark/ slave1:/usr/local/sudo scp -r /usr/local/spark/ slave2:/usr/local/sudo scp -r /usr/local/spark/ slave3:/usr/local/sudo chown -R hadoop ./spark/ |

...

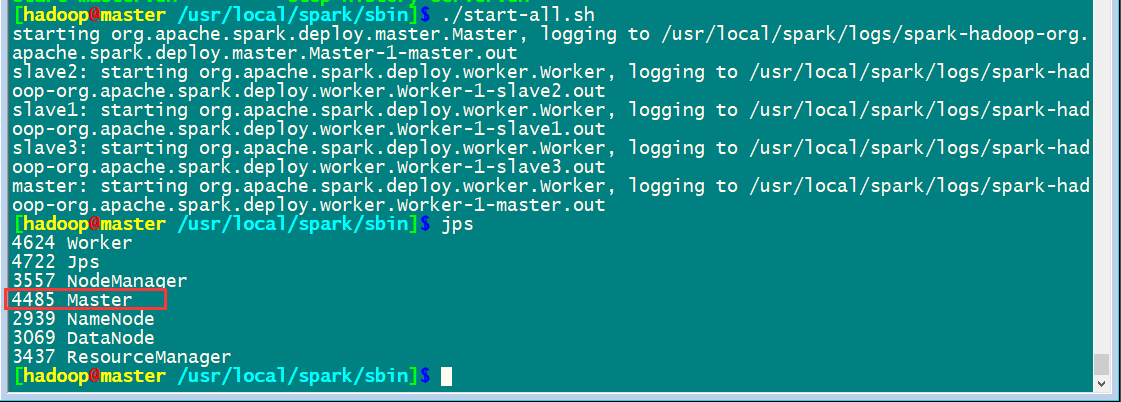

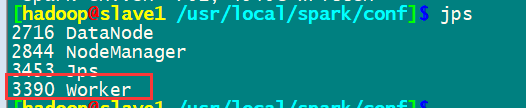

启动集群

先启动hadoop集群/usr/local/hadoop/sbin/start-all.sh

然后启动spark集群

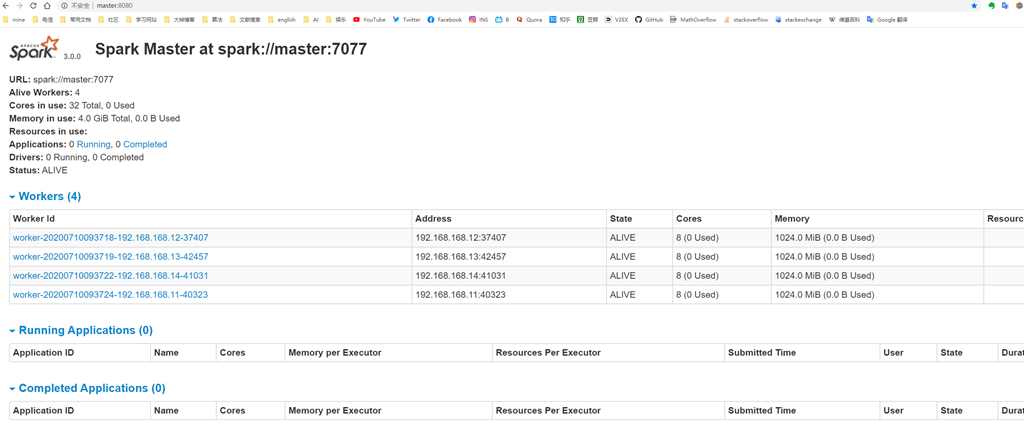

通过master8080端口监控

通过master8080端口监控

完成安装

作者:九命猫幺

博客出处:http://www.cnblogs.com/yongestcat/

欢迎转载,转载请标明出处。

如果你觉得本文还不错,对你的学习带来了些许帮助,请帮忙点击右下角的推荐

博客出处:http://www.cnblogs.com/yongestcat/

欢迎转载,转载请标明出处。

如果你觉得本文还不错,对你的学习带来了些许帮助,请帮忙点击右下角的推荐

【推荐】还在用 ECharts 开发大屏?试试这款永久免费的开源 BI 工具!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 软件产品开发中常见的10个问题及处理方法

· .NET 原生驾驭 AI 新基建实战系列:向量数据库的应用与畅想

· 从问题排查到源码分析:ActiveMQ消费端频繁日志刷屏的秘密

· 一次Java后端服务间歇性响应慢的问题排查记录

· dotnet 源代码生成器分析器入门

· ThreeJs-16智慧城市项目(重磅以及未来发展ai)

· .NET 原生驾驭 AI 新基建实战系列(一):向量数据库的应用与畅想

· Ai满嘴顺口溜,想考研?浪费我几个小时

· Browser-use 详细介绍&使用文档

· 软件产品开发中常见的10个问题及处理方法