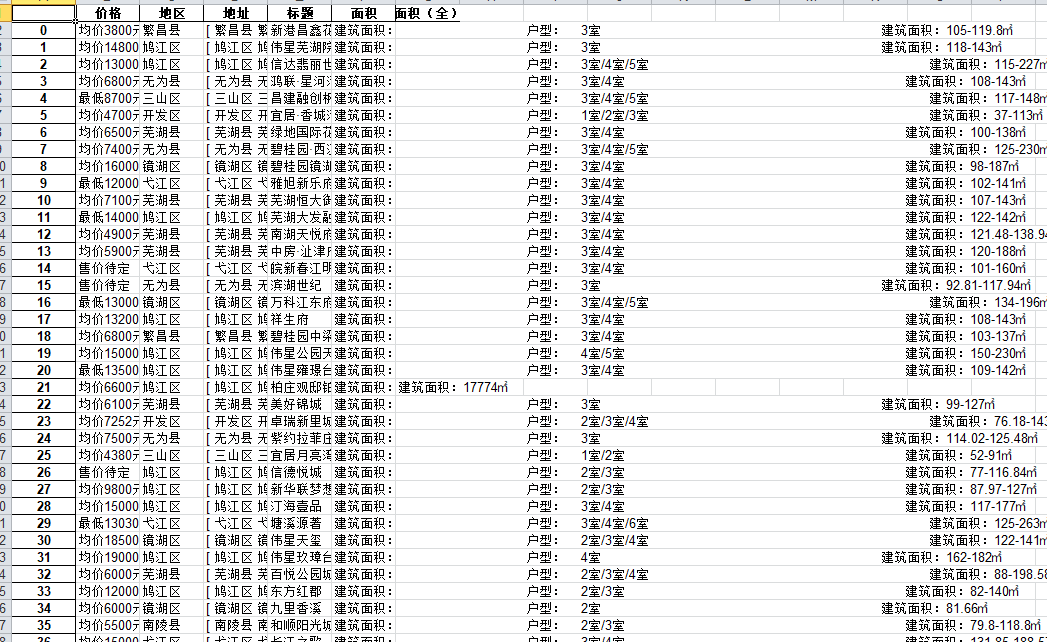

爬取安居客上芜湖房价

忘记在哪儿百度到的代码,学习一下

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 | import requestsfrom bs4 import BeautifulSoupimport timeheaders={'User-Agent':'Baiduspider'}total=[]def get_loupan(url): try: res=requests.get(url,headers=headers) soup=BeautifulSoup(res.text,'html.parser') titles=soup.find_all('span',class_='items-name') title=list(map(lambda x:x.text,titles)) dizhis=soup.find_all('span',class_='list-map') dizhi=list(map(lambda x:x.text,dizhis)) diqus=soup.find_all('span',class_='list-map') diqu=list(map(lambda x:x.text.split('\xa0')[1],diqus)) mianjis_quan=soup.find_all('a',class_='huxing') mianji_quan=list(map(lambda x:x.text,mianjis_quan)) mianjis=soup.find_all('a',class_='huxing') mianji=list(map(lambda x:x.text.split('\t')[-1].strip(),mianjis)) jiages=soup.find_all('a',class_='favor-pos') jiage=list(map(lambda x:x.p.text,jiages)) for tit,dizhi,diqu,mianq,mianj,jiage in zip(title,dizhi,diqu,mianji_quan,mianji,jiage): info={'标题':tit, '地址':dizhi, '地区':diqu, '面积(全)':mianq, '面积':mianj, '价格':jiage} total.append(info) except: print('') return totalif __name__ == '__main__': for i in range(1,21): url='https://wuh.fang.anjuke.com/loupan/all/p{}/'.format(i) get_loupan(url) print('第{}页抓取完毕'.format(i)) time.sleep(1)import pandas as pddf=pd.DataFrame(total)df.to_excel('安居客.xls') |

作者:九命猫幺

博客出处:http://www.cnblogs.com/yongestcat/

欢迎转载,转载请标明出处。

如果你觉得本文还不错,对你的学习带来了些许帮助,请帮忙点击右下角的推荐

博客出处:http://www.cnblogs.com/yongestcat/

欢迎转载,转载请标明出处。

如果你觉得本文还不错,对你的学习带来了些许帮助,请帮忙点击右下角的推荐

标签:

爬虫

【推荐】还在用 ECharts 开发大屏?试试这款永久免费的开源 BI 工具!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET制作智能桌面机器人:结合BotSharp智能体框架开发语音交互

· 软件产品开发中常见的10个问题及处理方法

· .NET 原生驾驭 AI 新基建实战系列:向量数据库的应用与畅想

· 从问题排查到源码分析:ActiveMQ消费端频繁日志刷屏的秘密

· 一次Java后端服务间歇性响应慢的问题排查记录

· 互联网不景气了那就玩玩嵌入式吧,用纯.NET开发并制作一个智能桌面机器人(四):结合BotSharp

· Vite CVE-2025-30208 安全漏洞

· 《HelloGitHub》第 108 期

· MQ 如何保证数据一致性?

· 一个基于 .NET 开源免费的异地组网和内网穿透工具