《Reinforcement Learning An Introduction》Richard S.Sutton && Andrew G.Barto

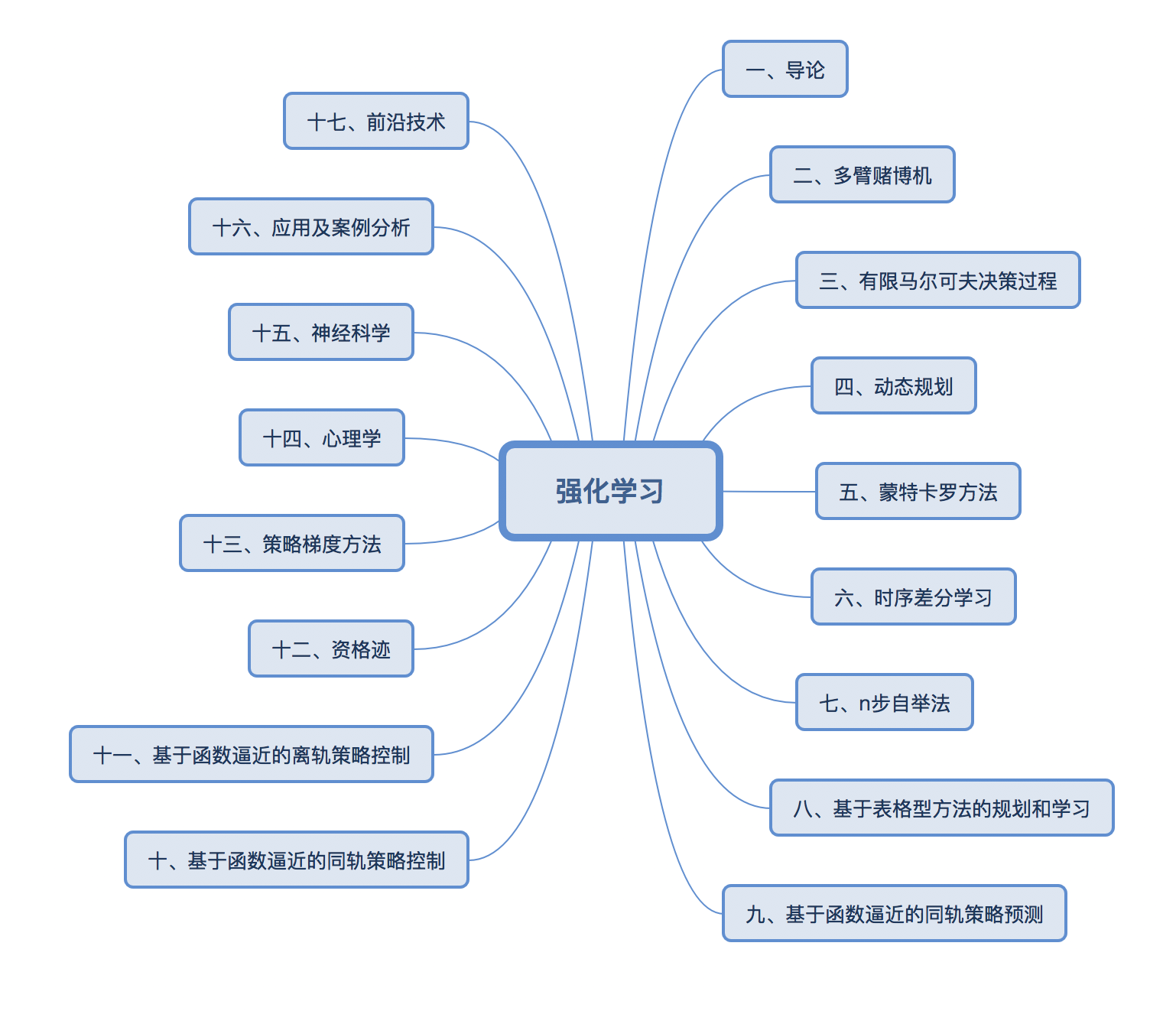

一、内容结构

二、笔记

第二章

- 有限马尔可夫决策的三个基本方法:动态规划、蒙特卡罗方法和时序差分学习

- K臂赌博机问题

- 动作的选择贪心,或者 $\epsilon$概率随机选择策略

- 增量式实现估计 $Q_{n+1}=Q_{n}+\frac{1}{n}[R_{n}-Q_{n}]$

- 估计的更新方式:新估计值 ← 旧估计值 + 步长 * [目标 - 旧估计值]

- 简单的多臂赌博机算法

- 如果收益平稳则$Q_{n}$可以用简单的平均法,对于非平稳收益,可以采用加权平均(距离当前收益越近权值越大)

- Upper confidence bound, UCB. $A_{t}=argmax_{t}[Q_{t}(a)+c\sqrt{\frac{lnt}{N_{t}(a)}}]$. 根号项为不确定性或方差的度量。$N_{t}$为选择动作a的次数。t为总次数。

- 随机梯度上学习实现赌博机算法$ H_{t+1}(a)=H_{t}(a)+\alpha (R_{t}-\bar{R_{t}})(I(a=A_{t})-\pi _{t}(a)) $

第52页

谢谢!