Cloudera Certified Associate Administrator案例之Configure篇

Cloudera Certified Associate Administrator案例之Configure篇

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

一.下载CDH集群中最新的配置文件

问题描述:

某个集群的使用者需要通过客户端登陆集群,请使用CM下载HDFS和YARN的配置文件,保存到客户端机器的"/home/yinzhengjie/hadoop/etc/hadoop"目录下,并保持文件名不变。

解决方案:

可以通过登陆CM WebUI界面下载,也可以直接登陆服务器进行下载。

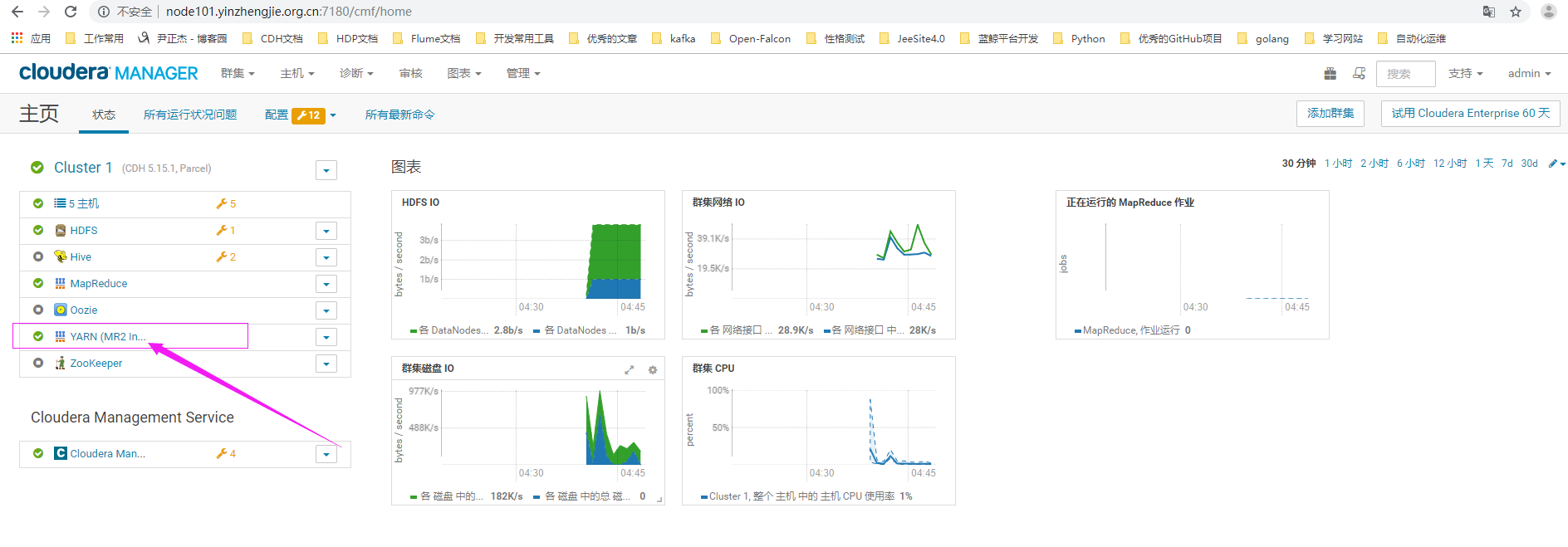

1>.使用正确的用户名密码登录CM界面,点击hdfs服务

2>. 下载HDFS的配置文件

3>.使用正确的用户名密码登录CM界面,点击yarn服务

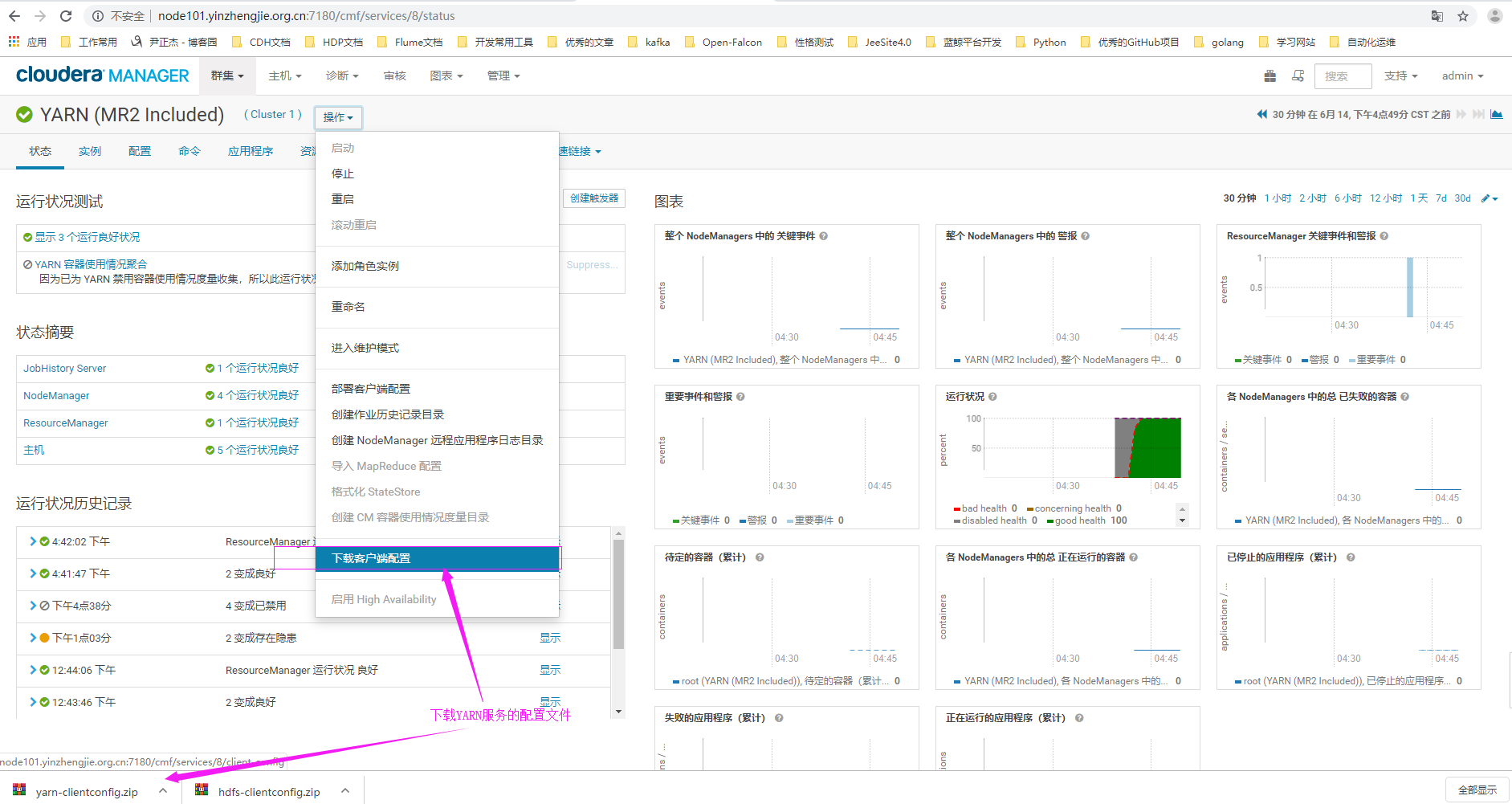

4>.下载YARN服务的配置文件

5>.查看集群后端存储配置文件的路径

[root@node101.yinzhengjie.org.cn ~]# ll /etc/hadoop/conf.cloudera.hdfs/ #HDFS集群存储路径 total 36 -rw-r--r-- 1 root root 19 Jun 14 12:27 __cloudera_generation__ -rw-r--r-- 1 root root 66 Jun 14 12:27 __cloudera_metadata__ -rw-r--r-- 1 root root 3556 Jun 14 12:27 core-site.xml -rw-r--r-- 1 root root 2696 Jun 14 12:27 hadoop-env.sh -rw-r--r-- 1 root root 1786 Jun 14 12:27 hdfs-site.xml -rw-r--r-- 1 root root 314 Jun 14 12:27 log4j.properties -rw-r--r-- 1 root root 315 Jun 14 12:27 ssl-client.xml -rw-r--r-- 1 root root 634 Jun 14 12:27 topology.map -rwxr-xr-x 1 root root 1594 Jun 14 12:27 topology.py [root@node101.yinzhengjie.org.cn ~]# [root@node101.yinzhengjie.org.cn ~]# [root@node101.yinzhengjie.org.cn ~]# [root@node101.yinzhengjie.org.cn ~]# ll /etc/hadoop/conf.cloudera.yarn/ #YARN集群存储路径 total 48 -rw-r--r-- 1 root root 21 Jun 14 12:42 __cloudera_generation__ -rw-r--r-- 1 root root 66 Jun 14 12:42 __cloudera_metadata__ -rw-r--r-- 1 root root 3869 Jun 14 12:42 core-site.xml -rw-r--r-- 1 root root 617 Jun 14 12:42 hadoop-env.sh -rw-r--r-- 1 root root 1786 Jun 14 12:42 hdfs-site.xml -rw-r--r-- 1 root root 314 Jun 14 12:42 log4j.properties -rw-r--r-- 1 root root 5154 Jun 14 12:42 mapred-site.xml -rw-r--r-- 1 root root 315 Jun 14 12:42 ssl-client.xml -rw-r--r-- 1 root hadoop 634 Jun 14 16:41 topology.map -rwxr-xr-x 1 root hadoop 1594 Jun 14 16:41 topology.py -rw-r--r-- 1 root root 3653 Jun 14 12:42 yarn-site.xml [root@node101.yinzhengjie.org.cn ~]# [root@node101.yinzhengjie.org.cn ~]#

二.限制HDFS服务的日志大小

问题描述:

根据管理要求,需要限制HDFS服务的日志大小。其限制为:NameNode服务保留4个日志文件,总量不超过8GB;Secondary NameNode 服务也保留4个日志文件,总量不超过8GB;两个服务总占用的磁盘空间 量不超过16GB。

解决方案:

单个服务的单个日志只要不超 过2GB,并将日志数设为4个,即可以满足要求。

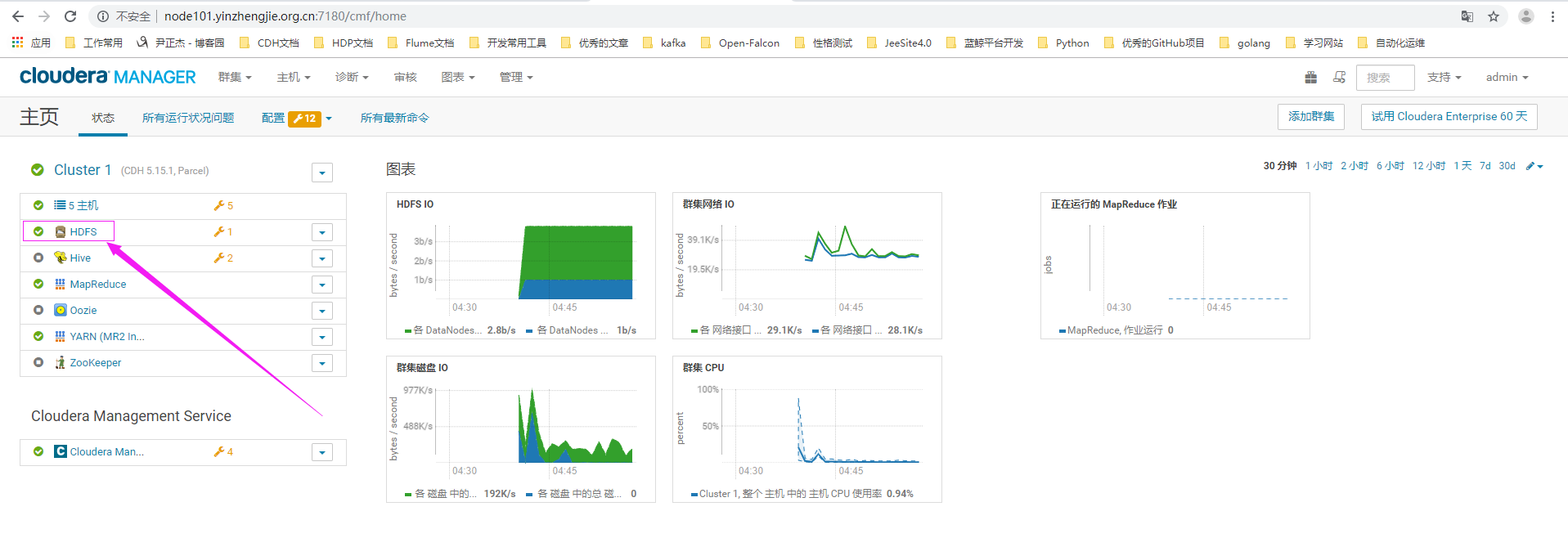

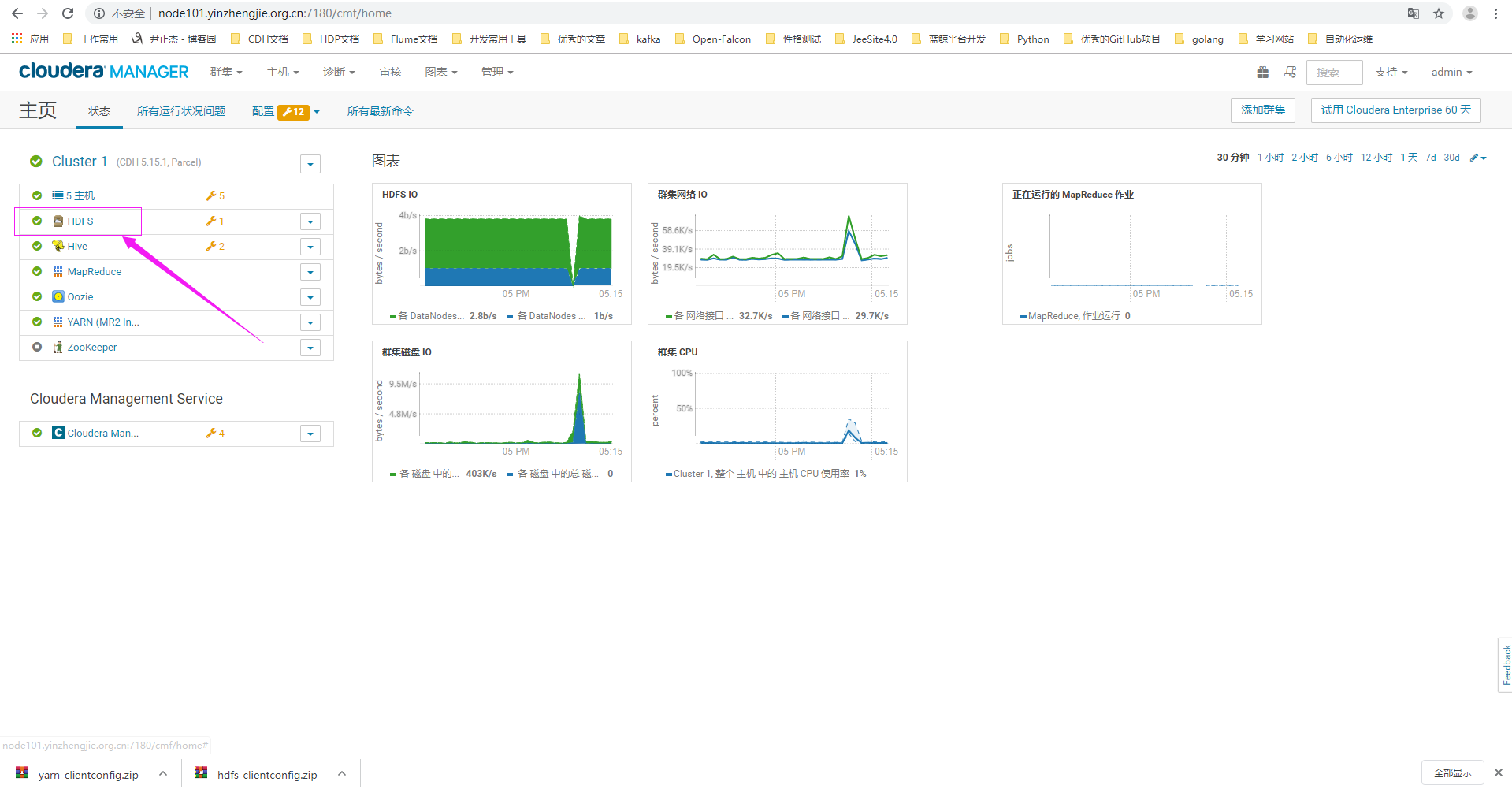

1>.使用正确的用户名密码登录CM界面,点击hdfs服务

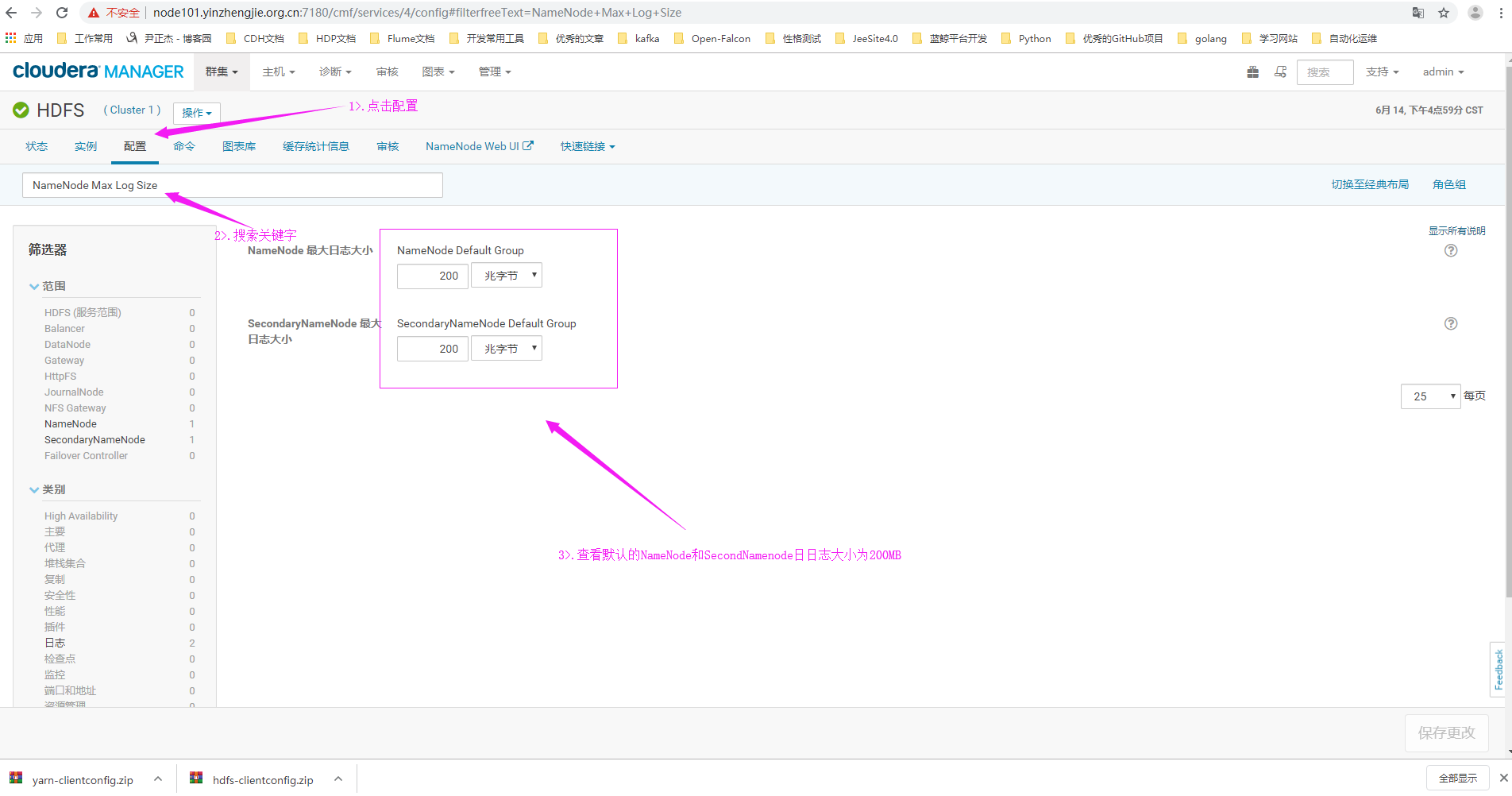

2>.搜索关键字“NameNode Max Log Size”

3>.修改默认值200MB为2GB并点击保存按钮

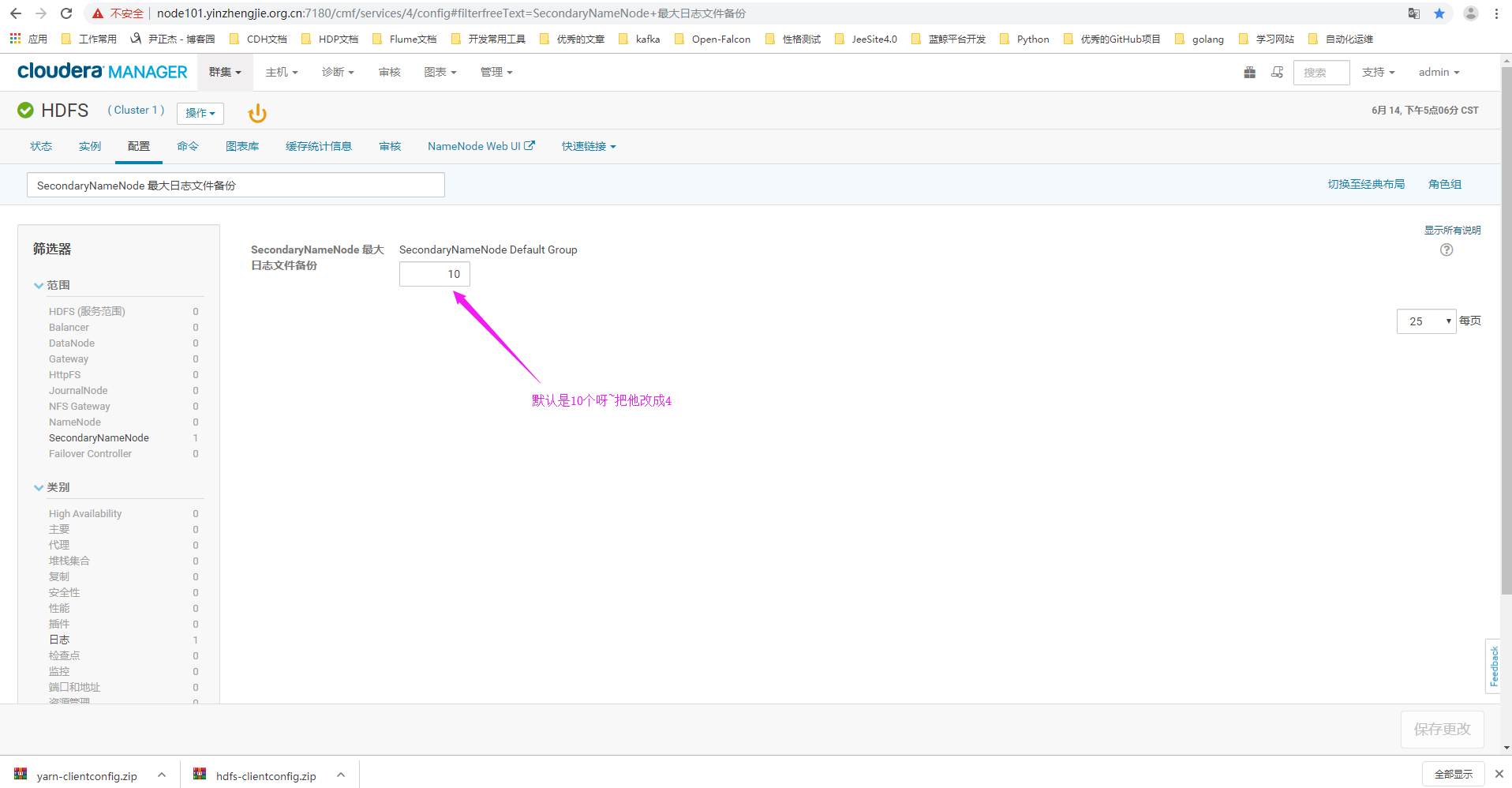

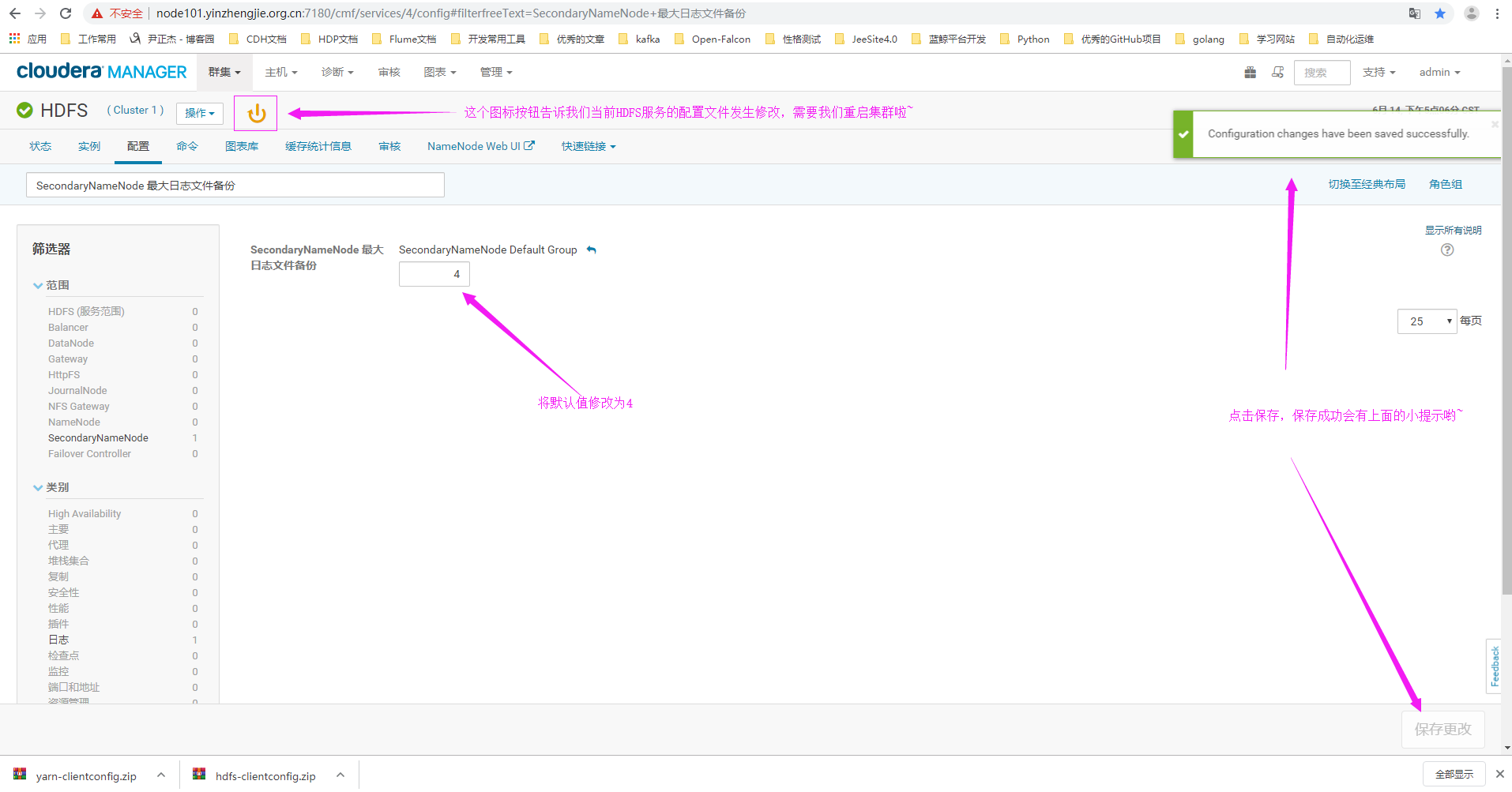

4>.搜索关键字“SecondaryNameNode Max Log Size”(中文对应:"SecondaryNameNode 最大日志文件备份")

5>.修改日志文件的备份数为4

6>.重启HDFS服务

三.修改Namenode的堆内存

问题描述:

集群承接了日志分析需求,将保存百万、千万数量级的文件,因 此需要扩大NameNode使用的堆内存,使其可以管理尽可能多的文件。物理内存的分配要求为:节点总物理内存为31GB,为系统服务保留的内存为6.2GB;NameNode和Secondary NameNode需设置相等大小的堆内存; 所有服务的堆内存均需要乘以1.3后计入总使用量中。需要为NameNode和相关服务配置尽可能大且满足要求的内存量,且不能触发任何警告。

解决方案:

根据计算(31 - 6.2) / 1.3 = 19,因此 NameNode和Secondary NameNode各可设置9.5GB的堆内存。

1>.使用正确的用户名密码登录CM界面,点击hdfs服务

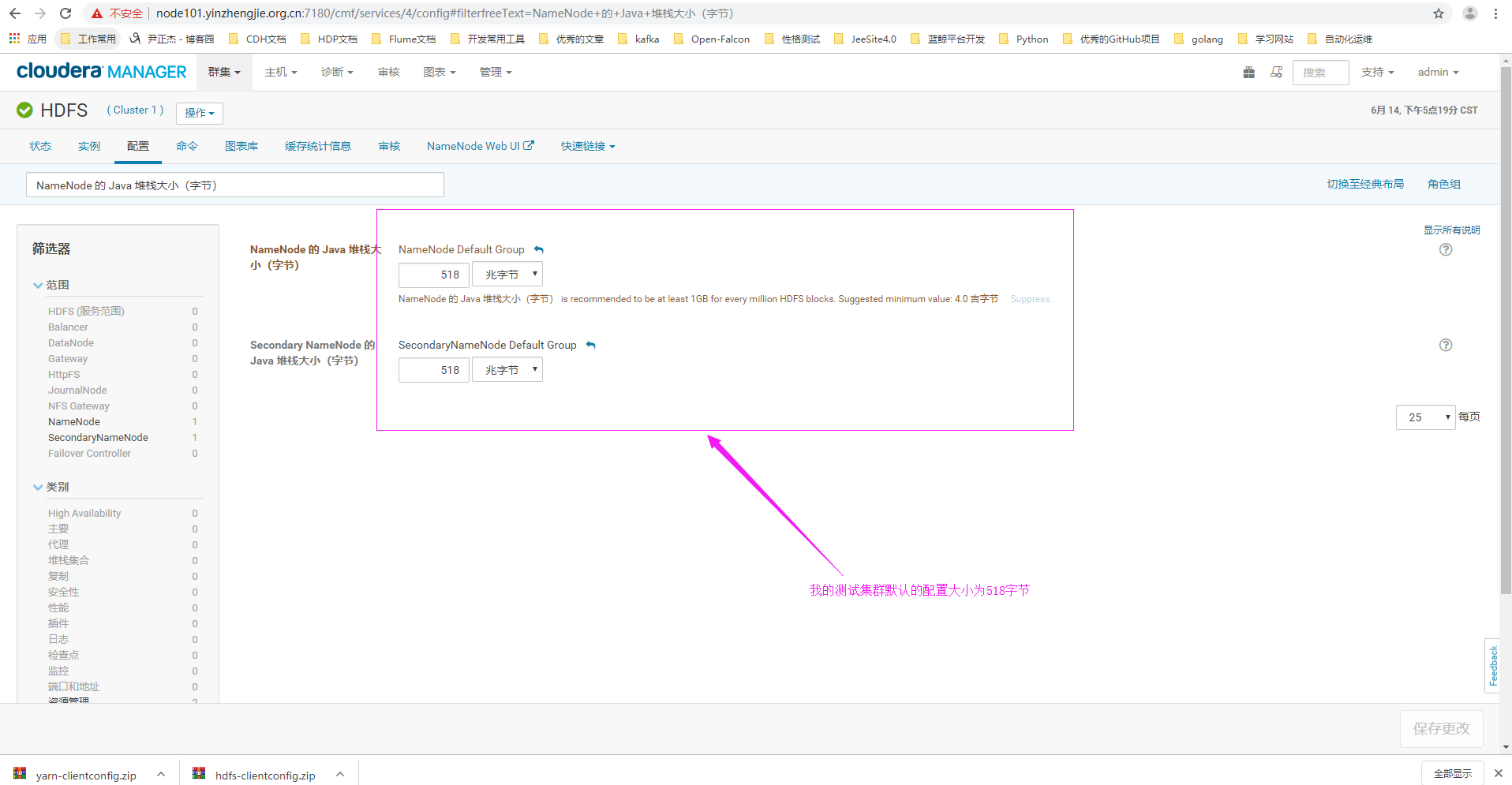

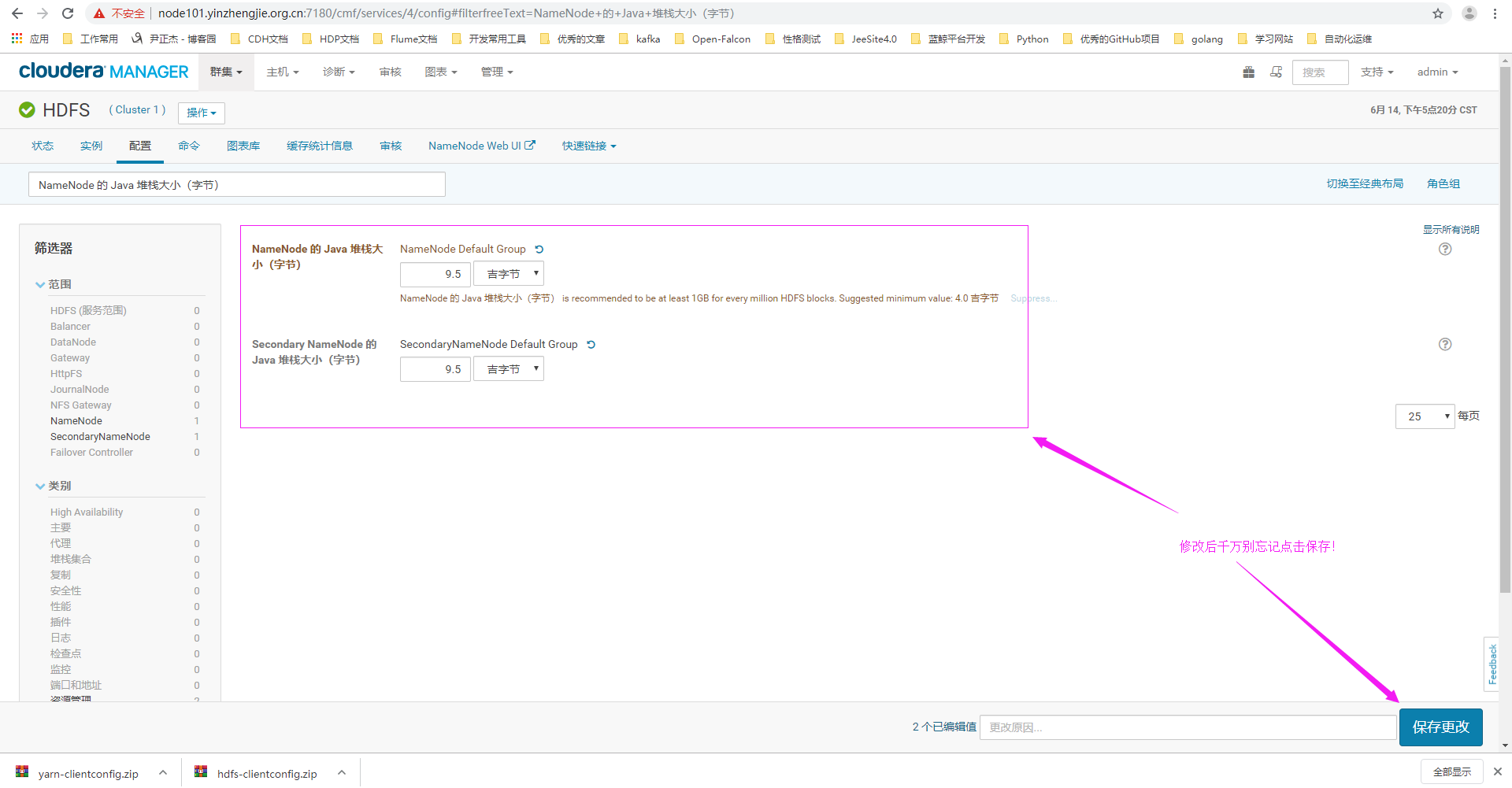

2>.点击配置,搜索关键字“Java Heap Size of NameNode in Bytes”(对应中文为:"NameNode 的 Java 堆栈大小(字节)")

3>.设置NameNode和SencondName的堆内存为9.5GB

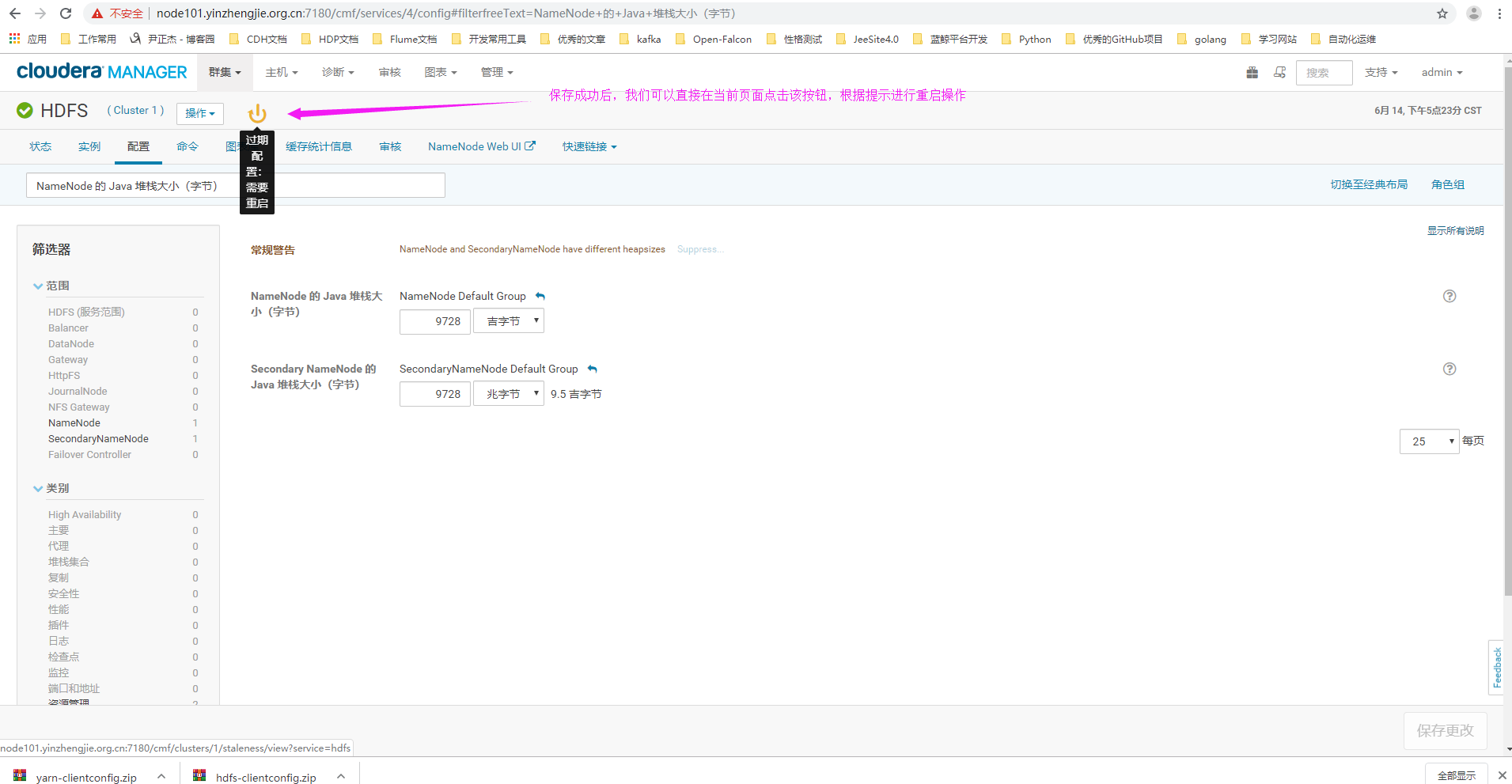

4>.重启HDFS集群(需要注意的是,如果我们设置的NameNode或者SecondNamenode的堆内存大小总和大于当前服务器内存时,我们在重启集群时会启动失败!)

四.开启回收站功能

问题描述:

在描述公司的运维策略时,有人提出如果误删了HDFS的文件系统,可能几天都不会出现,尤其时当周末前发生这样的情况时。为了提供足够的保护级别,你决定将HDFS数据删除后永久清除的时间改为7天。

解决方案:

我们直接在Cloudera Manager WebUI界面进行配置即可。除了配置回收站,还可以配置权限,副本书,块大小,balancer等。

1>.点击HDFS服务

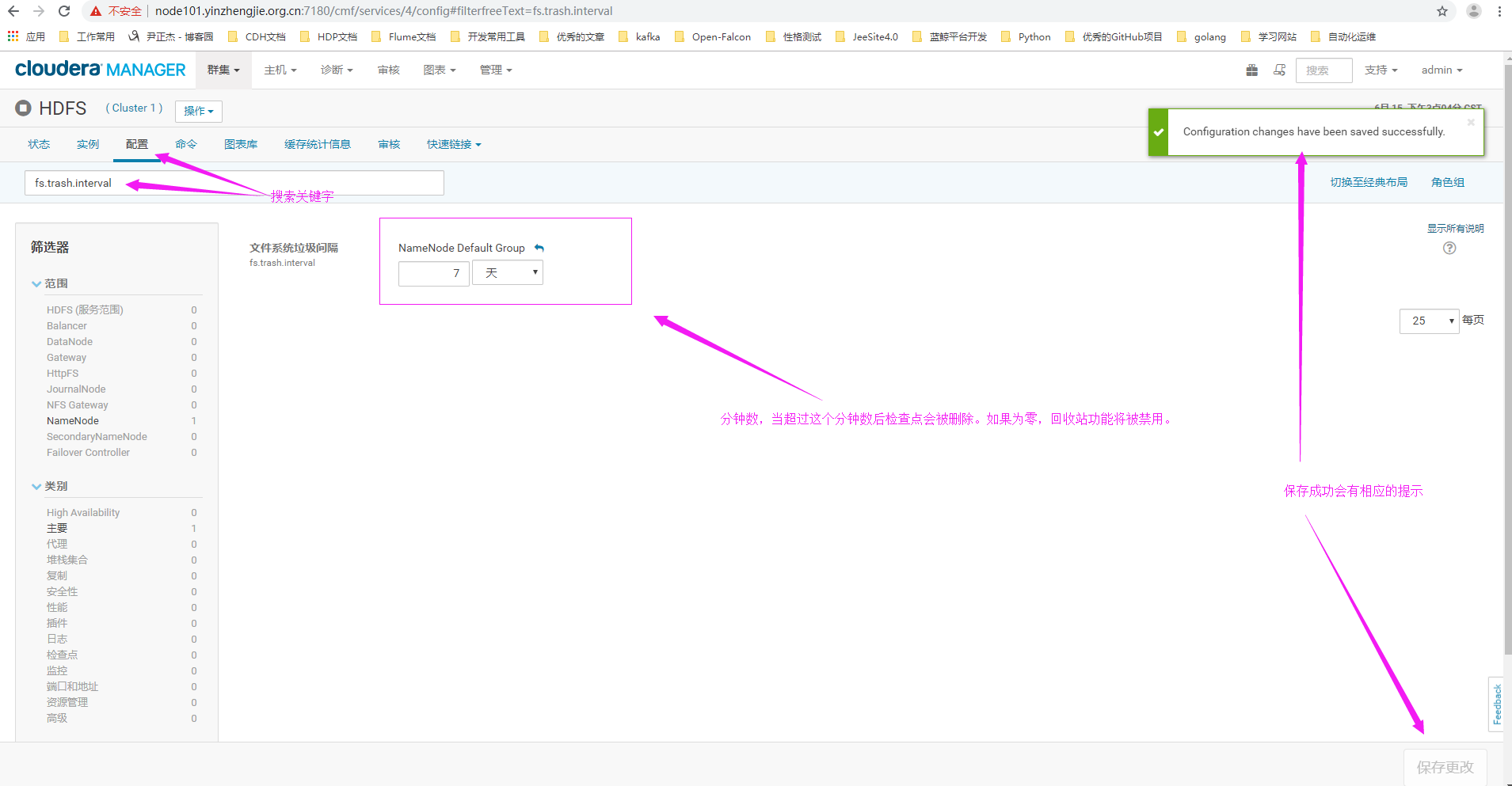

2>.点击配置,并搜索关键字"fs.trash.interval",修改其只为7天,即删除的文件在回收站中被保留的时间周期

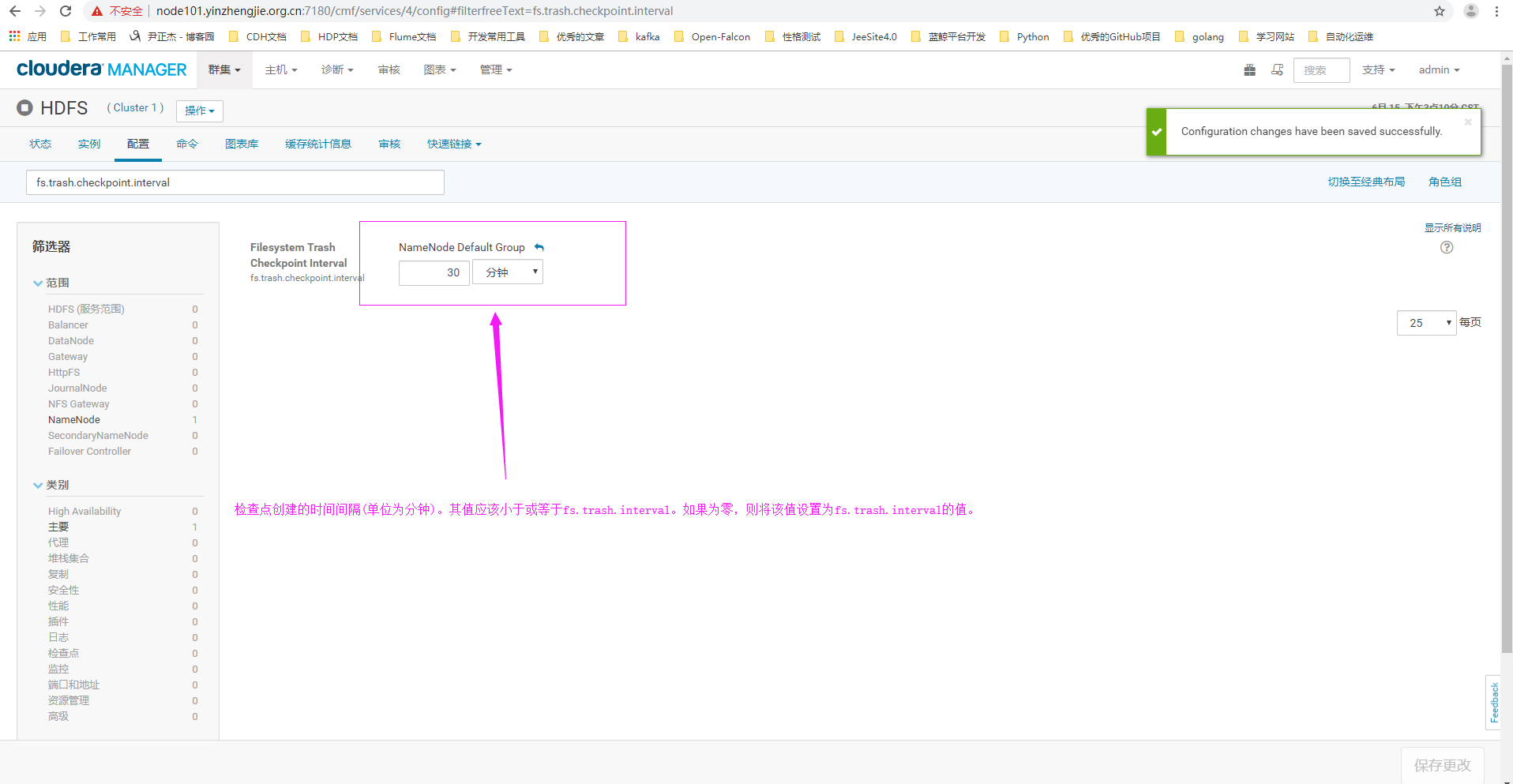

3>.搜索关键词"fs.trash.checkpoint.interval",即定义周期性检查回收站的文件是否过期的时间间隔,改值应该小于上面我们定义"fs.trash.interval"的值

五.

本文来自博客园,作者:尹正杰,转载请注明原文链接:https://www.cnblogs.com/yinzhengjie/p/10982541.html,个人微信: "JasonYin2020"(添加时请备注来源及意图备注,有偿付费)

当你的才华还撑不起你的野心的时候,你就应该静下心来学习。当你的能力还驾驭不了你的目标的时候,你就应该沉下心来历练。问问自己,想要怎样的人生。