Scrapy307重定向

最近在用Scrapy写爬虫,但是爬取有的网站时会出现307重定向的错误,使得无法爬取到正确网站,这往往是因为原网站采用了反爬虫机制导致的。

在StackOverFlow上有人提出了这个问题:scrapy 307 redirects to same page

这里的答案指出了307是Cookie的问题,它的建议是打开Cookie,并需要自己分析哪些是网站真正需要的用来鉴别是机器访问还是认为访问的数据。

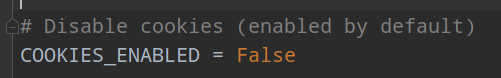

然而在Scrapy中,如果没有额外设置,默认情况下Cookie是打开的,对于我的情况,恰好是需要关闭Cookie即可,即在settings.py中,加入如下一句话:

是否是我这种情况,可以通过一个简单的方式来鉴别,请仔细看红框部分,即真实爬取的网页的URL后面比起预先定义的URL多了个UUID和vid,那么就表示开启了cookie,使用上述方式关闭即可。