超参数优化

什么是超参数

所谓超参数,就是机器学习模型里面的框架参数,比如聚类方法里面类的个数,或者话题模型里面话题的个数等等,都称为超参数。它们跟训练过程中学习的参数(权重)是不一样的,通常是手工设定,不断试错调整,或者对一系列穷举出来的参数组合一通枚举(叫做网格搜索)。深度学习和神经网络模型,有很多这样的参数需要学习,这就是为什么过去这么多年从业者弃之不顾的原因。以前给人的印象,深度学习就是“黑魔法”。时至今日,非参数学习研究正在帮助深度学习更加自动的优化模型参数选择,当然有经验的专家仍然是必须的。

超参数调试处理

- 在机器学习领域,超参数比较少的情况下,我们之前利用设置网格点的方式来调试超参数;

- 但在深度学习领域,超参数较多的情况下,不是设置规则的网格点,而是随机选择点进行调试。这样做是因为在我们处理问题的时候,是无法知道哪个超参数是更重要的,所以随机的方式去测试超参数点的性能,更为合理,这样可以探究更超参数的潜在价值。

如果在某一区域找到一个效果好的点,将关注点放到点附近的小区域内继续寻找。

为超参数选择合适的范围

Scale均匀随机

在超参数选择的时候,一些超参数是在一个范围内进行均匀随机取值,如隐藏层神经元结点的个数、隐藏层的层数等。但是有一些超参数的选择做均匀随机取值是不合适的,这里需要按照一定的比例在不同的小范围内进行均匀随机取值,以学习率α的选择为例,在0.001,…,1范围内进行选择:

如上图所示,如果在 0.001,…,1 的范围内进行进行均匀随机取值,则有90%的概率 选择范围在 0.1∼1 之间,而只有10%的概率才能选择到0.001∼0.1之间,显然是不合理的。

所以在选择的时候,在不同比例范围内进行均匀随机取值,如0.001∼0.001、0.001∼0.01、0.01∼0.1、0.1∼1 范围内选择。

超参数调试实践–Pandas vs. Caviar

在超参数调试的实际操作中,我们需要根据我们现有的计算资源来决定以什么样的方式去调试超参数,进而对模型进行改进。下面是不同情况下的两种方式:

- 在计算资源有限的情况下,使用第一种,仅调试一个模型,每天不断优化;

- 在计算资源充足的情况下,使用第二种,同时并行调试多个模型,选取其中最好的模型。

本系列博客系人工智能社区(www.studyai.com)推出的视频课程<<scikit-learn从0到1全面掌握>>的教案,均为授课老师 Antares博士 原创。我们允许进行全文链接式转载,但必须注明出处与原始链接。

链接:http://www.studyai.com/article/2fd97e83c5474bba

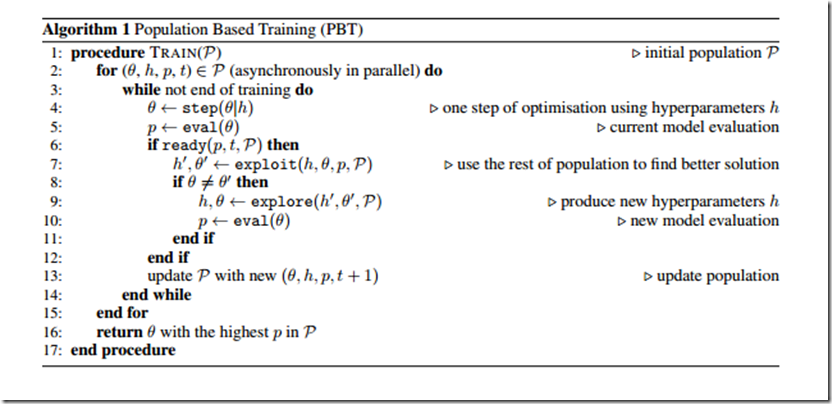

DeepMind提出新型超参数最优化方法:性能超越手动调参和贝叶斯优化

《Population Based Training of Neural Networks》

参考文献:

1.http://blog.csdn.net/yc1203968305/article/details/78503480