24. mysql实战

24.1 集群要求

1.搭建一个主N从的MYsql集群

2.从节点可以水平扩展

3.所有的写操作,都只能在主节点Master上执行

4.所有的读操作可以在所有节点上执行

1、配置并安装好Master节点的Mysql

2、通过XtraBackup将Master节点的数据备份到指定目录

3、将第2步备份出来的目录,连同备份信息文件,拷贝到Slave的 /var/lib/mysql,然后执行CHANGE MASTER TO指令

4、启动Slave节点,执行START SLAVE指令

5、在这个集群中添加更多的Slave节点

Master 节点和 Slave 节点需要有不同的配置文件

Master 节点和 Slave 节点需要能够传输备份信息文件

第一次启动 Slave 节点,需要执行一些初始化SQL操作

24.2 ConfigMap 为 Master/Slave 节点分配不同的配置文件

root@k8s-master1:~/k8s-data/yaml/magedu/mysql

apiVersion: v1

kind: ConfigMap

metadata:

name: mysql

namespace: mysql-cluster

labels:

app: mysql

data:

master.cnf: |

[mysqld]

log-bin

log_bin_trust_function_creators=1

lower_case_table_names=1

slave.cnf: |

[mysqld]

super-read-only

log_bin_trust_function_creators=1

这里我们定义了 master.cnf 和 slave.cnf 两个MySQL的配置文件

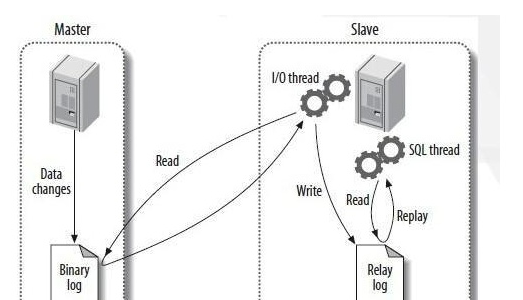

master.cnf 开启了 log-bin,即: 使用二进制日志文件的方式进行主从复制。

slave.cnf 开启了 super-read-only,表示从节点拒绝除了主节点的数据同步操作之外的所有写操作,即它对用户是只读的

创建ConfigMap查看状态

root@k8s-master1:~

root@k8s-master1:~

NAME DATA AGE

kube-root-ca.crt 1 5h10m

mysql 2 5h10m

24.3 Secret 为集群配置密码

root@k8s-master1:~

---

apiVersion: v1

kind: Secret

metadata:

name: mysql-secret

namespace: mysql

labels:

app: mysql

type : Opaque

data:

password: dVVOMzgjJXBx

24.4 Service 为 StatefulSet和用户提供服务发现

root@k8s-master1:~

apiVersion: v1

kind: Service

metadata:

namespace: mysql-cluster

name: mysql

labels:

app: mysql

spec:

ports:

- name: mysql

port: 3306

clusterIP: None

selector:

app: mysql

---

apiVersion: v1

kind: Service

metadata:

name: mysql-read

namespace: mysql-cluster

labels:

app: mysql

spec:

ports:

- name: mysql

port: 3306

selector:

app: mysql

配置介绍:

两个Service 都代理了所有携带 app=mysql 标签的 Pod,也就是所有的 MySQL Pod。端口映射都是用 Service 的3306端口对应 Pod 的 3306 端口

一个名叫 “mysql” Service 是 Headless Service (即:clusterIP=None)。它的作用是通过为 Pod 分配 DNS 记录来固定 Pod 集群,比如 “mysql-0.mysql” 和 “mysql-1.mysql” 这样的 DNS 名字。其中, “mysql-0.mysql” 的节点就是我们的主节点;

名叫 “mysql-read” 的 Service 是一个常规的 Service规定,所有用户的读请求必须访问名叫 “mysql-read” 的Service被分配的DNS记录上,这样,读请求就可以转发到任意一个 MySQL 的主节点或者从节点上;所有用户的写请求,则必须访问到 MySQL 的主节点,即 “mysql-0.mysql” 这条 DNS 记录

root@k8s-master1:~

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

mysql ClusterIP None <none> 3306/TCP 5h17m

mysql-read ClusterIP 10.100.62.232 <none> 3306/TCP 5h17m

24.5 准备存储PV NFS

root@k8s-deploy-ha:~

root@k8s-master1:~/k8s-data/yaml/magedu/mysql/pv

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: mysql-datadir-1

namespace: mysql-cluster

spec:

capacity:

storage: 50Gi

accessModes:

- ReadWriteOnce

nfs:

path: /data/k8sdata/mysql-datadir-1

server: 10.0.0.109

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: mysql-datadir-2

namespace: mysql-cluster

spec:

capacity:

storage: 50Gi

accessModes:

- ReadWriteOnce

nfs:

path: /data/k8sdata/mysql-datadir-2

server: 10.0.0.109

24.6 使用 StatefulSet 搭建 MySQL 集群

root@k8s-master1:~/k8s-data/yaml/magedu/mysql

root@k8s-master1:~

root@k8s-master1:~

root@k8s-master1:~

root@k8s-master1:~

root@k8s-master1:~

root@k8s-master1:~

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: mysql

namespace: mysql-cluster

spec:

selector:

matchLabels:

app: mysql

serviceName: mysql

replicas: 3

template:

metadata:

labels:

app: mysql

spec:

initContainers:

- name: init-mysql

image: harbor.nbrhce.com/demo/mysql:5.7.36

command :

- bash

- "-c"

- |

set -ex

[[ `hostname` =~ -([0-9]+)$ ]] || exit 1

ordinal=${BASH_REMATCH[1]}

echo [mysqld] > /mnt/conf.d/server-id.cnf

echo server-id=$((100 + $ordinal )) >> /mnt/conf.d/server-id.cnf

if [[ $ordinal -eq 0 ]]; then

cp /mnt/config-map/master.cnf /mnt/conf.d/

else

cp /mnt/config-map/slave.cnf /mnt/conf.d/

fi

volumeMounts:

- name: conf

mountPath: /mnt/conf.d

- name: config-map

mountPath: /mnt/config-map

- name: clone-mysql

image: harbor.nbrhce.com/demo/xtrabackup:1.0

command :

- bash

- "-c"

- |

set -ex

[[ -d /var/lib/mysql/mysql ]] && exit 0

[[ `hostname` =~ -([0-9]+)$ ]] || exit 1

ordinal=${BASH_REMATCH[1]}

[[ $ordinal -eq 0 ]] && exit 0

ncat --recv-only mysql-$(($ordinal -1 )).mysql 3307 | xbstream -x -C /var/lib/mysql

xtrabackup --prepare --target-dir=/var/lib/mysql

volumeMounts:

- name: data

mountPath: /var/lib/mysql

subPath: mysql

- name: conf

mountPath: /etc/mysql/conf.d

containers:

- name: mysql

image: harbor.nbrhce.com/demo/mysql:5.7.36

env :

- name: MYSQL_ALLOW_EMPTY_PASSWORD

value: "1"

ports:

- name: mysql

containerPort: 3306

volumeMounts:

- name: data

mountPath: /var/lib/mysql

subPath: mysql

- name: conf

mountPath: /etc/mysql/conf.d

resources:

requests:

cpu: 500m

memory: 1Gi

livenessProbe:

exec :

command : ["mysqladmin" , "ping" ]

initialDelaySeconds: 30

periodSeconds: 10

timeoutSeconds: 5

readinessProbe:

exec :

command : ["mysql" , "-h" , "127.0.0.1" , "-e" , "SELECT 1" ]

initialDelaySeconds: 5

periodSeconds: 2

timeoutSeconds: 1

- name: xtrabackup

image: harbor.nbrhce.com/demo/xtrabackup:1.0

ports:

- name: xtrabackup

containerPort: 3307

command :

- bash

- "-c"

- |

set -ex

cd /var/lib/mysql

if [[ -f xtrabackup_slave_info ]]; then

mv xtrabackup_slave_info change_master_to.sql.in

rm -f xtrabackup_binlog_info

elif [[ -f xtrabackup_binlog_info ]]; then

[[ `cat xtrabackup_binlog_info` =~ ^(.*?)[[:space:]]+(.*?)$ ]] || exit 1

rm xtrabackup_binlog_info

echo "CHANGE MASTER TO MASTER_LOG_FILE='${BASH_REMATCH[1]} ',\

MASTER_LOG_POS=${BASH_REMATCH[2]} " > change_master_to.sql.in

fi

if [[ -f change_master_to.sql.in ]]; then

echo "Waiting for mysqld to be ready (accepting connections)"

until mysql -h 127.0.0.1 -e "SELECT 1" ; do sleep 1; done

echo "Initializing replication from clone position"

mv change_master_to.sql.in change_master_to.sql.orig

mysql -h 127.0.0.1 <<EOF

$(<change_master_to.sql.orig),

MASTER_HOST='mysql-0.mysql',

MASTER_USER='root',

MASTER_PASSWORD='',

MASTER_CONNECT_RETRY=10;

START SLAVE;

EOF

fi

exec ncat --listen --keep-open --send-only --max-conns=1 3307 -c \

"xtrabackup --backup --slave-info --stream=xbstream --host=127.0.0.1 --user=root"

volumeMounts:

- name: data

mountPath: /var/lib/mysql

subPath: mysql

- name: conf

mountPath: /etc/mysql/conf.d

resources:

requests:

cpu: 100m

memory: 100Mi

volumes:

- name: conf

emptyDir: {}

- name: config-map

configMap:

name: mysql

volumeClaimTemplates:

- metadata:

name: data

namespace: mysql-cluster

spec:

accessModes: ["ReadWriteMany" ]

resources:

requests:

storage: 10Gi