自然语言处理预训练——词的相似性和类比任务

在 14.4节中,我们在一个小的数据集上训练了一个word2vec模型,并使用它为一个输入词寻找语义相似的词。实际上,在大型语料库上预先训练的词向量可以应用于下游的自然语言处理任务,这将在后面的 15节中讨论。为了直观地演示大型语料库中预训练词向量的语义,让我们将预训练词向量应用到词的相似性和类比任务中。

加载预训练词向量

以下列出维度为50、100和300的预训练GloVe嵌入,可从GloVe网站下载。预训练的fastText嵌入有多种语言。这里我们使用可以从fastText网站下载300维度的英文版本(“wiki.en”)。

#@save

d2l.DATA_HUB['glove.6b.50d'] = (d2l.DATA_URL + 'glove.6B.50d.zip',

'0b8703943ccdb6eb788e6f091b8946e82231bc4d')

#@save

d2l.DATA_HUB['glove.6b.100d'] = (d2l.DATA_URL + 'glove.6B.100d.zip',

'cd43bfb07e44e6f27cbcc7bc9ae3d80284fdaf5a')

#@save

d2l.DATA_HUB['glove.42b.300d'] = (d2l.DATA_URL + 'glove.42B.300d.zip',

'b5116e234e9eb9076672cfeabf5469f3eec904fa')

#@save

d2l.DATA_HUB['wiki.en'] = (d2l.DATA_URL + 'wiki.en.zip',

'c1816da3821ae9f43899be655002f6c723e91b88')

为了加载这些预训练的GloVe和fastText嵌入,我们定义了以下TokenEmbedding类。

下面我们加载50维GloVe嵌入(在维基百科的子集上预训练)。创建TokenEmbedding实例时,如果尚未下载指定的嵌入文件,则必须下载该文件。

glove_6b50d = TokenEmbedding('glove.6b.50d')

Downloading ../data/glove.6B.50d.zip from http://d2l-data.s3-accelerate.amazonaws.com/glove.6B.50d.zip...

输出词表大小。词表包含400000个词(词元)和一个特殊的未知词元。

len(glove_6b50d)

400001

我们可以得到词表中一个单词的索引,反之亦然。

glove_6b50d.token_to_idx['beautiful'], glove_6b50d.idx_to_token[3367]

(3367, 'beautiful')

应用预训练词向量

使用加载的GloVe向量,我们将通过下面的词相似性和类比任务中来展示词向量的语义。

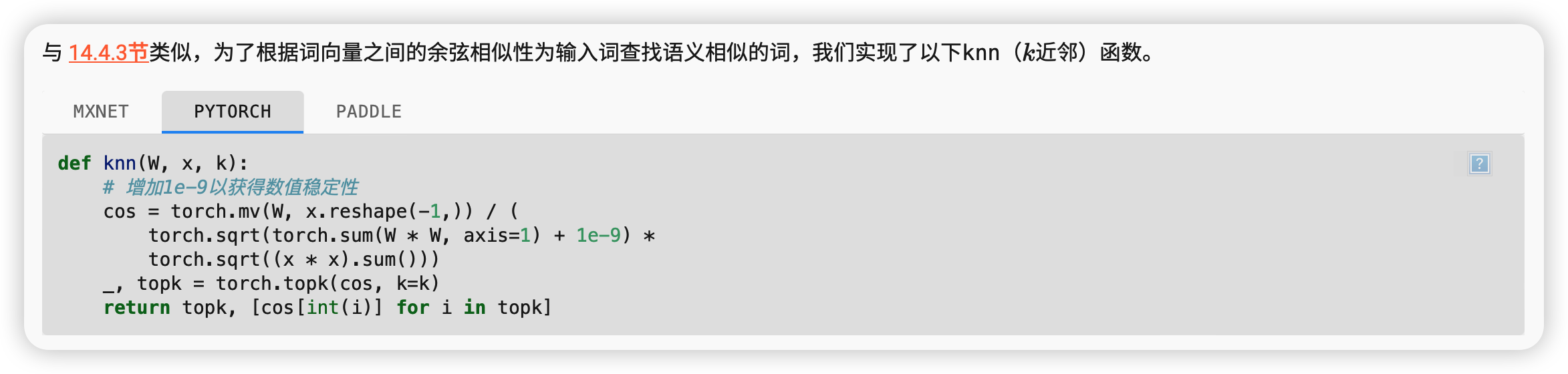

词相似性

- 计算输入向量 x 与数据集 W 中各个向量的余弦相似度。

- 对余弦相似度进行归一化处理,以避免数值不稳定性。

- 选取相似度最高的前 k 个向量,并返回它们的索引和相似度值。

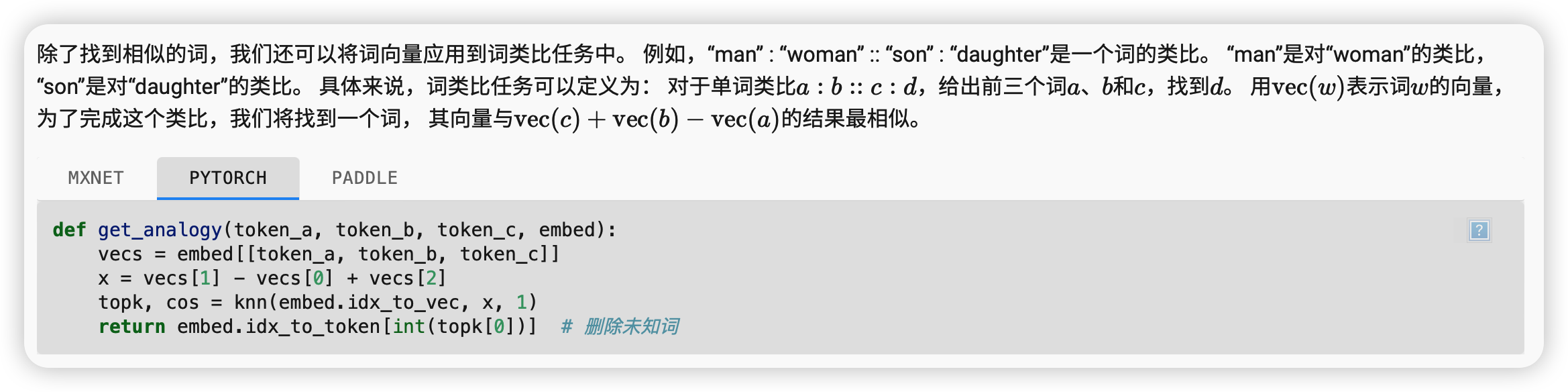

词类比

总结

-

在实践中,在大型语料库上预先练的词向量可以应用于下游的自然语言处理任务。

-

预训练的词向量可以应用于词的相似性和类比任务。

浙公网安备 33010602011771号

浙公网安备 33010602011771号