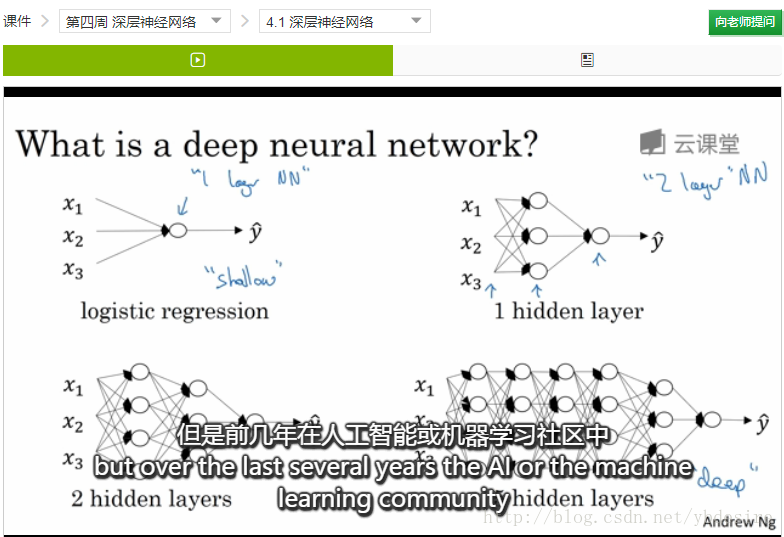

深层神经网络与浅层神经网络的区别

熟悉神经网络的可能知道,Hornik在1989年,就证明了一个定理:

- 只需一个包含足够多神经元的隐层,多层前馈神经网络就能以任意精度逼近任意复杂的连续函数

那大家可能就会有疑问:既然一个隐层就够了,我们为什么还需要多层神经网络呢?

我们可以从这个定理中找到可能思考方式:

- (1)足够多神经元,你在实践中能保证么?

- (2)如果你要拟合的模型并不是连续函数,单个隐层够吗?

显然,这两个问题的回答都是否定的。

如果觉得我这个解释过于粗糙,可以看Andrew Ng在新课程”Deep Learning”中的解释。

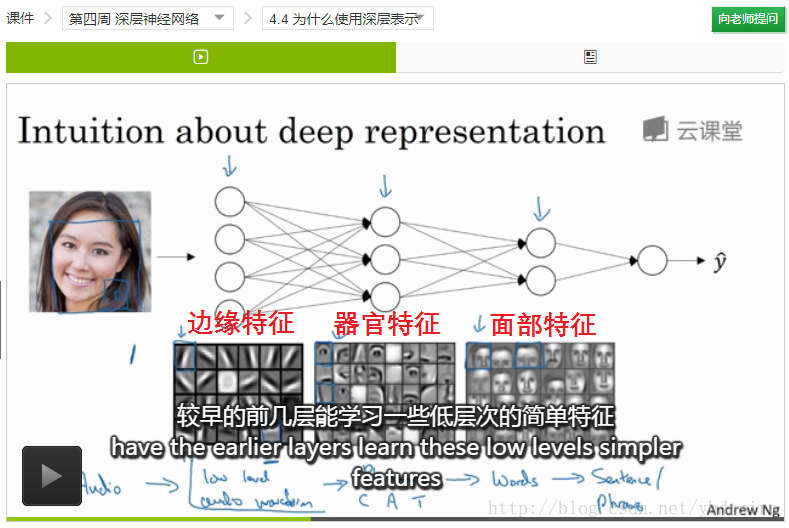

下面这个图,我们也能看到:

- 第一层,提取低层次的简单特征(边缘特征)

- 第二层,将简单特征组合成复杂一点的特征(器官)

- 第三层,将第二层的特征组合起来

Andrew Ng还提到,神经科学家们觉得,人的打到也是先探测简单的东西,然后组合起来才能看到整体。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构