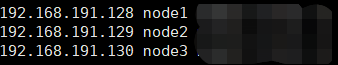

scp /etc/hosts root@node2:/etc/ root@node3:/etc/复制给其他机器

# 集群时间同步

ntpdate ntp5.aliyun.com

# 防火墙关闭

firewall-cmd --state #查看防火墙状态

systemctl stop firewalld.service #停止firewalld服务

systemctl disable firewalld.service #开机禁用firewalld服务

# 机器之间免密登录

# ssh免密登录(只需要配置node1至node1、node2、node3即可)

#node1生成公钥私钥 (一路回车)

ssh-keygen

#node1配置免密登录到node1 node2 node3

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node3

二、Hadoop安装部署

集群规划

| 主机 | 角色 |

|---|---|

| node1 | NN DN RM NM |

| node2 | SNN DN NM |

| node3 | DN NM |

上传Hadoop安装包到node1 /export/server(文件按个人需求)

解压:tar zxvf hadoop-3.3.0-Centos7-64-with-s nappy.tar.gz

修改配置文件(配置文件路径 hadoop-3.3.0/etc/hadoop)hadoop-env.sh

添加配置:

#文件最后添加

export JAVA_HOME=/export/server/jdk1.8.0_241

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

依次修改core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml、workers配置

分发给其他节点同步hadoop安装包

cd /export/server

scp -r hadoop-3.3.0 root@node2:$PWD

scp -r hadoop-3.3.0 root@node3:$PWD

将hadoop添加到环境变量(3台机器)

vim /etc/profile

export HADOOP_HOME=/export/server/hadoop-3.3.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile // 刷新系统配置

scp给其他节点

三、Hadoop集群启动

(==首次启动==)格式化namenode

hdfs namenode -format

脚本一键启动:

start-dfs.sh//启动dfs文件系统

start-yarn.sh//启动yarn资源调度器

可通过以下两个地址,访问该节点

-

-

YARN集群:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App

· 张高兴的大模型开发实战:(一)使用 Selenium 进行网页爬虫