360°视频论文调研

IEEE VR

2019

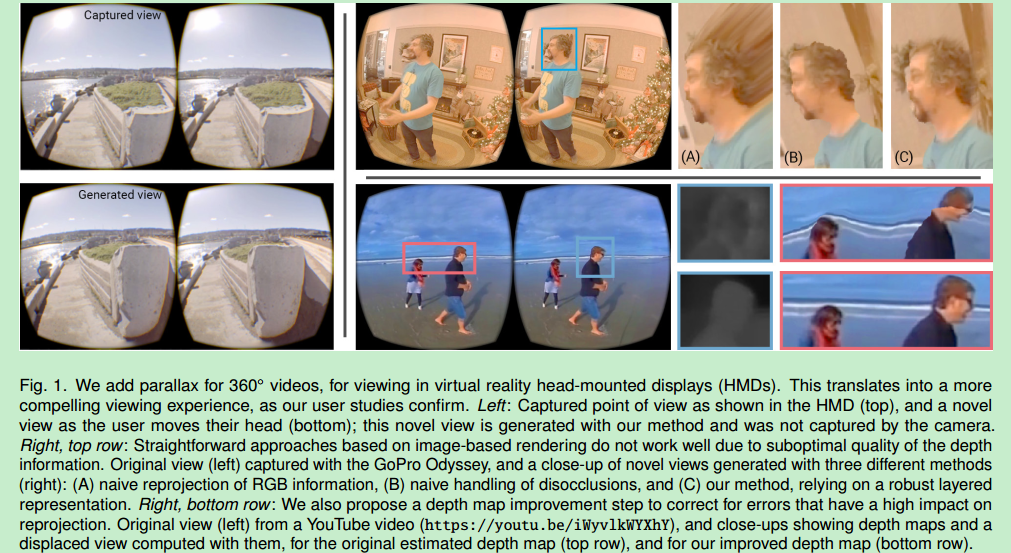

Motion parallax for 360◦ RGBD video(源码暂未公布)

disocclusion(遮挡图像的去除)

一种在虚拟现实头显为360°视频添加视差和实时回放的方法

背景:

现有的视频回放不能响应用户头部的平移运动,可能会给用户带来模拟器病的困扰

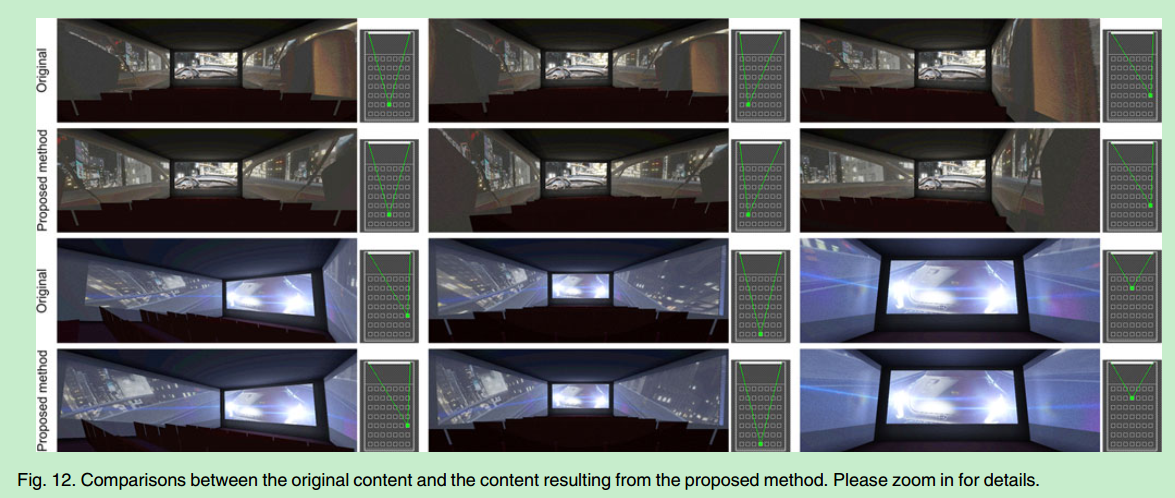

给定360°视频以及它对应的深度,简单的基于图像的渲染方法使用深度生成3d网格,可以相应用户头部平移。然而这种方法有看得见的扭曲以及使网格不连续

解决方案:

从输入的视频获得深度图(由现有的360缝合算法或现成的深度学习算法提供)

将给定的初始深度图改进为更干净的和自然的轮廓

依赖三层场景表示(一个前景层和两个静态背景层)

输入的视频+深度作为前景层

一个背景层表示遮挡物

另一个背景层表示遮挡物后面的背景

从第一个背景层的多帧传播信息处理不一致性,再修复第二个背景层

贡献:

为现有的360°视频提供了6自由度的观看体验(不需要新的捕捉和硬件要求)

disocclusion(遮挡图像的去除)

一种在虚拟现实头显为360°视频添加视差和实时回放的方法

背景:

现有的视频回放不能响应用户头部的平移运动,可能会给用户带来模拟器病的困扰

给定360°视频以及它对应的深度,简单的基于图像的渲染方法使用深度生成3d网格,可以相应用户头部平移。然而这种方法有看得见的扭曲以及使网格不连续

解决方案:

从输入的视频获得深度图(由现有的360缝合算法或现成的深度学习算法提供)

将给定的初始深度图改进为更干净的和自然的轮廓

依赖三层场景表示(一个前景层和两个静态背景层)

输入的视频+深度作为前景层

一个背景层表示遮挡物

另一个背景层表示遮挡物后面的背景

从第一个背景层的多帧传播信息处理不一致性,再修复第二个背景层

贡献:

为现有的360°视频提供了6自由度的观看体验(不需要新的捕捉和硬件要求)

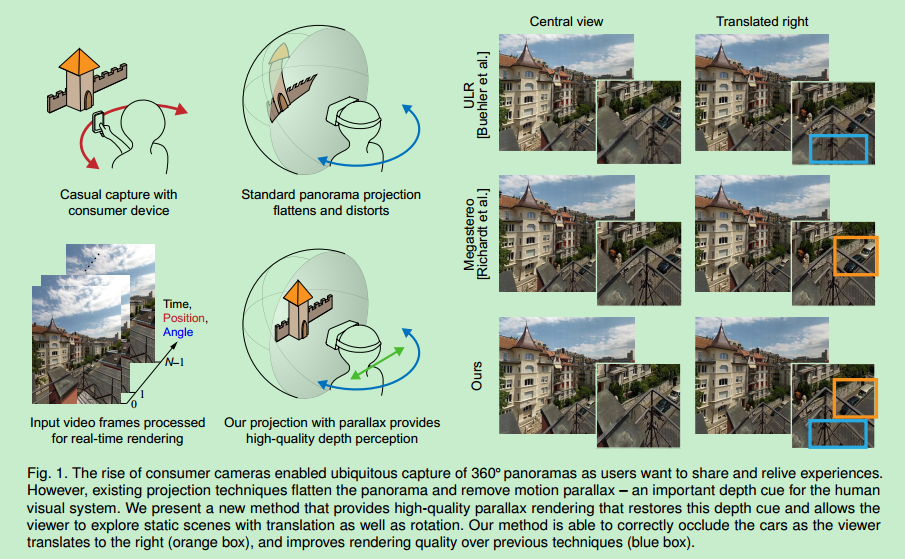

MegaParallax: Casual 360° Panoramas with Motion Parallax

binocular disparity(双目视差,左右眼看到的画面不同)

motion parallax(运动视差,视点改变时看到的画面不同)

背景:

用户可以用手机捕获360°全景图

全景图缺少运动视差(在不同的视点不会提供不同的画面)

研究由头部平移运动引起的运动视差是十分重要的

三维立体全景图提供的左右眼全景图是静态缝合的所以也缺少运动视差

带贴图的三维几何重建方法能提供运动视差,但是有看得见的重建噪点

解决方案:

基于单个相机的多视角全景图表示方式(用相机转360°)

不需要依靠不可靠的场景几何重建

是一种基于图像渲染的方法

贡献:

是第一个让普通消费者捕捉到带双目视差和运动视差的实时高质量360°全景图的方法

binocular disparity(双目视差,左右眼看到的画面不同)

motion parallax(运动视差,视点改变时看到的画面不同)

背景:

用户可以用手机捕获360°全景图

全景图缺少运动视差(在不同的视点不会提供不同的画面)

研究由头部平移运动引起的运动视差是十分重要的

三维立体全景图提供的左右眼全景图是静态缝合的所以也缺少运动视差

带贴图的三维几何重建方法能提供运动视差,但是有看得见的重建噪点

解决方案:

基于单个相机的多视角全景图表示方式(用相机转360°)

不需要依靠不可靠的场景几何重建

是一种基于图像渲染的方法

贡献:

是第一个让普通消费者捕捉到带双目视差和运动视差的实时高质量360°全景图的方法

Deep Learning-Based Approach For Automatic VR Image Upright Adjustment

背景:

相机朝向不是直的,获得的VR图像没有垂直对齐(在VR头显中图像倾斜)

解决方案:

基于深度学习的自动校正VR图像的方法

贡献:

返回校正后的视图

Dense 3D Scene Reconstruction from Multiple Spherical Images for 3-DoF+ VR Applications

背景:

解决方案:

基于多个球状图像的室内场景3维几何重建

探索大的光流替代算法获得相应的点

使用交叉验证和几何限制检测和移除关于形变和遮挡的不好的匹配点

贡献:

根据参考画面生成稠密的深度图

提供3个自由度+的沉浸式体验

Real-time panoramic depth maps from omni-directional stereo images for 6 DoF videos in virtual reality

一种使用CNN从全方位立体图(ODS images)获得6自由度全景视频的方法

解决方案:

用cnn实时地从ODS图生成一些深度图,这些深度图允许全景图像重投影因此能给VR中的观察者提供6自由度的体验

贡献:

提出了新的边缘权重误差函数以及新的关于全景图像拼接的误差度量

Exploration of Large Omnidirectional Images in Immersive Environments

背景:

导航对在沉浸式环境中探索数据是一个主要挑战,特别是在大型全向球形图中。

贡献:

提出了一个自动缩放的方法允许使用者在不同焦点的物理空间的安全范围内用远程传输进行导航

该方法结合了物理导航和虚拟传输

使用缩放镜头评估了我们的系统和其它不同的传输转换

目标视图会从缩放透镜中完全扩张直到将使用者包围

The Effect of Camera Height, Actor Behavior, and Viewer Position on the User Experience of 360° Videos

背景:

360°视频能够用头显来获得沉浸式的体验,然而观看体验是如何被360°视频的基本属性影响还没被弄明白,例如视频到底记录了多高,是否有人靠近相机

解决方案:

进行了一个24人参与的研究

研究内容:

观看体验是否被下列属性影响:

1.相机高度

2.出现在视频中的人的接近和行为

3.观看者站或坐的位置

结论:

观看者自己的高度对首选相机的高度和体验几乎没有影响

对于站和坐而言最优的相机高度大概位于150厘米

某些情况下,相机太矮或者人离相机很近会对体验有负面影响

贡献:

能够更好地理解和设计沉浸式360°体验

Live Stereoscopic 3D Image With Constant Capture Direction of 360 Cameras for High-Quality Visual Telepresence

背景:

为了捕捉遥远的3d画面,系统要使用传统的附在机器人脑袋上的3d相机

然而相机旋转时生成的低质量图的延迟和运动模糊容易造成VR病

解决方案:

一种叫作TwinCam的方法

使用两个360°相机,保持它们的距离为标准瞳孔间距,并保持它们在世界坐标系下的镜头方向不变即使它们绕头部的轴线旋转并沿着眼睛的位置移动

这种方法能抑制图像缓冲因为每个相机在固定捕捉方向时都能捕捉全方向图

贡献:

介绍了我们相机系统的设计和它在视觉远程呈现中的潜力

我们的相机机制能减少运动模糊和VR病

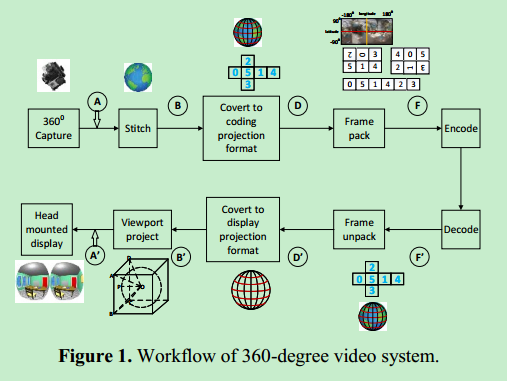

Efficient Hybrid Projection For Encoding 360 VR Videos

背景:

过去5年,市场上卖了成吨的360VR相机

360VR视频无所不在,然而数字工业的360VR视频的标准化依然引起热议

尽管ERP被广泛用于虚拟现实视频的投影和打包布局,但它在极轴处有严重的投影失真

解决方案:

新的使用混合圆柱投影的编码和存储360VR视频的格式

贡献:

能够生成平衡的像素扭曲,最小化结果投影的拉伸比例

2018

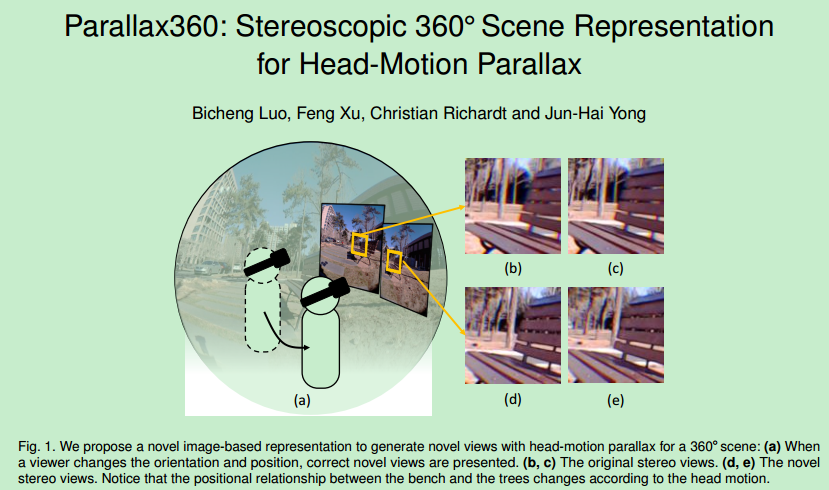

Parallax360: Stereoscopic 360 Scene Representation for Head-Motion Parallax

方法:

一种新颖的360°场景表示方法来将真实场景转化为立体带头部运动视差的三维虚拟现实内容

这种基于图像的场景表示能够有效合成6自由度的新画面

在一下两个方面用到了运动场:

1.视差运动场携带隐含深度信息并且它能从多个横向偏移的辅助视点被估计出来

2.成对的运动场能够实现实时的基于流的混合,从而通过最小化重影和画面转换的噪点改进结果的视觉逼真度

贡献:

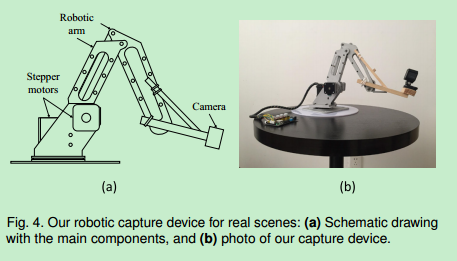

开发了一个系统:

1.它能用带有相机的机械臂捕捉真实场景

2.处理记录的数据并将场景实时渲染到头显上(大于40HZ)

这是第一个在观看真实360°场景支持头部运动视差的方法

方法:

一种新颖的360°场景表示方法来将真实场景转化为立体带头部运动视差的三维虚拟现实内容

这种基于图像的场景表示能够有效合成6自由度的新画面

在一下两个方面用到了运动场:

1.视差运动场携带隐含深度信息并且它能从多个横向偏移的辅助视点被估计出来

2.成对的运动场能够实现实时的基于流的混合,从而通过最小化重影和画面转换的噪点改进结果的视觉逼真度

贡献:

开发了一个系统:

1.它能用带有相机的机械臂捕捉真实场景

2.处理记录的数据并将场景实时渲染到头显上(大于40HZ)

这是第一个在观看真实360°场景支持头部运动视差的方法

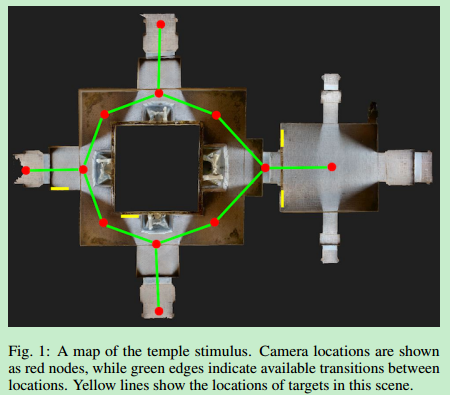

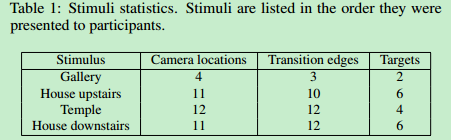

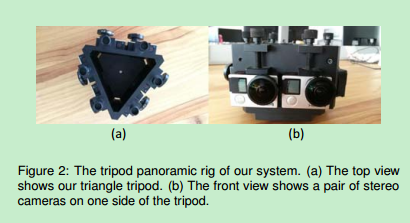

The Effect of Transition Type in Multi-View 360° Media

背景:

360°图像和视频成为了沉浸显示的极受欢迎的形式

许多体验都是用单个相机视点

越来越多的体验用的是多个相机位置

当用户从一个相机位置到另一个相机位置时需要视觉效果

贡献:

调研了沉浸式MV360M(multi-view 360◦media)体验中的平移类型的效果(31个参与者戴头显,体验四个静态的场景,三个由多个360°图像组成,一个由重建3d模型组成)

调研了以下三种平移方式:

1.teleport

2.线性移动穿过场景中的3d模型

3.使用莫比乌斯变换的基于图像的转换

度量标准:

1.空间感知

2.用户的移动轮廓

3.转换偏好

4.穿过空间的主观感受

背景:

360°图像和视频成为了沉浸显示的极受欢迎的形式

许多体验都是用单个相机视点

越来越多的体验用的是多个相机位置

当用户从一个相机位置到另一个相机位置时需要视觉效果

贡献:

调研了沉浸式MV360M(multi-view 360◦media)体验中的平移类型的效果(31个参与者戴头显,体验四个静态的场景,三个由多个360°图像组成,一个由重建3d模型组成)

调研了以下三种平移方式:

1.teleport

2.线性移动穿过场景中的3d模型

3.使用莫比乌斯变换的基于图像的转换

度量标准:

1.空间感知

2.用户的移动轮廓

3.转换偏好

4.穿过空间的主观感受

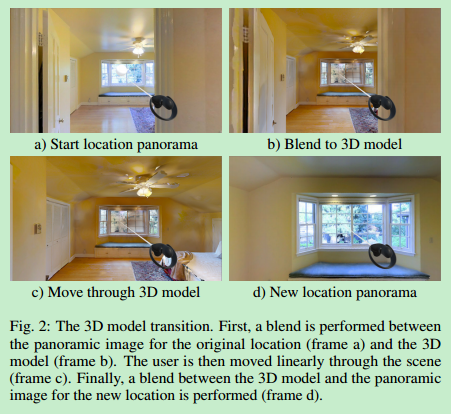

Generating VR Live Videos with Tripod Panoramic Rig

背景:

将真实生活的内容转化为VR需要复杂的计算,现有的技术不能合成高质量的360°三维VR内容也不能实时合成

解决方法:

端到端的系统

能够用三角全景支架记录场景和实时广播360°立体全景视频(>30fps)

基于图像渲染

背景:

将真实生活的内容转化为VR需要复杂的计算,现有的技术不能合成高质量的360°三维VR内容也不能实时合成

解决方法:

端到端的系统

能够用三角全景支架记录场景和实时广播360°立体全景视频(>30fps)

基于图像渲染

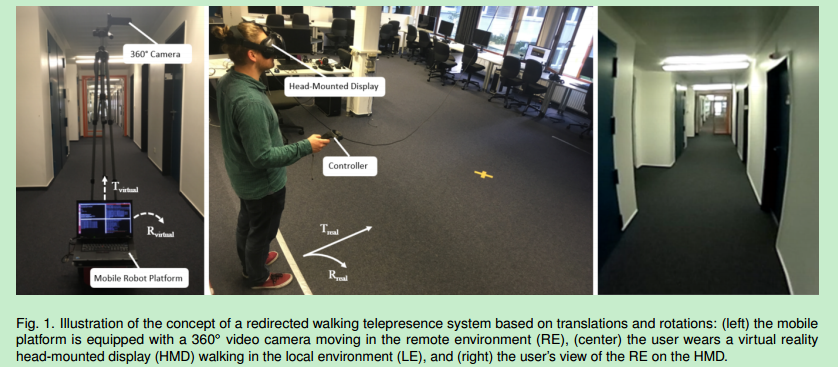

Detection Thresholds for Rotation and Translation Gains in 360° Video-based Telepresence System

背景:

远程传输系统能够克服现实世界的距离限制,因为它使人们可以远程访问和交互

现在的远程传输系统通常缺少自然的方法来支持遥远环境(remote environments REs)的交互和探索

单个捕捉RE的网络相机只提供有限的空间存在的幻象

现在的远程传输系统中的移动设备的移动控制受限于简单的交互设备

让用户在本地环境(local environment LE)控制遥远环境的机器平台运动是面临的主要挑战之一

解决方案:

重定向行走(redirected walking (RDW))是解决这个问题的合适方法

贡献:

进行了两个实验:

多少人可以在感觉不到遥远环境虚拟路径的重定向,这与他们在本地环境的实际行走路径是不同的

1.参与者在本地环境进行直线平移,并且被映射到远程的360°视频中的直线平移,参与者评估远程的平移感知比真实的物理场景中的平移是更快还是更慢(分析了本地和远程平移的区别)

2.参与者在本地环境进行旋转,并且被映射到远程的360°视频中的旋转,参与者评估远程的旋转感知比真实的物理场景中的旋转是更快还是更慢(分析了本地和远程旋转的区别)

结论:

当虚拟平移向下缩放5.8%到向上缩放9.7%以及虚拟旋转慢12.3%或快9.2%时参与者不能分辨本地的物理运动和远程环境360°视频的虚拟运动

背景:

远程传输系统能够克服现实世界的距离限制,因为它使人们可以远程访问和交互

现在的远程传输系统通常缺少自然的方法来支持遥远环境(remote environments REs)的交互和探索

单个捕捉RE的网络相机只提供有限的空间存在的幻象

现在的远程传输系统中的移动设备的移动控制受限于简单的交互设备

让用户在本地环境(local environment LE)控制遥远环境的机器平台运动是面临的主要挑战之一

解决方案:

重定向行走(redirected walking (RDW))是解决这个问题的合适方法

贡献:

进行了两个实验:

多少人可以在感觉不到遥远环境虚拟路径的重定向,这与他们在本地环境的实际行走路径是不同的

1.参与者在本地环境进行直线平移,并且被映射到远程的360°视频中的直线平移,参与者评估远程的平移感知比真实的物理场景中的平移是更快还是更慢(分析了本地和远程平移的区别)

2.参与者在本地环境进行旋转,并且被映射到远程的360°视频中的旋转,参与者评估远程的旋转感知比真实的物理场景中的旋转是更快还是更慢(分析了本地和远程旋转的区别)

结论:

当虚拟平移向下缩放5.8%到向上缩放9.7%以及虚拟旋转慢12.3%或快9.2%时参与者不能分辨本地的物理运动和远程环境360°视频的虚拟运动

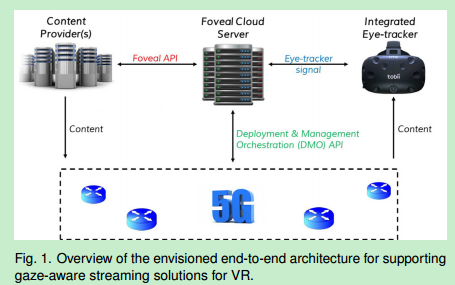

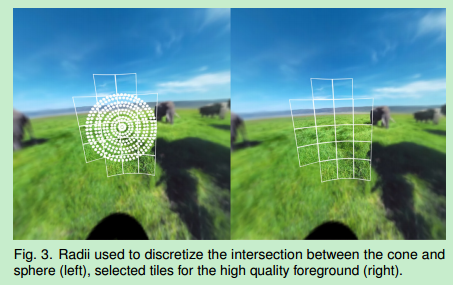

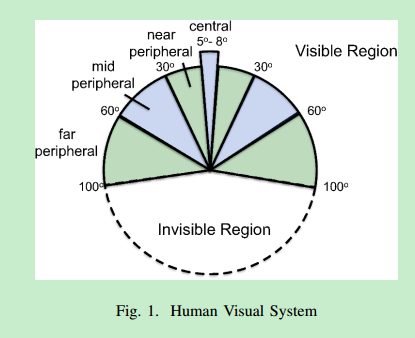

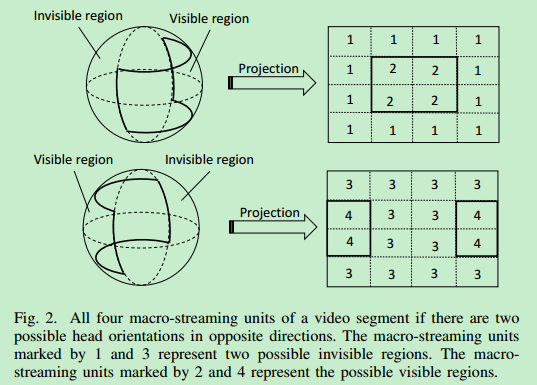

Gaze-aware streaming solutions for the next generation of mobile VR experiences

视频流服务转发的新颖方法

利用镶嵌在下一代VR头显中的相连的眼睛追踪器的信息

提升用户观看地方的视频质量,降低其他地方的视频质量

减少VR视频体验总的带宽,传递高质量的用户感知

结果:

与传统方法相比在传递高质量的体验时减少了将近83%的带宽

视频流服务转发的新颖方法

利用镶嵌在下一代VR头显中的相连的眼睛追踪器的信息

提升用户观看地方的视频质量,降低其他地方的视频质量

减少VR视频体验总的带宽,传递高质量的用户感知

结果:

与传统方法相比在传递高质量的体验时减少了将近83%的带宽

[2017](http://ieeevr.org/2017/program/papers.html#360° Video Cinematic Experience)

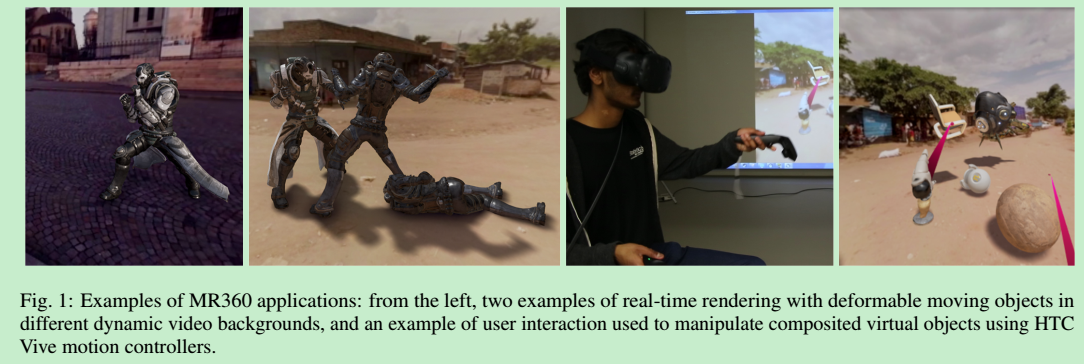

MR360: Mixed Reality Rendering for a 360° Panoramic Videos

一种新颖的叫做MR360的沉浸式系统

在头显中使用传统的低动态范围(low dynamic range LDR)的360°全景视频提供了混合现实(MR)的体验

使用输入的全景视频作为光源照亮虚拟物体

探测全景视频中的光源并用来产生可感知的阴影

利用实时360视频流为头显提供高质量的渲染效果的可交互的MR场景

###[6-DOF VR Videos with a Single 360-Camera](https://ieeexplore.ieee.org/abstract/document/7892229)

一种新颖的叫做MR360的沉浸式系统

在头显中使用传统的低动态范围(low dynamic range LDR)的360°全景视频提供了混合现实(MR)的体验

使用输入的全景视频作为光源照亮虚拟物体

探测全景视频中的光源并用来产生可感知的阴影

利用实时360视频流为头显提供高质量的渲染效果的可交互的MR场景

###[6-DOF VR Videos with a Single 360-Camera](https://ieeexplore.ieee.org/abstract/document/7892229)

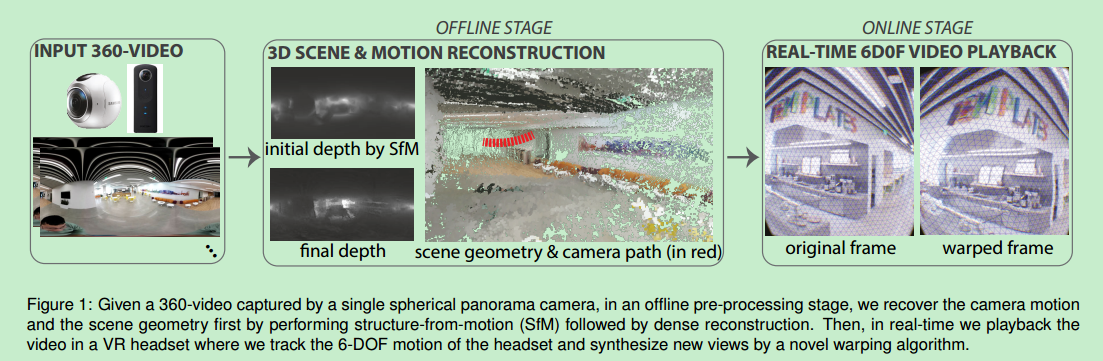

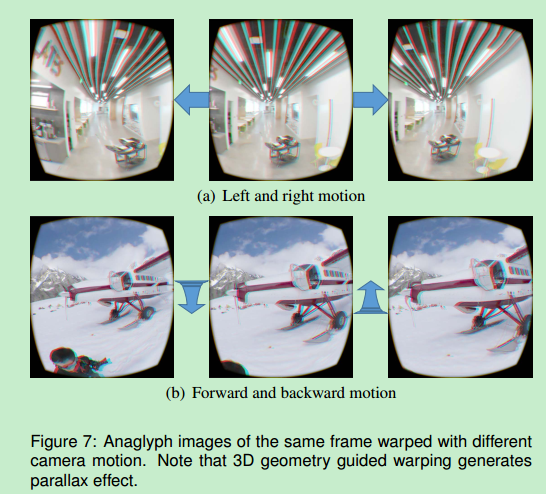

背景:

单目360视频是VR头显最流行的内容,但是缺少3d的信息,所以不能以6个自由度观看

解决方案:

通过一种新的可以合成新的带有视点旋转和平移运动的视图的弯曲算法来解决这个限制

生成的可回放VR视频帧率>120fps

是带有6个自由度的立体视频

贡献:

使输入的单目360视频文件可以在头显中以6个自由度的立体形式进行展示

###[Cinematic Virtual Reality: Evaluating the Effect of Display Type on the Viewing Experience for Panoramic Video](https://ieeexplore.ieee.org/abstract/document/7892230)

背景:

单目360视频是VR头显最流行的内容,但是缺少3d的信息,所以不能以6个自由度观看

解决方案:

通过一种新的可以合成新的带有视点旋转和平移运动的视图的弯曲算法来解决这个限制

生成的可回放VR视频帧率>120fps

是带有6个自由度的立体视频

贡献:

使输入的单目360视频文件可以在头显中以6个自由度的立体形式进行展示

###[Cinematic Virtual Reality: Evaluating the Effect of Display Type on the Viewing Experience for Panoramic Video](https://ieeexplore.ieee.org/abstract/document/7892230)

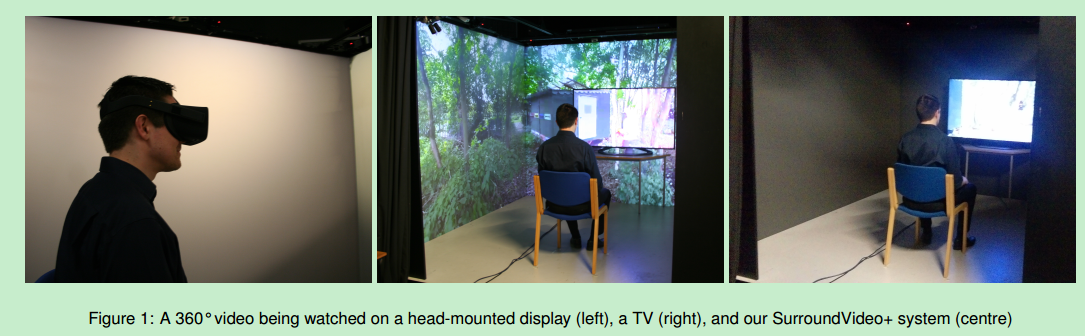

cinematic virtual reality (CVR)(影院级的虚拟现实)

背景:

市场上的头显卖得很好,影院级的虚拟现实越来越受欢迎

内容:

探索了几个代表CVR相对于传统观看形势(例如电视)的优缺点的度量

邀请了63个参与者进行试验,探索了以下三种显示全景视频的系统:

1.头显

2.SurroundVideo+(SV+ 环绕视频+)

3.标准的16:9的电视

结论:

头显在享受和空间感知方面有显著优势

SV+在享受方面优于传统电视

###[ScreenX: Public Immersive Theatres with Uniform Movie Viewing Experiences](https://ieeexplore.ieee.org/abstract/document/7414506)

cinematic virtual reality (CVR)(影院级的虚拟现实)

背景:

市场上的头显卖得很好,影院级的虚拟现实越来越受欢迎

内容:

探索了几个代表CVR相对于传统观看形势(例如电视)的优缺点的度量

邀请了63个参与者进行试验,探索了以下三种显示全景视频的系统:

1.头显

2.SurroundVideo+(SV+ 环绕视频+)

3.标准的16:9的电视

结论:

头显在享受和空间感知方面有显著优势

SV+在享受方面优于传统电视

###[ScreenX: Public Immersive Theatres with Uniform Movie Viewing Experiences](https://ieeexplore.ieee.org/abstract/document/7414506)

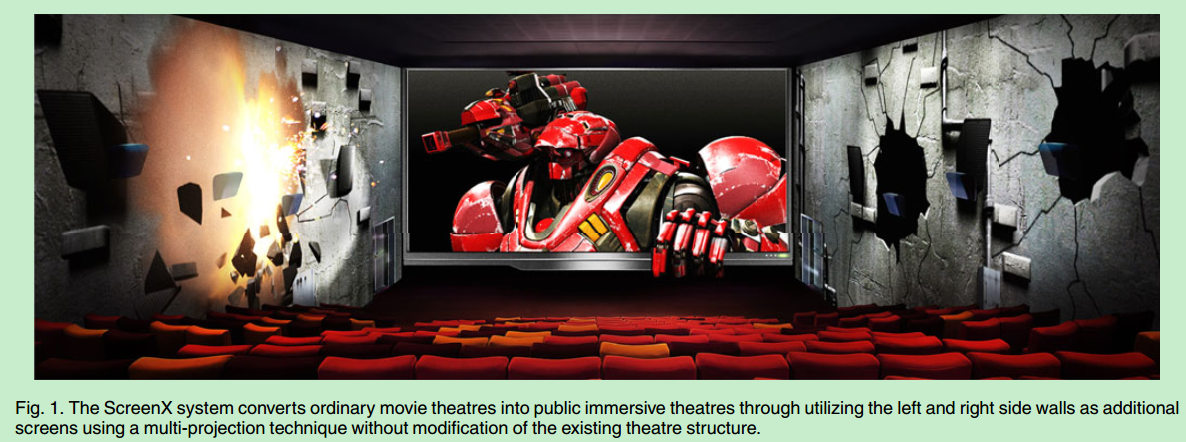

背景:

传统地在侧边墙上显示内容会根据观看者的位置导致图像扭曲

影院里不同的宽高和深度会有不同的视觉体验

解决方案:

ScreenX是一款可以让普通地电影院变成多投影的电影院的新颖电影观看平台

让大众享受沉浸式的视觉体验

左右两边的墙将会被用来形成屏幕

生成的电影视图将会带来强烈的沉浸感

减小侧边墙上图像的平均扭曲程度

背景:

传统地在侧边墙上显示内容会根据观看者的位置导致图像扭曲

影院里不同的宽高和深度会有不同的视觉体验

解决方案:

ScreenX是一款可以让普通地电影院变成多投影的电影院的新颖电影观看平台

让大众享受沉浸式的视觉体验

左右两边的墙将会被用来形成屏幕

生成的电影视图将会带来强烈的沉浸感

减小侧边墙上图像的平均扭曲程度

2016

Adaptive 360 VR Video Streaming Based on MPEG-DASH SRD

[四元数(Quaternion)和旋转](https://www.cnblogs.com/mimime/p/6192427.html)

背景:

360VR视频需要很大的带宽,如何在质量可接受的情形下有效传输360VR视频到无线VR头显呢?

解决方案:

自适应的带宽高效的基于MPEG-DASH SRD的360VR视频流系统

将[MPEG-DASH SRD](http://delivery.acm.org/10.1145/2920000/2910606/a5-niamut.pdf?ip=219.224.167.179&id=2910606&acc=ACTIVE%20SERVICE&key=BF85BBA5741FDC6E%2E478E8F2EC4A762F8%2E4D4702B0C3E38B35%2E4D4702B0C3E38B35&__acm__=1553063197_ac5fe0d137a71cc35498e21305d5586c)扩展到360VR视频的3维空间

解决了无线VR头盔对360VR视频流的高带宽需求

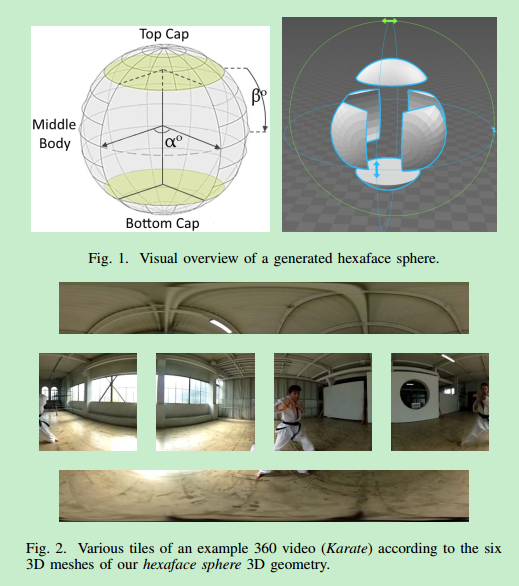

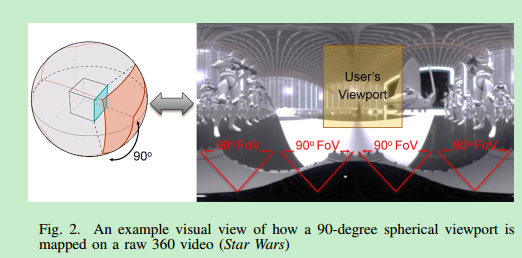

将底层三维网格空间划分为多个三维自网络,构建了一个称为六面体的高效的三维几何网格,以最佳方式表示三维空间中平铺的360VR视频

每一帧追踪用户视角,将在用户视角内的内容以高比特率的方式传输,不在用户视角内的以低质量的内容传输

贡献:

在最小化质量影响的条件下节省了360VR视频流72%的带宽(与传统方法相比)

###[Adaptive 360 VR Video Streaming: Divide and Conquer](https://ieeexplore.ieee.org/document/7823595)

[四元数(Quaternion)和旋转](https://www.cnblogs.com/mimime/p/6192427.html)

背景:

360VR视频需要很大的带宽,如何在质量可接受的情形下有效传输360VR视频到无线VR头显呢?

解决方案:

自适应的带宽高效的基于MPEG-DASH SRD的360VR视频流系统

将[MPEG-DASH SRD](http://delivery.acm.org/10.1145/2920000/2910606/a5-niamut.pdf?ip=219.224.167.179&id=2910606&acc=ACTIVE%20SERVICE&key=BF85BBA5741FDC6E%2E478E8F2EC4A762F8%2E4D4702B0C3E38B35%2E4D4702B0C3E38B35&__acm__=1553063197_ac5fe0d137a71cc35498e21305d5586c)扩展到360VR视频的3维空间

解决了无线VR头盔对360VR视频流的高带宽需求

将底层三维网格空间划分为多个三维自网络,构建了一个称为六面体的高效的三维几何网格,以最佳方式表示三维空间中平铺的360VR视频

每一帧追踪用户视角,将在用户视角内的内容以高比特率的方式传输,不在用户视角内的以低质量的内容传输

贡献:

在最小化质量影响的条件下节省了360VR视频流72%的带宽(与传统方法相比)

###[Adaptive 360 VR Video Streaming: Divide and Conquer](https://ieeexplore.ieee.org/document/7823595)

背景:

球状的360VR视频需要很大的带宽,以让人可以接受的质量传输是很困难的

解决方案:

使用分治算法的自适应带宽高效的360VR视频流系统

动态视觉感知的适应技术来解决360VR视频流大量带宽的需求

在编码和打包的时候将视频划分为很多块

使用MPEG-DASH SRD来描述360度空间中块的空间关系

优先处理在用户视野里的块

为了描述块的关系,我们将MPEG-DASH SRD扩展到了360VR视频的3d空间,对底层网格进行了空间划分并构建了有效的被称为六面体球的几何网格来代表3d空间中被块状化的360VR视频

贡献:

在最小化质量影响的条件下节省了360VR视频流72%的带宽(与传统方法相比)

##[2015](http://ieeevr.org/2015/)

背景:

球状的360VR视频需要很大的带宽,以让人可以接受的质量传输是很困难的

解决方案:

使用分治算法的自适应带宽高效的360VR视频流系统

动态视觉感知的适应技术来解决360VR视频流大量带宽的需求

在编码和打包的时候将视频划分为很多块

使用MPEG-DASH SRD来描述360度空间中块的空间关系

优先处理在用户视野里的块

为了描述块的关系,我们将MPEG-DASH SRD扩展到了360VR视频的3d空间,对底层网格进行了空间划分并构建了有效的被称为六面体球的几何网格来代表3d空间中被块状化的360VR视频

贡献:

在最小化质量影响的条件下节省了360VR视频流72%的带宽(与传统方法相比)

##[2015](http://ieeevr.org/2015/)

2014

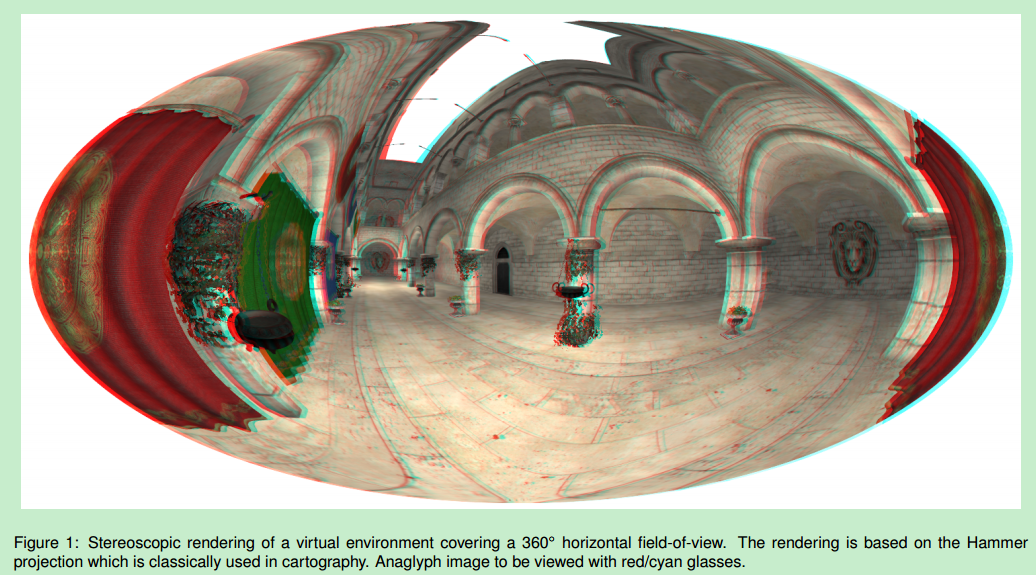

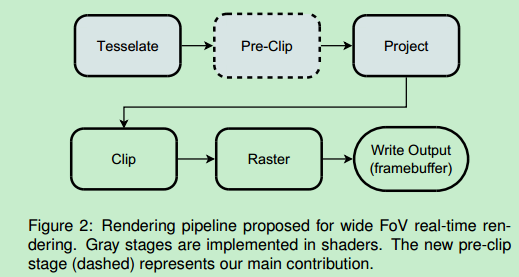

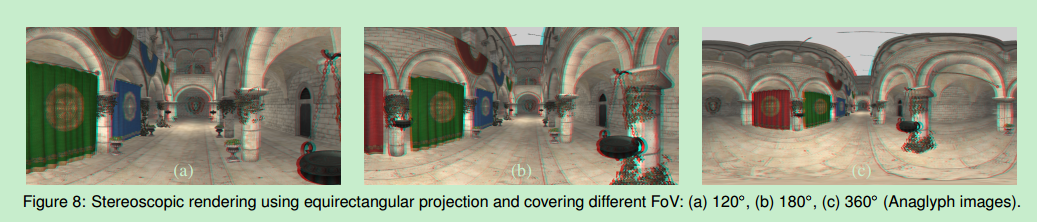

Stereoscopic rendering of virtual environments with wide Field-of-Views up to 360°

背景:

现有的基于图像和几何的方法通常在立体兼容、GPU友好和处理非平面投影的不连续上面不是特别有效

解决方案:

一种最多可达360°的宽视野的立体渲染虚拟场景的方法

一个新的预剪辑阶段,特别适用于跨越投影不连续的多边形会出现问题的几何方法

可以实时渲染三维宽视野图片

背景:

现有的基于图像和几何的方法通常在立体兼容、GPU友好和处理非平面投影的不连续上面不是特别有效

解决方案:

一种最多可达360°的宽视野的立体渲染虚拟场景的方法

一个新的预剪辑阶段,特别适用于跨越投影不连续的多边形会出现问题的几何方法

可以实时渲染三维宽视野图片

ISMAR

2018

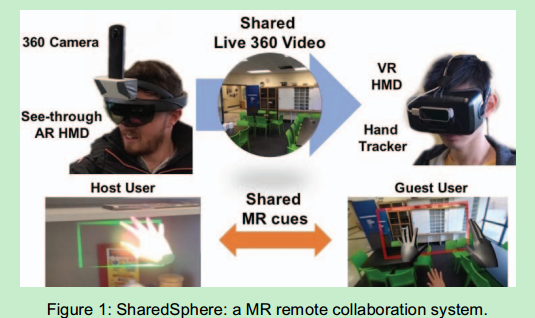

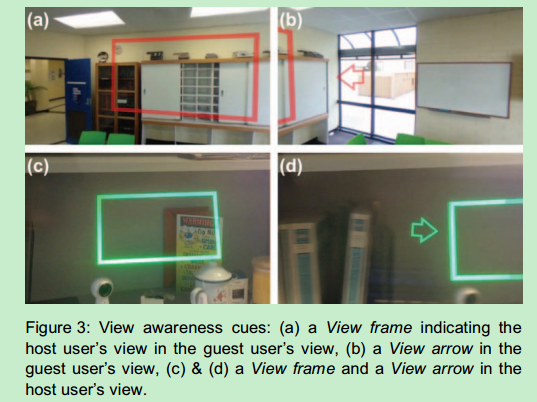

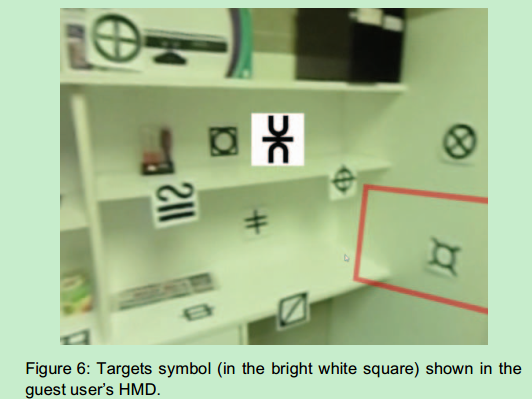

A User Study on MR Remote Collaboration Using Live 360 Video

deictic gesture(指示手势)

背景:

在现代社会网络平台上分享和观看实时360全景视频是能够实现的

交流通常是被动的单向的体验

研究内容:

如何通过添加混合现实(MR)线索改善基于实时360全景图的远程协作体验

贡献:

弄了一个叫做SharedSphere的可穿戴混合现实远程合作系统,能够通过MR可视化无语言交流线索,从而丰富实时捕捉的全景协作

研究了在使用基于可穿戴MR的远程合作系统的实时360全景视频的合作中的视图独立性的好处

揭示了如何设计基于实时360全景视频的MR远程合作接口

deictic gesture(指示手势)

背景:

在现代社会网络平台上分享和观看实时360全景视频是能够实现的

交流通常是被动的单向的体验

研究内容:

如何通过添加混合现实(MR)线索改善基于实时360全景图的远程协作体验

贡献:

弄了一个叫做SharedSphere的可穿戴混合现实远程合作系统,能够通过MR可视化无语言交流线索,从而丰富实时捕捉的全景协作

研究了在使用基于可穿戴MR的远程合作系统的实时360全景视频的合作中的视图独立性的好处

揭示了如何设计基于实时360全景视频的MR远程合作接口

SIGGRAPH

2018

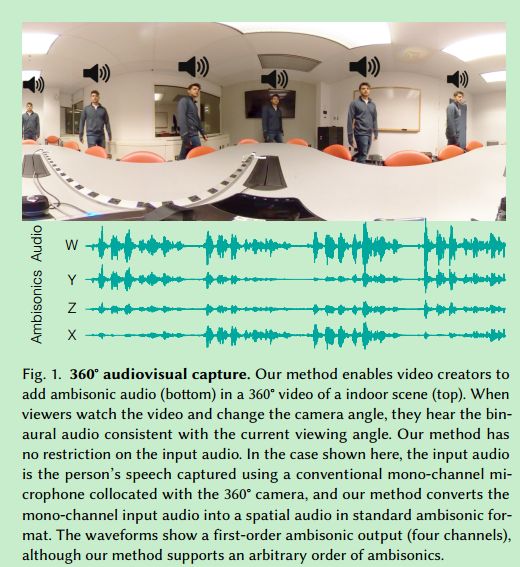

Scene-Aware Audio for 360° Videos

背景:

360相机为捕捉视频添加真实的360°音效是一个不小的挑战

解决方案:

一种为典型室内场景的360°视频添加场景感知的空间音效的方法(只是用传统的单频道麦克风和扬声器就能实现)

背景:

360相机为捕捉视频添加真实的360°音效是一个不小的挑战

解决方案:

一种为典型室内场景的360°视频添加场景感知的空间音效的方法(只是用传统的单频道麦克风和扬声器就能实现)

2017

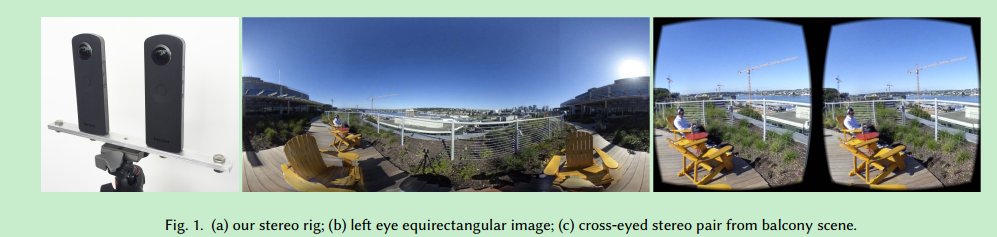

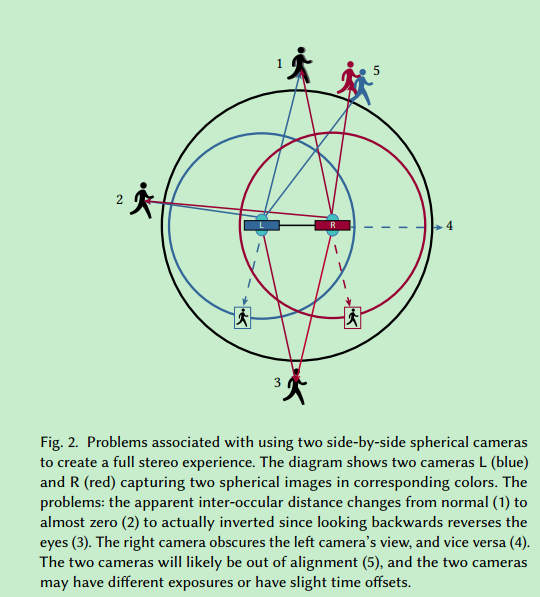

Low-cost 360 stereo photography and video capture

背景:

大量消费者使用的球状相机出现使得大众负担得起的单目360°X180°球状全景照片和视频VR内容创造成为可能

单目内容没法立体显示

现在创造立体全景图的设备太复杂

解决方案:

使用两个360°球状相机合成全方位立体全景图

贡献:

降低设备花费

利用现成的装备

轻量级

调查了什么样的几何处理让用户体验更佳

背景:

大量消费者使用的球状相机出现使得大众负担得起的单目360°X180°球状全景照片和视频VR内容创造成为可能

单目内容没法立体显示

现在创造立体全景图的设备太复杂

解决方案:

使用两个360°球状相机合成全方位立体全景图

贡献:

降低设备花费

利用现成的装备

轻量级

调查了什么样的几何处理让用户体验更佳

2016

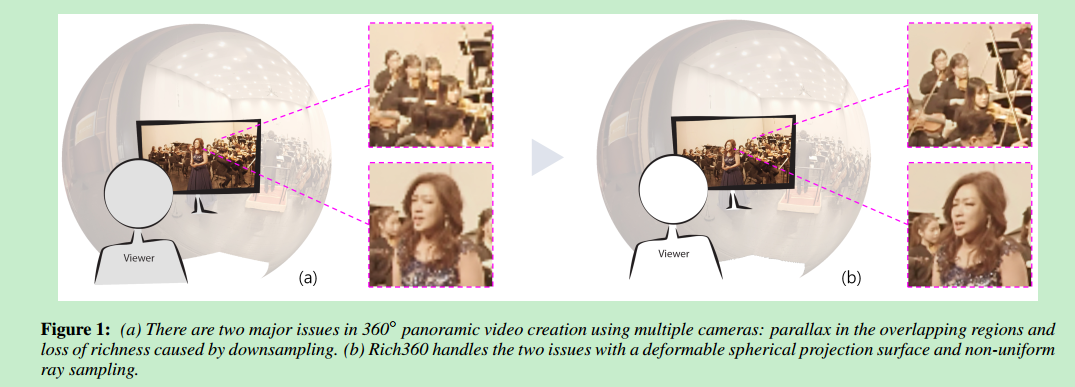

Rich360: Optimized Spherical Representation from Structured Panoramic Camera Arrays

背景:

使用多个相机拍摄360°全景视频有两个主要的问题:下采样造成的重叠区域的视差以及丰富度的丢失

解决方案:

提供了Rich360——一款创建和观看从固定在一个支架上的多个相机拍摄的360°全景视频的系统

可变形球状投影表面被用来最小化多个相机的视差

根据从互相重叠的视频区域的深度约束估计对表面进行时空变形

贡献:

提升了360°视频的丰富度

背景:

使用多个相机拍摄360°全景视频有两个主要的问题:下采样造成的重叠区域的视差以及丰富度的丢失

解决方案:

提供了Rich360——一款创建和观看从固定在一个支架上的多个相机拍摄的360°全景视频的系统

可变形球状投影表面被用来最小化多个相机的视差

根据从互相重叠的视频区域的深度约束估计对表面进行时空变形

贡献:

提升了360°视频的丰富度

Asia

2016

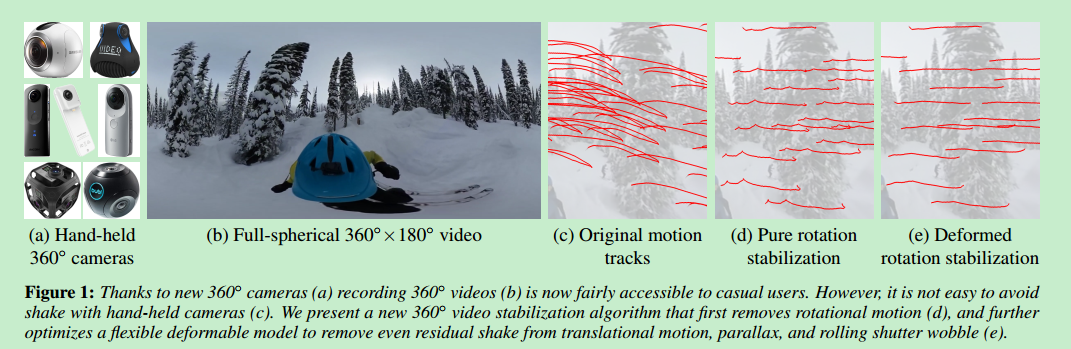

360◦ Video Stabilization

背景:

记录360°视频的360°相机可以被寻常人家买到

避免手持相机的抖动没那么简单

解决方案:

提供了新的360°视频稳定算法可以移除旋转运动,优化弹性形变模型来去除平移运动、视差和卷帘摆动中的残差抖动

一种使用可变形旋转运动模型的稳定360°视频的混合2d-3d的算法

用3d分析来估计相邻关键帧的旋转

对于其他帧使用2d优化来最大化特征点轨迹的视觉平滑度

背景:

记录360°视频的360°相机可以被寻常人家买到

避免手持相机的抖动没那么简单

解决方案:

提供了新的360°视频稳定算法可以移除旋转运动,优化弹性形变模型来去除平移运动、视差和卷帘摆动中的残差抖动

一种使用可变形旋转运动模型的稳定360°视频的混合2d-3d的算法

用3d分析来估计相邻关键帧的旋转

对于其他帧使用2d优化来最大化特征点轨迹的视觉平滑度

IEEE Confereces

2018

Content-Adaptive 360-Degree Video Coding Using Hybrid Cubemap Projection

一种改进360°视频编码效率的混合立方图投影(hybrid cubemap projection HCP)

一种改进360°视频编码效率的混合立方图投影(hybrid cubemap projection HCP)

BAS-360°: Exploring Spatial and Temporal Adaptability in 360-degree Videos over HTTP/2

背景:

360视频流网络服务很受欢迎

360°视频流需要过高的带宽

现有的解决方案大多数都是只高质量地传递用户感兴趣的地方(region of interest ROI)

解决方案:

叫做BAS-360°的方法

在不同区域的比特率选择上考虑了空间和时间适应性

通过选择更重要的区域来最小化带宽

背景:

360视频流网络服务很受欢迎

360°视频流需要过高的带宽

现有的解决方案大多数都是只高质量地传递用户感兴趣的地方(region of interest ROI)

解决方案:

叫做BAS-360°的方法

在不同区域的比特率选择上考虑了空间和时间适应性

通过选择更重要的区域来最小化带宽

2017

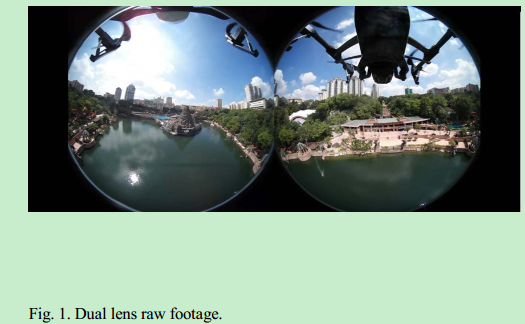

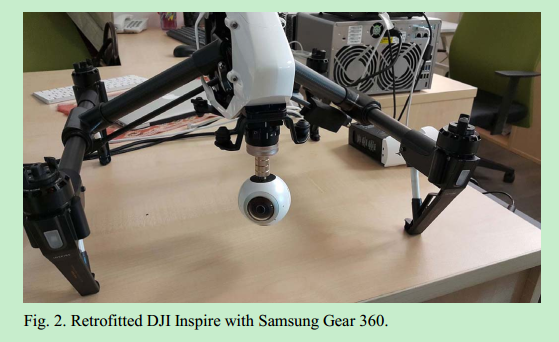

Aerial virtual reality 360 research-creation

一种空中VR360视频捕捉方法(无人机搭载消费者级别的360球状全景相机)

一种空中VR360视频捕捉方法(无人机搭载消费者级别的360球状全景相机)

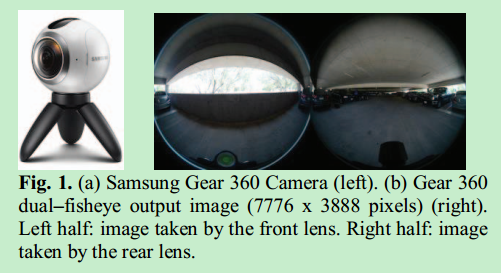

Dual-fisheye lens stitching for 360-degree imaging

背景:

双重鱼眼镜头越来越多地被用到360沉浸式成像中

两个镜头视图的重叠区域和错误对齐使得缝合边界不连续

解决方案:

适应性地最小化重叠区域不连续性来生成完整的球状360度图像的方法

背景:

双重鱼眼镜头越来越多地被用到360沉浸式成像中

两个镜头视图的重叠区域和错误对齐使得缝合边界不连续

解决方案:

适应性地最小化重叠区域不连续性来生成完整的球状360度图像的方法

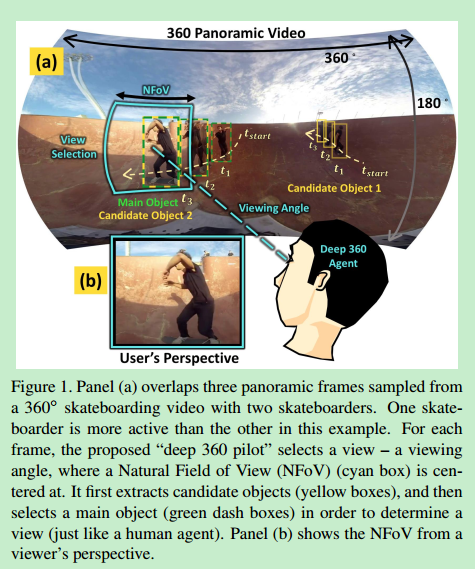

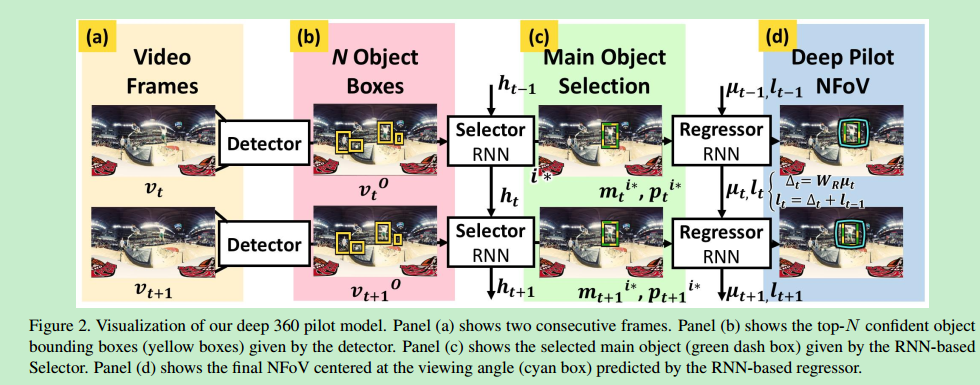

Deep 360 Pilot: Learning a Deep Agent for Piloting through 360° Sports Videos

[源码、数据集和视频演示](http://aliensunmin.github.io/project/360video/)

背景:

看360°运动视频需要观察者连续选择视角,通过一系列的鼠标点击或头部运动

解决方案:

叫作deep 360 pilot的方法

自动帮用户选择合适的视角的代理人

每一帧,代理人观察全景图,结合之前帧的视角得出下一个最合适的视角并帮助观看者调整画面,使用户不需要动鼠标和头部自动获得最佳画面内容体验

[源码、数据集和视频演示](http://aliensunmin.github.io/project/360video/)

背景:

看360°运动视频需要观察者连续选择视角,通过一系列的鼠标点击或头部运动

解决方案:

叫作deep 360 pilot的方法

自动帮用户选择合适的视角的代理人

每一帧,代理人观察全景图,结合之前帧的视角得出下一个最合适的视角并帮助观看者调整画面,使用户不需要动鼠标和头部自动获得最佳画面内容体验

浙公网安备 33010602011771号

浙公网安备 33010602011771号