|NO.Z.00017|——————————|BigDataEnd|——|Hadoop&Hive.V17|——|Hive.v17|Hive函数用法.v05|

一、自定义函数

### --- 自定义函数

~~~ 当 Hive 提供的内置函数无法满足实际的业务处理需要时,可以考虑使用用户自定义函数进行扩展。

~~~ 用户自定义函数分为以下三类:

~~~ UDF(User Defined Function)。用户自定义函数,一进一出

~~~ UDAF(User Defined Aggregation Function)。用户自定义聚集函数,多进一出;

~~~ 类似于:count/max/min

~~~ UDTF(User Defined Table-Generating Functions)。用户自定义表生成函数,一进多出;

~~~ 类似于:explode### --- UDF开发:

~~~ 继承org.apache.hadoop.hive.ql.exec.UDF

~~~ 需要实现evaluate函数;evaluate函数支持重载

~~~ UDF必须要有返回类型,可以返回null,但是返回类型不能为void### --- UDF开发步骤

~~~ 创建maven java 工程,添加依赖

~~~ 开发java类继承UDF,实现evaluate 方法

~~~ 将项目打包上传服务器

~~~ 添加开发的jar包

~~~ 设置函数与自定义函数关联

~~~ 使用自定义函数### --- 需求:扩展系统 nvl 函数功能:

~~~ nvl(ename, "OK"): ename==null => 返回第二个参数

~~~ nvl(ename, "OK"): ename==null or ename=="" or ename==" " =>

~~~ 返回第二个参数二、创建maven java 工程,添加依赖

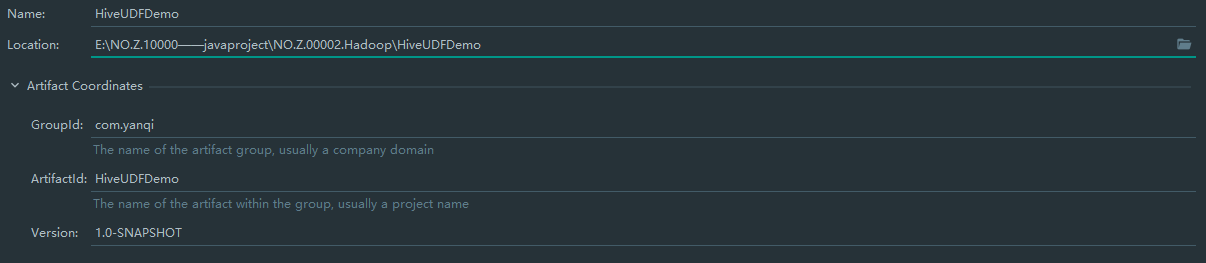

### --- 创建maven java 工程,添加依赖

<!-- pom.xml 文件 -->

<dependencies>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>2.3.7</version>

</dependency>

</dependencies>三、开发java类继承UDF,实现evaluate 方法

### --- 开发java类继承UDF,实现evaluate 方法

package com.yanqi.hive.udf;

import org.apache.hadoop.hive.ql.exec.UDF;

import org.apache.hadoop.io.Text;

public class nvl extends UDF {

public Text evaluate(final Text t, final Text x) {

if (t == null || t.toString().trim().length()==0) {

return x;

}

return t;

}

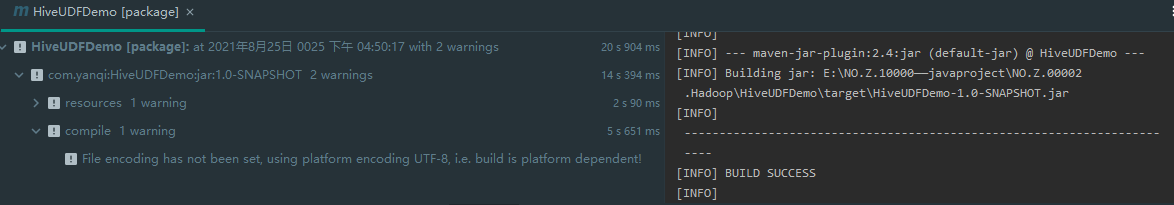

}四、将项目打包上传服务器:将打包好的jar包上传到服务器中:HiveUDFDemo-1.0-SNAPSHOT.jar

### --- 添加开发的jar包(在Hive命令行中)

[root@linux123 ~]# mv HiveUDFDemo-1.0-SNAPSHOT.jar hiveudf.jar

[root@linux123 ~]# mv hiveudf.jar /home/hadoop/

hive (default)> add jar /home/hadoop/hiveudf.jar ;

Added [/home/hadoop/hiveudf.jar] to class path

Added resources: [/home/hadoop/hiveudf.jar]### --- 创建临时函数。指定类名一定要完整的路径,即包名加类名

hive (default)> create temporary function mynvl as "com.yanqi.hive.udf.nvl";### --- 执行查询

hive (default)> use mydb;~~~ # 基本功能还有

hive (default)> select mynvl(comm, 0) from mydb.emp;

~~~ # 测试扩充的功能

hive (mydb)> select mynvl("", "OK");

OK

hive (mydb)> select mynvl(" ", "OK");

OK### --- 退出Hive命令行,再进入Hive命令行。执行步骤6的测试,发现函数失效。

~~~ 创建临时函数每次进入Hive命令行时,都必须执行以下语句,很不方便:

hive (default)> add jar /home/hadoop/hiveudf.jar;

hive (default)> create temporary function mynvl as "com.yanqi.hive.udf.nvl";五、可创建永久函数:

### --- 将jar上传HDFS

[root@linux123 hadoop]# hdfs dfs -put hiveudf.jar jar/

[root@linux123 hadoop]# hdfs dfs -ls jar/

-rw-r--r-- 3 root supergroup 2412 2021-08-25 17:11 jar/hiveudf.jar### --- 在Hive命令行中创建永久函数

hive (default)> create function mynvl1 as 'com.yanqi.hive.udf.nvl' using jar 'hdfs:/user/hadoop/jar/hiveudf.jar';

~~~ # 查询所有的函数,发现 mynvl1 在列表中

hive (default)> show functions; ### --- 退出Hive,再进入,执行测试

hive (default)> use mydb;~~~ # 基本功能还有

hive (default)> select mynvl(comm, 0) from mydb.emp;

~~~ # 测试扩充的功能

hive (mydb)> select mynvl1("", "OK");

OK

hive (mydb)> select mynvl1(" ", "OK");

OK### --- 删除永久函数,并检查

hive (mydb)> drop function mynvl1;

hive (mydb)> show functions;Walter Savage Landor:strove with none,for none was worth my strife.Nature I loved and, next to Nature, Art:I warm'd both hands before the fire of life.It sinks, and I am ready to depart

——W.S.Landor

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通