|NO.Z.00030|——————————|BigDataEnd|——|Hadoop&MapReduce.V03|——|Hadoop.v03|WordCount案例之编写本地YARN运行.v01|

一、WordCount代码实现

~~~ [WordCount案例之编写Mapper类]

~~~ [WordCount案例之Reducer类]

~~~ [WordCount案例之Driver类]

~~~ [WordCount案例之本地验证]

~~~ [WordCount案例之运行YARN集群]### --- 需求

~~~ 在给定的文本文件中统计输出每一个单词出现的总次数~~~ # 输入数据:wc.txt;

输出:

apache 2

clickhouse 2

hadoop 1

mapreduce 1

spark 2

xiaoming 1二、具体步骤

### --- 按照MapReduce编程规范,分别编写Mapper,Reducer,Driver。

~~~ 新建maven工程:创建项目:wc

~~~ 导入hadoop依赖 <dependencies>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>2.8.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.9.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.9.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.9.2</version>

</dependency>

</dependencies>

<!--maven打包插件 -->

<build>

<plugins>

<plugin>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<artifactId>maven-assembly-plugin </artifactId>

<configuration>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>注意:以上依赖第一次需要联网下载!!

添加log4j.properties

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n三、整体思路梳理(仿照源码)

### --- Map阶段:

~~~ map()方法中把传入的数据转为String类型

~~~ 根据空格切分出单词

~~~ 输出<单词,1>### --- Reduce阶段:

~~~ 汇总各个key(单词)的个数,遍历value数据进行累加

~~~ 输出key的总数### --- Driver

~~~ 获取配置文件对象,获取job对象实例

~~~ 指定程序jar的本地路径

~~~ 指定Mapper/Reducer类

~~~ 指定Mapper输出的kv数据类型

~~~ 指定最终输出的kv数据类型

~~~ 指定job处理的原始数据路径

~~~ 指定job输出结果路径

~~~ 提交作业四、WordCount案例之Mapper类

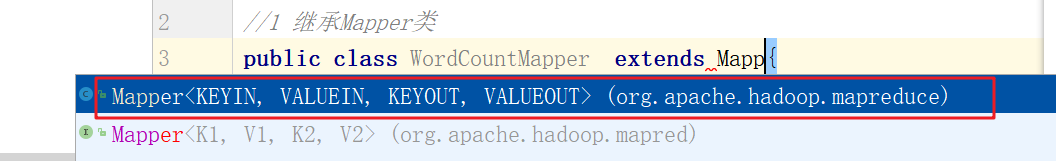

### --- 编写Mapper类

~~~ 继承的Mapper类型选择新版本API:

package com.yanqi.mr.wc;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

//需求:单词计数

//1 继承Mapper类

//2 Mapper类的泛型参数:共4个,2对kv

//2.1 第一对kv:map输入参数类型

//2.2 第二队kv:map输出参数类型

// LongWritable, Text-->文本偏移量(后面不会用到),一行文本内容

//Text, IntWritable-->单词,1

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

//3 重写Mapper类的map方法

/*

1 接收到文本内容,转为String类型

2 按照空格进行切分

3 输出<单词,1>

*/

//提升为全局变量,避免每次执行map方法都执行此操作

final Text word = new Text();

final IntWritable one = new IntWritable(1);

// LongWritable, Text-->文本偏移量,一行文本内容,map方法的输入参数,一行文本就调用一次map方法

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 1 接收到文本内容,转为String类型

final String str = value.toString();

// 2 按照空格进行切分

final String[] words = str.split(" ");

// 3 输出<单词,1>

//遍历数据

for (String s : words) {

word.set(s);

context.write(word, one);

}

}

}

五、WordCount案例之Reducer类

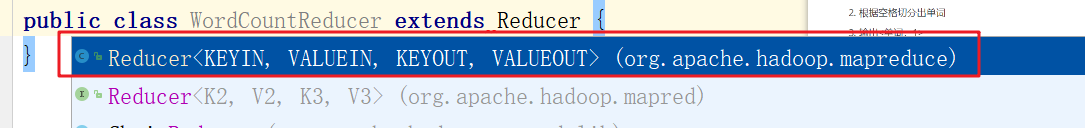

### --- 编写Reducer类

~~~ 选择继承的Reducer类

package com.yanqi.mr.wc;

import com.sun.org.apache.bcel.internal.generic.NEW;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

//继承的Reducer类有四个泛型参数,2对kv

//第一对kv:类型要与Mapper输出类型一致:Text, IntWritable

//第二队kv:自己设计决定输出的结果数据是什么类型:Text, IntWritable

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

//1 重写reduce方法

//Text key:map方法输出的key,本案例中就是单词,

// Iterable<IntWritable> values:一组key相同的kv的value组成的集合

IntWritable total = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

//2 遍历key对应的values,然后累加结果

int sum = 0;

for (IntWritable value : values) {

int i = value.get();

sum += 1;

}

// 3 直接输出当前key对应的sum值,结果就是单词出现的总次数

total.set(sum);

context.write(key, total);

/*

假设map方法:hello 1;hello 1;hello 1

reduce的key和value是什么?

key:hello,

values:<1,1,1>

假设map方法输出:hello 1;hello 1;hello 1,hadoop 1, mapreduce 1,hadoop 1

reduce的key和value是什么?

reduce方法何时调用:一组key相同的kv中的value组成集合然后调用一次reduce方法

第一次:key:hello ,values:<1,1,1>

第二次:key:hadoop ,values<1,1>

第三次:key:mapreduce ,values<1>

*/

}

}

六、WordCount案例之Driver类

### --- 编写Driver驱动类

package com.yanqi.mr.wc;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.CombineTextInputFormat;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.io.IOException;

//封装任务并提交运行

public class WordCountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

/*

1. 获取配置文件对象,获取job对象实例

2. 指定程序jar的本地路径

3. 指定Mapper/Reducer类

4. 指定Mapper输出的kv数据类型

5. 指定最终输出的kv数据类型

6. 指定job处理的原始数据路径

7. 指定job输出结果路径

8. 提交作业

*/

// 1. 获取配置文件对象,获取job对象实例

final Configuration conf = new Configuration();

//针对reduce端输出使用snappy压缩

// conf.set("mapreduce.output.fileoutputformat.compress", "true");

// conf.set("mapreduce.output.fileoutputformat.compress.type", "RECORD");

// conf.set("mapreduce.output.fileoutputformat.compress.codec", "org.apache.hadoop.io.compress.SnappyCodec");

final Job job = Job.getInstance(conf, "WordCountDriver");

// 2. 指定程序jar的本地路径

job.setJarByClass(WordCountDriver.class);

// 3. 指定Mapper/Reducer类

job.setMapperClass(WordCountMapper.class);

job.setReducerClass(WordCountReducer.class);

// 4. 指定Mapper输出的kv数据类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

// 5. 指定最终输出的kv数据类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// 6. 指定job读取数据路径

FileInputFormat.setInputPaths(job, new Path(args[0])); //指定读取数据的原始路径

// 7. 指定job输出结果路径

FileOutputFormat.setOutputPath(job, new Path(args[1])); //指定结果数据输出路径

// 8. 提交作业

final boolean flag = job.waitForCompletion(true);

//jvm退出:正常退出0,非0值则是错误退出

System.exit(flag ? 0 : 1);

}

}Walter Savage Landor:strove with none,for none was worth my strife.Nature I loved and, next to Nature, Art:I warm'd both hands before the fire of life.It sinks, and I am ready to depart

——W.S.Landor

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!