logback

官网:http://logback.qos.ch/manual/index.html

一、介绍

Logback,一个“可靠、通用、快速而又灵活的Java日志框架”。

分为以下几个模块:

logback-classic:log4j的一个改良版本,同时它完整提供了slf4j API是我们可以很方便地更换成其他日志系统如log4j

logback-access:访问模块与Servlet容器集成提供通过HTTP来访问日志的功能

logback-core:其他两个模块的基础模块

二、取代log4j的理由

1、更快的实现:重写了内核,在一些关键执行路径上性能提升了10倍以上,而且logback不仅性能提升了,初始化内存加载也更小了

2、非常充分的测试

3、Logback-classic非常自然实现了SLF4j:Logback-classic实现了SLF4j。在使用SLF4j中,你都感觉不到logback-classic。而且因为logback-classic非常自然地实现了slf4j ,

所以切换到log4j或者其他,非常容易,只需要提供成另一个jar包就OK,根本不需要去动那些通过SLF4JAPI实现的代码。

4、非常充分的文档,官网有两百多页的文档,官网地址:https://logback.qos.ch/index.html

5、自动重新加载配置文件,当配置文件修改了,Logback-classic能自动重新加载配置文件。扫描过程快且安全,它并不需要另外创建一个扫描线程。这个技术充分保证了应用程序能跑得很欢

在JEE环境里面。

6、Lilith是log事件的观察者,和log4j的chainsaw类似。而lilith还能处理大数量的log数据 。

7、谨慎的模式和非常友好的恢复,在谨慎模式下,多个FileAppender实例跑在多个JVM下,能 够安全地写道同一个日志文件。RollingFileAppender会有些限制。Logback的FileAppender和它

的子类包括 RollingFileAppender能够非常友好地从I/O异常中恢复。

8、配置文件可以处理不同的情况,开发人员经常需要判断不同的Logback配置文件在不同的环境下(开发,测试,生产)。而这些配置文件仅仅只有一些很小的不同,可以通过,和来实现,这

样一个配置文件就可以适应多个环境。

9、Filters(过滤器)有些时候,需要诊断一个问题,需要打出日志。在log4j,只有降低日志级别,不过这样会打出大量的日志,会影响应用性能。在Logback,你可以继续 保持那个日志级别

而除掉某种特殊情况,如alice这个用户登录,她的日志将打在DEBUG级别而其他用户可以继续打在WARN级别。要实现这个功能只需加4行XML配置。可以参考MDCFIlter 。

10、SiftingAppender(一个非常多功能的Appender):它可以用来分割日志文件根据任何一个给定的运行参数。如,SiftingAppender能够区别日志事件跟进用户的Session,然后每个用户会

有一个日志文件。

11、自动压缩已经打出来的log:RollingFileAppender在产生新文件的时候,会自动压缩已经打出来的日志文件。压缩是个异步过程,所以甚至对于大的日志文件,在压缩过程中应用不会受任

何影响。

12、堆栈树带有包版本:Logback在打出堆栈树日志时,会带上包的数据。

13、自动去除旧的日志文件:通过设置TimeBasedRollingPolicy或者SizeAndTimeBasedFNATP的maxHistory属性,你可以控制已经产生日志文件的最大数量。如果设置maxHistory 12,那那些

log文件超过12个月的都会被自动移除。

三、Logback的结构

Logback建立在三个类之上:Logger,Appender和Layouts(记录器、附加器、布局)。这三个类型的组件一起工作使开发人员能够根据消息类型和级别记录消息,并在运行时控制如何格式化这些消息以及在何处打印这些消息。

Logger context:指定了日志输出的上下文

Appender(附加目的地):Logback允许将日志输出到多个目的地,一个输出目的地对应一个Appender。目前Appeners有,console、file、remote socket servers、to MySQL、PostgreSQL 还有其他的数据库、JMS、remote UNIX Syslog daemons。

一个Logger可以输出到一个或多个appender。

默认情况下,日志输出Appender会继承,如所有的Logger都会输出到root指定的Appender,子包会输出到其父包的Appender。所以想要避免重复输出,需要指定additivity属性为false。

如果想根据日志级别筛选appender,那就使用filter,常用的filter有只输出某个级别的和输出定义级别及以上级别的过滤器:

<filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>INFO</level>// 只输出INFO级别的日志 <onMatch>ACCEPT</onMatch> // 匹配就接受 <onMismatch>DENY</onMismatch> // 不匹配就拒绝 </filter>

<filter class="ch.qos.logback.classic.filter.ThresholdFilter"> <level>INFO</level> // 接受所有INFO及以上级别的日志,WARN、ERROR </filter>

配置详解:

1)配置文件

①、logback首先会试着查找logback.groovy文件;

②、当没有找到时,继续试着查找logback-test.xml文件;

③、当没有找到时,继续试着查找logback.xml文件;

④、如果仍然没有找到,则使用默认配置(打印到控制台)。

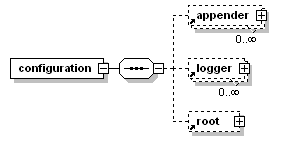

2)logback.xml配置介绍

appender:主要用于指定日志的输出目的地,目的地可以是控制台、文件、远程套接字服务器、MySQL等

logger:用来设置某一个包或具体的某一个类的日志打印级别,以及指定<appender>,<logger>仅有一个name属性,一个可选的level和一个可选的addtivity属性,可以包含零个或多个<appender-ref>元素,标识这个appender将会添加这个logger

root:也是logger元素,是所有logger的上级,只有一个level属性

pattern:

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS}|%thread|%-5level|%X{threadId}|%r|%C|%msg%n</pattern>

%表示日期

| 表示分隔符,可以自己指定其他分隔符

%t/thread表示线程名

%-5level:表示显示日志的级别,从左显示5个字符宽度

%X{traceId}:traceId是自己定义的线程追踪id,在代码中使用MDC.put()开始,MDC.remove()结束

MDC.put("traceId", UUID.randomUUID().toString().replaceAll("-", ""));

...

MDC.remove("traceId");

%r/relative:输出应用程序启动到创建日志事件所花费的毫秒数

%C/class:表示输出日志所在类的全路径

%msg/m/message:表示日志信息

%n:换行符

%L/line:输出发起日志请求所在的行号

%M/method:输出发起日志请求的方法名

如:%C{0}#%M:%L 配置:

- `%C{0}` 表示输出日志的类名,`{0}` 表示只输出类名,不包含包名。

- `#` 表示分隔符。

- `%M` 表示输出日志的方法名。

- `:` 表示分隔符。

- `%L` 表示输出日志的行号。

因此,这个格式化输出的结果是类名、方法名和行号以特定的格式组合在一起,用于标识日志输出的位置。

例如,输出类名为 `com.example.MyClass`,方法名为 `myMethod`,行号为 `42` 的日志,格式化输出的结果为 `MyClass#myMethod:42`。控制输出日志的长度:

%.-1024msg,msg的长度最大为1024,超过1024则从末尾截取

第一个可选的格式修饰符是左对齐标志,它只是减号 (-) 字符。

然后是可选的最小字段宽度 修饰符,这是一个十进制常量,表示要输出的最小字符数。如果数据项包含的字符较少,则会在左侧或右侧填充,直到达到最小宽度。默认是在左侧填充(右对齐),但您可以使用左对齐标志指定右填充。填充字符是空格。如果数据项大于最小字段宽度,则扩展字段以容纳数据。该值永远不会被截断。

可以使用由句点后跟十进制常量指定的最大字段宽度修饰符来更改此行为。如果数据项长于最大字段,则从 数据项的开头删除多余的字符。例如,如果最大字段宽度为 8,而数据项的长度为 10 个字符,则删除数据项的前两个字符,使用-指定左对齐的话,则会从右侧删除多余的字符

| 格式修饰符 | 左对齐 | 最小宽度 | 最大宽度 | 评论 |

|---|---|---|---|---|

| %20记录器 | 错误的 | 20 | 没有任何 | 如果记录器名称的长度少于 20 个字符,则用空格填充。 |

| %-20记录器 | 真的 | 20 | 没有任何 | 如果记录器名称的长度少于 20 个字符,则用空格填充右侧。 |

| %.30记录器 | 不适用 | 没有任何 | 30 | 如果记录器名称超过 30 个字符,则从头开始截断。 |

| %20.30记录器 | 错误的 | 20 | 30 | 如果记录器名称短于 20 个字符,则左填充空格。但是,如果记录器名称超过 30 个字符,则从头开始截断。 |

| %-20.30记录器 | 真的 | 20 | 30 | 如果记录器名称短于 20 个字符,则用空格填充右侧。但是,如果记录器名称超过 30 个字符,则从头 开始截断。 |

| %.-30记录器 | 不适用 | 没有任何 | 30 | 如果记录器名称超过 30 个字符, 则从末尾 截断。 |

下表列出了格式修饰符截断的示例。请注意方括号,即一对“[]”字符,不是输出的一部分。它们用于分隔输出的宽度。

| 格式修饰符 | 记录器名称 | 结果 |

|---|---|---|

| [%20.20记录器] | 主要名称 |

|

| [%-20.20记录器] | 主要名称 |

|

| [%10.10记录器] | main.foo.foo.bar.Name |

|

| [%10.-10记录器] | main.foo.foo.bar.Name |

|

RollingFileAppender:

| 属性名 | 类型 | 描述 |

| file | String | 日志文件路径和文件名 |

| append | boolean | |

| encoder | Encoder | 日志输出格式 |

| rollingPolicy | RollingPolicy | 滚动策略,如:TimeBasedRollingPolicy |

| triggeringPolicy | TriggeringPolicy | 触发策略 |

| prudent | boolean |

| 属性名 | 类型 | 描述 |

| fileNamePattern | String | 滚动输出文件命名格式,如:${LOG_HOME}/error.log.%d{yyyy-MM-dd} |

| maxHistory | int | 可选的 maxHistory 属性控制要保留的存档文件的最大数量,异步删除旧文件。例如,如果您指定每月翻转,并将 maxHistory 设置为 6,则将保留 6 个月的存档文件,而 6 个月之前的文件将被删除。请注意,由于旧的归档日志文件已被删除,因此为归档日志文件而创建的任何文件夹都将被适当地删除 |

| totalSizeCap | int | 可选的 totalSizeCap 属性控制所有存档文件的总大小。当超过总大小上限时,最旧的档案将被异步删除。 totalSizeCap 属性也需要设置 maxHistory 属性。此外,始终首先应用“最大历史记录”限制,然后应用“总大小上限”限制 |

| cleanHistoryOnStart | boolean |

如果设置为 true,归档删除将在 appender 启动时执行。默认情况下,此属性设置为 false。 档案删除通常在翻转期间执行。但是,某些应用程序的生存时间可能不足以触发翻转。因此,对于此类短暂的应用程序,归档删除可能永远不会有机会执行。通过将 cleanHistoryOnStart 设置为 true,在 appender 启动时执行归档删除 |

四、实践

①、pom配置:

slf4j(Simple Logging Facade for Java):

<dependency> <groupId>org.slf4j</groupId> <artifactId>slf4j-api</artifactId> <version>1.7.28</version> </dependency>

logback:

<!--logback--> <dependency> <groupId>ch.qos.logback</groupId> <artifactId>logback-access</artifactId> <version>1.0.0</version> </dependency> <dependency> <groupId>ch.qos.logback</groupId> <artifactId>logback-classic</artifactId> <version>1.1.11</version> </dependency> <dependency> <groupId>ch.qos.logback</groupId> <artifactId>logback-core</artifactId> <version>1.1.11</version> </dependency>

(SpringBoot默认引入了logback相关的jar包依赖,spring-boot-starter其中包含了 spring-boot-starter-logging,而 spring-boot-starter-web 包含了spring-boot-starter,所以引入web组件即可)

②、在工程src目录下建立logback.xml

一个简单的配置:

<?xml version="1.0" encoding="UTF-8"?> <configuration debug="false"> <!--定义日志文件的存储地址 勿在 LogBack 的配置中使用相对路径--> <property name="LOG_HOME" value="/logback/LogFile"/> <!--控制台输出--> <appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender"> <encoder> <pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%thread|%-5level|%r|%X{threadId}|%C|%msg%n</pattern> </encoder> </appender> <!--<logger name=""--> <root level="INFO"> <appender-ref ref="STDOUT"/> </root> </configuration>

项目中稍复杂的配置:

<?xml version="1.0" encoding="UTF-8"?> <!--默认每隔一分钟扫描此配置文件的修改并重新加载--> <configuration> <!--定义日志文件的存储地址 勿在LogBack的配置中使用相对路径--> <property name="LOG_HOME" value="xxx/logs"/> <!--控制台输出--> <appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender"> <!-- encoders are assigned the type ch.qos.logback.classic.encoder.PatternLayoutEncoder by default --> <encoder> <pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%highlight(%-5level)|%green(%X{threadId})|%cyan(%C{0}#%M:%L)|%msg%n</pattern> </encoder> </appender> <!--输出日志到文件中--> <appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <file>${LOG_HOME}/info.log</file> <!--不输出ERROR级别的日志--> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>ERROR</level> <onMatch>DENY</onMatch> <onMismatch>ACCEPT</onMismatch> </filter> <!--根据日期滚动输出日志策略--> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <fileNamePattern>${LOG_HOME}/info.log.%d{yyyy-MM-dd}</fileNamePattern> <!--日志保留文件数--> <maxHistory>30</maxHistory> </rollingPolicy> <encoder> <pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{threadId}|%C{0}#%M:%L|%msg%n</pattern> </encoder> </appender> <!--错误日志输出文件--> <appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender"> <file>${LOG_HOME}/error.log</file> <!--只输出ERROR级别的日志--> <filter class="ch.qos.logback.classic.filter.LevelFilter"> <level>ERROR</level> <onMatch>ACCEPT</onMatch> <onMismatch>DENY</onMismatch> </filter> <!--根据日期滚动输出日志策略--> <rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"> <fileNamePattern>${LOG_HOME}/error.log.%d{yyyy-MM-dd}</fileNamePattern> <!--日志保留文件数--> <maxHistory>30</maxHistory> </rollingPolicy> <encoder> <pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{threadId}|%C{0}#%M:%L|%msg%n</pattern> </encoder> </appender> <!--异步打印日志,任务放在阻塞队列中,如果队列达到80%,将会丢弃TRACE,DEBUG,INFO级别的日志任务,对性能要求不是太高的话不用启用--> <appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender"> <queueSize>1000</queueSize> <!--设为0表示队列达到80%,也不丢弃任务--> <discardingThreshold>0</discardingThreshold> <!--日志上下文关闭后,AsyncAppender继续执行写任务的时间,单位毫秒--> <maxFlushTime>1000</maxFlushTime> <!--队列满了直接丢弃要写的消息--> <neverBlock>true</neverBlock> <!--是否包含调用方的信息,false则无法打印类名方法名行号等--> <includeCallerData>true</includeCallerData> <!--One and only one appender may be attached to AsyncAppender,添加多个的话后面的会被忽略--> <appender-ref ref="FILE"/> </appender> <appender name="ERROR_ASYNC" class="ch.qos.logback.classic.AsyncAppender"> <queueSize>256</queueSize> <!--设为0表示队列达到80%,也不丢弃任务--> <discardingThreshold>0</discardingThreshold> <!--日志上下文关闭后,AsyncAppender继续执行写任务的时间,单位毫秒--> <maxFlushTime>1000</maxFlushTime> <!--队列满了直接丢弃要写的消息,不阻塞写入队列--> <neverBlock>true</neverBlock> <!--是否包含调用方的信息,false则无法打印类名方法名行号等--> <includeCallerData>true</includeCallerData> <!--One and only one appender may be attached to AsyncAppender,添加多个的话后面的会被忽略--> <appender-ref ref="ERROR_FILE"/> </appender> <!--指定一些依赖包的日志输出级别,所有的logger会继承root,为了避免日志重复打印,需指定additivity="false",将不会继承root的append-ref--> <!-- <logger name="com.xxx" level="ERROR" additivity="false"> <appender-ref ref="STDOUT"/> <!–<appender-ref ref="ERROR_FILE"/>–> </logger>--> <root level="INFO"> <!--<appender-ref ref="STDOUT"/>--> <appender-ref ref="FILE"/> <appender-ref ref="ERROR_FILE"/> <!--使用异步打印日志--> <!--<appender-ref ref="ASYNC"/>--> <!--<appender-ref ref="ERROR_ASYNC"/>--> </root> </configuration>

五、自定义日志Appender(日志输出目的地)

1 public class CustomAsyncAppender extends UnsynchronizedAppenderBase<ILoggingEvent> { 2 3 private static final Logger LOGGER = LoggerFactory.getLogger(CustomElkAsyncAppender.class); 4 5 /** 6 * 每条日志都会被包装成ILoggingEvent对象,传入append方法中。可通过此对象获取日志主体信息,当前线程,日志名称等信息 7 * 8 * @param eventObject 9 */ 10 @Override 11 protected void append(ILoggingEvent eventObject) { 12 try { 13 String ip = InetAddress.getLocalHost().getHostAddress(); 14 15 LogMsg logMsg = new LogMsg(); 16 logMsg.setTimestamp(eventObject.getTimeStamp()); 17 logMsg.setIp(ip); 18 logMsg.setLevel(eventObject.getLevel().levelStr); 19 logMsg.setThread_name(eventObject.getThreadName()); 20 logMsg.setThread_id(eventObject.getMDCPropertyMap().get("threadId")); 21 logMsg.setLogger_name(eventObject.getLoggerName()); 22 logMsg.setMethod(getMethodName(eventObject)); 23 logMsg.setLine(getLine(eventObject)); 24 logMsg.setMsg(eventObject.getFormattedMessage()); 25 if (eventObject.getThrowableProxy() != null) { 26 logMsg.setErr(eventObject.getThrowableProxy().getMessage()); 27 logMsg.setErr_stack_trace(ThrowableProxyUtil.asString(eventObject.getThrowableProxy())); 28 } 29 //日志写到哪里,消息队列等等 30 XXX 31 } catch (Exception e) { 32 LOGGER.info("写日志异常:" + e.getMessage(), e); 33 } 34 } 35 36 /** 37 * 输出日志的方法名 38 * @param eventObject 39 * @return 40 */ 41 private String getMethodName(ILoggingEvent eventObject) { 42 StackTraceElement[] cda = eventObject.getCallerData(); 43 if (cda != null && cda.length > 0) { 44 return cda[0].getMethodName(); 45 } else { 46 return CallerData.NA; 47 } 48 } 49 50 /** 51 * 输出日志的行号 52 * @param eventObject 53 * @return 54 */ 55 private String getLine(ILoggingEvent eventObject) { 56 StackTraceElement[] cda = eventObject.getCallerData(); 57 if (cda != null && cda.length > 0) { 58 return Integer.toString(cda[0].getLineNumber()); 59 } else { 60 return CallerData.NA; 61 } 62 } 63 64 65 }

自定义appender 在logback.xml中的配置:

<!-- 自定义appender,发送至ELK --> <appender name="ELK_LOG" class="com.xiaomi.mitv.outgoing.common.custom.CustomAsyncAppender"> <filter class="ch.qos.logback.classic.filter.ThresholdFilter"> <level>INFO</level> </filter> </appender> <root level="INFO"> <!-- INFO级别以上的日志交由自定义appender处理发送至ELK --> <appender-ref ref="ELK_LOG"/> </root>

logback日志配置最佳实践

1、使用两种滚动策略来控制日志文件的滚动输出:

①:FixedWindowRollingPolicy:按照固定窗口大小滚动输出日志,即当日志文件大小达到一定值后,将当前日志文件重命名并创建一个新的日志文件来继续输出日志。这里的配置中,日志文件名为error,%i表示日志文件的序号,minIndex表示日志文件的最小序号,maxIndex表示日志文件的最大序号

②: SizeBasedTriggeringPolicy:按照日志文件大小滚动输出日志,即当日志文件大小达到一定值后,将当前日志文件重命名并创建一个新的日志文件来继续输出日志。这里的配置中,maxFileSize表示日志文件的最大大小为1GB

<?xml version="1.0" encoding="UTF-8"?>

<!--默认每隔一分钟扫描此配置文件的修改并重新加载-->

<configuration>

<!--定义日志文件的存储地址 勿在LogBack的配置中使用相对路径-->

<property name="LOG_HOME" value="/home/work/log"/>

<!--输出日志到文件中-->

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_HOME}/info.log</file>

<!--不输出ERROR级别的日志-->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>DENY</onMatch>

<onMismatch>ACCEPT</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy">

<fileNamePattern>${LOG_HOME}/info%i.log</fileNamePattern>

<minIndex>1</minIndex>

<maxIndex>15</maxIndex>

</rollingPolicy>

<!--根据日期滚动输出日志策略-->

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<!--文件大小限制,超过这个限制则滚动覆盖当前文件-->

<maxFileSize>1GB</maxFileSize>

</triggeringPolicy>

<encoder>

<pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{traceId}|%C{0}#%M:%L|%.-4096msg%n</pattern>

</encoder>

</appender>

<!--错误日志输出文件-->

<appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_HOME}/error.log</file>

<!--只输出ERROR级别的日志-->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.FixedWindowRollingPolicy">

<fileNamePattern>${LOG_HOME}/error%i.log</fileNamePattern>

<minIndex>1</minIndex>

<maxIndex>15</maxIndex>

</rollingPolicy>

<!--根据日期滚动输出日志策略-->

<triggeringPolicy class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<maxFileSize>1GB</maxFileSize>

</triggeringPolicy>

<encoder>

<pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{traceId}|%C{0}#%M:%L|%msg%n</pattern>

</encoder>

</appender>

<!--异步打印日志,任务放在阻塞队列中,如果队列达到80%,将会丢弃TRACE,DEBUG,INFO级别的日志任务,对性能要求不是太高的话不用启用-->

<appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<!--队列的深度,该值会影响性能,默认256-->

<queueSize>512</queueSize>

<!--设为0表示队列达到80%,也不丢弃任务-->

<discardingThreshold>0</discardingThreshold>

<!--日志上下文关闭后,AsyncAppender继续执行写任务的时间,单位毫秒-->

<maxFlushTime>1000</maxFlushTime>

<!--队列满了直接丢弃要写的消息-->

<neverBlock>true</neverBlock>

<!--是否包含调用方的信息,false则无法打印类名方法名行号等-->

<includeCallerData>true</includeCallerData>

<!--One and only one appender may be attached to AsyncAppender,添加多个的话后面的会被忽略-->

<appender-ref ref="FILE"/>

</appender>

<appender name="ERROR_ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>256</queueSize>

<!--设为0表示队列达到80%,也不丢弃任务-->

<discardingThreshold>0</discardingThreshold>

<!--日志上下文关闭后,AsyncAppender继续执行写任务的时间,单位毫秒-->

<maxFlushTime>1000</maxFlushTime>

<!--队列满了直接丢弃要写的消息,不阻塞写入队列-->

<neverBlock>true</neverBlock>

<!--是否包含调用方的信息,false则无法打印类名方法名行号等-->

<includeCallerData>true</includeCallerData>

<!--One and only one appender may be attached to AsyncAppender,添加多个的话后面的会被忽略-->

<appender-ref ref="ERROR_FILE"/>

</appender>

<!--指定一些依赖包的日志输出级别,所有的logger会继承root,为了避免日志重复打印,需指定additivity="false",将不会继承root的append-ref-->

<!-- <logger name="com.xiaomi.mitv.outgoing" level="ERROR" additivity="false">

<appender-ref ref="STDOUT"/>

<!–<appender-ref ref="ERROR_FILE"/>–>

</logger>-->

<!-- <logger name="com.xiaomi.passport" level="INFO" additivity="false">

<appender-ref ref="ERROR_FILE"/>

</logger>-->

<root level="INFO">

<!--<appender-ref ref="FILE"/>-->

<!--<appender-ref ref="ERROR_FILE"/>-->

<!--使用异步打印日志-->

<appender-ref ref="ASYNC"/>

<appender-ref ref="ERROR_ASYNC"/>

</root>

</configuration>

这个日志配置可以进行一些优化,具体如下:

1. 考虑使用TimeBasedRollingPolicy来代替FixedWindowRollingPolicy,这样可以按照时间来滚动输出日志,而不是按照固定窗口大小。这样可以更加灵活地控制日志文件的数量和大小。

2. 考虑将日志文件的最大大小调整为更合适的值,以便更好地平衡日志文件大小和数量之间的关系。

综上所述,这个日志配置可以进行一些优化,以便更好地满足业务需求和管理要求。

2、按小时滚动输出日志文件,并控制文件的个数和总日志大小

1. 使用了TimeBasedRollingPolicy来按照时间滚动输出日志

2. 每小时生成一个日志文件,最多保留7天,7*24=168的日志文件

3. 日志文件总大小不超过30G,超过则删除最早的日志文件

4. 将异步打印日志的阻塞队列大小调整为合适的值,避免队列满了之后丢失日志

5. 将日志文件的存储地址配置为环境变量,这样可以在不同的环境中方便地修改日志文件的存储位置

<?xml version="1.0" encoding="UTF-8"?>

<!--默认每隔一分钟扫描此配置文件的修改并重新加载-->

<configuration>

<!--定义了一个名为"LOG_HOME"的属性,并将其值设置为环境变量"LOG_HOME"的值,如果环境变量未设置,则使用默认值"/home/work/log"-->

<property name="LOG_HOME" value="${LOG_HOME:-/home/work/log}"/>

<!--输出日志到文件中-->

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_HOME}/info.log</file>

<!--不输出ERROR级别的日志-->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>DENY</onMatch>

<onMismatch>ACCEPT</onMismatch>

</filter>

<!--每小时输出一个日志文件,最多保留7天,7*24=168,总大小不超过30G,超过会删除最早的日志文件-->

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<fileNamePattern>${LOG_HOME}/info.%d{yyyy-MM-dd_HH}.log</fileNamePattern>

<maxHistory>168</maxHistory>

<totalSizeCap>30GB</totalSizeCap>

</rollingPolicy>

<encoder>

<pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{traceId}|%C{0}#%M:%L|%.-4096msg%n</pattern>

</encoder>

</appender>

<!--错误日志输出文件-->

<appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_HOME}/error.log</file>

<!--只输出ERROR级别的日志-->

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<fileNamePattern>${LOG_HOME}/error.%d{yyyy-MM-dd_HH}.log</fileNamePattern>

<maxHistory>168</maxHistory>

<totalSizeCap>30GB</totalSizeCap>

</rollingPolicy>

<encoder>

<pattern>%date{yyyy-MM-dd HH:mm:ss.SSS}|%t|%-5level|%X{traceId}|%C{0}#%M:%L|%msg%n</pattern>

</encoder>

</appender>

<!--异步打印日志,任务放在阻塞队列中,如果队列达到80%,将会丢弃TRACE,DEBUG,INFO级别的日志任务,对性能要求不是太高的话不用启用-->

<appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<!--是否包含调用方的信息,false则无法打印类名方法名行号等-->

<includeCallerData>true</includeCallerData>

<!--将异步打印日志的阻塞队列大小调整为合适的值,避免队列满了之后丢失日志-->

<queueSize>10000</queueSize>

<!--One and only one appender may be attached to AsyncAppender,添加多个的话后面的会被忽略-->

<appender-ref ref="FILE"/>

</appender>

<appender name="ERROR_ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<includeCallerData>true</includeCallerData>

<queueSize>10000</queueSize>

<appender-ref ref="ERROR_FILE"/>

</appender>

<!--指定一些依赖包的日志输出级别,所有的logger会继承root,为了避免日志重复打印,需指定additivity="false",将不会继承root的append-ref-->

<!-- <logger name="com.xiaomi.mitv.outgoing" level="ERROR" additivity="false">

<appender-ref ref="STDOUT"/>

<!–<appender-ref ref="ERROR_FILE"/>–>

</logger>-->

<root level="INFO">

<!--<appender-ref ref="FILE"/>-->

<!--<appender-ref ref="ERROR_FILE"/>-->

<!--使用异步打印日志-->

<appender-ref ref="ASYNC"/>

<appender-ref ref="ERROR_ASYNC"/>

</root>

</configuration>

END.