hadoop的扩容

一、横向扩容(参见:https://www.cnblogs.com/yangy1/p/12362565.html)

现在在此基础上再添加一个节点

1、克隆一台主机hdp03(克隆hdp02)

修改ip

vim /etc/sysconfig/network-scripts/ifcfg-ens33 IPADDR=192.168.0.43

修改主机名及添加主机映射

vim /etc/hostname

hdp03

vim /etc/hosts

192.168.0.43 hdp03

删除tmp下的目录文件

cd /opt/software/hadoop-2.7.7/tmp rm -rf *

2、配置主(有namenode服务的主机)

添加主机映射

vim /etc/hosts 192.168.0.32 hdp01 192.168.0.42 hdp02 192.168.0.43 hdp03 //添加新的映射

配置slaves

vim /opt/software/hadoop-2.7.7/etc/hadoop/slaves hdp01 hdp02 hdp03 //添加新的主机名

3、启动hdp03的datanode

hadoop-daemon.sh start datanode //启动datanode

因为克隆的hdp02,所以和hdp02的私钥一样,不需要重新生成,hdp01可以直接访问

4、访问50070端口

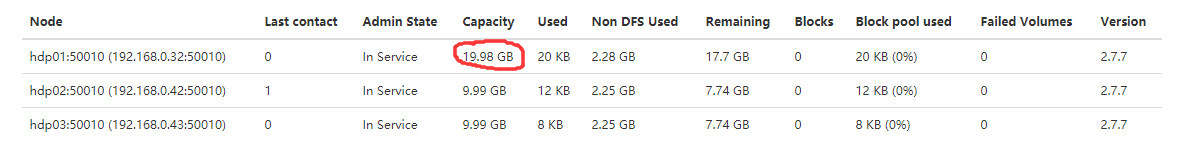

可以看到节点添加上去了,变成了3个。

二、纵向扩容

纵向扩容在hdp01上添加一块新的硬盘

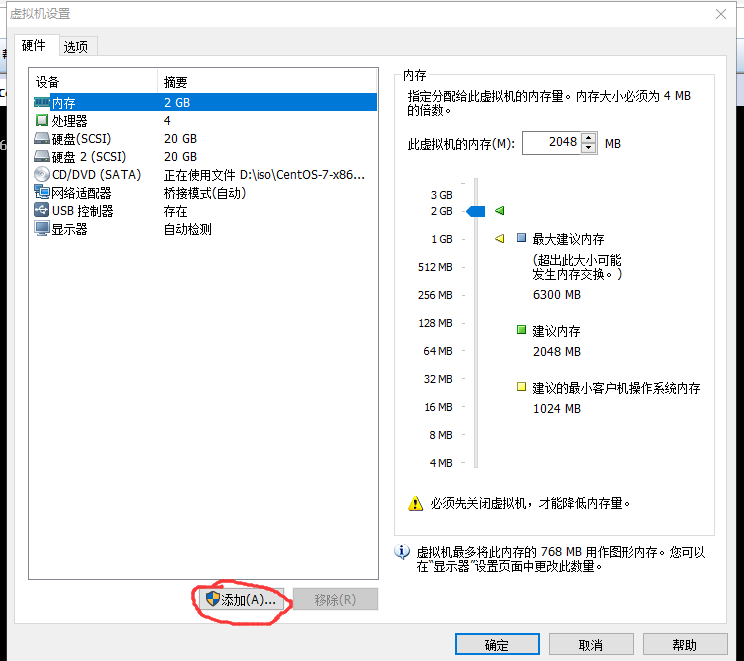

1、在虚拟机目录点击右键——>设置——>添加——>硬盘

然后用默认的配置一直点击下一步添加成功

重启虚拟机

reboot

2、将硬盘分区并挂载

在/dev里可以看到新添加的硬盘sdb

cd /dev

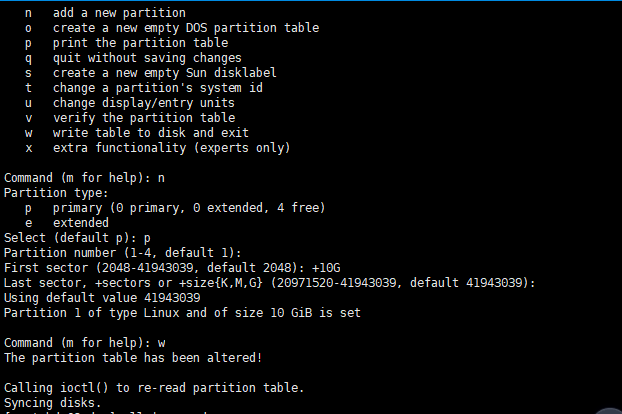

分区

fdisk sdb

m //查看帮助选项

n //添加分区

p //选择主分区

+10G //添加10G

w //保存并退出

再次查看可以看到分区成功sdb1

挂载

先在根目录新建文件夹

cd /

mkdir sdb1

mount /dev/sdb1 /sdb1

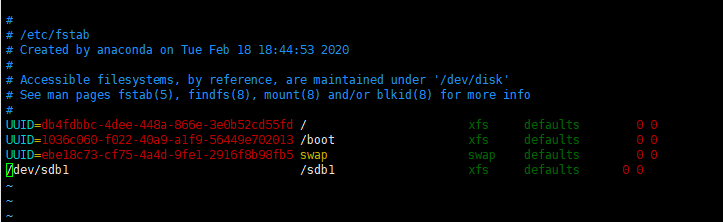

mount的挂载重启后就失效,要想永久挂载需要修改配置

vim /etc/fstab

/dev/sdb1 /sdb1 xfs defaults 0 0 //添加配置

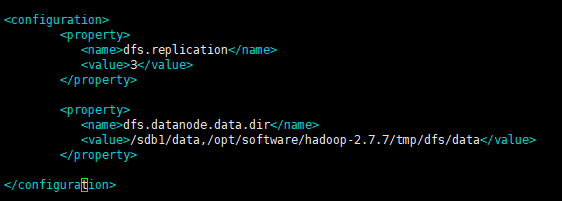

3、修改hdfs-site.xml

cd /opt/software/hadoop-2.7.7/etc/hadoop vim hdfs-site.xml

启动

start-dfs.sh

访问50070端口

可以看到hdp01的容量由原来的9.99GB扩容到19.98GB

浙公网安备 33010602011771号

浙公网安备 33010602011771号