spark IDEA开发环境搭建及运行问题

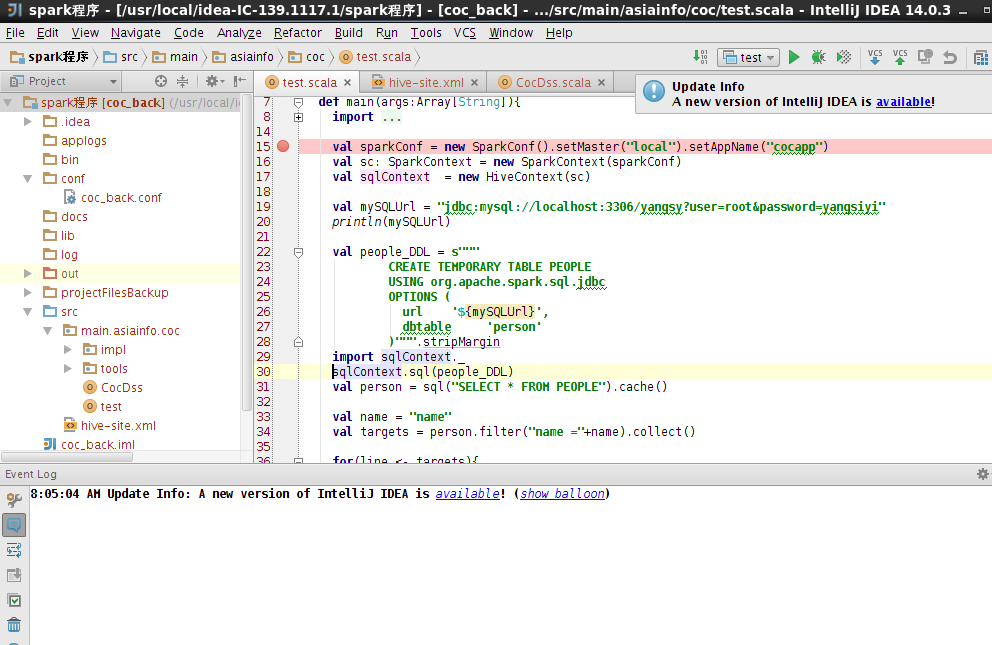

下图是例子:

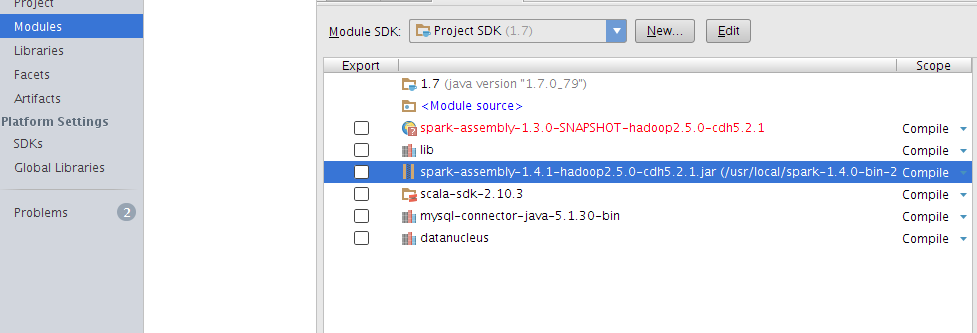

还用说么,引入相关jar包(等下再一一说明) 包括scala,spark-assembly-1.4.1-hadoop2.5.0-cdh5.2.1.jar(按照你的spark和hadoop版本),还有在spark的lib下datanucleus的jar,mysql的数据源连接,这都是必须的~

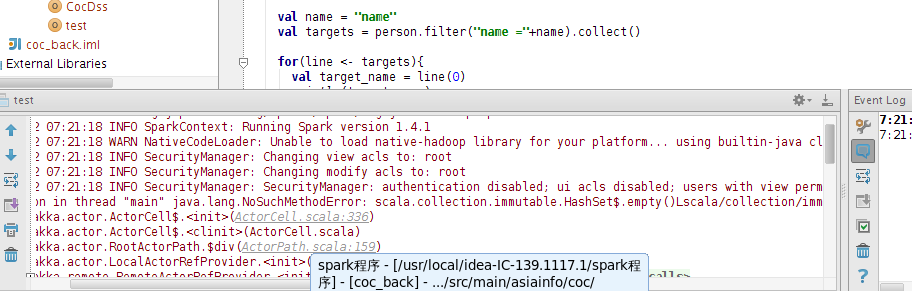

运行如果出现如下错误,说明scala版本较高,spark还不能完全支持最新的scala2.11版本,所以降低到scala-sdk-2.10.3

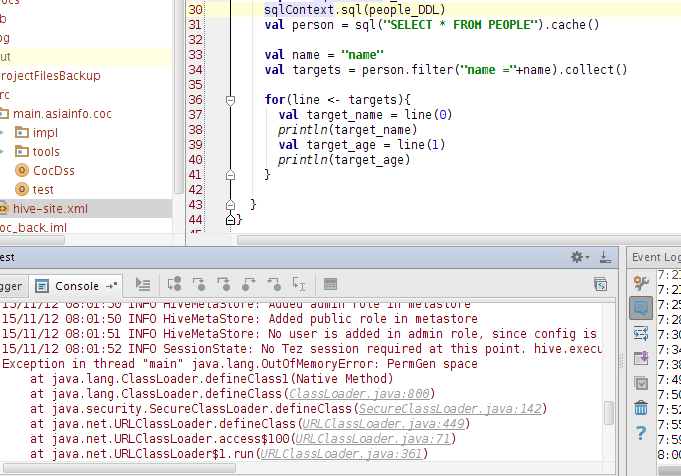

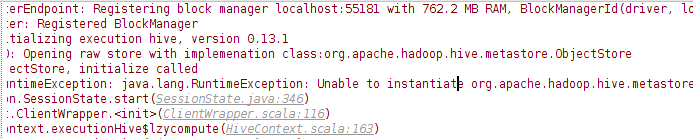

如下图的错误,是因为声明hivecontext时没有找到hive的metastore,所以一定要引入datanucleus的jar,将hive下的 hive-site-xml的配置文件放入项目中,引入mysql的jar包就OK(因为用了mysql为hive的metastore)

然后即将运行完成时,尼玛。。。内存溢出。。。这。。。。无解,只能调大虚拟机内存。