CentOS6安装各种大数据软件 第六章:HBase分布式集群的配置

相关文章链接

CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令

CentOS6安装各种大数据软件 第三章:Linux基础软件的安装

CentOS6安装各种大数据软件 第四章:Hadoop分布式集群配置

CentOS6安装各种大数据软件 第五章:Kafka集群的配置

CentOS6安装各种大数据软件 第六章:HBase分布式集群的配置

CentOS6安装各种大数据软件 第七章:Flume安装与配置

CentOS6安装各种大数据软件 第八章:Hive安装和配置

CentOS6安装各种大数据软件 第九章:Hue大数据可视化工具安装和配置

CentOS6安装各种大数据软件 第十章:Spark集群安装和部署

1. HBase分布式集群的安装准备

#上次HBase安装包到Linux #解压安装包到modules目录下 tar -zxvf hbase-0.98.6-cdh5.3.0.tar.gz -C /opt/modules/ #删除安装包内的docs文档 rm -rf docs/

2. HBase分布式集群的相关配置

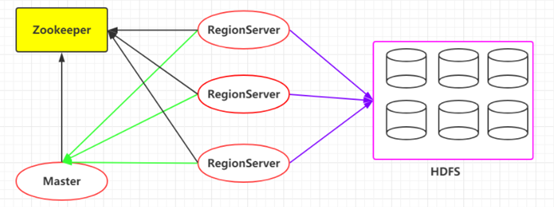

2.1. HBase架构体系

Hbase架构体系还是有两个基础服务作为依赖的.对于Hbase,它的数据存储真正落地是在HDFS文件系统上.因此,它的可扩展性非常强,我们可以对HDFS进行无限的横向扩展.数据的存放和管理我们是通过RegionServer来进行管理的.RegionServer类似于我们之前的DataNode,而Master类似我们之前的NameNode.RegionServer会定时的像Master发送心跳信息,报告自己的健康状态信息。

- Zookeeper:Zookeeper Quorum中除了存储了-ROOT-表的地址和HMaster的地址,HRegionServer也会把自己以Ephemeral方式注册到Zookeeper中,使得HMaster可以随时感知到各个HRegionServer的健康状态。此外,Zookeeper也避免了HMaster的单点问题。

- HBase Master:每台HRegion服务器都会和HMaster服务器通信,HMaster的主要任务就是要告诉每台HRegion服务器它要维护哪些HRegion。当一台新的HRegion服务器登录到HMaster服务器时,HMaster会告诉它先等待分配数据。而当一台HRegion死机时,HMaster会把它负责的HRegion标记为未分配,然后再把它们分配到其他HRegion服务器中。

- HRegionServer:HRegionServer主要负责响应用户I/O请求,向HDFS文件系统中读写数据,是HBase中最核心的模块。

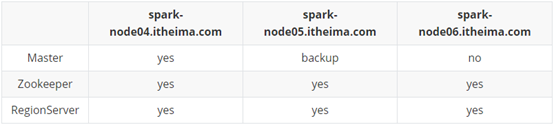

2.2. Hbase分布式集群各服务器的相关配置

3. HBase详细配置信息

参照官网:http://hbase.apache.org/book.html#quickstart

3.1. 在hbase-env.sh配置JavaHome

#导出JAVA_HOME,保证一定有JAVA的环境

export JAVA_HOME=/opt/modules/jdk1.8.0_144

#修改zookeeper,不使用内置的zookeeper实例,使用我们自己安装的zookeeper

export HBASE_MANAGES_ZK=false

3.2. 在hbase-site.xml配置HBase的主配置信息

<!--设置hbase的根目录--> <property> <name>hbase.rootdir</name> <value>hdfs://node01.ouyang.com:9000/hbase</value> </property> <!--开启hbase集群分布式--> <property> <name>hbase.cluster.distributed</name> <value>true</value> </property> <!—Hbase的Zookeeper的信息存放目录--> <property> <name>hbase.zookeeper.property.dataDir</name> <value>/export/data/hbase/zookeeper/</value> </property> <!--zookeeper的地址列表--> <property> <name>hbase.zookeeper.quorum</name> <value>node01.ouyang.com,node02.ouyang.com,node03.ouyang.com</value> </property>

3.3. 在regionservers中配置各个节点的ip地址

node01.ouyang.com

node02.ouyang.com

node03.ouyang.com

3.4. 在conf文件夹下新建backup-masters文件配置备份

#新建配置文件

touch backup-masters

#在该文件中配置备份节点的ip地址即可

node02.ouyang.com

3.5. 将HBase分发给其他节点

scp -r /export/servers/hbase/ node02.ouyang.com:$PWD

scp -r /export/servers/hbase/ node03.ouyang.com:$PWD

4. HBase的服务启动与测试

启动HBase之前需启动Zookeeper好HDFS

4.1. 逐个服务器节点启动HBase

#在节点1的HBase安装目录的bin目录下启动HBase Master

./hbase-daemon.sh start master

#在三节点启动regionserver

./hbase-daemon.sh start regionserver

4.2. 一键启动

#在HBase的bin目录下执行如下命令

./start-hbase.sh

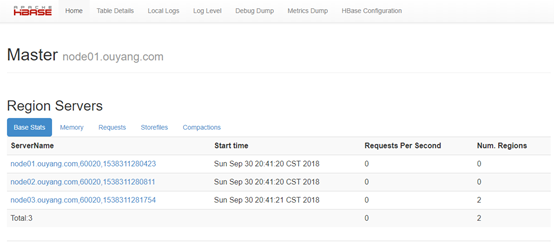

4.3. HBase测试

http://node01.ouyang.com:60010

5. HBase环境变量设置

export HBASE_HOME=/export/servers/hbase

export PATH=${HBASE_HOME}/bin:$PATH

重新加载环境变量的配置文件:source /etc/profile

6. HBase一键启动脚本

步骤一:在onekey文件夹下创建启动脚本文件

touch starthbase.sh

chmod 777 starthbase.sh

touch stophbase.sh

chmod 777 stophbase.sh

步骤二:编辑启动和停止脚本

启动脚本:/export/servers/hbase/bin/start-hbase.sh

停止脚本:/export/servers/hbase/bin/stop-hbase.sh

你现在所遭遇的每一个不幸,都来自一个不肯努力的曾经