Stanford NLP 第六课: Long Short Term Memory

RNN存在着梯度消失的问题, 难以学习长期的依赖关系。如何解决RNN的梯度消失问题? Long Short Term Memory (LSTM) 就是解决这个问题的。

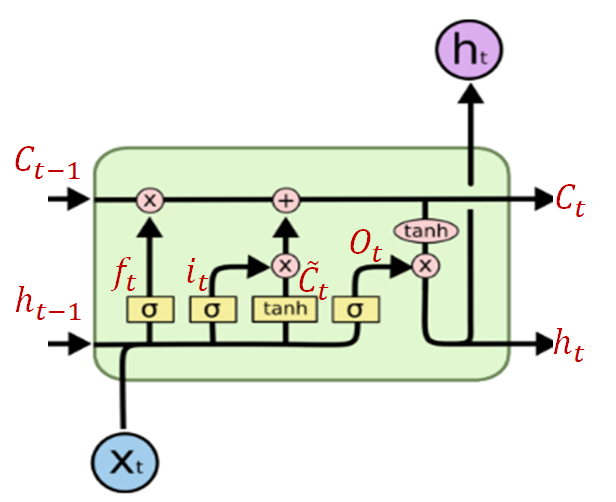

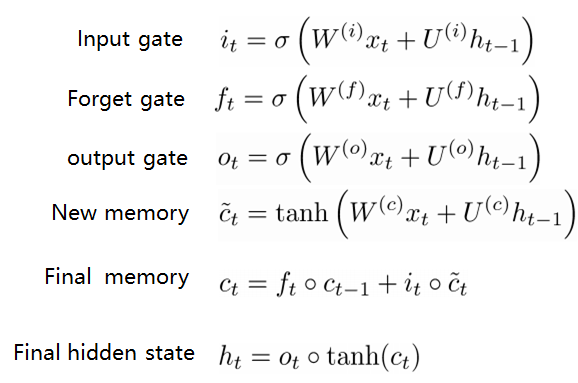

上图是LSTM的一个整体结构。下面是LSTM的细节。下面的整个模块可以看成是一个Memory Cell。Cell的输入有三个, C_t-1, h_t-1, x_t, 输出有两个C_t, h_t; 三个门控组件。输入门i_t, 遗忘门f_t, 输出门o_t。 新的记忆 c^_t, 空心圆圈表示元素级相乘。

一个更加细节一点的示意图。

LSTM是怎么解决梯度消失的问题的?(明天继续)