spark学习收集

spark优化:

http://www.cnblogs.com/hark0623/p/5533803.html

董西成学生写的经验分享(很详细很强大)

spark官网 API

http://spark.apache.org/docs/latest/api/scala/index.html#org.apache.spark.api.java.JavaRDD

spark java api解读--简书

比如:repartitionAndSortWithinPartitions、fullOuterJoin、leftOuterJoin等等

http://www.jianshu.com/u/c8bdd2f507eb

还有今天踩的坑scala 的isInstanceOf、asInstanceOf (classOf)

Spark性能优化指南——高级篇(美团)

https://zhuanlan.zhihu.com/p/21483985

技术大牛-(李伯韬)的技术博客

http://www.cnblogs.com/bourneli/p/4394271.html

spark排错与优化---超时问题

http://blog.csdn.net/lsshlsw/article/details/49155087

《Spark 官方文档》Spark配置-spark官方文档--各参数

http://ifeve.com/spark-config/

FetchFailedException解决方案

http://blog.csdn.net/lsshlsw/article/details/51213610

spark JVM调优之调节executor堆外内存与连接等待时长

http://blog.csdn.net/hutao_hadoop/article/details/52694550

在独立集群模式下:

1. 集群task并行度:SPARK_ EXECUTOR_INSTANCES* SPARK_EXECUTOR_CORES;

2. 集群内存总量:(executor个数) * (SPARK_EXECUTOR_MEMORY+ spark.yarn.executor.memoryOverhead)+(SPARK_DRIVER_MEMORY+spark.yarn.driver.memoryOverhead)。

重点强调:Spark对Executor和Driver额外添加堆内存大小,Executor端:由spark.yarn.executor.memoryOverhead设置,默认值executorMemory * 0.07与384的最大值。Driver端:由spark.yarn.driver.memoryOverhead设置,默认值driverMemory * 0.07与384的最大值。

在yarn模式下,这些配置受yarn的配置限制。

RDD、DataFrame和DataSet的区别

http://www.jianshu.com/p/c0181667daa0

RDD是分布式的Java对象的集合。

DataFrame是分布式的Row对象的集合。

DataSet以Catalyst逻辑执行计划表示,并且数据以编码的二进制形式被存储,不需要反序列化就可以执行sorting、shuffle等操作。

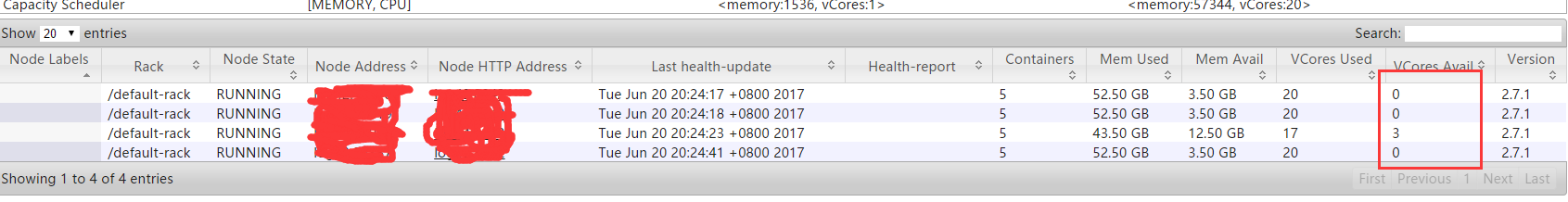

sprk on yarn的CPU空闲问题

yarn默认情况下,只根据内存调度资源,所以spark on yarn运行的时候,即使通过--executor-cores指定vcore个数为N,但是在yarn的资源管理页面上看到使用的vcore个数还是1.----没效果。

http://blog.csdn.net/u012684933/article/details/46800207(原贴)

下边帖子说明了原因

http://www.jianshu.com/p/25788c6caf49(YARN Capacity Scheduler(容量调度器))

Capacity Scheduler有两种比较器用以比较两个资源的大小:

1.默认是DefaultResourceCalculator,它只考虑内存资源。

2.另外一种是DominantResourceCalculator,它采用了DRF比较算法,同时考虑内存和CPU两种资源。

解决:替换资源比较器

<property> <name>yarn.scheduler.capacity.resource-calculator</name> <!-- <value>org.apache.hadoop.yarn.util.resource.DefaultResourceCalculator</value> --> <value>org.apache.hadoop.yarn.util.resource.DominantResourceCalculator</value> </property>

替换后发现内存和cpu都充分使用了

Spark学习+总结+面试

Spark数据本地化及 Locality Levels降级策略

http://www.w2请删掉bc.com/article/222724

今日头条分享

https://www.toutiao.com/c/user/7019620242/#mid=1588835969253380