积累--一些问题积累

1. Batch Normalization应该放在ReLU非线性激活层的前面还是后面? 当卷积层后跟batch normalization层时为什么不要偏置b

https://mp.weixin.qq.com/s/kqLpa_TsWcyjRly_ZJvENw

一般是conv-bn-relu

群里大佬说:

因为bn的作用就是归一化,归一化的话,这样每次输入就都能保证梯度都有一个范围,能一定程度减少ill defined的问题,以及环节梯度爆炸或者梯度消失的问题

然后又有一个大佬提问:

bn前的conv需要加bias吗?

后面他回答:

在bn归一化的时候偏置b就被减掉了,所以bn之前的卷积所带的b最终是没有用的。正在发挥作用的偏置项是bn自己的偏置。

果真,我百度了一下:

当卷积层后跟batch normalization层时为什么不要偏置b

https://blog.csdn.net/u010698086/article/details/78046671

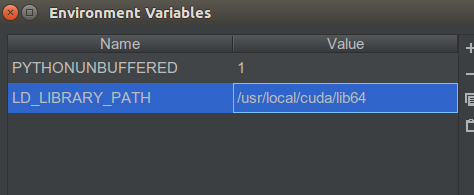

2 pycharm ImportError: libcudart.so.10.0: cannot open shared object file: No such file or directory

报错

ImportError: libcudart.so.10.0: cannot open shared object file: No such file or directory

解决:

在界面

Run -> Edit Configurations ->Environment variables

LD_LIBRARY_PATH /usr/local/cuda/lib64

好记性不如烂键盘---点滴、积累、进步!

浙公网安备 33010602011771号

浙公网安备 33010602011771号