深度学习笔记三——CNN基本结构

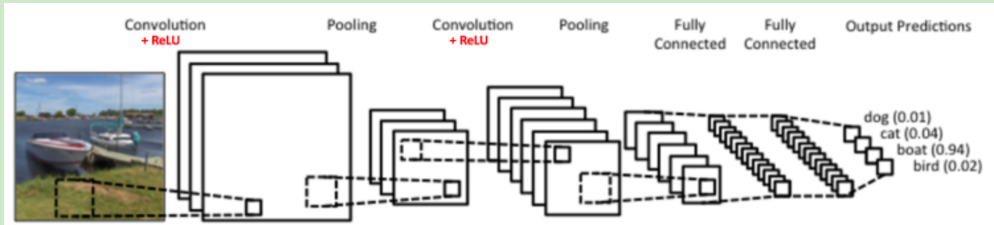

CNN的结构:

卷积层和池化层可以灵活使用,卷积层和池化层后是全连接层。其中卷积层使用的激活函数是ReLU(x)$=max(0,x)$,全连接层就是DNN的结构,输出层使用了Softmax激活函数。

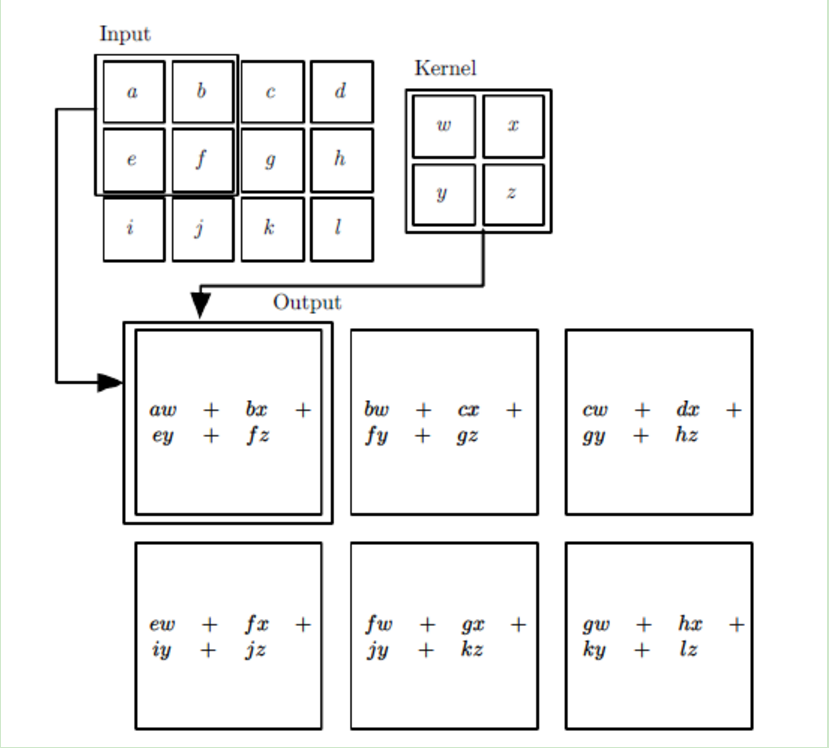

CNN中的卷积公式不是数学中严格意义上的卷积,CNN中一个二维的卷积公式为$s(i,j)=(X*W)(i,j) = \sum\limits_m \sum\limits_n x(i+m,j+n) w(m,n)$

其中W称为卷积核,X为输入,若X是二维的,则W也是二维的。

卷积的过程如下:输入为$4\times3$的二维矩阵,卷积核为$2\times2$的二维矩阵,卷积核每次移动一步,则得到的输出矩阵为$3\times2$

若输入为多维的,则公式变为$s(i,j)=(X*W)(i,j) + b = \sum\limits_{k=1}^{n\_in}(X_k*W_k)(i,j) +bs(i,j)=(X*W)(i,j) + b = \sum\limits_{k=1}^{n\_in}(X_k*W_k)(i,j) +b$

其中n_in是输入矩阵的个数,也可以称为张量的最后一维的维数。$X_k$代表第k个输入矩阵。$W_k$代表卷积核的第k个子卷积核矩阵。$s(i,j)$即卷积核W对应的输出矩阵的对应位置元素的值。

池化:

通俗的讲,池化就是对输入张量的子矩阵进行压缩,减少其维度。

要想将输入的$n\times n$的矩阵元素进行池化变为一个元素,需要建立一个池化标准。一般为Max或Average。