吴恩达学习笔记5 (Normal Equations)

2023-03-03 15:18:40 星期五

正规方程 (Normal equation with multiple variable)

对于某些线性回归问题,可以用更好的方法求得参数

的最优值

-

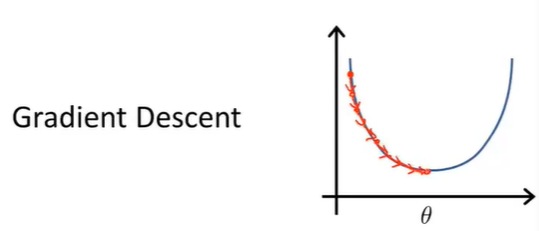

梯度下降算法

经过梯度下降的多次迭代来收敛到全局最小值

-

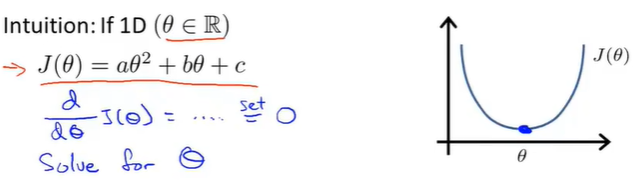

正规方程法

提供了一种求

此时最小化代价函数,对其求偏导=0时的

逐个对参数

正规方程法

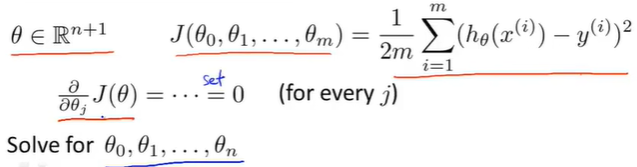

Example 1

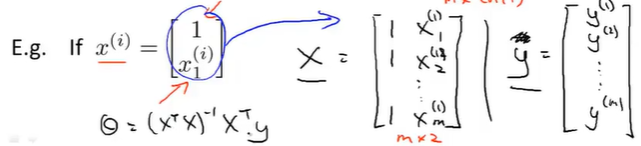

构建矩阵X,包含所有特征变量

Example 2

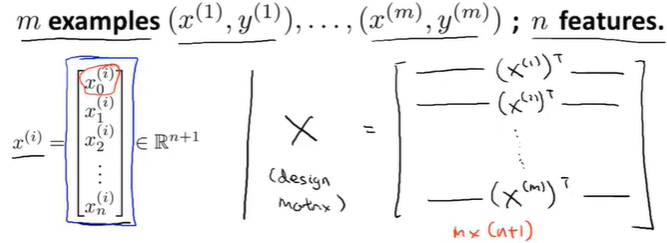

m个训练样本

eg.

这里X写错了,改为

matlab代码实现

正规方程法不需要进行特征缩放

梯度下降算法和正规方程对比

m个训练集,n个特征变量

| Gradient Descent | Normal Equation |

|---|---|

| Need to choose |

No need to choose |

| Need many iterations | Don't need to iterations |

| Works well even when n is large | Need to compute |

| Slow if |

So.

如果

如果

随着学习算法越来越复杂(例:logistic回归算法),正规方程算法并不使用于那些更复杂的学习算法,使用梯度下降法更合适

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 终于写完轮子一部分:tcp代理 了,记录一下

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理