评价指标

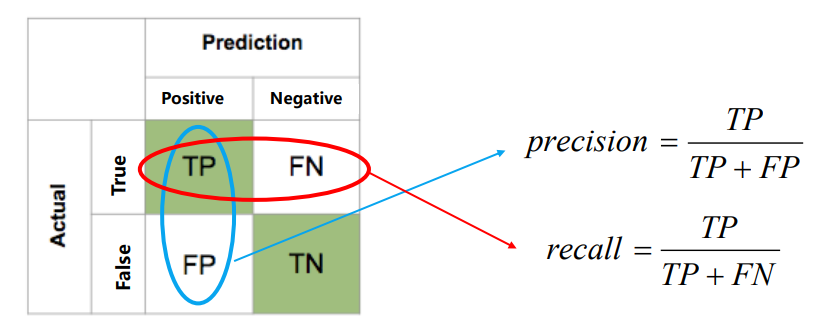

1 混淆矩阵(confusion matrix)

第一位T/F: 表示预测的对错

第二位P/N: 表示预测的结果

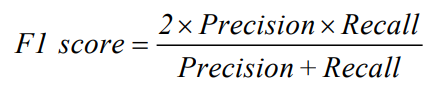

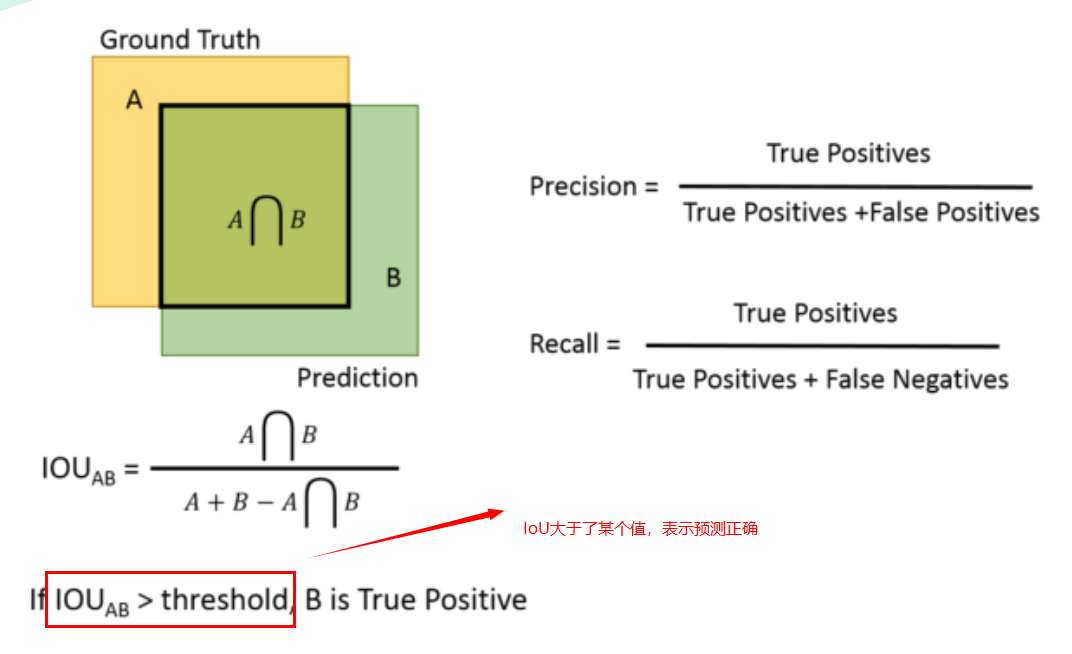

- 准确率Precision(查准率)是评估预测的准不准(看预测列)

- 召回率Recall(查全率)是评估找的全不全(看实际行)

2 交并比(IoU)

3 AP (Average Precison)

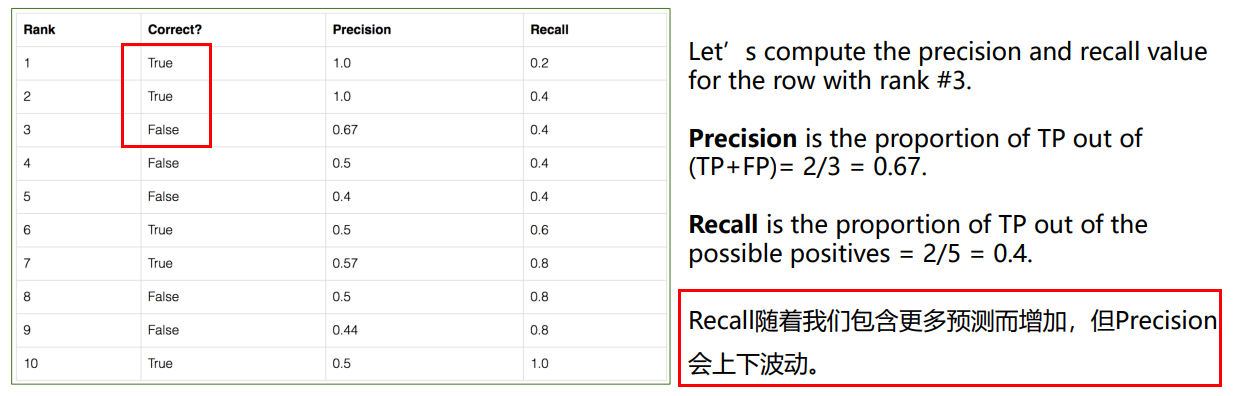

用一个简单的例子来演示平均精度(AP)的计算。 假设数据集中总共有5个苹果。 我们收集模型为苹果作的所有预测,并根据预测的置信水平(从最高到最低)对其进行排名。 第二列表示预测是否正确。 如果它与ground truth匹配并且IoU≥0.5,则是正确的。

- AP衡量的是学习出来的模型在每个类别上的好坏

- mAP衡量的是学出的模型在所有类别上的好坏。mAP就是取所有类别上AP的平均值。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术

· .NET周刊【3月第1期 2025-03-02】