Learning from delayed reward (Q-Learning的提出) (Watkins博士毕业论文)(建立了现在的reinforcement Learning模型)

最近在在学习强化学习方面的东西, 对于现有的很多文章中关于强化学习的知识很是不理解,很多都是一个公式套一个公式,也没有什么太多的解释,感觉像是在看天书一般,经过了较长时间的挣扎最后决定从一些基础的东西开始入手,于是便有了这篇论文的发现。

Learning from Delayed Reward

该论文的页面为: http://www.cs.rhul.ac.uk/~chrisw/thesis.html

下载地址为: http://www.cs.rhul.ac.uk/~chrisw/new_thesis.pdf

论文页面对这篇文章的描述:

The thesis introduces the notion of reinforcement learning as learning to control a Markov Decision Process by incremental dynamic programming,

and describes a range of algorithms for doing this, including Q-learning, for which a sketch of a proof of convergence is given.

这篇文章虽然在现有的很多文献中并不是很被提及,但是它却具有很大的意义。这篇文章(准确的说是作者在1987年发表的一篇会议论文,集成在了这篇学位论文中了)建立了现在意义上的强化学习模型,它第一次将trial-and-error 和 dynammic programming 和 temporal diffecrence 结合在了一起,并提出了Q-Learning算法。在某种意义上它可谓是“万恶之源”。

=====================================================

============================================================

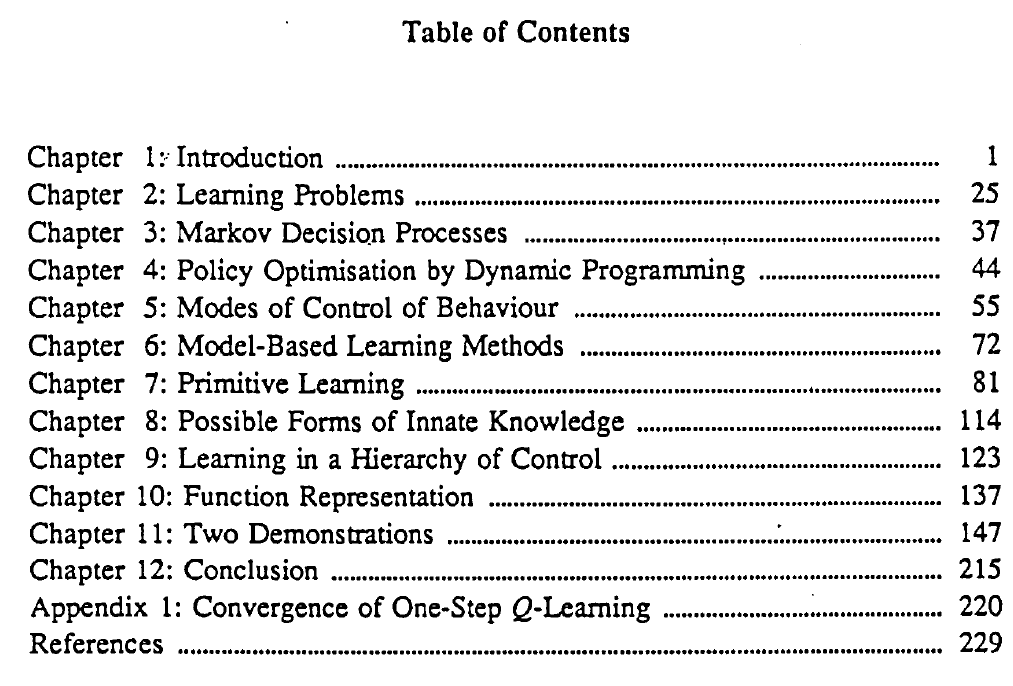

文章目录:

posted on 2019-01-11 20:47 Angry_Panda 阅读(4920) 评论(0) 编辑 收藏 举报

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· AI与.NET技术实操系列(六):基于图像分类模型对图像进行分类