何为meta learning

Meta learning的初衷是learning to learn,即学会学习。对比于依赖巨量训练的增强学习,元学习能够充分利用知识快速指导新任务学习,是通用人工智能的关键。

元学习的主要挑战是以系统的、数据驱动的方式从先前的经验中学习。首先,需要收集描述先前学习任务和先前学习模型的元数据。元数据包括用于训练模型的算法配置,超参数设置,机器学习的网络架构,得到的模型评估,学习的模型参数,以及任务本身的可测量属性。其次,需要从这个先前的元数据中学习,提取和传递指导新任务的最佳模型知识。

Meta learning VS 传统机器学习

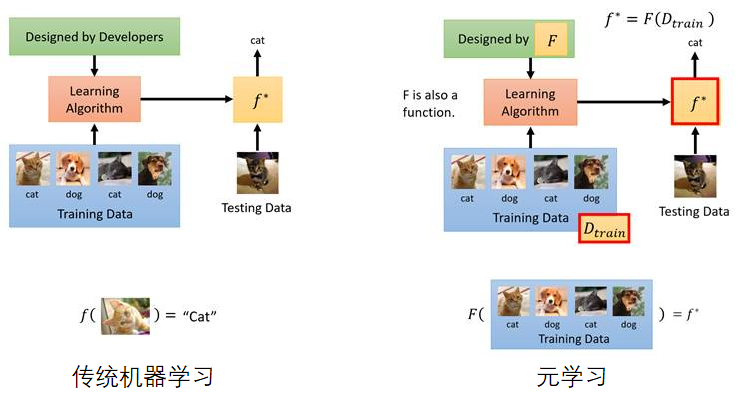

传统机器学习:根据资料找一个函数f

传统机器学习:根据资料找一个函数f

元学习:根据资料找一个函数F,F可以帮助找到f。这里的f包括了网络架构、参数初始化、参数更新方式等。元学习的最终学习成果是在给定训练资料的条件下,机器能够找到针对这笔资料的SGD最佳训练流程。f是由包含尽量多(步骤)和丰富组合方式的不同训练流程组成的。

Why meta

"Meta" is a prefix meaning "referring to itself."

meta learning = learning of learning (学习怎么去学,现在一般指自动地学习用哪个模型拟合给定分布的数据)

少样本学习

充足的训练样本能让判别器精准找到真假样本的分界线,让生成器精确拟合出精确的生成分布,但是少样本无法准确拟合数据的分布规律。

Meta learning 和 GANs

GANs学习的本质在于拟合数据的浅分布,而数据浅分布很大程度上取决于训练数据所具有的样本广度和样本质量,所以其训练很容易受到训练数据质量的影响。meta learning 可以帮助GAN训练中数据不匹配和数据缺乏问题,因为meta learning能够探索数据集的规律再制定学习策略,从传统的GAN训练:设计模型→寻找数据→验证模型,变为:寻找数据→设计模型→验证模型。从用数据去匹配模型变为用模型去匹配数据,解决生成模型的少样本学习问题。

Meta learning方案

Meta learning的训练资料是Dtrain和f*的组合,f是由包含尽量多和丰富的组合方式的不同训练流程来组成的,F可以选择各种不同的训练流程f,最重要的是定义F的损失函数和降低F的损失。Taski在F下学到训练算法fi,Taski在训练算法fi下测试结果的损失值为li,这里可以是分类损失,也可以是下降速率的损失,取决于希望F学习到什么样的算法效果。最终F的损失函数是所有任务上的损失函数总和。

参考文献:

⭕ 李宏毅b站视频

⭕ 学习笔记

浙公网安备 33010602011771号

浙公网安备 33010602011771号