什么是数据湖技术

数据湖(Data Lake)是Pentaho公司创始人及CTO James Dixon于2010年10月在2010年10月纽约Hadoop World大会上提出来的一种数据存储理念—即在系统或存储库中以自然格式存储数据的方法。数据湖作为一个集中的存储库,可以在其中存储任意规模的结构化和非结构化数据。在数据湖中,可以存储不需要对其进行结构化的数据,这样就可以运行不同类型的分析。

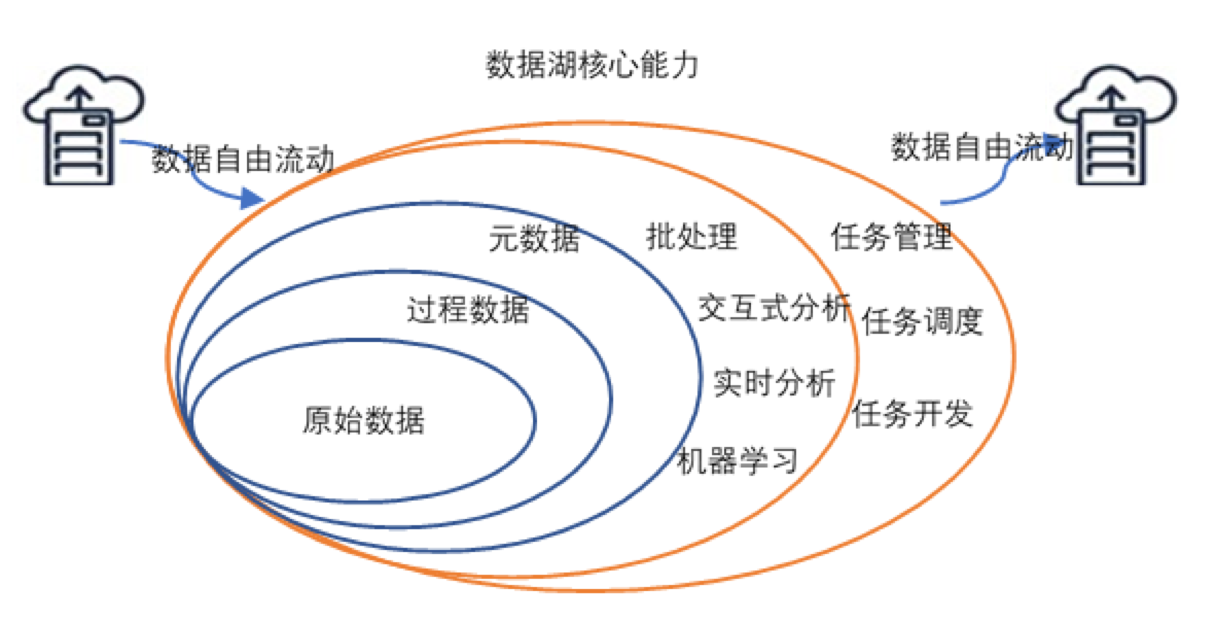

简单表述总结为以下8点:

1) 数据湖需要提供足够用的数据存储能力,存储保存了一个企业/组织中的所有数据。

2) 数据湖可以存储海量的任意类型的数据,包括结构化、半结构化和非结构化数据。

3)数据湖中的数据是原始数据,是业务数据的完整副本。

4) 需要具备完善的数据管理能力(完善的元数据),可以管理各类数据相关的要素,包括数据源、数据格式、连接信息、数据schema、权限管理等。

5) 需要具备多样化的分析能力,包括但不限于批处理、流式计算、交互式分析以及机器学习;同时,还需要提供一定的任务调度和管理能力。

6) 需要具备完善的数据生命周期管理能力。不仅需要存储原始数据,还要能够保存各类分析处理的中间结果,并完整的记录数据的分析处理过程,帮助用户完整详细追溯任意一条数据的产生过程。

7)需要具备完善的数据获取和数据发布能力。

8) 对于大数据的支持,包括超大规模存储以及可扩展的大规模数据处理能力。

三大理念:

1)能够存储海量的原始数据

2)能够支持任意的数据格式

3)有较好的分析和处理能力

六大基本特征:

1)“保真性”

2)“灵活性”

3)“可管理”

4)“可追溯”

5)丰富的计算引擎

6)多模态的存储引擎

数据湖和数据仓库的对比:

当前的数据仓库痛点:

1)只能存储结构化数据,无法采集存储非结构化数据

2)无法存储原始数据,所有的数据须经过ETL清洗过程

3)离线数仓的数据表牵一发而动全身,数据调整工程量大

4)实时数仓存储空间有限,无法采集和存储海量实时数据

5)回溯效率低下,实时数据和离线数据计算接口难以统一

数据湖可以完美的解决传统数仓的各大痛点,更大力度的挖掘数据价值。数据湖是帮助企业实现全量数据单一存储的集中式存储库,无需任何预处理,可以存储任意规模、任意类型、各种需求速度的数据,包括结构化、半结构化和音视频、图片、文本等非结构化数据。

而且,数据湖通常存储原始格式的对象块或者文件,保证数据的”原汁原味”,对企业更加全面的抓取、分析和应用数据,创造更大的数据价值提供重要的基础支撑。

数据湖理念支持各种分析方式,可以运行从控制面板、可视化、大数据处理、实时分析到机器学习等不同类型的分析。

不同于传统数据的表模型建立方式,数据湖基于读取型Schema,采用读时模式,能够根据业务需求灵活建表,大大提升了敏捷性和精准度。

使用传统数仓的企业,每个部门都只有自己的数据。数据湖打破了 “数据孤岛”的闭塞,允许多种职能角色包括数据科学家、数据开发人员和业务分析师等通过各自选择的分析工具和框架来访问数据,而无须移动数据,

大大节省了定义数据结构、Schema和转换的时间。这不仅让跨领域、跨平台、跨媒介的数据分析简单实现,”时空旅行”的回溯秒回功能加持数据湖能够更敏捷地提供全量和全生命周期的数据分析结果和数据预测分析服务,灵活高效支撑企业各种决策的制定,真正助力企业实现降本增效,落地实现数智化转型发展。

通过数据湖技术可以实现”敏捷”地统一存储和统一分析,能够最大程度地解决大数据的痛点问题。

常见的三大数据湖技术Delta、Hudi、Iceberg对比

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· winform 绘制太阳,地球,月球 运作规律

· AI与.NET技术实操系列(五):向量存储与相似性搜索在 .NET 中的实现

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)