Segformer: 高效自注意力/MIT encoder

NIPS21 SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers

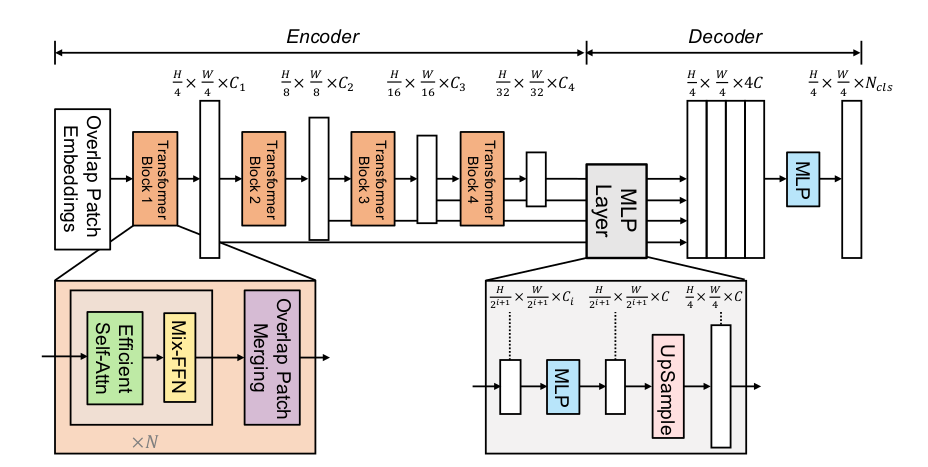

网络架构:轻量化decoder,各层只经过MLP和上采样到同一分辨率;主要依靠较重的encoer来获取特征,作者认为较大的感受野是提升性能的关键;encoder由四层transformer block组成,输入特征分辨率为1/4.

transformer block包含patch merging+N组(self-attention+Mix-feed-forward)

- self-attention对key特征维度做了衰减reshape,因而降低了计算复杂度;

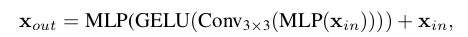

- Mix-feed-forward选择MLP(1*1卷积实现)和3*3卷积混合使用,解释为单纯3*3卷积padding补0操作会导致缺乏位置信息

实验

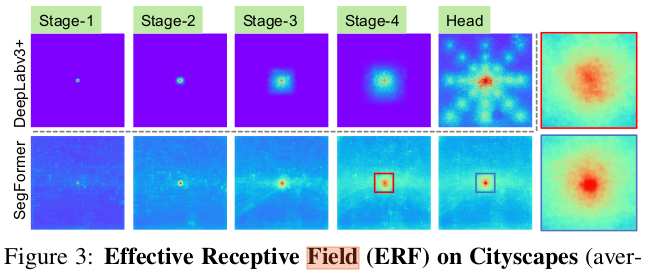

感受野可视化

浙公网安备 33010602011771号

浙公网安备 33010602011771号