集成学习

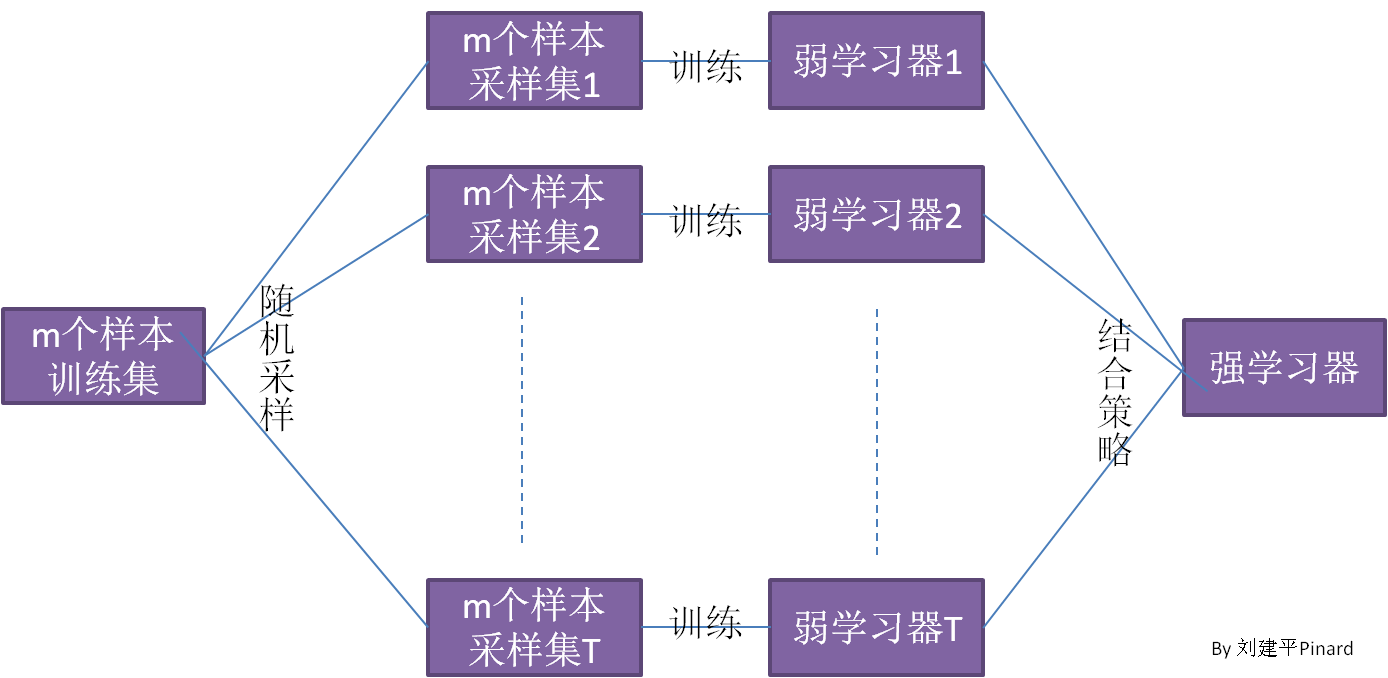

bagging

bagging的弱分类器之间是相互独立的,容易并行,bagging方法主要是能减少方差。

bagging对样本进行采样时采用有放回的采样(自助法),一般会随机采集和训练集样本数m一样个数的样本。这样得到的采样集和训练集样本的个数相同,但是样本内容不同

代表算法:随机森林

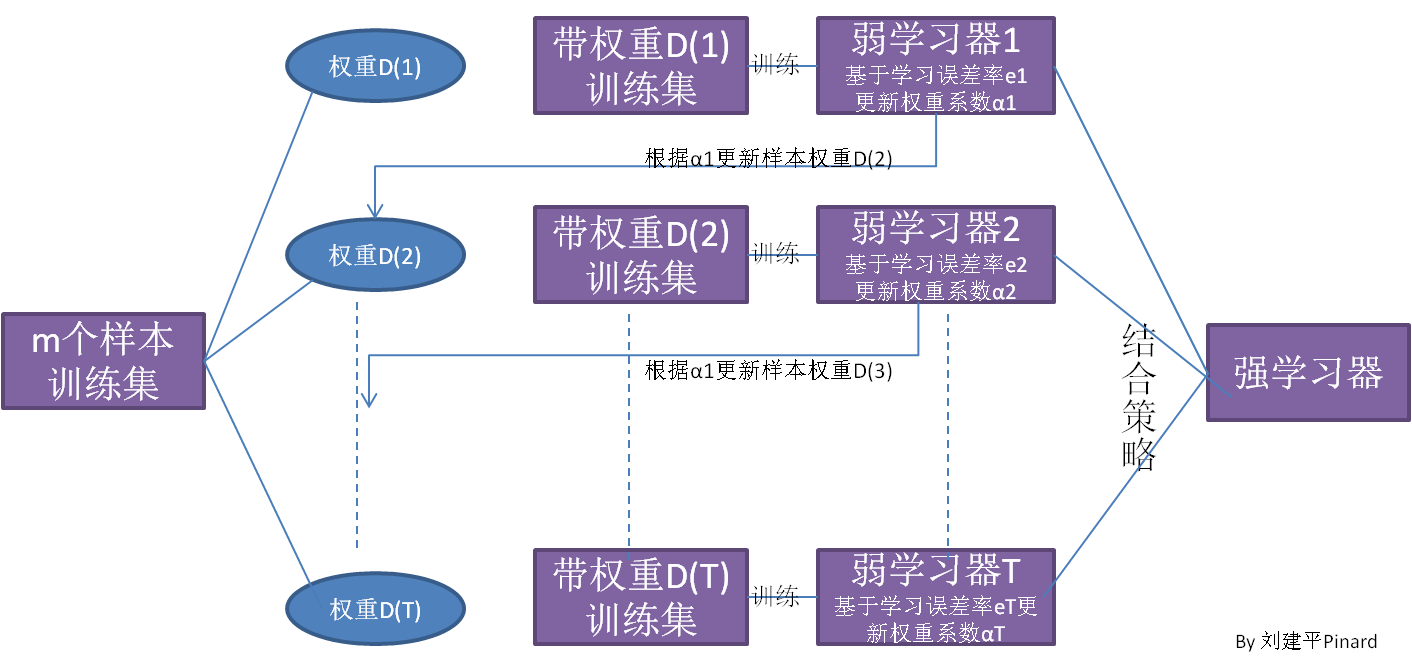

boosting

Boosting算法的工作机制是首先从训练集用初始权重训练出一个弱学习器1,根据弱学习的学习误差率表现来更新训练样本的权重,使得之前弱学习器1学习误差率高的训练样本点的权重变高,使得这些误差率高的点在后面的弱学习器2中得到更多的重视。然后基于调整权重后的训练集来训练弱学习器2.,如此重复进行,直到弱学习器数达到事先指定的数目T,最终将这T个弱学习器通过集合策略进行整合,得到最终的强学习器。

boosting方法弱分类之间是顺序依存的,难以并行,boosting方法主要是能减少偏差。

集成学习弱分类器结果的结合策略

1.取平均

2.投票

3.学习法:即把这些弱分类器的预测结果当作样本,用另外一个分类器去训练预测。