15 手写数字识别-小数据集

1.手写数字数据集

- from sklearn.datasets import load_digits

- digits = load_digits()

(1)导入数据包

(2)读取数据

2.图片数据预处理

- x:归一化MinMaxScaler()

- y:独热编码OneHotEncoder()或to_categorical

- 训练集测试集划分

- 张量结构

(1)x:归一化MinMaxScaler(),y:独热编码OneHotEncoder()

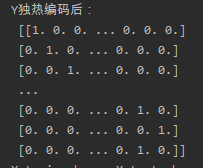

结果如图:

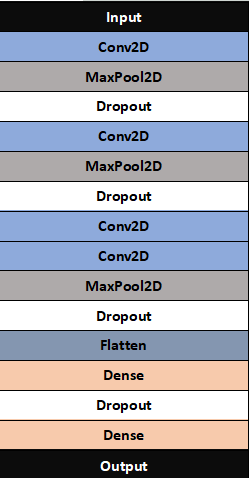

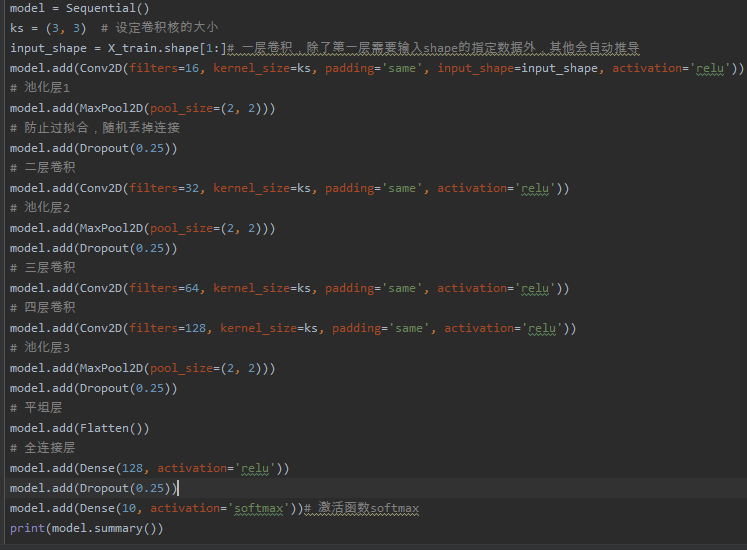

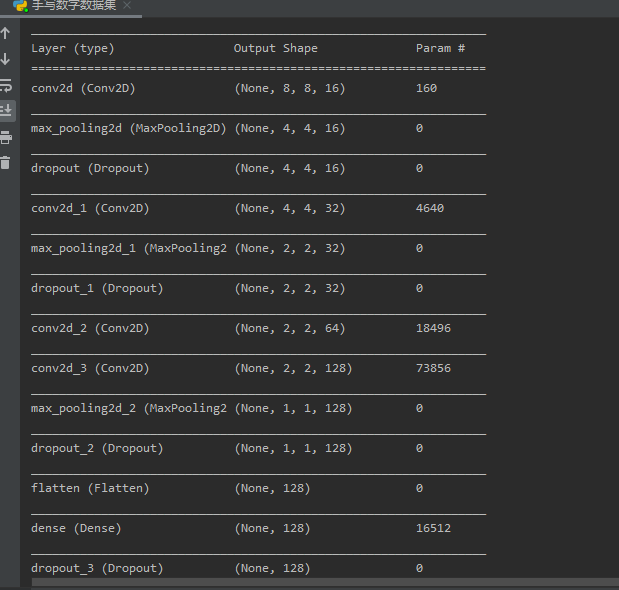

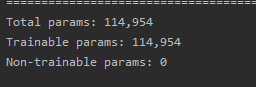

3.设计卷积神经网络结构

- 绘制模型结构图,并说明设计依据。

模型结构如图:

设计理念依据:

(1)传递一个input_shape的关键字参数给第一层,input_shape是一个tuple类型的数据,其中也可以填入None,如果填入None则表示此位置可能是任何正整数。数据的batch大小不应包含在其中

(2)传递一个batch_input_shape的关键字参数给第一层,该参数包含数据的batch大小。该参数在指定固定大小batch时比较有用,例如在stateful RNNs中。事实上,Keras在内部会通过添加一个None将input_shape转化为batch_input_shape

(3)有些2D层,如Dense,支持通过指定其输入维度input_dim来隐含的指定输入数据shape。一些3D的时域层支持通过参数input_dim和input_length来指定输入shape。

(4)优化器optimizer:该参数可指定为已预定义的优化器名

(5)损失函数loss:该参数为模型试图最小化的目标函数

(6)由于图像尺寸较小,故卷积核尺寸设置为3×3,三个卷积-池化层的卷积核数量分别设置为16、32、64。

4.模型训练

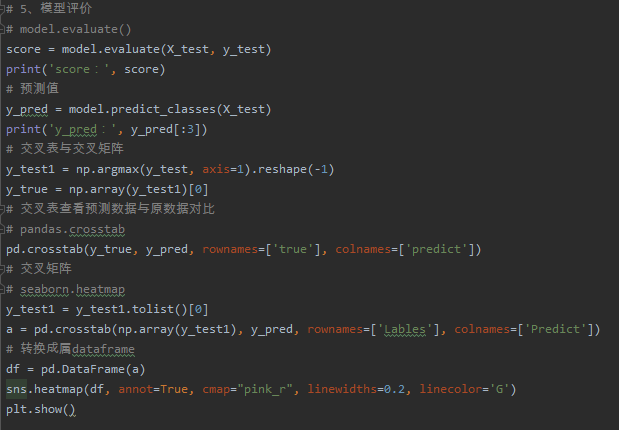

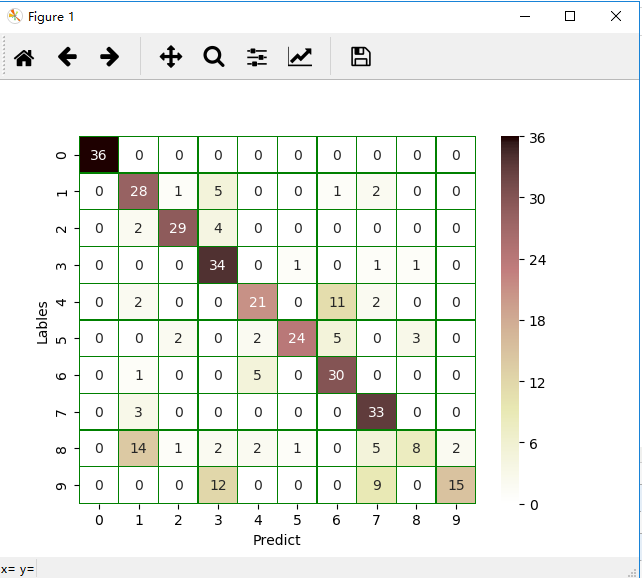

5.模型评价

- model.evaluate()

- 交叉表与交叉矩阵

- pandas.crosstab

- seaborn.heatmap

完整代码如下:

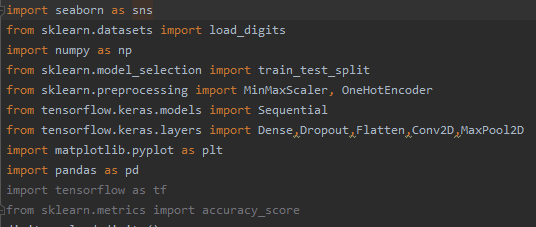

import seaborn as sns

from sklearn.datasets import load_digits

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import MinMaxScaler, OneHotEncoder

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense,Dropout,Flatten,Conv2D,MaxPool2D

import matplotlib.pyplot as plt

import pandas as pd

import tensorflow as tf

from sklearn.metrics import accuracy_score

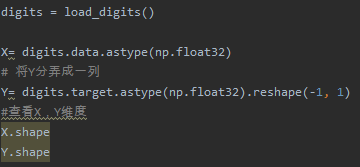

digits = load_digits()

X= digits.data.astype(np.float32)

# 将Y分弄成一列

Y= digits.target.astype(np.float32).reshape(-1, 1)

#查看X,Y维度

X.shape

Y.shape

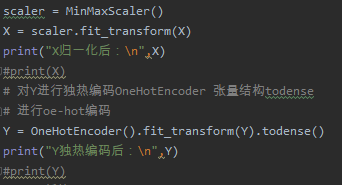

# 将属性缩放到一个指定的最大和最小值(通常是1-0之间)

# x:归一化MinMaxScaler()

scaler = MinMaxScaler()

X = scaler.fit_transform(X)

print("X归一化后:\n",X)

#print(X)

# 对Y进行独热编码OneHotEncoder 张量结构todense

# 进行oe-hot编码

Y = OneHotEncoder().fit_transform(Y).todense()

print("Y独热编码后:\n",Y)

#print(Y)

##XL最新的X

XL = X.reshape(-1, 8, 8, 1)

# 训练集测试集划分

X_train, X_test, y_train, y_test = train_test_split(XL, Y, test_size=0.2, random_state=0, stratify=Y)

print('X_train.shape, X_test.shape, y_train.shape, y_test.shape:', X_train.shape, X_test.shape, y_train.shape, y_test.shape)

#建立Sequential模型

model = Sequential()

ks = (3, 3) # 设定卷积核的大小

input_shape = X_train.shape[1:]# 一层卷积,除了第一层需要输入shape的指定数据外,其他会自动推导

model.add(Conv2D(filters=16, kernel_size=ks, padding='same', input_shape=input_shape, activation='relu'))

# 池化层1

model.add(MaxPool2D(pool_size=(2, 2)))

# 防止过拟合,随机丢掉连接

model.add(Dropout(0.25))

# 二层卷积

model.add(Conv2D(filters=32, kernel_size=ks, padding='same', activation='relu'))

# 池化层2

model.add(MaxPool2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

# 三层卷积

model.add(Conv2D(filters=64, kernel_size=ks, padding='same', activation='relu'))

# 四层卷积

model.add(Conv2D(filters=128, kernel_size=ks, padding='same', activation='relu'))

# 池化层3

model.add(MaxPool2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

# 平坦层

model.add(Flatten())

# 全连接层

model.add(Dense(128, activation='relu'))

model.add(Dropout(0.25))

model.add(Dense(10, activation='softmax'))# 激活函数softmax

print(model.summary())

# 画Train History图

def show_train_history(train_history, train, validation):

plt.plot(train_history.history[train])

plt.plot(train_history.history[validation])

plt.title('Train History')

plt.ylabel('train')

plt.xlabel('epoch')

plt.legend(['train', 'validation'], loc='upper left')

plt.show()

# 4、模型训练

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

train_history = model.fit(x=X_train, y=y_train, validation_split=0.2, batch_size=300, epochs=10, verbose=2)

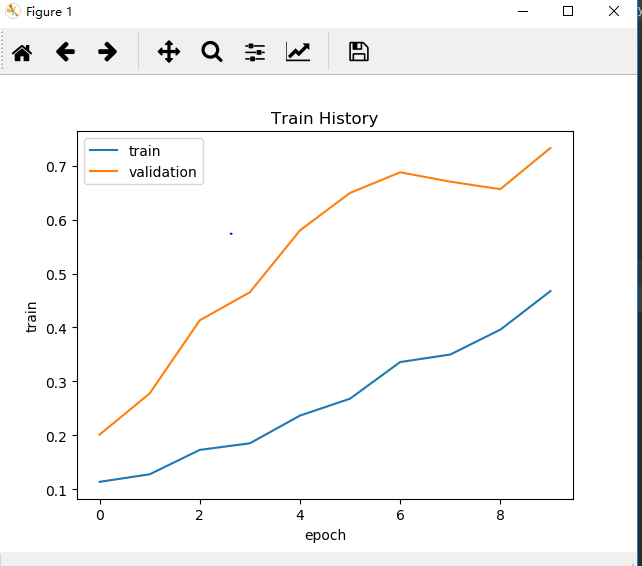

# 准确率

show_train_history(train_history, 'accuracy', 'val_accuracy')

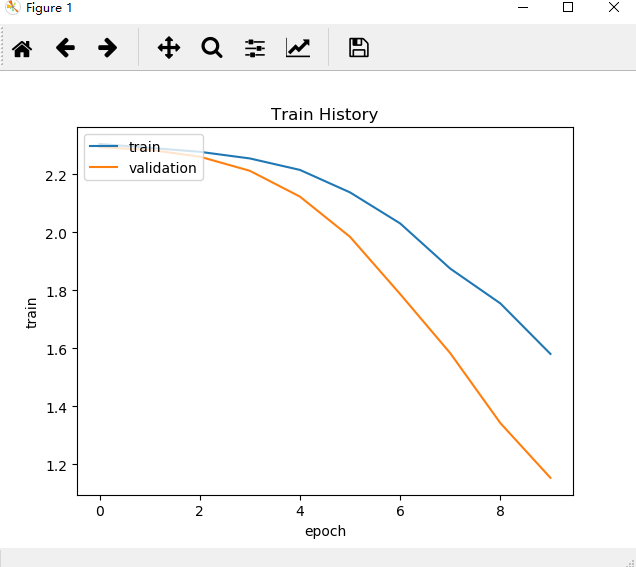

# 损失率

show_train_history(train_history, 'loss', 'val_loss')

# 5、模型评价

# model.evaluate()

score = model.evaluate(X_test, y_test)

print('score:', score)

# 预测值

y_pred = model.predict_classes(X_test)

print('y_pred:', y_pred[:3])

# 交叉表与交叉矩阵

y_test1 = np.argmax(y_test, axis=1).reshape(-1)

y_true = np.array(y_test1)[0]

# 交叉表查看预测数据与原数据对比

# pandas.crosstab

pd.crosstab(y_true, y_pred, rownames=['true'], colnames=['predict'])

# 交叉矩阵

# seaborn.heatmap

y_test1 = y_test1.tolist()[0]

a = pd.crosstab(np.array(y_test1), y_pred, rownames=['Lables'], colnames=['Predict'])

# 转换成属dataframe

df = pd.DataFrame(a)

sns.heatmap(df, annot=True, cmap="pink_r", linewidths=0.2, linecolor='G')

plt.show()