redis set 去重的 内存问题

在编写爬虫代码的过程中,程序员会使用redis 集合进行去重,今天就测试一下redis去重需要多少内存的问题

过程:我们对10w,100w,1000w 的数字进行 md5 加密,生成唯一的32位字符串,然后存入到redis集合中去,通过rdm 的 内存分析占用查看redis的大小。

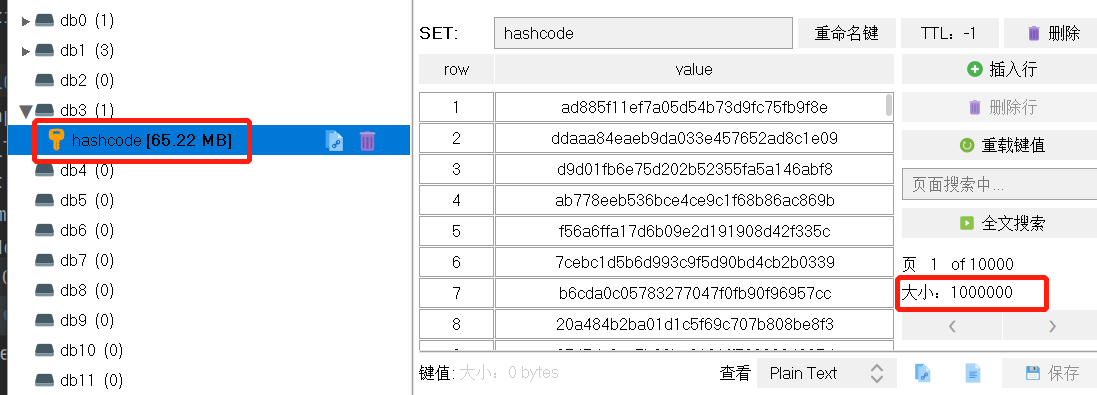

1. 对10w 数据去查,查看大小

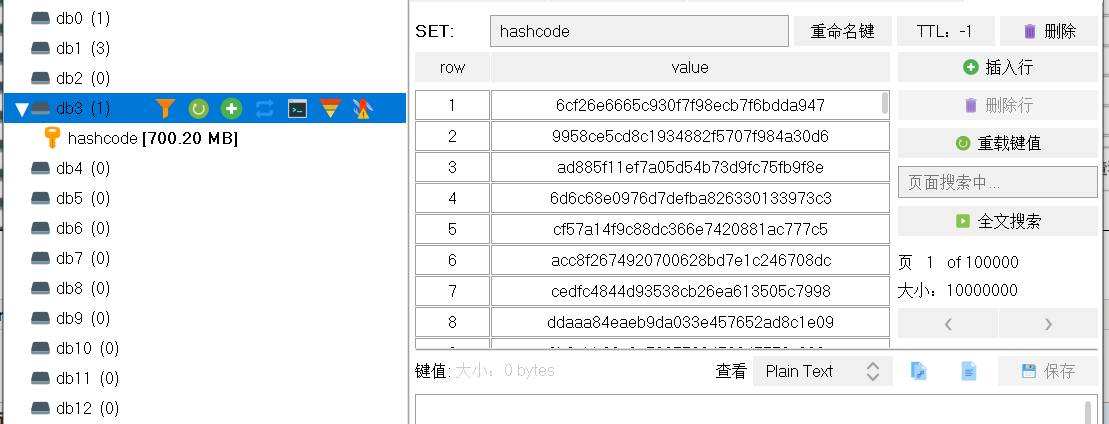

2. 对100w 数据去查,查看大小

3. 对1000w 数据去查,查看大小

4. 对 2000w 数据去查,查看大小

总结:

绘制一个图表展示一下吧

当需要去重的数据量达到1亿的时候,需要的内存是7GB左右,如果要是有50亿条数据,redis去重还是一个好的解决方案吗?

最后对自己想说的是:百想不如一测

如果觉得对您有帮助,麻烦您点一下推荐,谢谢!

好记忆不如烂笔头

好记忆不如烂笔头

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· Open-Sora 2.0 重磅开源!

· 周边上新:园子的第一款马克杯温暖上架