公司内部服务器实现同一块磁盘共享,方便Oracle做RAC或者达梦数据库做DSC群集

切记:做共享的环境不能存在虚拟机快照

公司内部服务器实现同一块磁盘共享,方便Oracle做RAC或者达梦数据库做DSC群集。

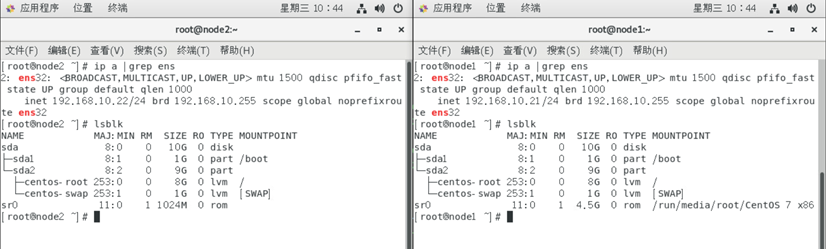

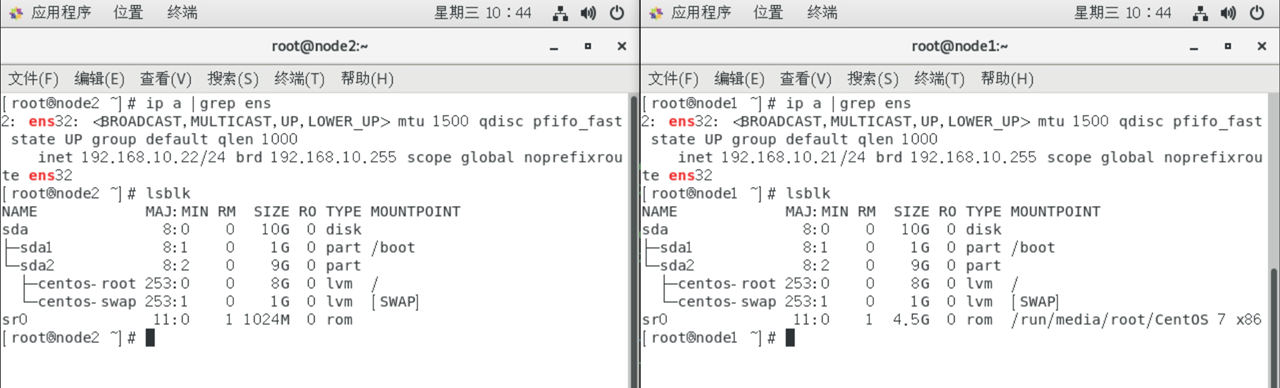

该处以两台机器(node1、node2)为例

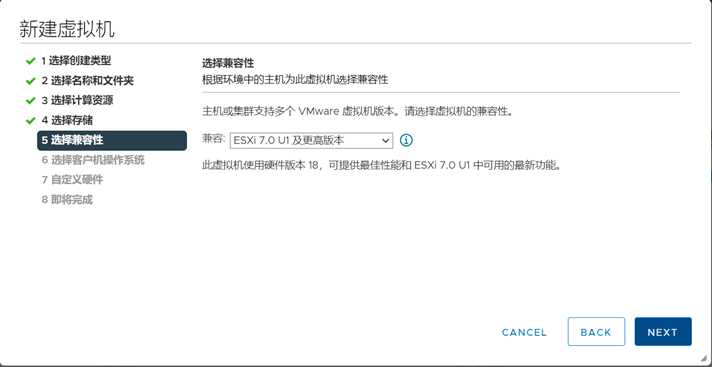

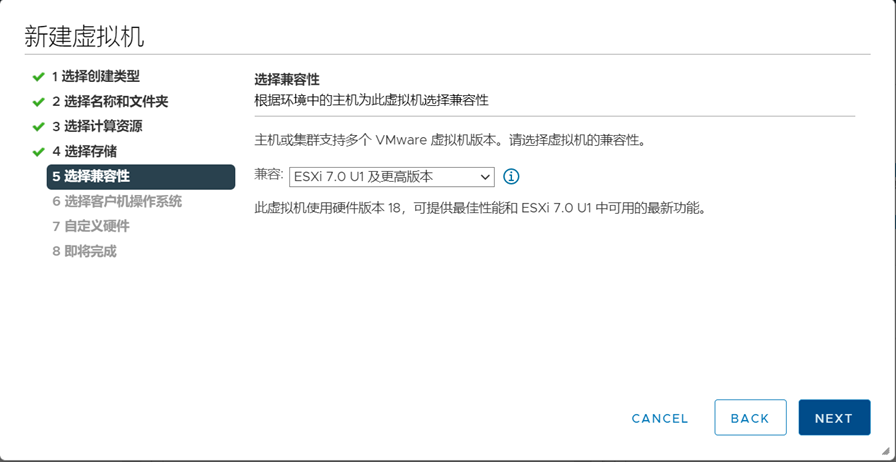

环境准备:新虚拟机节点2个(配置好静态ip,方便xshell操作)。

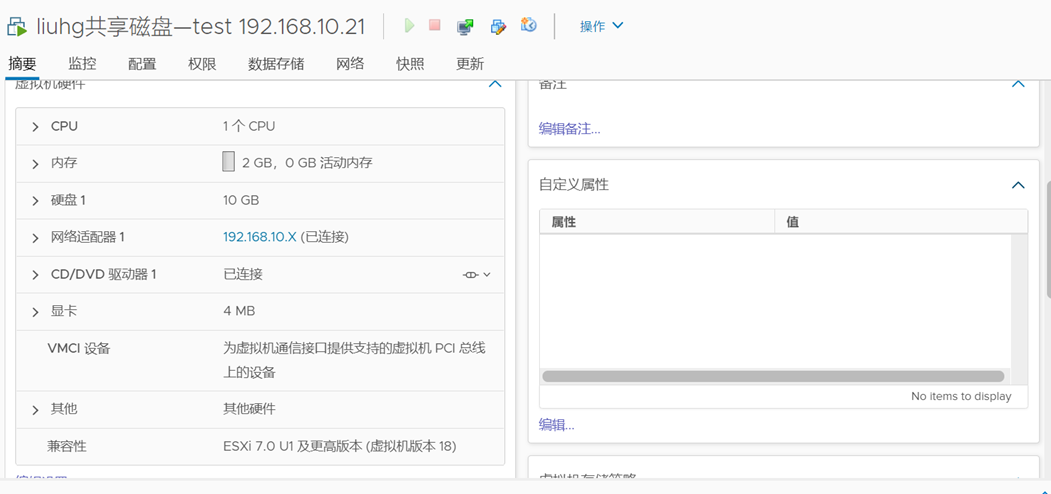

图上是刚配置好新机器的IP,没有共享磁盘的,现在开始创建共享磁盘。

任选一个机器做为创建磁盘的机器(该出以node1为例),两台机器全部关机(poweroff命令),关机之后,在node1上添加磁盘做共享。

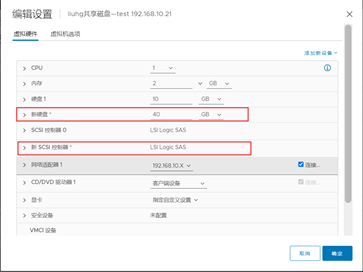

操作流程:node1的详情页上面编辑设置

添加新设备—>硬盘和SCSI控制器

添加完了之后会出现新硬盘和新SCSI控制器

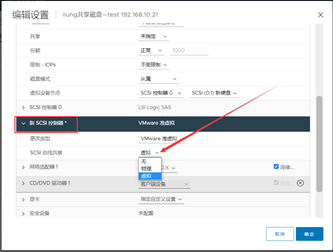

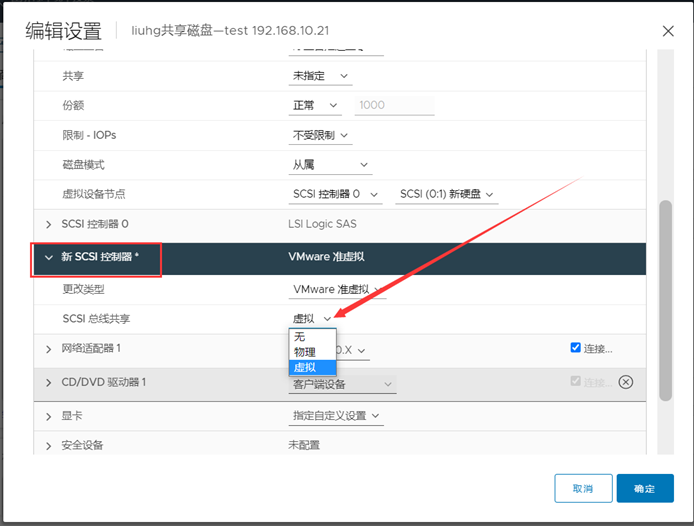

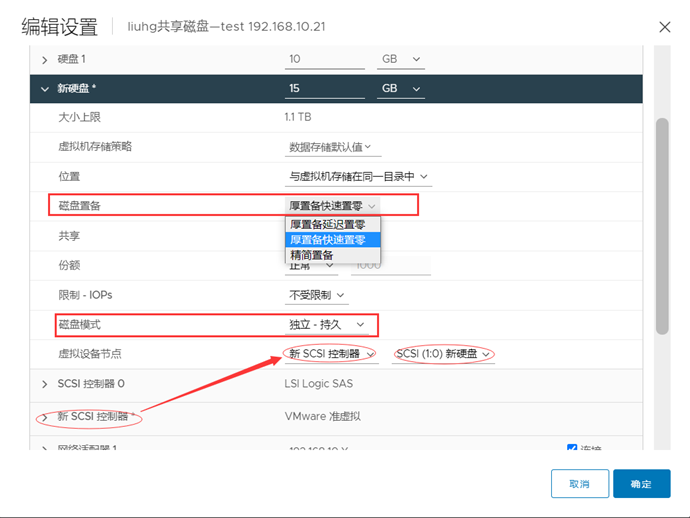

先设置新增的SCSI控制器

控制器总线共享选择虚拟(参考右图)

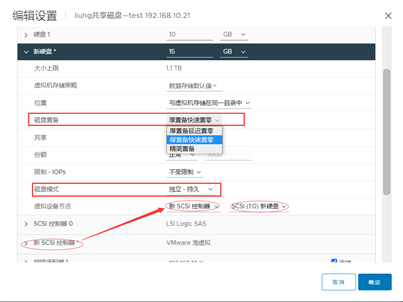

新增的SCSI控制器设置好了之后,然后开始设置新增的那块磁盘。

磁盘置备必选厚置备快速置零(可自行百度其中的区别)

磁盘模式选择为,独立—持久;

虚拟设备节点,使用新增SCSI控制器,后面选择所添加的新硬盘,然后点击右下角确认。

至此node1的配置已经做好备用。

总览:粗框为新增,细框为虚拟机创建的时候自带的。

粗框与粗框是形成配对,细框与细框是形成配对。

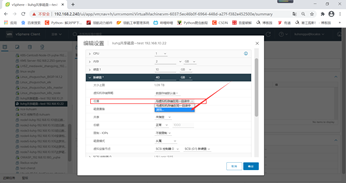

现在设置node2节点。右图为网页版,由于网页版的浏览文件不方便找到

node1的新增磁盘文件,所以需启动vmware客户端。

添加磁盘,指的是添加磁盘文件,也就是node1所添加的为一个虚拟的磁盘文件,但是该文件是真实存在的,因此,现在需通过node1找到该文件的具体存放路径和名字

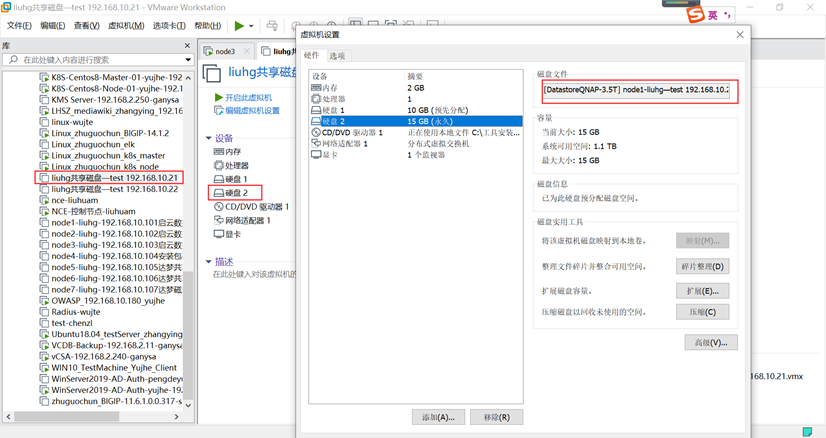

通过VMware客户端:点击所创建的node1机器——>硬盘2。

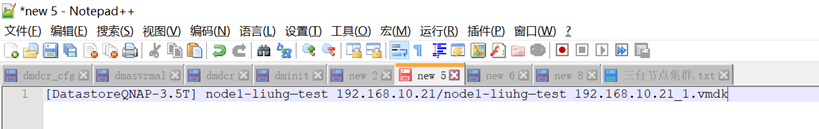

上图的磁盘文件,即真实的存放路径与文件名,拷贝下来放文本里面备用(带上文件后缀名字)。

再点击node2,添加一块硬盘,类型选择SCSI

选择磁盘点击使用现有的虚拟磁盘

然后会让你选择使用之前就已经配置的文件,这里直接填入刚才拷贝出来的那个路径和磁盘名字,然后点击完成、确认。

节点2的磁盘就添加好,

添加好了之后,再回到网页版的,刷新一下,硬盘2就是刚才所添加的

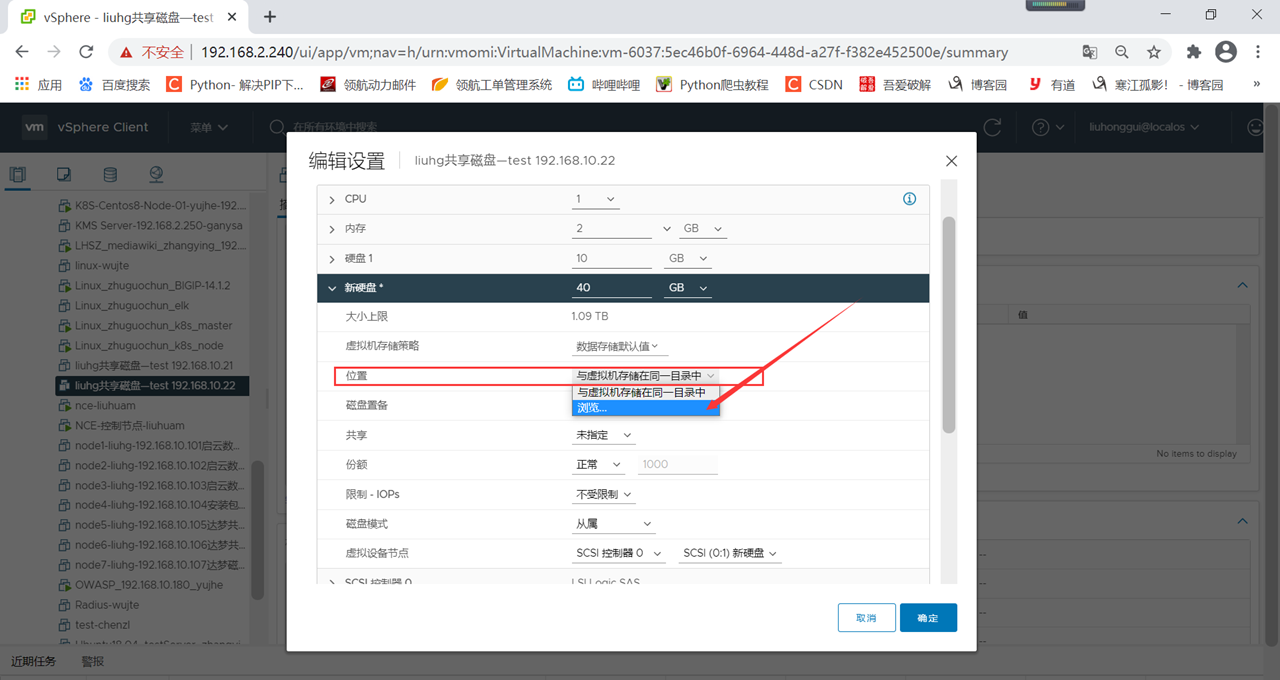

可以点击编辑设置,看到磁盘2的详细情况,类型和node1的磁盘类型一样,就说明所添加的磁盘是node1的磁盘,没有问题。

磁盘加好了之后,即可配置SCSI控制器和磁盘2。

与node1同样,因为磁盘已经添加好了,该处只需单独配置SCSI控制器,与node1的SCSI控制器设置一样

控制器设置好了之后,再来设置node2的磁盘(与node1类似)。

[root@node1 ~]# parted /dev/sdb

GNU Parted 3.1

使用 /dev/sdb

Welcome to GNU Parted! Type 'help' to view a list of commands.

(parted) mklabel gpt

(parted) mkpart primary 0% 10%

(parted) mkpart primary 10% 25%

(parted) mkpart primary 25% 50%

(parted) mkpart primary 50% 100%

(parted) print

Model: VMware, VMware Virtual S (scsi)

Disk /dev/sdb: 10.7GB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name 标志

1 1049kB 1074MB 1073MB primary

2 1074MB 2684MB 1611MB primary

3 2684MB 5369MB 2684MB primary

4 5369MB 10.7GB 5368MB primary

(parted) quit

磁盘格式化

mkfs.ext4 /dev/sdb1

mkfs.ext4 /dev/sdb2

mkfs.ext4 /dev/sdb3

mkfs.ext4 /dev/sdb4

分区1:2G

分区2:100M

分区3:1G

分区4:1G

两台都要配置

[root@back ~]# vim /etc/udev/rules.d/70-persistent-ipoib.rules

ACTION=="add", KERNEL=="sdb1", RUN+="/bin/raw /dev/raw/raw1 %N" # dcr 注册信息,表

ACTION=="add", KERNEL=="sdb2", RUN+="/bin/raw /dev/raw/raw2 %N" # vote 集群信息

ACTION=="add", KERNEL=="sdb3", RUN+="/bin/raw /dev/raw/raw3 %N" # log 日志

ACTION=="add", KERNEL=="sdb4", RUN+="/bin/raw /dev/raw/raw4 %N" # data 数据

ACTION=="add", KERNEL=="raw[1-4]", OWNER="dmdba", GROUP="dinstall", MODE="660"

重启udev:

[root@back ~]# /sbin/udevadm control --reload

[root@back ~]# systemctl restart systemd-udev-trigger.service

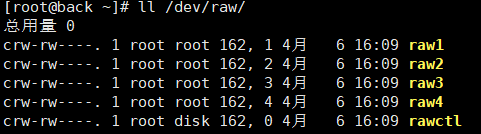

[root@back ~]# ll /dev/raw/

已经配置完成