再次理解线性回归与梯度下降

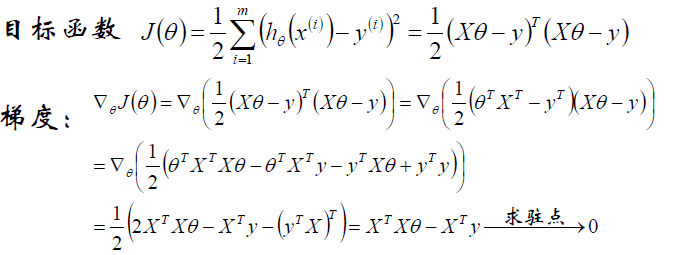

首先,给出目标函数:

目的就是使得J(Θ)最小。

还知道,Θ是未知量,目的就是求什么样的Θ能使目标函数J(Θ)最小。下面有两种方法:

(1)直接通过解析式,解除出Θ。

原式对Θ求导数,找驻点。

这样能得出Θ得参数解析式:

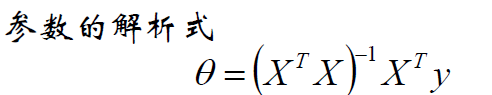

若XTX不可逆,这是数学上的解释,也可以解释为防止过拟合,所以增加了λ扰动。

这里还要补充两个知识点:

另外:ΘTAΘ(A为可逆矩阵)对Θ求偏导,结果为2AΘ。

以上是Θ的解析式求解。

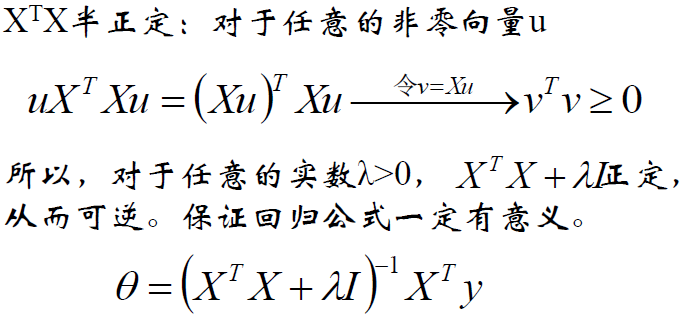

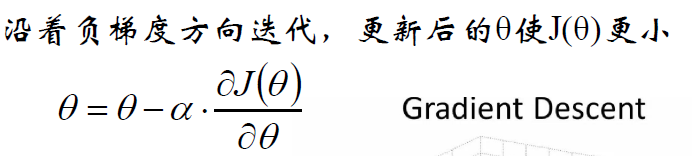

(2)梯度下降法

![]()

依然关注这个目标函数。

梯度下降的本质是:start with some Θ,keep change Θ to reduce J(Θ)。

那怎么change Θ来达到目的呢?

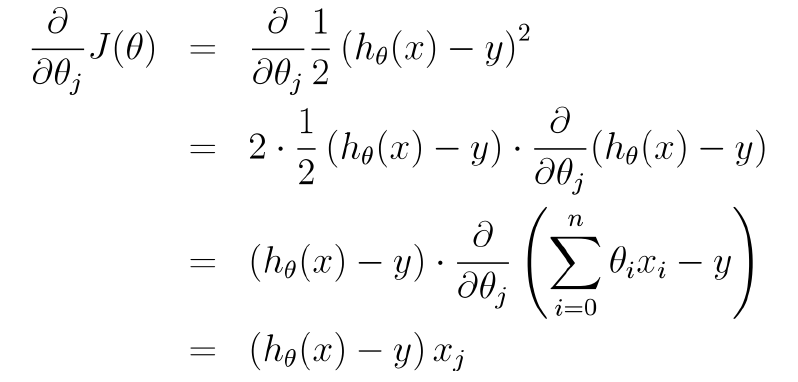

还看目标函数,为了mini J(Θ),对Θ求偏导找驻点,但驻点不好找,找J(Θ)关于Θ下降最快的方向也行啊。

这就是那个方向,梯度方向。

然后有:

现在突然有个问题,为什么这么更新Θ能使J(Θ)最小呢?

待解决。

bling bling

浙公网安备 33010602011771号

浙公网安备 33010602011771号